随着智能电网发展,变电站数量逐年增加,电力检修任务强度加大。变电站电力人员工作在高电压、强电流的复杂危险环境中,长时间重复作业易使其安全意识下降,增加安全事故发生概率。穿戴防护工具是保障人身安全的有效措施,传统电力作业监管采用人工巡查及抽查方式,存在监管不全面及主观因素干扰等问题[1]。近年来,机器视觉技术在识别精度等方面不输人类视觉,可实现电气作业人员安全作业自动化检测,克服人工监管不全面的问题[2],具有广阔前景和高应用价值。

目前,目标检测模型凭借其强大的特征学习能力、更高的精度和速度,以及更强的泛化性能,被众多学者广泛地应用于各类作业人员安全穿戴检测中[3-5],如针对安全帽[6-7]、反光衣[8-9]和绝缘手套[10]等穿戴设备进行的检测。其中,绝缘手套穿戴检测涉及人员手部和绝缘手套的检测,属于典型的小目标检测问题,难度较高。此外,在多人场景下,还需要识别未穿戴绝缘手套的具体人员,这进一步增加了检测难度。针对手部小目标识别和定位的难题,郑海洋等[10]提出了一种改进的YOLOv3算法,结合人体与手部关联匹配策略,该方法相比原算法精度提升了33.43%,但模型参数量较大,不利于边缘部署和实时检测。王茹等[11]提出了一种改进的YOLOv8n电力人员安全设备检测算法,能够有效检测电力人员常用的多种安全设备,并取得了不错的成果,但该算法训练周期较长且在未穿戴绝缘手套的检测精度方面需要进一步提升。

实际作业场景复杂多变,电力人员在监控视频中的尺度变化较大,同时手部具有目标小、姿态灵活、易被遮挡等特点,这些因素会增加检测难度。综合考虑以上因素,本文选择综合性能较好的RT-DETR-R18[12]模型进行改进,创新点如下。

(1)构建STPFM网络,在CCFM网络中引入SSFF模块[13]和TFE模块[13];增加以SSFF模块为核心的小目标检测层,利用较小的感受野增强模型对浅层局部信息的捕获,进一步提高小目标检测精度。

(2)为避免浅层小目标信息的损失以及增强模型实时性,构建轻量化PB_Block模块对模型主干网络的P4、P5层模块进行替换,利用PConV[14]仅对特征图部分连续通道进行卷积运算,减少模型的参数量,提高模型的实时性。

(3)采用PIoUv2损失函数优化边界框回归,通过聚焦中质量预测框回归,加快模型训练速度,提高模型处理不同难度样本的泛化能力和准确度。

1 RT-GLV模型

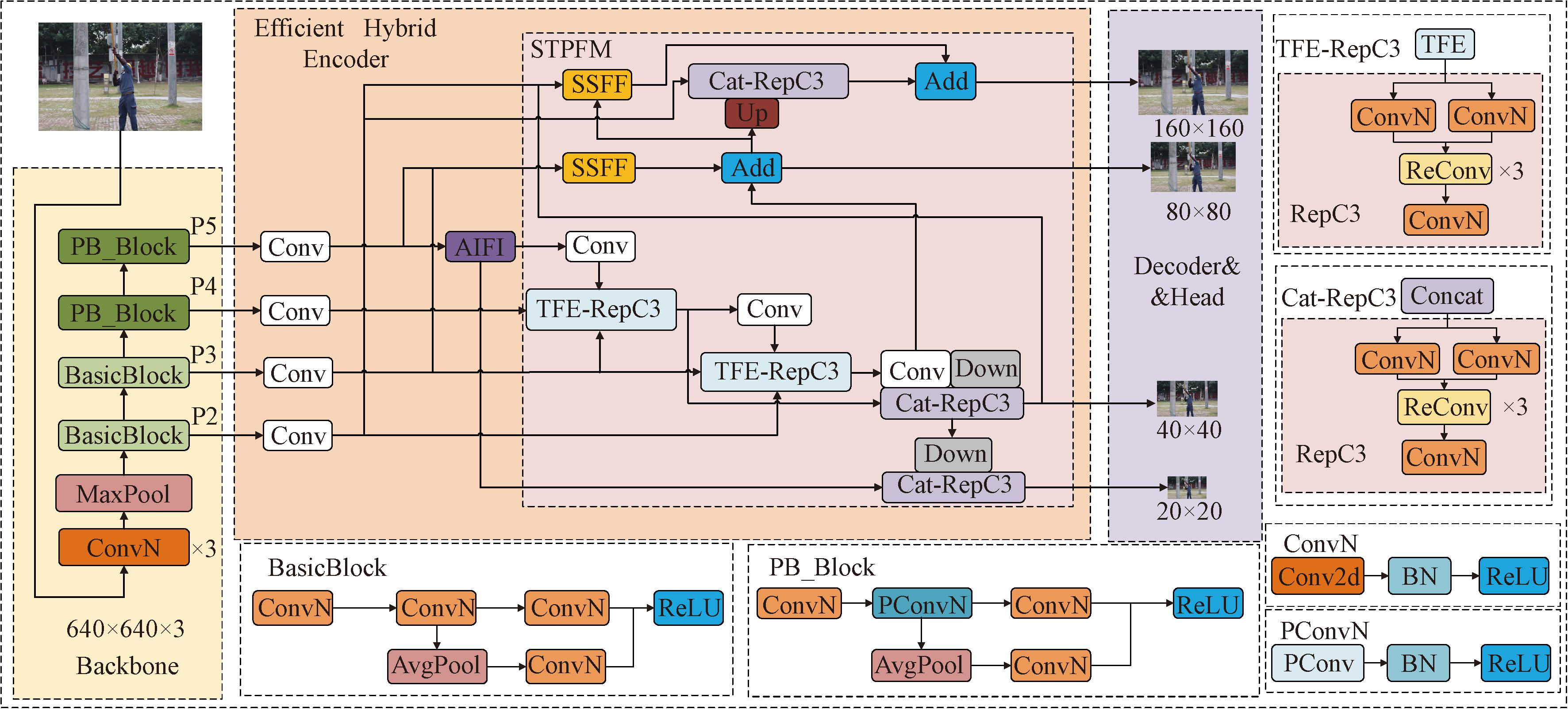

2023年4月,飞桨团队发布最新DETR模型RT-DETR。作为首个端到端实时目标检测器,RT-DETR不需要锚框和NMS后处理,相比传统DETR及其优化版本,有效解决了参数量大、收敛慢的问题,实现了实时性与准确性的平衡。RT-DETR网络结构包括主干网络(Backbone)、高效混合编码器(Efficient Hybrid Encoder)和解码器(Decoder)。主干网络可灵活选择ResNet或HGNet-V2两种类型网络;高效混合编码器通过内尺度交互和跨尺度融合增强多尺度语义信息;解码器通过IoU-Aware查询选择机制,解决样本类别与定位不一致的问题,提高对象查询的准确性。本文提出一种基于RT-DETR-R18改进的电力人员绝缘手套穿戴检测模型RT-GLV,结构如图1所示。

图1 RT-GLV模型结构图

Figure 1 Structure diagram of RT-GLV model

对于输入的电力人员作业图像,RT-GLV采用STPFM网络进行跨尺度融合编码,然后采用轻量化模块PB_Block的主干网络为STPFM网络提取特征图;再将融合后的特征图送入解码器进行解码,并通过IoU-Aware辅助预测检测框的位置和类别;为提升模型对目标边界框的定位精度,引入PIoUv2损失函数替代GIoU损失函数[15],提高模型预测准确性。

1.1 多尺度小目标特征融合网络STPFM

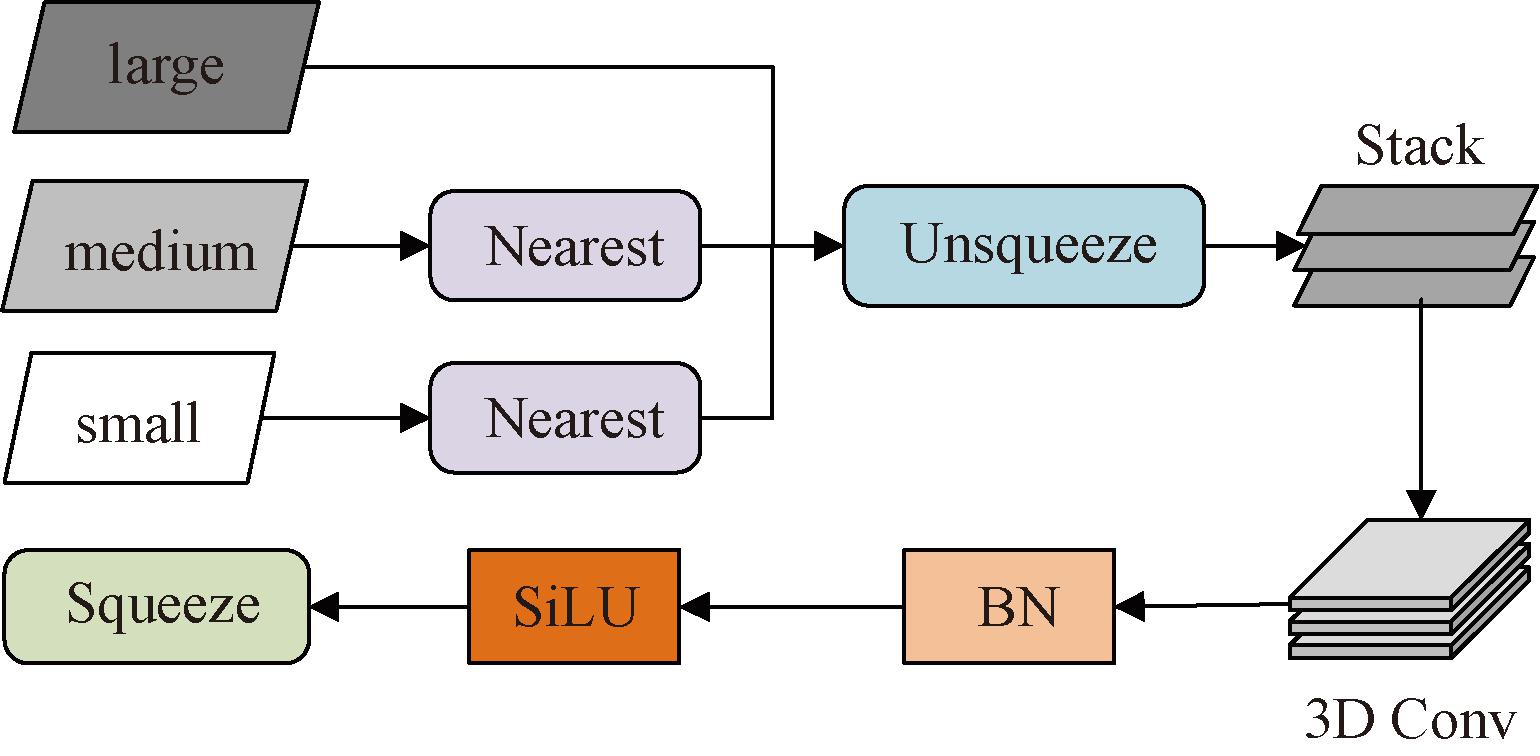

1.1.1 尺度序列特征融合模块SSFF

为缓解模型训练过程中因采样操作造成手部等小目标信息易丢失的问题,本文引入SSFF模块,如图2所示。该模块通过融合多尺度特征图来增强模型的信息提取能力。SSFF首先使用最近邻插值法(Nearest)将较小尺度的特征图进行上采样至同一尺度;然后通过增维操作(Unsqueeze),将原本3D的特征张量(高度,宽度,通道)转换为4D张量格式(深度,高度,宽度,通道);随后沿深度维度堆叠(Stack)形成适用于3D卷积的输入;接下来依次进行3D卷积、3D批量归一化和SiLU激活函数操作,实现对不同尺度特征的有效融合;最后通过降维操作(Squeeze)将4D张量还原为3D张量格式。

图2 SSFF模块结构

Figure 2 Structure of SSFF module

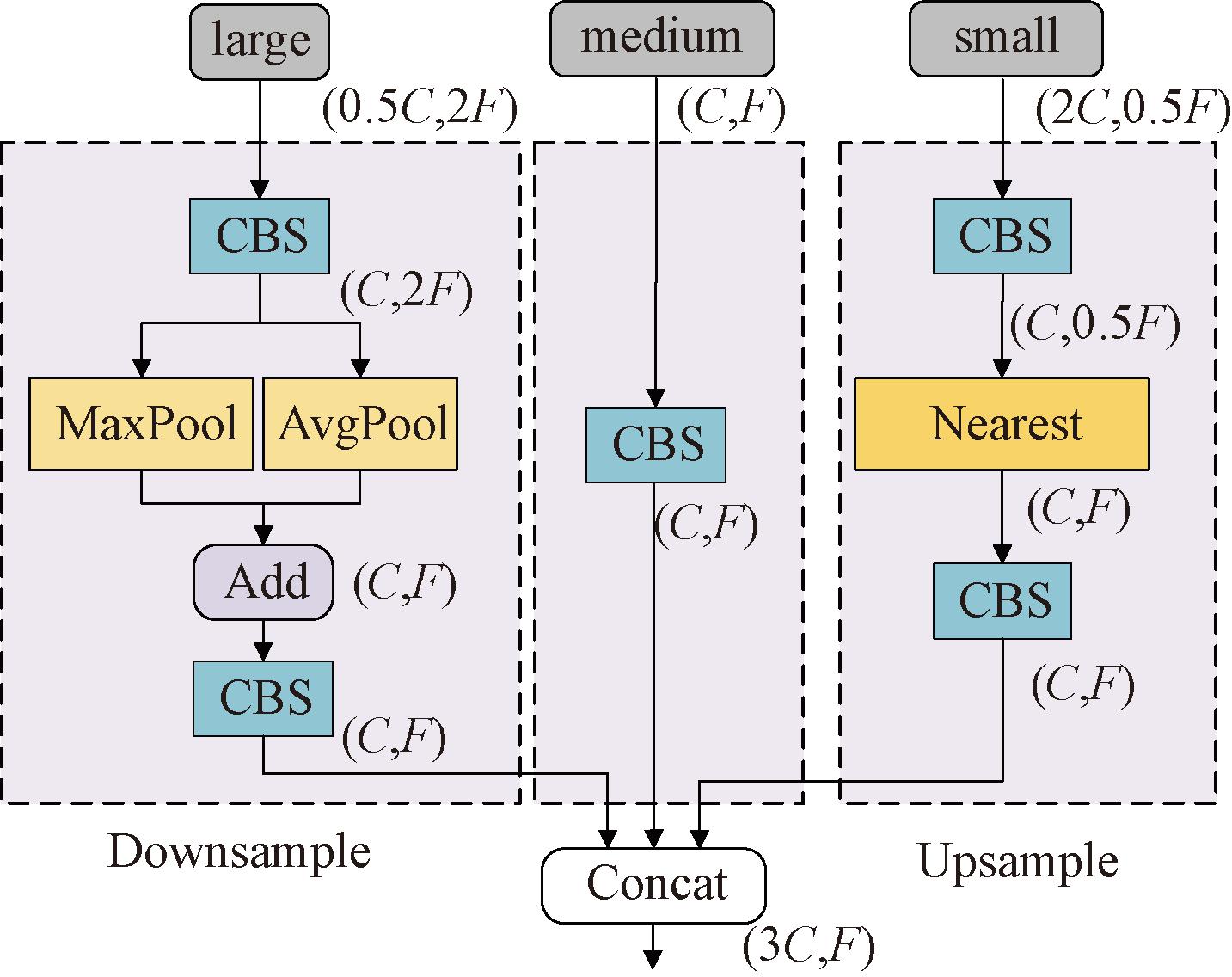

1.1.2 三重特征编码模块TFE

电力作业场景中,作业地点不固定和监控视角固定会导致人体尺度变化,而模型的浅层和深层信息对于捕捉不同尺度的人体特征至关重要。RT-DETR的跨尺度融合仅是将两张相邻尺度的特征图融合,忽略了其他尺度特征图的特征信息。为解决这一问题,本文引入TFE模块,该模块采用三尺度特征融合策略,能够有效整合不同尺度特征图的特征信息,从而提升模型细粒度信息提取能力。如图3所示,TFE模块首先对大尺度特征图进行混合池化(最大池化和平均池化)下采样,使其尺度与中尺度特征图一致,从而保留丰富的局部特征信息并避免小目标特征丢失。同时对小尺度特征图进行最近邻插值上采样,使其尺度也与中尺度特征图匹配,有助于保留全局特征信息。通过这种方式,TFE模块能够充分利用不同尺度特征图的优势,实现更有效的多尺度特征融合。最后3个尺度的特征图沿通道维度进行拼接融合。

图3 TFE模块结构

Figure 3 Structure of TFE module

1.1.3 以SSFF为核心的小目标检测层

通过在RT-DETR中增加小目标检测层[16],利用更小的感受野,增强对小目标细粒度特征提取能力和在特征图上捕捉局部细节信息的能力,从而弥补原始模型在处理不同尺度目标时的差异,最终提高小目标的检测精度,降低误检率和漏检率。主干网络中P2层输出的特征图尺度是输入图片尺度的1/4,蕴含着丰富的浅层表征信息,而在深层网络中蕴含着大量的高级语义信息。通过SSFF模块将浅层表征信息和高级语义信息融合,增强网络捕获小目标语义信息的能力。

具体来说,首先,通过SSFF模块将主干的P2特征图以及在CCFM网络中的P3、P4层特征图进行融合;其次,将CCFM的P3特征图上采样后变为P2特征图大小,再与主干的P2特征图拼接后,传递给RepC3模块计算;最后,将SSFF与RepC3的结果进行相加操作。这种策略使模型同时关注不同尺度的小目标信息,从而有助于模型更有效地捕捉小目标特征信息。

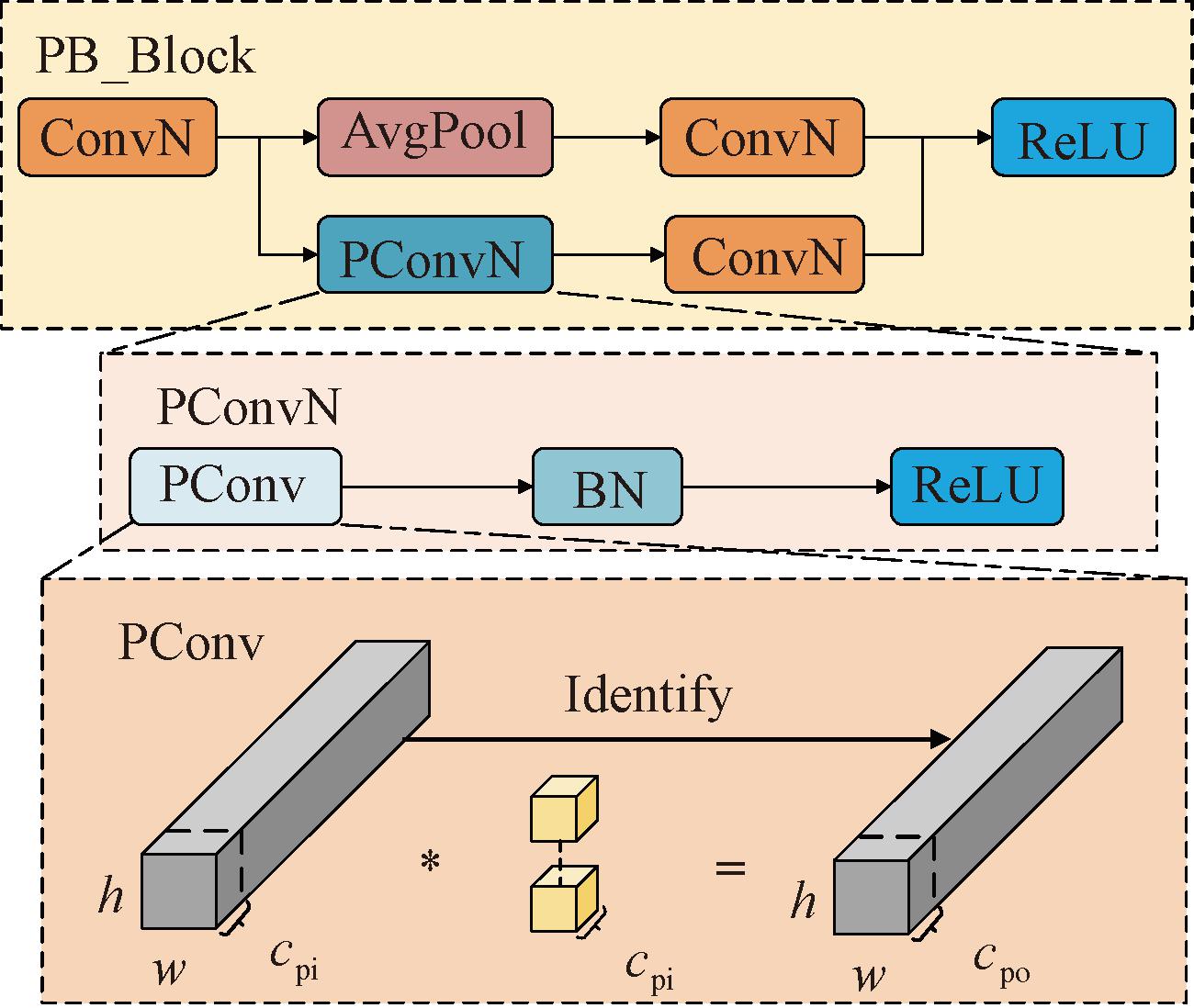

1.2 基于BasicBlock的改进轻量化模块PB_Block

为提升模型对小目标的检测能力,增加小目标检测层虽是有效手段,但也会导致模型参数量显著增加[17],不利于电力人员穿戴检测任务对实时性的要求。因此,本文提出采用PConv模块来改进主干网络的BasicBlock模块,改进后的模块PB_Block如图4所示。PConv轻量化的核心在于利用特征图之间存在高度的相似性,仅对部分通道进行卷积操作。通常选择特征图首端或末端的连续通道,以替代传统对整个特征图的卷积运算。普通卷积、部分卷积参数量计算公式[17]分别为

MConv=co(khkwci+1)≈cohwci;

(1)

MPConv=cpo(khkwcpi+1)≈cpohwcpi。

(2)

图4 PB_Block模块结构

Figure 4 Structure of PB_Block module

式中:h、w分别为卷积核的高和宽;ci、co分别为普通卷积的输入、输出通道数;cpi、cpo分别为部分卷积的输入、输出通道数。部分卷积通道数为普通卷积通道数的1/4,由于输入、输出通道数相等,故部分卷积的参数量为普通卷积的1/16。采用此种策略,不仅能有效缓解模型的计算负担,优化资源利用效率,还能在保证模型性能的前提下,提升其在实际应用中的实时性。

1.3 PIoUv2损失函数

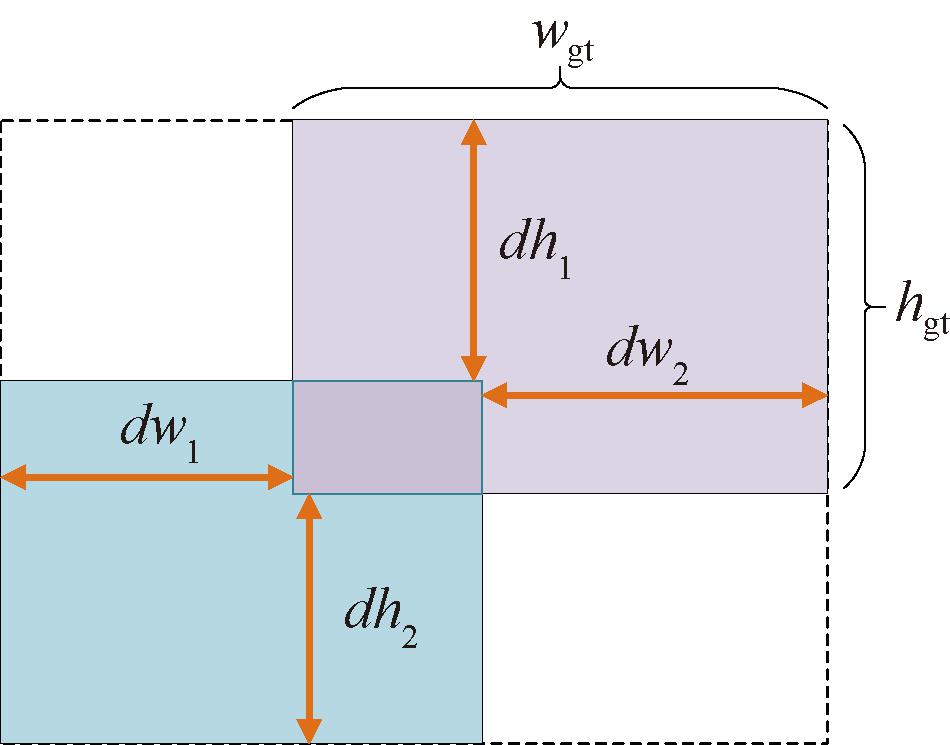

RT-DETR的损失函数GIoU采用目标框与预测框的最小外接矩形框,很好地解决了IoU在目标框与预测框没有重叠部分时模型无法训练的问题。然而,GIoU主要关注目标框与预测框重叠部分的相关变量,并未考虑小目标等难检测样本回归问题。为解决上述问题,本文提出用PIoU(Powerful-IoU)[18]损失函数中的PIoUv2来替换原本的GIoU损失函数。图5为PIoU目标框、预测框和最小外接矩形框的关系图,其中,右上角阴影是目标框,左下角阴影是预测框,虚线框表示最小外接矩形框。

图5 目标框、预测框和最小外接矩形框

Figure 5 Target box,prediction box,and minimum external rectangular box

PIoU的预测框质量惩罚函数的惩罚因子是依据目标框与预测框的各个对应边的距离设计的,反映了预测框与目标框之间的位置关系,可以将预测框分为高、中、低3个等级。其中,中质量预测框在目标检测任务中占据最大的比例,应着重关注。随着训练进程的推进,被关注的中质量预测框变为高质量预测框,而低质量预测框也会向中质量预测框转变,继而被非单调注意力函数关注,推动其向高质量预测框转变,以此提高模型对于难易样本的适应能力。PIoU采取这种策略有助于提高小目标检测的准确率,增强模型的泛化性能。PIoU共有两个版本,PIoUv1是基于预测框质量惩罚函数设计的;PIoUv2是在PIoUv1的基础上增加非单调注意力函数。本文最终选择PIoUv2来替换原本的GIoU损失函数。

PIoUv1损失函数的LPIoUv1为

LPIoUv1=LIoUf(P)+1-e-P2,LPIoUv1∈[0,2];

(3)

(4)

f(P)=1-e-P2。

(5)

式中:P为预测框的质量;预测框惩罚函数f(P)根据预测框的质量调整惩罚力度,使预测框回归更加有效。

为使模型进一步注重占据最大比例的中质量预测框,提升模型性能,PIoUv2引入非单调注意力函数,损失函数LPIoUv2为

LPIoUv2=u(λq)LPIoUv1;

(6)

u(λq)=3λqe-λq2;

(7)

q=e-P,q∈(0,1]。

(8)

式中:q为代替P的惩罚因子,当q=1时P=0,意味着边界框与目标框完全重叠,当P变大时,q变小,表示边界框质量低;u(λq)为非单调注意力函数,用于增强对中质量预测框的关注;λ为超参数。

2 算法性能评估

2.1 数据集及实验环境

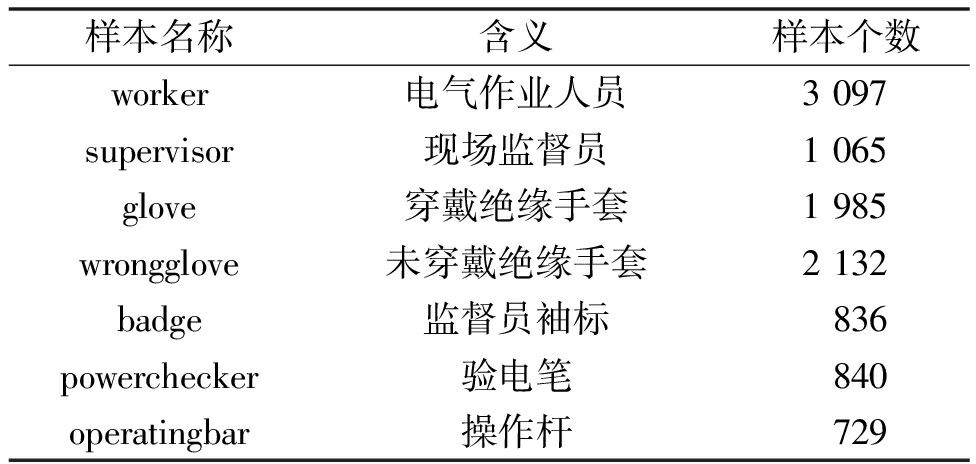

本文数据集来自广东智慧电网现场作业挑战赛的绝缘手套数据集,共2 821张图片,利用LabelImg软件进行人工标注,并以txt文件格式输出。数据集被划分为训练集2 030张、验证集508张和测试集283张,共包含7类标签,具体样本名称及解释如表1所示。其中,未穿戴绝缘手套包括徒手和穿戴针织手套。

表1 绝缘手套数据集样本划分说明

Table 1 Insulating gloves data set sample division description

样本名称含义样本个数worker电气作业人员3097supervisor现场监督员1065glove穿戴绝缘手套1985wrongglove未穿戴绝缘手套2132badge监督员袖标836powerchecker验电笔840operatingbar操作杆729

本文训练模型时采用Windows操作系统,CPU为Inter Core i9-14900K,内存64 GB,GPU为RTX 4090D 24 G,深度学习框架为PyTorch2.0.1,CUDA Version为11.8。输入图片设置为640×640像素,批次为4,训练轮数为150,优化器为AdamW。

2.2 实验评价指标

本文选用F1分数、平均均值精度(mAP)、参数量和帧率作为模型性能的评价指标,计算公式为

(9)

(10)

(11)

AP=![]() P(R)dR;

P(R)dR;

(12)

(13)

式中:TP表示预测为正类的正样本;FP表示预测为正类的负样本;FN表示预测为负类的正样本;P为精确度;R为召回率;F1分数为精确率和召回率的调和平均数;N为类别的个数;AP为单类别平均精度;mAP为所有类别AP的均值。本文的AP@0.5、mAP@0.5分别表示IoU阈值为0.5时的AP、mAP。

2.3 RT-GLV模型各改进部分有效性验证

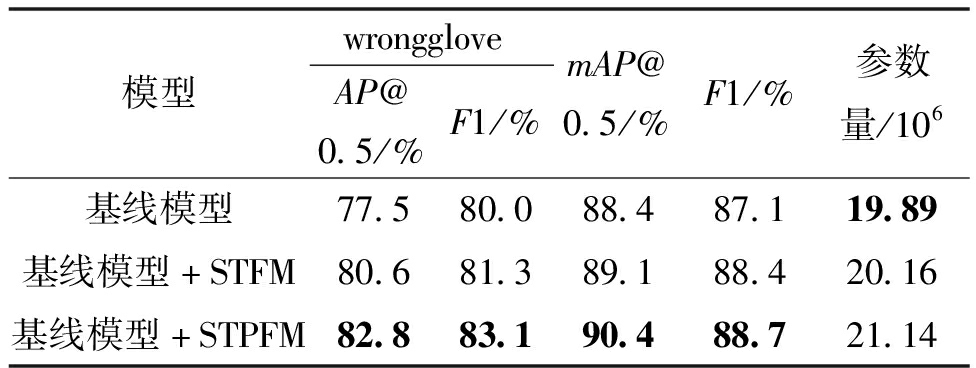

2.3.1 CCFM改进有效性验证

本文采用SSFF模块和TFE模块对CCFM网络进行改进(命名为STFM),在此基础上增加小目标检测层(命名为STPFM)。为验证STPFM在小目标检测上的效果,与RT-DETR-R18基线模型进行对比实验,结果如表2所示。由表2可知,相较于基线模型,STFM改进模型中未穿戴绝缘手套的AP@0.5和F1分数分别提升3.1百分点和1.3百分点,STPFM改进模型中未穿戴绝缘手套的AP@0.5和F1分数分别提升5.3百分点和3.1百分点;相较于STFM改进模型,STPFM改进模型中未穿戴绝缘手套的AP@0.5和F1分数分别提升2.2百分点和1.8百分点,且STPFM改进模型的mAP@0.5和F1分数均为最高,表明STPFM网络的小目标检测性能更优。

表2 CCFM网络改进对比

Table 2 Comparison of CCFM network improvement

模型wronggloveAP@0.5/%F1/%mAP@0.5/%F1/%参数量/106基线模型77.580.088.487.119.89基线模型+STFM80.681.389.188.420.16基线模型+STPFM82.883.190.488.721.14

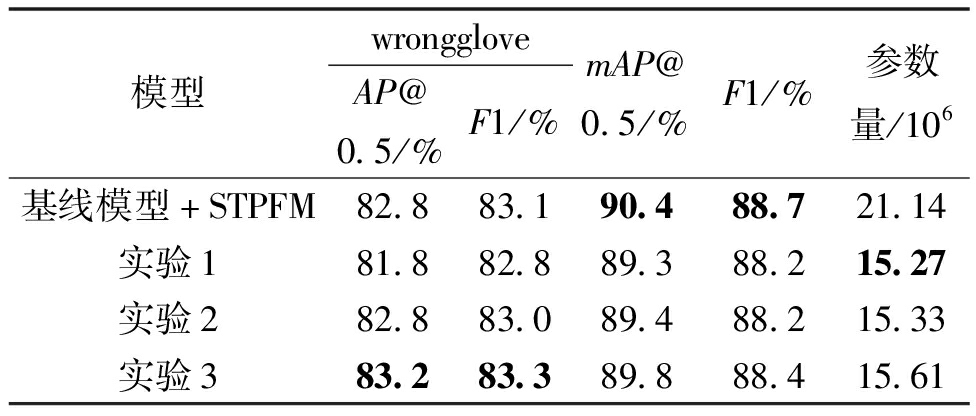

2.3.2 PB_Block模块改进位置有效性验证

为验证PB_Block模块对主干网络不同层级轻量化的影响,在STPFM改进模型的基础上进行3组对比实验,分别对主干网络的P2~P5层(实验1)、P3~P5层(实验2)和P4、P5(实验3)层进行轻量化改进,结果如表3所示。由表3可知,相较于STPFM改进模型,实验1的参数量减少了27.8%,但mAP@0.5、F1分数、未穿戴绝缘手套的AP@0.5和F1分数4个指标都有所降低;实验2的参数量减少了27.5%,mAP@0.5、F1分数有所降低,而未穿戴绝缘手套的AP@0.5和F1分数变化不大;实验3的参数量减少了26.2%,mAP@0.5、F1分数略微降低,但未穿戴绝缘手套的AP@0.5和F1分数分别提高了0.4百分点和0.2百分点。对比分析3组实验结果可知,实验3虽然在参数量轻量化方面略差于前两组,但在mAP@0.5和F1分数上的性能损失最小,且在未穿戴绝缘手套的AP@0.5和F1分数上还得到轻微的提升。综合考虑,选择对主干网络的P4、P5层进行轻量化改进。

表3 PB_Block模块改进位置对比

Table 3 Comparison of improved position of PB_Block module

模型wronggloveAP@0.5/%F1/%mAP@0.5/%F1/%参数量/106基线模型+STPFM82.883.190.488.721.14实验181.882.889.388.215.27实验282.883.089.488.215.33实验383.283.389.888.415.61

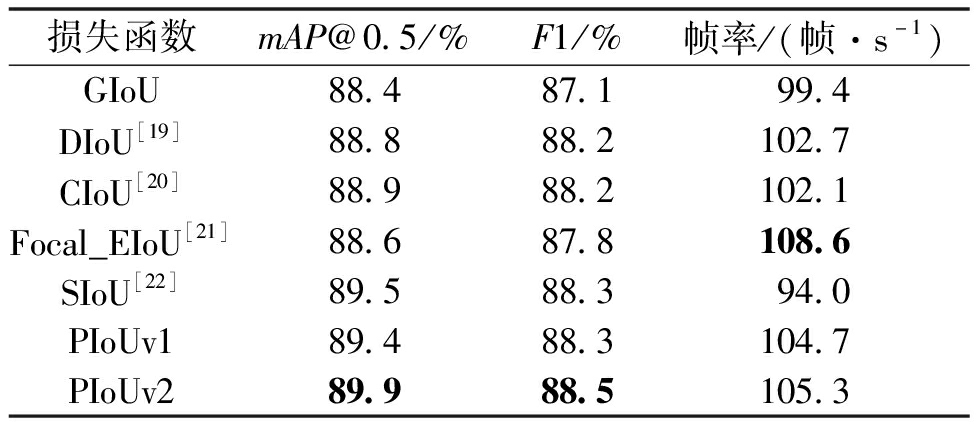

2.3.3 损失函数替换有效性验证

为验证PIoUv2损失函数的有效性,将其与GIoU、DIoU[19]、CIoU[20]、Focal_EIoU[21]、SIoU[22]、PIoUv1等损失函数进行实验对比,结果如表4所示。由表4可知,PIoUv2损失函数相较于其他损失函数在mAP@0.5、F1分数两个指标上均最高,帧率也较高,因此采用PIoUv2损失函数的RT-DETR模型在目标检测任务中能对目标物体实现置信度高的预测与有效定位。

表4 损失函数对比

Table 4 Comparison of loss functions

损失函数mAP@0.5/%F1/%帧率/(帧·s-1)GIoU88.487.199.4DIoU[19]88.888.2102.7CIoU[20]88.988.2102.1Focal_EIoU[21]88.687.8108.6SIoU[22]89.588.394.0PIoUv189.488.3104.7PIoUv289.988.5105.3

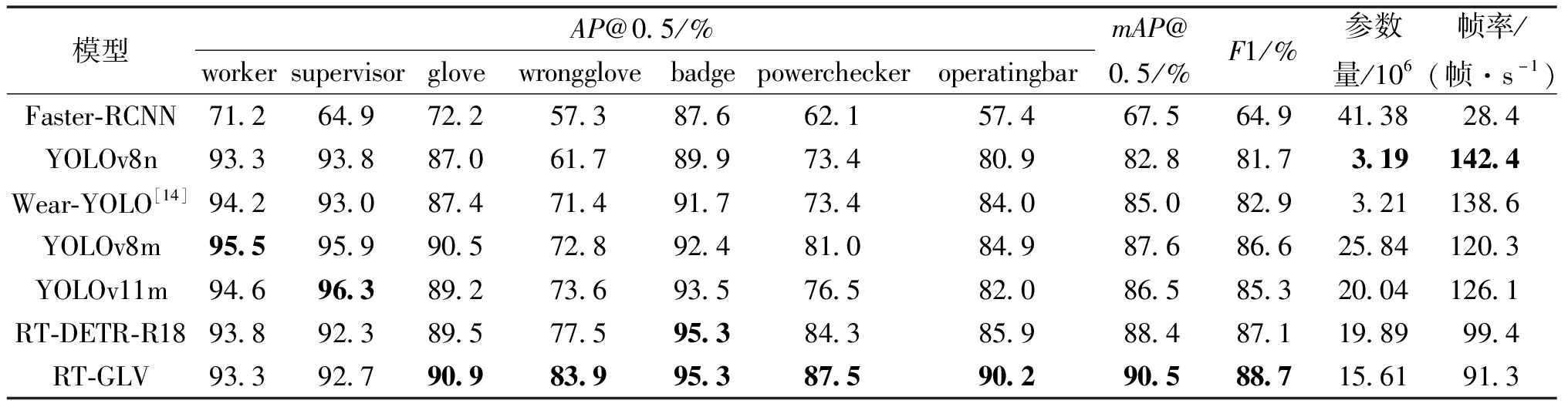

2.4 与其他模型的性能对比

为验证本文改进算法性能,同其他主流的目标检测算法模型进行对比实验。保持同一实验条件并采用官方默认超参数进行对比实验,结果如表5所示。由表5可知,本文的RT-GLV模型相较于RT-DETR-R18参数量减少21.5%,mAP@0.5提高2.1百分点,F1分数提高1.6百分点,穿戴绝缘手套的AP@0.5提高1.4百分点,未穿戴绝缘手套的AP@0.5提高6.4百分点;相较于Faster-RCNN、YOLOv8m和YOLOv11m等较大模型,RT-GLV在参数量方面优势明显,mAP@0.5、F1分数均有提高,未穿戴绝缘手套的AP@0.5分别提升26.6百分点、11.1百分点和10.3百分点;相较于YOLOv8n、Wear-YOLO等较小模型,RT-GLV的mAP@0.5、F1分数和未穿戴绝缘手套的AP@0.5都有较大提高。由实验结果对比可知,本文的RT-GLV模型相较于其他模型在各类目标物体检测精度方面表现更优,尤其小目标检测结果更为可靠,虽然检测速度为91.3 帧/s低于YOLO系列模型,但也能满足实时检测的要求。

表5 RT-GLV与其他算法对比实验结果

Table 5 Test results of RT-GLV compared with other algorithms

模型AP@0.5/%workersupervisorglovewrongglovebadgepowercheckeroperatingbarmAP@0.5/%F1/%参数量/106帧率/(帧·s-1)Faster-RCNN71.264.972.257.387.662.157.467.564.941.3828.4YOLOv8n93.393.887.061.789.973.480.982.881.73.19142.4Wear-YOLO[14]94.293.087.471.491.773.484.085.082.93.21138.6YOLOv8m95.595.990.572.892.481.084.987.686.625.84120.3YOLOv11m94.696.389.273.693.576.582.086.585.320.04126.1RT-DETR-R1893.892.389.577.595.384.385.988.487.119.8999.4RT-GLV93.392.790.983.995.387.590.290.588.715.6191.3

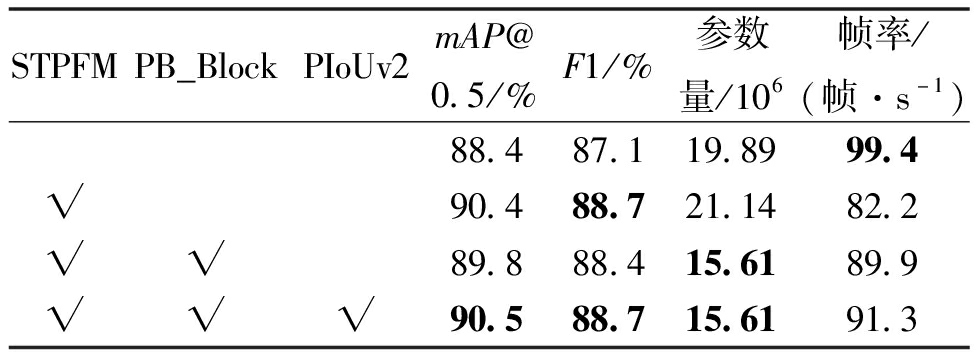

2.5 消融实验

为验证改进的各个部分对模型性能的影响,本文对RT-GLV模型进行消融实验。首先,在模型的高效混合编码器部分采用改进的STPFM网络;然后,采用改进的PB_Block模块对主干网络的P4、P5层进行轻量化改进;最后,将GIoU损失函数替换为PIoUv2损失函数,实验结果如表6所示。由表6可知,与基准模型RT-DETR-R18相比,替换成STPFM网络后mAP@0.5和F1分数有所提升,但参数量增加6.3%,帧率降低17.3%;在此基础上采用PB_Block模块后,mAP@0.5和F1分数略微降低,但参数量减少26.2%,帧率提高9.4%;继续将损失函数替换为PIoUv2后,mAP@0.5、F1分数和帧率分别提高0.7百分点、0.3百分点、1.6%;最终的RT-GLV模型相较于基准模型RT-DETR-R18,mAP@0.5和F1分数分别提高2.1百分点、1.6百分点,参数量减少21.5%,帧率降低8.1%,但也能满足实时检测的要求,证明了本文各改进模块的有效性。

表6 RT-GLV模型消融实验

Table 6 Ablation experiments of RT-GLV model

STPFMPB_BlockPIoUv2mAP@0.5/%F1/%参数量/106帧率/(帧·s-1)88.487.119.8999.4√90.488.721.1482.2√√89.888.415.6189.9√√√90.588.715.6191.3

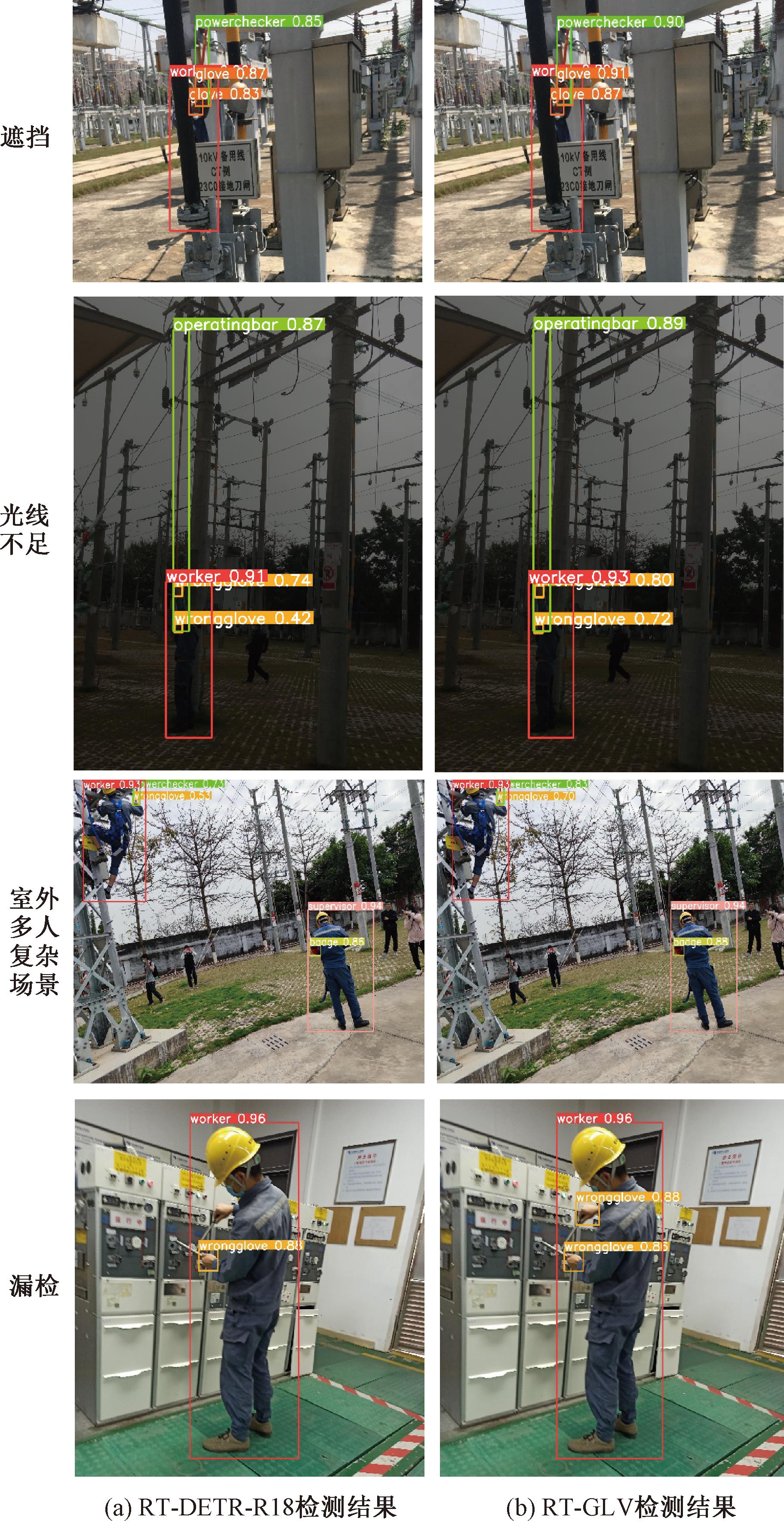

2.6 可视化分析

为直观了解本文改进的RT-GLV模型在电力人员绝缘手套检测任务的效果,将其在测试集上进行测试,图6为RT-DETR-R18与RT-GLV检测结果对比图。从图6可以看出,本文在有遮挡情况下,两只手穿戴绝缘手套的检测精度均有提升,表明本文模型在有遮挡情况下的检测结果更优;在光线不足的情况下,两只手未穿戴绝缘手套的检测精度有较大提升,其他类别也略有提升,表明本文模型的鲁棒性有进一步提升;在室外多人复杂场景下,未穿戴绝缘手套和验电笔的检测精度提升较大,表明本文模型在小目标检测表现更优;RT-DETR-R18出现漏检情况,而RT-GLV却能高精度地检测出,表明本文模型能更好地减少漏检情况。综上所述,本文模型在多种场景下能更准确地检测手部等小目标特征信息,为电力人员绝缘手套穿戴检测提供更可靠的依据。

图6 检测结果对比

Figure 6 Comparison of detection results

3 结论

为及时识别并纠正违规操作,有效降低安全事故风险、减少人员伤亡及经济损失,本文提出一种基于深度学习的变电站电力人员绝缘手套穿戴检测模型RT-GLV。STPFM网络使模型能更好地学习小目标的位置和特征信息;PB_Block模块对主干网络P4、P5层进行轻量化改进,改进后模型既能达成模型轻量化任务又能避免损害模型小目标检测能力;模型的损失函数替换为PIoUv2,引入基于目标尺度的惩罚因子和非单调注意力函数,增强模型的泛化能力,提高模型对难易样本适应能力。实验结果表明,RT-GLV模型在检测电力人员绝缘手套穿戴的任务中,检测精度高,模型参数量少,检测速度也能达到实时检测的要求,为电力人员安全作业提供了一种有效的检测方法。

[1] 李强,赵峰,李博强,等.改进的Faster R-CNN算法及其在电力作业安全穿戴检测中的应用[J].武汉大学学报(工学版),2024,57(4):462-469.LI Q,ZHAO F,LI B Q,et al.Improved Faster R-CNN algorithm and its application in power work safety wearing detection[J].Engineering Journal of Wuhan University,2024,57(4):462-469.

[2] 方明,张娇,徐晶,等.基于改进YOLOv8的轻量化皮革缺陷检测方法[J].电子测量技术,2025,48(1):111-118.FANG M,ZHANG J,XU J,et al.Lightweight leather defect detection method based on improved YOLOv8[J].Electronic Measurement Technology,2025,48(1):111-118.

[3] 李华,薛曦澄,吴立舟,等.深度学习下吊装作业工人防护装备及吊钩检测方法[J].安全与环境学报,2024,24(3):1027-1035.LI H,XUE X C,WU L Z,et al.Protective equipment and hook testing methods for workers in lifting operations under deep learning[J].Journal of Safety and Environment,2024,24(3):1027-1035.

[4] 崔铁军,郭大龙.基于改进YOLOX的变电站工人防护设备检测研究[J].中国安全生产科学技术,2023,19(4):201-206.CUI T J,GUO D L.Research on detection of protection equipment for substation workers based on improved YOLOX[J].Journal of Safety Science and Technology,2023,19(4):201-206.

[5] 张曼,孙凯军,李翔,等.融合FasterNet和RepVGG的安全设备佩戴检测方法[J].山东大学学报(工学版),2024,54(6):19-28.ZHANG M,SUN K J,LI X,et al.A security device wearing detection method integrating FasterNet and RepVGG[J].Journal of Shandong University (Engineering Science),2024,54(6):19-28.

[6] 刘甜甜,彭放,卢伟龙,等.基于YOLOv7的智能电网外部安全帽佩戴风险因素识别与检测[J].电测与仪表,2024,61(12):42-48.LIU T T,PENG F,LU W L,et al.Identification and detection of external risk factors for safety helmet wearing in smart grid based on YOLOv7[J].Electrical Measurement &Instrumentation,2024,61(12):42-48.

[7] WANG M L,QIU H T,WANG J R.Helmet detection algorithm based on lightweight improved YOLOv8[J].Signal,Image and Video Processing,2024,19(1):1-13.

[8] 谢国波,肖峰,林志毅,等.复杂作业场景下的反光衣和安全帽检测方法[J].安全与环境学报,2024,24(9):3513-3521.XIE G B,XIAO F,LIN Z Y,et al.Method for detecting reflective vests and safety helmets in complex operational environments[J].Journal of Safety and Environment,2024,24(9):3513-3521.

[9] 张学立,贾新春,王美刚,等.安全帽与反光衣的轻量化检测:改进YOLOv5s的算法[J].计算机工程与应用,2024,60(1):104-109.ZHANG X L,JIA X C,WANG M G,et al.Lightweight detection of helmets and reflective clothings:improved YOLOv5s algorithm[J].Computer Engineering and Applications,2024,60(1):104-109.

[10] 郑海洋,宋纯贺,武婷婷,等.面向绝缘手套佩戴状况检测的小目标检测与匹配算法[J].小型微型计算机系统,2023,44(9):1989-1995.ZHENG H Y,SONG C H,WU T T,et al.Small target detection and matching algorithm for wearing condition detection of insulating gloves[J].Journal of Chinese Computer Systems,2023,44(9):1989-1995.

[11] 王茹,刘大明,张健.Wear-YOLO:变电站电力人员安全装备检测方法研究[J].计算机工程与应用,2024,60(9):111-121.WANG R,LIU D M,ZHANG J.Wear-YOLO:research on detection methods of safety equipment for power personnel in substations[J].Computer Engineering and Applications,2024,60(9):111-121.

[12] CARION N,MASSA F,SYNNAEVE G,et al.End-to-end object detection with transformers[C]∥ European Conference on Computer Vision.Cham:Springer,2020:213-229.

[13] KANG M,TING C M,TING F F,et al.ASF-YOLO:a novel YOLO model with attentional scale sequence fusion for cell instance segmentation[J].Image and Vision Computing,2024,147:105057.

[14] CHEN J R,KAO S H,HE H,et al.Run,don′t walk:chasing higher FLOPS for faster neural networks[C]∥2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).Piscataway:IEEE,2023:12021-12031.

[15] REZATOFIGHI H,TSOI N,GWAK J,et al.Generalized intersection over union:a metric and a loss for bounding box regression[C]∥2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).Piscataway:IEEE,2019:658-666.

[16] 张鹏,石丽芬,陈子阳,等.基于多层卷积融合的红外小目标检测算法(特邀)[J].激光与光电子学进展,2024,61(16):1611014.ZHANG P,SHI L F,CHEN Z Y,et al.Infrared small target detection via multi-layer convolution fusion(invited)[J].Laser &Optoelectronics Progress,2024,61(16):1611014.

[17] 王新蕾,王硕,翟嘉政,等.多任务联合学习下的复杂天气航拍图像目标检测算法[J].计算机工程与应用,2025,61(2):97-111.WANG X L,WANG S,ZHAI J Z,et al.Object detection algorithm of aerial image in complex weather based on multi-task joint learning[J].Computer Engineering and Applications,2025,61(2):97-111.

[18] LIU C,WANG K G,LI Q,et al.Powerful-IoU:More straightforward and faster bounding box regression loss with a nonmonotonic focusing mechanism[J].Neural Networks,2024,170:276-284.

[19] ZHENG Z H,WANG P,LIU W,et al.Distance-IoU loss:faster and better learning for bounding box regression[EB/OL].(2019-11-19)[2025-03-08].https:∥arxiv.org/abs/1911.08287.

[20] ZHENG Z H,WANG P,REN D W,et al.Enhancing geometric factors in model learning and inference for object detection and instance segmentation[J].IEEE Transactions on Cybernetics,2022,52(8):8574-8586.

[21] ZHANG Y F,REN W Q,ZHANG Z,et al.Focal and efficient IOU loss for accurate bounding box regression[J].Neurocomputing,2022,506:146-157.

[22] GEVORGYAN Z.SIoU loss:more powerful learning for bounding box regression[EB/OL].(2022-05-25)[2025-03-08].https:∥arxiv.org/abs/2205.12740v1.