遗留物品检测作为智能视频监控系统的核心功能模块,在公共安全、生产安全和安防等领域中扮演着重要角色。燃气生产行业(如天然气分输场站)对工人的作业行为和现场物品管理有着严格要求,工人遗留的工具(如防爆扳手、螺丝刀等)可能被其他人员误触或人员被绊倒,导致人员受伤或设备损坏,而且疏散通道遗留的小型运输车辆在发生事故时严重影响人员撤离。因此,针对遗留物品检测的研究具有重大意义。

目标检测是计算机视觉的基本任务,当前主流的目标检测算法是基于深度学习的目标检测算法,分为单阶段目标检测算法和双阶段目标检测算法。双阶段目标检测算法首先是Girshick等[1]提出的R-CNN,该算法先根据图像提取候选框,然后基于候选区域做二次修正得到检测结果,检测精度较高,但检测速度较慢,难以达到实时处理效果。单阶段目标检测算法直接生成检测结果,虽然检测速度快,但检测精度低,这类算法有YOLO[2]、SSD[3]、FCOS[4]等。

国内外学者对遗留物品检测技术探索出了不同的研究方案。传统遗留物品检测算法多使用背景减法,Lin等[5]结合短期和长期背景模型来提取前景对象,将输入图像中的每个像素分为不同的状态,随后引入一个基于状态转换的静态前景区域识别框架,并通过分析遗留物品拥有者的回溯轨迹来确定候选区域是否包含遗留物品。Su等[6]利用时域中值滤波和时域最小值滤波分别提取前景目标和静态目标,同时提出了一种基于梯度的图像处理算法来消除夜间车灯的干扰,该方法可以在短时间内检测出遗留物品。Russel等[7]使用基于深度特征构建的先验模型检索前景目标,同时利用核典型相关分析和余弦相似度指数的深度特征来跟踪行人,为被跟踪者生成步态能量图以判断其所携带行李的状态。传统遗留物品检测算法难以应对人流拥挤、小目标、物品遮挡和光线变化等环境。近年来也有不少学者使用深度学习的方法。Park等[8]结合双背景模型和mask R-CNN,考虑当前和过去的掩码信息,检查当前视频帧或前一背景帧中是否存在相应的分割对象,但这样无法达到对视频帧的实时处理。Liu等[9]使用YOLO检测器来检测监控视频中行人通过场景前后的关键帧,并对关键帧进行了比较和分析,以获得遗留物品的位置。蒋晓可[10]使用YOLOv5和双背景模型检测前景目标,然后使用DeepSort算法跟踪前景目标,根据目标运动特点将物品与所属者进行配对,物品失配时将被识别为遗留物品。以上文献使用的YOLO系列算法的精度是有提升空间的。林德钰等[11]首先利用高斯混合模型背景建模进行前景检测,根据移动区域与静止区域的分离距离与时间得到可疑静止区域,然后将判定为分离时刻的帧图像传入轻量化的YOLO-G模型进行检测与识别,但该模型的参数量较高。

综上所述,为了实现更高的检测精度和相对较低的模型参数量,本文提出了一种改进的YOLOv8算法用于实时检测监控视频中的遗留物品。首先,使用动态上采样DySample替换原来的最近邻上采样,优化了上采样过程,增加了模型的泛化能力。其次,引入高效轻量的ADown模块缓解模型过拟合,不仅降低了模型参数量和计算量,还提升了算法的准确率。此外,引入一种高效的多尺度注意力机制EMA,对目标检测和特征提取过程进行优化,从而更好地提取行为特征,提升对小目标检测的效果。

1 YOLOv8模型

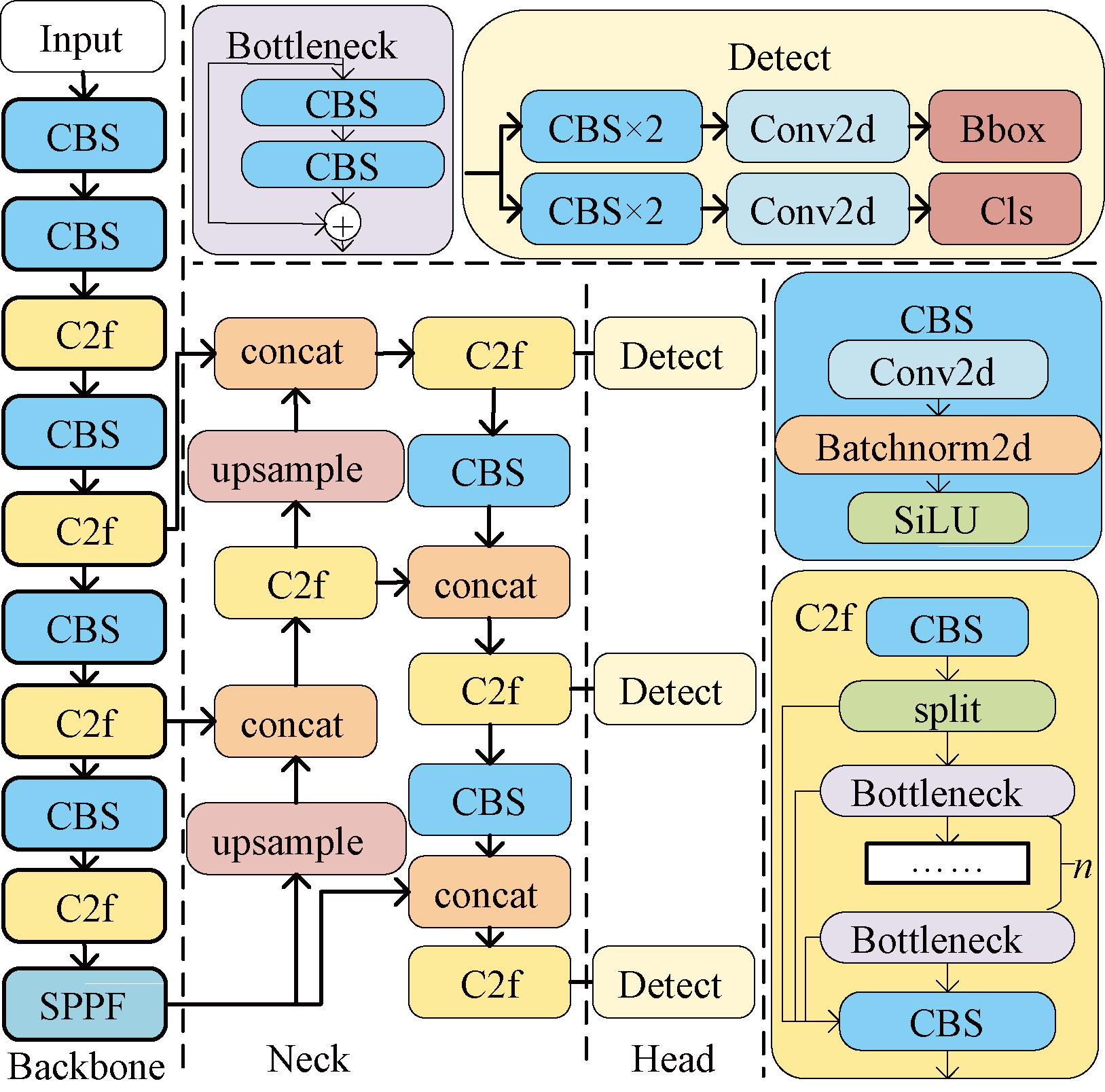

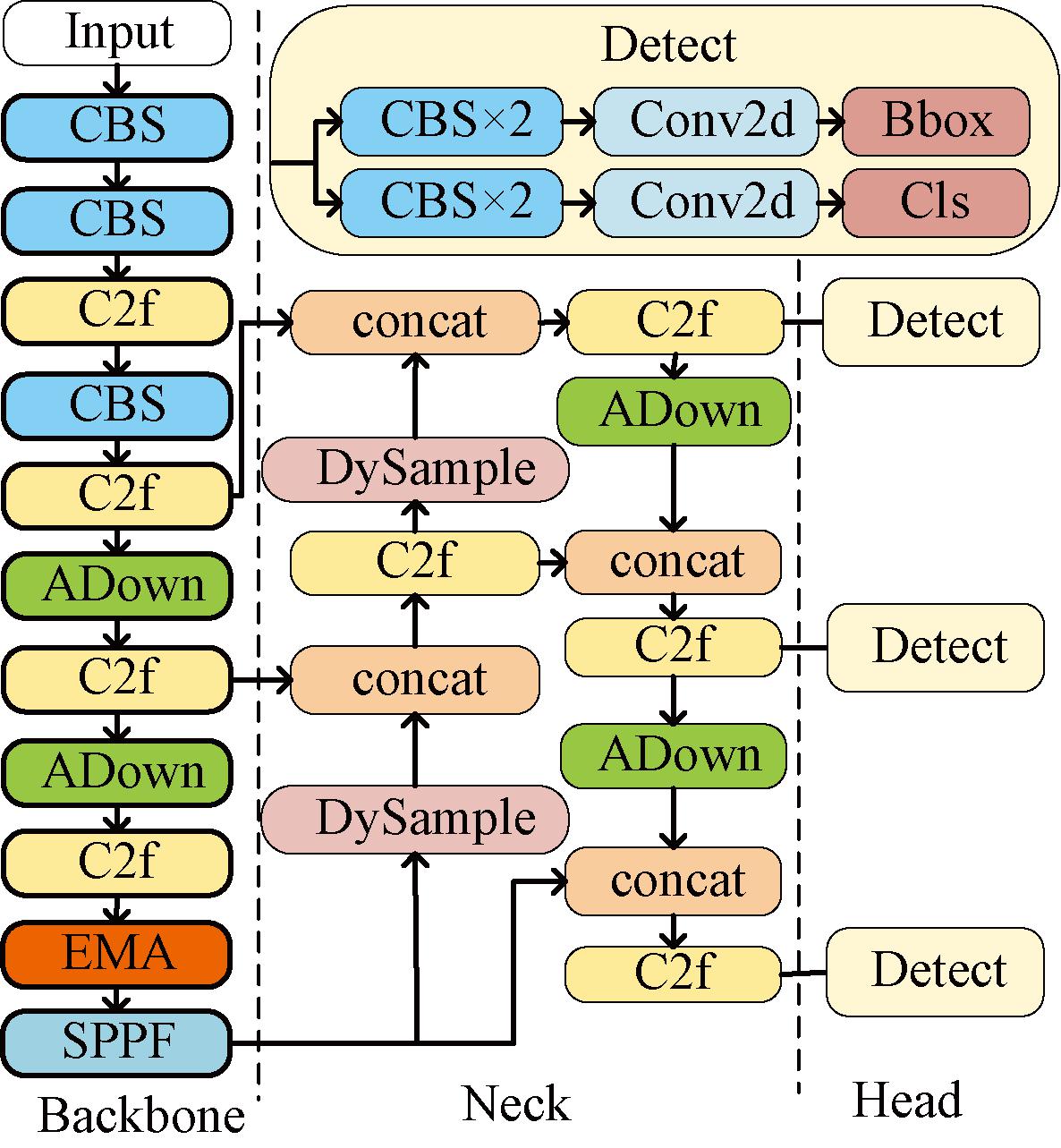

YOLOv8[12]是在YOLOv5[13]的基础上改进而来的,二者都是Ultralytics开源的实时目标检测算法。图1展示了YOLOv8模型结构及其模块,该算法数据预处理采用了马赛克增强、混合增强和空间扰动等。与YOLOv5不同的是,YOLOv8在整个网络中使用梯度流信息更丰富的C2f模块替代C3,Head部分替换成了解耦头结构,将分类和检测头分离,同时也从anchor-based换成了anchor-free。损失计算方面采用了task aligned assigner[14]正样本分配策略,根据分类与回归加权的分数选择正样本,其中分类损失使用了二值交叉熵(binary cross-entropy,BCE)损失,回归损失中引入了distribution focal loss[15],让网络快速聚焦到标签附近的数值,使标签处的概率密度尽量大。训练阶段的数据增强部分在最后10个epoch关闭马赛克数据增强的操作,可以有效地提升精度。Neck部分依然是采用PAN+FPN结构,充分将深层的语义特征和浅层特征融合,增强多个尺度上的语义信息。Backbone部分依旧使用了快速空间金字塔池化(spatial pyramid pooling fast,SPPF)模块,SPPF使用3个5×5的最大池化代替SPP的5×5,9×9,13×13最大池化操作,使用较小的卷积核能够提升计算速度。YOLOv8算法适合在工业场景中应用,容易部署,在保持较小参数量的同时能达到较高的精度。YOLOv8官方提供了n、s、m、l、x尺度的不同大小模型,本文采用YOLOv8s作为基础模型。

图1 YOLOv8模型结构

Figure 1 Structure of YOLOv8 model

2 模型改进

2.1 DySample模块

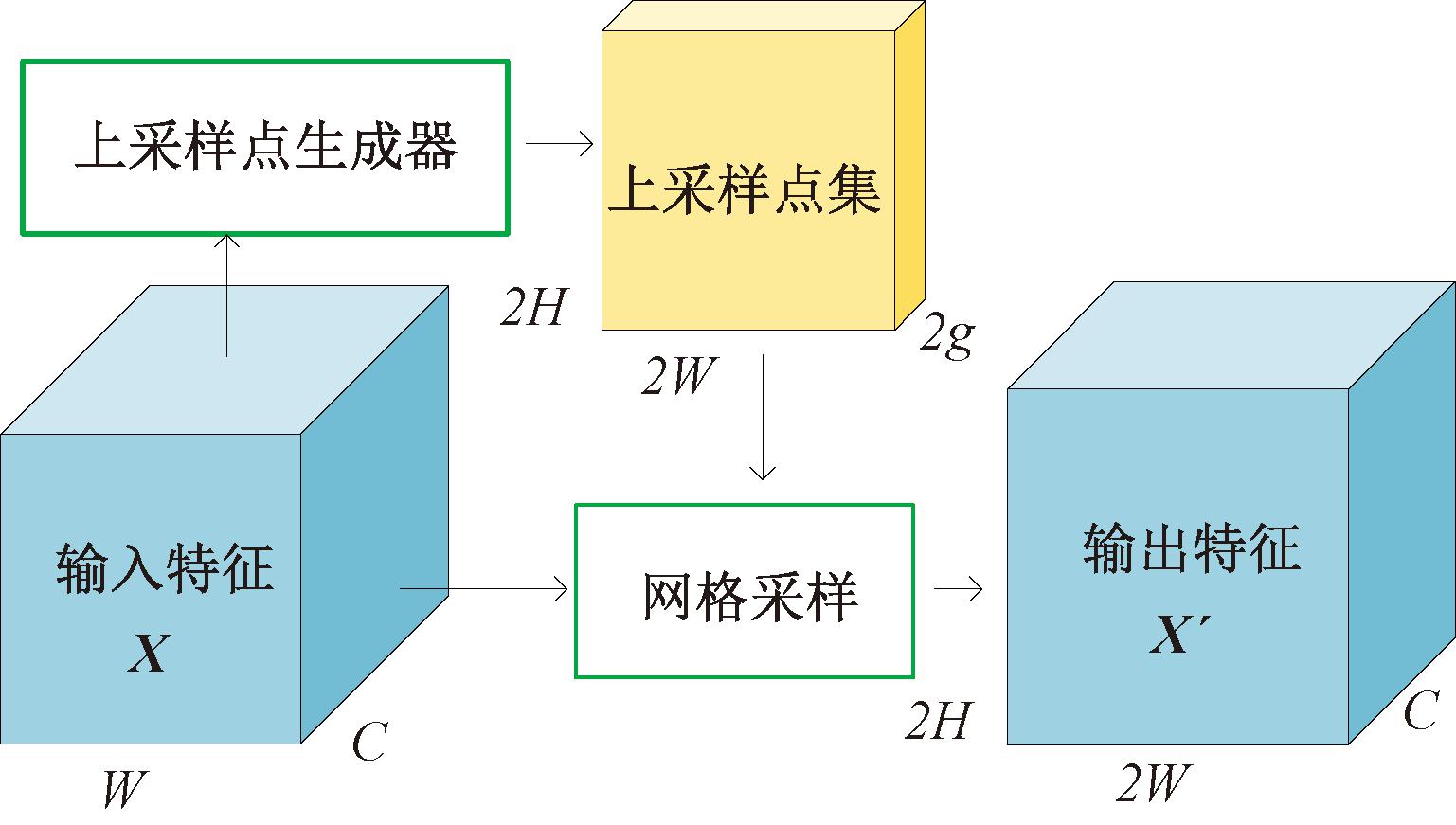

DySample是Liu等[16]提出的一种高效、轻量的动态上采样算子。其过程如图2所示,首先从输入的特征图X中学习到上采样点集,然后利用该点集对原特征图进行网格采样得到输出特征图X′。

图2 动态上采样流程图

Figure 2 Dynamic upsampling flowchart

上采样点就是上采样后的特征图中每个点在原特征图中的采样坐标。图2中g表示原始特征图的组数,同组特征共享相同的采样点集,图3展示了该坐标的生成过程。采样点集由原始网格和偏移量相加而成,偏移量有两种生成方式:静态调节方式首先从原始特征图中学习得到调节前偏移量,然后乘以静态调节因子0.25调整其大小,通过Pixel Shuffle操作上升到原始网格的维度;动态调节方式的差别在于调节因子不同,其调节因子是从原始特征图中学习,并经过Sigmoid函数然后乘以0.5得到的。

图3 采样点生成器

Figure 3 Sampling point generator

YOLOv8中使用最近邻上采样,该方法虽然简单快速,但只是将原始像素复制,没有考虑周围图像的信息,可能破坏图像中的线性关系。本文将具有动态调节因子的DySample模块替换原始网络中的最近邻上采样,设置g=4。

2.2 ADown模块

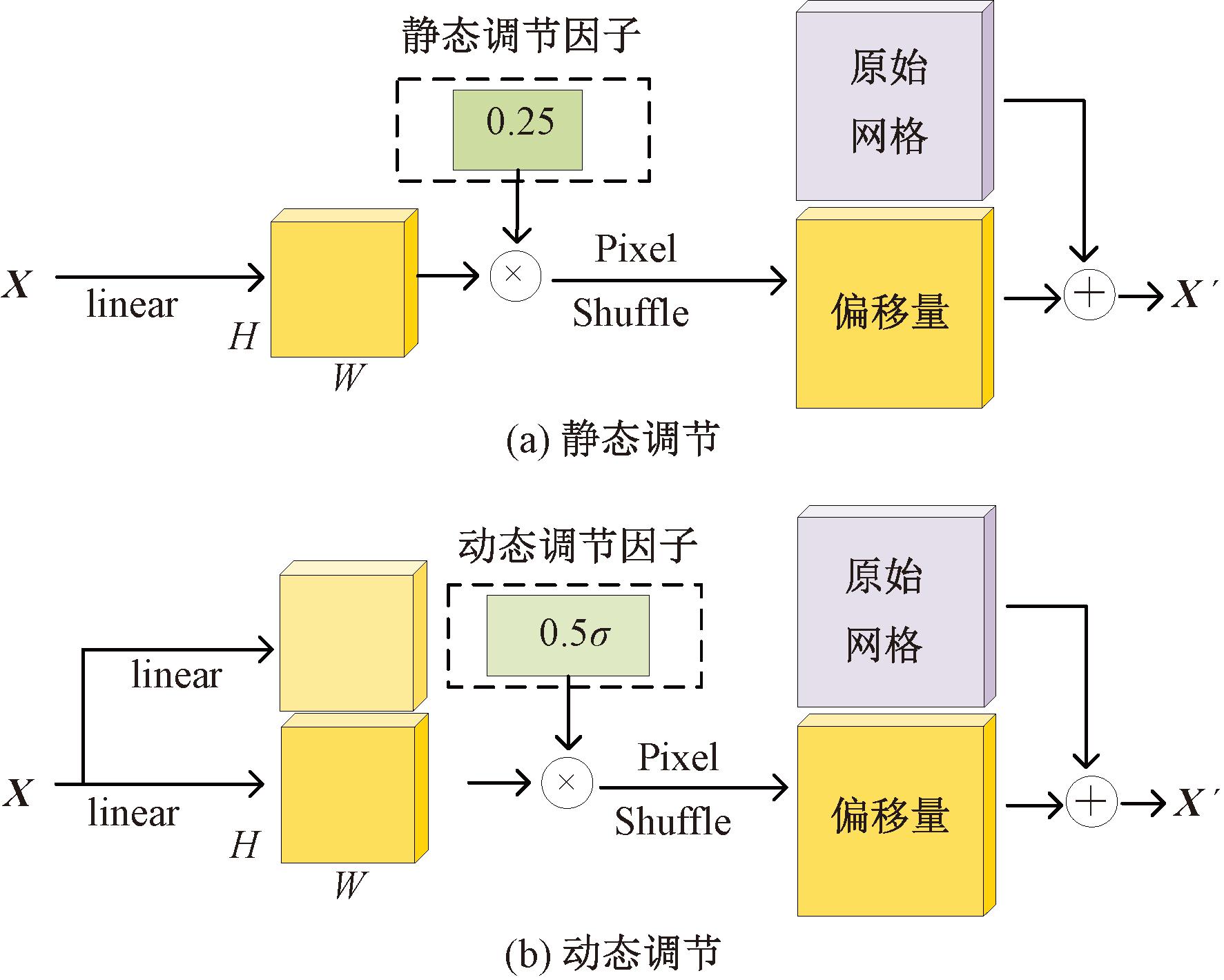

ADown是YOLOv9[17]算法中使用的一种取代普通卷积的轻量化、低参数的下采样模块,该模块优化了下采样过程,防止模型过拟合,如图4所示。首先将输入的特征图进行平均池化操作;然后拆分成两个部分,第一部分采用步长为2的普通卷积,第二部分先使用步长为2的最大池化,然后使用一个普通卷积;最后将得到的结果拼接到一起。

图4 ADown模块结构

Figure 4 Structure of ADown module

YOLOv8中使用步长为2的普通卷积进行下采样,该操作计算代价高且参数多。本文将ADown模块替换原始模型中Backbone和Neck的部分步长为2的Conv模块。

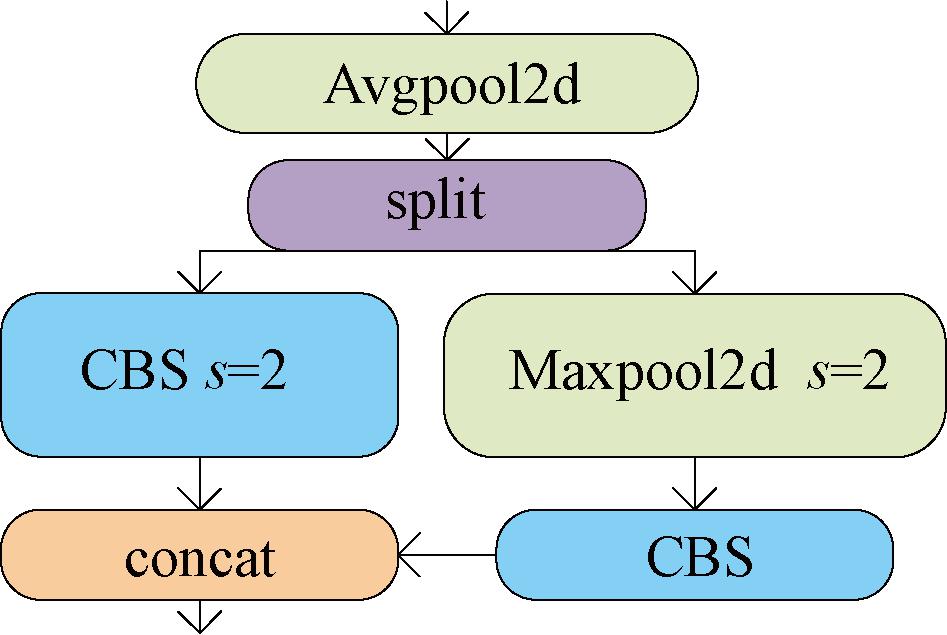

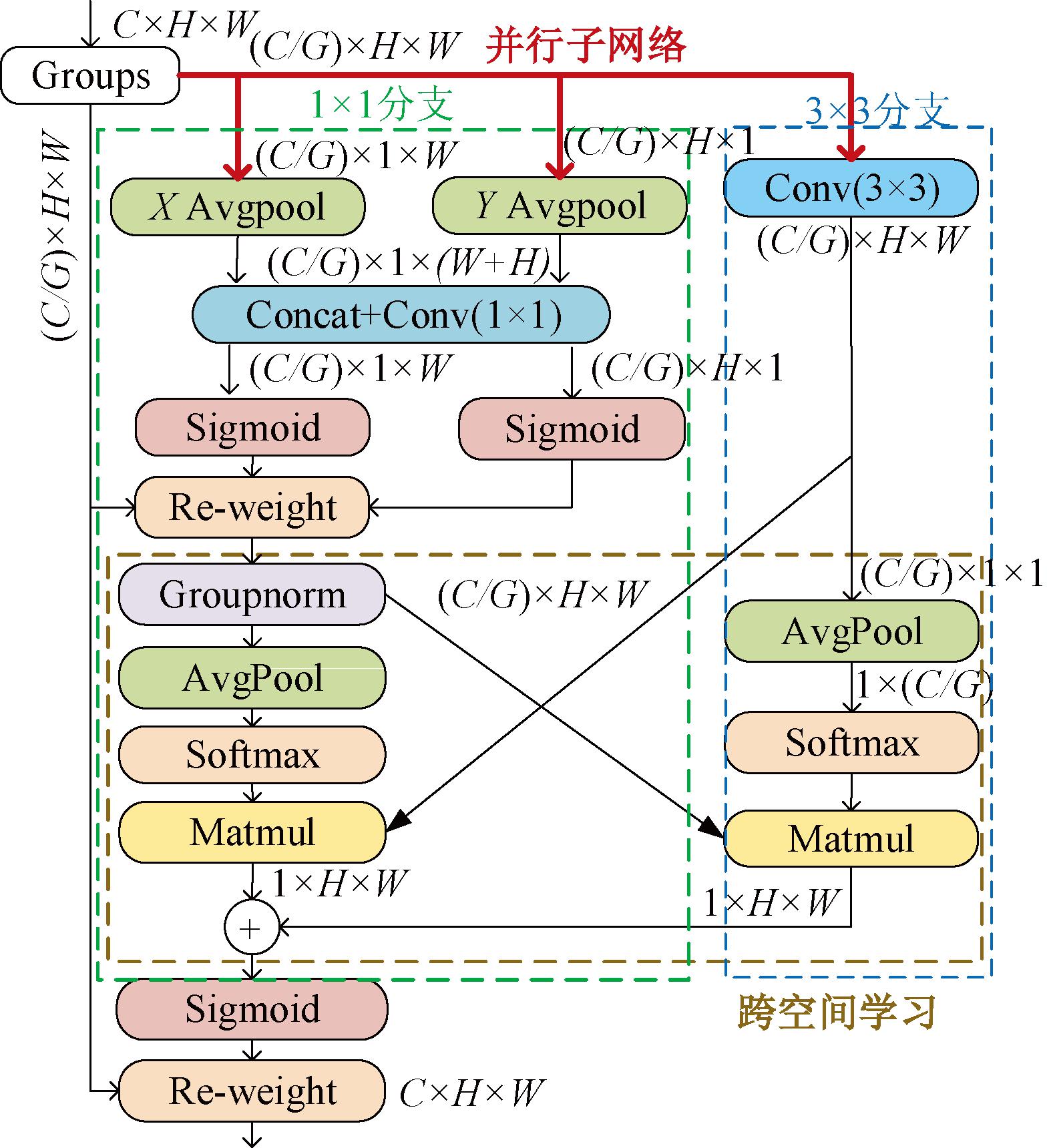

2.3 EMA注意力机制

EMA是Ouyang等[18]提出的一种高效多尺度注意力机制,能优化特征提取过程,增强模型性能,同时在保留每个通道信息的同时也减少了计算开销。图5所示为EMA注意力机制的结构。

图5 EMA注意力机制

Figure 5 EMA attention mechanisms

(1)特征分组。将维度为C×H×W的特征图X分成G组,拆分后子特征图维度为(C/G)×H×W。

(2)并行子网络。EMA利用3个子网络并行提取注意力权重,其中1×1的分支分别沿着两个空间方向进行全局平均池化,结果拼接后通过跨通道信息交互进行建模,随后将其输出拆分为两个向量,使用Sigmoid函数将其提取为注意力权重并作用于原始特征图上。3×3分支中的卷积捕捉局部跨通道信息,扩大特征空间。并行子网络捕捉不同尺度的特征信息。

(3)跨空间学习。在1×1分支中利用全局平均池化和Softmax函数提取出注意力权重后与3×3分支中的特征图融合,3×3分支使用相同操作提取出注意力权重并和1×1分支中经过组归一化的特征图结合,将融合后的特征相加后就得到了不同空间的多尺度信息。

3 遗留物品检测

改进后的YOLOv8s模型YOLO-DAE如图6所示。

图6 改进后的YOLOv8模型结构

Figure 6 Structure of improved YOLOv8 model

使用该模型检测视频流中的前景目标,利用多目标跟踪算法ByteTrack[19],为检测的每个目标分配ID,同时将每个跟踪到的目标的信息记录到跟踪队列中,根据分配的ID信息,判断当前帧某一目标与前一帧该目标的检测框的交并比(IoU)是否大于阈值S,其中S∈[0,1],若大于S,则说明该目标静止一帧,连续静止N帧的目标即可判定为遗留物品。本文的重点是提升遗留物品的检测能力,故不详细阐述遗留物品的判定规则。

4 实验结果与分析

4.1 数据集采集及预处理

目前开源的遗留物品检测数据集多为商场、车站站台和机场,并且遗留物品为背包、行李箱等,缺乏工业场景的数据集。因此,根据实际的业务需求,在天然气分输场站现场取景,同时也从互联网视频中收集了一些数据,构建的数据集共有4 828张图片,如图7所示,包含工人、防爆工具箱、几种防爆工具、小型运输叉车和丢弃的垃圾包裹等10个类别,数据中包含室内、室外、不同光照的背景,同时含有一定数量的人流拥挤、小尺度目标的图片,以数据驱动的方式增强模型对复杂背景、光照变化、密集目标等情况的干扰,使用LabelImg对数据打标签,将数据集划分为8∶2的训练集与验证集。

图7 10个遗留物品类别

Figure 7 10 categories of abandoned object

4.2 评价指标

模型性能评价指标采用准确率P、召回率R、平均准确率mAP。准确率P为预测正确的前景目标占所有预测为前景目标数量的百分比,反映是否能准确检测出前景目标;召回率R表示被正确检测出的前景目标占所有前景目标的百分比,反映前景目标的漏检程度;mAP表示所有类别的P-R曲线下面积AP的平均值。

4.3 实验平台

本次实验的设备使用Windows11操作系统,其中GPU为GRID T4-8Q,显存8 GB,CPU型号为QEMU Virtual CPU,内存32 GB。采用Pytorch深度学习框架,其版本为1.10.1,Python版本为3.9,将batch-size设置为8,训练150个epoch,初始学习率设置为0.01,使用AdamW优化器,初始动量为0.9,权重衰减系数设置为0.000 5。

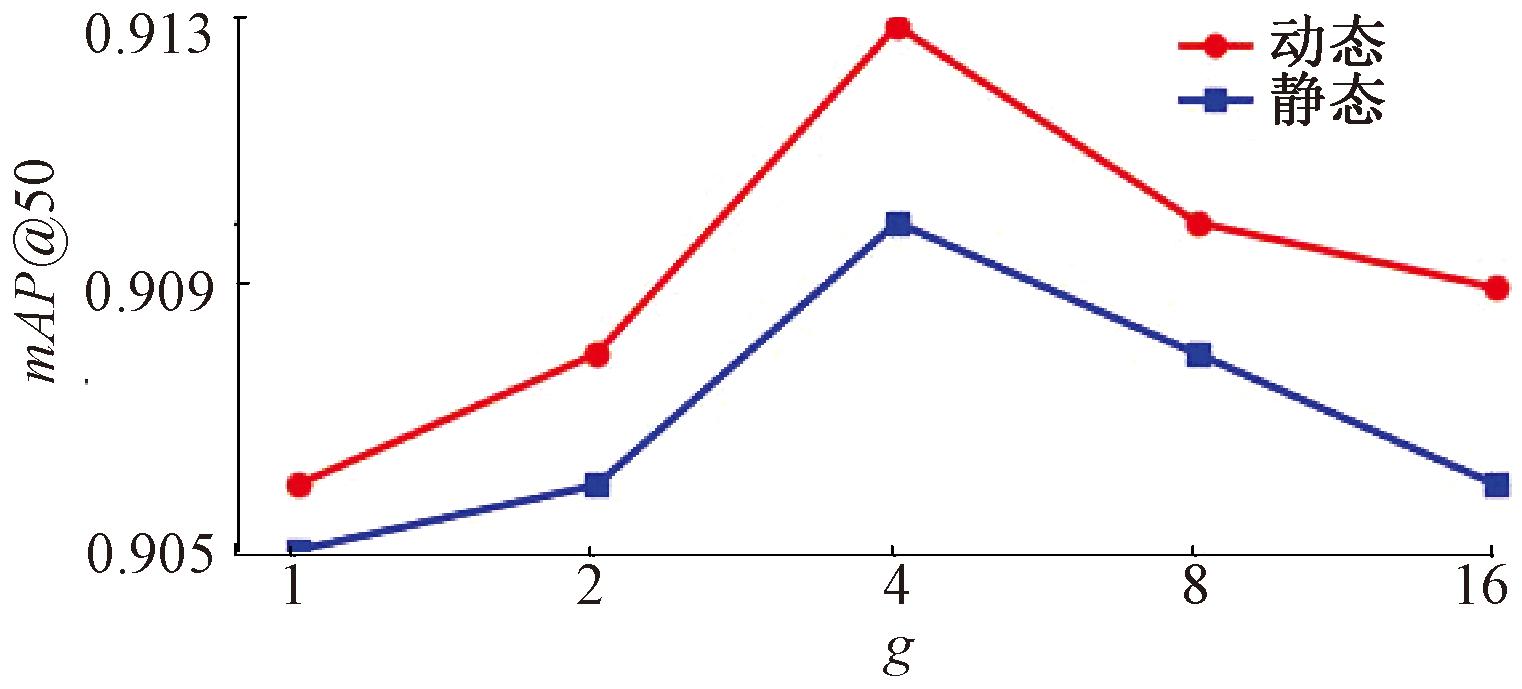

4.4 DySample有效性分析

为探究g取何值时mAP为最优以及比较动态、静态调节因子的优劣,本文在不同的组数和不同的调节因子下进行实验,实验结果如图8所示。可以看出,当g=4,使用动态因子时模型的准确度增益更高。

图8 不同组数与调节因子下的mAP@50

Figure 8 mAP@50 with different groups and regulatory factors

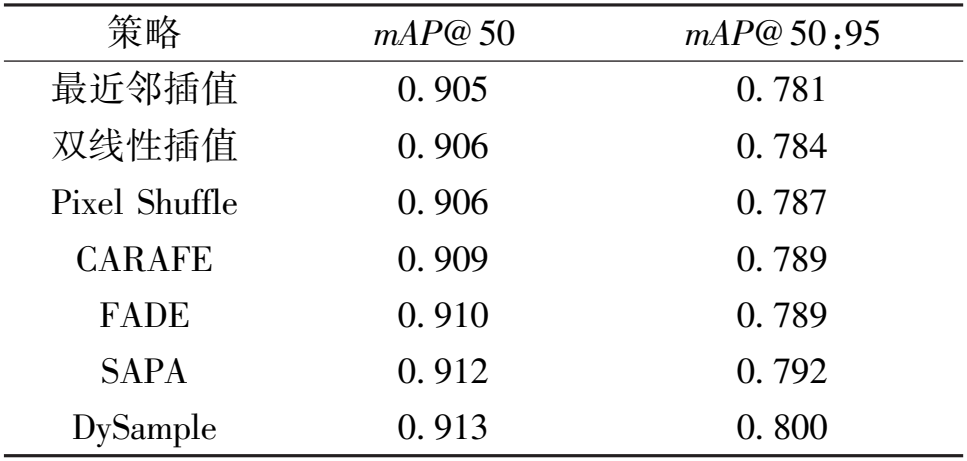

为进一步验证DySample上采样的优越性,本文采取用不同的上采样策略,包括双线性插值、Pixel Shuffle[20]、CARAFE[21]、FADE[22]和SAPA[23],实验结果如表1所示。可以看出,基础YOLOv8模型使用最近邻插值算法,在替换成DySample之后达到了最高的准确率。

表1 不同上采样策略对比

Table 1 Comparison of different upsampling strategies

策略 mAP@ 50 mAP@ 50:95 最近邻插值 0. 905 0. 781 双线性插值 0. 906 0. 784 Pixel Shuffle 0. 906 0. 787 CARAFE 0. 909 0. 789 FADE 0. 910 0. 789 SAPA 0. 912 0. 792 DySample 0. 913 0. 800

4.5 不同注意力机制对比

为探究EMA注意力中组数G对准确率的影响,本文做了不同组数下的对比实验。当G为1,2,4,8,16和32时,mAP@50:95分别为0.904,0.910,0.913,0.914,0.915和0.913,可以得出,G=16时模型达到最高的准确率。

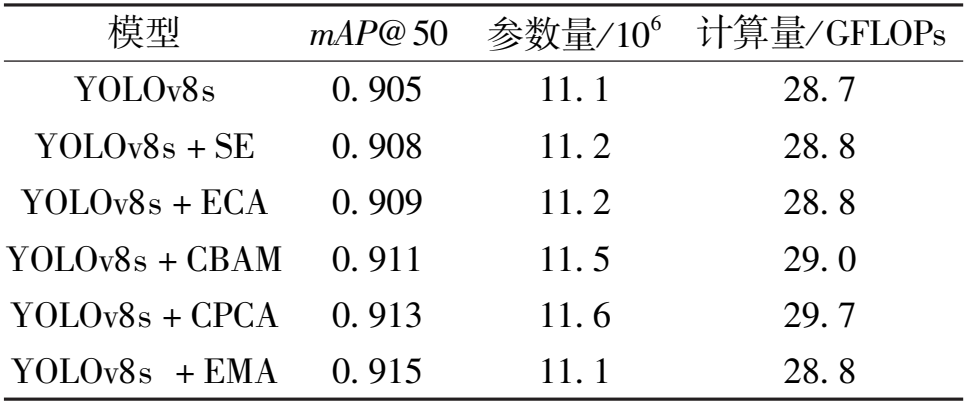

为进一步验证EMA注意力机制的优势,本文使用不同注意力进行对比实验,包括通道注意力机制SE[24]和ECA[25];空间和通道结合的注意力机制CBAM[26]、CPCA[27]。实验结果如表2所示。可以看出,在使用EAM之后达到了最高的准确率。

表2 不同注意力机制对比

Table 2 Comparison of different attention mechanisms

模型 mAP@ 50 参数量/ 10 6 计算量/ GFLOPs YOLOv8s 0. 905 11. 1 28. 7 YOLOv8s + SE 0. 908 11. 2 28. 8 YOLOv8s + ECA 0. 909 11. 2 28. 8 YOLOv8s + CBAM 0. 911 11. 5 29. 0 YOLOv8s + CPCA 0. 913 11. 6 29. 7 YOLOv8s + EMA 0. 915 11. 1 28. 8

4.6 实验结果及分析

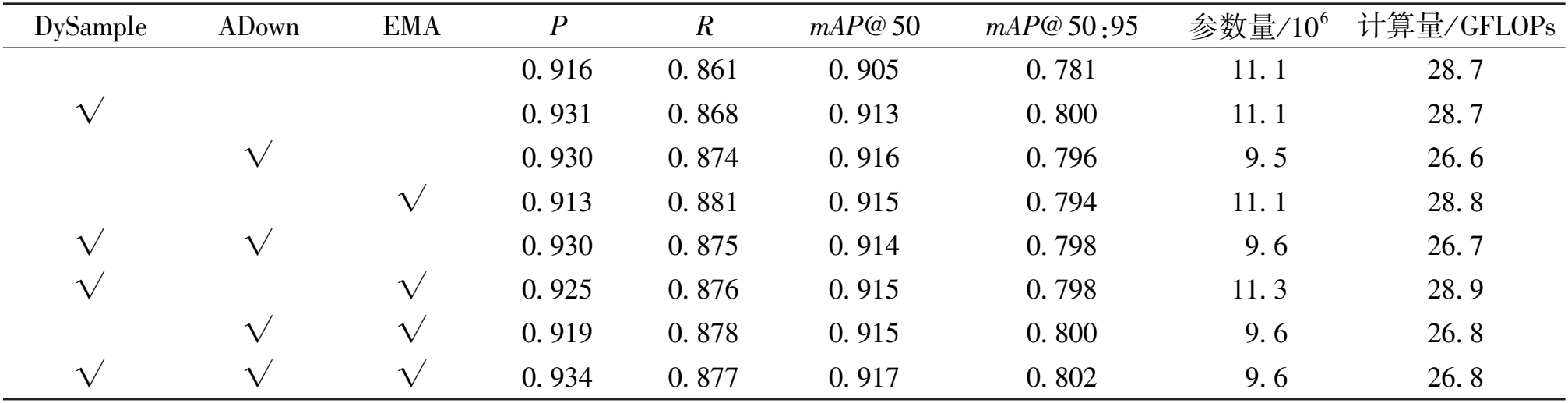

本文通过消融实验研究每个模块的加入对模型性能的影响,具体实验结果数据如表3所示,原始模型取得的P、R、mAP@50和mAP@50:95分别为91.6%,86.1%,90.5%和78.1%。使用动态上采样DySample能够优化上采样过程、增强模型性能,评价指标分别提升了1.5百分点、0.7百分点、0.8百分点和1.9百分点。ADown模块取代普通步长为2的卷积,防止模型过拟合,评价指标分别提升了1.4百分点、1.3百分点、1.1百分点和1.5百分点,同时参数量与计算量均有减少。EMA注意力能优化特征提取过程,增强特征提取能力,召回率R提升了2.0百分点。改进后的模型YOLO-DAE在自建数据集上取得的评价指标分别为93.4%,87.7%,91.7%和80.2%,相比于改进前的YOLOv8s模型分别提高了1.8百分点、1.6百分点、1.2百分点和2.1百分点。

表3 消融实验结果分析

Table 3 Analysis of ablation experiment results

D y S a m p l e A D o w n E M A P R mA P @ 5 0 mA P @ 5 0 : 9 5 参 数 量 / 1 0 6 计 算 量 / G F L O P s 0 . 9 1 6 0 . 8 6 1 0 . 9 0 5 0 . 7 8 1 1 1 . 1 2 8 . 7 √ 0 . 9 3 1 0 . 8 6 8 0 . 9 1 3 0 . 8 0 0 1 1 . 1 2 8 . 7 √ 0 . 9 3 0 0 . 8 7 4 0 . 9 1 6 0 . 7 9 6 9 . 5 2 6 . 6 √ 0 . 9 1 3 0 . 8 8 1 0 . 9 1 5 0 . 7 9 4 1 1 . 1 2 8 . 8 √ √ 0 . 9 3 0 0 . 8 7 5 0 . 9 1 4 0 . 7 9 8 9 . 6 2 6 . 7 √ √ 0 . 9 2 5 0 . 8 7 6 0 . 9 1 5 0 . 7 9 8 1 1 . 3 2 8 . 9 √ √ 0 . 9 1 9 0 . 8 7 8 0 . 9 1 5 0 . 8 0 0 9 . 6 2 6 . 8 √ √ √ 0 . 9 3 4 0 . 8 7 7 0 . 9 1 7 0 . 8 0 2 9 . 6 2 6 . 8

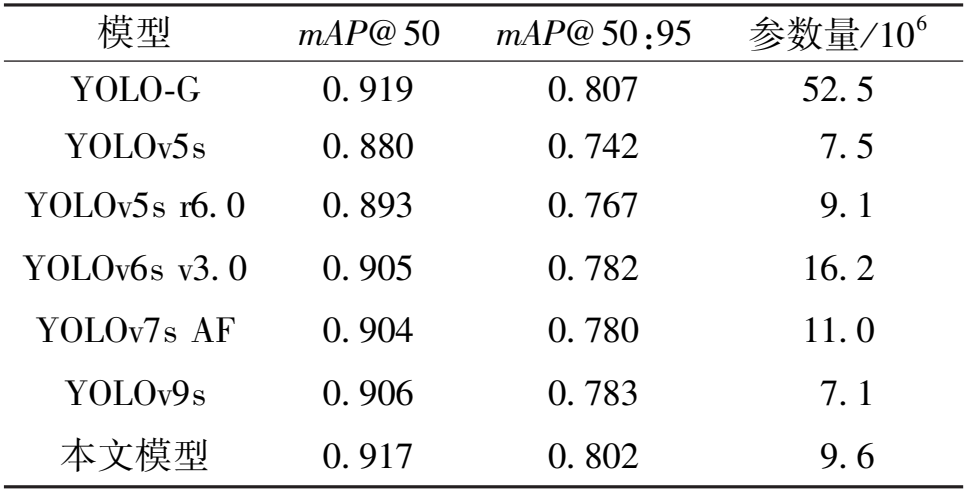

将用于遗留物品检测的YOLO-G[11]、YOLOv5s[10]算法与近几年提出的新的一阶段算法YOLOv5s r6.0[13]、YOLOv6s v3.0[28]、YOLOv7s AF[17]、YOLOv9s[17]和本文提出的算法进行对比,实验结果如表4所示。

表4 不同算法性能对比

Table 4 Comparison of the performance of different algorithms

模型 mAP@ 50 mAP@ 50:95 参数量/ 10 6 YOLO-G 0. 919 0. 807 52. 5 YOLOv5s 0. 880 0. 742 7. 5 YOLOv5s r6. 0 0. 893 0. 767 9. 1 YOLOv6s v3. 0 0. 905 0. 782 16. 2 YOLOv7s AF 0. 904 0. 780 11. 0 YOLOv9s 0. 906 0. 783 7. 1 本文模型 0. 917 0. 802 9. 6

由表4可知,用于遗留物品检测的YOLOv5s虽然参数更少,但其准确率较低;YOLO-G取得了最高的准确率,但其参数量约为本文模型的5.5倍;YOLOv5s r6.0与YOLOv7s的准确率较低;YOLOv6s v3.0的参数量较高;最新提出的YOLOv9s的综合性能较好;而本文模型在保持较低的模型参数量的同时达到了较高的检测准确率。

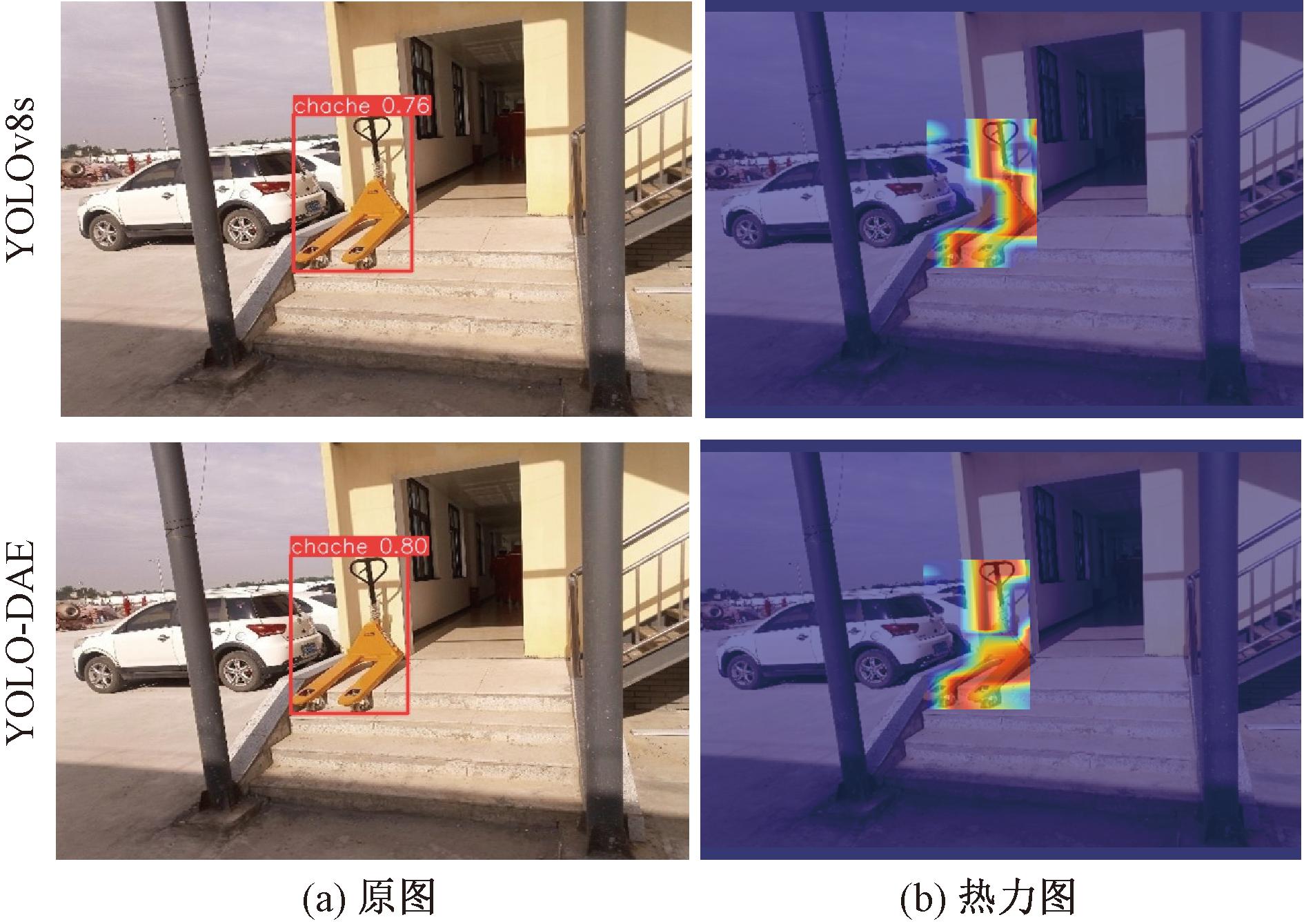

模型改进前后检测效果如图9所示。使用LayerCAM[29]生成模型可视化类激活热力图,可以看出,原模型更关注深红色区域,经过改进后置信度从76%提升到80%;同时从热力图中可以看出,改进后的模型提取了更多目标区域的特征,不过度依赖无关区域特征,有效提升了遗留物品检测能力。

图9 改进前后检测结果与热力图对比

Figure 9 Results and heat map before and after improvement

5 结论

针对传统遗留物品检测算法难以应对人流拥挤、小目标、物品遮挡和光线变化等环境,以及基于深度学习方法中模型准确率低等问题,提出了一种基于改进YOLOv8的遗留物品检测算法。使用具有动态调节因子的DySample优化了上采样,增加了模型的泛化能力。利用轻量高效的ADown下采样模块缓解网络过拟合,不仅能提升模型准确率,还降低了模型的参数量和计算量。引入EMA注意力机制,优化特征提取过程,有效地提升模型性能。改进后模型的准确率P、召回率R、mAP@50和mAP@50:95分别为93.4%,87.7%,91.7%和80.2%,相比于改进前的YOLOv8s模型分别提高了1.8百分点、1.6百分点、1.2百分点和2.1百分点,有效提升了遗留物品检测能力。

[1] GIRSHICK R, DONAHUE J, DARRELL T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]∥2014 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2014: 580-587.

[2] REDMON J, DIVVALA S, GIRSHICK R, et al. You only look once: unified, real-time object detection[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway: IEEE, 2016: 779-788.

[3] LIU W, ANGUELOV D, ERHAN D, et al. SSD: single shot multibox detector[C]∥14th European Conference on Computer Vision. Cham: Springer, 2016: 21-37.

[4] TIAN Z, SHEN C H, CHEN H, et al. FCOS: fully convolutional one-stage object detection[C]∥2019 IEEE/CVF International Conference on Computer Vision (ICCV). Piscataway: IEEE, 2019: 9626-9635.

[5] LIN K, CHEN S C, CHEN C S, et al. Abandoned object detection via temporal consistency modeling and back-tracing verification for visual surveillance[J]. IEEE Transactions on Information Forensics and Security, 2015, 10(7): 1359-1370.

[6] SU H, WANG W, WANG S W. A robust all-weather abandoned objects detection algorithm based on dual background and gradient operator[J]. Multimedia Tools and Applications, 2023, 82(19): 29477-29499.

[7] RUSSEL N S, SELVARAJ A. Ownership of abandoned object detection by integrating carried object recognition and context sensing[J]. The Visual Computer, 2024, 40(6): 4401-4426.

[8] PARK H, PARK S, JOO Y. Detection of abandoned and stolen objects based on dual background model and mask R-CNN[J]. IEEE Access, 2020, 8: 80010-80019.

[9] LIU W P, LIU P, XIAO C X, et al. General-purpose abandoned object detection method without background modeling[C]∥2021 IEEE International Conference on Imaging Systems and Techniques (IST). Piscataway: IEEE, 2021: 1-5.

[10] 蒋晓可. 工业监控视频中的遗留物品检测与识别方法研究[D]. 武汉: 华中科技大学, 2021.

JIANG X K. Research on method of abandoned object detection and recognition in industrial surveillance videos[D]. Wuhan: Huazhong University of Science and Technology, 2021.

[11] 林德钰, 周卓彤, 过斌, 等. 高斯混合模型与GhostNet结合的YOLO-G遗留物检测方法[J]. 计算机辅助设计与图形学学报, 2023, 35(1): 99-107.

LIN D Y, ZHOU Z T, GUO B, et al. YOLO-G abandoned object detection method combined with Gaussian mixture model and GhostNet[J]. Journal of Computer-Aided Design &Computer Graphics, 2023, 35(1): 99-107.

[12] Ultralytics. YOLOv8[EB/OL]. (2023-01-10)[2024-09-10]. https:∥github.com/ultralytics/ultralytics.

[13] Ultralytics. YOLOv5[EB/OL]. (2020-05-18)[2024-09-10]. https:∥github.com/ultralytics/yolov5.

[14] FENG C J, ZHONG Y J, GAO Y, et al. TOOD: task-aligned one-stage object detection[C]∥2021 IEEE/CVF International Conference on Computer Vision (ICCV). Piscataway: IEEE, 2021: 3490-3499.

[15] LI X, WANG W H, WU L J, et al. Generalized focal loss: learning qualified and distributed bounding boxes for dense object detection[EB/OL]. (2020-06-08)[2024-09-10]. https:∥arxiv.org/abs/2006.04388.

[16] LIU W Z, LU H, FU H T, et al. Learning to upsample by learning to sample[C]∥2023 IEEE/CVF International Conference on Computer Vision (ICCV). Piscataway: IEEE, 2023: 6004-6014.

[17] WANG C Y, YEH I H, LIAO H Y M. YOLOv9: learning what you want to learn using programmable gradient information[EB/OL]. (2024-02-29)[2024-09-10]. https:∥arxiv.org/abs/2402.13616.

[18] OUYANG D L, HE S, ZHANG G Z, et al. Efficient multi-scale attention module with cross-spatial learning[C]∥IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Piscataway: IEEE, 2023: 1-5.

[19] ZHANG Y F, SUN P Z, JIANG Y, et al. ByteTrack: multi-object tracking by associating every detection box[EB/OL]. (2022-04-07)[2024-09-10]. https:∥arxiv.org/abs/2110.06864.

[20] SHI W Z, CABALLERO J, HUSZ R F, et al. Real-time single image and video super-resolution using an efficient sub-pixel convolutional neural network[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway: IEEE, 2016: 1874-1883.

R F, et al. Real-time single image and video super-resolution using an efficient sub-pixel convolutional neural network[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway: IEEE, 2016: 1874-1883.

[21] WANG J Q, CHEN K, XU R, et al. CARAFE: content-aware reassembly of features[C]∥2019 IEEE/CVF International Conference on Computer Vision (ICCV). Piscataway: IEEE, 2019: 3007-3016.

[22] LU H, LIU W Z, FU H T, et al. FADE: fusing the assets of decoder and encoder for task-agnostic upsampling[EB/OL]. (2022-12-27)[2024-09-10]. https:∥arxiv.org/abs/2207.10392.

[23] LU HAO, LIU W Z, YE Z X, et al. SAPA: similarity-aware point affiliation for feature upsampling[EB/OL]. (2022-12-27)[2024-09-10].https:∥arxiv.org/abs/2209.12866.

[24] HU J, SHEN L, ALBANIE S. Squeeze-and-excitation networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020,42(8):2011-2023.

[25] WANG Q L, WU B G, ZHU P F, et al. ECA-Net: efficient channel attention for deep convolutional neural networks[C]∥2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway: IEEE, 2020: 11531-11539.

[26] WOO S Y, PARK J C, LEE J Y, et al. CBAM: convolutional block attention module[J]. Lecture Notes in Computer Science, 2018, 11211: 3-19.

[27] HUANG H J, CHEN Z G, ZOU Y, et al. Channel prior convolutional attention for medical image segmentation[EB/OL]. (2023-06-08)[2024-09-10]. https:∥arxiv.org/abs/2306.05196v1.

[28] LI C Y, LI L L, GENG Y F, et al. YOLOv6 v3.0: a full-scale reloading[EB/OL]. (2023-01-13)[2024-09-10]. https:∥arxiv.org/abs/2301.05586v1.

[29] JIANG P T, ZHANG C B, HOU Q B, et al. LayerCAM: exploring hierarchical class activation maps for localization[J]. IEEE Transactions on Image Processing, 2021, 30: 5875-5888.