变电站是电力系统的重要基础设施,在电能输送和配送环节发挥了重要作用。遥感影像具有独特的鸟瞰视角和高分辨率特点,覆盖范围广、细节丰富,与深度学习和计算机视觉技术相结合能够准确揭示电力设施时空变化信息,为电网从业人员提供及时、准确的多方位统计和分析结果,为电力安全生产和智能调度提供更全面、准确、及时的信息支持。

随着计算机视觉和深度学习技术的快速发展,目标检测领域涌现出许多高效方法。以Faster R-CNN[1]为代表的双阶段目标检测算法通过区域建议网络(region proposal network,RPN)生成初步的目标位置,然后分别修正目标的精细包围框和类别。这种策略精度较高,但其两阶段特性也导致处理速度较慢。YOLO[2-6]、SSD[7]等目标检测算法开创了一阶段目标检测的新纪元。其中,YOLO将目标检测任务简化为一个回归问题,将图像简单地按照网格划分并直接回归得到目标框坐标,显著提高了检测速度,被广泛应用于电力[8]、农业[9]、城市建设[10]等领域。

尽管目标检测算法已经比较成熟,但这些算法大多在自然图像上训练和评测,而卫星影像因其特有的高分辨率和广阔覆盖范围的特点,为目标检测任务带来了独特挑战。变电站在卫星影像中包含大量细碎特征,边界界定较为困难,常与周边建筑物、耕地等具有相似纹理特征的地物混淆,在视觉上难以区分。此外,光照条件、大气效应以及地形特征对目标检测准确性也会造成影响[11-12]。

对于变电站检测,已有研究主要集中在利用光学图像或红外图像对变电站中特定结构或组件的检测,包括变压器、断路器和散热器等[13-14]。Peng等[15]提出了一种基于深度迁移学习的算法,用于验证Google Earth图像中的变电站位置信息。该算法的核心是利用深度迁移学习模型来自动检测和验证数据库中记录的变电站位置信息是否准确,然而它并不是专门针对变电站检测任务而设计的。Pérez-Hern ndez等[16]提出的DetDSCI算法能够有效检测遥感影像中的基础设施目标,包括机场、变电站等典型地物。该算法首先通过一个分类模型判识影像分辨率,然后选择合适的模型进行设施检测,但该算法并未针对变电站检测任务专门优化深度学习模型。Mesvari等[17]提出了一种基于深度卷积神经网络的算法,用于在高分辨率卫星图像中分割变电站,实现了对变电站相关区域的高精度分割,但无法提供变电站的位置信息,不符合对变电站快速发现与动态监测的需求。

ndez等[16]提出的DetDSCI算法能够有效检测遥感影像中的基础设施目标,包括机场、变电站等典型地物。该算法首先通过一个分类模型判识影像分辨率,然后选择合适的模型进行设施检测,但该算法并未针对变电站检测任务专门优化深度学习模型。Mesvari等[17]提出了一种基于深度卷积神经网络的算法,用于在高分辨率卫星图像中分割变电站,实现了对变电站相关区域的高精度分割,但无法提供变电站的位置信息,不符合对变电站快速发现与动态监测的需求。

针对现有技术的局限性,本文基于YOLOv8进行改进,提出遥感影像变电站检测算法,主要贡献包括:构建变电站目标检测样本库,包含10 192张2 m分辨率卫星影像,覆盖城市、郊区、农田等各类场景;在骨干网络嵌入SimAM注意力模块,通过能量函数优化特征通道权重,提升对变电站细部特征的聚焦能力;设计梯度感知特征金字塔颈部GDFPN,结合Efficient-RepGFPN的跨层连接优势与DySample的动态上采样特性,缓解特征金字塔中的语义鸿沟问题。

1 YOLOv8遥感影像变电站目标识别存在的问题

本文实验数据为高分辨率光学遥感卫星影像,通常包含更复杂的背景和环境信息,且可能受到云层遮挡和传感器噪声等影响,进一步降低了图像质量,导致目标与背景之间的对比度较低,变电站在遥感影像中的细节信息更难捕捉。此外,遥感影像普遍存在同谱异物和同物异谱问题,中小尺度下变电站因其特有的矩形结构,在图像中与众多类似的人造结构,如建筑物、耕地上的灌溉网格、操场等在几何形态上高度相似,容易造成混淆或识别位置不准确。

在变电站检测数据集上训练并测试YOLOv8的实验结果表明,耕地、低矮平房容易被错检为变电站,部分测试图像上出现明显漏检,典型的误检问题包括:①耕地与变电站双向误判造成的错检;②耕地与变电站边界混淆造成的定位不准确;③将低矮平房错误分类为变电站的误检;④在广阔耕地区域中无法准确识别变电站目标的问题。

因此,需要针对各种误检问题对该模型进行改进优化,更好地提取遥感影像中变电站的细节特征,提高遥感影像中变电站检测的准确率。

2 YOLOv8改进方案

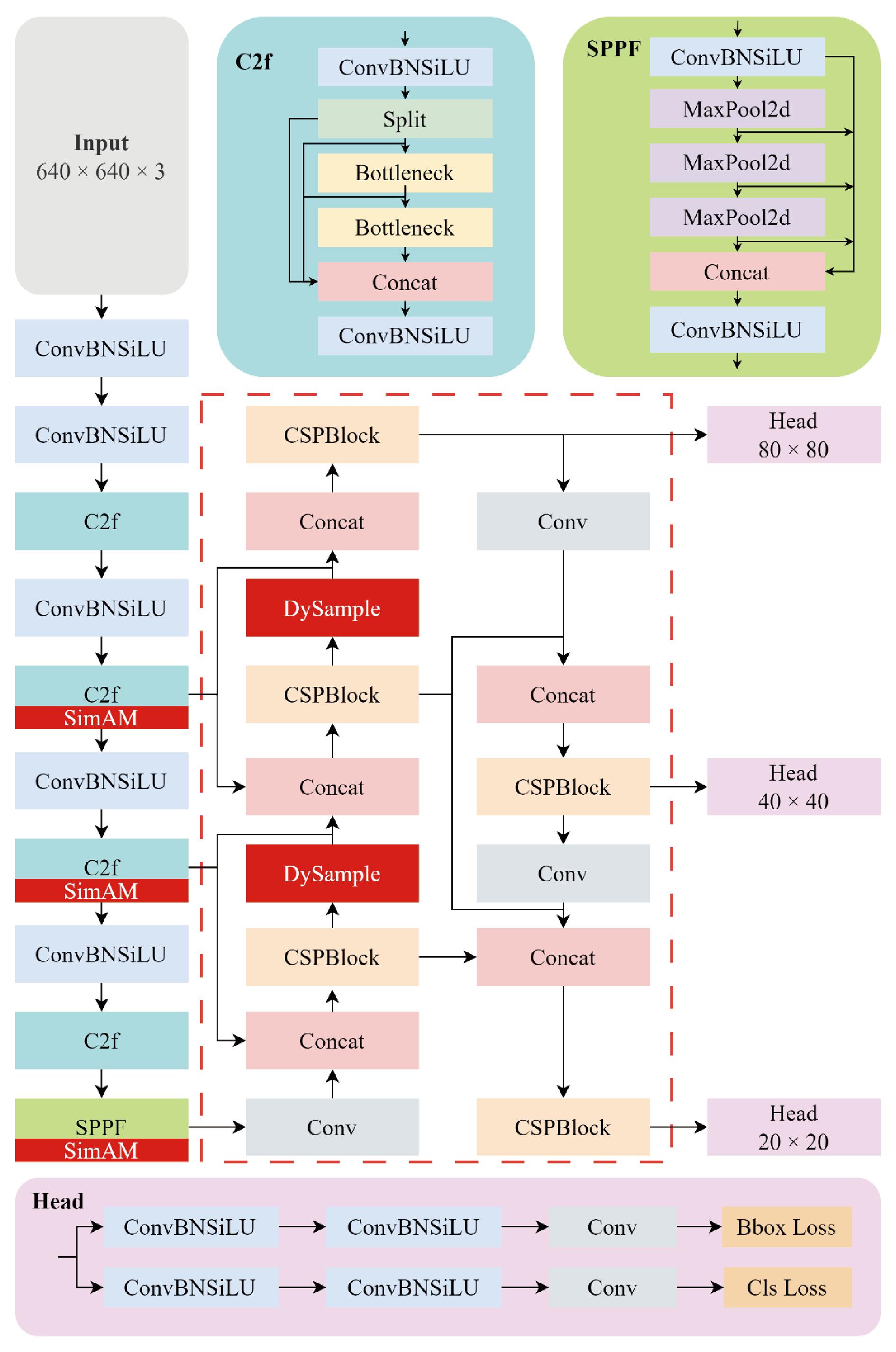

对比YOLOv8下s、m、l这3组不同大小模型的检测精度和效率后发现,m组取得了最优的效率和精度平衡,后续改进均基于该模型进行。改进后的遥感影像变电站检测网络详细结构如图1所示,在网络骨干不同层级处引入了SimAM注意力模块引导模型聚焦于变电站不同尺度上细部结构,提出基于动态上采样的颈部结构GDFPN,通过多级跨层设计实现了不同层级间的信息交换。

图1 改进后的遥感影像变电站检测网络详细结构

Figure 1 Detailed architecture of the improved remote sensing image substation detection network

2.1 轻量级注意力机制SimAM

SimAM[18]是一种基于三维权重分配的注意力机制,其核心思想是通过分析特征图的局部自相似性来生成注意力权重。该方法的理论基础为在视觉处理过程中,那些能够产生显著空间抑制效果的神经元通常具有更高的重要性。

为了高效地构建三维注意力权重,SimAM采用能量函数来评估单个神经元的重要性。具体而言,该方法通过测量目标神经元与其周围神经元的线性可分性来量化其显著性。基于这一原理,SimAM定义了如下能量函数:

(1)

式中:wt和bt分别为权重和偏置;t为目标神经元;ui为同一通道中除t外的其他神经元;M为通道中的神经元总数;λ为正则化项。

能量越低,神经元t与周围神经元的区别越大,其重要性越高。根据注意力机制的定义,最终的特征增强可以描述为

(2)

式中:E为包含所有最小能量的集合。

针对遥感影像变电站图像细节复杂且易与周围相似地物混淆的问题,在YOLOv8骨干网络的3个位置分别加入了SimAM注意力机制。具体而言,第1次引入位于骨干网络的第5层后,旨在利用注意力机制对经过下采样的特征图进行精细化处理,增强模型对小目标的检测能力;第2次引入位于第7层后,在更高层次的特征抽象中进一步提升模型对大目标的检测性能,同时保持对小目标检测的敏感性;第3次引入位于第10层后,经过SPPF(spatial pyramid pooling fast)处理之后,在最粗糙的特征级别上进一步提炼模型的注意力分配,确保在全局特征上也能实现对目标物体的精确识别。

2.2 动态上采样颈部GDFPN

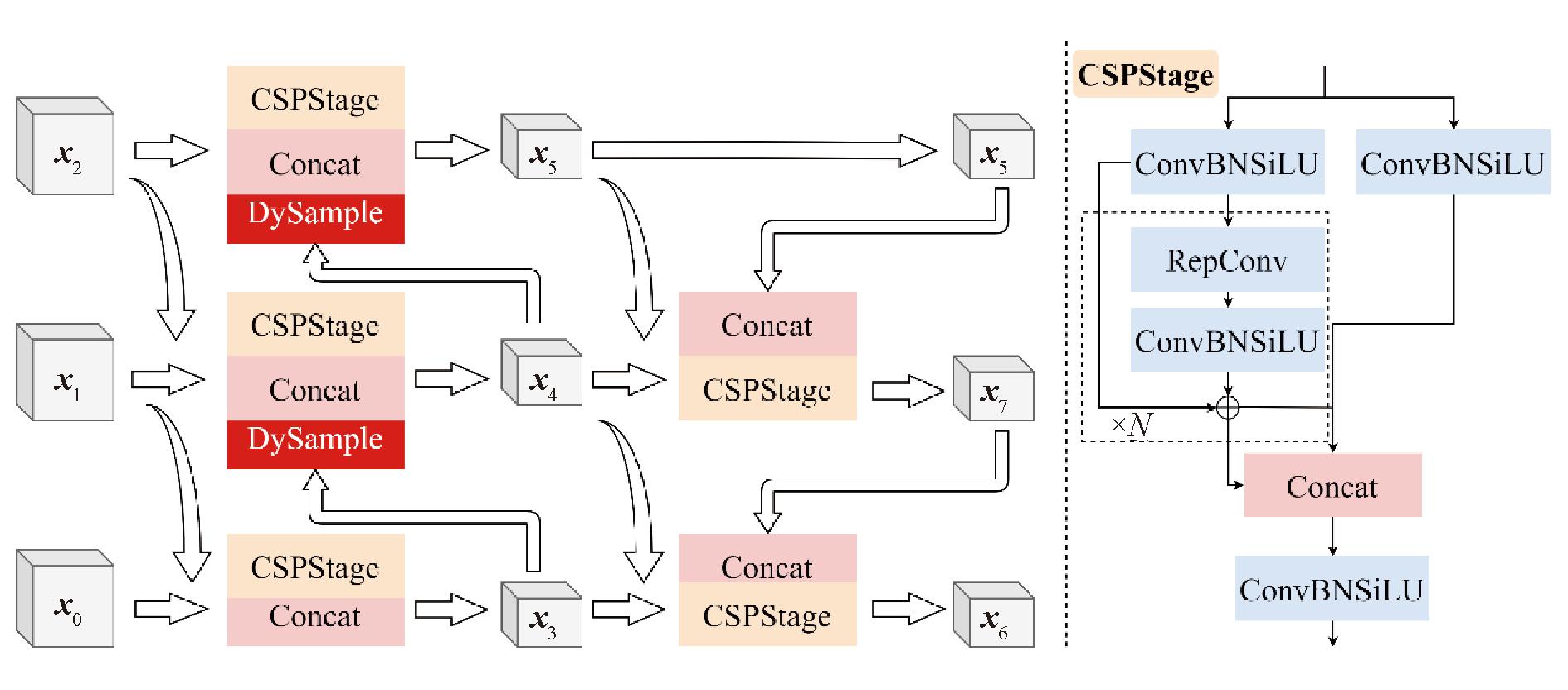

YOLOv8 的颈部采用PAFAN结构,旨在融合从主干网络中提取的浅层与深层特征,并输出3组多尺度特征。相比PAFPN,GFPN通过多级跨层设计实现了不同层级间的信息交换[19],但存在计算开销大的问题。Efficient-RepGFPN[20]对GFPN中的Queen-Fusion进行了加速,并使用CSPNet[21]替换原始基于3×3卷积的特征融合,结合ELAN结构,兼顾效率与精度。

为进一步提升遥感影像变电站检测效果,基于Efficient-RepGFPN,引入基于点采样的动态上采样技术DySample[22],提出了GDFPN(generalized dynamic feature pyramid network)颈部结构,如图2所示。

图2 GDFPN网络结构图

Figure 2 GDFPN network structure

设x0,x1,x2为GDFPN输入,在计算x4时,动态上采样操作将x3特征图尺寸放大,以便与x1和x2经过卷积后的特征图进行拼接;在计算x5时,动态上采样操作再次被使用,将x4的特征图尺寸放大,与x2进行拼接。通过这种方式,模型能够在不同的尺度上捕获和融合特征信息。最后,GDFPN输出3个不同尺度的特征图x5、x6、x7。颈部的输出特征图被送入网络检测头用于目标位置和类别预测。

GDFPN通过动态上采样技术构建一个多尺度的特征金字塔,允许模型在不同的层次上捕捉图像的细节和上下文信息;此外,利用DySample技术根据目标的大小和形状动态调整特征图的上采样过程,使得模型能够更加关注于目标区域的特征增强;颈部结构包含多个阶段的特征融合,有助于模型在保持细节信息的同时,也能够获取更加丰富的上下文信息。

2.3 基于点采样的动态上采样器

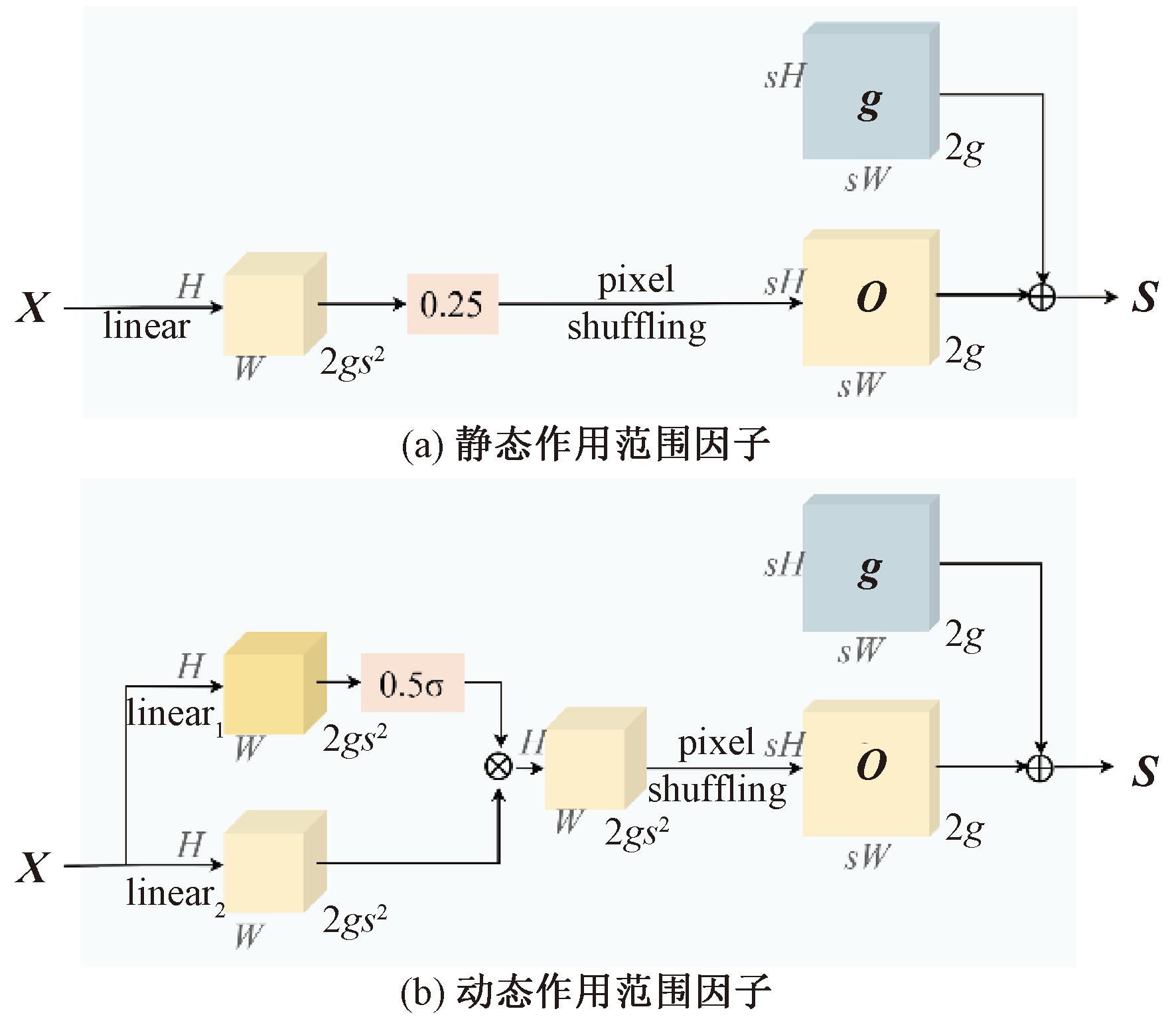

DySample基于点采样,通过以下几个关键步骤实现上采样。

(1)采样点生成。给定一个上采样尺度因子s和一个大小为C×H×W的特征图X,使用一个输入和输出通道分别为C和2s2的线性层,生成大小为2s2×H×W的偏移量O。然后,通过像素洗牌(pixel shuffling)[23]重塑为2×sH×sW。采样集S是偏移量O和原始采样网格g的和,用于从连续的特征图中重新采样。

O=linear(X);

(3)

S=g+O。

(4)

(2)偏移量作用范围调整。为了减少采样点之间的重叠,分别引入了静态作用范围因子Osta和动态作用范围因子Odyn调节偏移量的大小,结构如图3所示。

Osta=0.25linear(X);

(5)

Odyn=0.5sigmoid(linear1(X))·linear2(X)。

(6)

图3 DySample中的采样点发生器

Figure 3 Sampling point generator in DySample

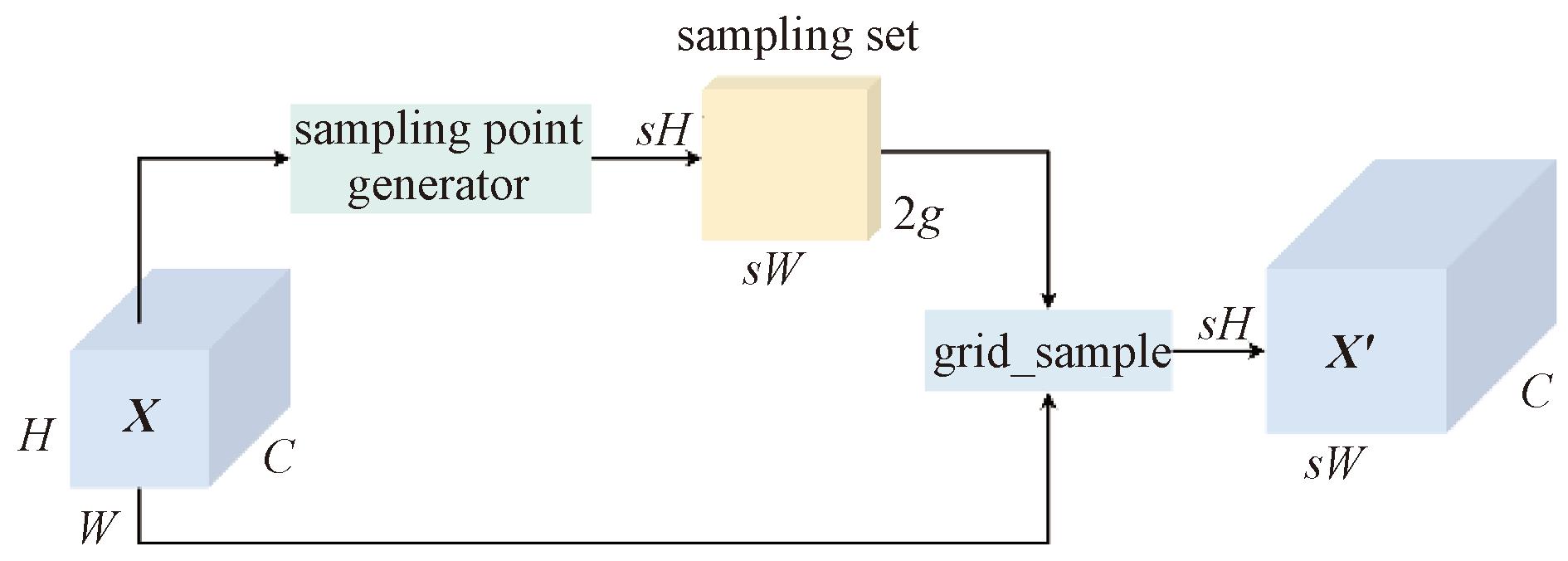

(3)连续插值。给定大小为C×H1×W1特征图,以及一个大小为2×H2×W2的采样集S,其中第一维的数字2对应每个采样点的x和y坐标。grid_sample函数使用双线性插值将输入特征图插值到一个连续的空间中,生成大小为C×H2×W2的X′,如图4所示,这意味着在原始离散的像素点之间生成了连续的像素值。计算公式如下所示:

X′=grid_sample(X,S)。

(7)

图4 基于点采样的动态上采样

Figure 4 Dynamic upsampling based on point sampling

3 实验结果与分析

3.1 数据集介绍

实验数据为高分辨率遥感卫星影像,空间分辨率为2 m,标注工具选择LabelImg,标签数据类型保存为 VOC 数据集数据类型后转化为YOLO格式进行训练。数据集中变电站范围分布广泛,覆盖了从城市到郊区以及偏远地区的各种地形和环境,比如密集城区、房屋周围、农田区域和交通基础设施附近等。训练集和测试集中图像为2 753×1 647像素,共10 192张,变电站目标共10 448个,其中小尺寸目标(小于500像素)数量为2 641个,中尺寸目标(500~1 000像素)数量为6 858个,大尺寸目标(超过1 000像素)有949个。训练集数量与测试集数量比例为9∶1,所有图像进入网络前按照等比缩放原则重采样到960×960像素。

3.2 模型训练细节

本文在16 GB的NVIDIA Tesla P100 GPU上进行训练和测试,初始加载YOLOv8m预训练权重,批大小为16,训练轮数为100。使用平均精度(mAP)、精确度(Precision)和召回率(Recall)作为性能评估指标。由于变电站数据集是单分类目标检测,使用更严格的mAP75作为评估指标,同时采用0.5~0.9倍IoU阈值范围模型的平均精度mAP50-90评价变电站位置准确性,计算公式如下所示:

(8)

(9)

(10)

式中:TP为模型正确检测到的目标数量;FP为模型错误地将背景检测为目标的数量;FN为模型未能检测到的目标数量;P(k)为在第k个召回率水平下的精确度;ΔR(k)为在第k个召回率阈值和第k+1个召回率阈值之间的召回率变化量;n为评估中使用的召回率水平的数量。

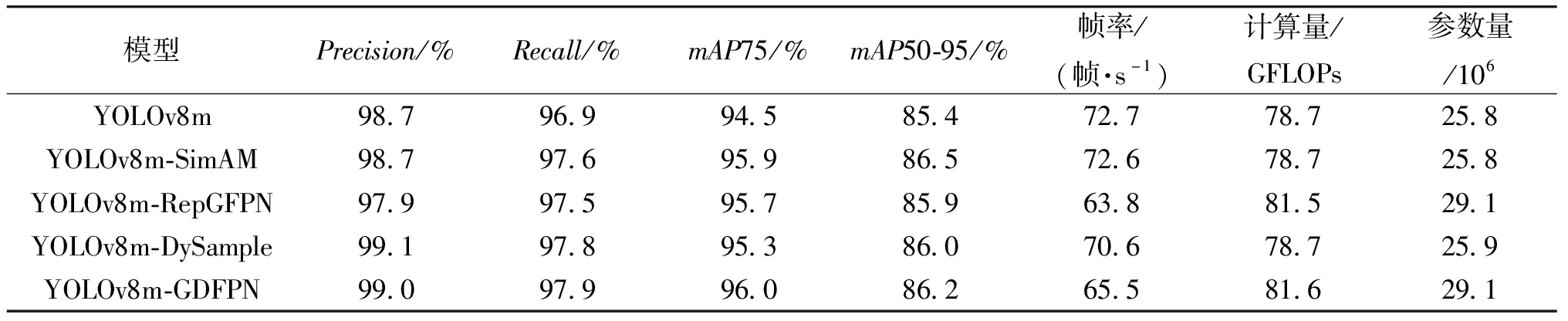

3.3 消融实验

为验证注意力机制以及高效特征融合策略与动态上采样DySample技术的有效性,进行消融实验,测试结果如表1所示。利用Efficient-RepGFPN的多尺度特征融合策略的颈部替换YOLOv8基于PAFAN的颈部后,召回率提升了0.6百分点,mAP75提升了1.2百分点,mAP50-95提升了0.4百分点。通过动态采样技术替换YOLOv8中使用的传统上采样操作后,精确度提升了0.4百分点,召回率提升了0.9百分点,mAP75提升了0.8百分点,mAP50-95提升了0.6百分点。而使用基于动态采样技术和高效特征融合策略改进的GDPFN结构作为YOLOv8的颈部后,召回率提升了1.0百分点,mAP75提升了1.5百分点、mAP50-95提升了0.8百分点。实验结果表明,使用动态上采样技术与高效特征融合策略改进后的网络提升了变电站检测精度,更加适合遥感场景下的变电站检测任务。

表1 SimAM注意力机制与动态上采样颈部GDFPN消融实验

Table 1 SimAM attention mechanism and dynamic upsampling neck GDFPN ablation experiment

模型Precision/%Recall/%mAP75/%mAP50-95/%帧率/(帧·s-1)计算量/GFLOPs参数量/106YOLOv8m98.796.994.585.472.778.725.8YOLOv8m-SimAM98.797.695.986.572.678.725.8YOLOv8m-RepGFPN97.997.595.785.963.881.529.1YOLOv8m-DySample99.197.895.386.070.678.725.9YOLOv8m-GDFPN99.097.996.086.265.581.629.1

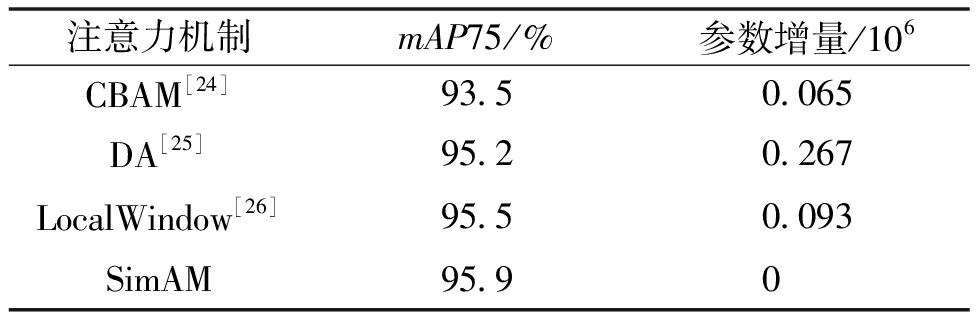

同时,为证明注意力机制在特征筛选中的重要作用,本文测试了几种常用的注意力机制在变电站检测场景下的效果,测试结果如表2所示。实验结果表明,加入CBAM[24]注意力模块不能充分发挥注意力机制的优势,没有提高网络的特征提取能力;DA[25]、LocalWindow[26]注意力机制对网络特征的提取效果有一定改善,但同时引入了额外的参数,降低了网络效率;而SimAM注意力机制对网络的改善最明显,能够充分筛选出变电站目标设备内的主要特征,同时不会增加网络的参数量。

表2 不同注意力机制的对比实验结果

Table 2 Comparative experiment results of different attention mechanisms

注意力机制mAP75/%参数增量/106CBAM[24]93.50.065DA[25]95.20.267LocalWindow[26]95.50.093SimAM95.90

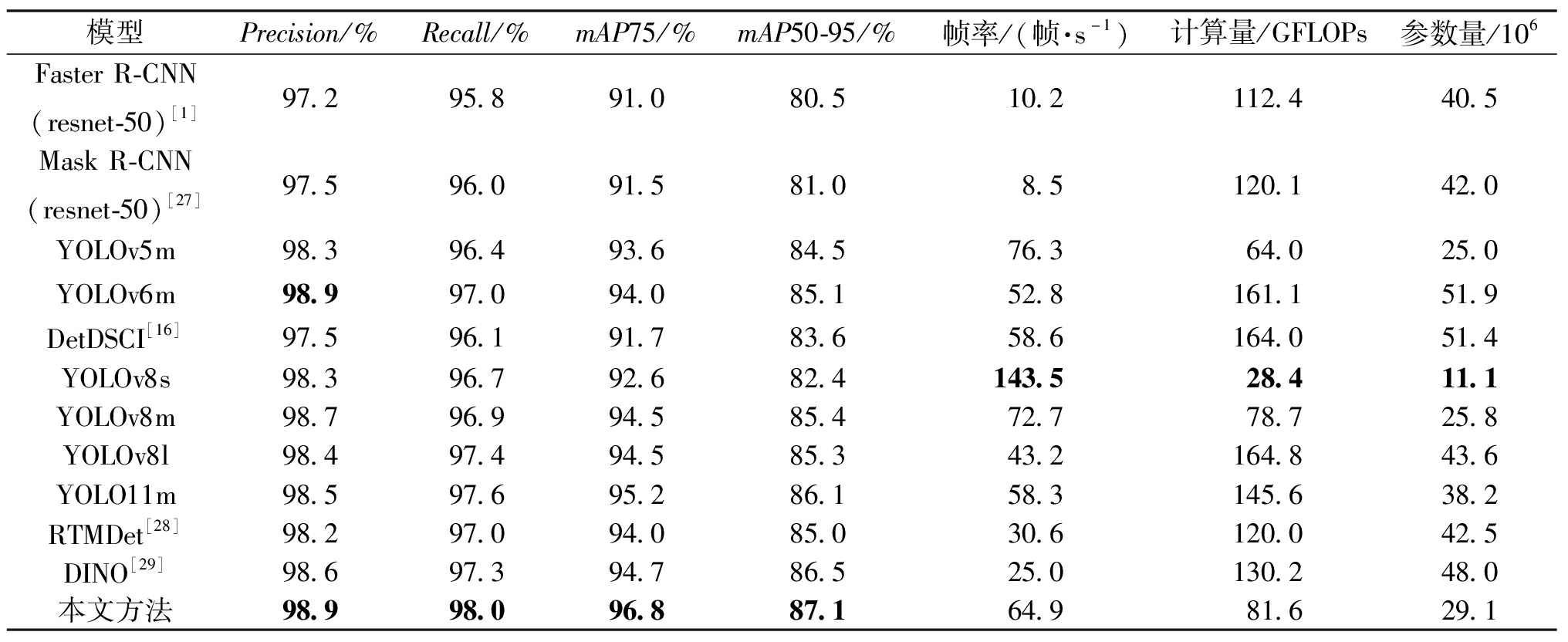

3.4 实验结果

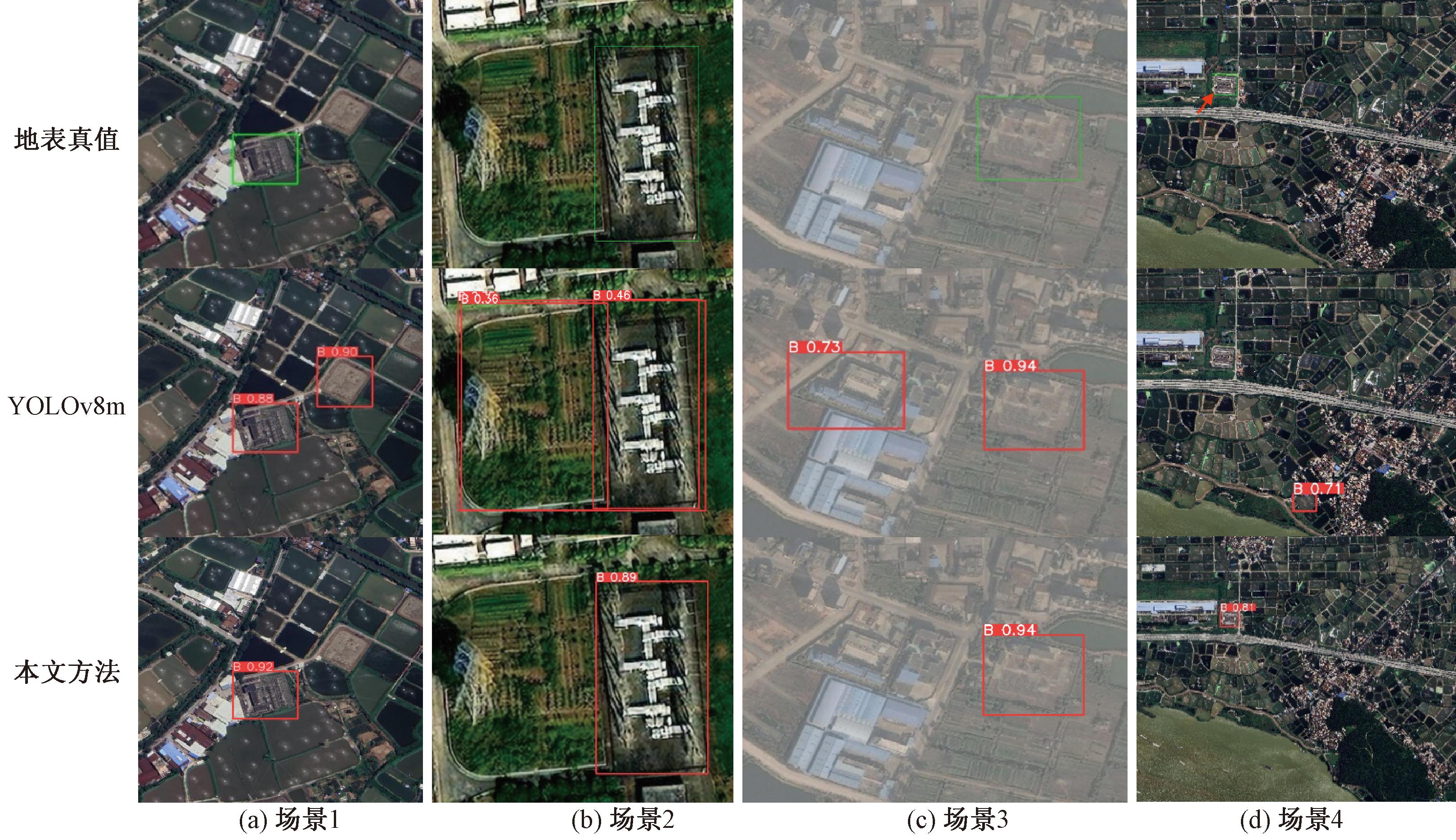

本文在变电站检测数据集上对比测试了多个目标检测算法,各方法检测精度和效率对比如表3所示。由表3可知,本文方法取得了最优检测精度,而且在推理速度和参数量之间实现了良好的平衡。各对比方法中,Faster R-CNN[1]和Mask R-CNN[27]作为经典的两阶段检测模型,在检测精度上有一定的保证,但误检现象明显,且在速度和参数量方面相对较差。YOLOv5m和YOLOv6m平均精度明显低于本文方法。DetDSCI[16]为两阶段方法,将设施划分为小型类别,实验中直接采用CI-SS_Det_stable 模型,效果明显不如本文方法。YOLOv8s速度最快,参数量最小,但是精度较低。YOLOv8l相较于YOLOv8m,参数量增加了50%,但是精度没有明显提升。虽然YOLO11m在评估指标上表现良好,但整体上精度与效率均略逊于本文方法。RTMDet[28]和DINO[29]两个最新的非YOLO系列模型虽具有较强的竞争力,但它们的推理速度和参数量都逊于本文方法。图5展示了部分典型方法在变电站检测数据上的表现,可以看出,本文方法在郊区、城区、农田等不同地物背景条件下均有效改善了错检和漏检问题,定位准确性高,不易受周边地物干扰。

表3 不同模型实验结果对比

Table 3 Experimental result comparison of different models

模型Precision/%Recall/%mAP75/%mAP50-95/%帧率/(帧·s-1)计算量/GFLOPs参数量/106FasterR-CNN(resnet-50)[1]97.295.891.080.510.2112.440.5MaskR-CNN(resnet-50)[27]97.596.091.581.08.5120.142.0YOLOv5m98.396.493.684.576.364.025.0YOLOv6m98.997.094.085.152.8161.151.9DetDSCI[16]97.596.191.783.658.6164.051.4YOLOv8s98.396.792.682.4143.528.411.1YOLOv8m98.796.994.585.472.778.725.8YOLOv8l98.497.494.585.343.2164.843.6YOLO11m98.597.695.286.158.3145.638.2RTMDet[28]98.297.094.085.030.6120.042.5DINO[29]98.697.394.786.525.0130.248.0本文方法98.998.096.887.164.981.629.1

图5 不同模型检测结果可视化对比

Figure 5 Visual comparison of detection results by different models

为了更直观地展示网络效果,单独对比了YOLOv8m和本文改进方案,如图6所示,YOLOv8m易将耕地、低矮平房错检为变电站,部分场景下还存在明显漏检,本文方法则无此类问题。

图6 误检情况对比

Figure 6 Comparison of false detection cases

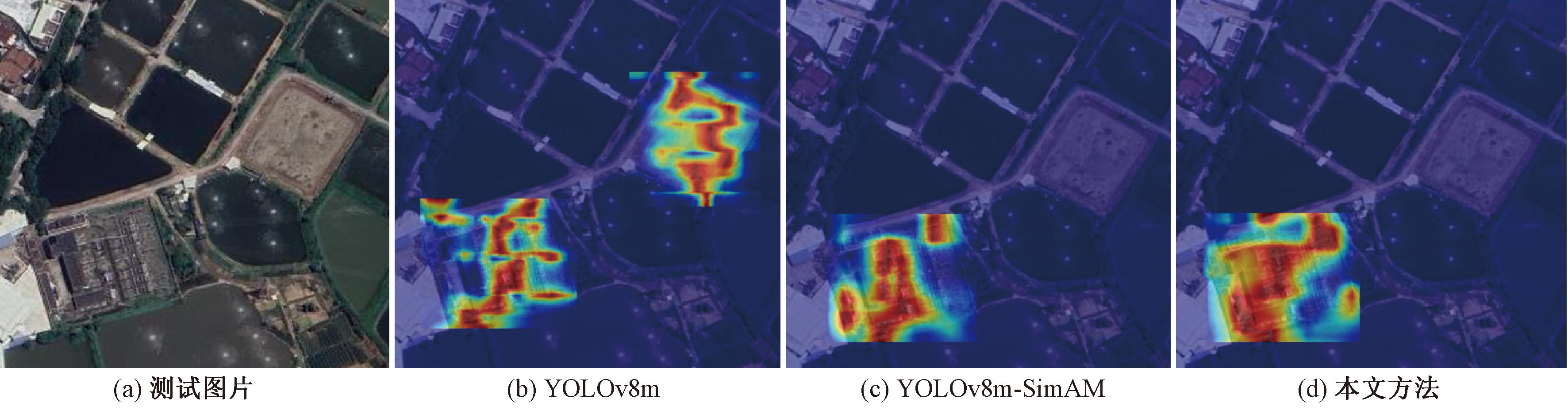

为进一步探究本文改进的有效性,以热力图的形式可视化了模型的注意力分布,如图7所示。从热力图来看,SimAM能够强化与变电站相关的特征并抑制无关背景,使网络更能注意到变电站区域内的细节信息,减少模型对非目标物体的响应,从而与周围地物,如建筑物、耕地、操场等区分开来,降低误检率。GDFPN颈部结构利用多尺度特征融合策略和动态上采样技术可以为后续的检测头提供更丰富的信息,进一步提升了检测精度。

图7 热力图可视化

Figure 7 Heatmap visualization

实验结果表明,本文对YOLOv8m模型进行优化,在处理遥感影像中远距离、复杂背景下的变电设备方面,相较于原始模型展现出了更强的抗干扰性能和更高的精确度。这种提升主要体现在模型能够更有效地区分与变电站目标相似的干扰物,同时保持了高准确率的检测结果。此外,本文所采用的改进措施并未对原模型的主干网络和检测模块进行改动。因此,改进后的模型保持了与原始模型相同的广泛适用性。这种优化在不牺牲通用性的前提下,提高了特定场景下的目标检测能力。

4 结论

YOLOv8因其高效和实时的目标检测能力在自然图像目标检测中得到了广泛应用。本文为适应遥感场景下变电站检测任务,在其基础上引入SimAM注意力机制,并提出了基于多尺度高效特征融合策略及动态上采样技术的改进颈部结构GDFPN,有效减少了误检情况。相比YOLOv8m,改进方法平均检测精度mAP75由94.5%提升至96.8%,提高了2.3百分点;mAP50-95由85.4%提升至87.1%,提高了1.7百分点。改进方法能够生成准确的变电站边界且不易受周围相似地物干扰。此外,本文所提出的方法对于遥感影像大型设施识别,如机场、港口等,具有一定启发的意义。

(本文受到蓝天实验室无人机警务应用科研项目“基于智联网的无人机监测定位与反制系统”(LTJW-24-02-03)的支持。)

[1] REN S Q,HE K M,GIRSHICK R,et al.Faster R-CNN:towards real-time object detection with region proposal networks[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,39(6):1137-1149.

[2] REDMON J,DIVVALA S,GIRSHICK R,et al.You only look once:unified,real-time object detection[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Piscataway:IEEE,2016:779-788.

[3] REDMON J,FARHADI A.YOLO9000:better,faster,stronger[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Piscataway:IEEE,2017:6517-6525.

[4] REDMON J,FARHADI A.YOLOv3:an incremental improvement[EB/OL].(2018-04-08)[2025-03-29].https:∥arxiv.org/abs/1804.02767.

[5] BOCHKOVSKIY A,WANG C Y,LIAO H M.YOLOv4:optimal speed and accuracy of object detection[EB/OL].(2020-04-23)[2025-03-29].https:∥arxiv.org/abs/2004.10934.

[6] WANG C Y,BOCHKOVSKIY A,LIAO H M.YOLOv7:trainable bag-of-freebies sets new state-of-the-art for real-time object detectors[C]∥2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).Piscataway:IEEE,2023:7464-7475.

[7] LIU W,ANGUELOV D,ERHAN D,et al.SSD:single shot MultiBox detector[C]∥Computer Vision-ECCV 2016.Cham:Springer,2016:21-37.

[8] SUN H B,SHEN Q C,KE H C,et al.Power transmission lines foreign object intrusion detection method for drone aerial images based on improved YOLOv8 network[J].Drones,2024,8(8):346.

[9] SHI J Y,BAI Y H,ZHOU J,et al.Multi-crop navigation line extraction based on improved YOLO-v8 and threshold-DBSCAN under complex agricultural environments[J].Agriculture,2024,14(1):45.

[10] XUE F C,CHENG Y N,SHEN Y F,et al.Urban flood inundation area detection using YOLOv8 model[J].Water Resources Management,2025,39:5443-5460.

[11] 邝先验,程福军,吴翠琴,等.基于改进YOLOv7-tiny的高效轻量遥感图像目标检测方法[J].电子测量与仪器学报,2024,38(7):22-33.KUANG X Y,CHENG F J,WU C Q,et al.Efficient and lightweight target detection method for remote sensing images based on improved YOLOv7-tiny[J].Journal of Electronic Measurement and Instrument,2024,38(7):22-33.

[12] 魏明军,王镆涵,刘亚志,等.基于特征融合和混合注意力的小目标检测[J].郑州大学学报(工学版),2024,45(3):72-79.WEI M J,WANG M H,LIU Y Z,et al.Small object detection based on feature fusion and mixed attention[J].Journal of Zhengzhou University (Engineering Science),2024,45(3):72-79.

[13] 鲁玲,李明良,熊威,等.基于改进的YOLOv8变电设备红外图像检测[J].红外技术,2025,47(9):1135-1141.LU L,LI M L,XIONG W,et al.Infrared image detection of substation equipment based on improved YOLOv8[J].Infrared Technology,2025,47(9):1135-1141.

[14] 李斌,李亚霖,朱新山,等.基于注意力机制与特征平衡的变电站多目标检测[J].电网技术,2022,46(6):2122-2132.LI B,LI Y L,ZHU X S,et al.Multi-target detection in substation scence based on attention mechanism and feature balance[J].Power System Technology,2022,46(6):2122-2132.

[15] PENG J,LIU Y B,MA Y,et al.Deep transfer learning for power substation recognition with Google Earth[C]∥2018 15th International Computer Conference on Wavelet Active Media Technology and Information Processing (ICCWAMTIP).Piscataway:IEEE,2018:54-57.

[16] PÉREZ-HERN NDEZ F,RODR

NDEZ F,RODR GUEZ-ORTEGA J,BENHAMMOU Y,et al.CI-dataset and DetDSCI methodology for detecting too small and too large critical infrastructures in satellite images:airports and electrical substations as case study[J].IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing,2021,14:12149-12162.

GUEZ-ORTEGA J,BENHAMMOU Y,et al.CI-dataset and DetDSCI methodology for detecting too small and too large critical infrastructures in satellite images:airports and electrical substations as case study[J].IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing,2021,14:12149-12162.

[17] MESVARI M,SHAH-HOSSEINI R.Segmentation of electrical substations using deep convolutional neural network[J].ISPRS Annals of Photogrammetry,Remote Sensing and Spatial Information Sciences,2023,10(4):495-500.

[18] YANG L X,ZHANG R Y,LI L D,et al.SimAM:a simple,parameter-free attention module for convolutional neural networks[C]∥ International Conference on Machine Learning.ICML:San Diego,2021:18-24.

[19] JIANG Y Q,TAN Z Y,WANG J Y,et al.GiraffeDet:a heavy-neck paradigm for object detection[EB/OL].(2022-02-09)[2025-03-29].https:∥arxiv.org/abs/2202.04256.

[20] XU X Z,JIANG Y Q,CHEN W H,et al.DAMO-YOLO:a report on real-time object detection design[EB/OL].(2022-11-23)[2025-03-29].https:∥arxiv.org/abs/2211.15444.

[21] WANG C Y,MARK LIAO H Y,WU Y H,et al.CSPNet:a new backbone that can enhance learning capability of CNN[C]∥2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops (CVPRW).Piscataway:IEEE,2020:390-391.

[22] LIU W Z,LU H,FU H T,et al.Learning to upsample by learning to sample[C]∥2023 IEEE/CVF International Conference on Computer Vision (ICCV).Piscataway:IEEE,2023:6004-6014.

[23] SHI W Z,CABALLERO J,HUSZ R F,et al.Real-time single image and video super-resolution using an efficient sub-pixel convolutional neural network[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Piscataway:IEEE,2016:1874-1883.

R F,et al.Real-time single image and video super-resolution using an efficient sub-pixel convolutional neural network[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Piscataway:IEEE,2016:1874-1883.

[24] WOO S,PARK J,LEE J Y,et al.CBAM:convolutional block attention module[C]∥ Computer Vision-ECCV 2018.Cham:Springer,2018:3-19.

[25] XIA Z F,PAN X R,SONG S J,et al.Vision transformer with deformable attention[C]∥2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).Piscataway:IEEE,2022:4784-4793.

[26] LIU Z,LIN Y T,CAO Y,et al.Swin transformer:hierarchical vision transformer using shifted windows[C]∥2021 IEEE/CVF International Conference on Computer Vision (ICCV).Piscataway:IEEE,2021:9992-10002.

[27] HE K M,GKIOXARI G,DOLL R P,et al.Mask R-CNN[C]∥2017 IEEE International Conference on Computer Vision (ICCV).Piscataway:IEEE,2017:2980-2988.

R P,et al.Mask R-CNN[C]∥2017 IEEE International Conference on Computer Vision (ICCV).Piscataway:IEEE,2017:2980-2988.

[28] LYU C Q,ZHANG W W,HUANG H A,et al.RTMDet:an empirical study of designing real-time object detectors[EB/OL].(2022-12-14)[2025-03-29].https:∥arxiv.org/abs/2212.07784.

[29] ZHANG H,LI F,LIU S L,et al.DINO:DETR with improved denoising anchor boxes for end-to-end object detection[EB/OL].(2022-07-11)[2025-03-29].https:∥arxiv.org/abs/2203.03605.