伪装目标检测(camouflaged object detection,COD)任务旨在检测出图像中与背景高度相似且边缘辨识度低的对象。高效的伪装目标检测方法不仅可以应用于医学、农业及工业等各个领域,同时也能为其他的检测任务提供解决方法。近年来,随着大规模数据集如CAMO[1]、COD10K[2]和NC4K[3]等的提出,许多基于深度学习的COD方法不断涌现。例如,2020年,Fan等[2]设计了一个伪装目标搜索识别网络SINet,将COD任务分为搜索和识别两个阶段来定位和细化伪装目标;2021年,Lv等[3]提出了一个基于排序的LSR网络,该网络在统一的框架中构建三重任务来同时定位、分割和排序伪装对象;2022年,Pang等[4]设计了一个混合尺度三元组网络ZoomNet,通过对伪装对象的尺度变化行为进行显式建模来实现检测任务;2023年,Song等[5]设计了一种双骨干网络FDNet,使用基于特征嫁接和干扰感知的策略聚合双骨干中的信息并消除潜在的干扰;同年,Huang等[6]提出了一个特征收缩金字塔网络FSPNet,利用特征探索与特征收缩策略来挖掘和聚合伪装对象线索。

虽然上述方法能够定位和分割出图像中包含伪装对象的区域,但它们仍未能精准地分割伪装对象的边界,且分割结果中普遍存在检测不完整的现象。针对上述问题,研究者们提出了多种基于边缘信息引导或基于纹理信息引导的方法来增强分割特征,以获取更精细的预测结果。例如,2022年,Sun等[7]提出了一种边缘引导网络BGNet,将探索到的边缘线索与对象特征进行聚合,引导网络学习对象的结构语义特征表示;同年,Zhu等[8]设计了一种边缘引导分离注意力模型BSA-Net;2023年,Sun等[9]提出了一种边缘感知镜像网络EAMNet,该网络采用包含边缘分支和分割分支的双分支架构来协同增强边缘特征和分割特征;同年,Ji等[10]提出一个利用双编码器提取对象与纹理特征的网络DGNet,该网络融合这两种特征进行最终预测。然而,以上方法中仍存在两个主要问题:①没有考虑对边缘细节和纹理线索的共同关注。②在使用边缘或纹理信息来辅助检测任务时仅使用较直接的特征引导方式,如BGNet仅使用逐元素相乘的策略来结合边缘与对象特征;BSA-Net仅通过较简单的加权相乘并相加的方式将边缘信息嵌入到伪装对象的前景与背景特征中;DGNet则设计了软分组策略,通过分组学习的方式较直接地使用梯度纹理信息来增强对象特征。总之,上述方法没有考虑多源信息间的相关性,可能会引入额外的噪声干扰,且导致网络无法充分学习多源信息中的对象线索,从而影响检测结果。

为了有效地减少引入边缘和纹理信息所带来的干扰,并充分利用这些信息来辅助检测任务以获得更精细的检测结果,本文提出了一种高效的边缘-纹理引导增强网络(edge-texture guided enhancement network, ETGENet)。首先,利用边缘与纹理感知解码器(edge &texture perception decoder, ETPD)来获取伪装对象精细的边缘和纹理先验信息;其次,设计了一种特征引导增强模块(feature guided enhancement module, FGEM),该模块通过计算边缘和纹理特征与对象特征间的引导注意力权重,使网络更加关注伪装对象的边缘和纹理信息,从而增强对象特征的表示能力;最后,提出了一种特征交互融合模块(feature interaction fusion module, FIFM),利用交互融合策略,FIFM能够有效地增强和聚合相邻层级特征,以获得整体语义更加完善的预测结果。

1 边缘-纹理引导增强网络

1.1 整体结构

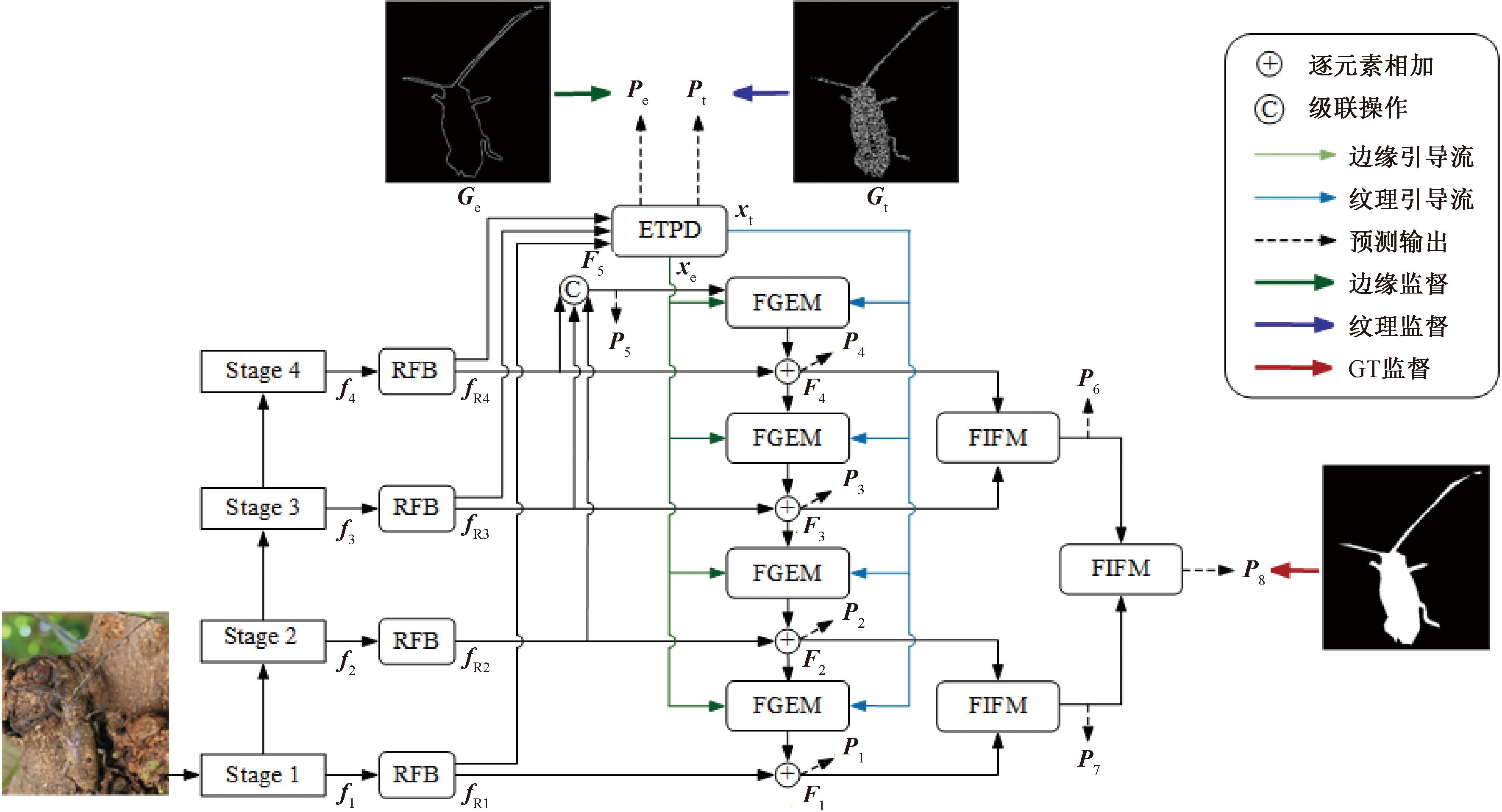

本文提出的ETGENet的整体结构如图1所示。具体来说,对于给定的一张RGB图像,首先,采用PVT v2(pyramid vision transformer v2)[11]作为编码器来逐层级提取图像特征,记为{fi,i∈1,2,3,4}。随后,利用感受野模块(receptive field block, RFB)[12]处理各层级信息,以获取更丰富的多尺度特征,即{fRi,i∈1,2,3,4}。经过RFB后,使用边缘与纹理感知解码器(ETPD)从低级特征fR1和高级特征(fR3、fR4)中提取出与伪装目标相关的边缘信息xe和纹理信息xt。同时,利用后3个层级的特征通过拼接和卷积操作生成具有更丰富语义的特征F5。随后,通过多个特征引导增强模块FGEM,自上而下地将来自ETPD的xe、xt与多级特征fR2、fR3、fR4和F5集成在一起,以引导网络关注边缘和纹理信息,从而增强伪装目标及其边界特征的表示能力。最后,本文采用多个特征交互融合模块FIFM,以渐进融合的方式聚合多级特征,逐步细化对象预测。在推理过程中,本文选择最后一个FIFM的预测作为最终结果。

图1 ETGENet整体结构

Figure 1 Overall structure of ETGENet

1.2 基于Transformer的特征提取

本文采用PVT v2作为特征提取的骨干网络。具体来说,PVT v2结合了CNN中的金字塔结构,使用渐进式收缩金字塔来生成多尺度特征,随着网络深度增加,Transformer的序列长度逐渐减小,从而显著减少了计算量。同时,利用线性空间缩减注意力的设计,PVT v2进一步缩减了自注意力计算时的空间维度,从而有效降低了学习高分辨率特征时的资源消耗。此外,PVT v2使用重叠补丁嵌入的序列化方式在相邻图像的Patch之间建立重叠区域,使得模型能够在全局建模的同时更好地捕捉图像中的局部细节信息。

1.3 边缘-纹理感知解码器

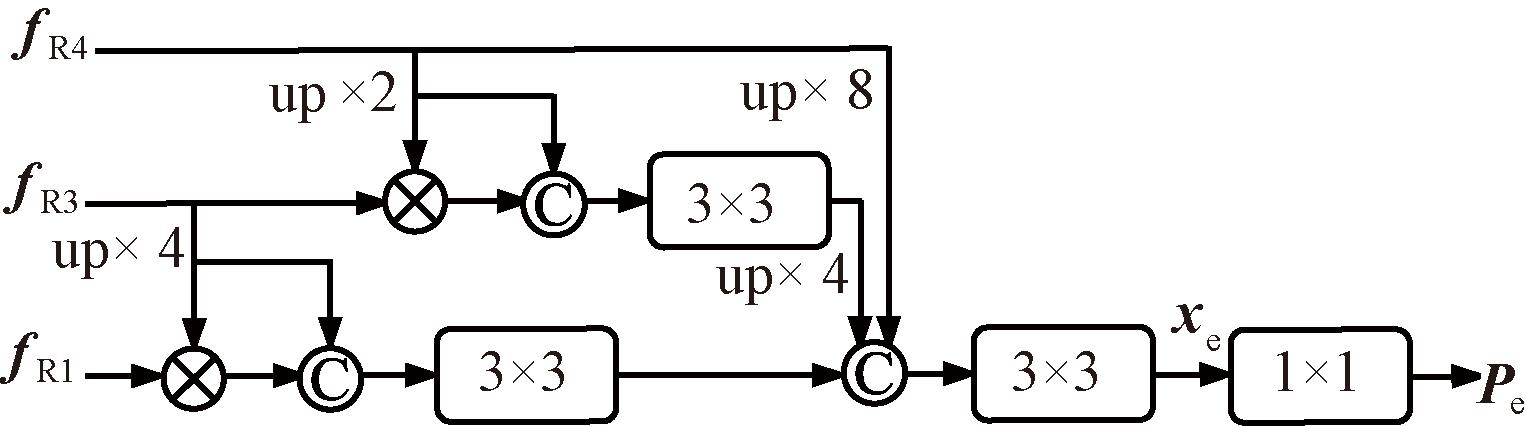

在COD任务中,良好的边缘先验信息常被作为有效的辅助线索广泛应用[7]。同时,伪装物体内部丰富的梯度信息也是一个有价值的探索方向[10]。故本文同时结合两种线索来辅助检测任务。具体来说,本文提出的边缘-纹理感知解码器(ETPD)包含两个结构相同的解码器,即边缘感知解码器(edge perception decoder, EPD)和纹理感知解码器(texture perception decoder, TPD),分别用于生成具有针对性的伪装对象的边缘特征xe与纹理特征xt。以EPD为例,使用经RFB增强后的骨干特征fR1、fR3和fR4进行解码。其中,低层特征包含了丰富的局部细节线索[13],而高层特征则具有能够减少干扰的全局位置信息。图2为边缘感知解码器。首先,EPD对fR1与fR3、fR3与fR4进行逐元素乘法,并通过跳跃连接和3×3卷积得到跨层级细化特征;其次,对3个分支的细化特征进行拼接,并利用3×3卷积生成xe;最后,使用1×1卷积及Sigmoid操作得到伪装对象的边缘预测Pe。同理,通过TPD也可以获得xt及其纹理预测Pt。对于得到的边缘与纹理预测图,本文使用对象边缘图Ge和对象纹理图Gt对二者进行监督。其中,对象边缘图通过Canny算法生成,对象纹理图则直接使用文献[10]中所提供的梯度级纹理标签。为了降低ETPD所占用的计算复杂度,这里未使用fR2。上述过程可以表示为

(1)

xe或xt=Conv3([fR4↑,(Conv3(Cat(fR4↑,fR4↑⊗fR3)))↑,Conv3(Cat(fR3↑,fR3↑⊗fR1)))。

(2)

式中:σ(·)为Sigmoid操作;Conv1(·)为1×1卷积;↑为上采样操作;Conv3(·)为3×3卷积;Cat(·)为级联操作;⊗为逐元素相乘。

图2 边缘感知解码器

Figure 2 Edge perception decoder

1.4 特征引导增强模块

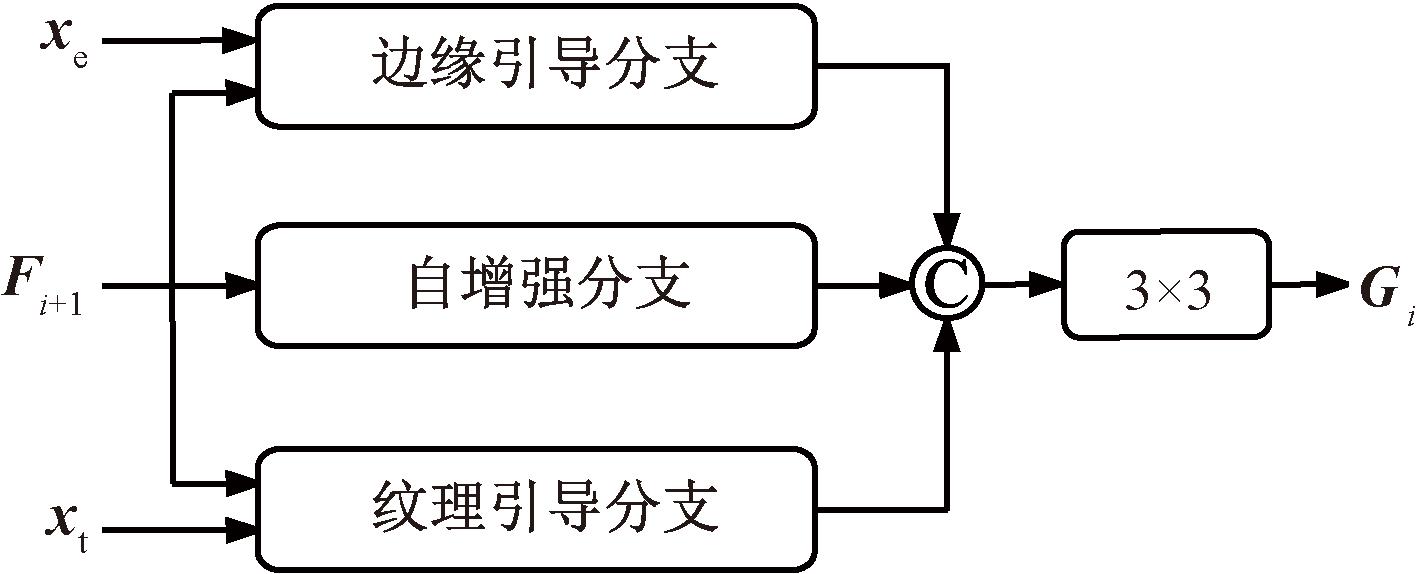

在形状大小各异且遮挡严重的复杂伪装场景下,增强网络对于对象边缘和纹理信息的表征能力至关重要。受到文献[14]中改进的自注意力模块的启发,本文提出了一种特征引导增强模块FGEM,以更充分地利用边缘-纹理线索对网络进行引导,并减少多源信息中不稳定因素所带来的干扰。图3为特征引导增强模块。以第i个层级中的FGEM为例,FGEM接收对象特征Fi+1和由ETPD生成的边缘特征xe、纹理特征xt,将这3个特征作为输入,通过自增强分支、边缘引导分支以及纹理引导分支对对象特征进行引导和优化。

图3 特征引导增强模块

Figure 3 Feature guide enhancement module

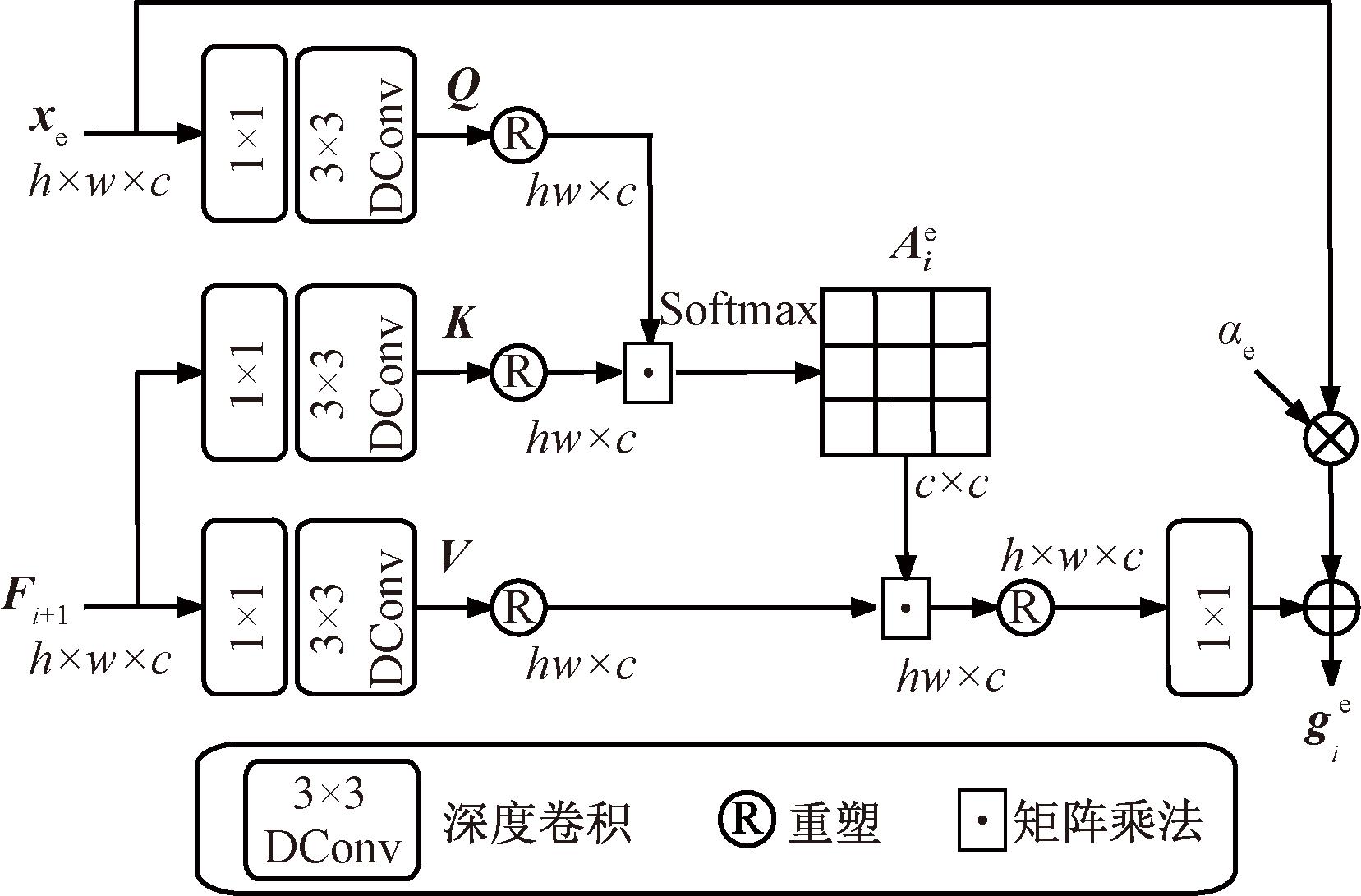

对于边缘引导分支,通过构建跨通道间的相关性矩阵来隐式地对不同特征之间的全局上下文关系进行建模,从而获得经过引导增强后的对象特征。图4为边缘引导分支。

图4 边缘引导分支

Figure 4 Edge guide branch

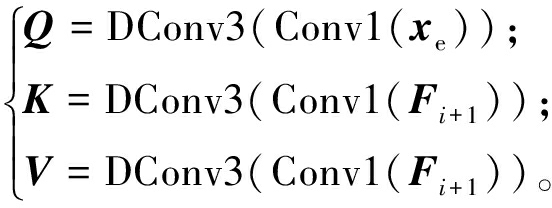

如图4所示,首先,对输入的边缘特征xe和对象特征Fi+1进行卷积处理,即通过1×1卷积分别聚合两种特征不同通道上的信息,再利用3×3深度卷积在通道级别上对空间上下文特征进行编码,从而捕捉特征的局部结构。经过这个过程,xe生成查询Q,而Fi+1生成键K和值V:

(3)

式中:DConv3(·)表示3×3深度卷积。其次,对Q和K进行重塑,并对二者进行矩阵相乘和Softmax操作,以生成引导注意力权重矩阵![]() 中的每个像素分别代表了两个向量间对应位置的相似性度量,反映了边缘特征与对象特征之间的相关程度。其中,相关程度较高的有效特征被分配更大的权重,而相关程度较低的噪声干扰将得到抑制。再次,通过矩阵乘法运算,利用

中的每个像素分别代表了两个向量间对应位置的相似性度量,反映了边缘特征与对象特征之间的相关程度。其中,相关程度较高的有效特征被分配更大的权重,而相关程度较低的噪声干扰将得到抑制。再次,通过矩阵乘法运算,利用![]() 对重塑后的V进行加权,从而引导模型关注与边缘特征高度相关的对象特征区域,最终生成具有针对性的对象特征。最后,将经过引导注意力细化后的对象特征进行重塑和1×1卷积处理,并与加权后的xe相加得到受边缘特征引导增强后的对象特征

对重塑后的V进行加权,从而引导模型关注与边缘特征高度相关的对象特征区域,最终生成具有针对性的对象特征。最后,将经过引导注意力细化后的对象特征进行重塑和1×1卷积处理,并与加权后的xe相加得到受边缘特征引导增强后的对象特征![]() 上述过程可写为

上述过程可写为

(4)

式中:αe为可学习的权重参数,用于自适应地对边缘特征进行补充;Softmax(·)为Softmax操作;α为可学习的缩放因子,用于确保K与Q的点积在一个合理的范围内。

类似于边缘引导分支,纹理引导分支以纹理特征xt和对象特征Fi+1作为输入,生成受纹理特征引导增强后的对象特征

(5)

式中:αt为可学习的权重参数,用于自适应地对纹理特征进行补充;β为可学习的缩放因子。

自增强分支仅以对象特征Fi+1作为输入,通过自注意力计算的方式来捕捉图像的全局上下文信息,从而得到细化特征gi:

(6)

式中:αs为可学习的权重参数,用于自适应地对对象特征进行补充;γ为可学习的缩放因子。

将3个分支中的细化特征进行拼接,从而获得多特征引导增强后的对象特征Gi。Gi与fRi相加得到Fi后被送到更浅层的FGEM中,从而生成更精细化的特征。同时,Fi在1×1卷积和进行上采样操作后生成粗略预测{Pi,i∈1,2,3,4,5},通过GT对网络进行深层监督。其中,第i个层级的聚合特征Fi可以写为

(7)

1.5 特征交互融合模块

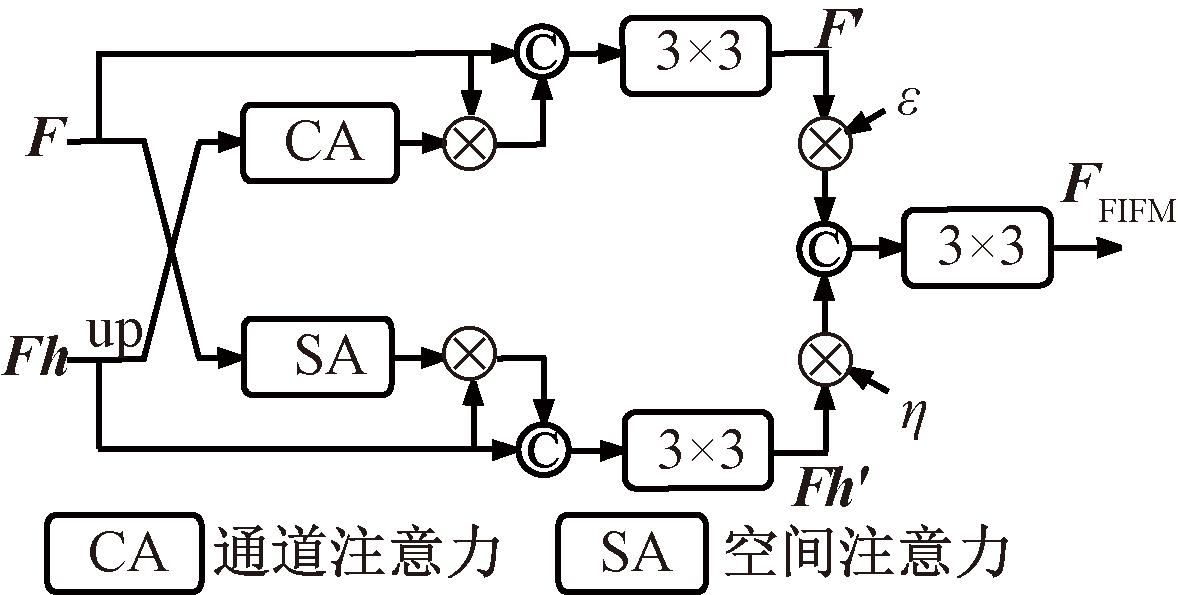

现有的COD方法通常使用自上而下的特征融合方式来聚合多层级特征,但高级特征中的对象语义会因此受到显著削弱。故本文提出了一种渐进融合的策略,通过3个特征交互融合模块FIFM来生成网络的最终预测结果。图5为特征交互融合模块。相较于简单的特征融合方法,FIFM采用了一种注意力交互融合的方式来获取更有效、更全面的特征表示。

图5 特征交互融合模块

Figure 5 Feature interaction fusion module

具体来说,对于输入的相邻特征,将低级特征记为F,高级特征记为Fh。为了充分探索相邻特征间的差异并挖掘互补信息,且同时关注高级特征中的通道信息和低级特征中的局部空间线索,FIFM使用F生成的空间注意力[15]与Fh进行逐元素相乘运算,并将得到的结果与Fh进行拼接得到Fh′,以补充Fh中的空间信息。同样,也利用Fh生成的通道注意力[15]与F进行逐元素相乘,将得到的结果与F进行拼接得到F′,以弥补F中的通道信息的不足。在这种双向交互后,两分支中的特征都可以学习到来自另外分支中的信息。上述过程分别写为

(8)

(9)

式中:SA(·)与CA(·)分别表示空间注意力和通道注意力;Avg(·)和Max(·)分别表示全局平均池化和全局最大池化操作;MLP(·)为共享多层感知机;Conv7(·)为7×7卷积。

本文对两个分支中的特征进行加权融合,从而生成关键信息更丰富且噪声更小的聚合特征FFIFM:

FFIFM=Conv3(Cat(ε⊗F′,η⊗Fh′))。

(10)

式中:ε和η为两个可学习的权重参数,这两个参数使网络自适应地聚合两个相邻特征。

在ETGENet中,每个FIFM输出的聚合特征均将在1×1卷积和上采样操作后生成对应的预测图{Pi,i∈6,7,8},本文以P8作为网络的最终预测。

1.6 损失函数

ETGENet的损失函数包括3种监督,即对象监督、边缘监督和纹理监督。受到文献[2]的启发,在对象监督中,本文使用二元交叉熵损失LwBCE和加权交并比损失LwIoU来对检测结果中的像素级差异和全局结构进行研究。这两种损失的计算方式与文献[16]中一致。

同时,受到文献[7]的启发,本文使用Dice损失LDice进行边缘监督,该损失可以更好地处理图像中不同类别间的像素数量不平衡的问题,故能够更有效地关注边缘部分的像素,有助于模型产生更加准确的边缘预测。对于纹理监督,采用文献[10]中的标准均方误差损失函数LMSE。本文所提出的模型共包含10个预测输出,分别为5个粗略图P1~P5、3个细化图P6~P8、1个边缘图Pe和1个纹理图Pt,因此,网络的总体损失Ltotal可以表示为

![]()

![]()

(11)

L=LwBCE+LwIoU。

(12)

式中:λ为权衡参数,在实验中设置其值为3。

2 实验设计

2.1 数据集

本文在CAMO、COD10K和NC4K这3个流行的公共基准数据集上评估了所提出的方法。其中,CAMO共包含了1 250张从互联网上收集的伪装图像,涵盖了8个伪装类别,1 000张图片被用于训练,剩余的250张图片被用于测试。COD10K是目前包含图像数量最多的COD数据集,研究人员通常使用其中的3 040张伪装图像进行COD方法的训练,2 026张进行测试。NC4K是目前最大的COD测试数据集,包含了4 121张伪装图像。

2.2 评估指标

COD广泛认可且最常用的评估指标为结构度量(S)[17]、加权F度量(F)[18]、平均绝对误差(M)和自适应增强匹配度量(E)[19]。其中,S用于评价两个图像的结构内容间的相似性;F为综合考虑精确率和召回率的指标;M用于计算地面真值和预测图像间的绝对像素差异;E用于评估预测图中全局信息和局部信息的精度。评估时,S、F和E越大越好,M越小越好。

2.3 实验细节

本文使用PyTorch深度学习框架,所有的实验均在Nvidia GeForce RTX 3090 GPU(24 GB显存)上运行。所有输入图像的大小设置为384×384,批量大小为24。实验中使用Adam优化器,初始学习率设置为1e-4,每50个周期学习率除以10,整个训练过程共包含100个周期。

3 实验结果与分析

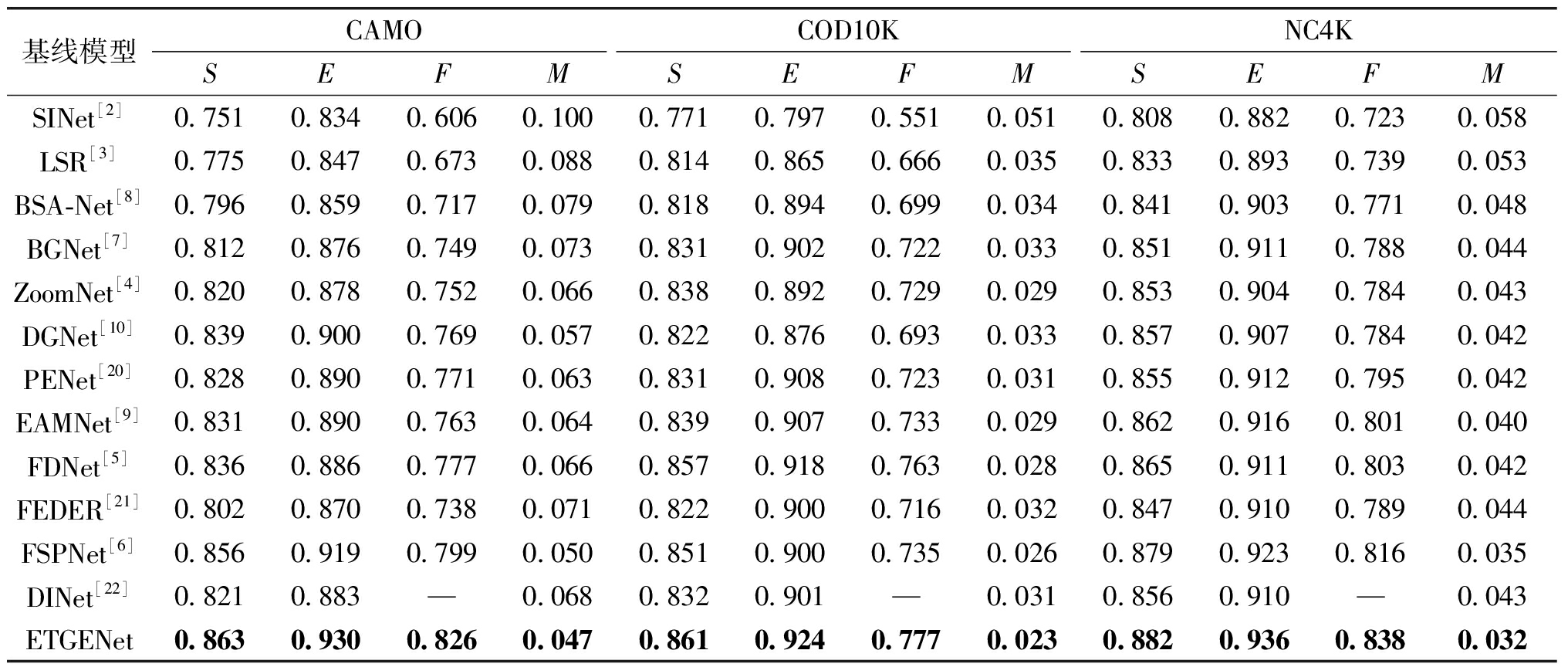

3.1 定量评估

为了展示所提方法的优越性,本文将其与12个COD方法进行了比较,表1为定量评估结果。由表1可知,ETGENet在所有评估指标上均取得了优异的性能。与同样使用了边缘感知的方法(EAMNet、BGNet和BSA-Net)和纹理感知的方法(DGNet)相比,ETGENet取得了明显的性能提升,其中,在最大的测试数据集NC4K上,ETGENet的F平均提升了5.2百分点,这一性能提升主要归功于本文提出的FGEM和FIFM模块,它们通过有效整合边缘与纹理线索来引导特征优化,从而显著提高了预测精度。

表1 定量评估结果

Table 1 Quantitative evaluation results

基线模型CAMOCOD10KNC4KSEFMSEFMSEFMSINet[2]0.7510.8340.6060.1000.7710.7970.5510.0510.8080.8820.7230.058LSR[3]0.7750.8470.6730.0880.8140.8650.6660.0350.8330.8930.7390.053BSA-Net[8]0.7960.8590.7170.0790.8180.8940.6990.0340.8410.9030.7710.048BGNet[7]0.8120.8760.7490.0730.8310.9020.7220.0330.8510.9110.7880.044ZoomNet[4]0.8200.8780.7520.0660.8380.8920.7290.0290.8530.9040.7840.043DGNet[10]0.8390.9000.7690.0570.8220.8760.6930.0330.8570.9070.7840.042PENet[20]0.8280.8900.7710.0630.8310.9080.7230.0310.8550.9120.7950.042EAMNet[9]0.8310.8900.7630.0640.8390.9070.7330.0290.8620.9160.8010.040FDNet[5]0.8360.8860.7770.0660.8570.9180.7630.0280.8650.9110.8030.042FEDER[21]0.8020.8700.7380.0710.8220.9000.7160.0320.8470.9100.7890.044FSPNet[6]0.8560.9190.7990.0500.8510.9000.7350.0260.8790.9230.8160.035DINet[22]0.8210.883—0.0680.8320.901—0.0310.8560.910—0.043ETGENet0.8630.9300.8260.0470.8610.9240.7770.0230.8820.9360.8380.032

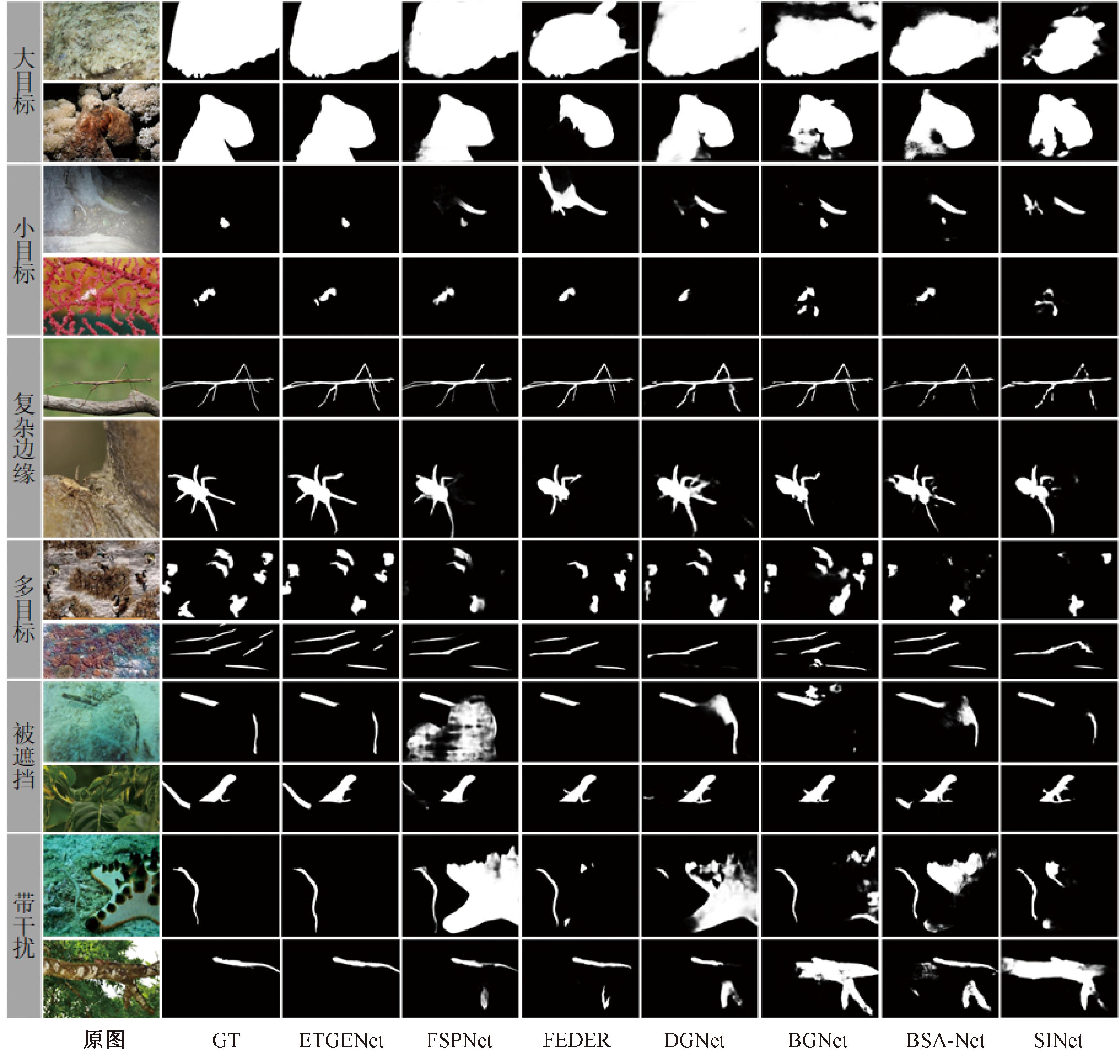

3.2 定性评估

图6显示了本文模型与较先进的方法以及同样引入了边缘或纹理信息的方法的定性评估结果。由图6可以看出,ETGENet能够检测出更完整的对象结构且能抑制噪声的干扰。同时,其预测结果的边缘细节还原度更好,并能更准确定位和分割目标区域,拥有更优越的性能。

图6 定性评估结果

Figure 6 Qualitative evaluation results

3.3 消融实验

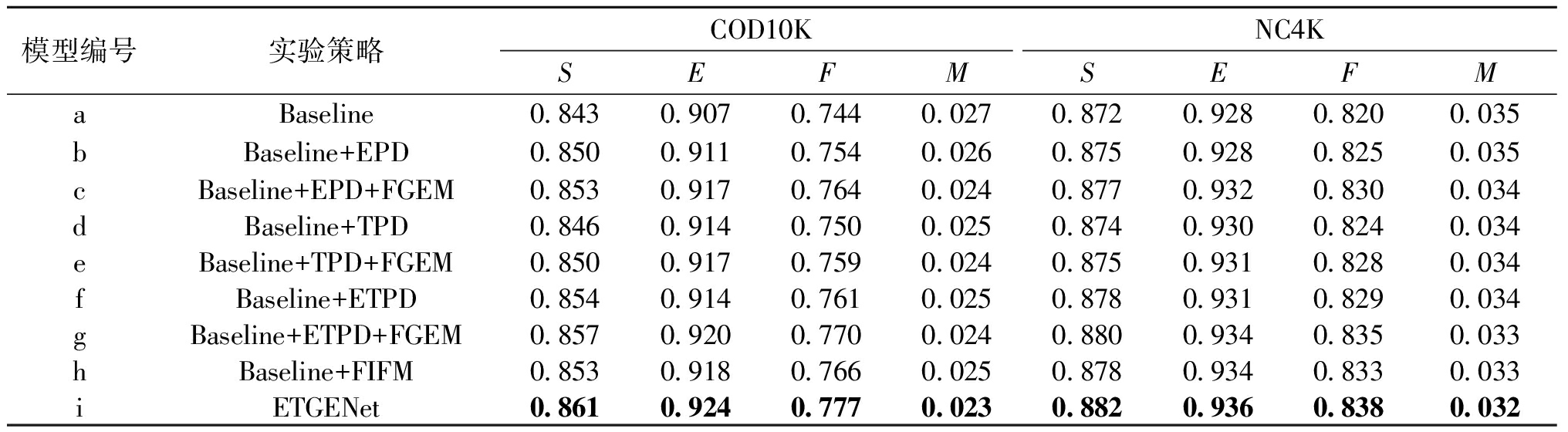

为了验证引入边缘和纹理信息以及两个关键模块FGEM和FIFM的有效性,本文在COD10K与NC4K数据集上对本文方法ETGENet进行了消融实验。表2为消融实验定量评估结果。表2中,对于基线模型a,本文删除了全部的附加模块(即ETPD、FGEM和FIFM),仅使用RFB模块处理骨干特征,并通过相加操作来自上而下地聚合多级特征生成最终预测;模型b、d、f在模型a的基础上分别引入边缘信息、纹理信息以及边缘和纹理信息,这些信息通过相加的方式对对象特征进行引导并生成预测;模型c、e、g将模型b、d、f中相加的引导方式替换为所提出的FGEM;模型h在模型a的基础上将自上而下的特征融合方式替换为FIFM;模型i则是最终模型。

表2 消融实验定量评估结果

Table 2 Quantitative evaluation results of ablation experiments

模型编号实验策略COD10KNC4KSEFMSEFMaBaseline0.8430.9070.7440.0270.8720.9280.8200.035bBaseline+EPD0.8500.9110.7540.0260.8750.9280.8250.035cBaseline+EPD+FGEM0.8530.9170.7640.0240.8770.9320.8300.034dBaseline+TPD0.8460.9140.7500.0250.8740.9300.8240.034eBaseline+TPD+FGEM0.8500.9170.7590.0240.8750.9310.8280.034fBaseline+ETPD0.8540.9140.7610.0250.8780.9310.8290.034gBaseline+ETPD+FGEM0.8570.9200.7700.0240.8800.9340.8350.033hBaseline+FIFM0.8530.9180.7660.0250.8780.9340.8330.033iETGENet0.8610.9240.7770.0230.8820.9360.8380.032

3.3.1 边缘与纹理信息的有效性

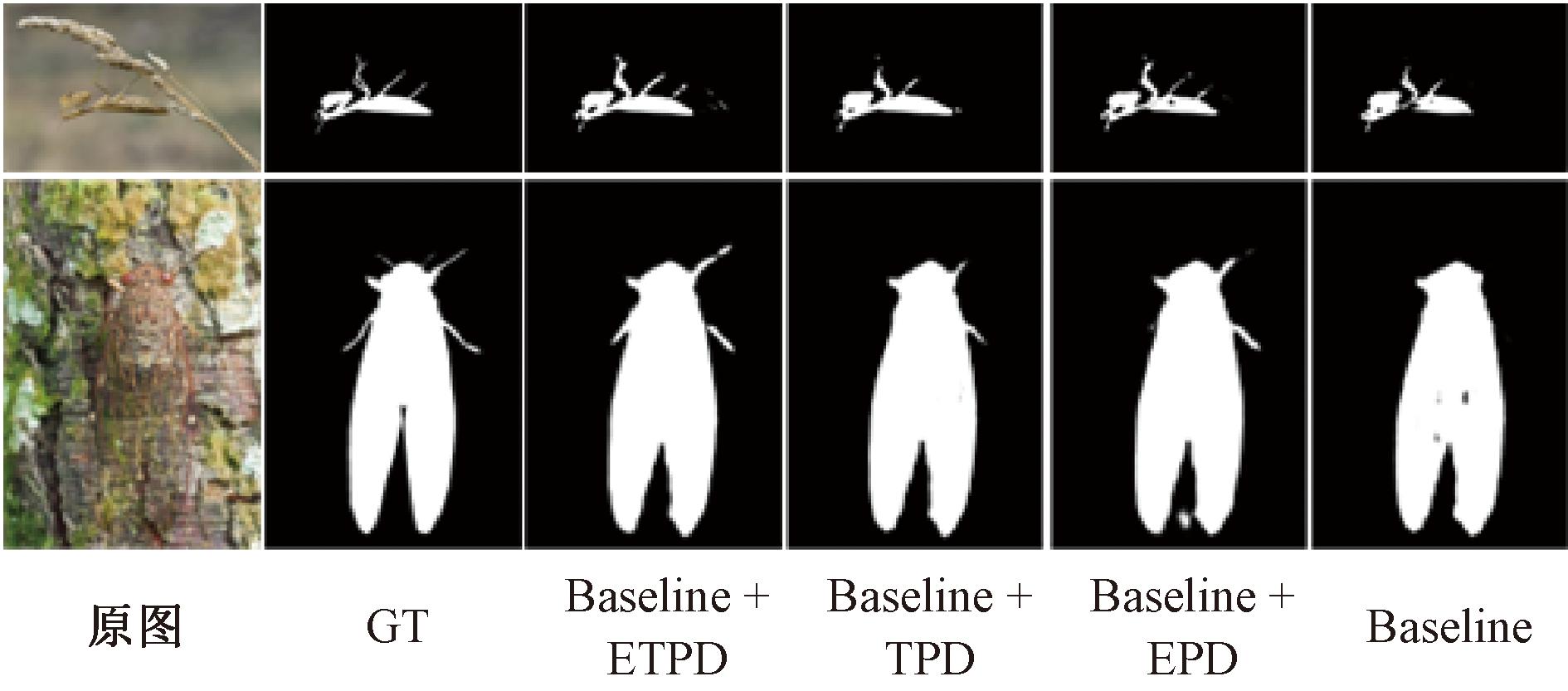

本文首先评估了引入边缘与纹理信息对模型的贡献。如表2所示,模型b、d和f在所有评估指标上均优于模型a,同时模型f相较于模型b、d实现了更好的整体性能。图7为引入边缘和纹理信息的消融实验对比。从图7可以看出,相比于基线模型a,在添加边缘信息后,预测结果中的边缘细节更加准确;在添加纹理信息后,网络预测中的假阴性情况得到了明显改善;而同时添加边缘和纹理信息后,网络获得了边缘细节更充足且对象更完整的检测结果。

图7 引入边缘和纹理信息的消融实验对比

Figure 7 Comparison of ablation experiments of introducing edge and texture information

3.3.2 特征引导增强模块的有效性

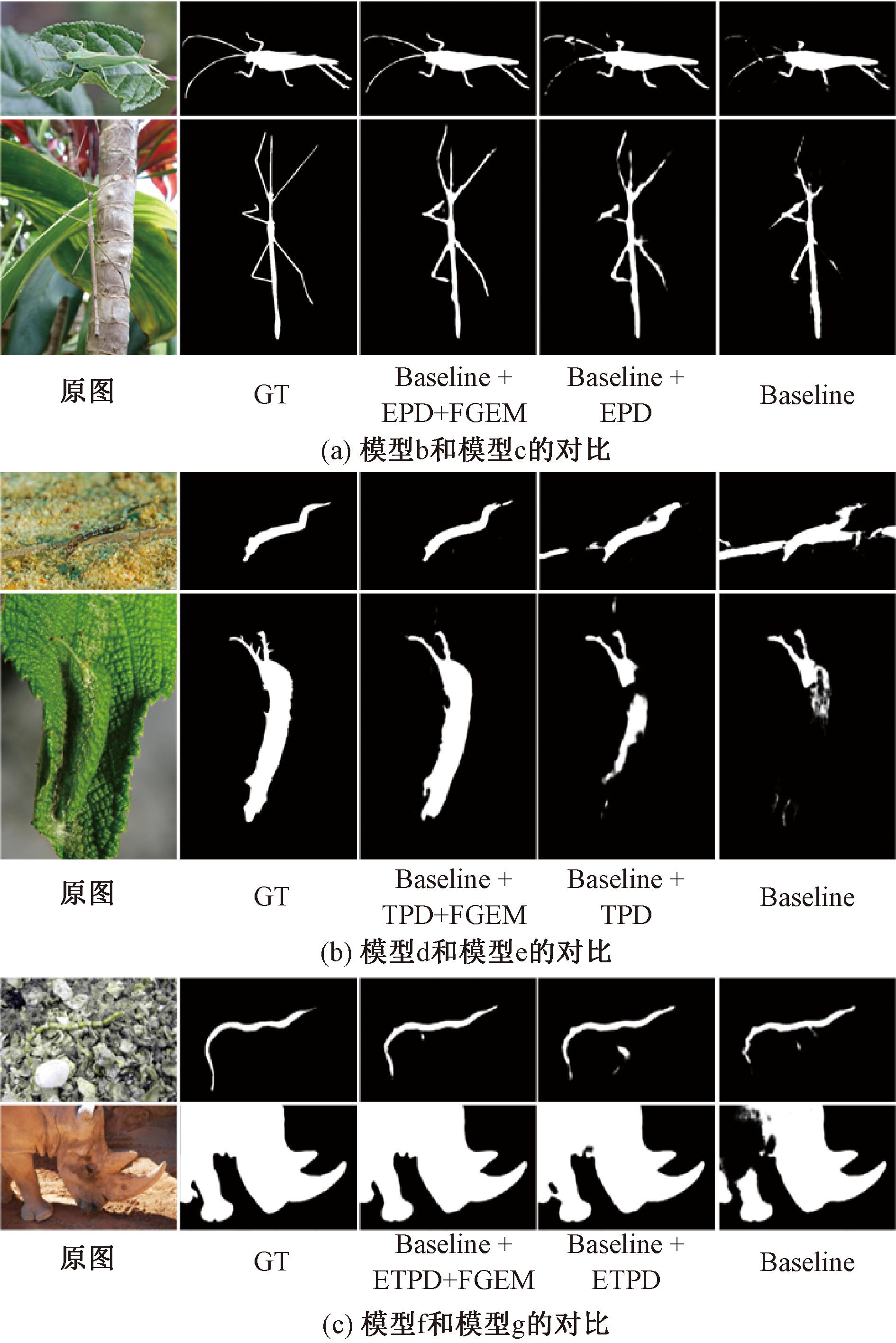

为了验证FGEM的有效性,本文对模型b和c、模型d和e以及模型f和g的实验结果进行了深入分析。由表2可知,在添加了FGEM后,各模型的检测性能均有所提升,这是由于该模块能够利用引导注意力进行更充分的特征引导。

图8为特征引导增强模块的消融实验对比。从图8(a)~8(c)的定性评估结果可以看出,在模型b的基础上添加FGEM后,ETGENet生成的检测结果中与对象相关的边缘区域更加完整、精细;在模型d的基础上添加FGEM后,可以减少直接引入纹理信息所导致的假阴性或假阳性错误;在模型f的基础上添加FGEM后,检测结果更完整、噪声更小以及在边缘细节上表现更好,这也充分证明了设计的模型可以更好地利用边缘和纹理信息辅助检测任务,从而提升分割质量。

图8 特征引导增强模块的消融实验对比

Figure 8 Comparison of ablation experiments of FGEM

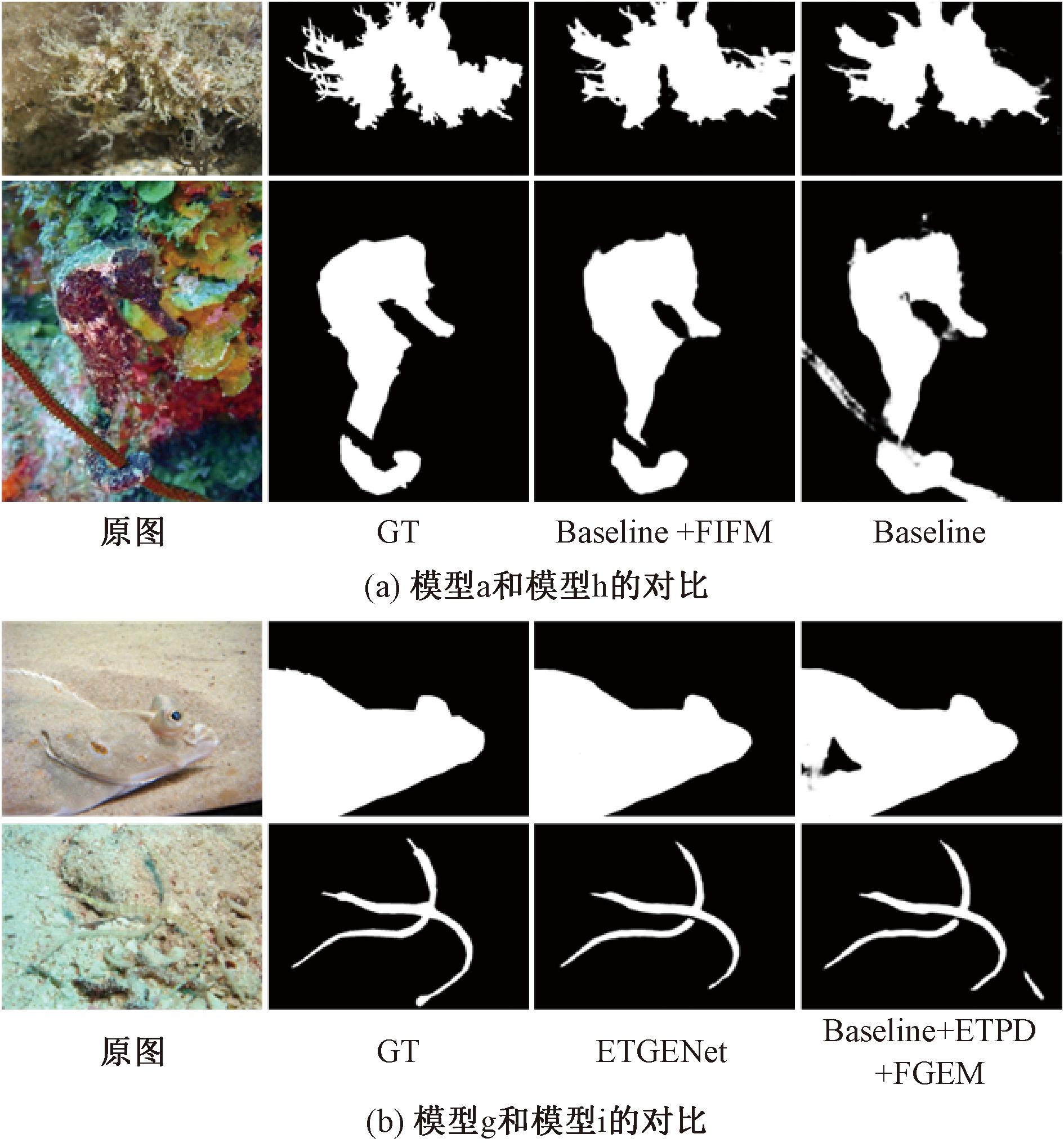

3.3.3 特征交互融合模块的有效性

本文使用两组不同的网络来分析FIFM所起到的作用,分别为模型a和h、模型g和i。由表2可知,包含FIFM的模型(h和i)可以在渐进的相邻层级聚合过程中获得更好的COD性能。图9为特征交互融合模块的消融实验对比。从图9(a)可以看出,添加FIFM后,网络的预测结果更加精细和完整;从图9(b)可以看出,当在模型i的基础上去除FIFM得到模型g时,网络的预测中容易丢失对象信息或者产生假阳性错误,这进一步验证了所提出的FIFM的有效性。

图9 特征交互融合模块的消融实验对比

Figure 9 Comparison of ablation experiments of FIFM

4 结论

本文提出了一种边缘-纹理引导增强网络ETGENet来进行精确的伪装目标检测。具体来说,网络中的边缘与纹理感知解码器可以有效获取与伪装对象相关的边缘和纹理信息。同时,所提出的特征引导增强模块能够通过多分支的并行处理和引导注意力细化操作使得网络更充分地利用所提取的多种类型对象线索,并增强网络的抗干扰能力。此外,特征交互融合模块能够通过交互和加权融合策略对不同层级的网络特征进行有效聚合,从而生成更完整的网络预测结果。在3个公共数据集上与其他方法的对比结果表明,所提出的ETGENet表现出更好的检测性能。在未来的工作中,将对网络进行轻量化研究,以实现更加高效的伪装目标检测。

[1] LE T N, NGUYEN T V, NIE Z L, et al. Anabranch network for camouflaged object segmentation[J]. Computer Vision and Image Understanding, 2019, 184: 45-56.

[2] FAN D P, JI G P, SUN G L, et al. Camouflaged object detection[C]∥2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Piscataway:IEEE, 2020: 2774-2784.

[3] LV Y Q, ZHANG J, DAI Y C, et al. Simultaneously localize, segment and rank the camouflaged objects[C]∥2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway:IEEE, 2021: 11586-11596.

[4] PANG Y W, ZHAO X Q, XIANG T Z, et al. Zoom in and out: a mixed-scale triplet network for camouflaged object detection[C]∥2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2022: 2150-2160.

[5] SONG Y X, LI X Y, QI L. Camouflaged object detection with feature grafting and distractor aware[C]∥2023 IEEE International Conference on Multimedia and Expo. Piscataway:IEEE, 2023: 2459-2464.

[6] HUANG Z, DAI H, XIANG T Z, et al. Feature shrinkage pyramid for camouflaged object detection with transformers[C]∥2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway:IEEE, 2023: 5557-5566.

[7] SUN Y J, WANG S, CHEN C, et al. Boundary-guided camouflaged object detection[EB/OL]. (2022-07-02)[2024-11-20].https:∥doi.org/10.48550/arXiv.2207.00794.

[8] ZHU H W, LI P, XIE H R, et al. I can find you! boundary-guided separated attention network for camouflaged object detection[C]∥ Proceedings of the 36th AAAI Conference on Artificial Intelligence. Palo Alto: AAAI, 2022: 3608-3616.

[9] SUN D Y, JIANG S Y, QI L. Edge-aware mirror network for camouflaged object detection[C]∥2023 IEEE International Conference on Multimedia and Expo. Piscataway:IEEE, 2023: 2465-2470.

[10] JI G P, FAN D P, CHOU Y C, et al. Deep gradient learning for efficient camouflaged object detection[J]. Machine Intelligence Research, 2023, 20(1): 92-108.

[11] WANG W H, XIE E Z, LI X, et al. PVT v2: improved baselines with pyramid vision transformer[J]. Computational Visual Media, 2022, 8(3): 415-424.

[12] LIU S T, HUANG D, WANG Y H. Receptive field block net for accurate and fast object detection[EB/OL].(2017-11-21)[2024-11-20].https:∥doi.org/10.48550/arXiv.1711.07767.

[13] 田旭, 彭飞, 刘飞, 等. 基于金字塔特征与边缘优化的显著性对象检测[J]. 郑州大学学报(工学版), 2022, 43(2): 35-43.

TIAN X, PENG F, LIU F, et al. Salient object detection based on pyramid features and edge optimization[J]. Journal of Zhengzhou University (Engineering Science), 2022, 43(2): 35-43.

[14] ZAMIR S W, ARORA A, KHAN S, et al. Restormer: efficient transformer for high-resolution image restoration[C]∥2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2022: 5718-5729.

[15] WOO S, PARK J, LEE J Y, et al. CBAM: convolutional block attention module[EB/OL].(2018-07-17)[2024-11-20].https:∥doi.org/10.48550/arXiv.1807.06521.

[16] WEI J, WANG S H, HUANG Q M. F3Net: fusion, feedback and focus for salient object detection[C]∥ Proceedings of the 34th AAAI Conference on Artificial Intelligence. Palo Alto: AAAI, 2020: 12321-12328.

[17] CHENG M M, FAN D P. Structure-measure: a new way to evaluate foreground maps[J]. International Journal of Computer Vision, 2021, 129(9): 2622-2638.

[18] MARGOLIN R, ZELNIK-MANOR L, TAL A. How to evaluate foreground maps[C]∥2014 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway:IEEE, 2014: 248-255.

[19] FAN D P, GONG C, CAO Y, et al. Enhanced-alignment measure for binary foreground map evaluation[EB/OL]. (2018-05-26)[2024-11-20].https:∥doi.org/10.48550/arXiv.1805.10421.

[20] LI X F, YANG J X, LI S H, et al. Locate, refine and restore: a progressive enhancement network for camouflaged object detection[C]∥Proceedings of the Thirty-Second International Joint Conference on Artificial Intelligence. Cape Town: International Joint Conferences on Artificial Intelligence Organization, 2023: 1116-1124.

[21] HE C M, LI K, ZHANG Y C, et al. Camouflaged object detection with feature decomposition and edge reconstruction[C]∥2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway:IEEE, 2023: 22046-22055.

[22] ZHOU X F, WU Z C, CONG R M. Decoupling and integration network for camouflaged object detection[J]. IEEE Transactions on Multimedia, 2024, 26: 7114-7129.