跳频通信技术作为一类关键抗截获、抗干扰技术,因其通过宽频段内载波频率的快速跳变实现恶意干扰规避与侦听防御,在现代军事通信系统中具有重要应用价值。然而,跳频信号的时变载频特性显著增加了其检测与识别的技术难度,这一挑战性课题已引起广泛关注。值得注意的是复杂电磁环境中的密集干扰信号(特指跳频信道内共存的多类型干扰源)会严重劣化信号检测性能,这一现象在工业物联网、军事通信及雷达系统等应用场景中尤为突出。

现有跳频信号检测与识别方法可系统划分为基于特征工程的经典方法与基于深度学习的现代方法两类技术路线。前者主要依赖领域先验知识,通过人工设计的时频特征提取实现调制类型识别。典型研究包括:基于时频能量谱纹理特征捕捉信号频谱动态变化[1];利用梯度方向直方图(histogram of oriented gradient, HOG)[2]来提取时频图中的边缘和方向特征;构建双稀疏性特征表征模型进行调制识别[3]。尽管这些方法在特定场景下表现良好,但其性能受到特征工程质量的限制,存在特征表征能力不足、环境适应性弱等缺陷。

随着人工智能与计算机视觉技术的突破性进展,基于深度学习的自动特征提取方法已成为跳频信号识别领域的主流研究方向。该类方法通过时频分析技术(如时频特征提取、多时相星座图构建等)获取信号多维特征表征,并利用深度神经网络实现特征的自适应提取与分类决策,在复杂电磁环境中展现出显著的性能优势。现有研究已取得诸多进展,例如基于choi-williams分布(choi-williams distribution, CWD)时频图谱构建与YOLOv5分类器集成的自动识别框架[4];Gabor变换特征图与YOLOv5协同的跳频信号分类模型[5];短时傅里叶变换(short time fourier transform, STFT)时频特征与单步检测器(single shot detector, SSD)融合的调制识别系统研究[6]等代表性成果,均验证了深度学习方法的有效性。深度学习方法凭借其自动特征学习机制与强泛化能力,已成为信号识别领域的研究前沿。其中,YOLOv5s网络作为轻量级目标检测模型,在检测效率与识别精度间实现了优化平衡,尤其适用于复杂频谱环境下的跳频信号识别任务。其多维度特征提取能力可有效提升高干扰场景下的识别鲁棒性。基于此,本研究提出基于STFT时频YOLOv5s网络架构,旨在构建面向复杂干扰环境的跳频信号高效检测与识别系统。本文的核心创新点体现在以下两个方面:

(1)为了能够准确区分干扰与信号,增大网络视野,采用语境分层与门控聚合机制来优化YOLOv5s网络的主干网络部分,提升网络对信号和背景特征的融合能力,改善信号识别率。语境分层包含多个深度可分离卷积(depth-wise separable convolutions,DSC)[7],用来获取分级的上下文信息,在维持精度的同时降低参数量,提升检测速度;而门控聚合则是通过对不同层次的特征进行加权融合,提高网络对重要信息的学习能力,从而显著提升识别精度。

(2)本文采用蒙特卡罗仿真,验证了改进后的YOLOv5s网络性能较之传统的YOLOv5网络,其综合mAP@0.5∶0.95提升8.9百分点,识别精确率P提升0.5百分点,召回率R提升15.9百分点,F1提升9百分点,显著提升了复杂频谱环境中跳频信号的检测和识别性能。

1 干扰环境中基于YOLOv5s网络的信号检测与识别

1.1 YOLOv5网络

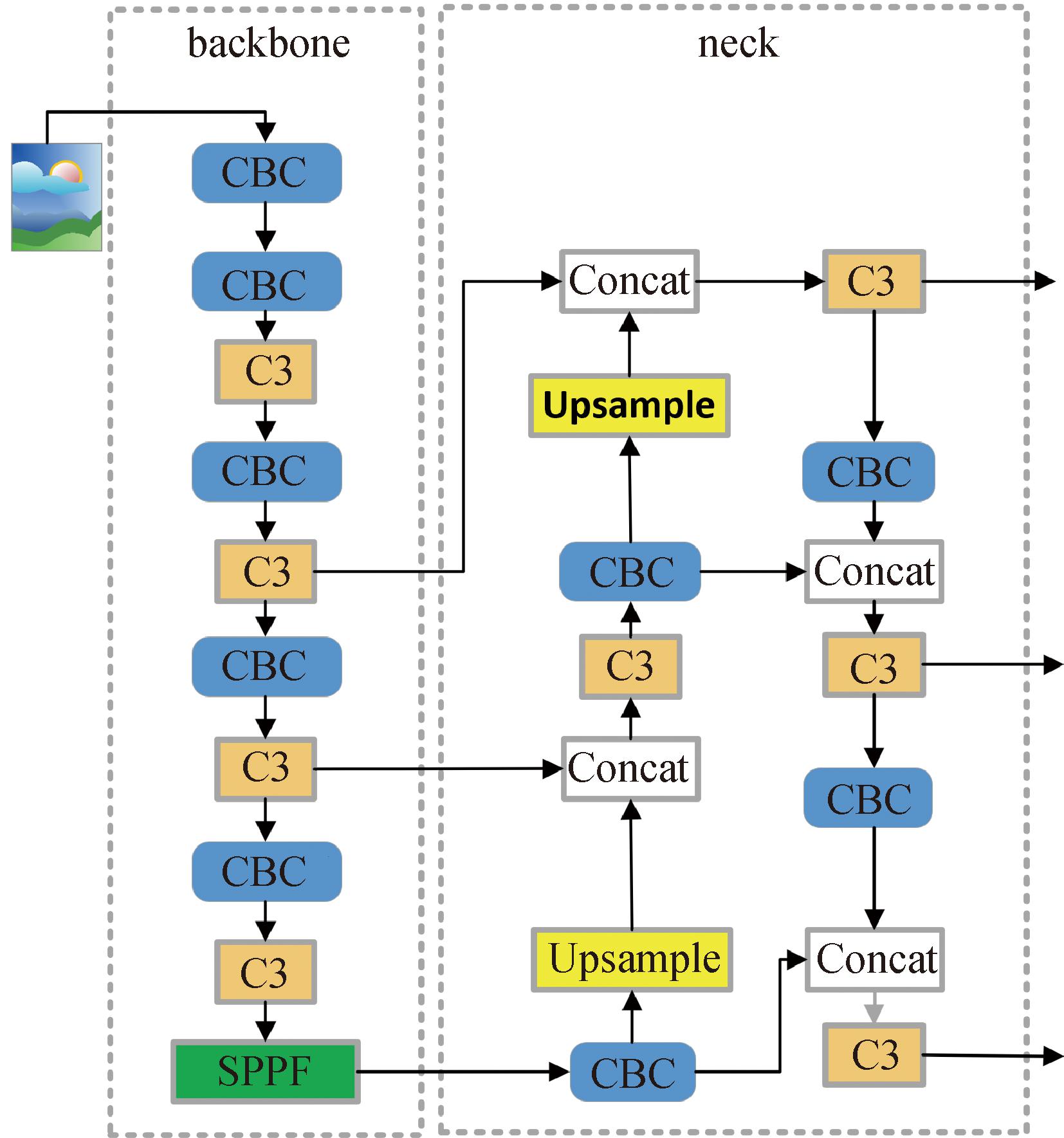

当前,目标检测的主流方法大致分为两种:以Fast R-CNN[8]和Faster R-CNN[9]网络为代表的两阶段目标检测,以及以YOLO[10]和SSD[11]为代表的单阶段目标检测。由于两阶段目标检测在进行图像识别时需要先选出候选区域,再对选出的候选区域进行调整分类,这就使得双阶段比单阶段的检测精度高,但同时检测速度大打折扣。随着YOLO网络的不断更新,单阶段目标检测已能够在保证较高检测速度的同时兼顾良好的检测精度。YOLOv5网络结构如图1所示。

图1 YOLOv5网络结构

Figure 1 YOLOv5 network structure

YOLOv5网络由输入端(input)、主干网络(backbone)、颈部网络(neck)和输出端(output)4个部分构成。

在输入端采用马赛克数据增强方式,对4张含有目标的图片进行拼接,获得一张图片,增强了网络的鲁棒性,同时加快了图片的读取速度。

输入图像经过主干网络进行特征提取,并得到3种尺度特征的输出。主干网络由CBS模块(convolution batchnorm2d sigmoid linear unit)、C3模块(cross convolutional connection)以及空间金字塔池化模块(spatial pyramid pooling-fast,SPPF)组成。

CBS模块封装了卷积、批归一化和激活函数的组合操作;C3模块是CSP(cross stage partial)结构,主要由瓶颈层模块和3个CBS模块构成,其中瓶颈层模块利用了残差结构来防止梯度爆炸和梯度消失;SPPF模块先将输入图像经过CBS模块,再串行通过卷积核为5的3个最大值池化层,将每次的输出进行拼接,再经过一层CBS提取特征,这样可以加快速度,提高模型的感受野和特征表达能力。

特征融合部分采用特征金字塔网络(feature pyramid networks, FPN)和路径聚合网络(path aggregation network, PAN)相结合的方式。FPN网络自顶向下与主干网络提取的特征进行融合,以提取深层次的语义信息;PAN网络通过采用自底向上传递目标位置信息以减少底层特征信息的丢失,有利于模型更好地学习目标特征,增强模型对小目标的敏感度。

最后将特征融合网络输出的3种不同尺度特征输入到预测部分(detect)进行目标分类与边界框回归,采用非极大值抑制方法保留最优目标框。

YOLOv5的损失主要由3个部分组成:分类损失(classes loss)、置信度损失(object loss)和定位损失(location loss)。其中,分类损失(classes loss)采用二值交叉熵损失(binary cross-entropy,BCE loss);置信度损失(object loss)采用网络预测的目标边界框与人工标注框(ground truth box, GT Box)的完整交并比(complete-intersection over union, CIoU)损失,计算所有样本的置信度损失;定位损失(location loss)采用CIoU损失。

Loss=λ1Lcls+λ2Lobj+λ3Lloc。

(1)

式中: λ1、λ2、λ3为加权参数;Lcls为分类损失,Lobj为置信度损失;Lloc为定位损失。

针对跳频信号检测任务中实时性和计算资源受限的需求,选用YOLOv5框架中的轻量化版本——YOLOv5s,该架构在保证检测精度的同时显著降低了计算复杂度,更适合资源受限的实时信号检测场景。

1.2 现存问题

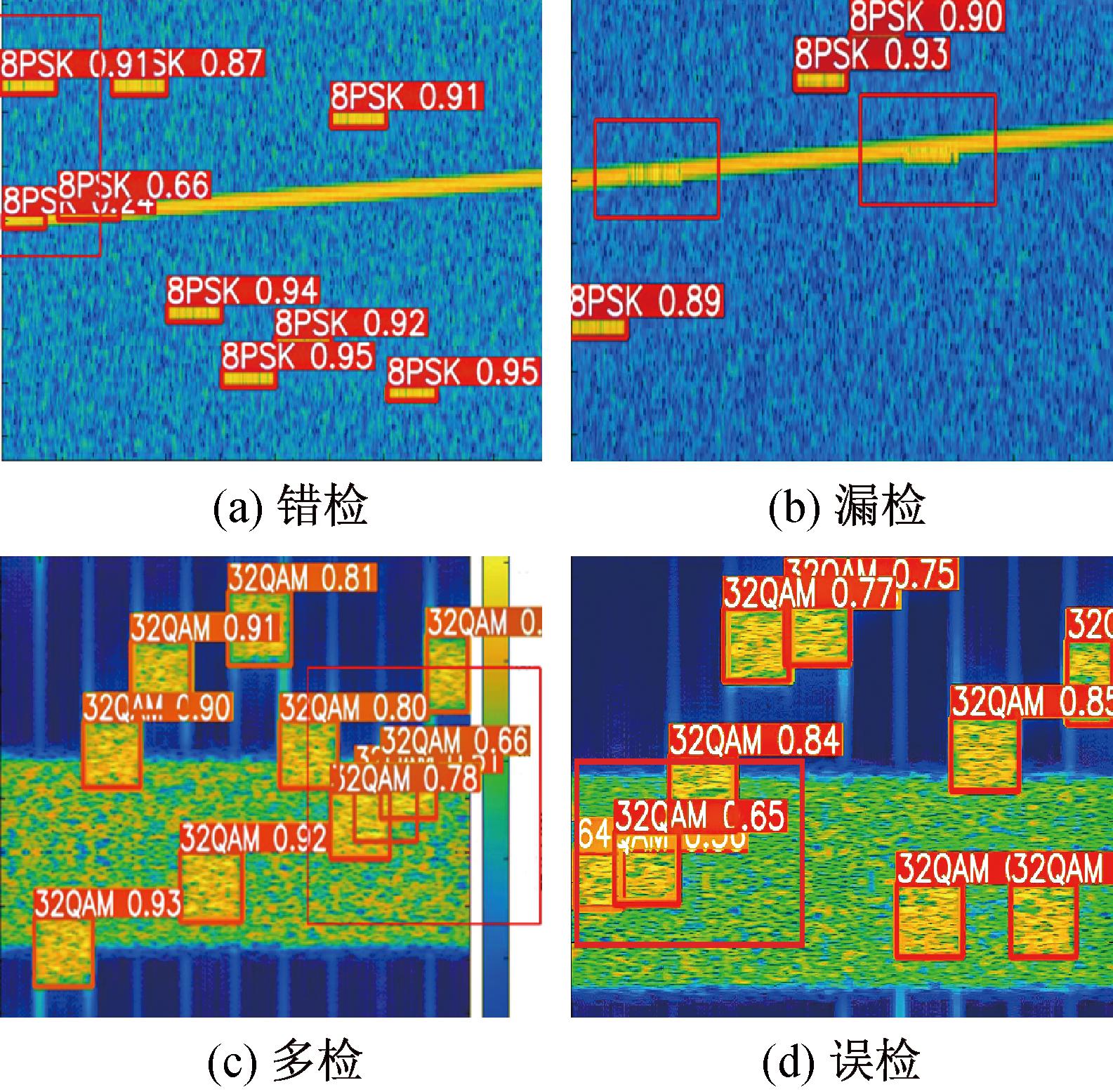

目前,跳频信号检测识别研究多在高信干比条件下进行,跳频信号在时频图上较为清晰,检测结果准确率较高。然而,在复杂电磁频谱环境下,通常难以保证高信干比,强干扰信号将显著降低检测和识别性能,导致误检和漏检问题。本文首先梳理出干扰对跳频信号检测和识别造成的挑战。

单音和线性调频等干扰信号,与采用8PSK调制的跳频信号在时频图上具有非常相似的特征,目标检测网络难以区分,容易造成错检。在时频域,与跳频信号存在重叠的干扰信号,会覆盖跳频信号特征,造成信号漏检。对于一些信号分布较为密集的情况,YOLOv5网络会将背景与信号置于同一个检测框中,混乱的检测框会造成多检。当目标检测网络学习了多种调制类型信号特征后,有些调制信号的时频特征高度相似,因此,仅依靠信号的时频特征容易造成调制类型的误检。各种检测错误情况见图2。

图2 检测错误情况示意图

Figure 2 Diagram of different detection error cases

2 改进的YOLOv5s网络

2.1 YOLO-Fc网络

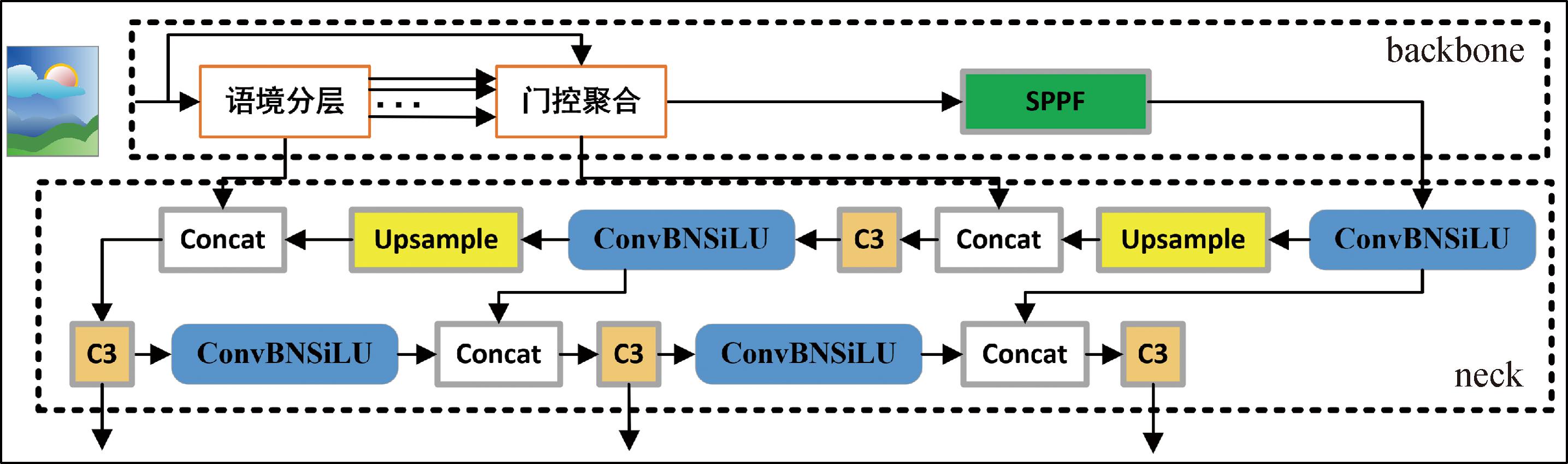

本文提出通过Focal 网络[12]改造YOLOv5s结构,引入分层语境化和门控聚合机制扩大网络视野,增强信号与背景特征的融合能力,从而提升检测效果与识别率。

Focal网络使用了聚焦调制(focal modulation)替代自注意力模块,先聚合目标信号周围的上下文信息,再与信号特征交互得到调制特征。其数学模型如式(2)所示:

yi=Γ(M(i,X),xi)。

(2)

式中: i表示时频图中的位置;X为整个分析频带内的时频图;M(i, X)操作表示位置i周围的时频聚合特征;Γ(M(i,X),xi)表示时频图中位置i上的信号特征xi与聚合特征M(i, X)的交互操作,以获得信号与背景的融合特征,其中,M(i, X)采用语境分层和门控聚合,扩大YOLOv5s网络的感受野,从时频图获取信号的上下文信息。此外,Γ是一个轻量级操作符,采用一个查询映射函数和哈达玛积实现,其计算复杂度较低。下面,将改进后的网络称为YOLO-Fc网络,其网络结构如图3所示。

图3 YOLO-Fc网络模型

Figure 3 YOLO-Fc network model

由图3可以看出,YOLO-Fc网络主要是改进了YOLOv5s网络的backbone部分。不同于之前的卷积模块与C3模块交替叠加,本文首先将时频图输入到线性层中,采用深度可分离卷积提取分级的上下文信息;其次,引入门控聚合机制;最后,采用特征加权融合得到融合特征并传递到SPPF层。

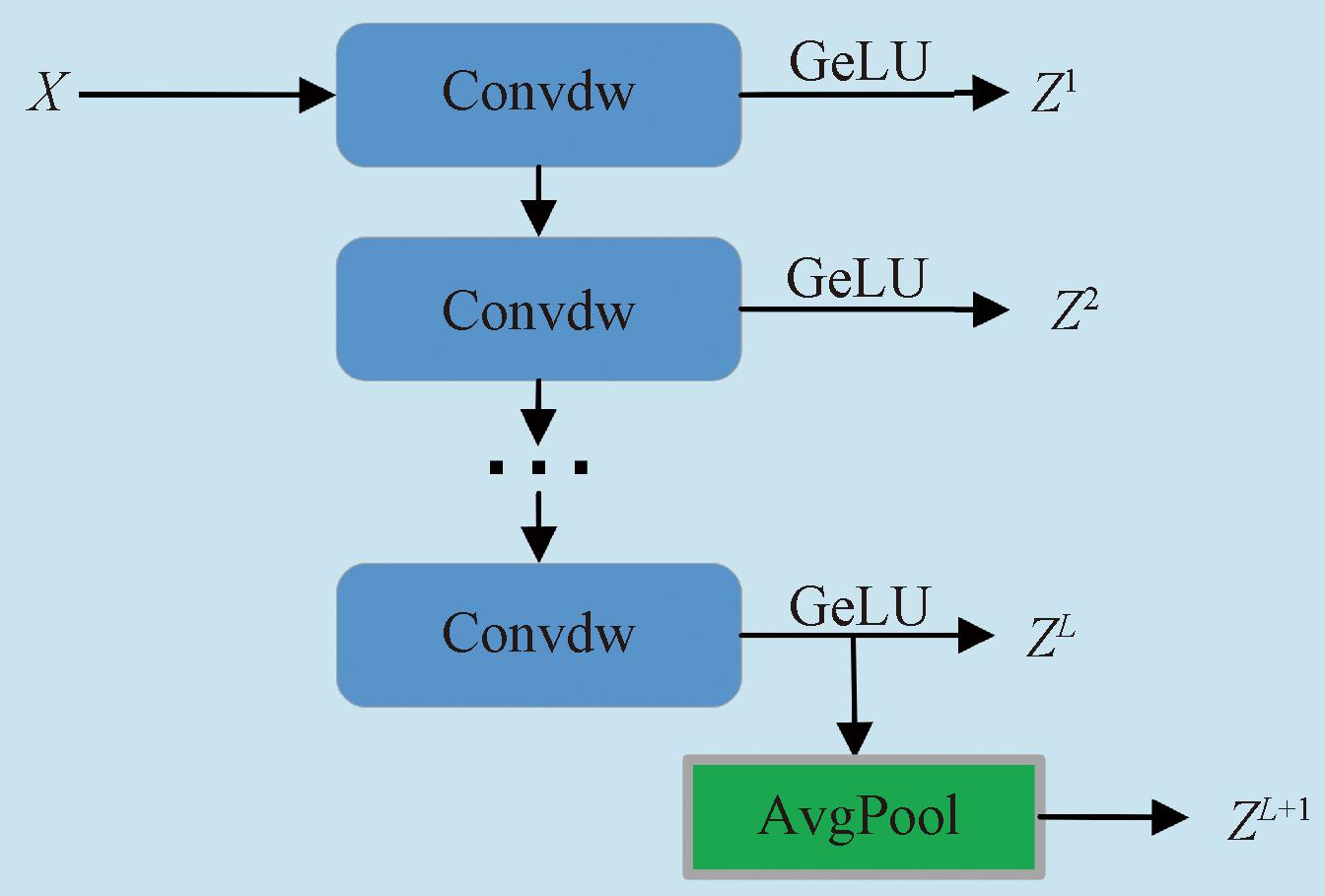

2.2 语境分层

语境分层模块结构如图4所示。

图4 语境分层模块结构

Figure 4 Contextual layering module structure

为扩大感受野,捕获全局信息,首先,输入时频图特征映射X,遍历每个聚焦层级,卷积核的感受野随层级增加而变大,每一层都经过深度可分离卷积和GeLU激活函数处理,得到(L+1)个分级的特征;其次,对所有特征进行投影,便于后续门控聚合的处理,这个过程的输出表示为

(3)

式中: Z 表示第

表示第 级的特征映射;

级的特征映射;![]() 为第

为第 级的分层化函数;Convdw为深度可分离卷积;GeLU为激活函数。最后,对第L级特征映射ZL应用平均池化,得到ZL+1特征映射,通过语境分层模块,一共得到(L+1)个特征映射。

级的分层化函数;Convdw为深度可分离卷积;GeLU为激活函数。最后,对第L级特征映射ZL应用平均池化,得到ZL+1特征映射,通过语境分层模块,一共得到(L+1)个特征映射。

以上过程称为语境分层。通过提取上下文信息,利用语境分层生成的特征图放大感受野,以更粗的粒度捕获更多的上下文信息,可以使网络更容易捕获跳变信号的时频特征,以区分信号与干扰,降低错检与漏检的概率。

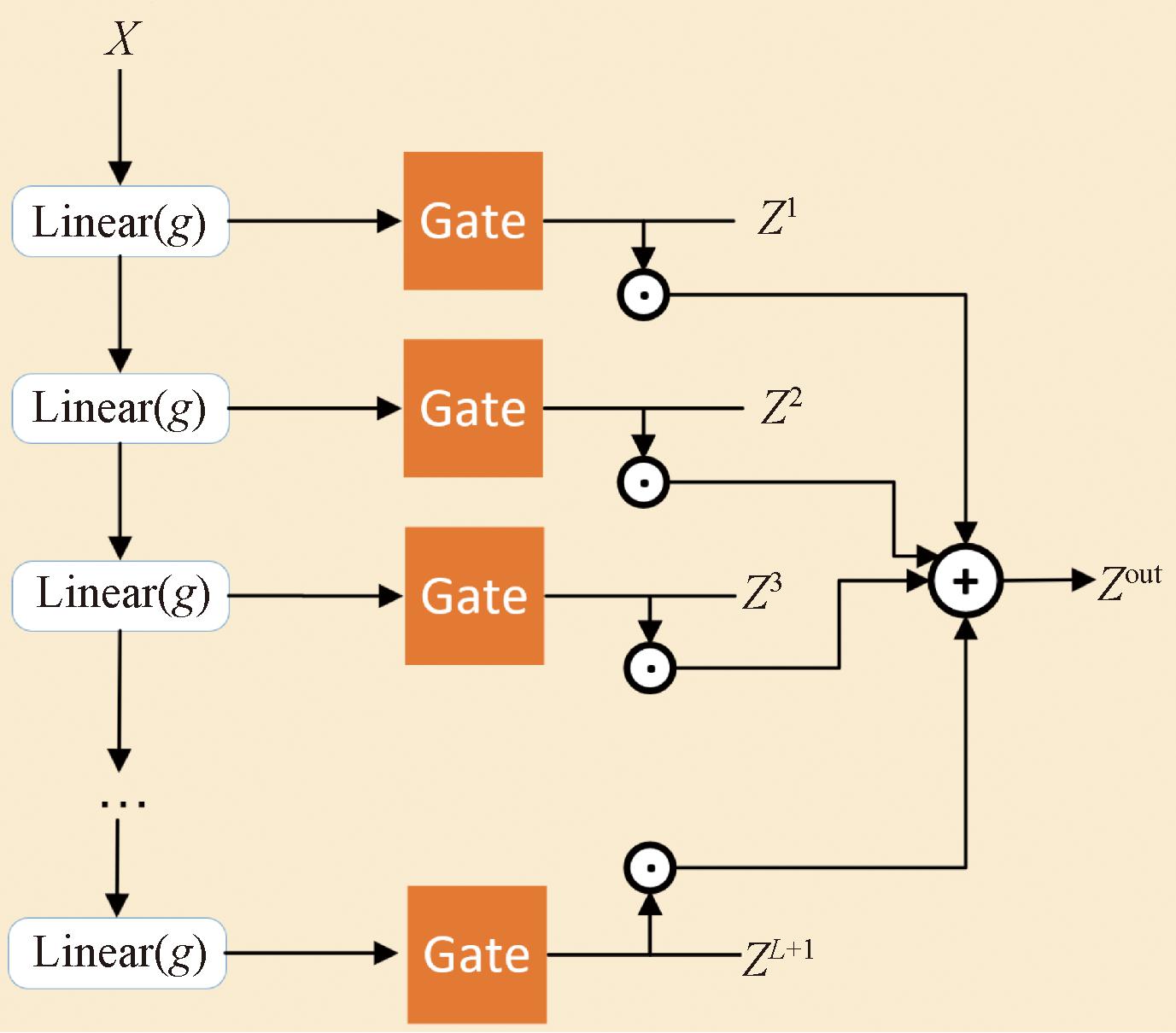

2.3 门控聚合

门控聚合模块结构如图5所示。在这个模块中,将X通过线性层进行分离,分别可以得到信号特征xi,上下文特征ctx,门控权重G。在时频图像中,会根据检测目标不同设定不同的级别。遍历每个层级,将语境分层模块得到的(L+1)个特征映射与该层门控权重G相乘,最后整体相加得到聚合特征Zout,即

(4)

图5 门控聚合模块结构

Figure 5 Gated aggregation module structure

式中: G=fg(X)∈RH×W×(L+1);⊙为哈达玛积。最后将调制特征输入到SPPF层。

门控聚合模块通过加入分层的特征融合机制,同时学习粗粒度的空间信息,即背景信息和细粒度的信号特征信息,从而大幅度提高网络的信号检测与识别性能。

2.4 总结

YOLO-Fc网络通过语境分层结构融合多尺度上下文信息,使低层特征同时具备大感受野和高细节保留能力,并结合门控聚合机制自适应融合粗细粒度特征,从而显著提升检测与定位精度。相较于YOLOv5,YOLO-Fc在强干扰环境下可实现跳频信号检测与识别率的显著提升。

3 实验设计

3.1 实验环境

实验环境:CPU型号为Intel Core i7-12700H,内存为16 GB,显卡类型为RTX 3060,显存为8 GB,Python版本为3.8。

3.2 数据集生成

本文数据集构建的跳频信号参数设置为:跳频速率≥8 000跳/秒,带宽98 MHz,包含51个频点,调制方式覆盖8PSK、16QAM、32QAM和64QAM等典型高阶调制。通过覆盖低阶至高阶调制,能全面评估系统在多种信号条件下的识别性能,同时考察模型对频谱利用率、抗干扰能力和实现复杂度的适应性和鲁棒性。

为分析YOLO-Fc网络的性能,本文设计了多种干扰信号,包括带宽30 MHz的线性调频干扰(linear frequency modulation, LFM)、调幅系数为3且带宽为15 MHz的噪声调幅干扰(noise-AM jamming, NAM)、调频系数为0.2且带宽20 MHz的噪声调频干扰(noise-FM jamming, NFM)、带宽为30 MHz的射频噪声干扰(noise modulated jamming, NMJ)、脉冲间断噪声干扰(pulse interval noise jamming, PINJ),以及单音干扰(single-tone jamming, STJ),所有干扰的中心频率均在跳频信号带宽内。

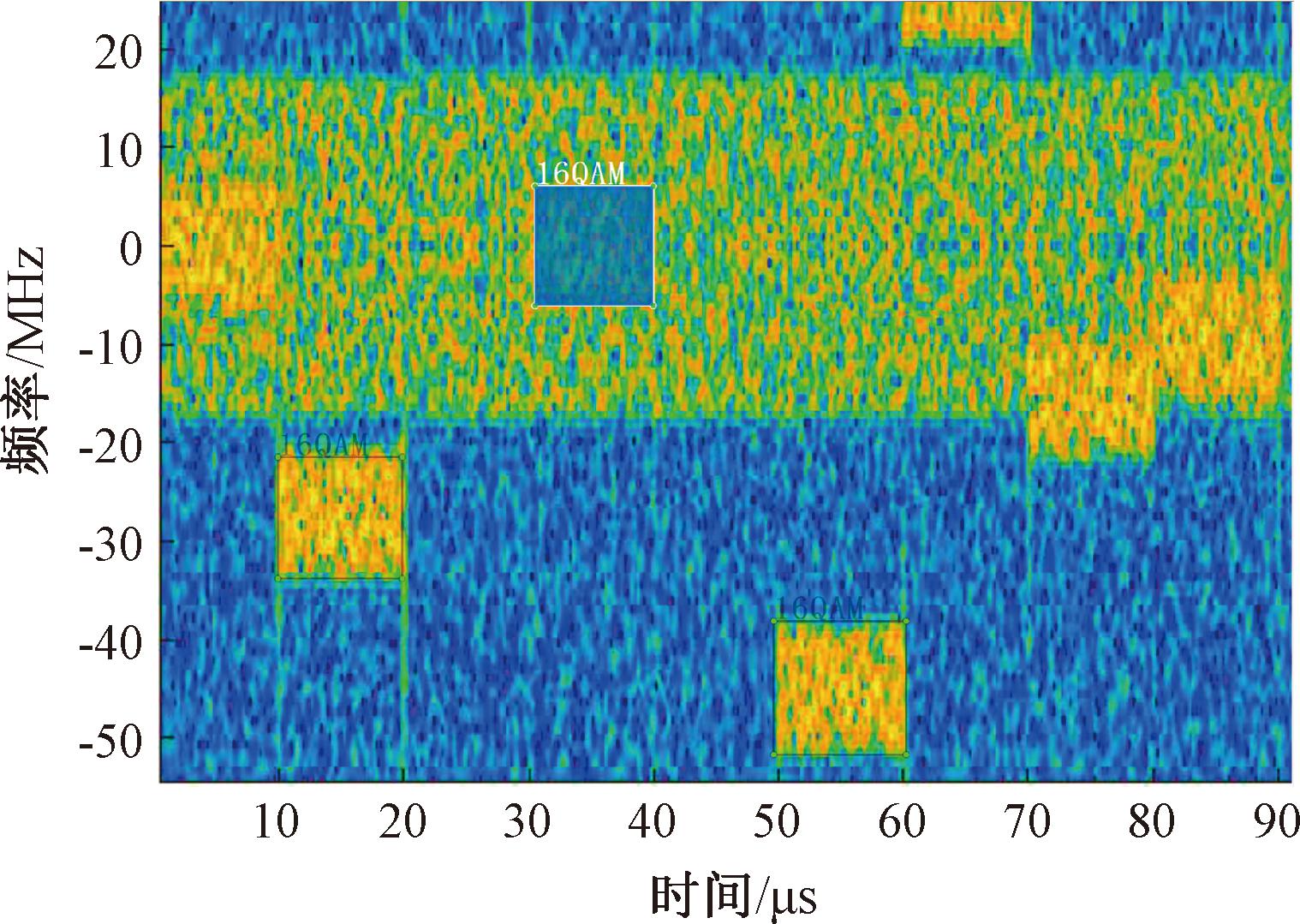

数据集生成基于MATLAB仿真平台,在信干比为5 dB、信噪比为10 dB的条件下分别生成调制信号、干扰信号及噪声。选择该信干比和信噪比旨在创建具有一定挑战性但可控的环境,以便测试算法在现实条件下的鲁棒性。将调制信号、干扰信号和噪声叠加后采用短时傅里叶变换生成时频图,每种调制与干扰组合生成300个样本,总计7 200个样本,按90∶5∶5比例划分为训练集、验证集和测试集。

3.3 训练步骤

步骤1 对所有图片进行标签操作,利用LabelImg工具对所有图片进行标签操作,保存生成的xml文件,LabelImg标签界面如图6所示。

图6 LabelImg标签界面

Figure 6 LabelImg tagging interface

步骤2 将xml文件转换为适用于YOLOv5s网络的txt文件,按比例随机生成训练集、测试集和验证集。

步骤3 YOLO-Fc网络的初始学习率设置为0.010 0,多轮训练后学习率减小至0.000 1,训练批次大小设置为16,进行300轮训练。

4 实验结果与分析

4.1 评价指标

为确保实验可比性,本文使用相同的实验设置进行训练与测试,并采用精确率P、召回率R来评估实验效果,具体计算过程如下:

(5)

(6)

式中:TP为检测正确的目标数量;FP为检测错误的目标数量;FN为漏检的目标数量。

F1为精确率和召回率的加权平均。F1的最优值为1,最差值为0,F1的计算公式为

(7)

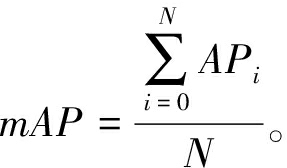

以召回率和精确率分别为横坐标和纵坐标,绘出R-P曲线,对曲线求积分为平均精准度AP值。由于考虑了多个类别的识别,其平均值记为平均精度均值mAP,用来衡量模型对所有类别的检测效果,计算公式如下:

AP=![]() PdR;

PdR;

(8)

(9)

式中: N为数据集中检测目标的类别数;i为当前类别的编号。考虑8PSK、16QAM、32QAM和64QAM 4种调制类型分析网络的检测和识别性能,本文实验设置N=4。

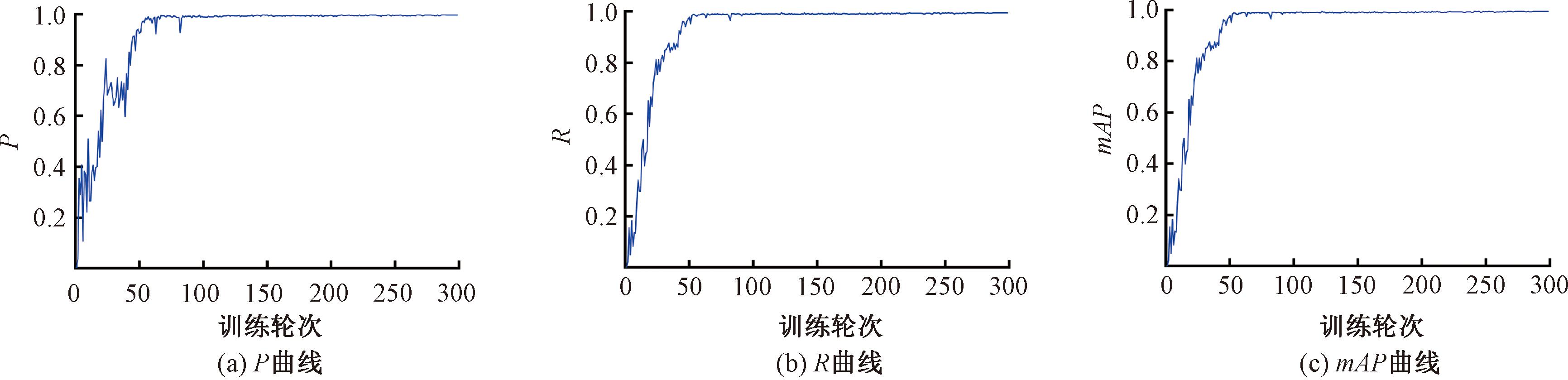

4.2 训练结果分析

各指标曲线如图7所示。由图7可以看出,当训练迭代分别到第82轮和第56轮后,P和R趋于平稳,当训练迭代到第52轮后,mAP也趋于稳定,证明了改进模型的稳定性。

图7 指标曲线

Figure 7 Index curve

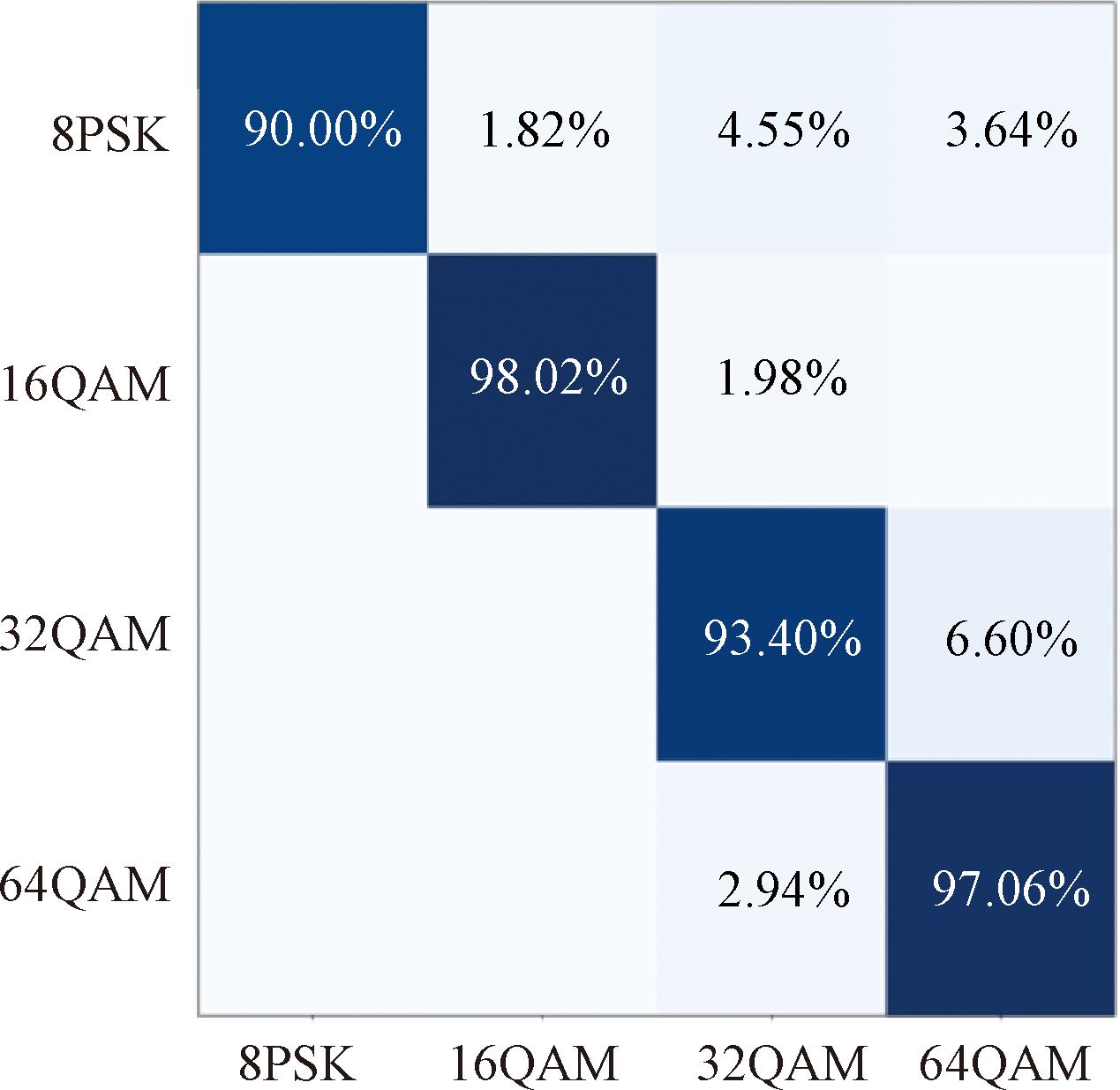

图8为得到的混淆矩阵,由图8可以看出各个种类的调制信号都能够被准确区分。

图8 混淆矩阵

Figure 8 Confusion matrix

4.3 指标对比分析

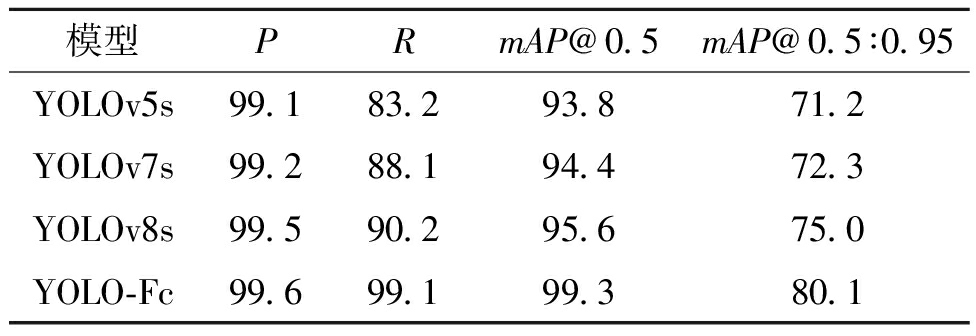

本文在此实验中分别训练了改进的YOLOv5s网络和原始的YOLOv5s网络,同时,本文还进行了其他YOLO系列网络[13-14]的训练,表1为各指标性能对比。

表1 不同模型性能对比

Table 1 Performance comparison of different models %

模型PRmAP@0.5mAP@0.5∶0.95YOLOv5s99.183.293.871.2YOLOv7s99.288.194.472.3YOLOv8s99.590.295.675.0YOLO-Fc99.699.199.380.1

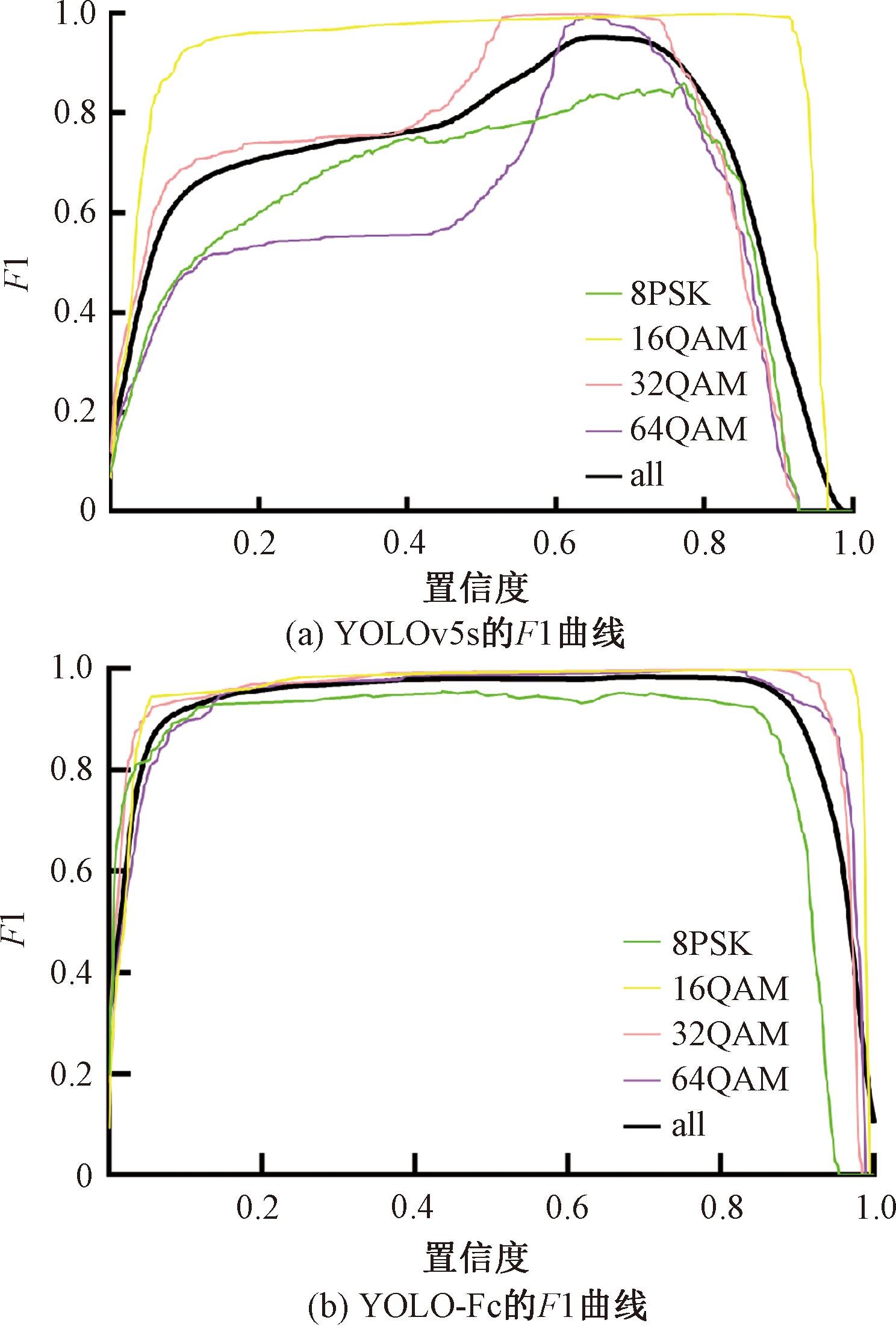

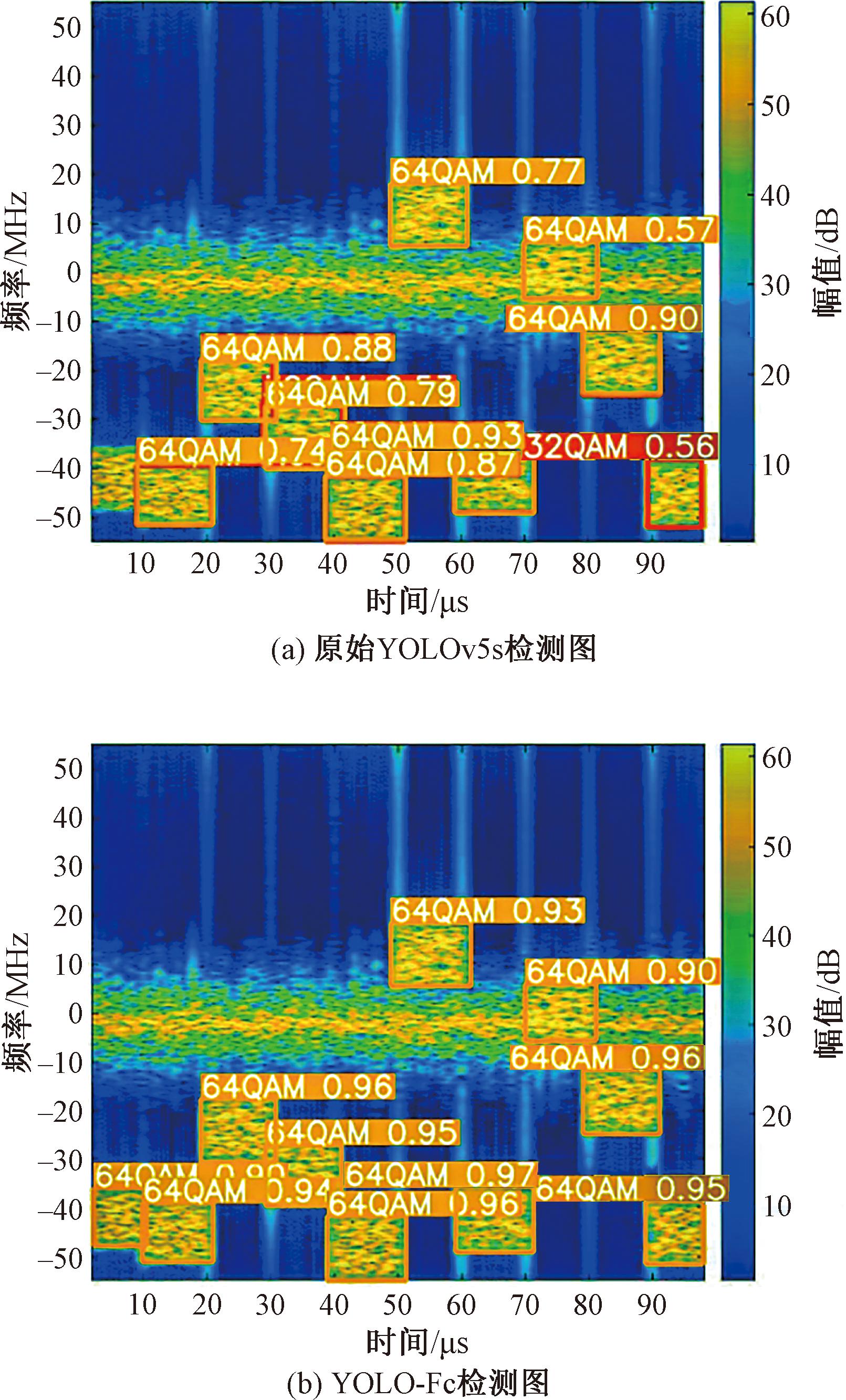

引入YOLO-Fc网络后,相较其他YOLO系列网络,精确率略有提升,召回率提升显著,相比YOLOv5s提升15.9百分点,mAP@0.5提升5.5百分点,mAP@0.5∶0.95提升8.9百分点,体现了模型的有效性和鲁棒性。YOLO系列网络为提高精度往往会牺牲召回率,导致漏检率较高;而YOLO-Fc则在精确率和召回率上达到平衡,不为精确率牺牲召回率,也不为召回率牺牲精确率。图9为YOLOv5s和YOLO-Fc的F1曲线对比。由图9可知,综合全部4种调制方式的数据计算结果(all)可知,YOLO-Fc相比YOLOv5s,F1提升9百分点。

图9 F1曲线对比

Figure 9 F1 Curve comparison

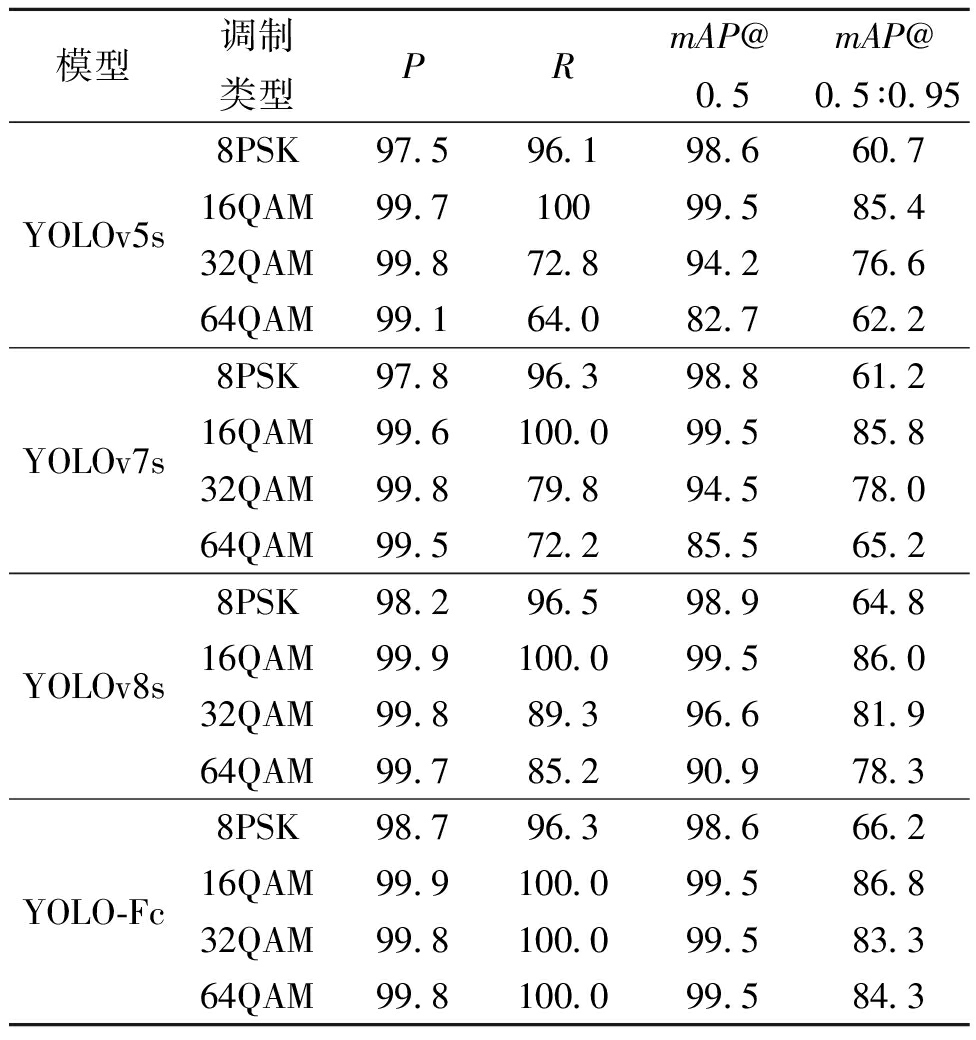

具体到每种调制类型信号,各参数结果如表2所示。由表2可以看出,对于不同的调制类型,YOLO-Fc网络与YOLOv5s、YOLOv7s和YOLOv8s相比,在P、R、mAP 3种性能指标上大部分数值有所提升。

表2 不同网络模型在各调制类型信号的指标对比

Table 2 Comparison of indicators of different network models in signals of each modulation type %

模型调制类型PRmAP@0.5mAP@0.5∶0.95YOLOv5s8PSK97.596.198.660.716QAM99.710099.585.432QAM99.872.894.276.664QAM99.164.082.762.2YOLOv7s8PSK97.896.398.861.216QAM99.6100.099.585.832QAM99.879.894.578.064QAM99.572.285.565.2YOLOv8s8PSK98.296.598.964.816QAM99.9100.099.586.032QAM99.889.396.681.964QAM99.785.290.978.3YOLO-Fc8PSK98.796.398.666.216QAM99.9100.099.586.832QAM99.8100.099.583.364QAM99.8100.099.584.3

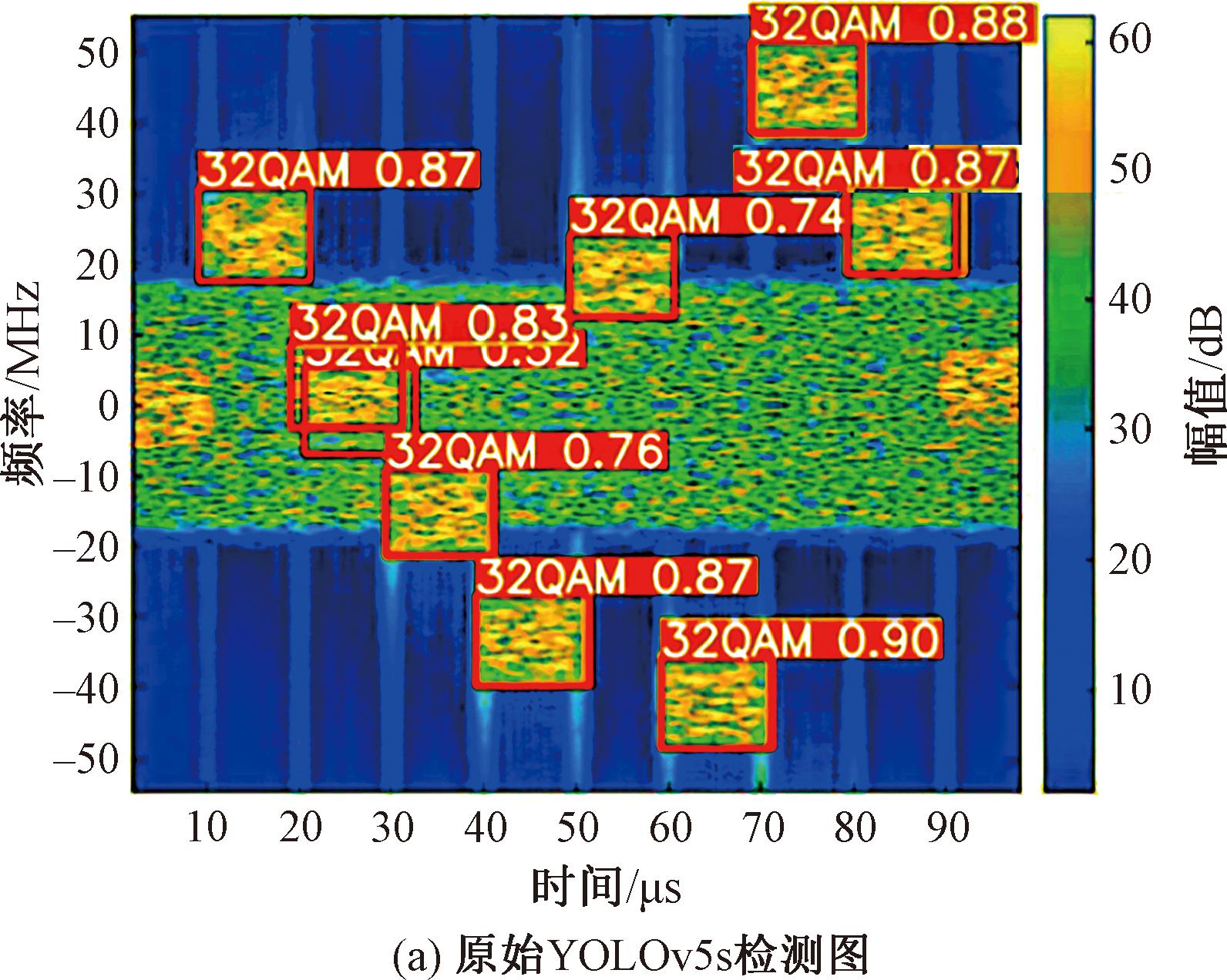

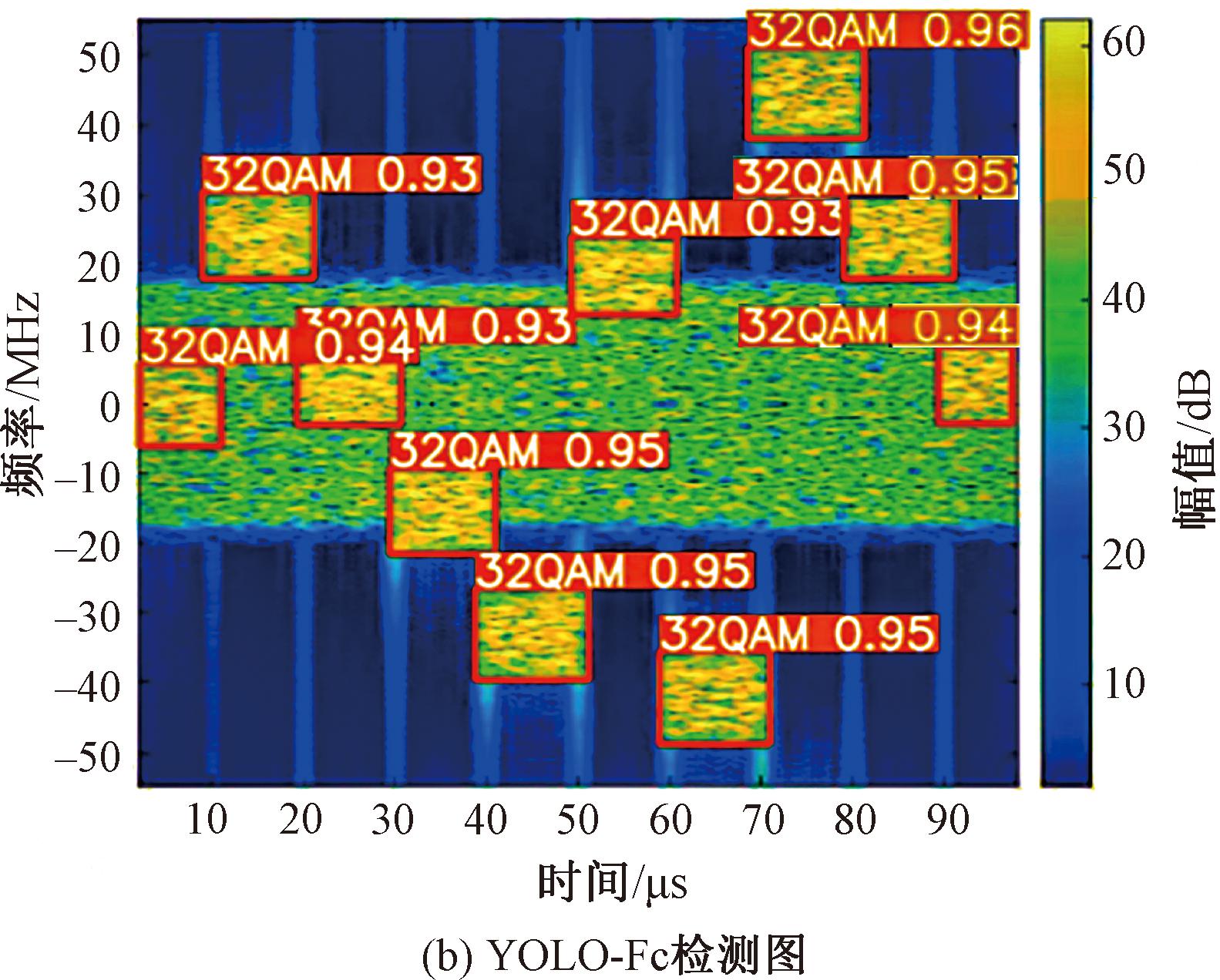

4.4 模型检测对比分析

在相同的硬件条件下,利用训练得到的模型对时频图进行测试,模型检测结果对比如图10、11所示。通过对比可以看出,YOLO5-Fc置信度有了明显的提升,在干扰附近的提升较大。除此之外,频率变化较小,导致频谱图比较密集,并且处于干扰之中的情况,原始YOLOv5s网络会出现多检、漏检,如图10(a)所示;对于信号特征不明的情况则会出现错检,如图11(a)所示。而YOLO-Fc几乎不存在多检、漏检及错检等现象。

图10 模型检测结果对比1

Figure 10 Comparison of model detection results 1

图11 模型检测结果对比2

Figure 11 Comparison of model detection results 2

5 结论

本文通过在YOLOv5s网络中引入语境分层和门控聚合机制扩展了网络的感受野,并使其能够更有效地学习和理解目标信号的上下文信息。这种改进不仅增强了网络对信号时间和频率特征的感知能力,也显著提高了在复杂信号环境中的检测和定位精度。

实验结果表明,YOLO-Fc网络在减少错检和漏检方面提升明显,其P和R指标的提升反映了网络在维持检测准确性的同时,也显著提高了对目标信号的识别率,证明YOLO-Fc网络在P和R之间达到了更好的平衡,使得模型能够更加准确地识别和定位在电磁干扰条件下的信号。

[1] 李红光, 郭英, 眭萍, 等. 基于时频能量谱纹理特征的跳频调制方式识别[J]. 通信学报, 2019, 40(10): 20-29.

LI H G, GUO Y, SUI P, et al. Frequency hopping modulation recognition based on time-frequency energy spectrum texture feature[J]. Journal on Communications, 2019, 40(10): 20-29.

[2] 张萌, 王文, 任俊星, 等. 基于HOG-SVM的跳频信号检测识别算法[J]. 信息安全学报, 2020, 5(3): 62-77.

ZHANG M, WANG W, REN J X, et al. Detection and recognition algorithm for frequency hopping signals based on HOG-SVM[J]. Journal of Cyber Security, 2020, 5(3): 62-77.

[3] 胡晓芳. 基于稀疏性的跳频信号检测技术研究[D]. 哈尔滨: 哈尔滨工程大学, 2018.

HU X F. Research on frequency hopping signal detection technology based on sparsity[D]. Harbin: Harbin Engineering University, 2018.

[4] HUANG D K, YAN X P, HAO X H, et al. Low SNR multi-emitter signal sorting and recognition method based on low-order cyclic statistics CWD time-frequency images and the YOLOv5 deep learning model[J]. Sensors, 2022, 22(20): 7783.

[5] 周凯. 基于YOLOv5的跳频信号调制方式检测识别[J]. 数字通信世界, 2022(11): 8-10.

ZHOU K. Detection and identification of frequency hopping signal modulation based on YOLOv5[J]. Digital Communication World, 2022(11): 8-10.

[6] WANG Y Y, HE S R, WANG C R, et al. Detection and parameter estimation of frequency hopping signal based on the deep neural network[J]. International Journal of Electronics, 2022, 109(3): 520-536.

[7] CHOLLET F. Xception: deep learning with depthwise separable convolutions[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition.Piscataway: IEEE, 2017: 1800-1807.

[8] GIRSHICK R. Fast R-CNN[C]∥2015 IEEE International Conference on Computer Vision.Piscataway:IEEE, 2015: 1440-1448.

[9] REN S Q, HE K M, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149.

[10] REDMON J, DIVVALA S, GIRSHICK R, et al. You only look once: unified, real-time object detection[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition .Piscataway:IEEE, 2016: 779-788.

[11] LIU W, ANGUELOV D, ERHAN D, et al. SSD: single shot multibox detector[C]∥Lecture Notes in Computer Science. Cham: Springer, 2016: 21-37.

[12] YANG J W, LI C Y, DAI X Y, et al. Focal modulation networks[EB/OL].(2022-03-22)[2025-01-02]. https:∥doi.org/10.48550/arXiv.2203.11926.

[13] WANG C Y, BOCHKOVSKIY A, LIAO H Y M. YOLOv7: trainable bag-of-freebies sets new state-of-the-art for real-time object detectors[C]∥2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway:IEEE,2022: 7464-7475.

[14] VARGHESE R, SAMBATH M. YOLOv8: A novel object detection algorithm with enhanced performance and robustness[C]∥2024 International Conference on Advances in Data Engineering and Intelligent Computing Systems.Piscataway:IEEE, 2024: 1-6.