工业产品表面缺陷检测旨在识别并定位工业制品的外观瑕疵,是保障产品质量、维持生产稳定的重要技术之一。目前,工业产品表面缺陷检测主要包括人工质检、基于机器学习的方法和基于深度学习的方法[1]。早期的检测方法主要采取人工质检的方式,人工筛查的速度和质量过度依赖质检员的水平。企业一方面需要花费额外成本培训质检员;另一方面,由于人的主观性和视觉疲劳等问题,误检和漏检也在所难免。基于机器学习的检测方法主要根据缺陷位置像素块的颜色、形状、纹理等特征,通过图像处理方法描述缺陷的特征,再利用支持向量机、随机森林等传统机器学习方法进行分类[2]。与人工质检相比,基于机器学习的检测方法实时性好,还能提供安全、简便的操作环境,但不同的缺陷都需要设计对应的缺陷模板,因此,检测水平主要依靠缺陷模板的精心设计,遇到未知缺陷类型时,没有模板与之匹配就会导致漏检。此外,对于需要识别多种缺陷的场景,缺陷模板也容易混淆缺陷类型。

基于深度学习的方法依靠复杂的神经网络自动提取缺陷特征,比基于机器学习的方法更容易识别并区分缺陷目标,使得检测精度大幅提高。目前基于深度学习的目标检测模型可分为两阶段和单阶段类型。两阶段检测器在第一阶段中,生成多个潜在候选区域;在第二阶段中,提取这些区域的特征进行分类和回归,得到最终的目标检测结果。此类模型在两个阶段之间进行显式的区分,所以需要更多的计算资源和时间。两阶段检测代表模型包括Faster R-CNN[3]、Cascade R-CNN[4]和Mask R-CNN[5]等。Liu等[6]改进了Faster R-CNN用于检测航空发动机叶片表面缺陷,改进了非极大值抑制算法NMS,从而保证了缺陷的连续性;Wei等[7]构建了Faster VG-RCNN模型,引入注意力机制提升模型的视觉感知的敏锐程度,在检测纺织品上的微小缺陷方面效果显著,但速度较慢。

单阶段检测器从输入图像中提取特征,经过一次前向传播过程直接预测目标的类别和位置,此类模型的检测速度快,但精度上略低于两阶段方法。单阶段检测代表模型包括SSD[8]、RetinaNet[9]、YOLO系列[10-15]等。Zhang等[16]为了提高汽车油漆缺陷检测的效率和准确性,提出了一种改进的MobileNet-SSD算法,针对汽车油漆的特征设计了特征提取网络,并优化了检测框的匹配策略,实现了实时检测。Pan等[17]设计了基于特征增强YOLO的表面缺陷检测算法,首先,提出了一种改进的特征金字塔网络,提高了多尺度特征层的空间位置相关性;其次,将深度可分离卷积和密集连接层相结合,降低了模型的计算量;最后,建立了一种新的预测框回归损失,在高IoU阈值下提升了检测精度,加速了模型收敛。Liu等[18]提出了LF-YOLO模型,在YOLOv3中引入了高效的特征提取模块和多尺度特征模块,在焊缝缺陷检测方面具有高效、低复杂度的检测性能。

上述方法主要从提升检测的精度和速度的角度进行改进,但没有考虑到在成像条件较差的工业场景中,缺陷图像往往存在弱特征、强干扰、低对比度等缺点,易导致缺陷和背景混淆的问题,这种情况可以通过改进特征提取方式和采用注意力机制改善。张震等[19]将CBAM注意力模块嵌入到YOLOv5的特征提取块中,提升了对目标特征的提取能力;魏明军等[20]将CBAM与多头注意力机制相结合,设计了一种混合注意力机制,增强了模型在杂乱背景下的抗干扰能力;Xie等[21]针对焊缝X射线图像的对比度低、缺陷的形状和大小变化大的问题,提出了WD-YOLO模型,该模型引入灰度值曲线增强模型,用于提高模型的对比度,并添加了双重注意力机制,使模型能够更好地区分前景和背景区域;Guo等[22]针对钢表面缺陷图像背景干扰大、缺陷类型易混淆的问题,提出了MSFT-YOLO模型,该模型将Transformer模型的Trans模块添加到YOLO模型的主干和检测图中,将特征和全局信息进行融合,还组合了多尺度特征融合结构来融合不同尺度的特征,增强了检测器对不同尺度目标的检测效果。上述方法均使用注意力机制来提升识别和定位能力,但复杂的注意力机制也增加了模型的复杂度,降低了检测速度。

虽然目前工业缺陷检测的性能得到显著提升,但依然存在许多不足。针对缺陷图像的对比度较低、骨干网络提取特征能力不足等问题,本文引入感受野增强模块(RFEM)提升特征提取能力;针对缺陷与背景的差异不明显,难以对缺陷准确定位等问题,引入混洗注意力(SAM)模块,消除噪声背景的干扰;针对分类和回归任务侧重点不同,但却由同一特征图预测等问题,引入任务解耦检测头(TDDH),分别对分类和回归任务设计独立的特征图。

1 改进YOLOv5的工业产品表面缺陷检测方法

1.1 网络结构

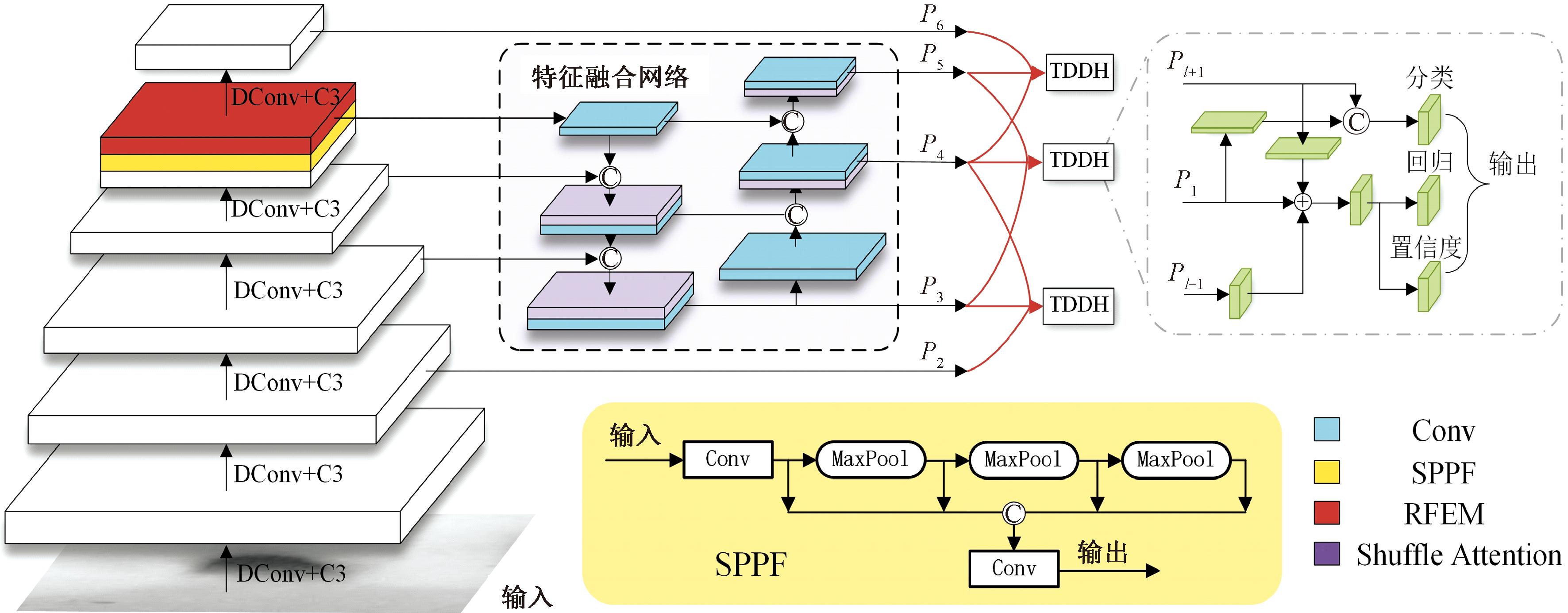

本文以轻量网络YOLOv5-n为基础,提出了一种改进YOLOv5的工业产品表面缺陷检测网络结构,如图1所示。

图1 改进YOLOv5的工业产品表面缺陷检测网络结构

Figure 1 Structure of industrial product surface defect detection network for improved YOLOv5

该网络由骨干网络、特征融合网络和任务解耦检测头3个部分组成。骨干网络采用跨阶段局部网络(cross stage partial networks, CSPNet)[23],每层通过下采样卷积DConv和C3模块提取特征,并在快速空间金字塔池化层(spatial pyramid pooling faster, SPPF)后添加感受野增强模块,该模块通过膨胀卷积获取不同尺度的感受野,然后将局部特征和区域特征相融合,提升模型的特征表达能力。特征融合网络的结构采取特征金字塔(feature pyramid, FP)和路径聚合网络(path aggregation net, PANet)[24]相结合的形式,对骨干网络的P3、P4、P5这3层特征图进行特征融合。在上下特征图按通道对齐拼接后,采用混洗注意力模块提取有效信息,该模块通过空间注意力和通道注意力相结合的方式,聚焦特征图中缺陷区域的位置信息,提升模型对缺陷区域的判别能力。最后将融合特征图送入任务解耦检测头中进行预测,检测头同时获取当前尺度及其高低两层的特征图,用以辅助分类和回归任务。其中高层特征图的感受野更广,适合从整幅图像上观察目标的轮廓,有助于判定目标的类别和形状信息;低层特征图拥有更细致的边缘纹理信息,用于辅助精细回归定位。由于任务解耦检测头需要对应3层特征图输入,因此在骨干网络中额外引入P2和P6特征图。任务解耦检测头结合不同尺度特征图的特点,将其分别用于构建分类和回归任务,从而提升了检测精度。

1.2 感受野增强模块

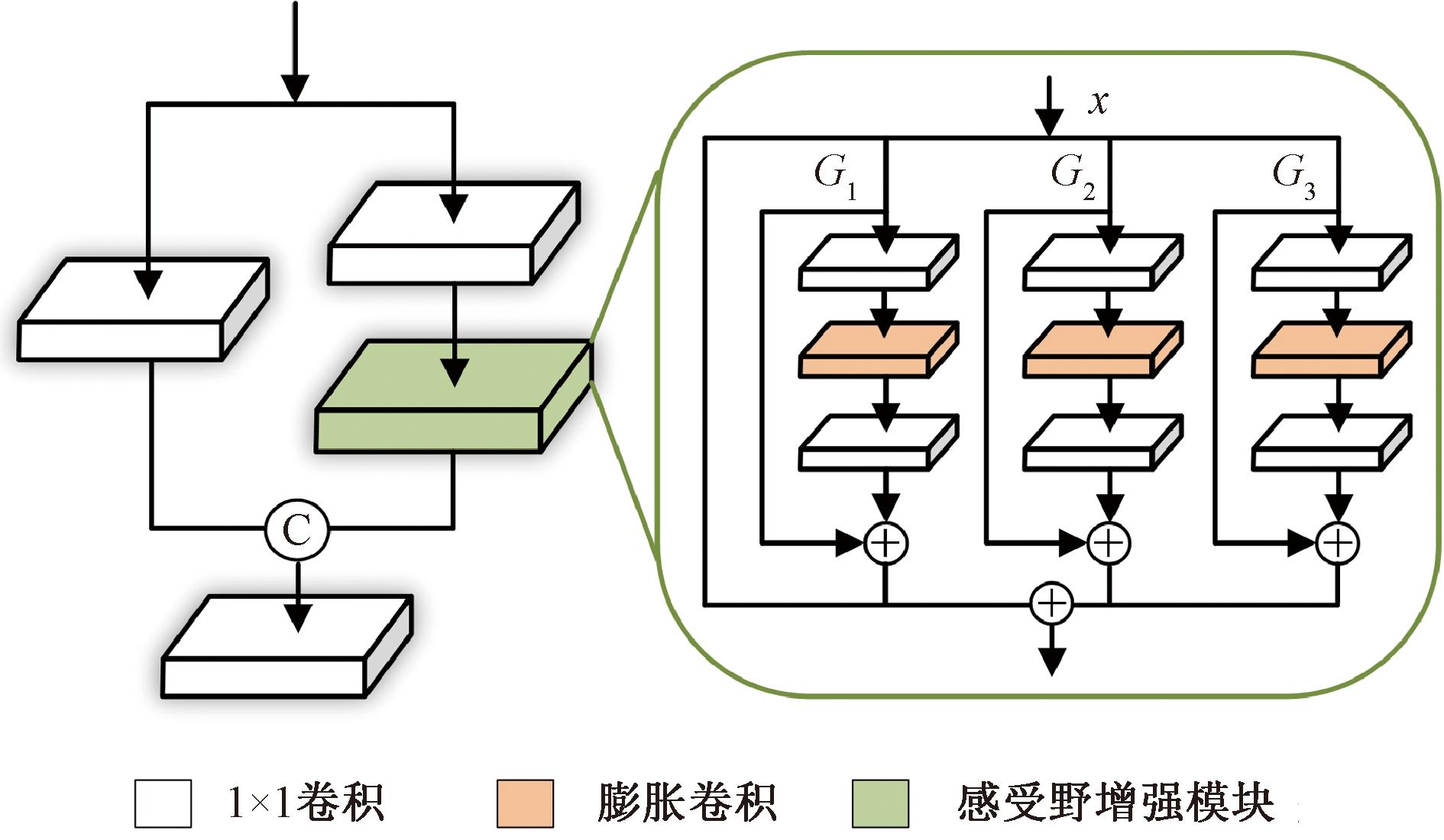

为了增强骨干网络的特征提取能力,引入了感受野增强模块(receptive field enhancement module, RFEM),其结构如图2所示。

图2 感受野增强模块结构

Figure 2 Structure of receptive field enhancement module

为了从骨干网络中获取不同尺度的特征,将YOLOv5网络中C3模块的瓶颈结构替换为3组卷积,每组膨胀卷积首先使用1×1卷积收缩通道数,然后分别采用不同的扩张速率的膨胀卷积获取不同尺度的感受野,扩张速率依次设置为1,2和3。最后使用1×1卷积扩张至原通道数,类似瓶颈结构的设计降低了膨胀卷积的参数量和计算量。为防止训练过程中梯度爆炸和梯度消失问题,每组膨胀卷积都采取了残差结构,其计算公式为

Gi(x)=x+Conv(DiConv(Conv(x),i))。

(1)

式中:x表示输入;i表示膨胀卷积的扩张速率,分别为1,2,3;Conv表示1×1卷积;DiConv表示膨胀卷积。每组膨胀卷积参数共享,既降低了参数量,又降低了模块过拟合的风险。最后,每组分支和残差分支对应通道相拼接得到输出:

(2)

1.3 混洗注意力模块

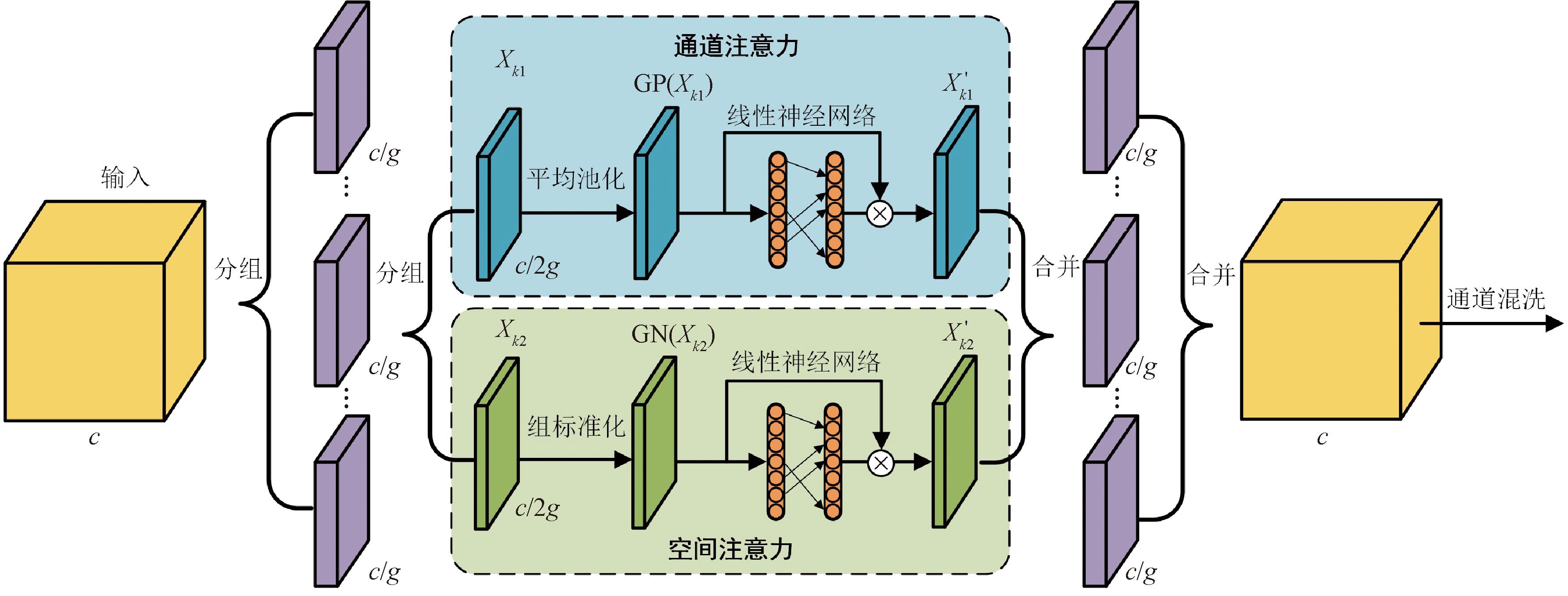

特征融合网络在融合上下两层特征图时,采取通道拼接的方式,这种方法虽然能够保留完整的特征信息,但也不可避免地引入了冗余甚至干扰信息。由于注意力机制能够获取偏向信息最丰富的特征分支,而抑制信息较弱的特征分支,因此,在通道拼接之后利用注意力机制获取有效特征信息。由于拼接特征通道数较大,直接采用注意力机制会引入大量的参数,对此,采用了混洗注意力模块(shuffle attention module, SAM),其结构如图3所示。该模块首先将特征的通道数c等分为g组,得到g组子特征,每组子特征再根据通道数等分成两部分,分别用于计算通道注意力和空间注意力。在该模块中,通道注意力由全局平均池化和线性神经网络实现。

X′k1=σ(W1s+b1)·Xk1;

(3)

(4)

图3 混洗注意力模块结构

Figure 3 Structure of shuffle attention module

RFEM(x)=x+G1(x)+G2(x)+G3(x)。

式中:Xk1表示子特征对应通道注意力的输入分支;X′k1表示通道注意力的输出分支;σ表示SiLU激活函数[25];W1和b1分别表示线性神经网络的权重和偏置;GP表示平均操作。

空间注意力采取组归一化和线性神经网络实现:

X′k2=σ(W2·GN(Xk2)+b2)·Xk2。

(5)

式中:Xk2表示子特征对应空间注意力的输入分支;X′k2表示空间注意力的输出分支;σ表示SiLU激活函数;W2和b2分别表示线性神经网络的权重和偏置;GN表示组归一化操作。最后,将所有的子特征拼接起来,然后使用通道混洗操作打乱不同组特征的顺序,增强不同组特征之间的信息通信。

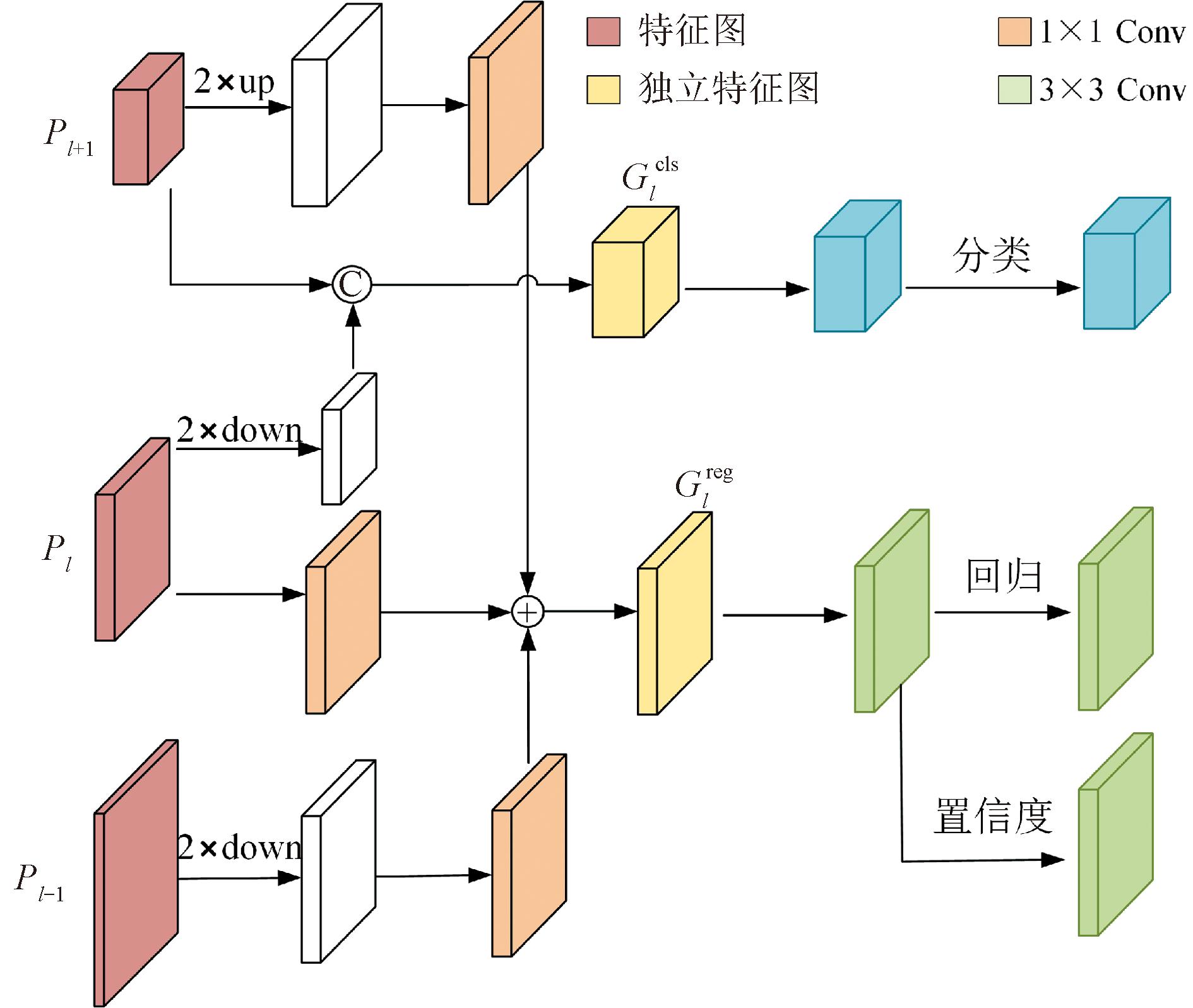

1.4 任务解耦检测头

时亚南等[26]设计了一种轻量的解耦检测头TIDE,完全解耦了分类和回归任务,提升了检测精度。基于此,本文设计了任务解耦检测头(task decoupling detection head, TDDH),其结构如图4所示。对分类任务而言,为了判断目标的类别,特征图需要提供目标的细节信息。更深层的特征图其感受野更广,能够从图像全局的角度给出图像的显著区域。同时,更深层的特征图还拥有更多的通道数,这就意味着其语义信息更丰富。因此,对于分类任务,对Pl进行下采样卷积后,与通道数更多的Pl+1相连,二者拼接成Glcls作为分类特征图。Glcls可以表示为

(6)

图4 任务解耦检测头结构

Figure 4 Structure of task decoupling detection head

式中:Concat表示按照通道对齐的方式拼接特征;DConv表示下采样卷积。最终得到的Glcls用于预测分类结果。由于对Pl进行了下采样卷积,使得Glcls的通道数扩展为Pl的3倍,而分辨率只有Pl的一半,不仅语义信息得到了非常丰富,还节约了大量参数和计算量。

对回归任务而言,不但需要从整体上观察到目标轮廓,还需要充足的边缘细节来辅助检测框回归。因此,在特征图Pl的基础上,同时引入了Pl对应的上下两层特征图Pl+1和Pl-1。其中,Pl+1用于提供全局性的边界特征,有助于模型推断出目标的大致边界定位。Pl-1则尺寸更大,拥有更细致的边缘纹理信息,有助于模型准确定位目标的边界位置。由于回归任务对语义信息不敏感,过多的通道数不仅容易误导回归边界,还引入了额外的计算量,因此,首先将3层特征图分别通过1×1卷积统一通道数;然后将Pl+1上采样至Pl大小,将Pl-1下采样至Pl大小;最后3层特征图对位相加得到为回归任务设计的特征图

![]()

![]() DConv(Conv(Pl-1))。

DConv(Conv(Pl-1))。

(7)

式中:Conv表示1×1卷积;μ表示上采样;DConv表示下采样卷积。

1.5 损失函数

本文提出的总损失函数包括分类损失、置信度损失和回归损失3部分,其计算公式为

Loss=αclsLcls+αobjLobj+αboxLbox。

(8)

式中:Lcls、Lobj、Lbox分别表示分类损失、置信度损失和回归损失;αcls、αobj、αbox分别表示3项损失的权重占比。分类损失和置信度损失均采用二值交叉熵损失BCELoss计算,其计算公式为

![]() (1-yn)·log(1-γ(xn))]。

(1-yn)·log(1-γ(xn))]。

(9)

式中:N表示样本总数;yn表示真实值;xn表示预测值;γ表示sigmoid激活函数。

回归损失采用CIoU损失,其计算公式为

![]()

(10)

(11)

(12)

式中:A、B分别表示预测框和真实框;Actr和Bctr分别表示预测框和真实框的中心点坐标;IoU(A,B)表示A框和B框的交并比;ρ(Actr,Bctr)表示A框和B框中心点坐标的欧氏距离;d表示包住A、B两框的最小矩形框的对角线距离;α和v是对检测框长宽比的惩罚系数,使得回归任务在训练过程中更稳定;wgt和hgt分别表示真实框的宽和高;w和h分别表示预测框的宽和高。

2 实验设置

2.1 数据集

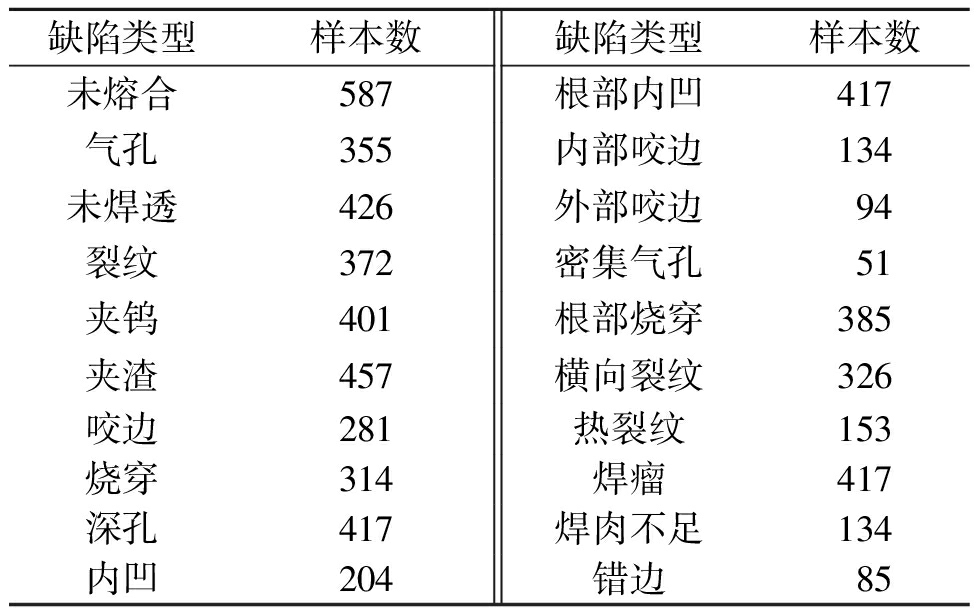

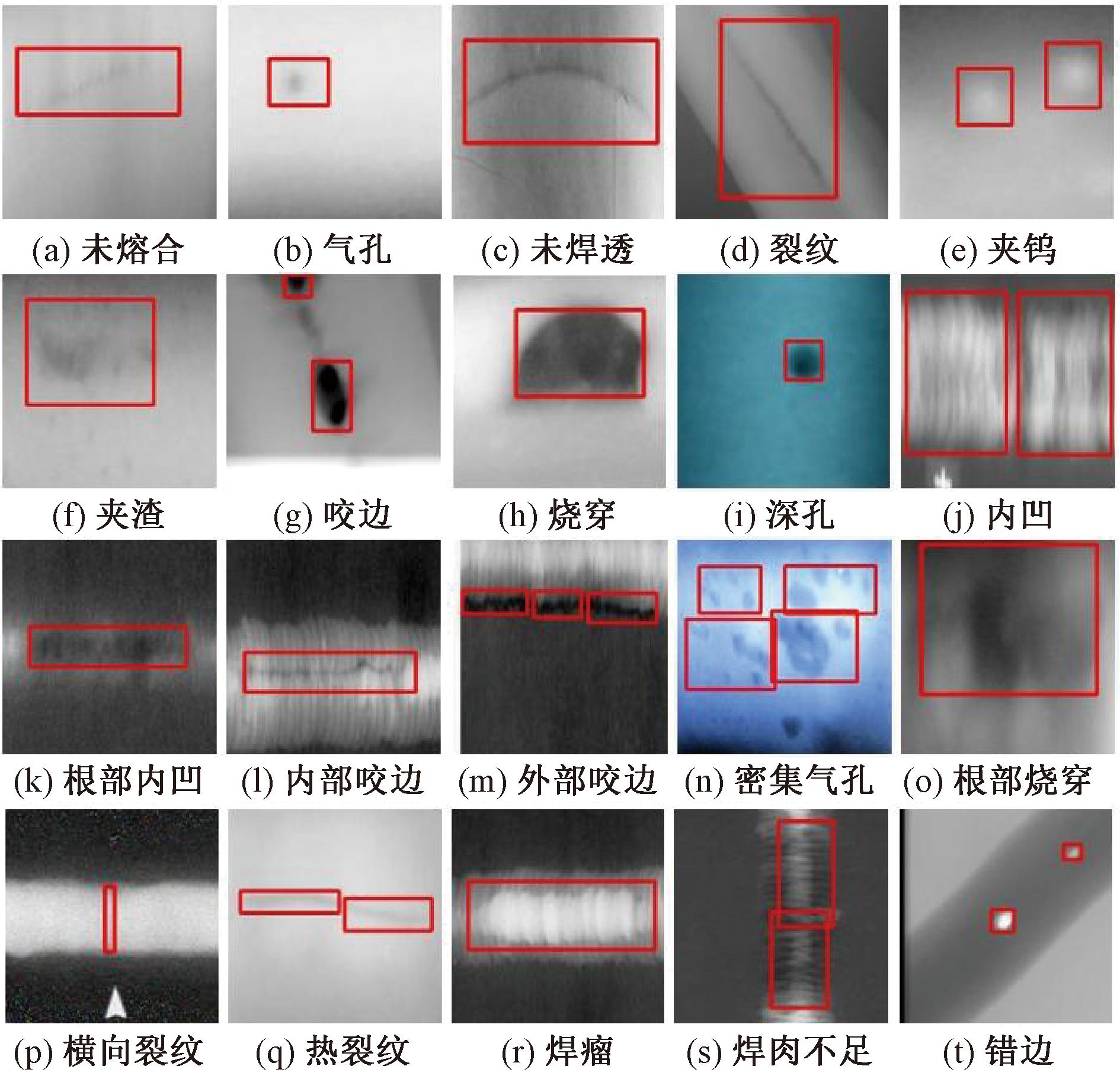

为了验证本文方法,采用了管道DR缺陷图像数据集PDD和钢材表面缺陷检测数据集NEU-DET[27]进行实验。PDD数据集由本文制作标注,一共包括6 010幅图像,共20类管道缺陷,每类缺陷样本数量如表1所示,管道DR缺陷图像样例如图5所示,本文选择了4 866幅图像作为训练集,542幅图像作为验证集,602幅图像作为测试集。

表1 PDD数据集中各类缺陷样本数量

Table 1 Number of various defect samples in the PDD dataset

缺陷类型样本数缺陷类型样本数未熔合587根部内凹417气孔355内部咬边134未焊透426外部咬边94裂纹372密集气孔51夹钨401根部烧穿385夹渣457横向裂纹326咬边281热裂纹153烧穿314焊瘤417深孔417焊肉不足134内凹204错边85

图5 管道DR缺陷图像样例

Figure 5 Sample images of pipeline DR defect

NEU-DET数据集是东北大学发布的公开缺陷检测数据集[27]。涉及裂纹、斑块、麻点表面、轧入氧化皮和划痕6种热轧带钢的典型表面缺陷,共有1 800幅图像,每类缺陷包含300张样本。本文选择1 458幅图像作为训练集,162幅图像作为验证集,180幅图像作为测试集。

2.2 参数设置

本文实验平台在windows11操作系统下进行,处理器型号为13th Gen Intel(R) Core(TM) i5-13490F,GPU型号为NVIDIA GeForce RTX 4060Ti 16 G,使用可建立深度神经网络和执行张量计算的深度学习框架PyTorch 1.11,python版本为Python3.8,CUDA版本为CUDA11.3。超参数设置:训练图片大小为320×320,训练前对样本进行Mosaic数据增强,所有模型均训练200个训练轮次,学习率采取线性调整策略,从0.010 0逐步下降到0.000 1,优化器使用SGD算法,动量系数设置为0.937,权重衰减系数为0.000 5,批次设置为32,3项损失函数的权重αcls、αobj、αbox均与官方YOLOv5保持一致。

3 实验结果与分析

3.1 对比实验

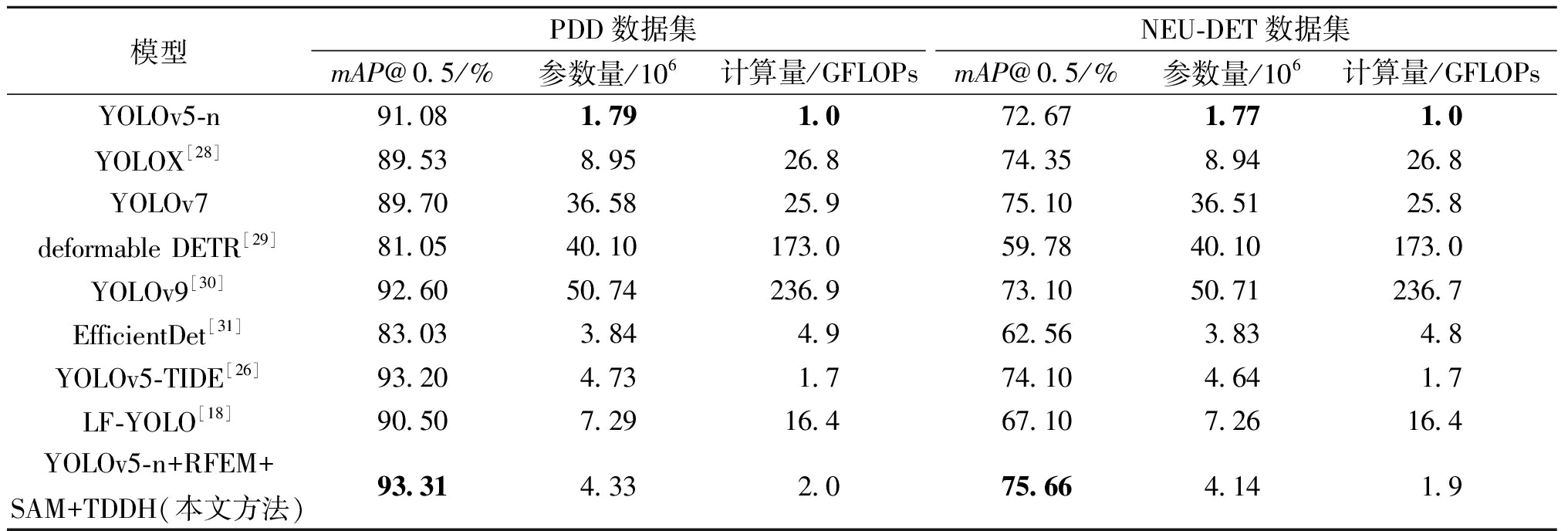

将本文方法与现存的多种目标检测算法进行对比,分别在PDD数据集和NEU-DET数据集上开展了对比实验,对比实验结果如表2所示。从表2可以看出,在参数量上,改进方法相比YOLOv5-n有所增加,除EfficientDet-d0外均低于其他检测方法[27],但EfficientDet-d0的检测精度不高。在计算量上,改进方法比YOLOv5-n稍高,但远低于其他方法,满足了工业场景中的硬件和算力需求。在检测精度上,本文方法在PDD数据集上的mAP@0.5达到93.31%,比YOLOv5-n提高了2.23百分点;在NEU-DET数据集上的mAP@0.5上达到75.66%,比YOLOv5-n提高了2.99百分点,均高于其他方法。

表2 本文方法与其他模型在两个数据集上对比实验结果

Table 2 Comparative experiments results of this method and other models on two datasets

模型PDD数据集NEU-DET数据集mAP@0.5/%参数量/106计算量/GFLOPsmAP@0.5/%参数量/106计算量/GFLOPsYOLOv5-n91.081.791.072.671.771.0YOLOX[28]89.538.9526.874.358.9426.8YOLOv789.7036.5825.975.1036.5125.8deformable DETR[29]81.0540.10173.059.7840.10173.0YOLOv9[30]92.6050.74236.973.1050.71236.7EfficientDet[31]83.033.844.962.563.834.8YOLOv5-TIDE[26]93.204.731.774.104.641.7LF-YOLO[18]90.507.2916.467.107.2616.4YOLOv5-n+RFEM+SAM+TDDH(本文方法)93.314.332.075.664.141.9

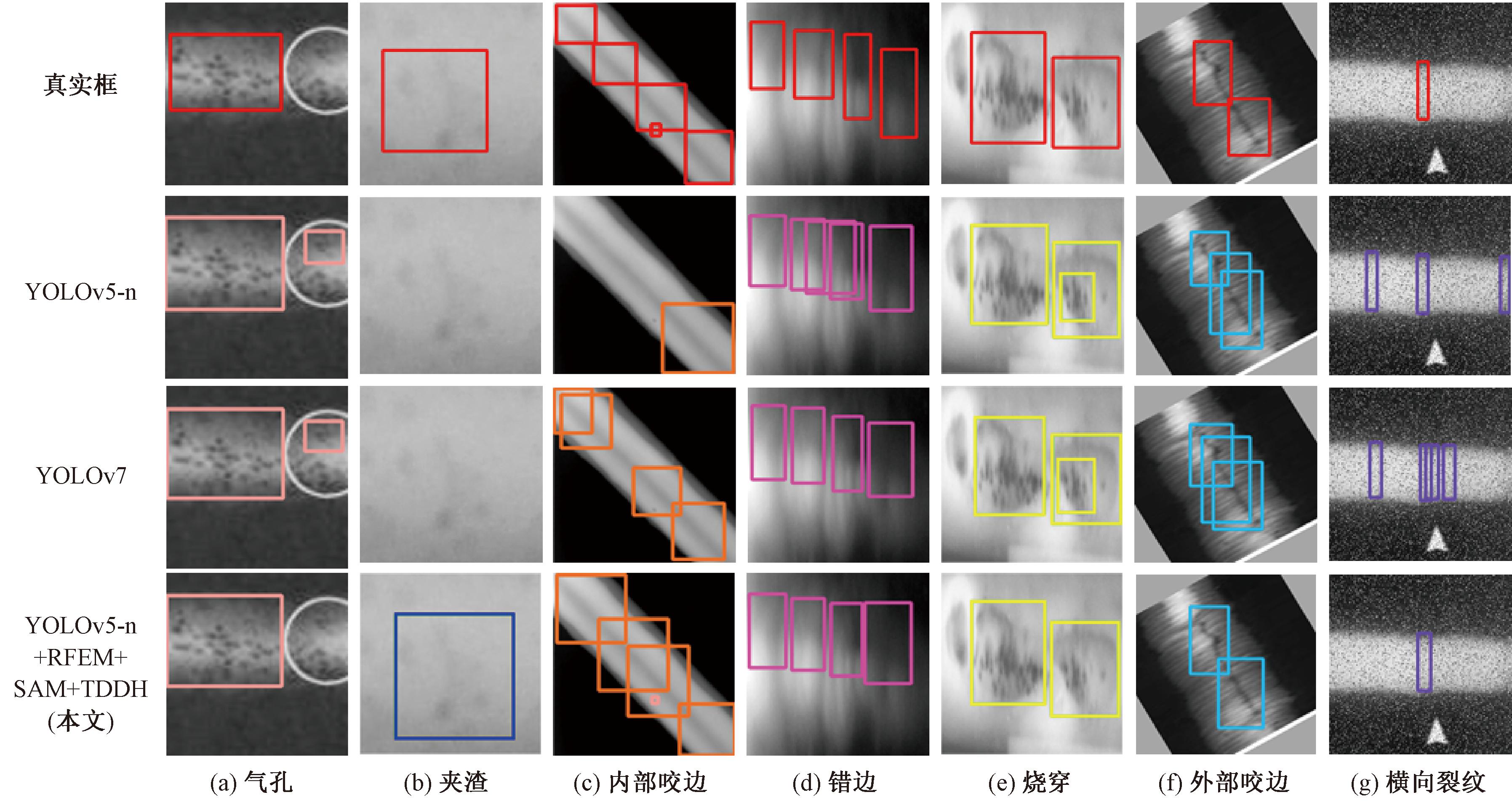

为了更直观地展示本文方法的检测效果,图6给出了本文方法与其他模型的检测结果。从图6可以看出,YOLOv5-n和YOLOv7在图6(a)、6(e)、6(f)和6(g)中都出现了类似的误检,在图6(b)中出现了漏检。在图6(c)中,YOLOv5-n和YOLOv7都不能完整地检测到缺陷,并漏检了微小缺陷。在图6(d)中,YOLOv5-n存在多个检测框重叠的问题。

图6 本文方法与其他模型的检测结果对比

Figure 6 Comparison of detection results between this method and other models

3.2 消融实验

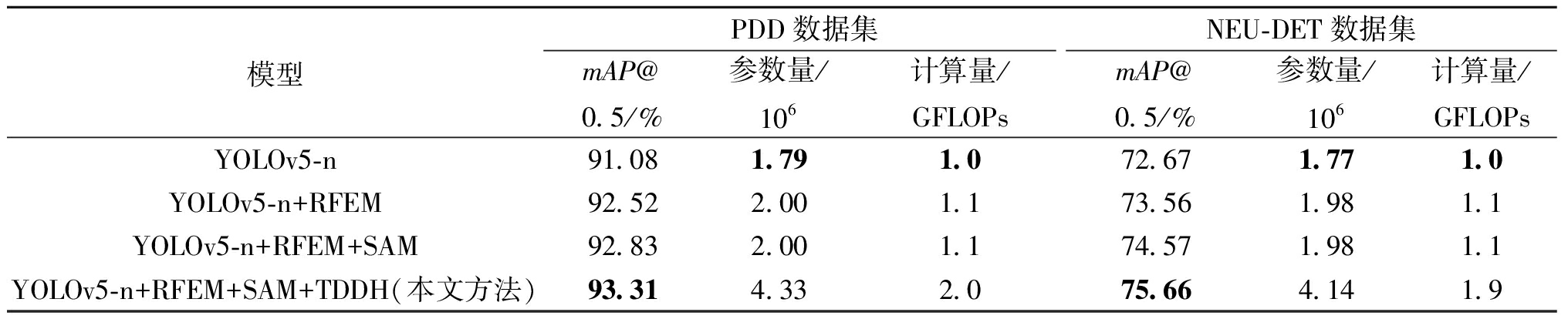

为探究每项改进方法对检测性能的影响,本文在PDD数据集和NEU-DET数据集上同时评估每个模块对模型性能的影响,实验结果如表3所示。从表3可以看出,在增加了感受野增强模块后,两个数据集的mAP@0.5分别提高了1.44百分点和0.89百分点。继续增加混洗注意力模块后,mAP@0.5分别提高了0.31百分点和1.01百分点,值得注意的是,由于混洗注意力模块采用通道分组以及简单的线性神经网络,所以几乎不增加参数量和计算量。最后增加任务解耦检测头后,mAP@0.5分别提高了0.48百分点和1.09百分点。这充分证明了本文中改进模块的有效性。

表3 本文方法与其他模型在两个数据集上消融实验

Table 3 Ablation experiments of this method and other models on two datasets

模型PDD数据集NEU-DET数据集mAP@0.5/%参数量/106计算量/GFLOPsmAP@0.5/%参数量/106计算量/GFLOPsYOLOv5-n91.081.791.072.671.771.0YOLOv5-n+RFEM92.522.001.173.561.981.1YOLOv5-n+RFEM+SAM92.832.001.174.571.981.1YOLOv5-n+RFEM+SAM+TDDH(本文方法)93.314.332.075.664.141.9

4 结论

针对工业缺陷图像弱特征、强干扰的特点,以及工业场景中对模型规模和算力的限制,本文提出了一种快速精确的工业产品表面缺陷检测方法。该模型以YOLOv5-n为基础,首先,在骨干网络尾部添加感受野增强模块,提升模型的特征表达能力;其次, 在特征融合网络中引入混洗注意力模块,从融合特征图中获取有效信息,抑制无用信息,提升模型对缺陷区域的判别能力;最后,提出了任务解耦检测头,结合不同尺度特征图的特点,将其分别用于构建分类和回归任务,从而提升了检测精度。

(本文受国家市场监管总局科技计划项目(2021MK119)的支持)

[1] CHEN Y J, DING Y Y, ZHAO F, et al. Surface defect detection methods for industrial products: a review[J]. Applied Sciences, 2021, 11(16): 7657.

[2] 罗东亮, 蔡雨萱, 杨子豪, 等. 工业缺陷检测深度学习方法综述[J]. 中国科学: 信息科学, 2022, 52(6): 1002-1039.

LUO D L, CAI Y X, YANG Z H, et al. Survey on industrial defect detection with deep learning[J]. Scientia Sinica (Informationis), 2022, 52(6): 1002-1039.

[3] REN S Q, HE K M, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149.

[4] CAI Z W, VASCONCELOS N. Cascade R-CNN: delving into high quality object detection[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway:IEEE, 2018: 6154-6162.

[5] HE K M, GKIOXARI G, DOLL R P, et al. Mask R-CNN[C]∥2017 IEEE International Conference on Computer Vision. Piscataway:IEEE, 2017: 2980-2988.

R P, et al. Mask R-CNN[C]∥2017 IEEE International Conference on Computer Vision. Piscataway:IEEE, 2017: 2980-2988.

[6] LIU Y X, WU D B, LIANG J W, et al. Aeroengine blade surface defect detection system based on improved Faster RCNN[J]. International Journal of Intelligent Systems, 2023, 2023: 1992415.

[7] WEI B, HAO K R, GAO L, et al. Detecting textile micro-defects: a novel and efficient method based on visual gain mechanism[J]. Information Sciences, 2020, 541: 60-74.

[8] LIU W, ANGUELOV D, ERHAN D, et al. SSD: single shot MultiBox detector[EB/OL].(2015-12-08)[2024-11-06].https:∥doi.org/10.48550/arXiv.1512.02325.

[9] LIN T Y, GOYAL P, GIRSHICK R, et al. Focal loss for dense object detection[C]∥2017 IEEE International Conference on Computer Vision. Piscataway:IEEE, 2017: 2999-3007.

[10] REDMON J, DIVVALA S, GIRSHICK R, et al. You only look once: unified, real-time object detection[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway:IEEE, 2016: 779-788.

[11] REDMON J, FARHADI A. YOLO9000: better, faster, stronger[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway:IEEE, 2017: 6517-6525.

[12] REDMON J, FARHADI A. YOLOv3: an incremental improvement[EB/OL].(2018-04-08)[2024-11-06].https:∥doi.org/10.48550/arXiv.1804.02767.

[13] BOCHKOVSKIY A, WANG C Y, LIAO H Y M. YOLOv4: optimal speed and accuracy of object detection[EB/OL].(2020-04-23)[2024-11-06]. https:∥doi.org/10.48550/arXiv.2004.10934.

[14] LI C, LI L, JIANG H, et al. Yolov6: a single-stage object detection framework for industrial applications[EB/OL]. (2022-09-01)[2024-11-06].https:∥doi.org/10.48550/arXiv.2209.02976.

[15] WANG C Y, BOCHKOVSKIY A, LIAO H Y M. YOLOv7: trainable bag-of-freebies sets new state-of-the-art for real-time object detectors[C]∥2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway:IEEE, 2023: 7464-7475.

[16] ZHANG J D, XU J B, ZHU L Y, et al. An improved MobileNet-SSD algorithm for automatic defect detection on vehicle body paint[J]. Multimedia Tools and Applications, 2020, 79(31): 23367-23385.

[17] PAN K L, HU H Y, GU P. WD-YOLO: a more accurate YOLO for defect detection in weld X-ray images[J]. Sensors, 2023, 23(21): 8677.

[18] LIU M Y, CHEN Y P, XIE J M, et al. LF-YOLO: a lighter and faster YOLO for weld defect detection of X-ray image[J]. IEEE Sensors Journal, 2023, 23(7): 7430-7439.

[19] 张震, 陈可鑫, 陈云飞. 优化聚类和引入CBAM的YOLOv5管制刀具检测[J]. 郑州大学学报(工学版), 2023, 44(5): 40-45, 61.

ZHANG Z, CHEN K X, CHEN Y F. YOLOv5 with optimized clustering and CBAM for controlled knife detection[J]. Journal of Zhengzhou University (Engineering Science), 2023, 44(5): 40-45, 61.

[20] 魏明军, 王镆涵, 刘亚志, 等. 基于特征融合和混合注意力的小目标检测[J]. 郑州大学学报(工学版), 2024, 45(3): 72-79.

WEI M J, WANG M H, LIU Y Z, et al. Small object detection based on feature fusion and mixed attention[J]. Journal of Zhengzhou University (Engineering Science), 2024, 45(3): 72-79.

[21] XIE Y F, HU W T, XIE S W, et al. Surface defect detection algorithm based on feature-enhanced YOLO[J]. Cognitive Computation, 2023, 15(2): 565-579.

[22] GUO Z X, WANG C S, YANG G, et al. MSFT-YOLO: improved YOLOv5 based on transformer for detecting defects of steel surface[J]. Sensors, 2022, 22(9): 3467.

[23] WANG C Y, MARK LIAO H Y, WU Y H, et al. CSPNet: a new backbone that can enhance learning capability of CNN[C]∥2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops. Piscataway:IEEE, 2020: 1571-1580.

[24] LIU S, QI L, QIN H F, et al. Path aggregation network for instance segmentation[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway:IEEE, 2018: 8759-8768.

[25] ELFWING S, UCHIBE E, DOYA K. Sigmoid-weighted linear units for neural network function approximation in reinforcement learning[J]. Neural Networks, 2018, 107: 3-11.

[26] 时亚南, 陈志远, 刘兆英, 等. 改进YOLOv5n的管道DR缺陷图像检测方法[J]. 计算机工程与应用, 2024, 60(12): 366-372.

SHI Y N, CHEN Z Y, LIU Z Y, et al. Improved YOLOv5n pipeline DR defect image detection method[J]. Computer Engineering and Applications, 2024, 60(12): 366-372.

[27] HE Y, SONG K C, MENG Q G, et al. An end-to-end steel surface defect detection approach via fusing multiple hierarchical features[J]. IEEE Transactions on Instrumentation and Measurement, 2020, 69(4): 1493-1504.

[28] GE Z, LIU S T, WANG F, et al. YOLOX: exceeding YOLO series in 2021[EB/OL].(2021-07-18)[2024-11-06].https:∥arxiv.org/abs/2107.08430.

[29] ZHU X Z, SU W J, LU L W, et al. Deformable DETR: deformable transformers for end-to-end object detection[EB/OL].(2020-10-08)[2024-11-06]. https:∥doi.org/10.48550/arXiv.2010.04159.

[30] WANG C Y, YEH I H, LIAO H Y M. YOLOv9: learning what you want to learn using programmable gradient information[EB/OL].(2024-02-21)[2024-11-06].https:∥doi.org/10.48550/arXiv.2402.13616.

[31] TAN M X, PANG R M, LE Q V. EfficientDet: scalable and efficient object detection[C]∥2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway:IEEE, 2020: 10778-10787.