近年来,目标检测作为计算机视觉领域的基础任务之一,被广泛应用于各种工业场景中。王子豪等[1]基于热力图预测减少了对“锚框”的依赖和计算,并将该改进用于对人物目标的位置检测。Gou等[2]针对目标激活区域设计增强模块,减少了环境背景对特征提取的干扰,增强了网络的特征学习能力,在安防领域的人体隐藏目标检测中取得显著成效。此外,还有用于公共交通的目标检测[3]等。

目前对于防护装备佩戴检测方法主要是基于深度学习的目标检测方法,该方法基于候选区域的分类和基于端到端的回归[4],即双阶段和单阶段两种目标检测算法。双阶段算法检测精度高而速度较慢,单阶段算法检测速度较快而检测精度较低,包括以R-CNN[5]、Faster R-CNN[6]、Mask R-CNN[7]为代表的双阶段目标检测算法和以YOLO系列[8-11]为代表的单阶段目标检测算法。针对施工现场防护装备佩戴检测这种实时性和检测准确性要求较高并且能轻易部署在边缘设备上的场景,本文提出了一种改进YOLOv8n的施工场景下防护装备佩戴检测模型,同时满足检测的实时性、准确性和轻量化要求。

在施工场景复杂环境背景下,有研究人员对YOLO算法进行改进,以满足特定条件下的检测要求。Zhou等[12]使用YOLOv5模型实现了建筑施工现场安全帽佩戴的高准确度、高速度检测。但由于数据集中的真实场景较少,模型的泛化能力不强,Zeng等[13]改进了YOLOv4算法,改进后模型对建筑工地人员安全帽检测的精度和速度都有所提升,在特征金字塔中使用跨阶段层次模块代替多个卷积模块,提高模型检测小目标的性能。Cheng等[14]改进了轻量化YOLOv3-Tiny算法,用于人员安全帽佩戴检测,使用轻量级Sandglass残差模块替代原有的卷积层,减少了参数量。程换新等[15]提出了一种基于改进YOLOX-S算法的安全帽和反光衣检测方法,使用Mosaic方法进行训练,提高网络在复杂场景下的检测能力,通过引入GIoU损失函数,有效提高了模型的识别准确率。郑海洋等[16]通过改进YOLOv3算法,对网络中多层级特征信息进行融合,使用K均值算法分析数据集,并设计了手与人体关联匹配算法,提高了绝缘手套佩戴检测的准确率。

现有的目标检测模型在防护装备佩戴检测领域取得了一定成绩,但在面对复杂背景和环境时,准确性仍然有所欠缺。本文提出的基于改进YOLOv8n的施工场景下防护装备佩戴检测算法主要贡献在于:在YOLOv8n的基础上加入了BiFPN[17]结构和EIoU[18]损失函数,并设计了C2f-ContextGuided模块和LSCD(lightweight shared convolutional detection)检测头,有效提高了网络的检测效率。

1 YOLOv8n算法

YOLOv8n在所有YOLOv8算法模型中所需参数量、计算量最小,YOLOv8n的网络结构主要包括输入端、主干网络、颈部网络和检测头。

在输入端将自适应图片缩放到同一尺寸(640×640像素)并进行Mosaic数据增强,提高了模型的鲁棒性。主干网络主要是对输入端输入的图像进行特征提取,其由CBS模块、SPPF模块和C2f模块构成。YOLOv8n提出全新的C2f模块,C2f模块通过引入频率维度帮助网络更好地学习通道之间的关系,实现增强网络特征融合能力和轻量化的目的。颈部网络即特征融合层采用PAN结构,通过引入横向连接来加强特征的语义信息,显著增强了特征信息的融合与利用。检测头通过Anchor-Free机制直接回归目标的位置和大小来实现目标检测任务,从而简化模型设计、提高检测性能。

2 YOLO-LA模型

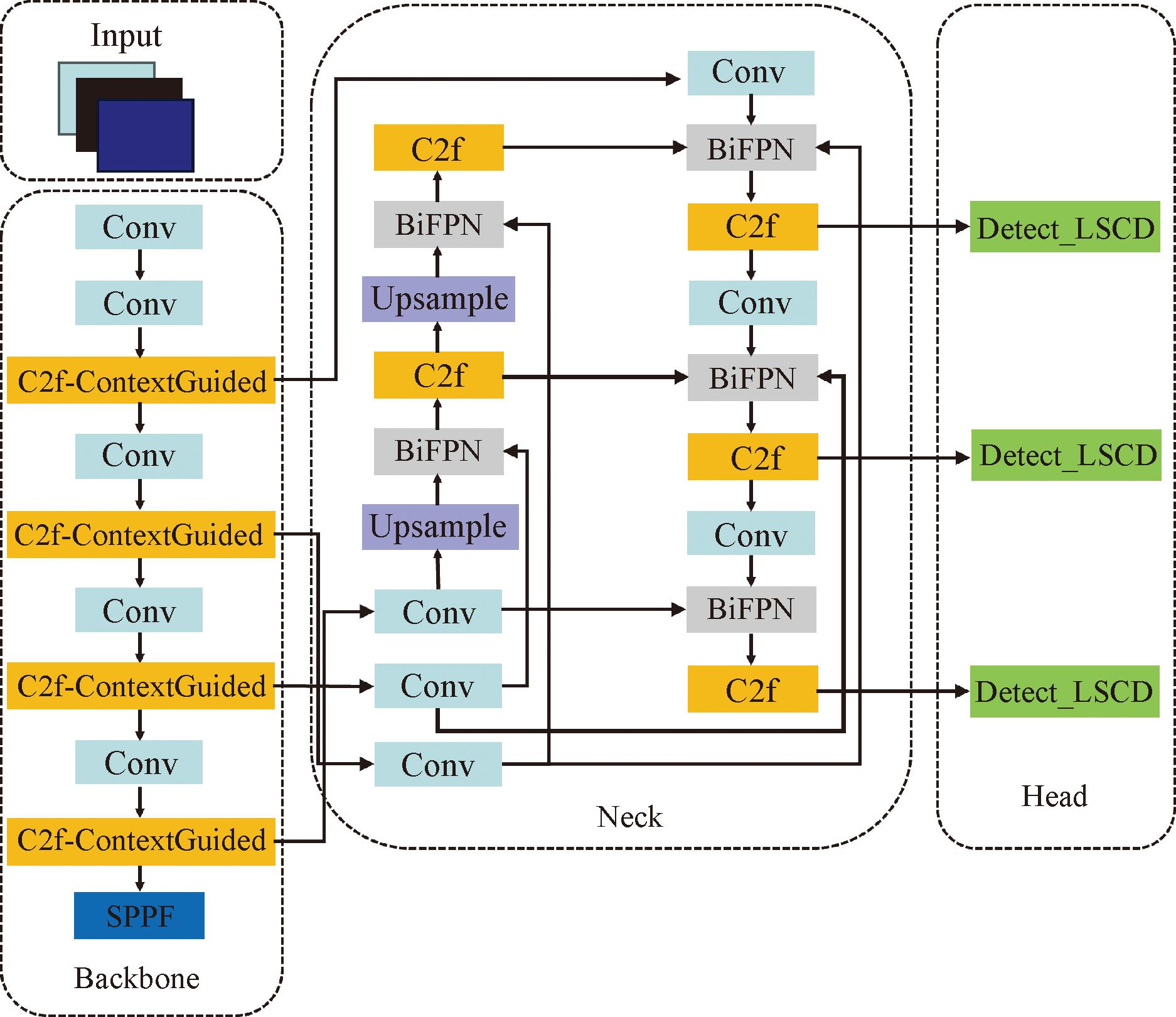

针对目前施工场景下防护装备佩戴检测中存在的模型参数量大、模型计算复杂度高、计算量大以及难以部署在边缘设备上等问题,采用4种优化策略对YOLOv8n进行改进,改进后的YOLO-LA如图1所示。

图1 YOLO-LA的网络结构

Figure 1 Structure of YOLO-LA

2.1 加权双向特征金字塔网络BiFPN

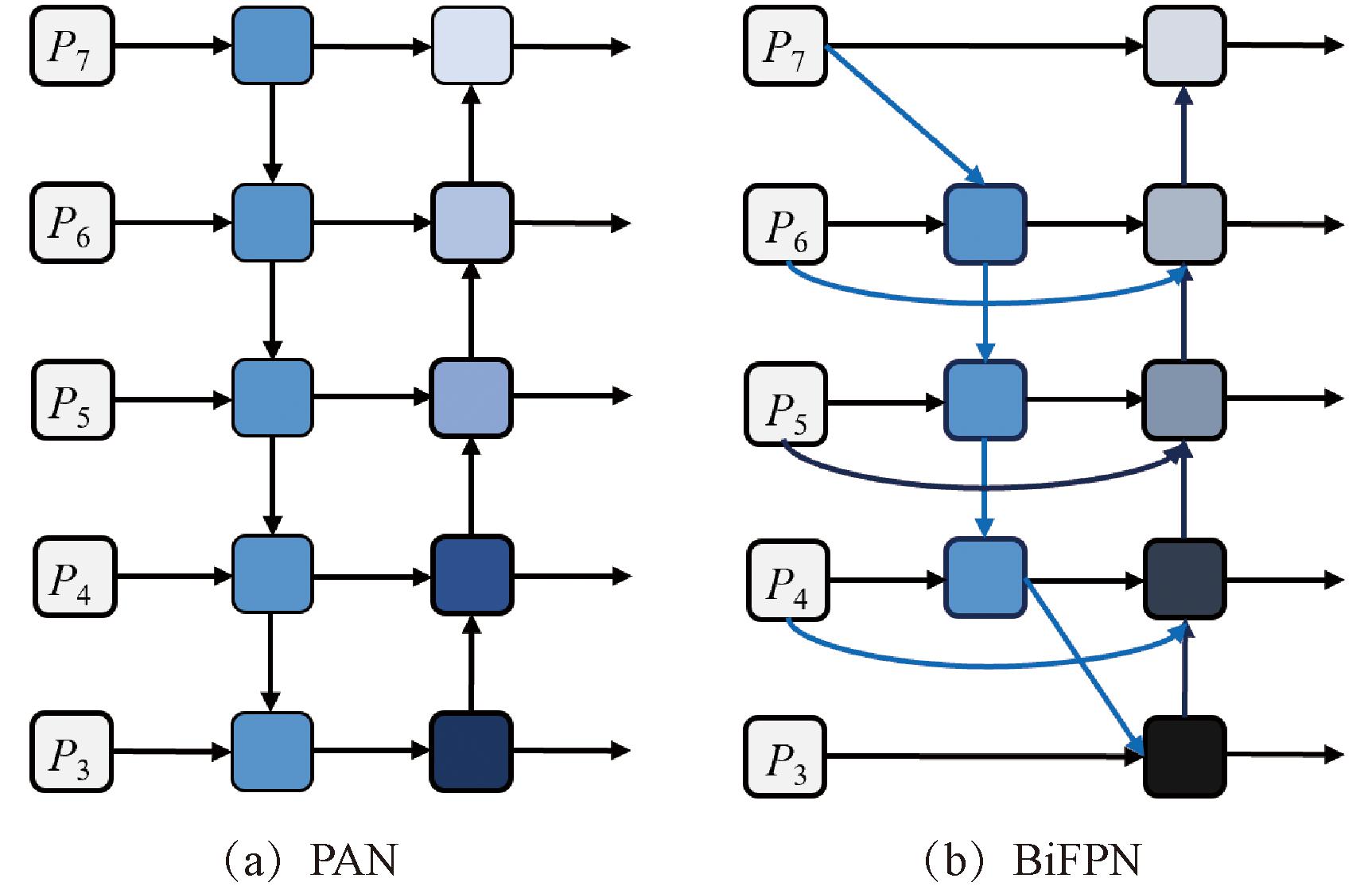

YOLOv8n的颈部网络采用的是PAN结构,其由一个自顶向下的路径和一个自底向上的路径组成,用于聚合不同尺度的特征,自顶向下的路径用于上采样低层特征以匹配高层特征的分辨率,自底向上的路径用于融合不同尺度的特征。

图2为PAN结构图和BiFPN 结构图。BiFPN结构通过对传统FPN[19]的改进,删除只有一条输入边且没有特征融合的节点(如图2(b)中P7右边第1个节点),由于其本身对融合特征的特征网络贡献较小,删除它对网络检测精度影响不大,同时简化了网络结构、减少了参数计算量。此外,BiFPN的特征融合过程是通过在每个级别上进行特征融合和跨层连接来实现的,使得网络可以更好地利用不同尺度的特征信息,相较于PAN结构,BiFPN有效提高了模型对小目标的检测精度。

图2 PAN结构图和BiFPN结构图

Figure 2 Structure diagrams of PAN and BiFPN

2.2 C2f-ContextGuided模块

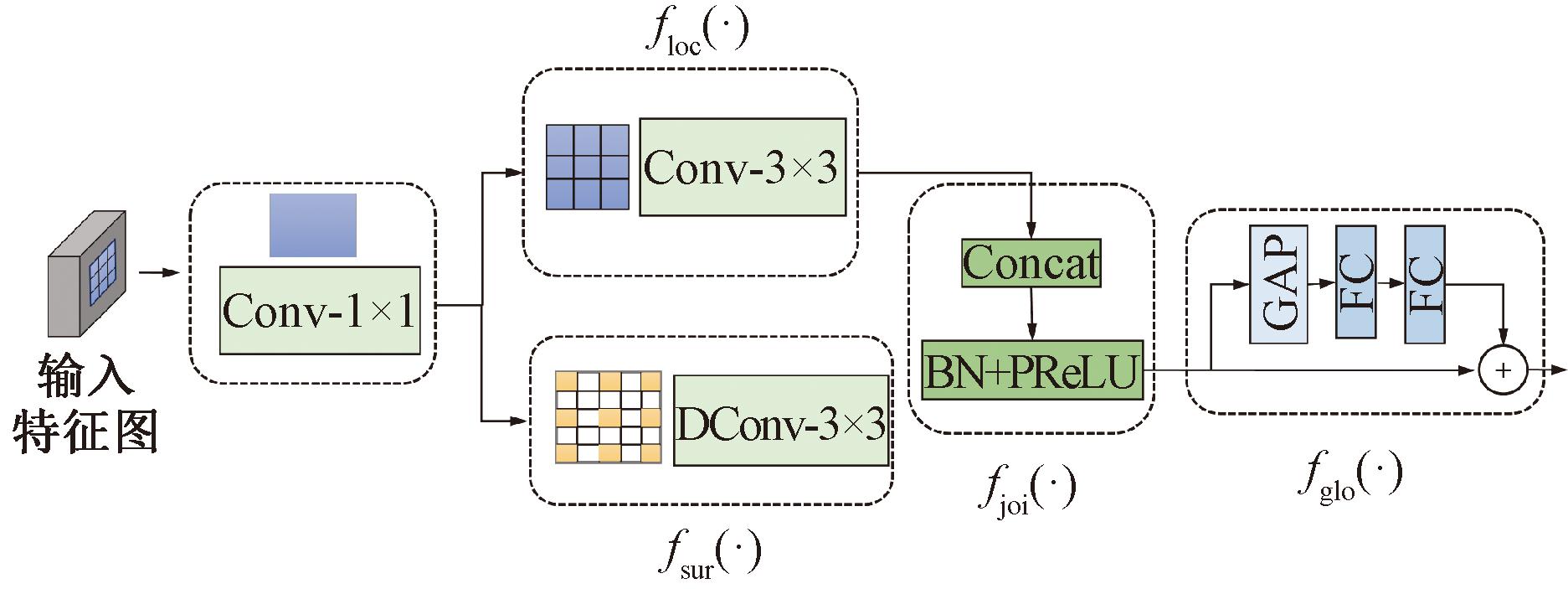

ContextGuided Block是轻量级语义分割网络CGNet[20]的主要构成部分,该模块通过引入全局和局部上下文信息,帮助模型更好地理解输入数据的结构和特征,使得CGNet仅需较少参数的同时保证较高准确度。ContextGuided Block主要由4部分组成,如图3所示。图3中floc(·)提取器通过3×3普通卷积提取局部特征,通过滑动卷积核的方式在整个输入数据上提取不同位置的局部特征,从而实现对输入数据的局部感知;fsur(·)提取器通过3×3膨胀卷积提取周围上下文特征,膨胀卷积通过增加卷积核的空洞,使得卷积核在不改变参数数量的情况下扩大了感受野,从而可以更好地捕捉输入数据中的全局上下文信息,其在提取更广泛的上下文信息时,仍然能够保持较少的参数量;fjoi(·)提取器将floc(·)和fsur(·)的输出进行Concat操作,再通过BN层对模型训练进行加速收敛,Parametric ReLU激活函数使得网络更具有稳健性,减少了对网络架构和超参数的敏感度,最终得到联合特征;fglo(·)提取器将联合特征进行全局平均池化和多层感知机操作,将得到的权重和输入按元素相乘得到最终的全局上下文特征。

图3 ContextGuided模块

Figure 3 ContextGuided module

使用ContextGuided Block改进C2f中的Bottleneck 模块,得到新的C2f-ContextGuided模块如图4所示。该结构在不增加网络参数的情况下减小了模型的总体尺寸,利用空间依赖性和上下文信息,通过学习局部特征和上下文特征的联合特征,再利用全局上下文特征改进上述联合特征,能够更好地捕捉数据中的重要信息,减少冗余和无用信息的影响,增强网络的学习能力。

图4 C2f-ContextGuided模块

Figure 4 C2f-ContextGuided module

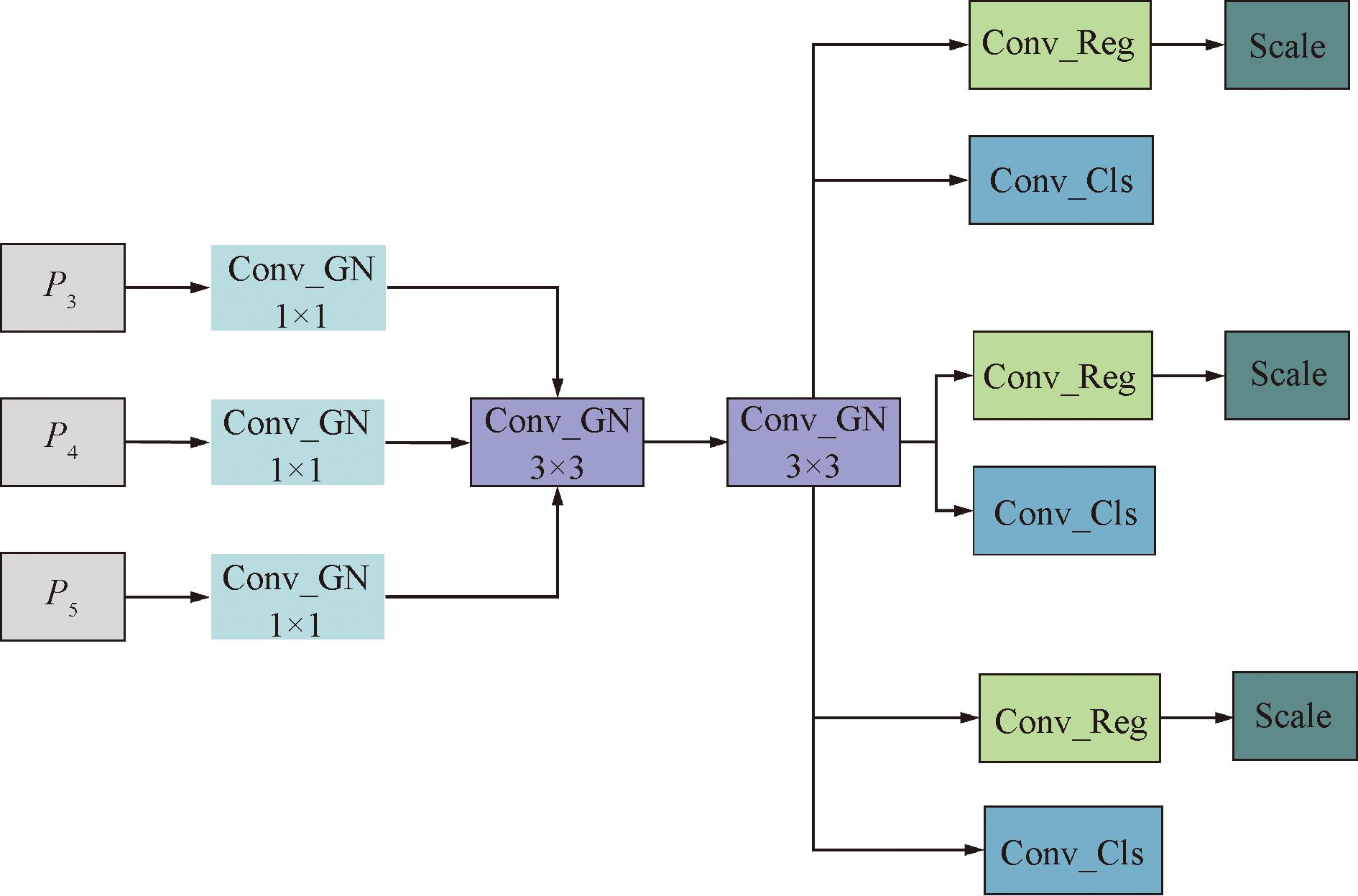

2.3 LSCD轻量化检测头

YOLOv8n采用解耦头,将检测头分为两个分支,每个分支都会进行两个3×3Conv操作和一个1×1Conv2d操作,这会产生冗余的参数计算量且模型检测精度会受影响。由于施工场景下防护装备佩戴检测对实时性要求高,因此重新设计检测头,整体结构如图5所示。

图5 LSCD轻量化检测头

Figure 5 LSCD lightweight detection head

设计Conv_GN模块,其结构如图6所示,将CBS模块中的BN(batch normalization)层修改为GN[21](group normalization)层。这是因为BN层在batchsize过小时性能降低,过大时容易显存不足,而GN将有关联的特征通道分为一组,并计算通道方向每个group的均值和方差,在每个group内进行归一化,灵活避开了BN的问题,同时提升了检测头定位和分类性能。此外,在检测头部分还使用了共享卷积操作,通过1×1Conv_GN模块的输出数据输入到3×3Conv_GN模块,在输入数据的每个位置,都使用相同的卷积核进行卷积操作。这种共享参数的方式可以有效提取输入数据的特征,降低模型的复杂度。为了应对每个检测头所检测的目标尺度不一致的问题,通过Scale层对特征进行缩放。

图6 Conv_GN结构图

Figure 6 Structure diagram of Conv_GN

2.4 优化边界框损失函数

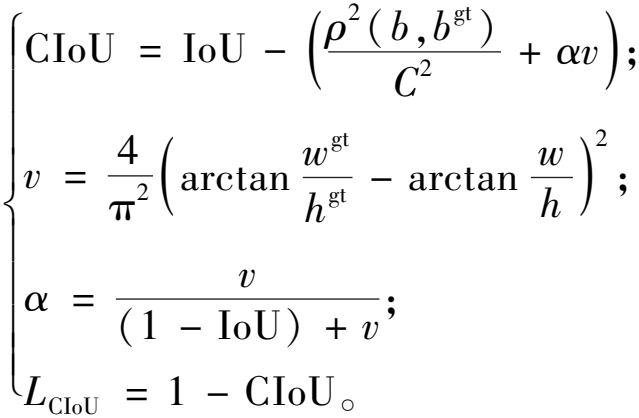

损失函数通常用于模型的训练和优化,YOLOv8n采用的是CIoU损失函数[22],表达式为

(1)

式中:IoU为两框之间的交并比;ρ为两个框中心点之间的距离;α为权衡参数;v为衡量长宽比一致性的参数;wgt、hgt分别为目标框的宽和高;w、h分别为预测框的宽和高。

然而,CIoU损失函数存在宽高比例不明确的问题,可能导致宽度和高度差异被忽略。因此使用EIoU损失函数可以更全面地评估边界框预测的准确性,进一步提高模型的性能。该损失函数的表达式如下:

(2)

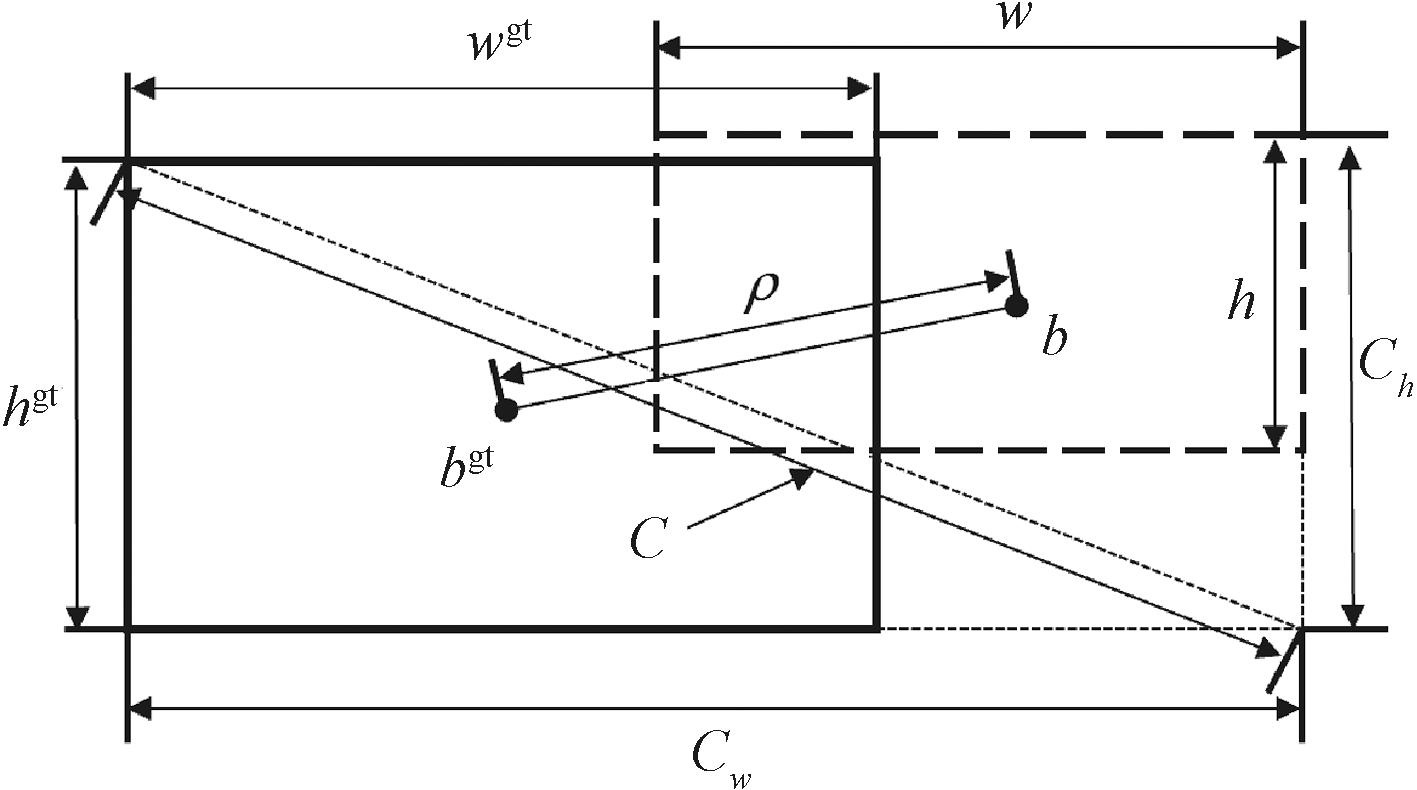

式中:C为预测框和目标框的最小外接框的对角线距离;Cw和Ch分别表示预测框和目标框的最小外接框宽度和高度;ρ2(b,bgt)表示预测框和目标框中心点之间的欧氏距离;w和wgt分别为预测框和目标框的宽度;h和hgt分别为预测框和目标框的高度。图7为EIoU损失函数参数图,虚线为预测框,粗实线为目标框。

图7 EIoU损失函数参数图

Figure 7 EIoU loss function parameter diagram

EIoU在CIoU基础上将预测框和目标框的纵横比直接拆分为单独预测长和宽,并结合其梯度下降趋势对损失函数进行了改进。EIoU损失函数可以提高目标检测的准确度、稳定性和自适应能力。

3 实验结果与分析

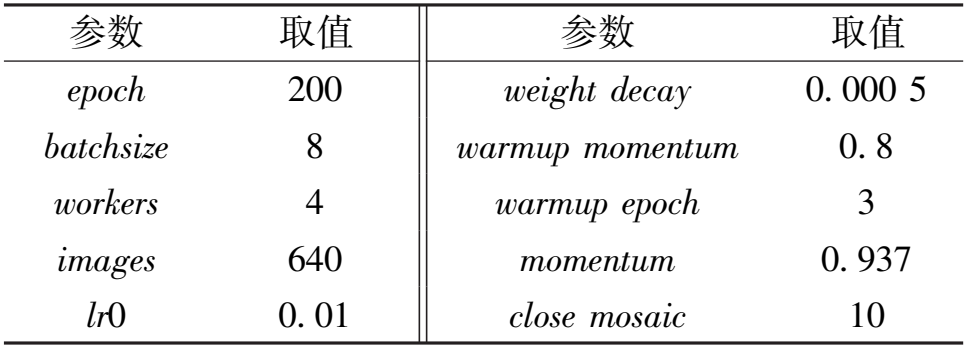

3.1 实验环境和参数配置

本文实验使用的是Linux系统,搭载深度学习框架Pytorch,CUDA为11.3版本,编程语言为Python。在硬件配置方面,配备了12个虚拟CPU(型号为Intel(R) Xeon(R) Platinum 8255C,主频为2.50 GHz)、40 GB内存以及一块RTX 3080显卡,训练参数设置如表1所示。

表1 训练参数设置

Table 1 Training parameter setting

参数 取值 参数 取值 epoch 200 weight decay 0. 000 5 batchsize 8 warmup momentum 0. 8 workers 4 warmup epoch 3 images 640 momentum 0. 937 lr0 0. 01 close mosaic 10

3.2 实验数据集

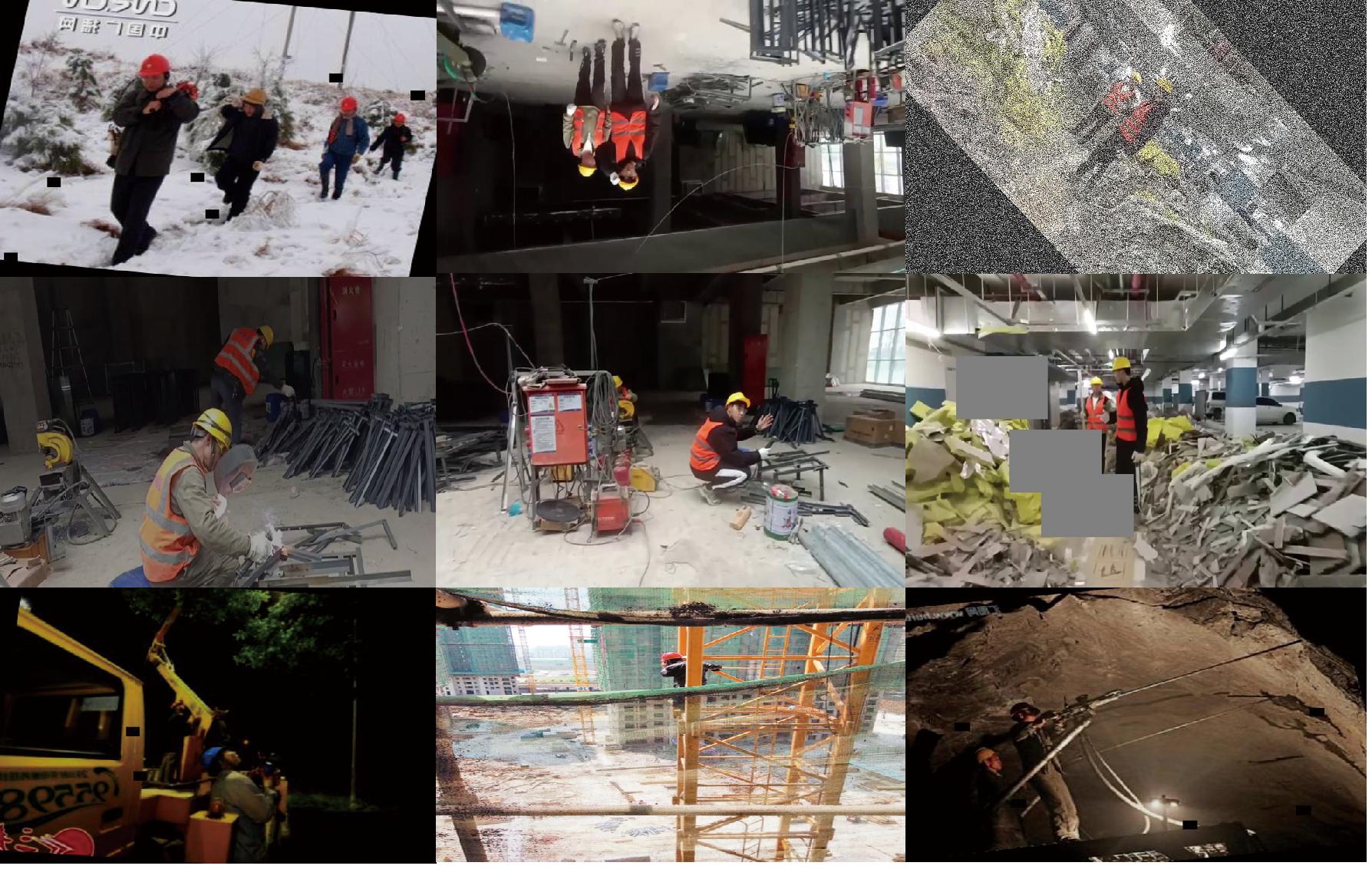

本文模型训练所需的安全帽、安全手套和反光衣(安全背心)数据集获取的来源主要分为3部分:通过爬虫在百度图片中获取、通过对施工现场进行拍摄采集以及通过公开数据集获得。该数据集的内容特点是工人在施工现场工作的场景,包含2 616张图片。为了增加实验数据集的丰富性以及避免训练过程中产生过拟合现象,采用数据增强技术对数据集进行处理,通过增加掩码、增加高斯噪声、图像旋转、调整亮度和图像模糊等方式对原始图像进行转换。数据增强后的数据集样例如图8所示,最终数据集共包含7 057张图片,图片尺寸为1 280×720像素,将数据集数据按9∶1的比例划分为训练集和验证集,其中训练集图片6 351张,验证集图片706张。

图8 数据集样例

Figure 8 Data augmentation

3.3 评价指标

在目标检测任务中,使用多种指标来衡量模型的性能,这些指标可以用来评价网络模型检测结果的好坏,其中常用的指标包括:准确率P、召回率R、平均精度AP、均值平均精度mAP以及每秒帧率FPS。FPS越高,速度性能越好,它可以判断目标检测算法是否可以满足实时性的需求。

平均精度 AP(average precision)是目标检测模型的一个重要评价指标,用于计算整个模型的平均检测精确度,通过计算 P-R 曲线下的积分面积实现。其计算公式如下:

AP=![]() P(R)dR。

P(R)dR。

(3)

均值平均精度mAP(mean average precision)是所有类别的AP值取平均值,用于衡量算法在多个类别上的平均表现,可以反映模型的综合性能。mAP越大,说明模型的准确率越高,检测效果越好。其计算公式如下:

(4)

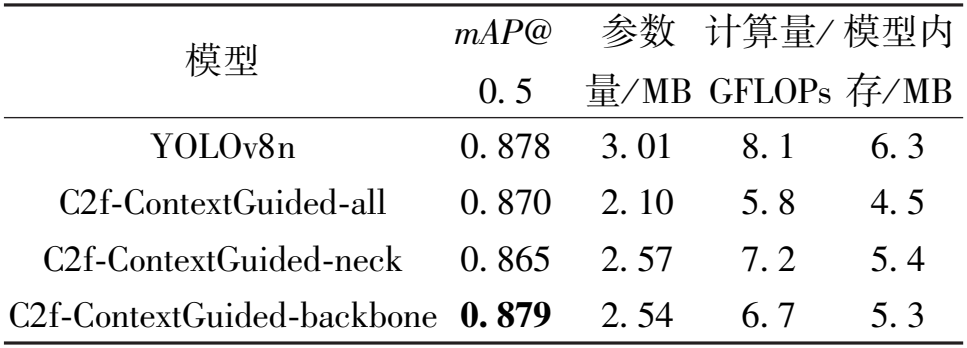

3.4 C2f-ContextGuided模块有效性

为测试C2f-ContextGuided模块加入模型不同位置后对模型性能提升情况,本文设计如表2所示的对比实验。由表2数据可知,将基线模型中骨干网络的C2f模块替换为C2f-ContextGuided后,减少了模型总体参数和计算复杂度,同时检测精度不变。这是因为膨胀卷积通过增加卷积核的空洞,可以在保持感受野大小的情况下减少卷积操作的数量,从而降低计算量。该模型能够实现局部特征和全局特征的信息融合,更好地捕捉数据中的重要信息,减少冗余信息和无用信息的影响,进而降低参数量和模型内存,使得模型更加轻量化。

表2 C2f-ContextGuided模块不同位置对比

Table 2 Comparison of different positions of the C2f-ContextGuided module

模型 mAP@ 0. 5 参数 量/ MB 计算量/ GFLOPs 模型内 存/ MB YOLOv8n 0. 878 3. 01 8. 1 6. 3 C2f-ContextGuided-all 0. 870 2. 10 5. 8 4. 5 C2f-ContextGuided-neck 0. 865 2. 57 7. 2 5. 4 C2f-ContextGuided-backbone 0. 879 2. 54 6. 7 5. 3

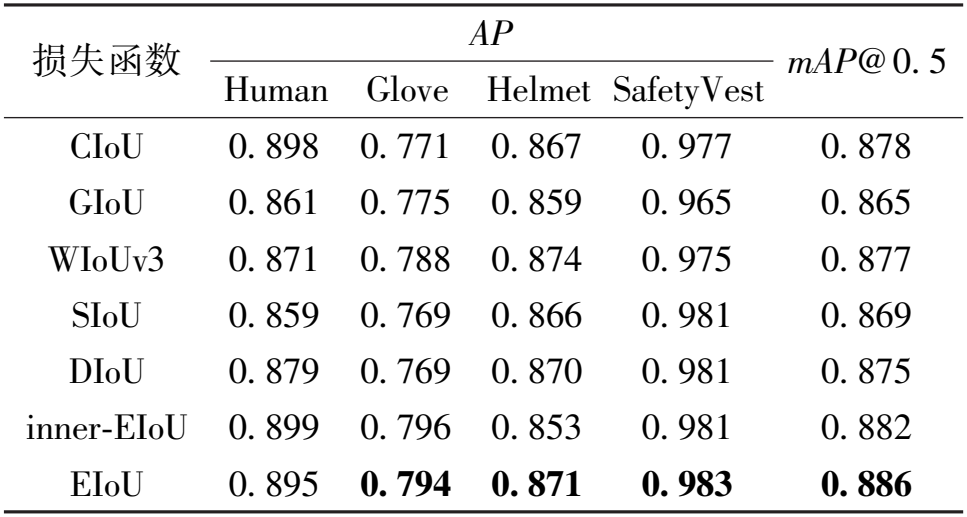

3.5 损失函数有效性

为了验证EIoU损失函数的有效性,在原模型YOLO8n的基础上将 EIoU损失函数分别与GIoU、WIoUv3、SIoU、DIoU、inner-EIoU损失函数进行对比,结果如表3所示。由表3可知,使用 EIoU模型的性能最好。EIoU 提高了模型高质量anchor的贡献,有效减少了模型训练的回归定位损失。

表3 损失函数对比

Table 3 Comparison of loss functions

损失函数 AP Human Glove Helmet SafetyVest mAP@ 0. 5 CIoU 0. 898 0. 771 0. 867 0. 977 0. 878 GIoU 0. 861 0. 775 0. 859 0. 965 0. 865 WIoUv3 0. 871 0. 788 0. 874 0. 975 0. 877 SIoU 0. 859 0. 769 0. 866 0. 981 0. 869 DIoU 0. 879 0. 769 0. 870 0. 981 0. 875 inner-EIoU 0. 899 0. 796 0. 853 0. 981 0. 882 EIoU 0. 895 0. 794 0. 871 0. 983 0. 886

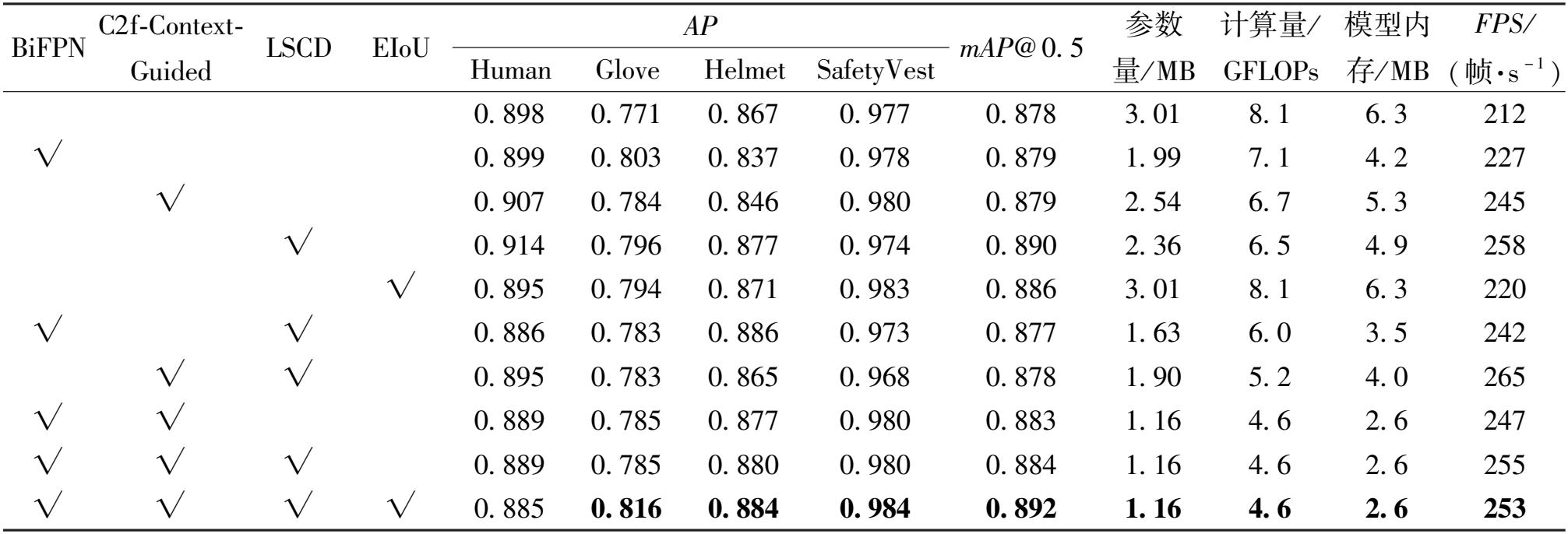

3.6 消融实验

为验证每个改进模块对基线模型的优化效果,本文共进行了10组消融实验,在3.1节所述的相同实验环境和参数配置下进行实验,每组消融实验的epoch都设置为200,在验证集上对各个训练输出的最佳权重文件进行验证,得到数据如表4所示。

表4 消融实验结果

Table 4 Results of ablation experiments

BiFPN C2f-Context- Guided LSCD EIoU AP Human Glove Helmet SafetyVest mAP@ 0. 5 参数 量/ MB 计算量/ GFLOPs 模型内 存/ MB FPS / (帧·s - 1 ) 0. 898 0. 771 0. 867 0. 977 0. 878 3. 01 8. 1 6. 3 212 √ 0. 899 0. 803 0. 837 0. 978 0. 879 1. 99 7. 1 4. 2 227 √ 0. 907 0. 784 0. 846 0. 980 0. 879 2. 54 6. 7 5. 3 245 √ 0. 914 0. 796 0. 877 0. 974 0. 890 2. 36 6. 5 4. 9 258 √ 0. 895 0. 794 0. 871 0. 983 0. 886 3. 01 8. 1 6. 3 220 √ √ 0. 886 0. 783 0. 886 0. 973 0. 877 1. 63 6. 0 3. 5 242 √ √ 0. 895 0. 783 0. 865 0. 968 0. 878 1. 90 5. 2 4. 0 265 √ √ 0. 889 0. 785 0. 877 0. 980 0. 883 1. 16 4. 6 2. 6 247 √ √ √ 0. 889 0. 785 0. 880 0. 980 0. 884 1. 16 4. 6 2. 6 255 √ √ √ √ 0. 885 0. 816 0. 884 0. 984 0. 892 1. 16 4. 6 2. 6 253

注:√表示采用该改进算法。

在基线模型上引入C2f-ContextGuided模块、LSCD轻量化检测头、BiFPN结构以及EIoU损失函数,改进后模型所拥有的参数量、计算量、模型内存都有明显缩减,同时检测精度和FPS也显著提升。为进一步优化模型算法,将改进模块两两组合进行消融实验,其中将BiFPN结构和C2f-ContextGuided模块进行结构改进,得到的参数量、计算量和模型内存分别为1.16 MB、4.6 GFLOPs和2.6 MB,同时mAP@0.5达到88.3%,在此基础上依次引入LSCD轻量化检测头和EIoU损失函数,得到最终的改进模型YOLO-LA,相较于基线模型,参数量、计算量和模型复杂度分别降低了61.5%,43.2%和58.7%,mAP@0.5提高了1.4百分点,FPS为253帧/s,证明了本文所提算法的实时性和有效性。

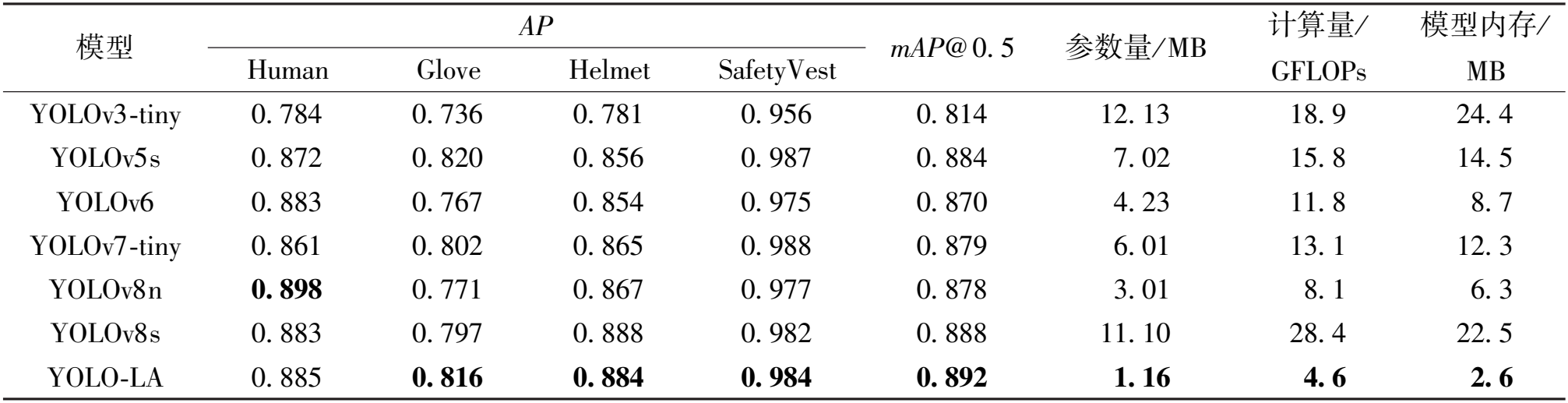

3.7 不同算法性能对比

为验证本文算法YOLO-LA的优越性,将改进算法YOLO-LA与一系列当前热门的YOLO算法在同一环境下进行对比实验,实验结果如表5所示。

表5 不同算法对比实验结果

Table 5 Comparison among experimental results of different algorithms

模型 AP Human Glove Helmet SafetyVest mAP@ 0. 5 参数量/ MB 计算量/ GFLOPs 模型内存/ MB YOLOv3-tiny 0. 784 0. 736 0. 781 0. 956 0. 814 12. 13 18. 9 24. 4 YOLOv5s 0. 872 0. 820 0. 856 0. 987 0. 884 7. 02 15. 8 14. 5 YOLOv6 0. 883 0. 767 0. 854 0. 975 0. 870 4. 23 11. 8 8. 7 YOLOv7-tiny 0. 861 0. 802 0. 865 0. 988 0. 879 6. 01 13. 1 12. 3 YOLOv8n 0. 898 0. 771 0. 867 0. 977 0. 878 3. 01 8. 1 6. 3 YOLOv8s 0. 883 0. 797 0. 888 0. 982 0. 888 11. 10 28. 4 22. 5 YOLO-LA 0. 885 0. 816 0. 884 0. 984 0. 892 1. 16 4. 6 2. 6

由表5可知,本文改进算法不仅参数量、模型内存及计算量小于其他对比网络,而且mAP@0.5的值明显大于其他网络。因此改进模型算法在各个指标方面都展现了明显的优越性。

3.8 算法效果验证

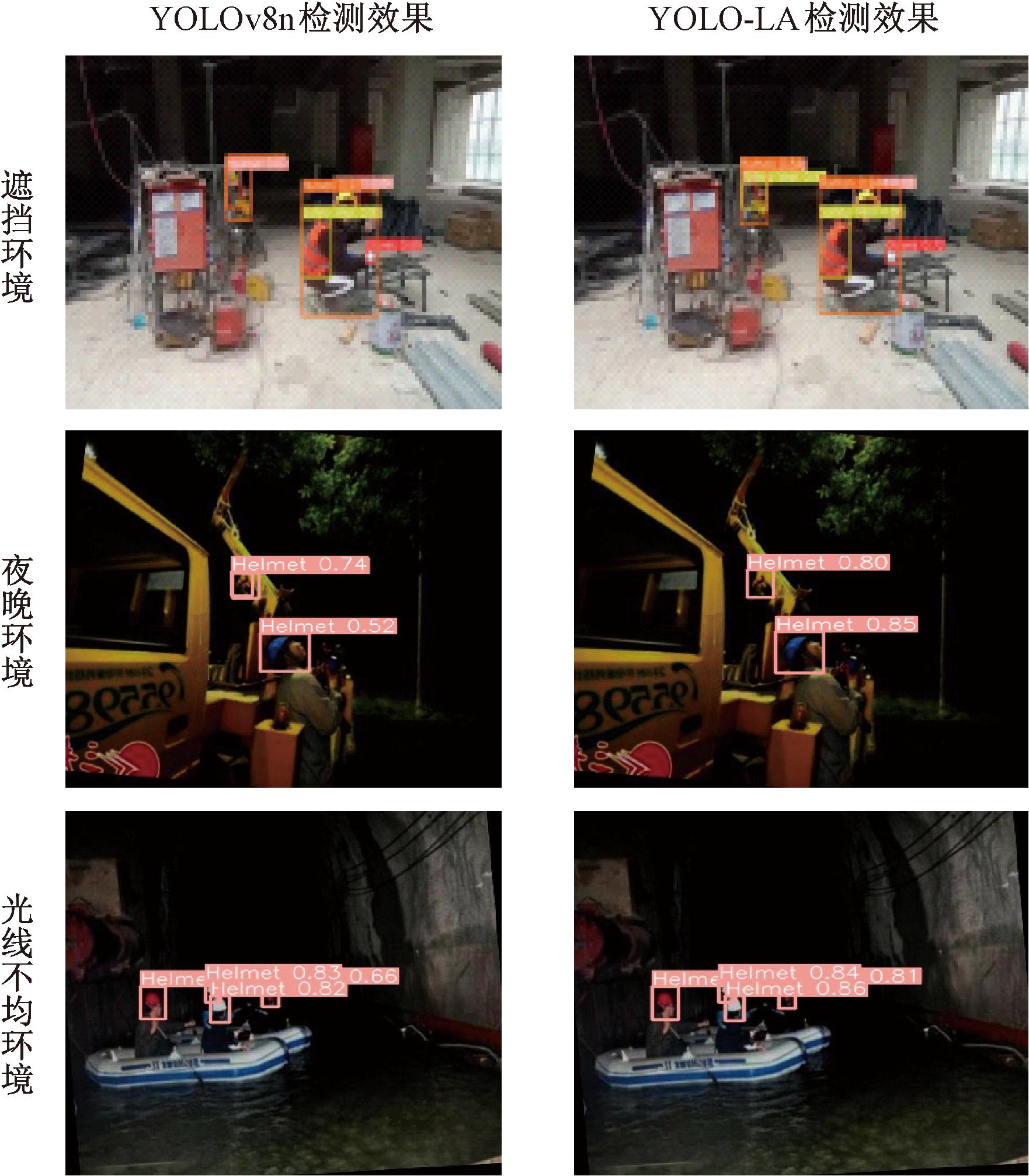

为了验证改进模型在实际检测中的效果,将YOLOv8n和YOLO-LA算法在各种复杂场景下的防护装备佩戴检测结果进行可视化图片对比,如图9所示。

图9 防护装备佩戴检测效果对比图

Figure 9 Comparison of the detection effect of protective equipment wearing

由图9可以看出,在遮挡环境下,造成待测目标仅保留局部特征,使得网络提取到的特征不全,导致左图反光衣漏检,改进C2f-ContextGuided通过融合局部特征和全局特征强化对目标的关注度,提升网络对该类目标的特征提取能力,解决了漏检的问题,如图9中右图所示检测出了所有目标,同时使用BiFPN多尺度融合机制提高了对小目标(安全手套)的检测精度。

在夜晚环境下,光线较暗,导致目标物体不易辨别和定位,同时背景干扰较大,容易产生误判,此外,夜晚环境下目标物体的形状、颜色和纹理等特征也变得模糊不清,增加了目标检测的难度,通过改进检测头,在LSCD检测头中采用共享卷积操作可以帮助模型在夜晚学习到更加通用的特征表示,从而实现更好的性能表现。

在光线不均环境下,能见度和清晰度显著降低,模型特征学习变得更加困难,导致图9中左图安全帽检测精度较低,通过改进损失函数,解决了CIoU无法准确反映宽、高与置信度之间真实差异的问题,同时提高了目标检测任务的准确性,缓解了上述现象,因此图9中右图检测效果显著优于左图。

综上,本文模型对漏检、精度低等问题有明显改善,进一步证明了本文模型的有效性和实用性。

4 结论

针对在施工场景中现有的防护装备检测算法存在受复杂背景干扰、光照昏暗不均以及被施工设备遮挡等问题,本文提出的YOLO-LA算法表现较好,平均精确度为89.2%,检测速度为253帧/s,相比基线模型YOLOv8n,参数量、计算量和模型内存分别降低了61.5%,43.2%和58.7%,检测识别和轻量化效果都有所提高。

(1) BiFPN增强了模型的多尺度特征融合能力,提高了对小目标的检测能力。

(2) C2f-ContextGuided模块提高了模型对局部特征和上下文特征的联合使用,能够更好地捕捉图像中的重要信息,降低了模型计算复杂性、网络结构复杂性并增强了网络灵活性。

(3)LSCD轻量化检测头使用组归一化(GN)和共享卷积提高了检测头定位和分类性能,并降低了模型的复杂度。EIoU损失函数有效提高了模型anchor的质量,改善了目标检测的准确度、稳定性和自适应能力。

下一步工作将研究基于YOLOv8改进算法的智慧工地防护装备佩戴检测的实际应用,以智慧工地管理系统的方式代替人工巡检的自主目视检测。

[1] 王子豪,方成,李丽萍,等.基于热力图预测的免“锚框”人物目标检测算法[J].计算机工程,2024,50(10):51-60.

WANG Z H, FANG C, LI L P, et al.Anchor-free person target detection algorithm based on heat map prediction[J].Computer Engineering,2024,50(10):51-60.

[2] GOU S P, WANG X L, MAO S S, et al. Weakly-supervised semantic feature refinement network for MMW concealed object detection[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2023, 33(3): 1363-1373.

[3] CAO J, LI P H,ZHANG H, et al. An improved YOLOv4 lightweight traffic sign detection algorithm[J]. IAENG International Journal of Computer Science, 2023,50(3):825-831.

[4] 许德刚, 王露, 李凡. 深度学习的典型目标检测算法研究综述[J]. 计算机工程与应用, 2021, 57(8): 10-25.

XU D G, WANG L, LI F. Review of typical object detection algorithms fordeep learning[J]. Computer Engineering and Applications, 2021, 57(8): 10-25.

[5] GIRSHICK R, DONAHUE J, DARRELL T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]∥2014 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2014: 580-587.

[6] REN S Q, HE K M, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposalnetworks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149.

[7] HE K M, GKIOXARI G, DOLL R P, et al. Mask R-CNN[C]∥2017 IEEE International Conference on Computer Vision (ICCV). Piscataway: IEEE, 2017: 2980-2988.

R P, et al. Mask R-CNN[C]∥2017 IEEE International Conference on Computer Vision (ICCV). Piscataway: IEEE, 2017: 2980-2988.

[8] ROY A M, BOSE R, BHADURI J. A fast accurate fine-grain object detection model based on YOLOv4 deep neural network[J].Neural Computing and Applications,2022,34(5): 3895-3921.

[9] QIAO S Y, CHEN L C, YUILLE A. DetectoRS: detecting objects with recursive feature pyramid and switchable atrous convolution[C]∥2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway: IEEE, 2021: 10213-10224.

[10] BIST R, SUBEDIS B, YANG X, et al. A novel YOLOv6 object detector for monitoring piling behavior of cage-free laying hens[J]. Agriengineering,2023,5(2): 905-923.

[11] WANG C Y, BOCHKOVSKIY A, LIAO H Y M. YOLOv7: trainable bag-of-freebies sets new state-of-the-art for real-time object detectors[C]∥2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway: IEEE, 2023: 7464-7475.

[12] ZHOU F B, ZHAO H L, NIE Z. Safety helmet detection based on YOLOv5[C]∥2021 IEEE International Conference on Power Electronics, Computer Applications (ICPECA). Piscataway: IEEE, 2021: 6-11.

[13] ZENG L P, DUAN X L, PAN Y H, et al. Research on the algorithm of helmet-wearing detection based on the optimized yolov4[J]. The Visual Computer:International Journal of Computer Graphics, 2023, 39(5): 2165-2175.

[14] CHENG R, HE X W, ZHENG Z L, et al. Multi-scale safety helmet detection based on SAS-YOLOv3-tiny[J]. Applied Sciences, 2021, 11(8): 3652.

[15] 程换新, 蒋泽芹, 程力, 等. 基于改进YOLOX-S的安全帽反光衣检测算法[J]. 电子测量技术, 2022, 45(6): 130-135.

CHENG H X, JIANG Z Q, CHENG L, et al. Helmet andreflective clothing detection algorithm based on improved YOLOX-S[J]. Electronic Measurement Technology, 2022, 45(6): 130-135.

[16] 郑海洋, 宋纯贺, 武婷婷, 等. 面向绝缘手套佩戴状况检测的小目标检测与匹配算法[J]. 小型微型计算机系统, 2023, 44(9): 1989-1995.

ZHENG H Y, SONG C H, WU T T, et al. Small target detection and matching algorithm for wearing condition detection of insula-ting gloves[J]. Journal of ChineseComputer Systems, 2023, 44(9): 1989-1995.

[17] TAN M X, PANG R M, LEQ V. EfficientDet:scalable and efficient object detection[C]∥2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway: IEEE, 2020: 10781-10790.

[18] ZHANG Y F, REN W Q, ZHANG Z, et al. Focal and efficient IOU loss for accurate bounding box regression[J]. Neurocomputing, 2022, 506: 146-157.

[19] GHIASI G, LIN T Y, LE Q V. NAS-FPN: learning scalable feature pyramid architecture for object detection[C]∥2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway: IEEE, 2019: 7036-7045.

[20] WU T Y, TANG S, ZHANG R, et al. CGNet:a light-weight context guided network for semantic segmentation[J]. IEEE Transactions on Image Processing,2021,30: 1169-1179.

[21] WU Y X, HE K M.Group normalization[J]. International Journal of Computer Vision. 2020,128(3):742-755.

[22] ZHENG Z H, WANG P, LIU W, et al. Distance-IoU loss:faster and better learning for bounding box regression[J]. Proceedings of the AAAI Conference on Artificial Intelligence, 2020, 34(7): 12993-13000.