遥感图像目标检测是指从遥感图像中识别出感兴趣的物体或目标,并将其轮廓用矩形或多边形等形式表示出来的技术。遥感图像目标检测是地理信息技术领域中一个重要的研究方向,在环境检测、地质勘查、植被检测、海洋生态监测、地表灾害监测等领域发挥着重要的作用。

遥感图像中的目标检测算法通常被划分为两阶段检测算法与单阶段检测算法两类。R-CNN系列算法作为典型的两阶段检测方法,在准确性上有明显的优势,但这类算法存在训练复杂及检测速度较慢的问题。相比之下,单阶段检测算法如YOLO(you only look once)[1]系列算法和SSD(single shot multibox detector)[2]算法,则采用了直接回归的方式来确定目标的位置和分类信息。这种方法大大减少了计算资源的需求,显著加快了检测速度,不过在精度上有所妥协。YOLO系列算法[3]在遥感图像目标检测领域,常见的改进措施包括:增强骨干网络的特征提取能力[4]、引入注意力机制[5]、采用密集连接技术[6]等。

改进目标检测算法可以更换骨干网络。一些骨干网络利用深度卷积(DWconv)[7]或组卷积(Gconv)[8]提取网络特征来解决特征冗余,但会导致精度下降,而Chen等[9]提出了一种简单的部分卷积(Pconv),并基于此构建了FasterNet网络有效解决了此类问题。此外,融合注意力机制[10]可以突出目标特征权重来改进算法性能,如SE注意力机制[11]、CA注意力机制[12]和EMA注意力机制[13]。其中,EMA是一种新型的高效多尺度注意力机制,可以有效解决特征融合过程中小目标特征丢失问题。YOLOv8算法的损失函数中,CIoU损失函数关注中心坐标的回归,而忽略了边界框长宽比的影响,可能导致细长或压缩的物体难以准确检测,而WIoU边界框损失函数对于小目标检测更为有效。综上所述,本文提出了一种基于FEW-YOLOv8(FasterNet-EMA-WIoU-YOLOv8)模型的遥感图像目标检测算法。主要工作如下:使用FasterNet作为算法的骨干网络,更有效地提取了遥感图像中小目标的空间特征;使用EMA注意力与C2f构建全新的C2f_EMA模块,在融合特征前进行特征注意力加强操作;采用具有动态非单调FM的WIoUv3作为边界框的损失函数,提高模型的边界框定位准确度,强化对小目标的定位能力。

1 基于FEW-YOLOv8遥感图像目标检测算法

1.1 改进的FEW-YOLOv8算法

YOLO系列算法主要包括骨干网络(Backbone)、颈部结构(Neck)和头部预测层(Head)3个组件,YOLOv8相较于YOLOv5[14]和YOLOv7[15]检测精度和速度都有所提升。骨干网络使用CSPDarknet[16],由一系列卷积层和池化层构成,用于图像的特征提取;颈部设计了基于PANet[17]的PAN-FPN结构,即在PAN结构中去掉了上采样后的卷积;在头部预测层中使用分布焦点损失DFL[18]和CIoU[19],实现了检测精度的提升,加速了模型的收敛。但YOLOv8对于遥感图像的小目标检测还存在一些问题,如在检测过程中特征提取时缺少小目标信息、特征融合过程中部分信息丢失、小目标特征信息不明显等。

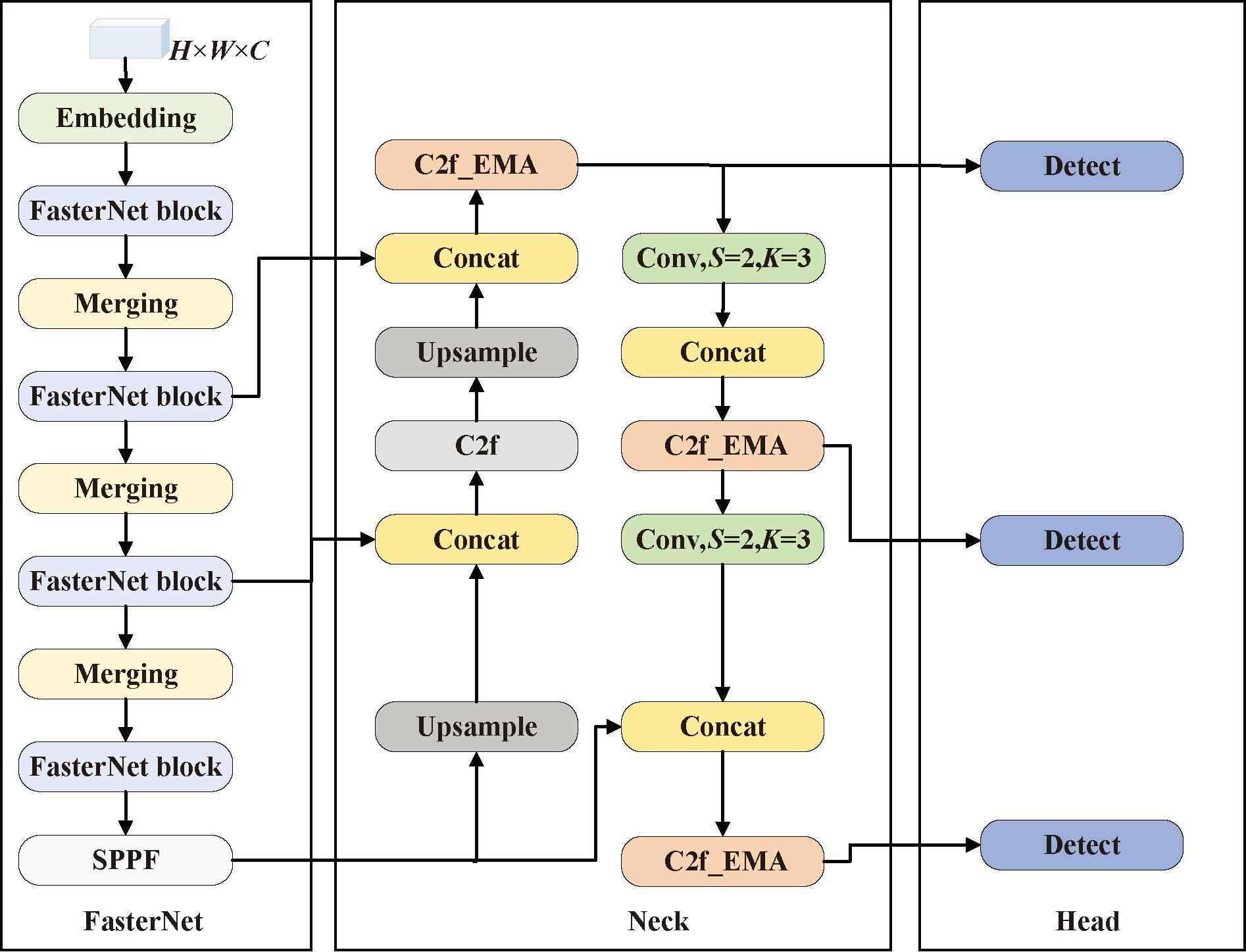

针对上述问题,本文基于YOLOv8设计了一种FEW-YOLOv8算法,对YOLOv8算法进行改进以提升小目标检测的性能,其网络结构如图1所示。

图1 FEW-YOLOv8的网络结构

Figure 1 Network structure of FEW-YOLOv8

首先,优化骨干网络架构,使用FasterNet骨干网络,更有效地提取了遥感图像中小目标的空间特征,使得网络模型更专注于微小目标,从而提升小目标检测精度。其次,使用EMA注意力与C2f构建全新的C2f_EMA模块,替换Neck结构中的C2f模块,在融合特征前进行特征注意力加强操作,使网络模型更突出特征信息中小目标部分,有效解决特征融合过程中小目标特征丢失问题。最后,采用具有动态非单调FM的WIoUv3作为边界框损失函数,提高模型的边界框定位准确度,强化对小目标的定位能力。

1.2 FasterNet骨干网络

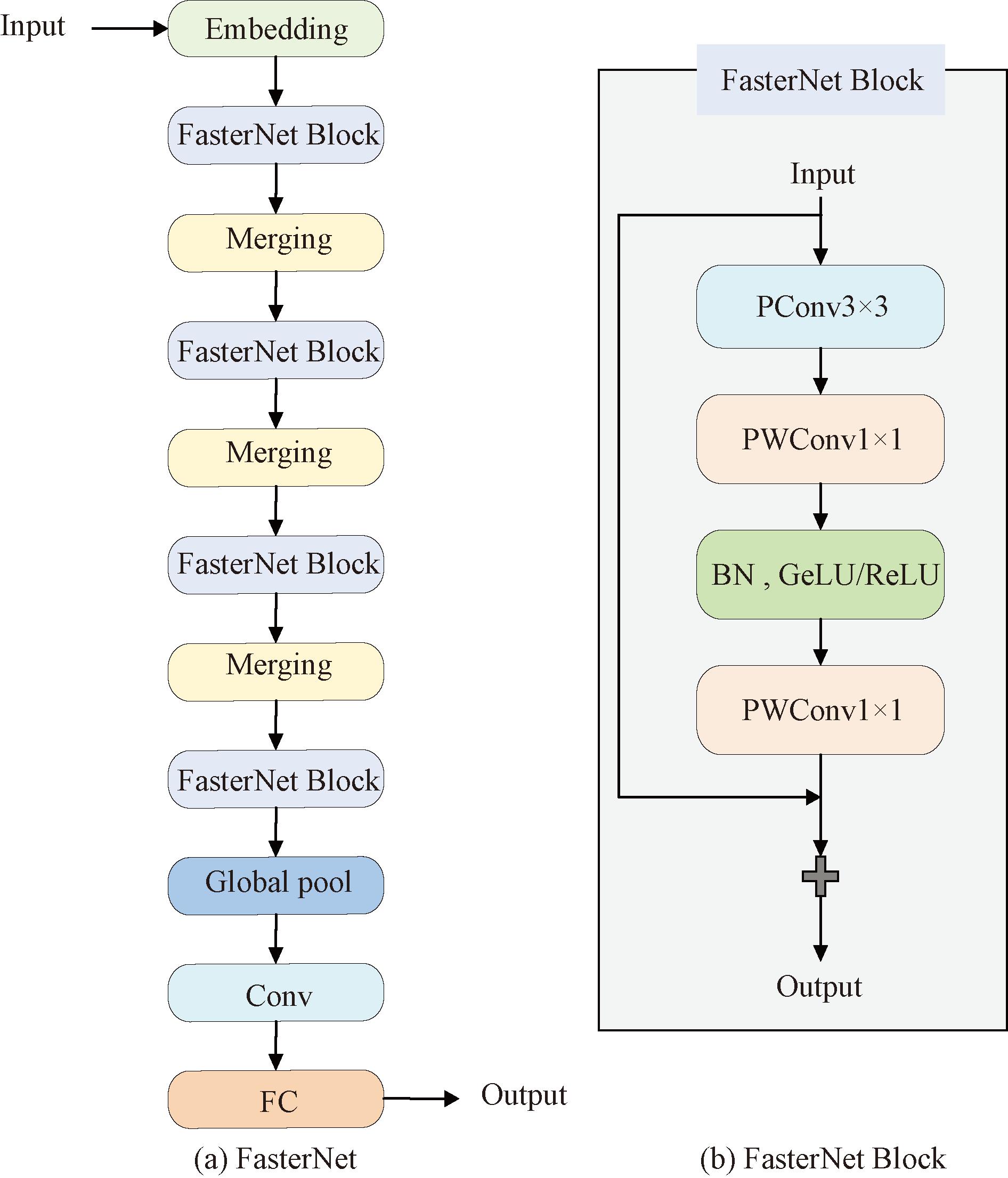

FasterNet[9]网络结构如图2(a)所示,运行速度快,并且可以提升检测系统性能。FasterNet网络分为4个模块,每个模块之前是一个卷积为4×4、步幅为4的嵌入层对图片的每一块处理,或是一个卷积为2×2、步幅为2的合并层将先前按块处理的图像以重叠的方式进行合并,这一合并过程实现了空间的下采样和增加了通道的数量。网络末端的3个层——全局平均池化层、1×1卷积层和全连接层则共同负责特征的转换与分类任务。

图2 FasterNet和FasterNet Block的网络结构

Figure 2 Network structure of FasterNet and FasterNet Block

FasterNet网络的核心组件是FasterNet Block,其结构如图2(b)所示,包括一个PConv[20]层和两个PWConv层,其中间层拥有扩展的通道数,并且加入了BN层和GeLU/ReLU层。卷积层的主要职责在于捕捉图像中的局部特征;批归一化层的作用是加快训练速度并提高网络的稳定性;激活层通过引入非线性元素,增强了网络的表现力,保持了特征的多样性。批归一化层和激活层可能会略微减缓整体计算速度,在激活层中,对于较小的变体FasterNet选择了GeLU,而对于较大的变体则使用了ReLU,这样的选择兼顾了运行效率和有效性。

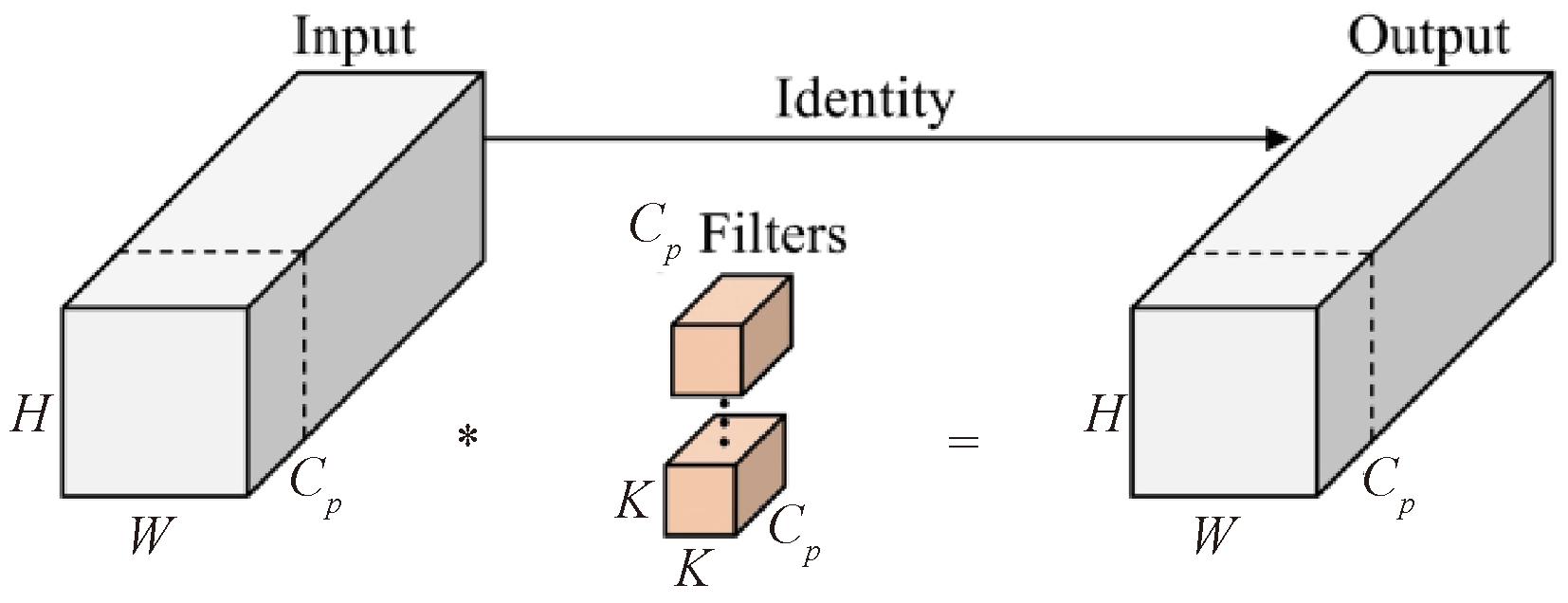

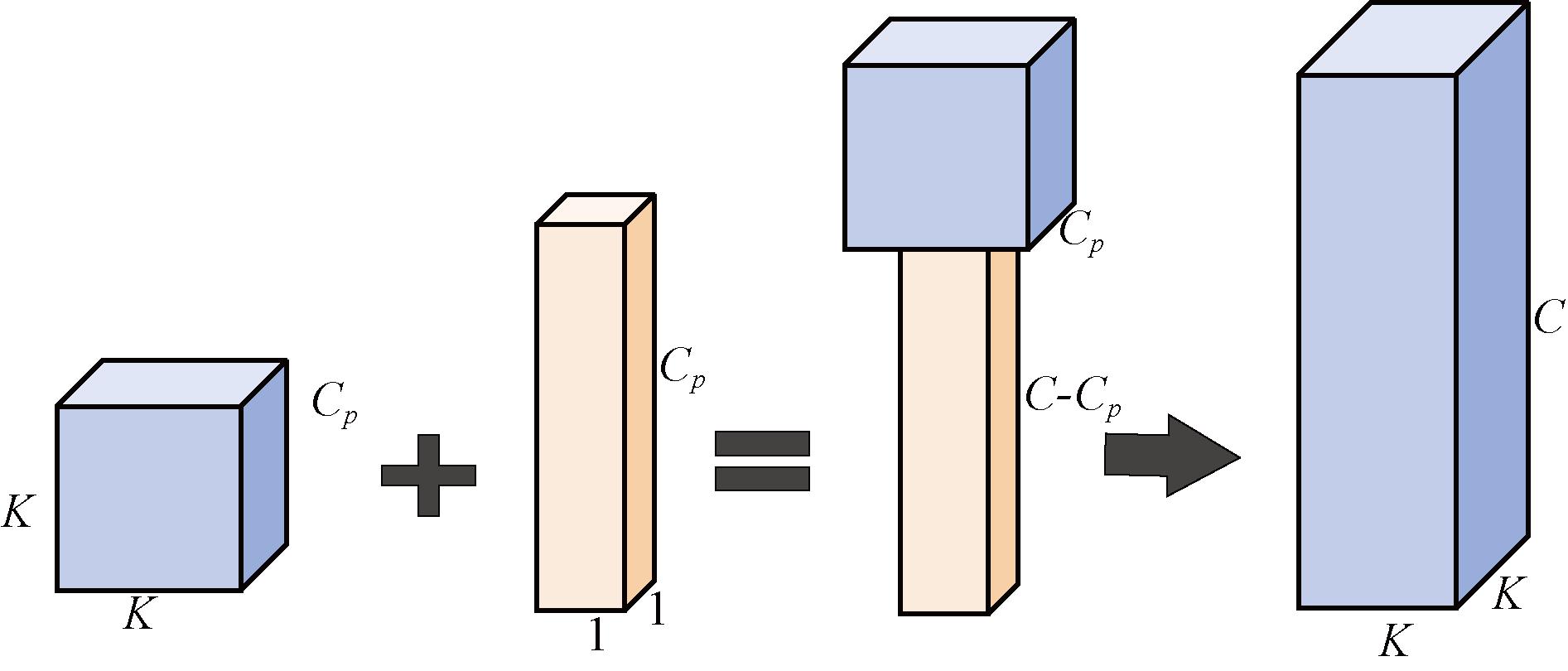

传统卷积通过对所有输入通道进行全面扩张,导致了内存访问次数的增加;而深度可分离卷积(DWConv)不对通道进行扩张,可能会导致精度下降。为了解决这些问题,可以采用部分卷积(PConv)。作为FasterNet的主要运算单元,PConv的结构如图3所示,它能够同时减少计算的冗余性和内存访问次数,仅对部分通道执行卷积操作,而其他通道则不进行处理。

图3 PConv示意图

Figure 3 Schematic diagram of PConv

PConv的计算量为![]() 对于r=Cp/C=1/4,常规卷积计算量是其16倍。对于内存访问量,PConv也有较大优势,其访问量为

对于r=Cp/C=1/4,常规卷积计算量是其16倍。对于内存访问量,PConv也有较大优势,其访问量为![]() 其中,H、W分别为通道的高和宽。

其中,H、W分别为通道的高和宽。

为了充分而高效地利用来自所有通道的信息,在PConv的后面添加一个PWConv,这两个结合起来在输入上的有效感受野看起来像一个T-shaped Conv,与普通卷积相比更关注于中心区域。通过计算Frobenius norm可以证明这种T型感受野进而评估每个位置的重要性。如果一个位置的Frobenius norm比其他位置都大,那么它往往更重要。一个普通卷积F∈RK2×C位置i处的Frobenius norm通过式(1)计算得到:

(1)

已知一个显著的位置是具有最大Frobenius norm的位置。图4是研究ResNet18中的每个卷积核,找到每个卷积核的显著位置,然后画出一个显著位置的直方图,得出中心位置作为最显著位置的频率是最高的。中心位置的权重比周围都要大,这与T形计算集中于中心处是一致的。

图4 T-shaped Conv示意图

Figure 4 Schematic diagram of T-shaped Conv

将YOLOv8中的骨干网络换为引入PConv的FasterNet网络,减少了算法的参数量和计算量,更有效地提取了遥感图像中小目标的空间特征,最终在保证遥感图像小目标检测精度的同时大幅度提升了检测速度。

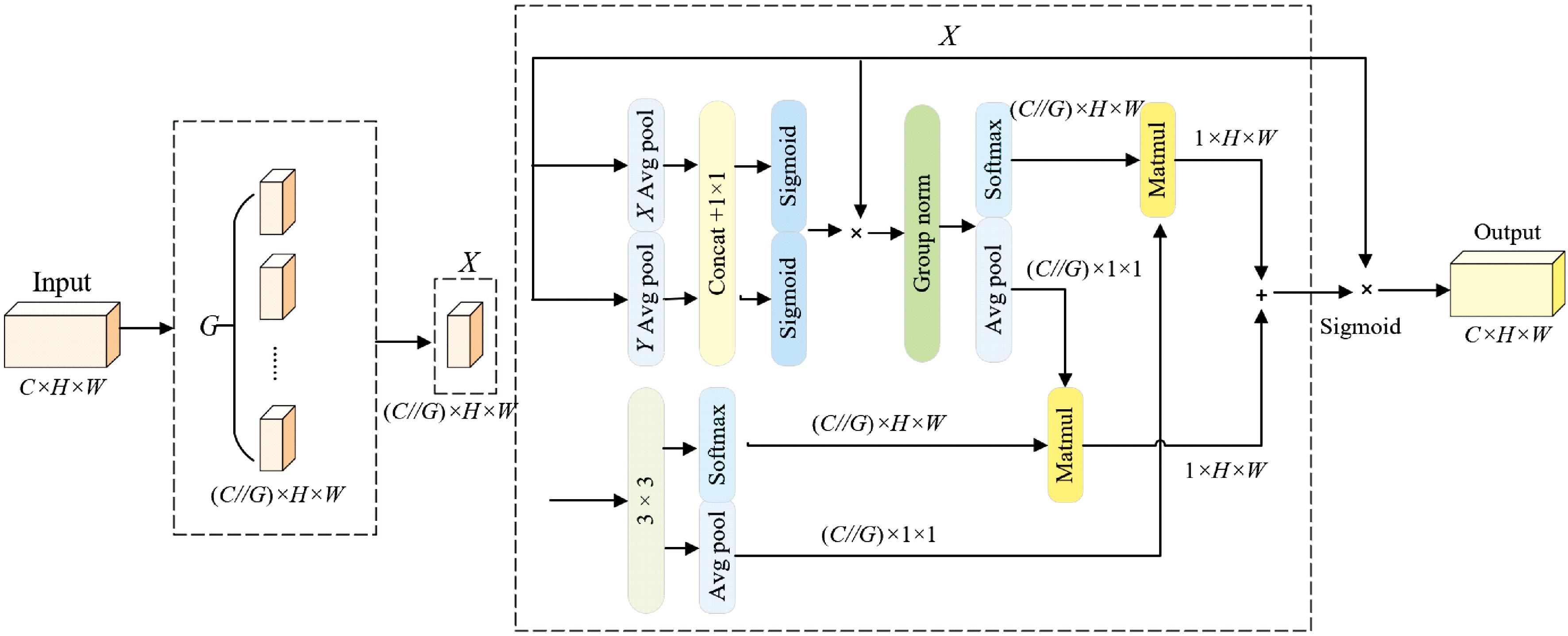

1.3 多尺度注意力机制模块

EMA[13]高效多尺度注意力机制结构如图5所示,其中,G代表分组;X Avgpool为在一维水平方向的全局平均池化;Y Avgpool为在一维垂直方向的全局平均池化。该机制将输入特征映射X∈RC×H×W,分割成G个独立的子集即X=[X0,Xi,…,XG-1],Xi∈R(C∥G)×H×W,通过使用3个并行子网结构来得到分组的特征图。在第一个1×1分支中,输入的张量被重塑成特定的形式(C∥G)×H×W,随后组内的两个通道注意力图通过乘法操作被合并,接着采用Avgpool(全局平均池化)对上层输入进行编码,得到第一个输出为![]() 最后通过2D全局池化和矩阵点积运算操作,将这些并行处理的结果结合起来形成第一个空间注意力图,其公式为

最后通过2D全局池化和矩阵点积运算操作,将这些并行处理的结果结合起来形成第一个空间注意力图,其公式为![]() 在第二个分支中,采用的是3×3的卷积进行捕捉,接着类比于第一个分支的方法进行编码,经过系列调整后得到第二个输出为

在第二个分支中,采用的是3×3的卷积进行捕捉,接着类比于第一个分支的方法进行编码,经过系列调整后得到第二个输出为![]() 进而得到了第二个分支的空间注意力图。然后,将每组内的输出特征映射与第一、第二个空间注意力图结合,并通过Sigmoid激活函数进行处理,以捕捉像素级别的配对关系并强调全局上下文信息,使得EMA的输出保持与输入相同的尺寸。

进而得到了第二个分支的空间注意力图。然后,将每组内的输出特征映射与第一、第二个空间注意力图结合,并通过Sigmoid激活函数进行处理,以捕捉像素级别的配对关系并强调全局上下文信息,使得EMA的输出保持与输入相同的尺寸。

图5 EMA网络结构

Figure 5 EMA network architecture

本文将EMA与C2f模块相结合,构成C2f_EMA模块,以提高模块提取小目标特征的能力。EMA在通道方向上对跨通道特征交互进行建模,可以捕获所有通道之间的依赖关系并减少计算量,提高特征融合的精确度。设计的C2f_EMA模块在小目标、模糊目标识别任务上具有更强大的应对能力,在YOLOv8中使用C2f_EMA模块使算法在融合特征前进行特征注意力加强操作,使网络模型更突出特征信息中小目标部分,有效解决特征融合过程中小目标特征丢失问题。

1.4 WIoU损失函数

WIoU[21]使用了一种非单调的聚焦机制,该机制通过生成动态的梯度增益因子来改进锚框的质量评估过程。这一方法采用离群度来替代交并比(IoU)作为评估锚框质量的标准,有助于缓解传统IoU损失函数中存在的问题,即该函数基于尺寸差异、长宽比等因素对低质量样本施加过大的惩罚,从而影响模型的泛化能力。通过这种方式,可以更有效地处理不同质量的样本,提高模型的整体性能。WIoU公式如下所示:

LWIoUv1=RWIoULIoU;

(2)

(3)

LIoU=1-IoU;

(4)

(5)

式中:(x,y)为锚框的中心点坐标;(xgt,ygt)为目标框的坐标;Wg和Hg为最小包围框的尺寸;*代表将Wg和Hg从计算图中分离;RWIoU用于放大普通质量锚框的LIoU,LIoU用于降低高质量锚框的RWIoU,借此可以根据需要增加或降低对中心点距离的关注度。

WIoUv3在WIoUv1的基础上引入了一个非单调聚焦系数r。这样,WIoUv3能够根据训练过程动态调整梯度增益。具体来说,对于那些与目标框匹配良好的锚框(即离群度较低的锚框),赋予较小的梯度增益,从而使边界框回归更加关注于一般质量的锚框;而对于匹配较差的锚框(即离群度较高的锚框),则赋予较大的梯度增益,以此来避免低质量锚框产生过大的负面影响。具体公式如下所示:

LWIoUv3=rLWIoUv1;

(6)

(7)

(8)

(9)

式中:α和δ均为超参数,设定为1.9和3.0,此时对于异常框抑制效果更加显著;β为离群度,可以表示锚框的质量,与锚框质量负相关;![]() 为梯度增益,可以根据每个检测目标的情况来动态计算和调整;

为梯度增益,可以根据每个检测目标的情况来动态计算和调整;![]() 为动量m的滑动平均值,可以动态调节最大的梯度增益;t为epoch值;n为batches值。

为动量m的滑动平均值,可以动态调节最大的梯度增益;t为epoch值;n为batches值。

采用带有动态非单调FM的WIoUv3作为边界框的损失函数,能够在训练过程中消除许多不利影响,可以根据实际情况来动态地调整梯度增益,从而提高模型边界框定位的准确性。

2 实验结果与分析

2.1 实验环境和参数设置

本文的实验环境配置环境如下:使用配备24 GB显存的NVIDIA GeForce RTX 4090 GPU,并运行在Ubuntu 20.04操作系统上。编程语言采用Python 3.8,CUDA版本为11.3。模型训练共迭代了100轮,初始学习率设定为0.01,批量大小为16,采用线性学习率衰减策略,优化算法采用随机梯度下降(SGD)。

2.2 实验数据集

一共选择了3个具有代表性的公开遥感图像的数据集进行实验,使得实验结果具有科学性和普遍性。3个数据集分别为NWPU VHR-10、HRSC2016和DOTA v1.0。

NWPU VHR-10数据集中有650幅图像包含目标,选择520幅图像作为训练集,130幅图像作为测试集。HRSC2016数据集包含1 070张图像和2 976个实例,使用旋转矩形框进行标注,专门用于舰船检测。DOTA v1.0数据集有2 806张航空遥感图像,将其分割成21 046张子图像,在其中选用15 749张图像作为训练集,5 297张作为测试集。

2.3 公共评价指标

本文实验结果使用目标检测常用的评估指标:准确率P、召回率R、参数量Parameters、计算量和平均精度均值mAP[22]。采用mAP50和mAP50-95表示不同IoU阈值下的平均精度均值。计算公式如下所示:

(10)

(11)

AP=![]() P(R)dR;

P(R)dR;

(12)

(13)

式中:TP为真正例,指的是实际存在并且被模型正确识别为目标类别的样本数量;FP为假正例,指的是实际上不属于某个类别但被模型错误地识别为目标类别的样本数量;FN为假反例,指的是实际存在某个类别但模型未能正确识别出来的样本数量;N为类别数;AP为平均精度;mAP为各个AP的加权平均值,mAP考虑了所有类别,是一个综合指标,能够全面反映模型在多个类别上的表现,可以有效评估模型性能。

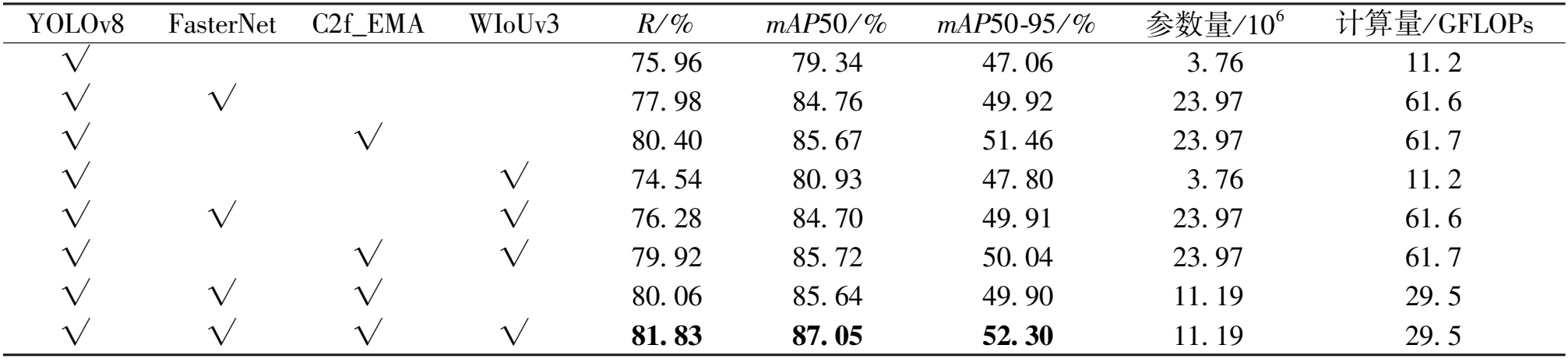

2.4 消融实验

为验证各个模块的性能,以YOLOv8原始模型为基准方法,采用NWPU VHR-10数据集设计一系列消融实验进行对比验证,使用R、mAP50、和mAP50-95为定量评价指标,实验结果如表1所示。由表1中数据可得,单独使用FasterNet网络替换原始骨干网络时,实验结果和基准方法相比,R提升了2.02百分点,mAP50和mAP50-95分别提升了5.42百分点和2.86百分点。完整模型与没有采用FasterNet网络相比,mAP50提升了1.32百分点。说明FasterNet网络可以有效解决遥感图像小目标检测精度不高的问题。

表1 消融实验

Table 1 Ablation experiment

Y O L O v 8 F a s t e r N e t C 2 f_ E M A W I o U v 3 R/ % mA P5 0 / % mA P5 0 - 9 5 / % 参 数 量 / 1 0 6 计 算 量 / G F L O P s √ 7 5 . 9 6 7 9 . 3 4 4 7 . 0 6 3 . 7 6 1 1 . 2 √ √ 7 7 . 9 8 8 4 . 7 6 4 9 . 9 2 2 3 . 9 7 6 1 . 6 √ √ 8 0 . 4 0 8 5 . 6 7 5 1 . 4 6 2 3 . 9 7 6 1 . 7 √ √ 7 4 . 5 4 8 0 . 9 3 4 7 . 8 0 3 . 7 6 1 1 . 2 √ √ √ 7 6 . 2 8 8 4 . 7 0 4 9 . 9 1 2 3 . 9 7 6 1 . 6 √ √ √ 7 9 . 9 2 8 5 . 7 2 5 0 . 0 4 2 3 . 9 7 6 1 . 7 √ √ √ 8 0 . 0 6 8 5 . 6 4 4 9 . 9 0 1 1 . 1 9 2 9 . 5 √ √ √ √ 8 1 . 8 3 8 7 . 0 5 5 2 . 3 0 1 1 . 1 9 2 9 . 5

单独使用C2f_EMA改进颈部结构时,实验结果与基准方法相比,R提升了4.44百分点,mAP50和mAP50-95分别提升了6.33百分点和4.40百分点。C2f_EMA模块结合FasterNet网络和WIoUv3损失函数相比没有采用C2f_EMA模块的模型,其mAP50和mAP50-95都有所上升。说明加入C2f_EMA模块可以优化系统对遥感图像小目标的检测性能。

采用WIoUv3作为回归损失函数时,相比基准方法其mAP50和mAP50-95分别提高了1.59百分点和0.74百分点;对于完整模型来说,改进损失函数mAP50和mAP50-95分别提高了1.41百分点和2.40百分点。由此可知,WIoUv3可以提高回归框精度,提高模型鲁棒性。

当更换为FasterNet骨干网络,引入C2f_EMA和WIoUv3时,其召回率、mAP50和mAP50-95分别比基准方法高出5.87百分点、7.71百分点和5.24百分点,对于小目标检测的性能较好,有效改善遥感图像中小目标检测精度较低的问题,所提出的FEW-YOLOv8网络检测效果良好。

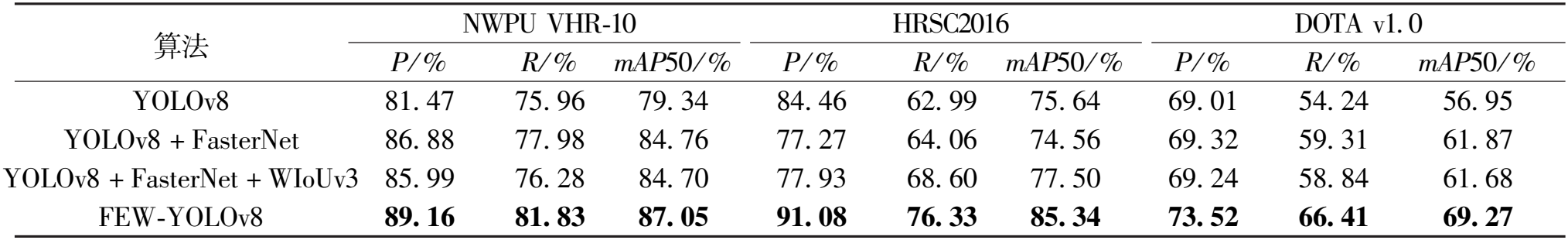

2.5 对比实验

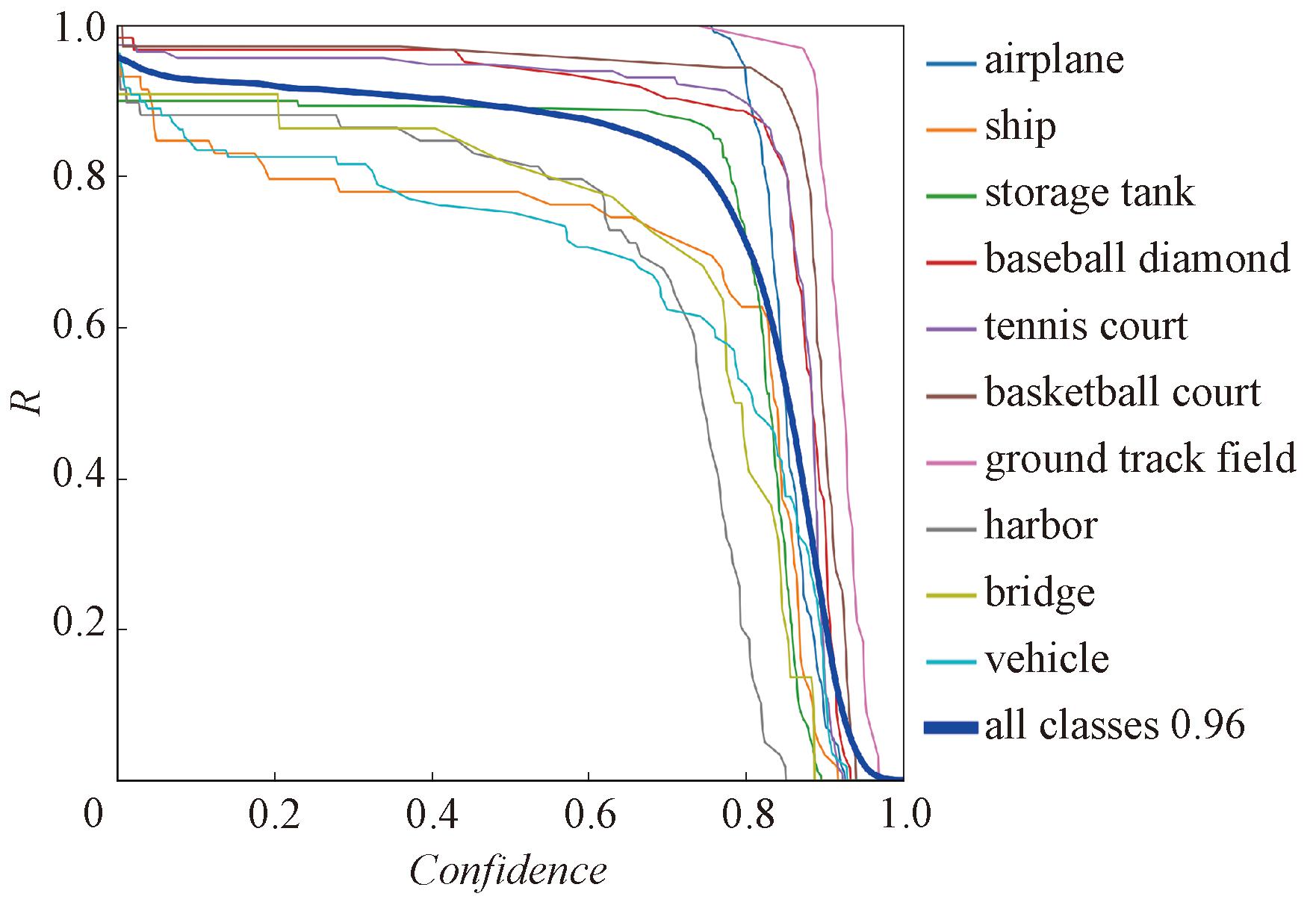

为了验证本文算法的有效性,在保证参数设置不变的情况下,分别对NWPU VHR-10、HRSC2016和DOTA v1.0数据集进行实验,实验结果如表2所示。可以看出,对于不同的改进算法,FEW-YOLOv8的检测效果在3个数据集上均比基准方法效果好,其中,mAP50在NWPU VHR-10、HRSC2016、DOTA v1.0数据集上分别提升了7.71百分点、9.7百分点和12.32百分点。所以FEW-YOLOv8对小目标的检测性能的提升有效且具有普遍性。其中,FEW-YOLOv8在NWPU VHR-10数据集上的召回率曲线如图6所示。

表2 不同算法在NWPU VHR-10、HRSC2016和DOTA v 1.0数据集上的性能比较

Table 2 Performance comparison of different algorithms with NWPU VHR-10,HRSC2016 and DOTA v1.0 datasets

算法 NWPU VHR-10 HRSC2016 DOTA v1. 0 P/ % R/ % mAP50 / % P/ % R/ % mAP50 / % P/ % R/ % mAP50 / % YOLOv8 81. 47 75. 96 79. 34 84. 46 62. 99 75. 64 69. 01 54. 24 56. 95 YOLOv8 + FasterNet 86. 88 77. 98 84. 76 77. 27 64. 06 74. 56 69. 32 59. 31 61. 87 YOLOv8 + FasterNet + WIoUv3 85. 99 76. 28 84. 70 77. 93 68. 60 77. 50 69. 24 58. 84 61. 68 FEW-YOLOv8 89. 16 81. 83 87. 05 91. 08 76. 33 85. 34 73. 52 66. 41 69. 27

图6 NWPU VHR-10数据集中每个类别的召回率曲线

Figure 6 Recall curves for each category in the NWPU VHR-10 dataset

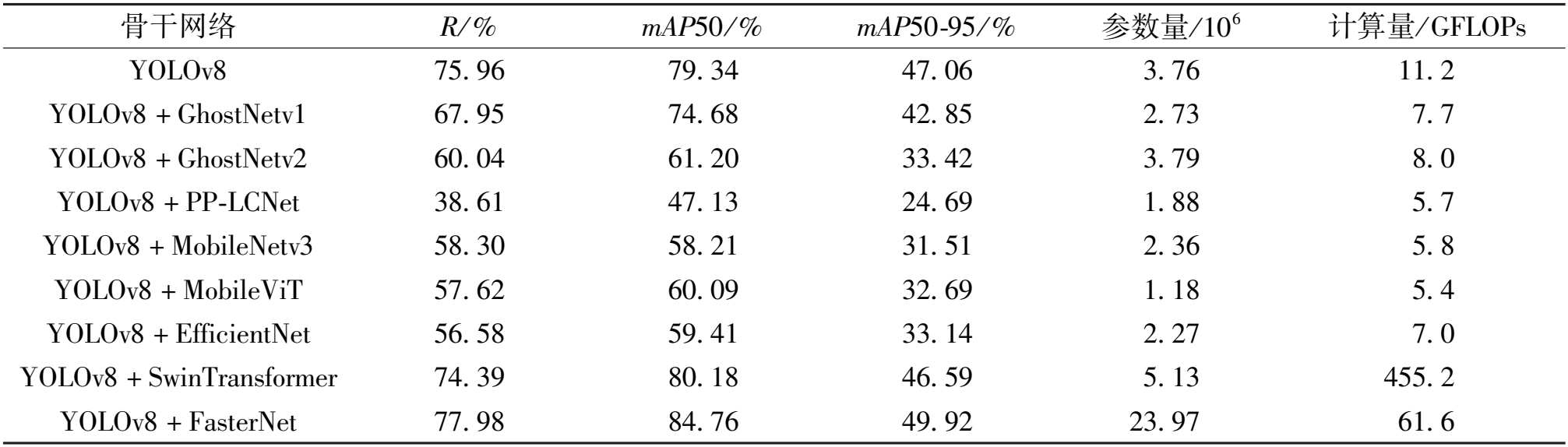

如表3所示,在各骨干网络改进的实验中,GhostNetv1和GhostNetv2[23]使用更少的参数生产更多的特征图,以此替换骨干网络的改进效果并不理想,虽模型参数量有所减少,但检测精度均有较大幅度降低。由PP-LCNet[24]、MoblieNetv3[25]、MobileViT[26]、EfficientNet[27]、SwinTransformer替换骨干网络的改进,检测精确度和召回率均有不同幅度的下降,检测性能相比基准方法并未提升。而由FasterNet网络替换骨干网络的改进表现优秀,更有效地提取了遥感图像中小目标的空间特征,从而提升小目标检测精度。

表3 各骨干网络改进与FasterNet的对比

Table 3 Comparison between the improvement of each backbone network and FasterNet

骨干网络 R/ % mAP50 / % mAP50-95 / % 参数量/ 10 6 计算量/ GFLOPs YOLOv8 75. 96 79. 34 47. 06 3. 76 11. 2 YOLOv8 + GhostNetv1 67. 95 74. 68 42. 85 2. 73 7. 7 YOLOv8 + GhostNetv2 60. 04 61. 20 33. 42 3. 79 8. 0 YOLOv8 + PP-LCNet 38. 61 47. 13 24. 69 1. 88 5. 7 YOLOv8 + MobileNetv3 58. 30 58. 21 31. 51 2. 36 5. 8 YOLOv8 + MobileViT 57. 62 60. 09 32. 69 1. 18 5. 4 YOLOv8 + EfficientNet 56. 58 59. 41 33. 14 2. 27 7. 0 YOLOv8 + SwinTransformer 74. 39 80. 18 46. 59 5. 13 455. 2 YOLOv8 + FasterNet 77. 98 84. 76 49. 92 23. 97 61. 6

2.6 实验结果

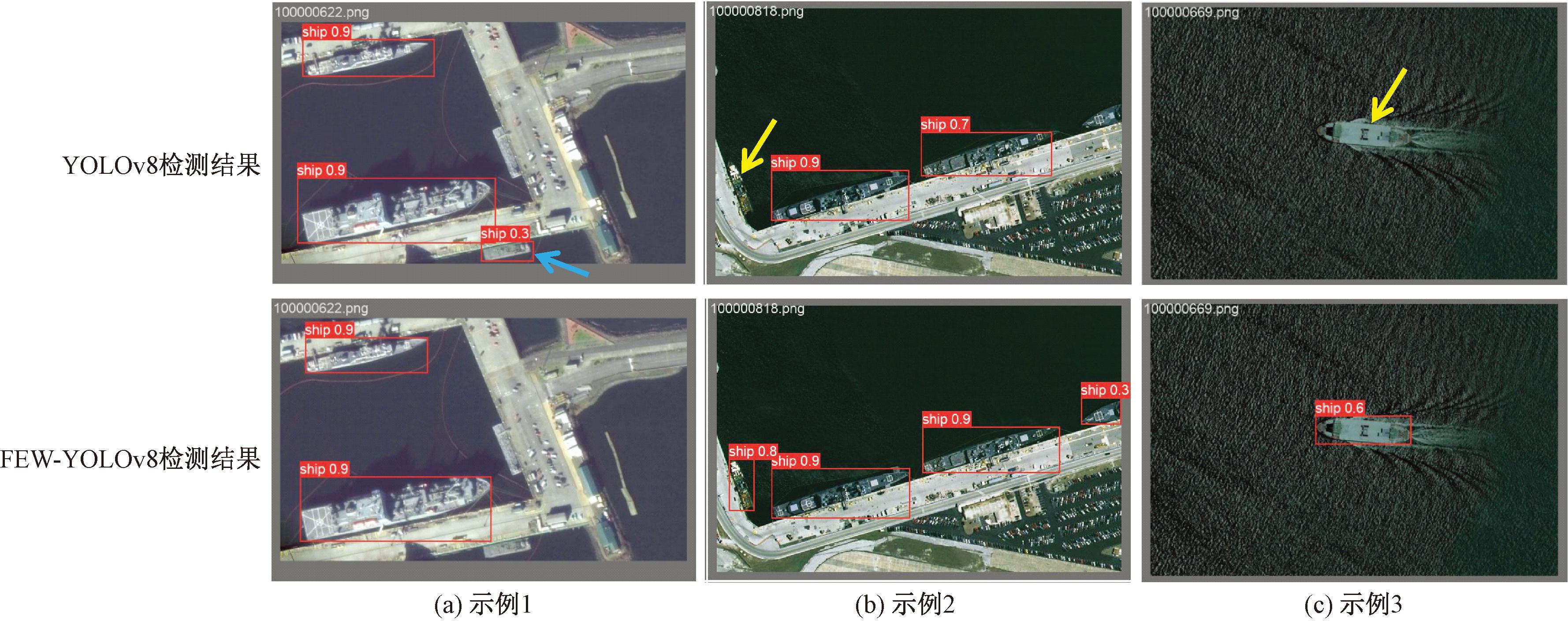

为了直观地显示本文算法的检测性能,选取HRSC2016数据集中小目标数量多且特征不明显的港口的部分图像进行可视化实验,如图7所示,对于同一组图像,将原始YOLOv8检测结果和FEW-YOLOv8的检测结果进行了直观对照。其中,蓝色箭头所标出的是原YOLOv8误检部分,黄色箭头标出的是原YOLOv8漏检部分,通过图7中可以明显观察到FEW-YOLOv8能有效纠正这些错误,提高检测精度。由此可见,本文提出的FEW-YOLOv8算法能有效地提升遥感图像小目标的检测性能。

图7 YOLOv8与FEW-YOLOv8在HRSC2016数据集中部分目标检测结果对比

Figure 7 Comparison of partial detection results of YOLOv8 and FEW-YOLOv8 in the HRSC2016 dataset

3 结论

本文提出了基于YOLOv8的FEW-YOLOv8算法,可以有效提高遥感图像目标检测性能。首先,优化骨干网络架构,使用FasterNet骨干网络,能更有效地提取了遥感图像中小目标的空间特征,使得网络模型更专注于微小目标,从而提升小目标检测精度。其次,使用EMA注意力与C2f构建全新的C2f_EMA模块,替换Neck结构中的C2f模块,在融合特征前进行特征注意力加强操作,使网络模型更突出特征信息中小目标部分,可有效解决特征融合过程中小目标特征丢失问题。最后,采用具有动态非单调FM的WIoUv3作为边界框损失函数,提高模型的边界框定位准确度,强化对小目标的定位能力。通过实验结果表明,3个模块的改进对遥感图像小目标检测的改进都是有效的,且将3个改进模块组合在一起检测效果较好;与YOLOv8等其他具有代表性的改进算法进行比较,FEW-YOLOv8算法在检测精度和检测速度两方面可以兼顾,对于遥感图像小目标精度有较高的提升。

[1] REDMON J, DIVVALA S, GIRSHICK R, et al. You only look once: unified, real-time object detection[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway: IEEE, 2016: 779-788.

[2] LIU W, ANGUELOV D, ERHAN D, et al. SSD: single shot multibox detector[C]∥ European Conference on Computer Vision. Cham: Springer, 2016: 21-37.

[3] GAO F, CAI C X, JIA R H, et al. Improved YOLOX for pedestrian detection in crowded scenes[J]. Journal of Real-Time Image Processing, 2023, 20(2): 1-13.

[4] XU D Q, WU Y Q. FE-YOLO: a feature enhancement network for remote sensing target detection[J]. Remote Sensing, 2021, 13(7): 1311.

[5] CHEN L Q, SHI W X, DENG D X. Improved YOLOv3 based on attention mechanism for fast and accurate ship detection in optical remote sensing images[J]. Remote Sensing, 2021, 13(4): 660.

[6] XU D Q, WU Y Q. Improved YOLO-V3 with DenseNet for multi-scale remote sensing target detection[J]. Sensors, 2020, 20(15): 4276.

[7] POUDEL R P K, BONDE U, LIWICKI S, et al. ContextNet: exploring context and detail for semantic segmentation in real-time[EB/OL]. (2018-11-05)[2024-10-12]. http:∥arxiv.org/abs/1805.04554.

[8] CHEN J T, LEI B W, SONG Q Y, et al. A hierarchical graph network for 3D object detection on point clouds[C]∥2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2020: 389-398.

[9] CHEN J R, KAO S H, HE H, et al. Run, don′t walk: chasing higher FLOPS for faster neural networks[C]∥2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2023: 12021-12031.

[10] ZHOU T, HUANG B, LI R R, et al. An attention-based deep learning model for citywide traffic flow forecasting[J]. International Journal of Digital Earth, 2022, 15(1): 323-344.

[11] GAO R X, WANG T F. Motion deblurring algorithm for wind power inspection images based on Ghostnet and SE attention mechanism[J]. IET Image Processing, 2023, 17(1): 291-300

[12] LI G B, SHI G L, JIAO J. YOLOv5-KCB: a new method for individual pig detection using optimized K-means, CA attention mechanism and a bi-directional feature pyramid network[J]. Sensors, 2023, 23(11): 5242.

[13] OUYANG D L, HE S, ZHANG G Z, et al. Efficient multi-scale attention module with cross-spatial learning[C]∥ 2023 IEEE International Conference on Acoustics, Speech and Signal Processing. Piscataway: IEEE, 2023: 1-5.

[14] YUAN Z, FANG W, ZHAO Y M, et al. Research of insect recognition based on improved YOLOv5[J]. Journal on Artificial Intelligence, 2021, 3(4): 145-152.

[15] WANG C Y, BOCHKOVSKIY A, LIAO H Y M. YOLOv7: trainable bag-of-freebies sets new state-of-the-art for real-time object detectors[C]∥2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2023: 7464-7475.

[16] YIN L L. Analysis recognition of ghost pepper and cili-padi using mask RCNN and YOLO[J]. Przegl![]() d Elektrotechniczny, 2023, 1(8): 94-99.

d Elektrotechniczny, 2023, 1(8): 94-99.

[17] LIU S, QI L, QIN H F, et al. Path aggregation network for instance segmentation[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2018: 8759-8768.

[18] ZHENG Z H, WANG P, LIU W, et al. Distance-IoU loss: faster and better learning for bounding box regression[J]. Proceedings of the AAAI Conference on Artificial Intelligence, 2020, 34(7): 12993-13000.

[19] WANG P J, BAYRAM B, SERTEL E. A comprehensive review on deep learning based remote sensing image super-resolution methods[J]. Earth Science Reviews, 2022, 232: 104110.

[20] PENG X C, CHEN Y Z, CAI X W, et al. An improved YOLOv7-based model for real-time meter reading with PConv and attention mechanisms[J]. Sensors, 2024, 24(11): 3549.

[21] TONG Z J, CHEN Y H, XU Z W, et al. Wise-IoU: bounding box regression loss with dynamic focusing mechanism[EB/OL]. (2023-04-08)[2024-10-12].https:∥arxiv.org/abs/2301.10051.

[22] 贾云飞, 郑红木, 刘闪亮. 基于YOLOv5s的金属制品表面缺陷的轻量化算法研究[J]. 郑州大学学报(工学版), 2022, 43(5): 31-38.

JIA Y F, ZHENG H M, LIU S L. Lightweight surface defect detection method of metal products based on YOLOv5s[J]. Journal of Zhengzhou University (Engineering Science), 2022, 43(5): 31-38.

[23] 刘庆华, 杨欣仪, 接浩, 等. 基于融合GhostNetV2的YOLO v7水稻籽粒检测[J]. 农业机械学报, 2023, 54(12): 253-260, 299.

LIU Q H, YANG X Y, JIE H, et al. Rice grain detection based on YOLO v7 fusing of GhostNetV2[J]. Transactions of the Chinese Society for Agricultural Machinery, 2023, 54(12): 253-260, 299.

[24] 胡瑛,刘狄昆,刘拯,等.基于改进YOLOv5的复杂场景下交通标志识别方法[J].湖南工程学院学报(自然科学版), 2024,34(2):31-38.

HU Y, LIU D K, LIU Z, et al. Traffic sign recognition method in complex scenes based on improved YOLOv5[J]. Journal of Hunan Institute of Engineering (Natural Science Edition), 2024,34(2):31-38.

[25] 刘磊. YOLOv4交通信号灯检测[J]. 电子世界, 2021(15): 92-94.

LIU L. YOLOv4 traffic light detection[J]. Electronics World, 2021(15): 92-94.

[26] 邓翔宇, 裴浩媛, 盛迎. 基于网络融合的改进MobileViT人脸表情识别[J]. 计算机工程与科学, 2024, 46(6): 1072-1080.

DENG X Y, PEI H Y, SHENG Y. Facial expression recognition based on network fusion to improve MobileViT[J]. Computer Engineering &Science, 2024, 46(6): 1072-1080.

[27] 胡施威, 邓建新, 王浩宇, 等. 基于改进EfficientNetB0模型的葡萄叶部病害识别方法[J]. 现代电子技术, 2024, 47(15): 73-80.

HU S W, DENG J X, WANG H Y, et al. Grape leaf disease identification method based on improved EfficientNetB0 model[J]. Modern Electronics Technique, 2024, 47(15): 73-80.