随着机器学习[1]的兴起,基于卷积神经网络的遥感图像检索方法[2]被提出。由于标签制作费时费力,研究者们提出无监督遥感图像检索[3],但这又引发了另一个问题:标签的缺失会导致从训练数据中随机抽取的样本存在负样本与正样本相似的情况[4]。Chuang等[5]将这种现象称为抽样偏差,并且用实验证明抽样偏差会影响检索模型的最终性能。

另一方面,传统遥感图像检索直接将特征映射到高维欧氏空间,导致图像特征变成上千维的实值向量,这不仅增加了存储成本,还降低了检索速度。

针对这个问题,本文提出一种基于交叉量化和样本校正的自监督遥感图像检索模型(简称CQSC)。首先,使用乘积量化替换对比学习中的映射层,从而产生比哈希更丰富的距离表示,有效降低量化误差对模型性能的影响,在保证模型的准确性和鲁棒性的同时提升检索速度。其次,引入交叉学习策略,最大化对比学习中映射层前后图像描述符之间的交叉相似性,使模型提取的图像特征更具有判别力,帮助CQSC进一步提高检索精度。最后,通过计算正样本与负样本之间的矢量距离,使用自适应纠错标签标注出训练样本中的错误负样本,避免模型将正样本误认为负样本,以此来提高模型的检索精度。

1 相关工作

1.1 深度哈希图像检索

近似最近邻(approximate nearest neighbor, ANN)搜索[6]以低存储成本和快速搜索等优势在遥感图像检索研究中备受关注。ANN研究包含两种主流方法:哈希(Hashing)[7]和矢量量化(vector quantization, VQ)[8]。二者虽然都是将高维图像数据转换为紧凑的二进制代码,但是哈希只是使用汉明距离[9]计算二进制代码之间的距离,无法表示复杂的距离关系。乘积量化(product quantization, PQ)可以快速准确地提供检索结果。Liang等[10]提出了一种基于PQ的深度哈希框架,利用基于Softmax的可微分PQ分支来吸收与该类相关的预先建立的PQ代码,不需要复杂的矩阵操作,就能够熟练地培养高度独特和紧凑的哈希码。

1.2 自监督遥感图像检索

在自监督遥感图像检索[11]中,计算机使用遥感图像数据自动学习特征表示。与传统的监督学习方法相比,自监督遥感图像检索不需要标注数据,可以从未标注数据中学习特征表示,因此具有更强的泛化能力和更高的效率。对比学习[12]是一种广泛应用于自监督学习中的方法,但是由于抽样偏差的存在,导致训练使用的负样本与目标样本相似,从而导致检索精度降低。Chuang等[5]提出一种近似理论无偏的对比损失,并没有直接针对抽样偏差问题提出解决方案。NNCLR[13]对数据特征进行排序来缓解抽样偏差引起的性能下降,但是依赖于预定义的样本数量。

2 基于交叉量化和样本校正的自监督遥感图像检索

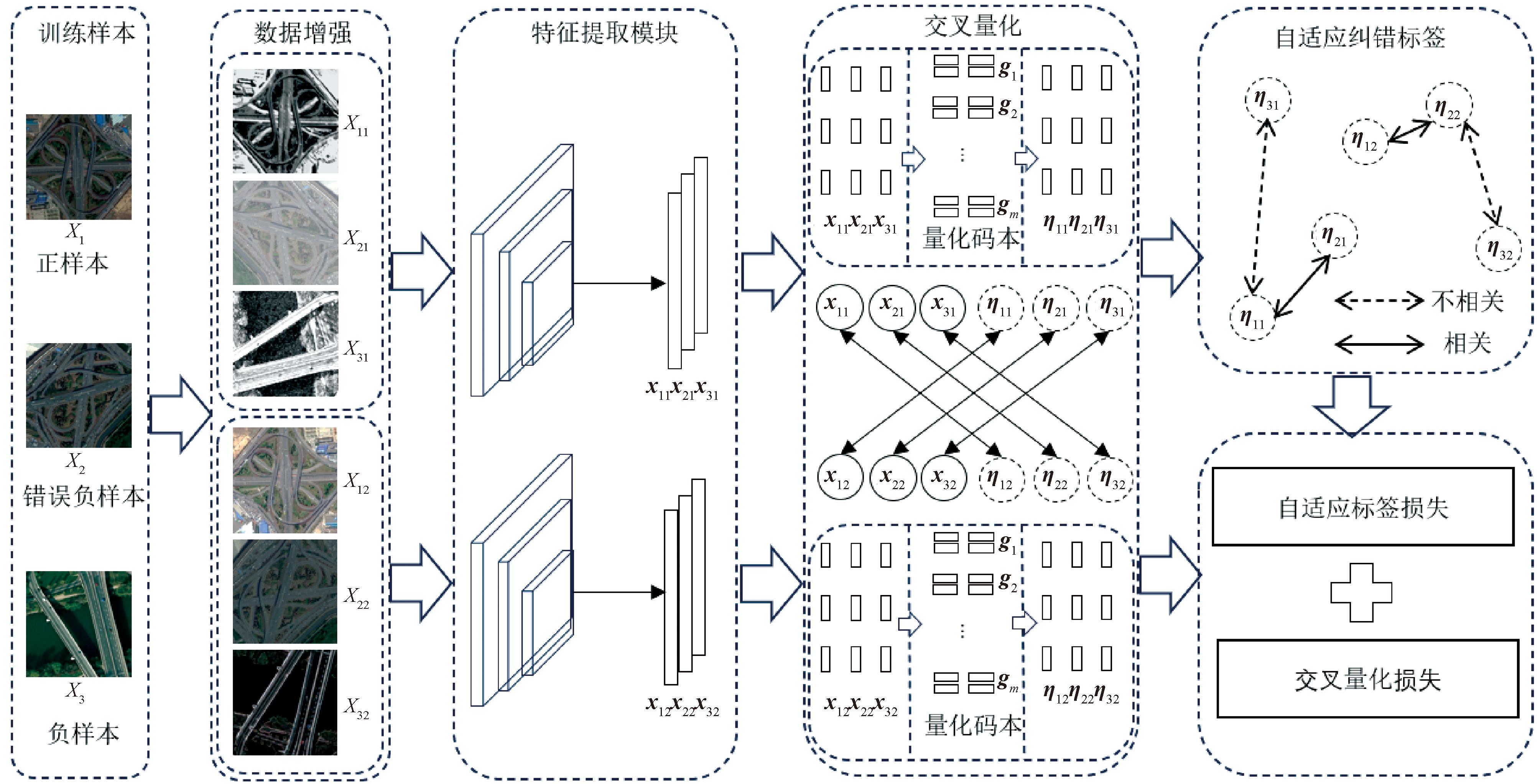

如图1所示,遥感图像经过数据增强可以得到不同的增强版本,所用特征增强包含随机裁剪、随机旋转、高斯模糊等。通过将特征增强后的样本映射进同一纬度得到其特征向量。遥感图像Xi在经过随机数据增强之后,得到图像Xi的不同增强版本{Xi1,Xi2},使用ResNet50将特征增强后的样本{Xi1,Xi2}映射到同一纬度,从而得到遥感图像的特征向量{xi1,xi2},xi1∈RD,xi2∈RD,D为特征向量的原始维度。

图1 基于交叉量化和样本校正的自监督遥感图像检索框架

Figure 1 Self-supervised remote sensing image retrieval framework based on cross-quantization and sample correction

关于遥感图像检索的量化,乘积量化通过笛卡尔积运算将码字规范成一个码本,将特征向量xi1分成m个独立的子特征向量,即xi1={xi11,xi12,…,xi1m},xi1m∈RD/m。量化头G由m个独立的子量化器gi组成,G={g1,g2,…,gm}。gi又由K个不同的码字组成,gi={gi1,gi2,…,giK},giK∈RD/m。通过量化头G分别对这m个子特征向量进行量化索引。将遥感图像特征向量xi1分割后的m个子特征向量,在对应的子量化器中找到最接近的码字并替换,将替换的码字拼接成一个新的向量,得到特征向量xi1自身的量化描述符ηi1。对于增强样本Xi2进行同样的处理可以得到其量化描述符ηi2。

通过计算不同样本量化描述符之间的距离,将距离转化成相似概率,加权得到最终的概率分布。通过样本特征空间的相对分布赋予样本纠错标签,标注训练样本中的错误负样本。

交叉量化通过压缩图像数据提供高效的特征表示,自适应纠错标签通过概率分布调整优化模型处理错误负样本的能力。二者结合显著提高了自监督遥感图像检索的性能,实现了检索效率和准确度的双重提升。

2.1 基于交叉量化的遥感图检索

基于交叉量化的自监督遥感图像检索任务的主要算法过程如下。

首先,计算子特征向量与对应的子量化器中码字之间的距离,例如特征向量xi1的第n个子特征向量xi1n与第n个子量化器中码字的距离为

(1)

式中:gnk为子量化器gn中的第k个码字;![]() 为L2范数。

为L2范数。

通过计算每个切分后的xi1n和gnk之间的欧氏距离,使用Softmax函数将距离转换为相应的概率值,如式(2)所示:

ηi1n=argmax(dnk,gn)。

(2)

式中:ηi1n为属于第n个子量化器gn中最接近子特征向量xi1n的码字。

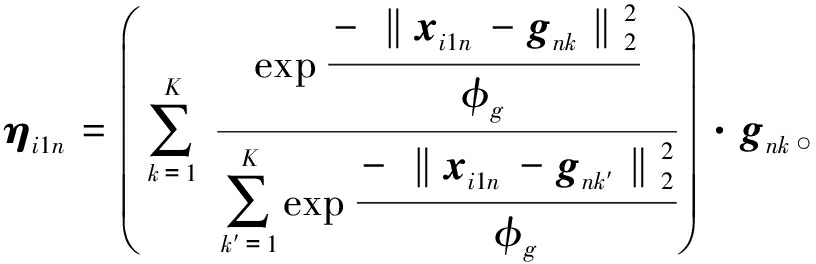

其次,将ηi1n看作子量化器gn中码字的指数加权和,将子量化器中的码字近似量化输出,最接近子特征向量的码字将会被输出作为子特征向量的量化表示,如式(3)所示:

(3)

式中:φg为非负温度参数,设置为![]() 为计算每个切分后的子特征向量xi1n和子量化器的码字gnk之间的余弦距离。

为计算每个切分后的子特征向量xi1n和子量化器的码字gnk之间的余弦距离。

最后,将得到的码字拼接在一起,就是特征向量xi1乘积量化后的量化描述符ηi1。

何悦等[14]提出一种基于深度多相似性哈希(DMSH)的遥感图像检索方法,通过挖掘图像间的多种相似信息生成哈希码。吴刚等[15]提出一种基于级联池化自注意力模块的遥感影像检索方法,采用监督核哈希生成哈希码。相较于这些基于传统哈希的遥感图像检索,本文提出的交叉量化降低量化阶段的信息损失,减少距离计算的时间复杂度,更好地保留原始数据的结构和相似性。

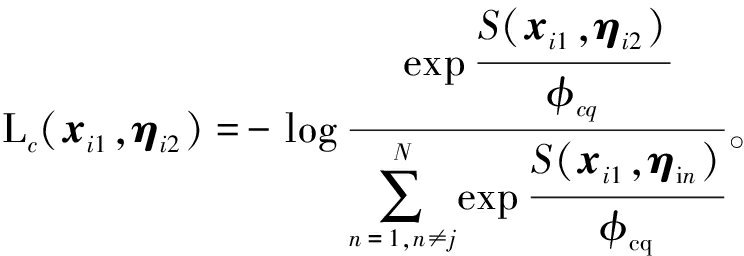

为了更好地学习特征向量和码字,增加码字的泛化能力,引入交叉学习策略。对于同一幅遥感图像来说,使用不同的随机增强得到的特征向量和量化描述符之间是相关联的,与批量样本内的其他图像是不相关的。基于这一思想,设计了一个交叉量化对比损失函数来学习相关的实例对,如式(4)所示:

(4)

(5)

式中:S表示余弦相似性;φcq为交叉量化损失函数的非负温度参数。

交叉量化利用不同随机增强的遥感图像特征,通过乘积量化促进特征准确量化,增强了模型对遥感图像中复杂地物和场景的区分能力,优化了检索结果的相关性和准确性。

2.2 自适应纠错标签

如上所述,对比学习在训练过程中会主观地认定每个样本都是一个独立的个体,互相没有关联,同一批次中只有一个正样本,其余全是负样本,从而导致抽样偏差。针对这一问题,设计一个纠错标签。具体步骤如下。

步骤1 对于遥感图像的特征向量xi1,计算特征向量xi1的量化描述符ηi1与批量样本{x11,x21,…,xN1}的量化描述符{η11,η21,…,ηN1}之间的余弦相似度Sij:

(6)

式中:ηi1和ηj1为遥感图像的量化描述符;![]() 为L2范数;ηi1T为ηi1的转置。

为L2范数;ηi1T为ηi1的转置。

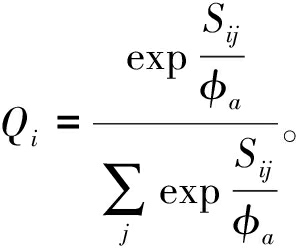

步骤2 通过余弦相似度Sij来构建批量样本的相似分布Qi,如式(7)所示:

(7)

式中:φa为控制样本相似分布的参数。

步骤3 将置信度定义为相对分布Qi的归一化熵E,如式(8)所示:

(8)

式中:H(Qi)用于计算相对分布Qi的香农熵;N为样本数量。

步骤4 使用相对分布Qi本身作为样本的纠错标签,并使用相对分布Qi的归一化熵E对自适应纠错标签进行加权,纠错标签y定义为

(9)

最终批量样本的纠错标签损失La为

(10)

Chuang等[5]提出一种近似理论无偏的对比损失,并没有直接针对抽样偏差问题提出解决方案。NNCLR[13]对数据特征使用排序来缓解抽样偏差引起的性能下降,但是依赖于预定义的样本数量。这些方法并不适用于所有的遥感图像类型和场景,本文通过引入纠错标签,不需要引入预定义数据,针对抽样偏差问题提供了解决方案,通过动态调整标签来减少这种错误,从而提高检索的准确性。

2.3 多损失函数学习

在训练学习阶段,本文采用基于交叉量化的对比损失函数和自适应纠错标签损失来共同更新模型参数。基于交叉量化的损失函数学习遥感图像的深度特征和码字来区分图像内容,保证遥感图像的深度特征可以保留在量化编码中,如式(4)所示。

自适应纠错标签损失函数用来标注训练过程中的错误负样本,降低抽样偏差导致的精度下降,如式(10)所示。

用于模型训练的总损失函数为

L=Lcq+λLa。

(11)

式中:λ为用来平衡Lcq和La的超参数。

3 实验部分

3.1 数据集

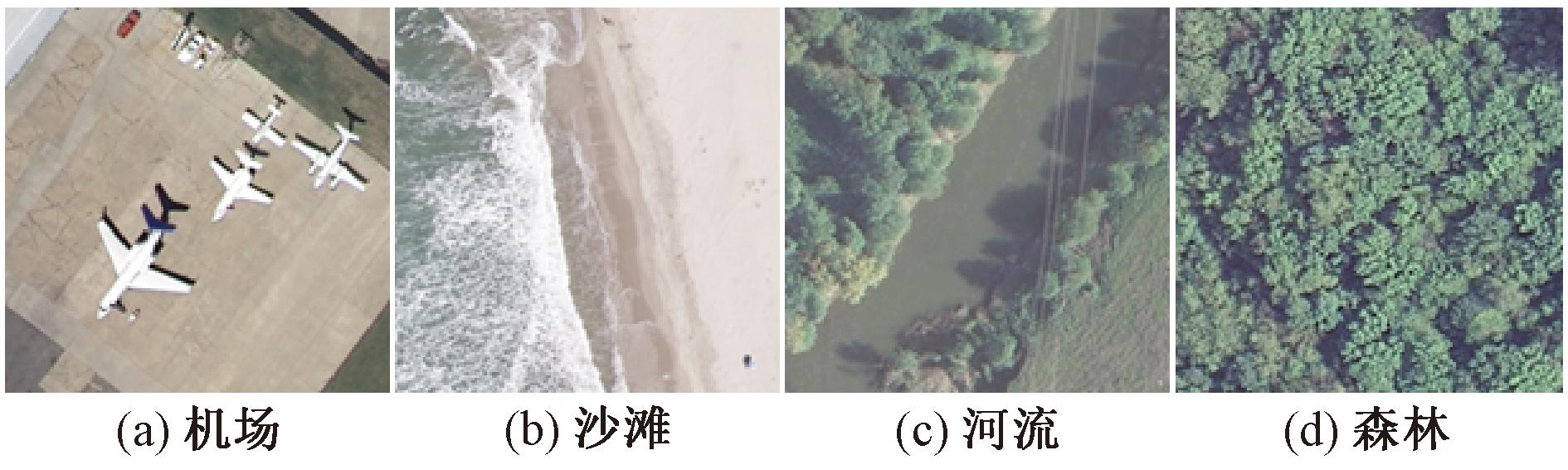

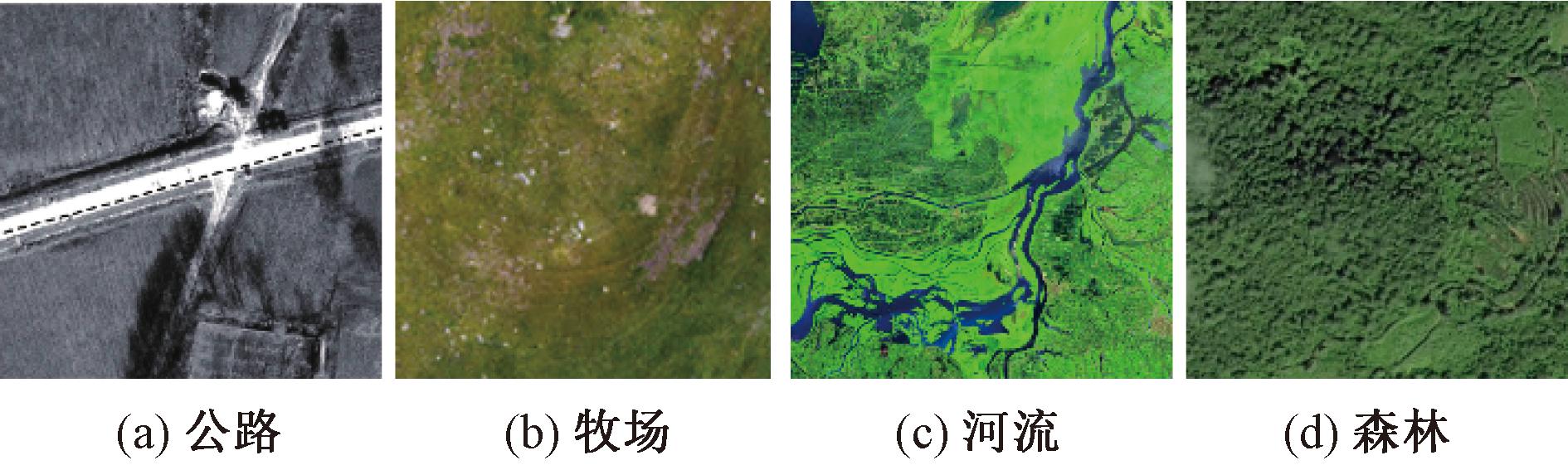

本文在UCMerced和EuroSAT数据集上进行实验,数据集包含多种不同的遥感图像,具有不同的场景和地物类型。UCMerced包含21种不同的地物类型,每个类别共有100张图像,每张图像的大小为256×256像素,如图2所示。EuroSAT包含10种不同的地物类型,每个类别有2 000~3 000张图像,每张图像大小为64×64像素,如图3所示。

图2 UCMerced示例图像

Figure 2 Example images of UCMerced

图3 EuroSAT示例图像

Figure 3 Example images of EuroSAT

3.2 实验设置与评价指标

本文使用标准的ResNet50作为骨干网络,实验所用GPU为TeslaP40,PyTorch版本号为1.8.1。

对于网络训练,使用Adam优化器,学习率为0.000 3,使用余弦衰减策略调整学习速率,在UCMerced上设置batch size为64,在EuroSAT上设置batch size为256。子量化器的数量m={4,8,12,16},将子量化器中码字的数量固定为K=24。遥感图像特征经过乘积量化后的量化维度D=mlog2 K。通过调整码本数量m来获得{16,32,48,64}位二进制代码。模型中的超参数φg=5.0,λ=1,φa=0.5,φcq=0.5。

本文使用mAP评估检索性能。mAP表示对于给定的查询q,计算其平均精度AP,最后计算所有查询图像的AP的平均值得到mAP。平均精度AP为

(12)

式中:N′为返回的图像数量;R表示相关图像的数量;P(r)表示返回图像的精确度;yr表示第r个返回的图像是否与图像相关。

3.3 对比实验

在EuroSAT和UCMerced数据集上将CQSC与多种先进的方法进行比较。其中,有3种专门为遥感图像检索设计的无监督哈希方法,包括基于内核的无监督哈希(KULSH)[16]、概率潜在语义哈希(PLSH)[17]和部分随机哈希(PRH)[18];还有3种在计算机视觉中广泛使用的自然图像哈希方法,即局部敏感哈希(LSH)[19]、迭代量化(ITQ)[20]和双瓶颈哈希(TBH)[21]。

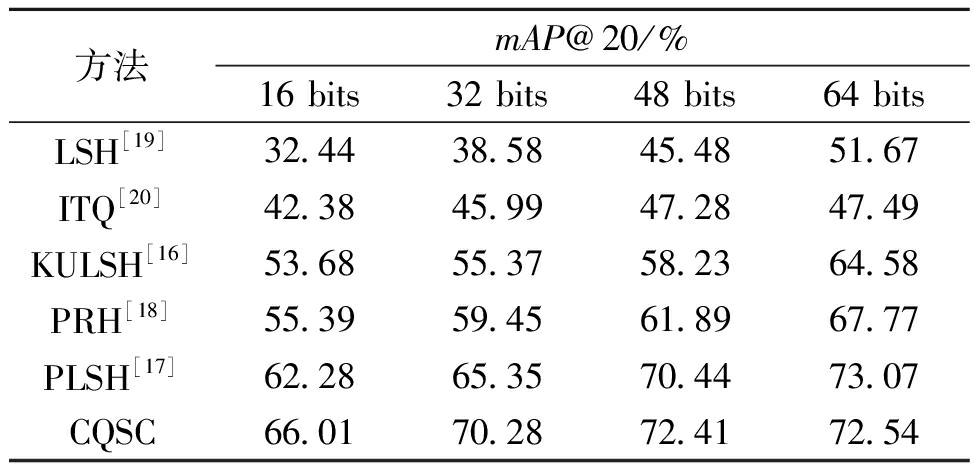

表1展示了在UCMerced数据集上不同长度哈希码下的mAP@20。在16 bits的哈希码长度下,mAP@20提升3.73百分点;在32 bits的哈希码长度下,相对于PLSH,提升了4.93百分点;当哈希码长度达到48 bits时,相对于低位数哈希码情况下的结果,依旧提升1.97百分点,仍然保持较高的性能;当哈希码长度达到64 bits时,mAP@20略低于PLSH,说明随着编码长度的增加,数据在高维空间中的分布变得更加稀疏,使得学习有效特征变得更加困难。同时,编码长度的增加会引入更多的冗余信息,也会影响遥感图像检索性能的提升。在UCMerced数据集上的实验结果表明,本文方法的mAP@20比PLSH方法综合提高了2.52百分点。

表1 在UCMerced上mAP@20的对比结果

Table 1 Comparison results of mAP@20 on UCMerced

方法mAP@20/%16 bits32 bits48 bits64 bitsLSH[19]32.4438.5845.4851.67ITQ[20]42.3845.9947.2847.49KULSH[16]53.6855.3758.2364.58PRH[18]55.3959.4561.8967.77PLSH[17]62.2865.3570.4473.07CQSC66.0170.2872.4172.54

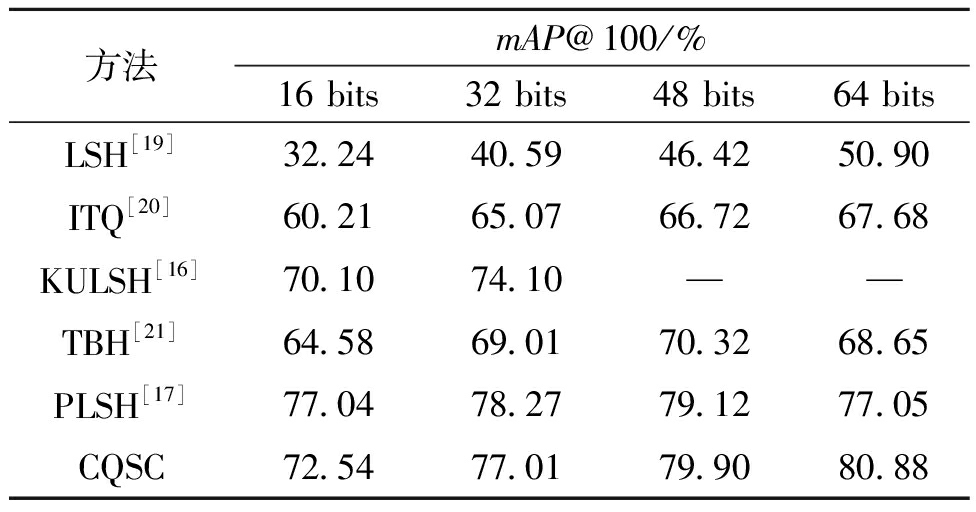

表2为展示了在EuroSAT数据集上不同长度哈希码下的mAP@100。在16 bits和32 bits的哈希码长度下,CQSC略低于PLSH的mAP;当哈希码长度达到48 bits时,相较于效果最好的PLSH精度提升0.78百分点;当哈希码长度达到64 bits时,PLSH的精度有所下降,但是CQSC的精度依然提升,保持较高的性能水平,CQSC的mAP@100比PLSH提升了3.83百分点。这说明PLSH在编码长度较短的时候呈现了检索优势,但是随着编码的增长,PLSH检索性能并没有持续提升。

表2 在EuroSAT上mAP@100的对比结果

Table 2 Comparison results of mAP@100 on EuroSAT

方法mAP@100/%16 bits32 bits48 bits64 bitsLSH[19]32.2440.5946.4250.90ITQ[20]60.2165.0766.7267.68KULSH[16]70.1074.10——TBH[21]64.5869.0170.3268.65PLSH[17]77.0478.2779.1277.05CQSC72.5477.0179.9080.88

3.4 消融实验

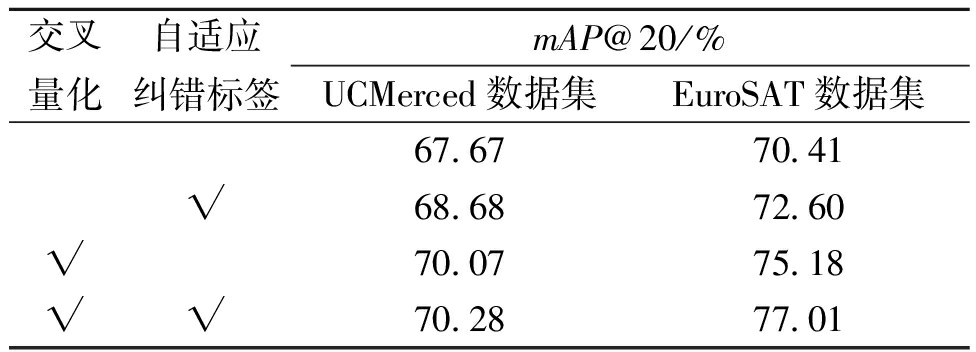

为证明CQSC的可行性,在EuroSAT和UCMerced上进行消融实验,将哈希码的长度固定为32位,保持其他参数固定不变,分别进行epoch为2 000的实验,结果如表3所示。由表3可以看出,在UCMerced数据集中,没有使用交叉量化学习策略和自适应纠错标签的情况下,mAP@20为67.67%,这表明模型在没有这两个模块的情况下,对于信息检索的效果相对较低。仅使用交叉量化学习策略的情况下,mAP@20为70.07%;而仅使用自适应纠错标签的情况下,mAP@20为68.68%,这表明交叉量化学习策略和自适应纠错标签的使用对于提升模型性能是有益的。最后,同时使用交叉量化学习和自适应纠错标签,mAP@20为70.28%,这表明两个模块的结合对于模型的性能有协同效应,能够进一步提升自监督遥感图像检索的准确性。

表3 消融实验

Table 3 Ablation experiment

交叉量化自适应纠错标签mAP@20/%UCMerced数据集EuroSAT数据集67.6770.41√68.6872.60√70.0775.18√√70.2877.01

注:√表示采用该项策略。

在EuroSAT数据集中,没有使用交叉量化学习策略和自适应纠错标签的情况下CQSC的mAP@20只有70.41%,当分别采用交叉量化学习策略和自适应纠错标签时,提升了2.19百分点和4.77百分点,这证明CQSC是可行的。当采用交叉量化学习策略和自适应纠错标签时,在EuroSAT数据集上表现最好,mAP@20达到77.01%。

综合分析,交叉量化学习策略和自适应纠错标签对模型的性能均有积极影响,同时使用的情况下,能够达到最佳的mAP分数。

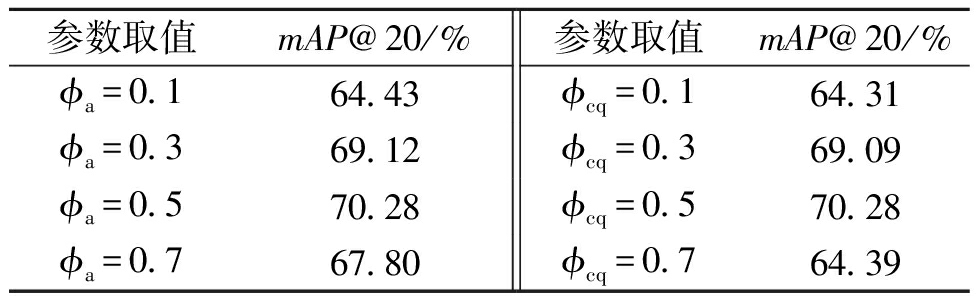

3.5 参数敏感性分析

在UCMerced上的敏感性分析结果如表4所示。为证实验结果的最佳,首先,在UCMerced数据集中测试自适应纠错标签中控制量化分布的参数φa对实验的影响,取值为0到1,将哈希码的长度固定为32位,保持φcq和其他超参数不变的情况下,训练2 000 轮次。从表4中可以看出,当φa为0.1时,mAP@20为64.43%;当φa为0.3时,mAP@20提高到69.12%;当φa为0.5时,进一步提高到70.28%;当φa为0.7时,mAP@20降低到67.8%。随着φa的增加,平均准确度逐渐提高,说明适当增加自适应纠错标签的权重可以提升模型的性能。当φa达到0.5时,mAP@20达到 70.28%,这表明此时自适应纠错标签的权重达到一个良好的平衡,能够最大化地改善模型的性能。

表4 在UCMerced上的敏感性分析实验结果

Table 4 Experimental results of sensitivity analysis on UCMerced

参数取值mAP@20/%参数取值mAP@20/%ϕa=0.164.43ϕcq=0.164.31ϕa=0.369.12ϕcq=0.369.09ϕa=0.570.28ϕcq=0.570.28ϕa=0.767.80ϕcq=0.764.39

其次,对交叉量化损失函数的非负温度参数φcq进行最佳值测定,取值范围从0到1,保持φa和其他超参数不变。结果发现,当φcq的值为0.1时,mAP@20为64.31%;当φcq的值为0.3时,mAP@20提高到69.09%;当φcq的值为0.5时,mAP@20达到最高点,为70.28%;然而,当φcq的值增加到0.7时,mAP@20却下降至64.39%。

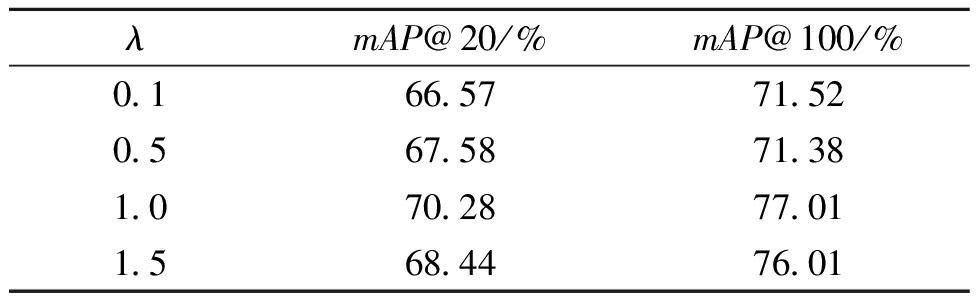

最后,将哈希码的长度固定为32 bits,保持其他参数不变的情况下,训练1 000轮次,对平衡交叉量化损失和自适应纠错标签损失的参数λ进行最佳值分析。表5为参数λ在UCMerced数据集上mAP@20和EuroSAT数据集上mAP@100的分析结果。

表5 λ的敏感性实验结果

Table 5 Sensitivity test results ofλ

λmAP@20/%mAP@100/%0.166.5771.520.567.5871.381.070.2877.011.568.4476.01

由表5可以看出,随着自适应纠错损失的所占比重提升,模型能够获得更好的检索性能。当λ从0.1增加到0.5时,在UCMerced数据集上检索精度提升了1.01百分点,这表明自适应纠错损失在总损失中的权重较小,对模型的指导作用不足以产生大的变化。当λ继续增加到1时,相较于λ为0.5时mAP@20提升了2.70百分点,mAP@100提升了5.63百分点,这表明自适应纠错标签开始对模型产生了较强的影响,改善了检索性能。当λ增加到1.5时,性能有所下降,这表明自适应纠标签占据过大的比重时会导致模型过度注意错误负样本而忽略了交叉量化损失,从而破坏了损失函数之间的平衡,影响模型的总体性能。

4 结论

本文提出了一种基于交叉量化和样本校正的自监督遥感图像检索模型(CQSC),根据特征空间中的样本间的相邻关系,对相似性进行加权作为自适应纠错标签减少训练样本中的错误负样本。通过交叉策略和乘积量化,高效压缩数据的同时,提升自监督遥感图像检索的准确率。

[1] 张艺琨, 唐雁, 陈强. 基于多特征融合的三维模型检索[J]. 郑州大学学报(工学版), 2019, 40(1): 1-6.ZHANG Y K, TANG Y, CHEN Q. 3D model retrieval method based on multiple feature fusion[J]. Journal of Zhengzhou University (Engineering Science), 2019, 40(1): 1-6.

[2] 冯孝鑫, 王子健, 吴奇. 基于三元采样图卷积网络的半监督遥感图像检索[J]. 电子与信息学报, 2023, 45(2): 644-653.FENG X X, WANG Z J, WU Q. Semi-supervised learning remote sensing image retrieval method based on triplet sampling graph convolutional network[J]. Journal of Electronics &Information Technology, 2023, 45(2): 644-653.

[3] JING W P, XU Z K, LI L H, et al. Deep unsupervised weighted Hashing for remote sensing image retrieval[J]. Journal of Database Management, 2022, 33(2): 1-19.

[4] FENG C, PATRAS I. Adaptive soft contrastive learning[C]∥The 26th International Conference on Pattern Recognition (ICPR). Piscataway: IEEE, 2022: 2721-2727.

[5] CHUANG C Y, ROBINSON J, YEN-CHEN L, et al. Debiased contrastive learning[C]∥Proceedings of the 34th International Conference on Neural Information Processing Systems. New York: ACM, 2020: 8765-8775.

[6] AI L F, TAO Y, CHENG H J, et al. Accumulative quantization for approximate nearest neighbor search[J]. Computational Intelligence and Neuroscience, 2022, 2022: 4364252.

[7] SUN Y X, YE Y M, LI X T, et al. Unsupervised deep Hashing through learning soft pseudo label for remote sensing image retrieval[J]. Knowledge-Based Systems, 2022, 239: 107807.

[8] CHEN B, FENG Y, DAI T, et al. Adversarial examples generation for deep product quantization networks on image retrieval[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2023, 45(2): 1388-1404.

[9] ZHOU H Y, QIN Q B, HOU J K, et al. Deep global semantic structure-preserving Hashing via corrective triplet loss for remote sensing image retrieval[J]. Expert Systems with Applications, 2024, 238: 122105.

[10] LIANG Y, ZHANG S L, LI K L, et al. Unleashing the full potential of product quantization for large-scale image retrieval[EB/OL]. (2023-10-09)[2024-08-22].https:∥paperswithcode.com/paper/unleashing-the-full-potential-of-product.

[11] TANG J Y, WANG D L, TONG X C, et al. Learning from self-supervised features for Hashing-based remote sensing image retrieval[J]. IEEE Geoscience and Remote Sensing Letters, 2023, 20: 2501705.

[12] HUYNH T, KORNBLITH S, WALTER M R, et al. Boosting contrastive self-supervised learning with false negative cancellation[C]∥2022 IEEE/CVF Winter Conference on Applications of Computer Vision (WACV). Piscataway: IEEE, 2022: 986-996.

[13] DWIBEDI D, AYTAR Y, TOMPSON J, et al. With a little help from my friends: nearest-neighbor contrastive learning of visual representations[EB/OL].(2021-10-07)[2024-08-22]. http:∥arxiv.org/abs/2104.14548.

[14] 何悦, 陈广胜, 景维鹏, 等. 基于深度多相似性哈希方法的遥感图像检索[J]. 计算机工程, 2023, 49(2): 206-212.HE Y, CHEN G S, JING W P, et al. Remote sensing image retrieval based on deep multi-similarity Hashing method[J]. Computer Engineering, 2023, 49(2): 206-212.

[15] 吴刚, 葛芸, 储珺, 等. 面向遥感图像检索的级联池化自注意力研究[J]. 光电工程, 2022, 49(12): 220029.WU G, GE Y, CHU J, et al. Cascade pooling self-attention research for remote sensing image retrieval[J]. Opto-Electronic Engineering, 2022, 49(12): 220029.

[16] DEMIR B, BRUZZONE L. Hashing-based scalable remote sensing image search and retrieval in large archives[J]. IEEE Transactions on Geoscience and Remote Sensing, 2016, 54(2): 892-904.

[17] FERNANDEZ-BELTRAN R, DEMIR B, PLA F, et al. Unsupervised remote sensing image retrieval using probabilistic latent semantic Hashing[J]. IEEE Geoscience and Remote Sensing Letters, 2021, 18(2): 256-260.

[18] LI P, REN P. Partial randomness hashing for large-scale remote sensing image retrieval[J]. IEEE Geoscience and Remote Sensing Letters, 2017, 14(3): 464-468.

[19] SLANEY M, CASEY M. Locality-sensitive Hashing for finding nearest neighbors lecture notes[J]. IEEE Signal Processing Magazine, 2008, 25(2): 128-131.

[20] GONG Y C, LAZEBNIK S, GORDO A, et al. Iterative quantization: a procrustean approach to learning binary codes for large-scale image retrieval[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2013, 35(12): 2916-2929.

[21] SHEN Y M, QIN J, CHEN J X, et al. Auto-encoding twin-bottleneck Hashing[C]∥2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway: IEEE, 2020: 2815-2824.