立体视觉是计算机视觉领域的基本问题之一,其目标是从一个或多个图像中恢复拍摄场景的三维结构,恢复图像中像素点对应三维场景的相对深度,在三维重建、增强现实、自动驾驶、机器人技术等领域应用广泛。

单视图立体视觉从单个图像中推断3D形状的关键几何和结构信息。Yan等[1]从学习代理的角度研究了单视图三维对象重建,提出一种具有由投影变换定义的新投影损失的编码器-解码器网络。Sun等[2]提出一种基于深度学习单视图三维重建和姿态估计的模型。从单视图恢复三维结构是一个不适定问题,由于图像与三维模型间存在的表示模式差异,通常存在物体自遮挡、低光照等情况。

多视图立体视觉(MVS)[3]从一组校准过的重叠图像中恢复场景的密集三维结构,能够有效减少物体遮挡、光照等因素带来的影响。根据输出表示形式,可分为直接点云重建[4],体积重建[5]和深度图重建。根据最近的MVS基准,目前最好的MVS算法都是基于深度图的方法。虽然深度图可以被视为点云表示的一种特殊情况(如像素级点云),但它将重构简化为逐视图深度的估计问题。此外,可以很容易地将深度图融合到点云或体积重建。

虽然传统方法在MVS上取得了优异的性能,但它们也有一些共同的局限性。例如,场景的低纹理、镜面和反射区域使得密集匹配难以处理,从而导致重建结果不完整。最近的研究表明,使用Deep CNN可以进一步提高MVS的性能。Huang等[6]和Ji等[7]使用多视图图像构建代价体,并使用CNN学习该代价体的正则化过程。Yao等[8]提出了一种MVS深度学习网络MVSNet,用于从多视图图像中推断深度图。该网络架构是一种端到端的MVS架构,基于卷积神经网络特征构建成本量,并使用3D卷积神经网络学习成本量正则化。该网络不仅性能显著优于以往的方法,而且速度效率大大提高。Yao等[9]和杜弘志等[10]提出了基于门控循环单元(GRU)的方法,沿深度方向顺序正则化代价体。Chen等[11]提出了Point-MVSNet网络从粗到细的方式预测深度图,并处理点云以估计每个点的3D流,有效提高了MVS过程的计算效率。Yu等[12]提出了Fast-MVSNet网络,构造高分辨率稀疏深度图,并使用高斯牛顿层对结果进行优化,其计算效率和内存占用均优于以上模型。此外,最近的优化算法[13-14]也表现出了巨大的潜力。

然而,这些基于深度学习的方法大多使用多尺度3D卷积网络来预测深度图,因此,随着三维空间体积的增长,内存需求立方级增长,基于深度学习的方法只能在高计算资源设备上进行运算。本文针对基于深度学习的MVS网络参数量大、显存占用较高的问题,提出了一种由稀疏到稠密、由粗糙到精细的轻量化卷积循环网络LSD-MVSNet。采用轻量化多尺度特征提取网络提取图像的高层语义信息,构建稀疏代价体减小计算体积;正则化过程使用卷积循环网络逐深度平面处理以减少显存占用,使得本文方法参数量大大减少,运行时的显存开销显著降低。对于特征图的通道聚合过程,充分利用了二维卷积特征,保证了重建质量。本文工作主要包含:设计了一种轻量化的多尺度特征提取网络;提出了一种充分利用所有特征的稀疏代价体构造方式;设计了一种双向卷积门控循环单元正则化网络。

1 相关知识

1.1 多视图立体视觉

多视图立体视觉重建的方法中,基于点云的方法直接在三维点上操作,通常依赖传播策略来逐步强化重建。由于点云的传播是按顺序进行的,这些方法难以完全并行化,处理时间长。基于体积的方法将三维空间划分为规则网格,然后估计每个体素是否在表面附近。这种表示的缺点是空间离散化错误和高内存消耗。相比之下,深度图是最灵活的表示法,它将复杂的MVS问题解耦为相对较小的逐视图深度图估计问题,每次只关注一个参考图像和几个源图像。

1.2 基于深度图的多视图立体视觉

深度图表示为每个观测视图的2.5D形式用来显示3D几何图形,利用深度融合技术可以将深度图融合为3D点云恢复三维模型。传统的方法在理想的朗伯表面场景下表现出良好的效果,但它们存在一些共同的局限性,例如场景的低纹理、镜面和反射区域使密集匹配难以处理,从而导致不完整的重建。

近年来卷积神经网络研究的成功,引发了人们对改进多视角立体视觉的兴趣如DeepMVS。基于学习的方法引入诸如镜面先验和反射先验等全局语义信息,实现更健壮的匹配。具体来说,基于平面扫描的方法经过特征提取、代价体构建、代价体正则化、深度图回归得到预测深度图,深度融合后得到3D点云。

1.3 卷积门控循环单元

门控循环单元是循环神经网络的一种,是长短期记忆的简化版本,能够更好地处理长时序列中每个阶段之间的信息流动。

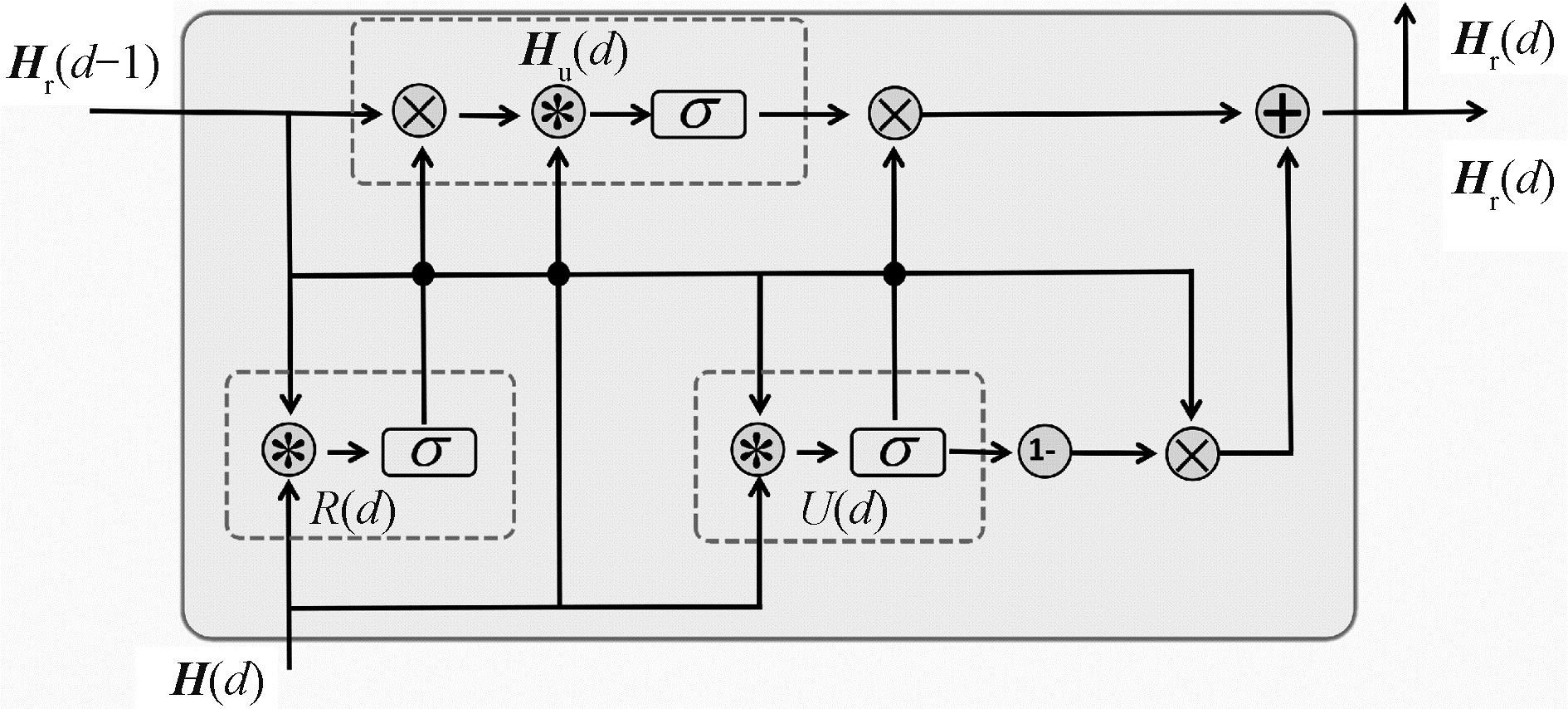

多视图立体视觉问题中,物体在深度方向是连续的,对于物体上的任意一点,深度方向上距离较近的相邻点对其有较大贡献,深度方向上距离较远的相邻点对其有较小贡献,因此门控循环单元可以应用到本文的正则化过程中。本文模型中的卷积门控循环单元结构如图1所示。

图1 卷积门控循环单元结构

Figure 1 Convolutional gated recurrent unit architecure

图1中,R(d)为重置门;U(d)为更新门;σ为逐元素运算的sigmoid函数;Hr(d-1)为深度为d-1时的隐藏状态;Hu(d)为深度为d时的候选隐藏状态;H(d)为深度为d时的输入状态;Hr(d)为深度为d时隐藏状态;⊗为按元素相乘;*为卷积运算符;⊕为按元素相加运算符。图1省略了偏置值的体现。

卷积门控循环单元主要包括重置门R(d)与更新门U(d):

R(d)=σg(Wr*[H(d),Hr(d-1)]+br);

(1)

U(d)=σg(Wu*[H(d),Hr(d-1)]+bu)。

(2)

式中:W为学习的权重参数;b为学习的偏置值;[,]为连接2个向量运算。

输入经过重置门后与前一平面d-1的隐藏状态计算出当前平面d的候选隐藏状态Hu(d):

(3)

由候选隐藏状态Hu(d)与更新门输出可构造当前平面d的隐藏状态Hr(d):

(4)

卷积门控循环单元相较于经典门控循环单元的区别在于引入了卷积层,二维卷积计算不仅在空间上优化深度图,而且沿着深度方向聚合空间的全局信息。

2 LSD-MVSNet模型

2.1 模型架构

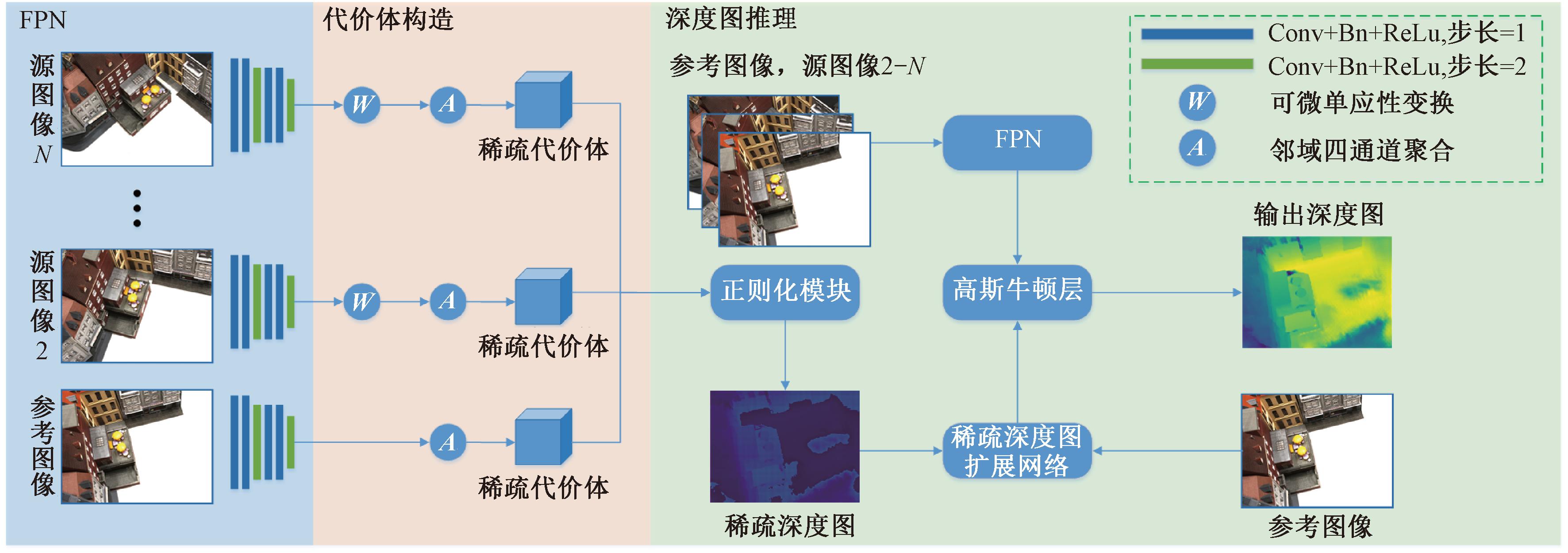

本文提出的模型整体架构如图2所示。首先,参考图像及N-1个源图像经过1个6层二维卷积网络输出特征图;其次,特征图经过可微单应性变换构造稀疏代价体;再次,代价体正则化后经过softmax输出稀疏深度图;最后,参考图像经过深度图扩展网络扩展稀疏深度图为稠密深度图。另外,本文模型沿用了Fast-MVSNet[12]的优化层,参考图像经过优化层与稠密深度图融合后输出优化后的深度图。

图2 LSD-MVSNet模型架构图

Figure 2 LSD-MVSNet model architecture

2.2 特征提取模块

特征提取主要通过多尺度二维卷积网络完成。给定一个参考图像I1和一组相邻的源图像![]() 对输入图像进行密集匹配。多尺度设计借鉴了MVSNet[8]的3个尺度。本文方法设计了一个轻量化的多尺度二维卷积网络,第3层和第6层的步幅设置为2层,将特征金字塔划分为3个尺度。在前2个尺度内,应用了2个卷积层来提取更高级别的图像表示。每个卷积层之后都有1个批归一化层和1个用于校正的ReLu函数,权重参数在特征金字塔之间共享。

对输入图像进行密集匹配。多尺度设计借鉴了MVSNet[8]的3个尺度。本文方法设计了一个轻量化的多尺度二维卷积网络,第3层和第6层的步幅设置为2层,将特征金字塔划分为3个尺度。在前2个尺度内,应用了2个卷积层来提取更高级别的图像表示。每个卷积层之后都有1个批归一化层和1个用于校正的ReLu函数,权重参数在特征金字塔之间共享。

特征提取网络的输出为N个8通道的特征图![]() 每个维度为输入图像的1/4。虽然特征提取后图像尺度缩小,但每个像素的原始相邻信息已经被编码到8通道特征图中,避免了在密集匹配过程中丢失全局特征。

每个维度为输入图像的1/4。虽然特征提取后图像尺度缩小,但每个像素的原始相邻信息已经被编码到8通道特征图中,避免了在密集匹配过程中丢失全局特征。

2.3 代价体构建模块

基于MVSNet的网络大多沿用了平面扫描算法[15]。平面扫描是一种多视图立体算法,解决了二维到三维的立体问题。参考图像I1与源图像![]() 经过特征提取网络输出N个8通道特征图

经过特征提取网络输出N个8通道特征图![]() 给定深度假设

给定深度假设![]() 匹配特征图

匹配特征图![]() 中像素p,在参考特征图F1中的相对应像素p′在第d个深度假设平面经过可微单应性变换可以表示为

中像素p,在参考特征图F1中的相对应像素p′在第d个深度假设平面经过可微单应性变换可以表示为

(5)

式中:i∈[1,N];Ki,R1,i,t1,i分别为特征图对应相机的内参矩阵、参考特征图到匹配特征图的旋转矩阵和位移向量。

将所有特征图变换到参考特征图的平面后组成特征体![]() 特征体大小为

特征体大小为

(6)

式中:W、H、D、F分别为输入图像的宽度、高度、深度采样数和特征图的通道数。

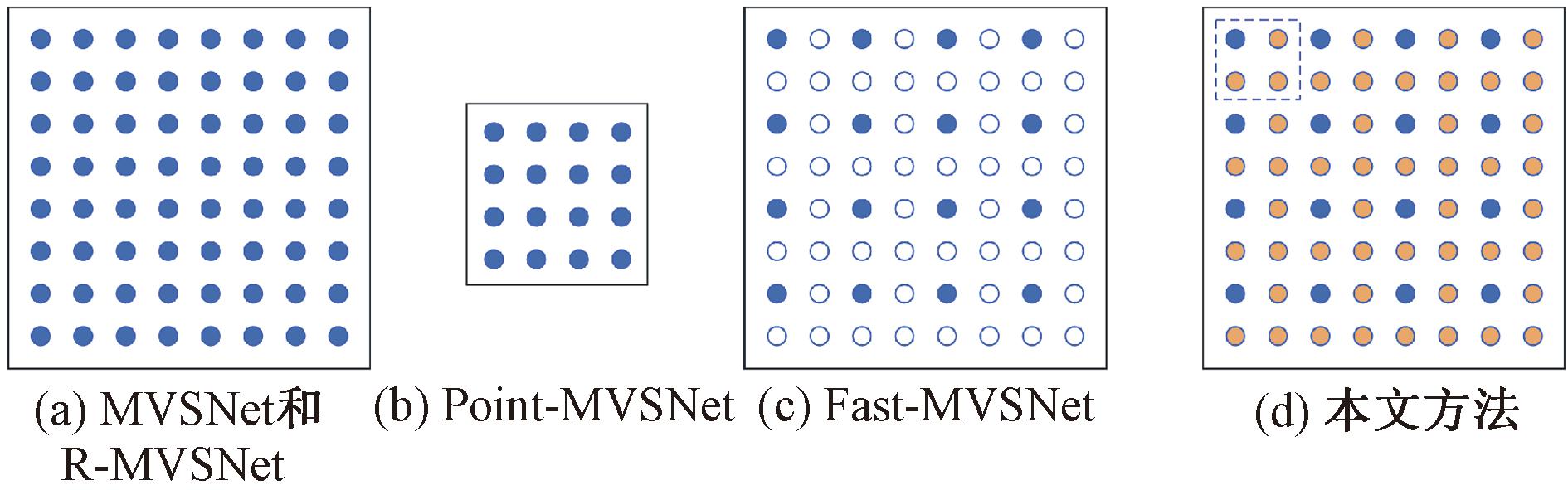

将多个特征体聚合为一个代价体C:

(7)

式中:N为代价体个数;Vi为以第i个特征图作为参考特征图时的特征体;![]() 为以第i个特征图作为参考特征图时的所有特征体均值。

为以第i个特征图作为参考特征图时的所有特征体均值。

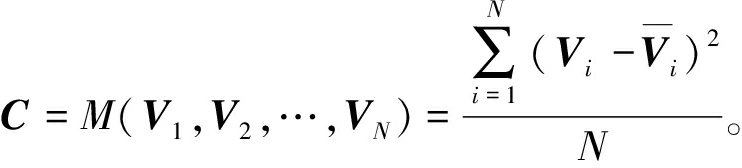

特征图的维度直接影响了代价体的维度,最近的研究通过减小特征图维度来降低代价体的维度,从而加速后续的正则化过程。几种代价体构造方案如图3所示。

图3 不同代价体构造方案

Figure 3 Different cost volume construct schemes

图3(a)为MVSNet和R-MVSNet所使用的特征图。Point-MVSNet为了降低正则化成本,缩小了特征图的维度,如图3(b),其特征体大小![]() 构造了一个稀疏代价体如图3(c)所示,经过正则化阶段后,使用1个轻量的扩展网络将获得的稀疏深度图扩展为原始分辨率深度图,降低了正则化成本,提高了处理速度,并保证了重建质量。

构造了一个稀疏代价体如图3(c)所示,经过正则化阶段后,使用1个轻量的扩展网络将获得的稀疏深度图扩展为原始分辨率深度图,降低了正则化成本,提高了处理速度,并保证了重建质量。

本文设计了与Fast-MVSNet类似的稀疏代价体构造方式,与前者直接丢弃75%特征点不同的是,本文方法充分利用了所有特征,如图3(d)所示。本文特征提取阶段输出8通道特征图,对于特征图的蓝色像素点,将其相邻的3个橙色特征像素点扩充至蓝色像素点的通道维度,构造了与Fast-MVSNet相似的32通道稀疏代价体。同时本文放弃了在深度方向上均匀采样的方法,在逆深度方向上进行均匀采样。在处理大尺度重建时,可以确保特征聚集在一个相对集中的区域,因此本文网络具有更好的处理大尺度数据的能力。

2.4 正则化模块

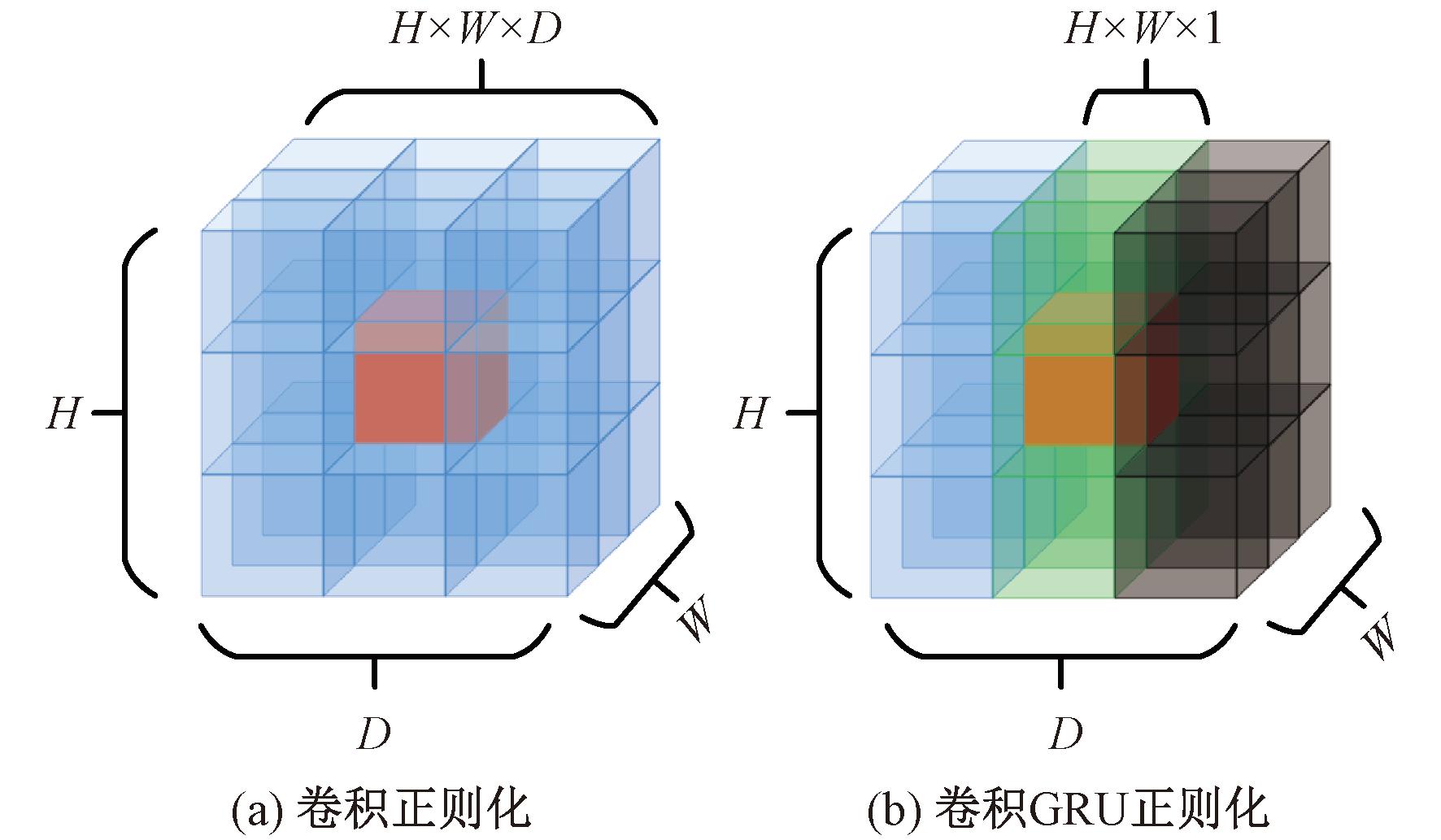

对代价体进行全局正则化的一种方法是沿深度方向进行顺序处理。MVSNet采用三维卷积正则化提取整个空间的成本信息,这种方式精度较高,但是运行时显存开销达到模型分辨率的立方级别。大多数改进MVSNet网络均延续了三维卷积正则化过程。本文使用卷积门控循环单元来进行正则化。如图4所示,红色体素为当前感兴趣区域,蓝色体素为代价体正则化过程接受野,图4(b)中绿色平面为当前处理的深度平面,卷积门控循环单元正则化时考虑前d个平面。三维卷积正则化显存占用为H×W×D,而卷积门控循环单元正则化显存占用为H×W×1。

图4 不同正则化方案

Figure 4 Different regularization schemes

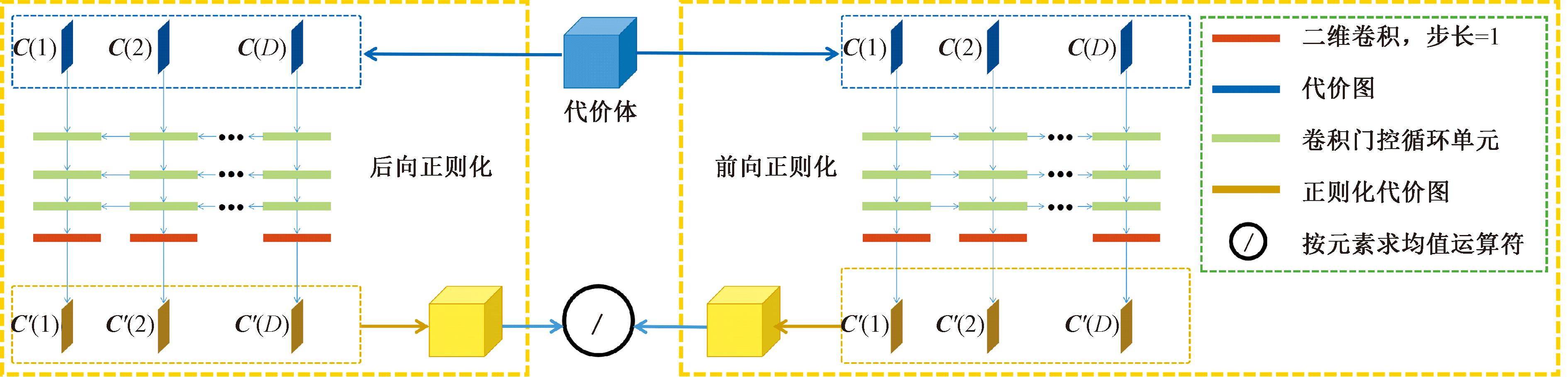

本文方法在深度方向上按顺序对代价体进行正则化。如图5所示,代价体C可看作D个代价图在深度方向上的拼接。由于卷积门控循环单元沿深度方向单向处理代价图,对于代价体C的代价图C(i),i∈[1,D],正则化过程中仅能感受前i-1个代价图。为了更好地感知全局信息,本文提出一种双向卷积门控循环单元正则化方法,该方法使用一个卷积门控循环单元网络,沿深度前、后2个方向对代价体进行正则化。具体来说,本文模型使用前向、后向2个正则化过程,分别从代价图C(1)到代价图C(D)、从代价图C(D)到代价图C(1)对代价体进行正则化,最后2个正则化后的代价体按元素求均值,得到最终正则化后的代价体,理论上可以将运行时内存开销降低至模型分辨率的平方级别。基本的门控循环单元模型由1个单层组成,为了进一步提高正则化能力,本文使用3层堆叠卷积门控循环单元,形成更深层次的网络。需要说明的是,相较于三维卷积正则化网络,本文方法在深度方向上迭代处理特征图,在减小显存占用的同时降低了处理速度。正则化过程将正则化代价图定义为![]() 对于第d个平面的顺序处理理想状态下,C(d)应当只依赖于当前平面的代价图C(d)以及之前所有平面的代价图

对于第d个平面的顺序处理理想状态下,C(d)应当只依赖于当前平面的代价图C(d)以及之前所有平面的代价图![]() 在本文的模型中,使用卷积门控循环单元在深度方向上聚合了这些上下文信息,对应了自然语言处理领域中的时间方向。

在本文的模型中,使用卷积门控循环单元在深度方向上聚合了这些上下文信息,对应了自然语言处理领域中的时间方向。

图5 卷积门控循环单元正则化

Figure 5 Convolutional GRU regularization

为了进一步增强正则化能力,本文采用3层叠加的卷积门控循环单元结构。首先应用二维卷积层将32通道的代价图C(t)缩小到16通道,作为第一个门控循环单元层的输入。每一层门控循环单元的输出作为下一层门控循环单元的输入,3层的输出通道数分别设置为16、4、1。正则化的代价图![]() 最后经过一个softmax层,生成用于计算训练损失的概率体积。

最后经过一个softmax层,生成用于计算训练损失的概率体积。

2.5 深度图扩展模块

稀疏深度图D扩展得到稠密深度图![]() 本文选择与Fast-MVSNet相同的联合双侧上采样器,使用原始高分辨率图像的信息作为指导。稀疏深度图D首先利用最近邻扩展到稠密深度图。然后,一个轻量级卷积网络以参考图像作为输入,输出每个位置的k×k权重w。最后,计算出扩展的深度图

本文选择与Fast-MVSNet相同的联合双侧上采样器,使用原始高分辨率图像的信息作为指导。稀疏深度图D首先利用最近邻扩展到稠密深度图。然后,一个轻量级卷积网络以参考图像作为输入,输出每个位置的k×k权重w。最后,计算出扩展的深度图![]()

(8)

式中:N(p)为像素点p附近的局部k×k邻域;Zp为一个归一化项;wp,q为轻量级卷积网络学习权重参数。

轻量级卷积网络简单地使用2.1节网络结构来提取图像特征,并附加1个2层3×3卷积网络来预测具有k×k通道的特征图。

2.6 损失函数

本文使用估计深度图与地面真实深度图之间平均绝对差作为模型的训练损失,初始深度图![]() 和优化深度图

和优化深度图![]() 都考虑在训练损失中:

都考虑在训练损失中:

(9)

式中:Pvalid为有效真实深度的集合。

3 实验

3.1 数据集

本文实验使用公开的MVS数据集:DTU数据集。DTU数据集是被广泛应用在多视图三维重建中的经典大规模数据集,共包含80个场景,且场景多样性较大。每个场景都在49或64个精确的相机位置上拍摄,并有7种不同的照明条件。每张图片的分辨率为1 600×1 200像素,该数据集提供了由精确的结构光扫描仪以及高分辨率RGB图像获得的参考模型。

3.2 对比方法

本文方法与不同的MVS方法进行对比,包括传统MVS方法Camp[16]、Furu[17]、Tola[18]、Gipuma[19],基于深度学习的MVS方法PUNet[20]、MVSNet[8]、RMVSNet[9]、PointMVSNet[11]、SurfaceNet[7]、Fast-MVSNet[12]、GBI-Net[21]、TransMVSNet[22]。

3.3 评价标准

本文实验结果评价标准采用MVS领域中的3个评价指标:精确度误差、完整度误差和总体误差。计算MVS点云与参考点云中最近点距离,采样距离阈值为0.2 mm、异常值拒绝阈值为20 mm、射线扩展阈值为10 mm 。指标值单位均为mm,指标值越小效果越好。

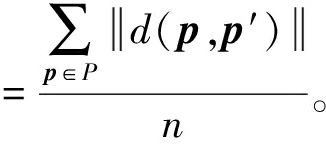

精确度为MVS点云到参考点云的距离差,反映了MVS点云的重建质量:

精确度误差

(10)

式中:P为重建点云集合;d(,)为求点云距离函数;p为P中0.2 mm采样点;p′为p对应的真实点云集合P′中0.2 mm采样点;n为重建点云个数。

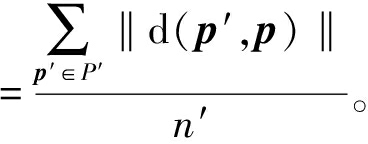

完整度为参考点云到MVS点云的距离差,反映了MVS表面的重建质量:

完整度误差

(11)

式中:n′为真实点云个数。

总体误差为精确度误差和完整度误差的总体评价:

总体误差![]()

(12)

此外,对于基于深度学习的MVS方法,本文实验计算了效率指标,包括深度图分辨率、显存开销和帧率。

3.4 实验方案

本文使用基于深度学习的MVS领域中使用的DTU训练集作为实验的训练集,遵循相同的过程来生成渲染深度图进行训练。使用Pytorch框架实现本文的模型,输入图像的分辨率为640×512像素,视图数N设置为3。使用了与MVSNet相同的视图选择策略,为参考图像选择源图像进行训练。在稀疏深度图预测中,沿用了Fast-MVSNet的深度采样数D=48,本文模型采用逆深度采样,在425~921 mm进行逆深度均匀采样,以便更好地处理高分辨率输入图像。使用初始学习率为0.001的RMSProp优化器,每2个周期降低学习率0.9。在1台Nvidia Tesla T4 GPU上进行训练,批量大小为4。首先对稀疏深度图预测模块和传播模块进行了4轮的预训练,然后对整个模型进行12轮端到端训练。

在DTU测试集预测时,使用分辨率为1 280×960像素的N=5个图像作为输入,设置深度平面的采样数D=96。首先为每个参考图像预测一个深度图,然后使用后处理fusibile将预测的深度图融合到点云中,对输出点云进行定量测试得到实验结果。在1台Nvidia Tesla T4 GPU上进行预测。

4 结果分析

4.1 精度分析

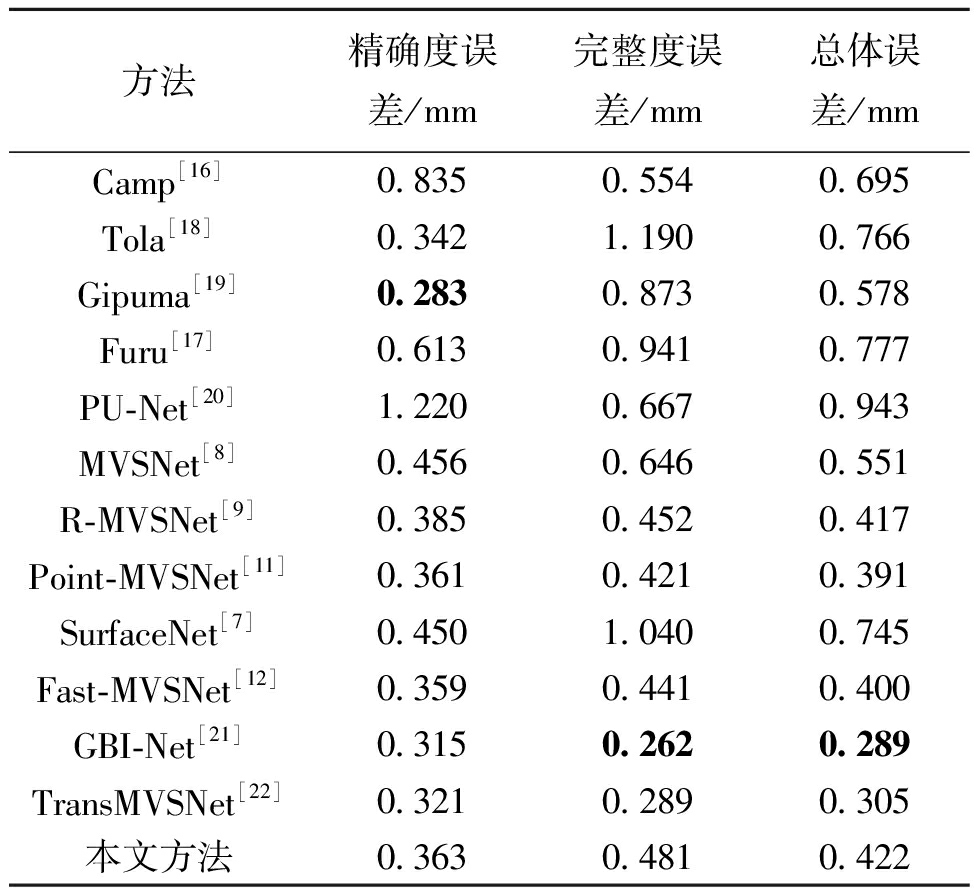

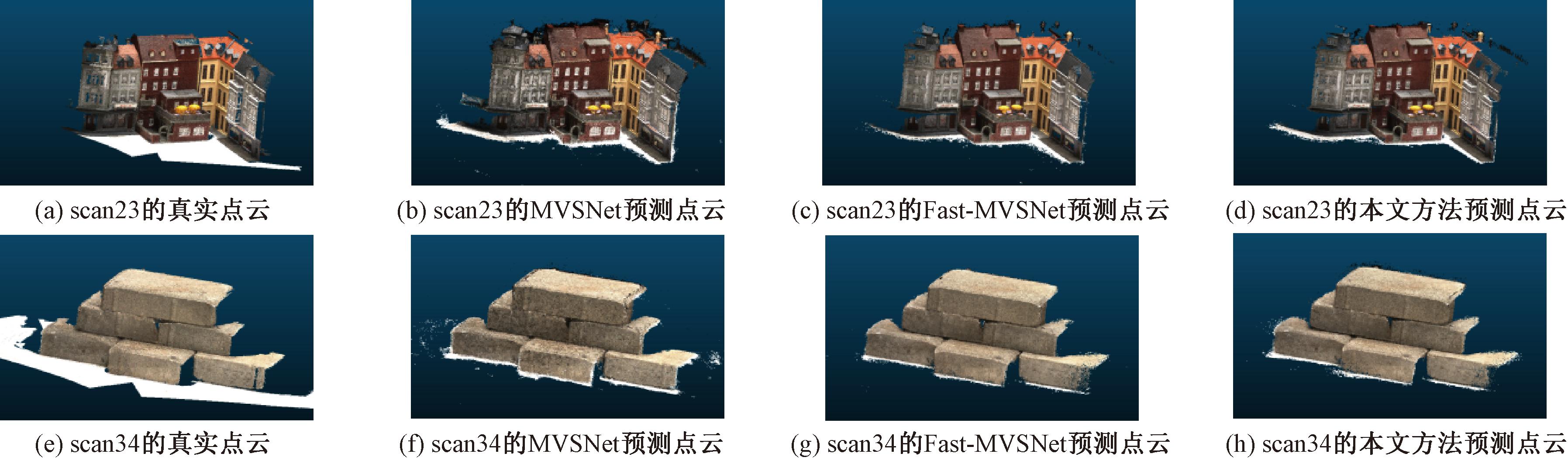

本文方法在DTU测试集上与其他MVS方法精度结果对比如表1所示。从表1可以看出,本文所提轻量化方法的平均精确度误差与最好的Gipuma对比仅增加0.080 mm,平均完整度误差与GBI-Net对比仅增加0.219 mm,平均总体误差与最好的GBI-Net对比仅增加0.133 mm。图6为DTU测试集中场景scan23和scan34的重建点云结果。

表1 不同方法在DTU测试集上的精度结果对比

Table 1 Accuracy result comparison of different methods on DTU test dataset

方法精确度误差/mm完整度误差/mm总体误差/mmCamp[16]0.8350.5540.695Tola[18]0.3421.1900.766Gipuma[19]0.2830.8730.578Furu[17]0.6130.9410.777PU-Net[20]1.2200.6670.943MVSNet[8]0.4560.6460.551R-MVSNet[9]0.3850.4520.417Point-MVSNet[11]0.3610.4210.391SurfaceNet[7]0.4501.0400.745Fast-MVSNet[12]0.3590.4410.400GBI-Net[21]0.3150.2620.289TransMVSNet[22]0.3210.2890.305本文方法0.3630.4810.422

图6 DTU测试集scan23和scan34点云预测结果

Figure 6 Point cloud evaluation results on DTU test dateset scan23 and scan34

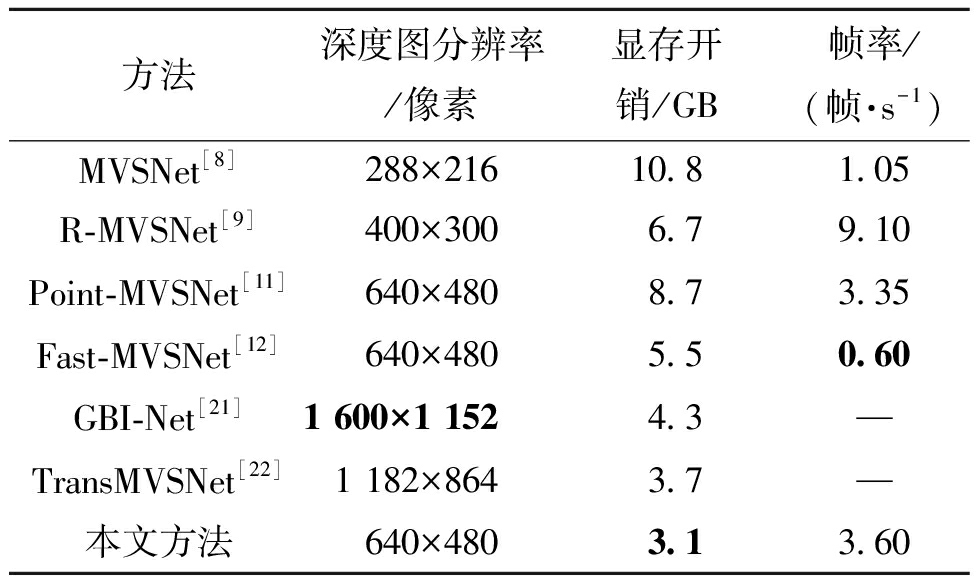

4.2 效率分析

在DTU测试集上与部分基于深度学习的MV方法进行效率对比,结果如表2 所示。

表2 不同方法在DTU测试集上的效率结果对比

Table 2 Efficiency result comparison of different methods on DTU test dataset

方法深度图分辨率/像素显存开销/GB帧率/(帧·s-1)MVSNet[8]288×21610.81.05R-MVSNet[9]400×3006.79.10Point-MVSNet[11]640×4808.73.35Fast-MVSNet[12]640×4805.50.60GBI-Net[21]1 600×1 1524.3—TransMVSNet[22]1 182×8643.7—本文方法640×4803.13.60

从表2可以看出,本文所提轻量化方法在显存开销上优于其他MVS 方法。由于预测时显存开销与CUDA Context 有关,不同显卡的CUDA Context 占用不同,且不同版本的Pytorch 框架也会产生较小影响,因此在不同显卡和不同Pytorch 版本上测试时显存开销可能有微小差别。

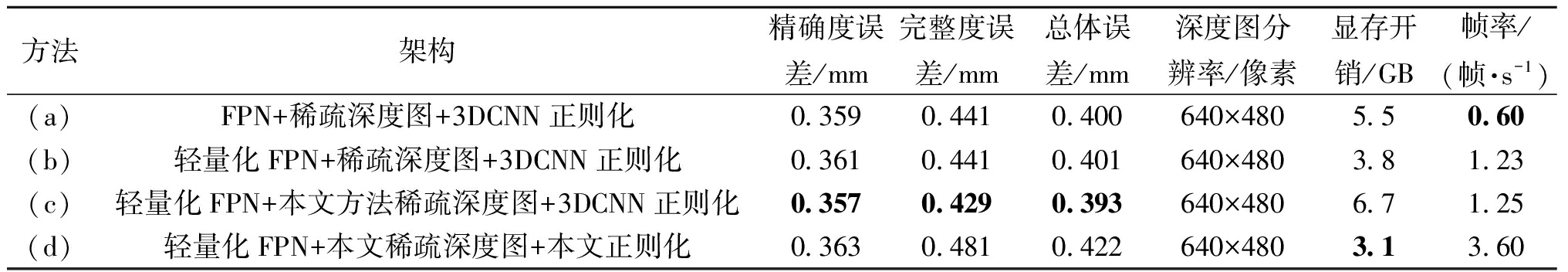

4.3 消融实验

为了验证本文的轻量化特征提取FPN模块、稀疏深度图模块和正则化模块的有效性,本文设计了3个变种方法,如表3所示。

表3 消融实验

Table 3 Ablation study

方法架构精确度误差/mm完整度误差/mm总体误差/mm深度图分辨率/像素显存开销/GB帧率/(帧·s-1)(a)FPN+稀疏深度图+3DCNN正则化0.3590.4410.400640×4805.50.60(b)轻量化FPN+稀疏深度图+3DCNN正则化0.3610.4410.401640×4803.81.23(c)轻量化FPN+本文方法稀疏深度图+3DCNN正则化0.3570.4290.393640×4806.71.25(d)轻量化FPN+本文稀疏深度图+本文正则化0.3630.4810.422640×4803.13.60

方法(a)为FPN 模块+稀疏深度图模块+3DCNN正则化模块架构,使用基于深度学习的MVS常用FPN模块提取图像特征,使用Fast-MVSNet中稀疏深度图模块构造代价体,使用3DCNN模块对代价体进行正则化,组成骨干网络架构。方法(b)为轻量化FPN 模块+稀疏深度图模块+3DCNN正则化模块架构,在方法(a)的基础上,轻量化FPN模块替换了原FPN模块。可以看出,所提轻量化FPN模块大幅度降低了显存占用,精度上几乎没有损失。方法(c)为轻量化FPN模块+本文方法稀疏深度图模块+3DCNN正则化模块架构,在方法(b)的基础上,本文所提稀疏深度图模块替换了原稀疏深度图模块。可以看出,本文方法稀疏深度图模块的MVS精确度误差、完整度误差和总体误差均有所下降。方法(d)为轻量化FPN模块+本文稀疏深度图模块+本文正则化模块架构,即本文所提方法。在方法(c)的基础上,本文所提正则化模块替换了原3DCNN正则化模块,显存开销大幅降低至3.1 GB,精度略微有所下降。

5 结论

本文针对基于深度学习的MVS网络参数量大、显存占用较高的问题,提出了LSD-MVSNet网络。实验结果表明:本文所提轻量化多尺度特征提取网络能够充分提取图像的高层语义信息,降低显存开销;邻域特征通道聚合充分利用图像特征,保证了一定的精度;正则化过程中卷积循环网络能够进一步降低显存开销,使得本文方法参数量大大减少,运行时显存开销显著降低。

[1] YAN X C, YANG J M, YUMER E, et al. Perspective transformer nets: learning single-view 3D object reconstruction without 3D supervision[C]∥Proceedings of the 30th International Conference on Neural Information Processing Systems. New York: ACM, 2016: 1704-1712.

[2] SUN X Y, WU J J, ZHANG X M, et al. Pix3D: dataset and methods for single-image 3D shape modeling[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2018: 2974-2983.

[3] FURUKAWA Y, HERN NDEZ C. Multi-view stereo: a tutorial[J]. Foundations and Trends in Computer Graphics and Vision, 2015, 9(1/2): 1-148.

NDEZ C. Multi-view stereo: a tutorial[J]. Foundations and Trends in Computer Graphics and Vision, 2015, 9(1/2): 1-148.

[4] 纪勇, 刘丹丹, 罗勇, 等. 基于霍夫投票的变电站设备三维点云识别算法[J]. 郑州大学学报(工学版), 2019, 40(3): 1-6, 12.

JI Y, LIU D D, LUO Y, et al. Recognition of three-dimensional substation equipment based on Hough transform[J]. Journal of Zhengzhou University (Engineering Science), 2019, 40(3): 1-6, 12.

[5] KUTULAKOS K N, SEITZ S M. A theory of shape by space carving[J]. International Journal of Computer Vision, 2000, 38(3): 199-218.

[6] HUANG P H, MATZEN K, KOPF J, et al. DeepMVS: learning multi-view stereopsis[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2018: 2821-2830.

[7] JI M Q, GALL J, ZHENG H T, et al. SurfaceNet: an end-to-end 3D neural network for multiview stereopsis[C]∥2017 IEEE International Conference on Computer Vision (ICCV). Piscataway: IEEE, 2017: 2326-2334.

[8] YAO Y, LUO Z X, LI S W, et al. MVSNet: depth inference for unstructured multi-view stereo[C]∥European Conference on Computer Vision. Cham: Springer, 2018: 785-801.

[9] YAO Y, LUO Z X, LI S W, et al. Recurrent MVSNet for high-resolution multi-view stereo depth inference[C]∥2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway: IEEE, 2019: 5520-5529.

[10] 杜弘志, 张腾, 孙岩标, 等. 基于门控循环单元的立体匹配方法研究[J]. 激光与光电子学进展, 2021, 58(14): 387-394.

DU H Z, ZHANG T, SUN Y B, et al. Stereo matching method based on gated recurrent unit networks[J]. Laser &Optoelectronics Progress, 2021, 58(14): 387-394.

[11] CHEN R, HAN S F, XU J, et al. Point-based multi-view stereo network[C]∥2019 IEEE/CVF International Conference on Computer Vision (ICCV). Piscataway: IEEE, 2019: 1538-1547.

[12] YU Z H, GAO S H. Fast-MVSNet: sparse-to-dense multi-view stereo with learned propagation and Gauss-Newton refinement[C]∥2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway: IEEE, 2020: 1946-1955.

[13] MA L B, LI N, YU G, et al. Pareto-wise ranking classifier for multi-objective evolutionary neural architecture search[J]. IEEE Transactions on Evolutionary Computation, 2023: 1-12.

[14] LI N, MA L B, YU G, et al. Survey on evolutionary deep learning: principles, algorithms, applications, and open issues[J]. ACM Computing Surveys, 2024, 56(2): 1-34.

[15] COLLINS R T. A space-sweep approach to true multi-image matching[C]∥Proceedings CVPR IEEE Computer Society Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2002: 358-363.

[16] CAMPBELL N D, VOGIATZIS G, HERN NDEZ C, et al. Using multiple hypotheses to improve depth-maps for multi-view stereo[C]∥ 10th European Conference on Computer Vision. New York: ACM, 2008: 766-779.

NDEZ C, et al. Using multiple hypotheses to improve depth-maps for multi-view stereo[C]∥ 10th European Conference on Computer Vision. New York: ACM, 2008: 766-779.

[17] FURUKAWA Y, PONCE J. Accurate, dense, and robust multiview stereopsis[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2010, 32(8): 1362-1376.

[18] TOLA E, STRECHA C, FUA P. Efficient large-scale multi-view stereo for ultra high-resolution image sets[J]. Machine Vision and Applications, 2012, 23(5): 903-920.

[19] GALLIANI S, LASINGER K, SCHINDLER K. Massively parallel multiview stereopsis by surface normal diffusion[C]∥2015 IEEE International Conference on Computer Vision (ICCV). Piscataway: IEEE, 2015: 873-881.

[20] YU L Q, LI X Z, FU C W, et al. PU-net: point cloud upsampling network[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2018: 2790-2799.

[21] MI Z X, DI C, XU D. Generalized binary search network for highly-efficient multi-view stereo[C]∥2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway: IEEE, 2022: 12981-12990.

[22] DING Y K, YUAN W T, ZHU Q T, et al. TransMVSNet: global context-aware multi-view stereo network with transformers[C]∥2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Piscata-way: IEEE, 2022: 8575-8584.