人类在视觉识别方面有很出色的表现,这是机器无法做到的。尽管卷积神经网络(convolutional neural networks,CNN)的出现和大规模应用使得机器视觉分类的性能有了明显提高,但它们的泛化能力仍无法达到人类水平。

脑电图(electroencephalogram,EEG)是从人脑中记录的电信号。目前大多数研究集中在脑电信号处理上,它可以帮助我们理解脑电活动与电信号之间的关系。研究人员已经发现大脑活动记录包含有关视觉对象类别的信息[1-3]。因此,通过EEG数据和神经成像技术(如核磁共振成像)可以识别人类用于视觉分类的特征空间。近些年的研究很少直接使用图像诱发的EEG信号进行视觉分类。分析EEG数据可以使用深度学习方法从复杂信号中分析、学习和提取复杂模式。El-lone等[4]发表了关于使用密集脑电图数据进行视觉识别的研究。刺激数据集包含400幅图像,使用256个电极的密集脑电图系统记录大脑信号,平均分类率为82.70%。Parekh等[5]提出了一种CNN结构驱动的脑电图像标注系统。用2 500幅图像作为训练刺激源,F1得分为0.88。Spampinato等[6]训练递归神经网络(recurrent neural networks,RNN)学习脑电波视觉表示,并且使用基于CNN的回归器将学习能力转移到机器上,获得83%的准确率。Zheng等[7]提出LSTM结合集成学习的模型,使用40个类别的2 000个图像进行特征提取,特征提取准确率为97.13%。Zheng等[8]提出了一种基于端到端的注意力机制的Bi-LSTM方法,在Bi-LSTM框架中引入了两种注意力策略,获得了99.50%的准确率。在最近的研究中,Mishra等[9]设计了一种将脑电图信号编码为图像的有效方法,对39个图像类对应的编码脑电图信号进行分类,在6个主题的分层数据集上进行图像分类,获得了82%的准确率。Khaleghi等[10]提出基于功能连通性的几何深度神经网络(FC-GDW),利用图像诱发脑电信号中的时空分布式信息直接提取高分辨率的时间样本隐藏状态,在EEG-ImageNet数据集上的平均准确率为98.4%。以上这些研究表明,利用EEG信号对视觉场景进行分类是可行的,结合深度学习的研究结果为进一步探索脑电在视觉分类场景的应用指明了方向,但很少有文献针对所提出模型的泛化能力进行研究,验证模型在图像分类上是否具有一定的应用价值,并且基于EEG的现有研究在图像分类上的准确率仍有很大的提高空间。综上,本文针对现有研究存在的问题设计改进了TextCNN和StackCNN模型,加入K-max池化,解决在提取脑电特征时信息丢失问题,并应用在EEG特征提取上,显著提升了分类性能。然后分别将TextCNN和StackCNN模型与Bagging算法结合,进一步提高模型的泛化能力,最后将表现更优的StackCNN-B方法应用到基于ResNet的视觉分类模型上,将图像特征映射到脑电特征,使机器更好地理解视觉场景。

1 模型设计

当受试者观看屏幕上显示的图像时,会产生相应的脑电信号。脑电信号可以传递视觉相关信息,可以用于识别不同的图像,从而理解不同的图像内容。EEG是一种多通道的时间序列类型信号,其中包含一些噪声,因此须利用多通道的序列提取低维和有意义的特征表示视觉相关的信息。当提取到了表示大脑视觉活动的脑电特征后,可以将脑电图像映射到相应的脑电特征上,从而实现视觉分类。

基于上述思想,图像分类过程由两个阶段组成,如图1所示。第一阶段是解码人类大脑活动,由于每个脑电序列都对应着相应的图像类别,因此提取的脑电特征可以用于图像分类。第一阶段的目的是从原始EEG信号中提取到低维的EEG特征和训练Softmax分类器,本文采用基于改进的两种CNN模型结合改进的Bagging算法实现此目的。第二阶段是实现自动视觉分类,基于上一阶段提取到的EEG特征,并在此阶段训练基于残差神经网络(residual network,ResNet)的回归,将提取到的图像特征直接映射到上一阶段提取到的EEG特征上,通过上一阶段训练好的softmax分类器可以估计新图像的EEG特征,并对其进行预测分类。

图1 图像分类体系

Figure 1 Image classification system

1.1 基于改进的TextCNN和StackCNN模型设计

本文使用两种不同的CNN架构结合受图像刺激的EEG数据进行分析。

(1) TextCNN:利用多个大小不同的卷积核提取EEG序列中的关键信息。

(2) StackCNN:利用多个堆叠的卷积核提取脑电信号特征,并将低维和高维的特征合并。

1.1.1 K-max池化

上述两种CNN结构均使用了最大池化(max-pooling)方法,该池化运算仅取特征向量中的最大值,存在两个明显的缺陷:一是未考虑任何特征的位置信息;二是容易忽视特征的强度,如果得分最高的特征只出现了一次,而得分第二的特征出现多次,得分第二的特征比得分最高的特征更为重要,但却被丢弃,从而造成信息损失。

为解决最大池化带来的问题,本文选择使用K-max池化(K-max pooling)[11],此方法选取得分最高的前K个特征,在一定程度改善了上述问题。K-max池化可以表达同一类特征出现多次的情形,即表达某类特征的强度。另外,因为这些特征值的相对顺序得以保留,所以其保留了部分位置信息,但这种位置信息只是特征间的相对顺序,而非绝对位置信息。

1.1.2 改进的TextCNN模型

TextCNN最初由Kim[12]提出,是一种非常有用和有效的深度学习算法,用于文本分类任务[13-14]。

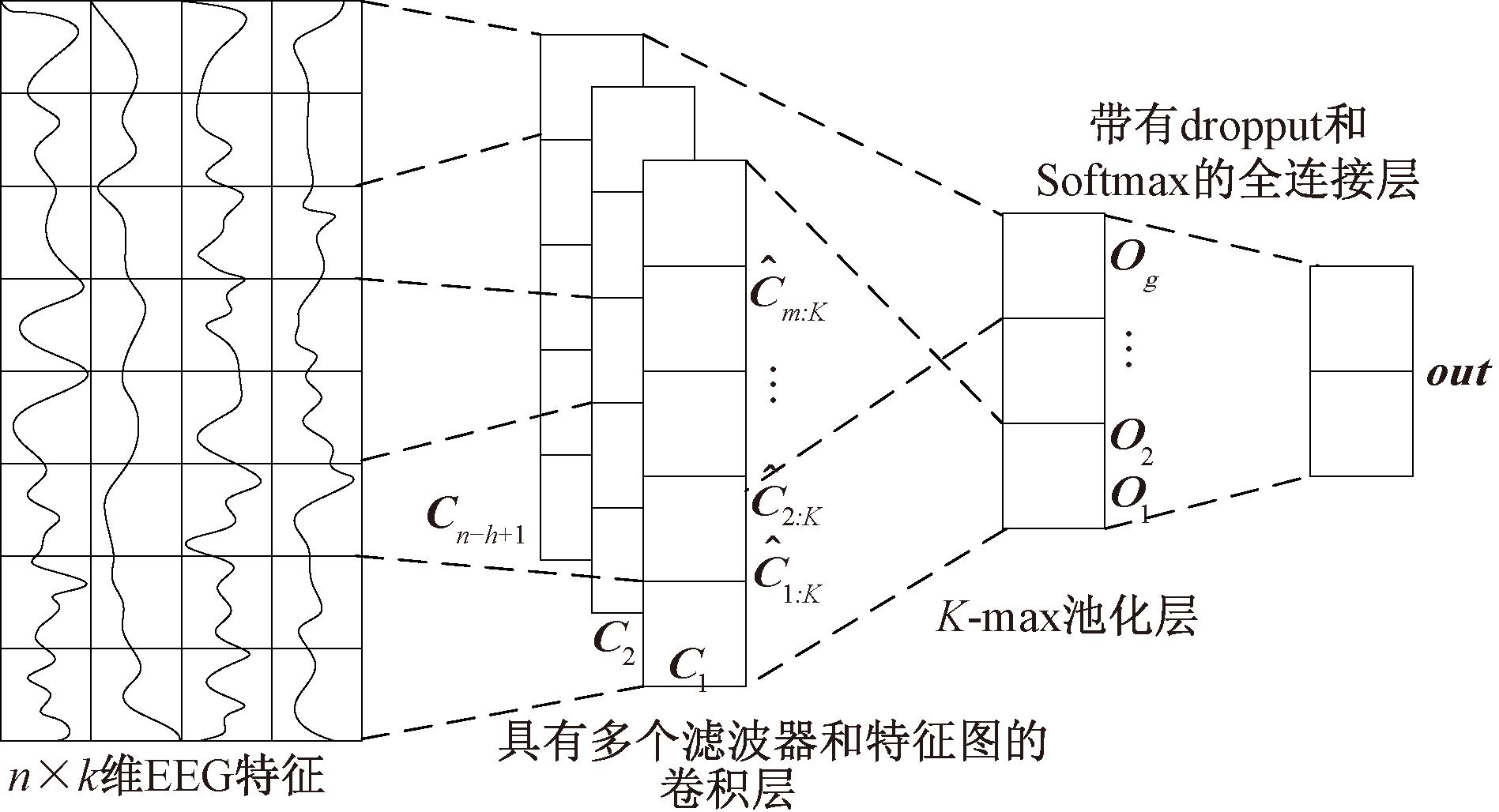

TextCNN由一维卷积层和时序最大池化层组成,为了保留更多重要的特征,这里由K-max池化层替代,其网络结构如图2所示。在一维卷积运算中,卷积窗口从输入数组的最左方开始,按从左往右的顺序,依次在输入数组上滑动。当卷积窗口滑动到某一位置时,窗口中的输入子数组与核数组按元素相乘并求和,得到输出数组中相应位置的元素。

图2 TextCNN网络结构

Figure 2 TextCNN network structure

令xi∈Rk是k通道EEG数据中第i个采样点。这样一个受试者在一张图像上产生的EEG数据可以表示为

x1:n=x1⊕x2⊕…⊕xn。

(1)

式中:⊕为连接运算符。这样,xi:i+j就表示EEG数据采样点xi,xi+1,…,xi+j的连接。一维卷积运算使用一个过滤器w∈Rhk,它应用于h个EEG样本点的窗口,并产生新的EEG特征。例如,一个EEG特征Ci由一个EEG样本点窗口xi:i+h-1生成:

Ci=f(w·xi:i+h-1+b+b)。

(2)

式中:b为偏置项;f(·)为一个非线性函数,如ReLU函数。这个过滤器被用于EEG序列{x1:h,x2:h+1,…,xn-h+1:n}每个可能的样本点窗口,并产生一个EEG特征向量:

C=[C1,C2,…,Cn-h+1]。

(3)

式中:C∈Rn-h+1。然后对C应用K-max池化运算,选取得分最高的前K个特征![]() 这个想法是为每个EEG特征向量捕捉最重要的前K个特征。

这个想法是为每个EEG特征向量捕捉最重要的前K个特征。

一个过滤器有m个输出通道,每个输出通道产生一个EEG特征向量。对每个特征向量应用K-max池化,将所有特征向量结果的前K个值连接起来,得到最后的输出向量:

(4)

TextCNN使用多个不同大小的过滤器获取不同宽度的视野,从而捕捉到不同个数的相邻EEG 的相关性。令有g个过滤器,把它们池化后的向量拼接起来得到:

out=O1⊕O2⊕…⊕Og。

(5)

最后,把out馈入全连接层,再使用Softmax计算,即可得到分类结果。

1.1.3 改进的StackCNN模型

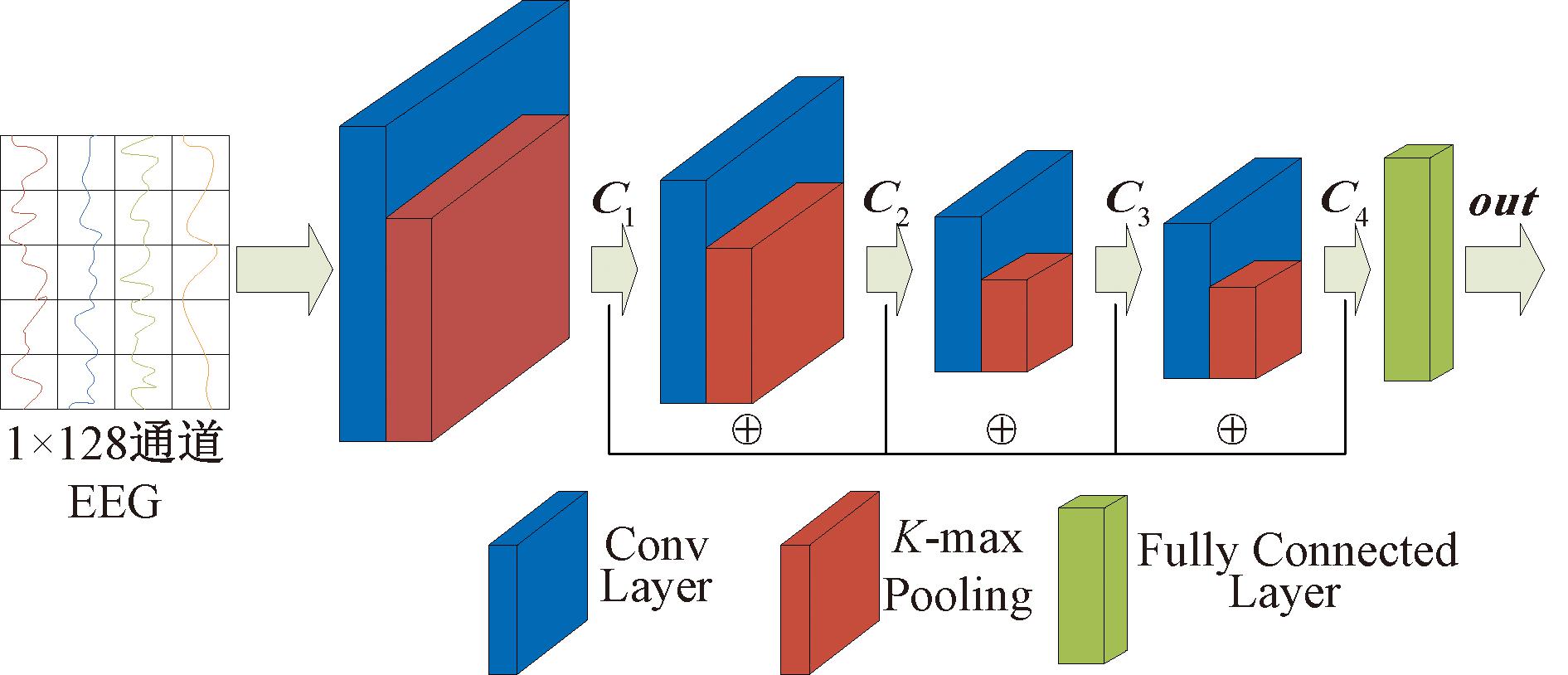

StackCNN和TextCNN不同的地方在于TextCNN的过滤器为横向排列,彼此之间互不干扰,而StackCNN的过滤器为纵向排列,即前一个过滤器的输出作为后一个过滤器的输入,并且StackCNN的结构由堆积的小过滤器[15]构成,这可以增加网络深度以保证学习更复杂的模式,而且代价更小(参数更少)。StackCNN将所有过滤器的输出进行池化运算,同样为了保留更多重要的特征,这里由K-max池化替代普通池化运算,然后,将输出向量连接起来;最后,馈入完全连接层。

StackCNN和VGG[16]网络类似,所有过滤器都使用3×3的小过滤器,填充为1,步幅为1,保证每次输出的特征向量维度和输入维度相同。StackCNN网络结构如图3所示,图3中输入n×k维的EEG,这里n为1,k为128。

图3 StackCNN网络结构

Figure 3 StackCNN network

对于EEG序列{x1:h,x2:h+1,…,xn-h+1:n},假设有l个过滤器,则有:

(6)

式中:Conv(·)为过滤器;b为偏置项。对每个EEG特征图进行K-max池化运算,然后连接起来:

out=max(K,C1)⊕max(K,C2)⊕…⊕

max(K,Cl)。

(7)

StackCNN网络结构中位置靠前的过滤器用于捕捉EEG数据之间的局部相关性,可以看作是学习到了EEG低维特征,而越到后面的过滤器感受野越大,从而捕捉输入上更大尺寸的EEG特征,可以看作是学习到了EEG高维特征。因此,StackCNN可以同时利用低维和高维的特征,这也是它优于Text-CNN的地方。

1.2 改进的Bagging算法

集成学习属于机器学习,是一种训练思路,并不是指某种具体的方法或者算法。集成学习潜在的思想是即便某一个弱分类器得到了错误的预测,其他的弱分类器也可以将错误纠正回来。

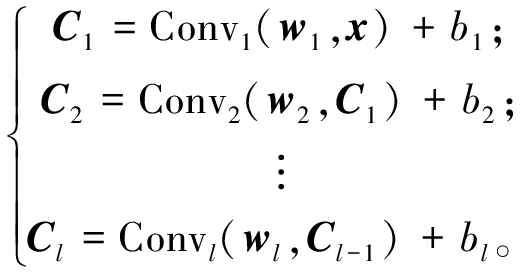

自助法(bootstrapping)和引导聚集算法(bootstrap aggregating,Bagging)均是集成学习领域的一种基本算法[17],均用于确定训练集和测试集,提高训练有效性。Bagging 算法可与其他分类算法、回归算法结合,提高其准确率、稳定性的同时,通过降低结果的方差,避免过拟合的发生。然而,在传统的Bagging算法中,通常使用投票法进行决策,这使得所有的分类器具有相同的决策能力,因而忽略了基分类器的性能差异。本文使用一种改进的Bagging算法[7]进行集成学习,改进的Bagging算法利用基分类器在袋外数据(out of bag, OOB)上每个类别的F1值确定基分类器在每个类别上的权重,在很细的粒度上考虑了每个基分类器的性能差异,同时避免了对性能好的基分类器的过度依赖,OOB指的是训练过程中缺失的数据点,由于这些数据没有参与训练集模型的拟合,因此可以用来检测模型的泛化能力。本文对每个类别的权重定义如下:

(8)

式中:i表示不同的类别(对于本文使用的数据集,i的范围从0到39);λin为第n个最弱分类器对第i个类别的权重分配;OOB_F为类别i上第N个最弱分类器的测试集数据的F值;N为基分类器的数量。此外如果分类器在数据集上的性能越好,λin值则越大。

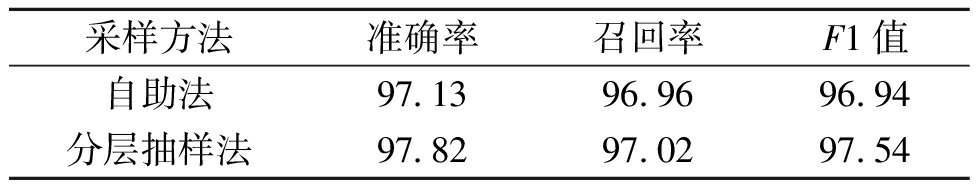

Zheng等[7]在改进的Bagging算法中采用自助法确定训练集和测试集,结果发现,在针对40个类别的图像数据集的实验中,Bagging算法中的分层抽样策略比原先实验取得了更好的效果,如表1所示。因此,本文使用了分层抽样法采样进行训练集和测试集的划分。

表1 自助法与分层抽样法采样结果对比

Table 1 Comparison of sampling results between self service sampling and stratified sampling %

采样方法准确率召回率F1值自助法97.1396.9696.94分层抽样法97.8297.0297.54

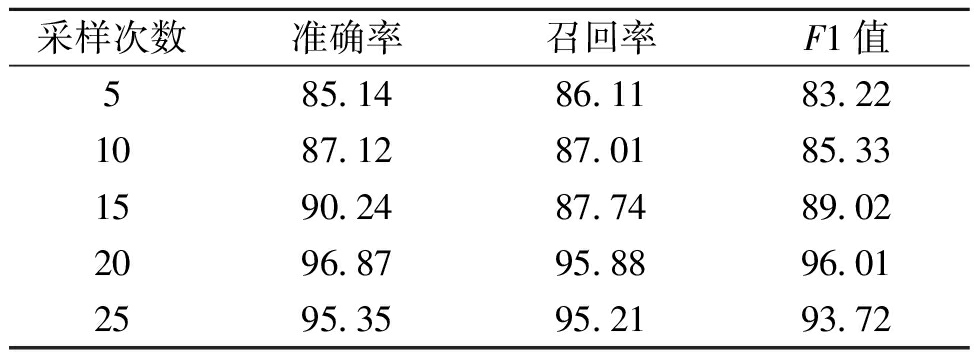

另外,分层抽样法的采样次数是需要仔细考虑的重要因素。过多的采样次数可能导致过拟合,而太少的采样次数则可能导致欠拟合。因此,本文使用k折交叉验证方法来确定最佳采样次数,对于N个基分类器,在k个类别上进行分类,采样10折交叉验证进行分层抽样,如表2所示,从表2中可以看出,当采样次数为20时,所有基分类器的准确率的平均值达到了最佳水平。因此,最佳采样次数为20。

表2 不同采样次数在所有基分类器上的结果对比

(取平均值)

Table 2 Comparison of results across all base classifiers with different sampling frequencies (taking the average) %

采样次数准确率召回率F1值585.1486.1183.221087.1287.0185.331590.2487.7489.022096.8795.8896.012595.3595.2193.72

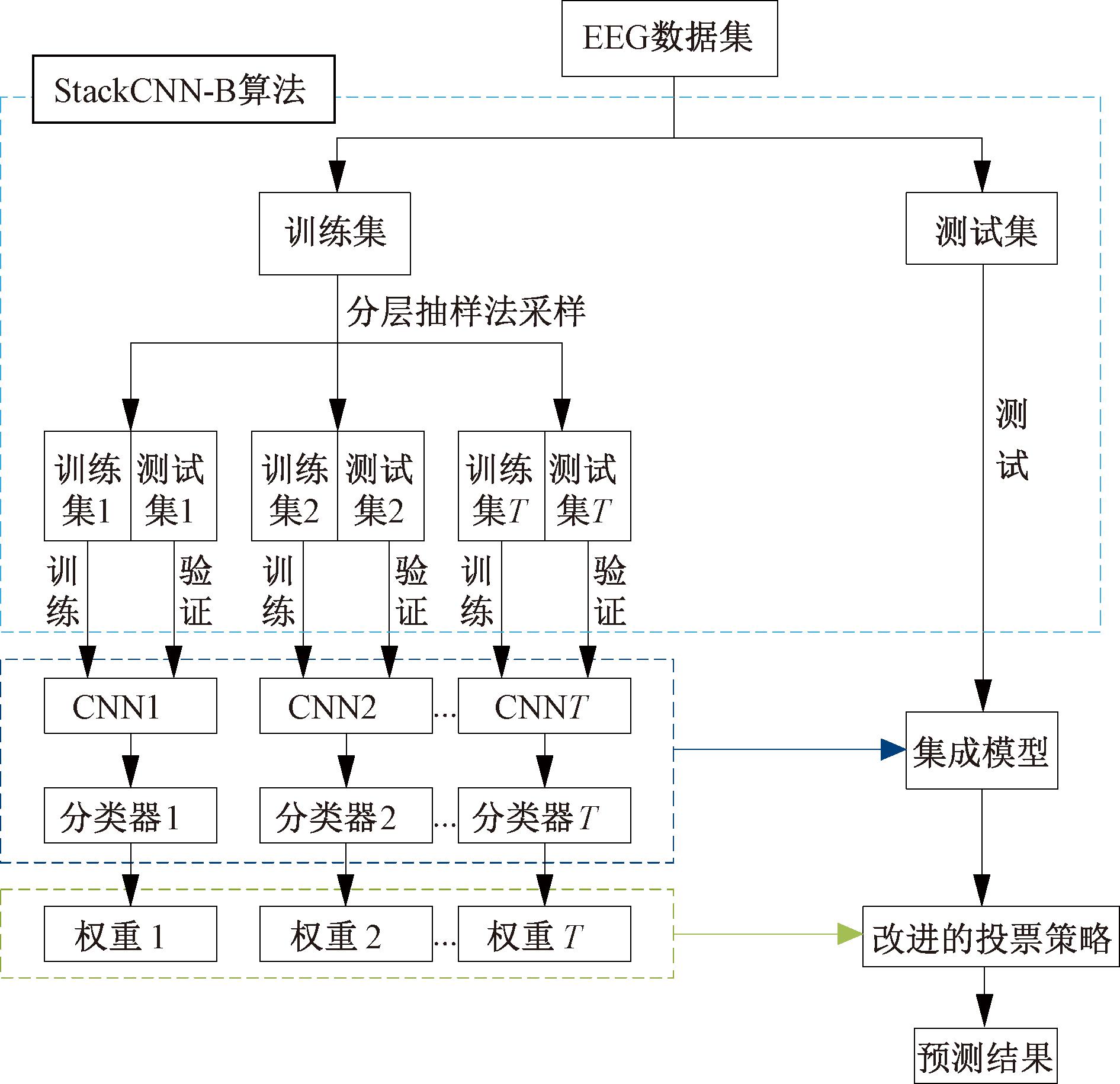

1.3 解码人脑活动的StackCNN-B模型

基于改进的Bagging算法和改进的StackCNN模型,本文提出了StackCNN-B模型,模型数据流图如图4所示。

图4 StackCNN-B模型流程图

Figure 4 StackCNN-B model flow chart

模型具体实现步骤如下。

步骤1 将脑电图像数据分为训练集和测试集两部分。

步骤2 使用Bagging算法从训练集中通过分层抽样获得T个子训练集和测试集。

步骤3 分别训练T个CNN模型,即T个弱分类器,并将结果输入Softmax分类器进行分类。

步骤4 根据训练得到的权重集成模型,使用改进的投票策略在测试集上预测结果。

1.4 EEG特征回归和视觉分类

本模型首先通过使用结合改进的Bagging算法,从EEG数据中提取相关的脑电特征表示用于解码人类的大脑活动;其次,使用原始图像数据集和之前提取到的EEG特征训练基于ResNet的回归,将回归的输出作为特征对图像进行分类,从而实现视觉分类。

完成第一阶段模型的构建和训练后,每个CNN的输出(每个Softmax分类器的输入)可以被看作是EEG的视觉特征向量。为了将集成CNN模型学习到的脑电特征扩展到一般的图像中,需要能够跳过脑电记录阶段,直接从图像中提取与视觉相关的脑电特征。为了实现这一假想,使用ResNet回归从输入的图像中提取近似的EEG特征,ResNet回归由ResNet模型和回归网络组成。ResNet最初是由He等[18]提出,因其简单实用,被广泛应用于图像检测、分割和识别[19]。它将残差学习应用到每一层,解决了由于网络过深神经网络训练困难的问题。ResNet通过引入快捷连接,解决了精度退化,即随着网络层数的加深,训练精度快速降低。

本文采用ResNet-18模型作为脑电特征提取器,它包含17个卷积层和一个完全连接层。基于ResNet-18的训练过程包含两个步骤。第一步,通过预训练的ResNet-18[20]模型提取图像的全局和局部特征;第二步,利用回归方法将图像特征映射到EEG特征向量。本文对比了常见的几种回归方法[21-22]:随机森林回归(random forest regressor)、决策树回归(decision tree regressor)、K邻近回归(K neighbors regressor)、支持向量机回归(support vector regressor)。由于回归层单元数目与CNN模型中学习到的EEG特征维数相同,实现了可以从任意图像中提取脑电信号特征。

获得脑电信号后,使用经过训练的ResNet对测试集进行回归,提取测试图像集的EEG特征,并使用训练过的Softmax分类器对特征进行分类。

2 实验与分析

实验分为两个部分:一是使用基于改进的CNN模型和集成学习相结合的方法学习EEG视觉特征;二是使用基于ResNet的EEG特征回归进行自动视觉分类。

代码使用Pytorch深度学习框架进行模型搭建和训练。实验的具体流程如下。首先,在采集到的EEG数据上训练模型,学习到EEG数据的嵌入表示,再将这个嵌入表示输入到分类器中进行分类;其次,训练一个回归模型将从图像中提取到的特征映射到EEG嵌入上;最后,将提取的特征输出到分类器中进行分类。

2.1 EEG数据集及其预处理

本文使用的数据是由Spampinato等[6]通过实验收集整理所得到的。该实验共有6名参与者(1名女性和5名男性),通过仪器记录参与者的EEG数据。当参与者看到视觉刺激图像时,他们的脑电图信号被记录下来。参与者均由专业医生进行检查,排除可能影响实验数据的身体状况。

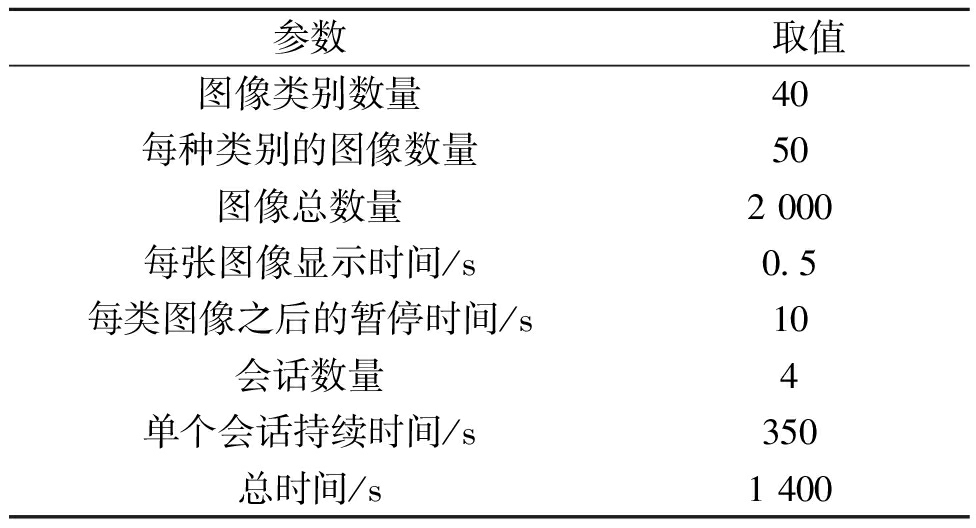

视觉刺激数据集是ImageNet[23]数据集的一个子集,包含40个互不相同且易于识别的类别,共2 000个图像,其中每个类别包含50个图像。在脑电采集过程中,每幅图像显示0.5 s,每一类图像连续显示25 s作为一批。随后,受试者休息10 s,并显示一个黑色图像。黑色图像被用于“清除”上一节实验所产生的大脑活动,其中,受试者观看顺序为线性。因此,每次实验只需1 400 s。实验参数如表3所示,该表来自Spampinato等[6]的视觉分类实验参数。

表3 实验参数

Table 3 Parameters of experimental

参数 取值图像类别数量40每种类别的图像数量50图像总数量2 000每张图像显示时间/s0.5每类图像之后的暂停时间/s10会话数量4单个会话持续时间/s350总时间/s1 400

EEG数据通过一个128通道的有源低噪声电极设备进行采集,且采集过程中使用了脑视觉信号放大器。在运行时设置了陷波滤波器(49~51 Hz)和二阶带通滤波器(截止频率分别为14、71 Hz),使脑电信号包含视觉认知过程中最有价值的频带(β和γ)。采样频率设置为1 000 Hz,数据分辨率为16位。

理论上应该在1 000 Hz的采样频率下对每幅图像产生的脑电信号采集500个采样点。然而,由于许多因素的影响(如硬件系统、软件过程等),从模拟设备采集的数据呈现出不同的大小。为确保序列长度固定,对长度小于500的样本在后面补0,并裁剪那些大于500的序列。在实验中,每一个EEG序列的前40个样本(0~40 ms)被丢弃,以最小化上一个刺激图像的干扰。经过以上处理后,总计使用了460个样本(40~500 ms)。

2.2 使用StackCNN-B学习EEG视觉特征

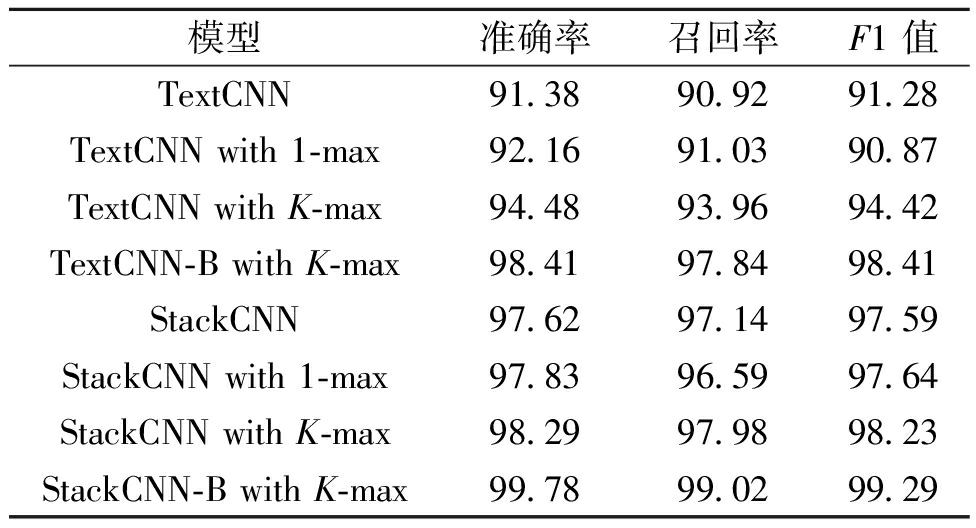

为了验证本文改进CNN算法的泛化能力,以及优化手段的效果,本文分别验证了各方法在视觉刺激数据集上的准确率、F1值和召回率,具体实验结果如表4所示。在实验过程中,具体参数设置如表3所示,利用反向传播(back propagation, BP)算法[24]对每个模型进行训练,然后使用小批量梯度下降算法计算梯度。首先,将数据集按8∶2的比例随机分为训练集和测试集,其中训练集有1 600幅图像,测试集有400幅图像;其次,确保所有6名参与者对同一幅图像记录的脑电图被分割成相同的部分;最后,对训练集进行10次随机抽样。各个模型之间的对比情况如表4所示。

表4 最佳参数模型的结果

Table 4 Results of the best parameter model %

模型准确率召回率F1 值TextCNN91.3890.9291.28TextCNN with 1-max92.1691.0390.87TextCNN with K-max94.4893.9694.42TextCNN-B with K-max98.4197.8498.41StackCNN97.6297.1497.59StackCNN with 1-max97.8396.5997.64StackCNN with K-max98.2997.9898.23StackCNN-B with K-max99.7899.0299.29

由表4可知,StackCNN网络加入K-max池化和Bagging算法后,在准确率和F1值上都优于其他模型。该结果证明K-max池化和Bagging算法对CNN网络有很好的提升作用。并且StackCNN在视觉分类问题中明显优于TextCNN,这说明StackCNN不仅能捕捉低维的特征,而且随着过滤器感受野的变大,还能捕捉更高维的特征。

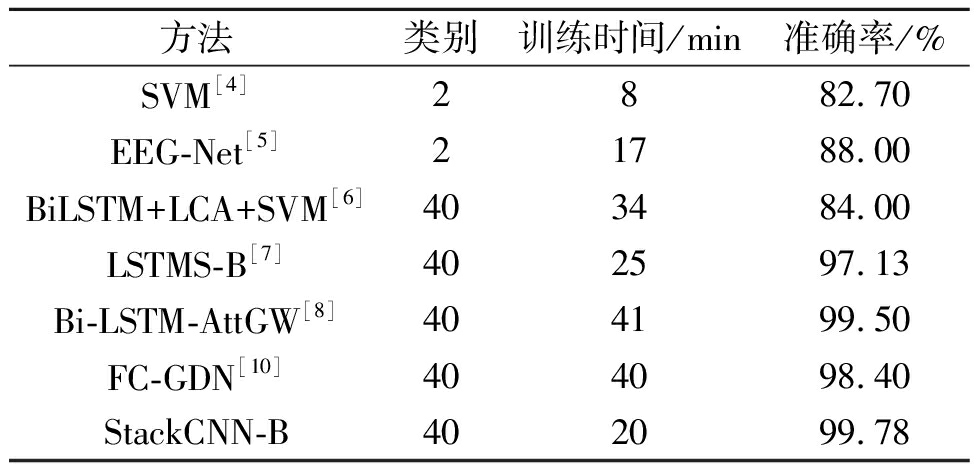

为进一步验证模型的有效性,本文使用视觉刺激数据集再次进行实验,与现有其他EEG特征提取方法对比,实验结果如表5示。

表5 StackCNN-B方法与其他方法的比较

Table 5 Comparison between StackCNN-B method and other methods

方法类别训练时间/min准确率/%SVM[4]2882.70EEG-Net[5]21788.00BiLSTM+LCA+SVM[6]403484.00LSTMS-B[7]402597.13Bi-LSTM-AttGW[8]404199.50FC-GDN[10]404098.40StackCNN-B402099.78

El-lone等[4]利用经典的支持向量机分类器对脑电信号进行生物和非生物的二分类,分类准确率达到82.70%。Parekh[5]采用基于CNN的带离群点去除的EEG网络结构对两类EEG信号进行分类,得到了88.00%的准确率。Zheng等[8]采用了基于注意力的Bi-LSTM方法对40类EEG信号进行分类,获得了99.50%的准确率。此外,本研究还使用了与文献[6-7,10]相同的脑电图数据集以及类似的流程进行实验,在分类准确率和分类类别上,本文方法StackCNN-B取得了更好的效果。

由表5可知,本文提出的模型在对于EEG信号分类的准确率和分类数目上明显优于其他模型。分析表5可知,深度学习的算法明显优于机器学习,因为本实验所用的数据集十分庞大;LSTM与Bagging结合的算法优于BiLSTM算法,这说明Bagging算法具有较好的泛化能力,这也是本模型使用Bagging算法的原因。本实验提出的改进的StackCNN模型优于LSTM模型,虽然两种模型均适合应用于时序序列,但StackCNN使用多个较小的过滤器增加网络深度,不仅可以捕捉到高维的特征,而且实验所需的参数量远小于LSTM模型,因此训练时间更短。结果表明,本文所提出的模型在各方面均表现优异。

2.3 基于ResNet的特征回归与视觉自动分类

基于ResNet的回归分析旨在将视觉图像映射到学习的EEG特征向量上。本文使用CNN提取脑电特征,然后对大脑视觉活动进行分类。对于每个图像,可以从每个CNN模型获得一个EEG特征向量。将基于ResNet的回归作为一个图像的输入,并希望它的输出能够尽可能类似于CNN的输出。

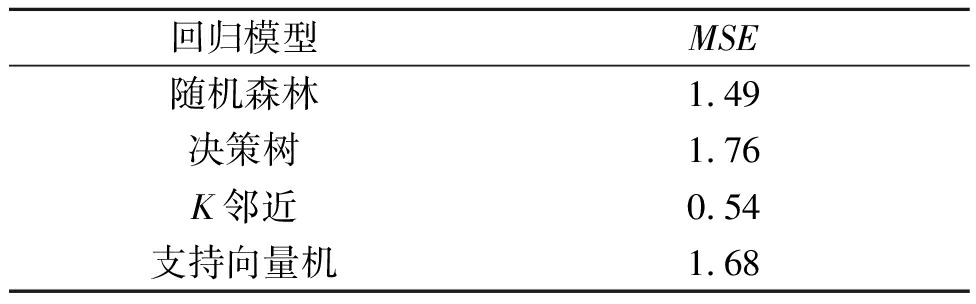

为了验证该回归的性能,本实验使用与激发EEG信号相同的图像集,并按照上文所提到的分层抽样法将图像数据集分为训练集和测试集,本文采用均方误差MSE评估4种不同的回归方法的性能,如表6所示。根据表6的数据可以观察到K邻近回归的均方误差最小,于是将K邻近作为本文的回归模型,用于作为图像的特征提取器,并映射到EEG特征向量。

表6 4种回归模型的MSE对比

Table 6 MSE comparison of four regression models

回归模型MSE随机森林1.49决策树1.76K邻近0.54支持向量机1.68

为了验证本文提出的StackCNN-B在图像分类上的应用价值,使用ResNet回归对提取到的脑电信号相关的视觉特征表示和原始图像数据集进行训练,再将基于ResNet回归的输出作为特征对图像进行分类,如表7所示。将ResNet回归应用到其他模型上,相对比之下,基于StackCNN-B模型的图像分类平均准确率更高,表明了集成深度学习方法在自动视觉分类中具有良好的性能和良好的应用价值。再次证明本模型能更好地学习到EEG的特征表示,从而使得回归器能够更好地利用EEG的数据进行图像分类。

表7 基于ResNet回归不同模型关于图像分类性能比较

Table 7 Performance comparison of different models for image classification based on ResNet regression

方法准确率/%BiLSTM+LCA+SVM[6]89.70LSTMS-B[7]90.16Bi-LSTM-AttGW[8]93.48FC-GDN[10]92.18StackCNN-B96.45

3 结论

本文设计了一种改进的StackCNN网络和集成学习相结合的方法,用于学习脑电信号相关的视觉特征表示,采用深度残差网络对提取到的脑电信号相关的视觉特征表示和原始图像数据集进行训练,实现视觉图像分类。使用分层抽样法对训练集和测试集划分,将改进的 StackCNN网络与Bagging算法结合提取脑电信号视觉特征,在此基础上训练基于ResNet-18的回归实现对原始图像的视觉分类,在ImageNet公开数据集上测试的结果表明,本文方法分类准确率均优于现有研究方法。证明本文提出的StackCNN-B模型在视觉分类中具有良好的性能和巨大的应用价值。

[1] DAS K, GIESBRECHT B, ECKSTEIN M P. Predicting variations of perceptual performance across individuals from neural activity using pattern classifiers[J]. NeuroImage, 2010, 51(4): 1425-1437.

[2] CARLSON T, TOVAR D A, ALINK A, et al. Representational dynamics of object vision: the first 1000 ms[J]. Journal of Vision, 2013, 13(10): 1.

[3] KANESHIRO B, PERREAU GUIMARAES M, KIM H S, et al. A representational similarity analysis of the dynamics of object processing using single-trial EEG classification[J]. PLoS One, 2015, 10(8): e0135697.

[4] EL-LONE R, HASSAN M, KABBARA A, et al. Visual objects categorization using dense EEG: a preliminary study[C]∥2015 International Conference on Advances in Biomedical Engineering (ICABME). Piscataway: IEEE, 2015: 115-118.

[5] PAREKH V, SUBRAMANIAN R, ROY D, et al. An EEG-based image annotation system[M]∥Communications in Computer and Information Science. Berlin: Springer, 2018: 303-313.

[6] SPAMPINATO C, PALAZZO S, KAVASIDIS I, et al. Deep learning human mind for automated visual classification[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway: IEEE, 2017: 4503-4511.

[7] ZHENG X, CHEN W Z, YOU Y, et al. Ensemble deep learning for automated visual classification using EEG signals[J]. Pattern Recognition, 2020, 102: 107147.

[8] ZHENG X, CHEN W Z. An attention-based Bi-LSTM method for visual object classification via EEG[J]. Biomedical Signal Processing and Control, 2021, 63: 102174.

[9] MISHRA A, RAJ N, BAJWA G. EEG-based image feature extraction for visual classification using deep learning[C]∥2022 International Conference on Intelligent Data Science Technologies and Applications (IDSTA). Piscataway: IEEE, 2022: 181-188.

[10] KHALEGHI N, REZAII T Y, BEHESHTI S, et al. Developing an efficient functional connectivity-based geometric deep network for automatic EEG-based visual decoding[J]. Biomedical Signal Processing and Control, 2023, 80: 104221.

[11] SHU B, REN F J, BAO Y W. Investigating LSTM with k-max pooling for text classification[C]∥2018 11th International Conference on Intelligent Computation Technology and Automation (ICICTA). Piscataway: IEEE, 2018: 31-34.

[12] KIM Y. Convolutional neural networks for sentence classification[C]∥Proceedings of the 2014 Conference on Empirical Methods in Natural Language Processing (EMNLP). Stroudsburg: ACL, 2014: 1746-1751.

[13] GUO B, ZHANG C X, LIU J M, et al. Improving text classification with weighted word embeddings via a multi-channel TextCNN model[J]. Neurocomputing, 2019, 363: 366-374.

[14] 周澳回, 翁知远, 周思源, 等. 一种基于主题过滤和语义匹配的服务发现方法[J]. 郑州大学学报(工学版), 2022, 43(6): 36-41, 56.ZHOU A H, WENG Z Y, ZHOU S Y, et al. A service discovery method based on topic filtering and semantic matching[J]. Journal of Zhengzhou University (Engineering Science), 2022, 43(6): 36-41, 56.

[15] MONTANARO A, EBISUZAKI T, BERTAINA M. Stack-CNN algorithm: a new approach for the detection of space objects[J]. Journal of Space Safety Engineering, 2022, 9(1): 72-82.

[16] SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[EB/OL]. (2014-09-04)[2023-07-15].http:∥doi.org/10.48550/arXiv.1409.1556.

[17] BAUER E, KOHAVI R. An empirical comparison of voting classification algorithms: Bagging, boosting, and variants[J]. Machine Learning, 1999, 36(1): 105-139.

[18] HE K M, ZHANG X Y, REN S Q, et al. Deep residual learning for image recognition[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway: IEEE, 2016: 770-778.

[19] WU Z F, SHEN C H, VAN DEN HENGEL A. Wider or deeper: revisiting the ResNet model for visual recognition[J]. Pattern Recognition, 2019, 90: 119-133.

[20] DUBEY V K, SARKAR S, SHUKLA R, et al. Epileptic seizure stage classification from EEG signal using ResNet18 model and data augmentation[C]∥2022 IEEE Delhi Section Conference (DELCON). Piscataway: IEEE, 2022: 1-5.

[21] 杨剑锋, 乔佩蕊, 李永梅, 等. 机器学习分类问题及算法研究综述[J]. 统计与决策, 2019, 35(6): 36-40.YANG J F, QIAO P R, LI Y M, et al. A review of machine-learning classification and algorithms[J]. Statistics &Decision, 2019, 35(6): 36-40.

[22] SHAH K, PATEL H, SANGHVI D, et al. A comparative analysis of logistic regression, random forest and KNN models for the text classification[J]. Augmented Human Research, 2020, 5(1): 12.

[23] RUSSAKOVSKY O, DENG J, SU H, et al. ImageNet large scale visual recognition challenge[J]. International Journal of Computer Vision, 2015, 115(3): 211-252.

[24] 郝旺身, 陈耀, 孙浩, 等. 基于全矢-CNN的轴承故障诊断研究[J]. 郑州大学学报(工学版), 2020, 41(5): 92-96.HAO W S, CHEN Y, SUN H, et al. Bearing fault diagnosis based on full vector-CNN[J]. Journal of Zhengzhou University (Engineering Science), 2020, 41(5): 92-96.