知识图谱(knowledge graph,KG)是Google公司于2012年提出的用于提高搜索引擎速度的概念[1]。其中包括了丰富的社会多元关系数据,并广泛地运用在人类社会的各种生产任务当中。现有的知识图谱如Freebase[2]、YAGO[3]等,都包括了大量由事实所构成的三元组,而这种三元组一般以(头实体,关系,尾实体)的形式表示,即(h,r,t)。在工作生产中,这种以图结构表示的知识在诸多下游应用中具有重要作用,包括语义搜索[4]、智能问答[5]以及个性化推荐[6]等领域。然而,知识图谱仍然存在事实不完整的问题,为了解决这个问题,有必要通过知识图谱补全(knowledge graph completion,KGC)来自动推导和填充缺失的事实,进一步提高知识图谱的利用价值。

近年来,相关研究者针对KGC任务提出了许多基于知识图嵌入技术[7]的知识图谱补全模型,在一定程度上解决了知识图谱实体和关系不完整的问题。但实际背景下,传统知识图谱补全模型不能很好地解决不常见的实体和关系的知识图谱补全问题。相关研究者提出多种小样本的知识图谱补全(few-shot knowledge graph completion,FKGC)方法。在FKGC任务上,基线模型都取得了很好的结果,但这些方法还存在一些不足。

1 相关工作

知识图谱补全任务是指通过自动推理和学习的方式填补知识图谱中缺失的实体、关系和属性等信息。目前,基于知识图谱嵌入的补全方法主要有如下3类:基于翻译模型的方法、基于语义匹配的方法以及基于神经网络的方法。基于翻译模型的方法是将关系看作实体对之间的翻译操作,并通过距离评分函数来判断实体和关系之间是否存在关联。如TransE[8]是一个经典的翻译模型,将关系视为头实体到尾实体的翻译过程,从而有效地应对大规模的知识图谱补全任务。基于语义匹配的方法是使用基于相似性的评分函数来挖掘实体和关系之间的潜在语义,以解决知识图谱补全任务。如DISTMULT[9]模型将关系矩阵限制为对角阵简化模型,但也导致其不能处理非对称关系。ComplEx[10]模型使用复向量来表示实体和关系,能够有效地建模多种二元关系。相较基于翻译模型的方法,基于语义匹配的方法能够更好地捕捉实体间的隐含语义。基于神经网络的方法利用神经网络强大的学习能力和表达能力进行建模。如GATs[11]通过聚合知识图谱中的路径信息和图结构数据来捕捉信息,使用图注意力网络的注意力机制为不同邻居节点分配不同权重来达到捕捉最关键的邻居节点信息的目的。

传统的知识图谱补全方法需要大量的训练实例来提高模型准确率,当知识图谱无法为这些新增事实提供足够的训练实例时,模型的推理结果会受到极大的限制。因此,相关研究人员开始探究在只有少量实例的情况下进行知识图谱补全任务。

在FKGC任务中,由Xiong等[12]提出的GMatching模型首次定义了小样本知识图谱补全问题。使用基于度量学习的方法,通过邻域中的一条邻居结构获得嵌入表征,使用LSTM网络将嵌入表征与目标匹配进而得到相似度分数来度量查询三元组与参考集的相似性。然而,GMatching对邻居信息并未进行区分,引入了噪声问题。FSRL[13]可以有效地从异构图结构中捕获知识,聚合少量样本的表示,并利用异构邻居解码器给邻域信息分配不同的权重。但上述2种模型并未充分考虑知识图谱中的实体和关系具有动态属性的这一特点。FAAN[14]考虑了实体和关系的动态属性,通过注意力机制捕获不同任务中发生变化的动态特征,以提高其细粒度语义表示。另一方面,MetaR[15]与上述利用邻域信息增强实体嵌入的方法不同,其采用了包括梯度元和关系元的元学习框架进行FKGC任务,有效地提升了模型的学习能力。GANA[16]对MetaR进行了改进,通过采用全局-局部框架有效地过滤了邻域中的噪声信息,并且优化了在知识图谱中涉及一对多、多对一和多对多等复杂关系问题的表现。

在FKGC任务中,上述模型都取得了很好的结果,但这些方法还存在一些不足:①FAAN[14]使用注意力机制聚合邻域信息时,并没有很好地将高阶邻域实体的有效信息利用起来,同时针对不同邻居信息的重要性带来的噪声问题没有妥善解决;②FSRL[13]简单地使用循环自编码器聚合少量的参考集,但随着训练次数的增加会导致关系嵌入对实体的依赖,造成关系过拟合的问题,从而降低了模型的泛化性;③FSRL在进行匹配查询时,未充分考虑TransE[8]模型的平移性对匹配精度造成的影响;④以往的方法并未充分考虑上下文语义对实体对表示的影响,从而降低了链接预测的准确性。

针对上述问题,本文提出一种基于关系学习的小样本知识图谱补全模型(few-shot relation learning completion,FRLC),该模型通过学习实体和小样本关系的细粒度语义表示,达到小样本知识图谱补全的目的。

2 模型设计与实现

2.1 问题描述

知识图![]() 由多种事实组成,每个事实可以用三元组集合

由多种事实组成,每个事实可以用三元组集合![]() ={(h,r,t)⊆ε×

={(h,r,t)⊆ε×![]() ×ε}来表示,其中ε表示实体集合,

×ε}来表示,其中ε表示实体集合,![]() 表示关系集合。本文研究的是给定头实体h和关系r预测尾实体t。

表示关系集合。本文研究的是给定头实体h和关系r预测尾实体t。

基于上述定义,小样本知识图谱补全任务可定义为给定一个任务关系r和它的参考集Sr={(hi,ti)|(hi,r,ti)∈ε×![]() ×ε}i,根据知识图

×ε}i,根据知识图![]() 和参考集Sr提供的信息,并利用查询三元组(hj,r,?)中的头实体hj和任务关系r的链接,预测尾实体tj。其中|Sr|=K,通常K值很小,故称为小样本知识图谱补全[12]。因为小样本知识图谱补全是一个特定的关系任务,所以在知识图

和参考集Sr提供的信息,并利用查询三元组(hj,r,?)中的头实体hj和任务关系r的链接,预测尾实体tj。其中|Sr|=K,通常K值很小,故称为小样本知识图谱补全[12]。因为小样本知识图谱补全是一个特定的关系任务,所以在知识图![]() ={(h,r,t)⊆ε×

={(h,r,t)⊆ε×![]() ×ε}中,关系

×ε}中,关系![]() 分为

分为![]() br,

br,![]() task。其中

task。其中![]() br为背景知识图

br为背景知识图![]() ′中的关系集,背景知识图

′中的关系集,背景知识图![]() ′为知识图

′为知识图![]() 移除所有任务关系的子图;

移除所有任务关系的子图;![]() task为任务关系集,其中包括

task为任务关系集,其中包括![]() train、

train、![]() validation、

validation、![]() test,分别在FKGC任务的元训练(meta-train)、元验证(meta-validation)以及元测试(meat-test)3个阶段使用。

test,分别在FKGC任务的元训练(meta-train)、元验证(meta-validation)以及元测试(meat-test)3个阶段使用。

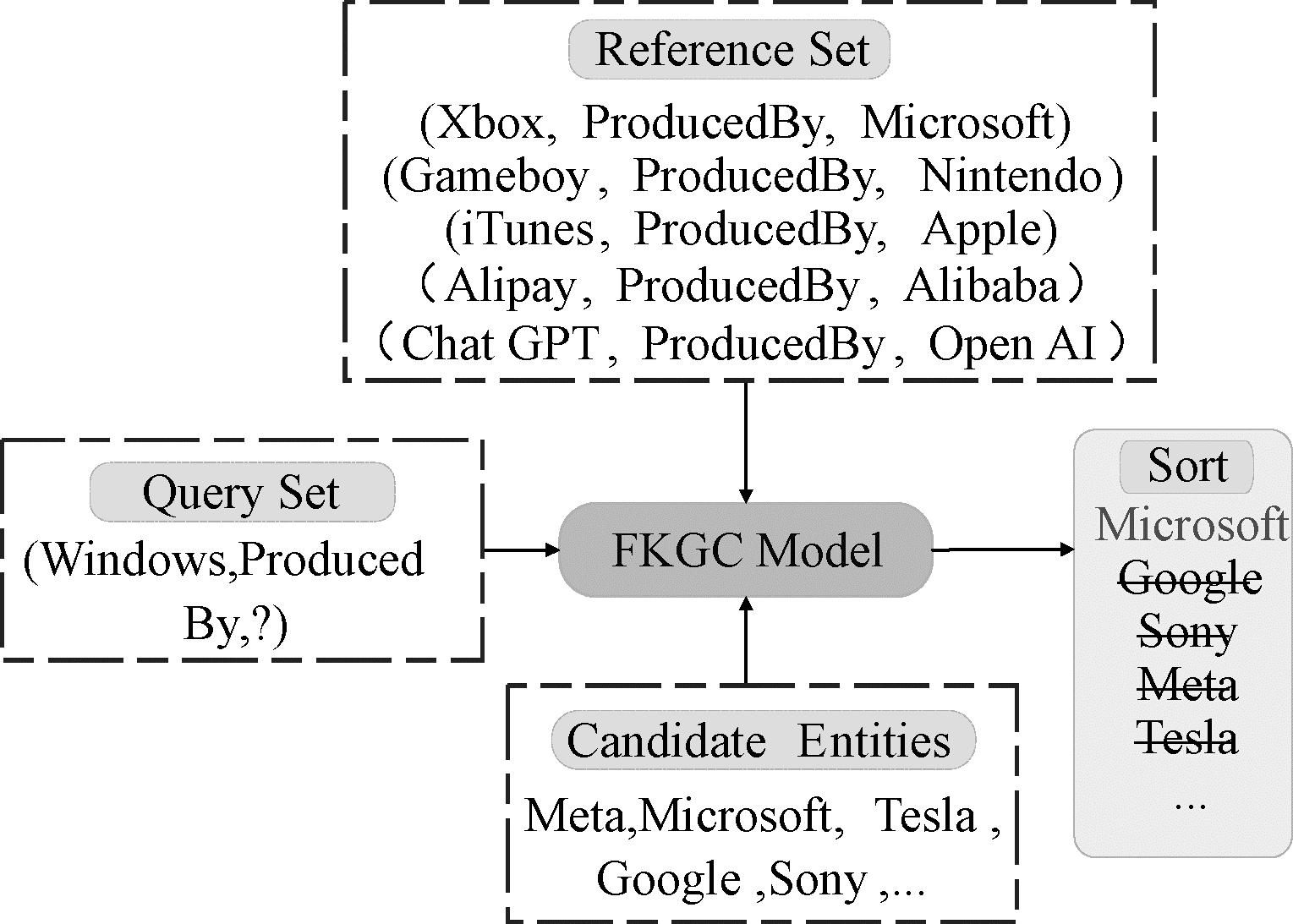

图1给出了一个5-shot KGC任务示例。在小样本知识图谱补全任务中,查询三元组(Windows,ProducedBy,?)的参考集有5个关联三元组,利用参考集为查询三元组(Windows,ProducedBy,?)匹配正确的尾实体。即真实尾实体Microsoft的排名要高于其他尾实体。通过少量的参考信息预测新的事实,就是FKGC任务的核心。

图1 5-shot KGC示例

Figure 1 An example of 5-shot KGC task

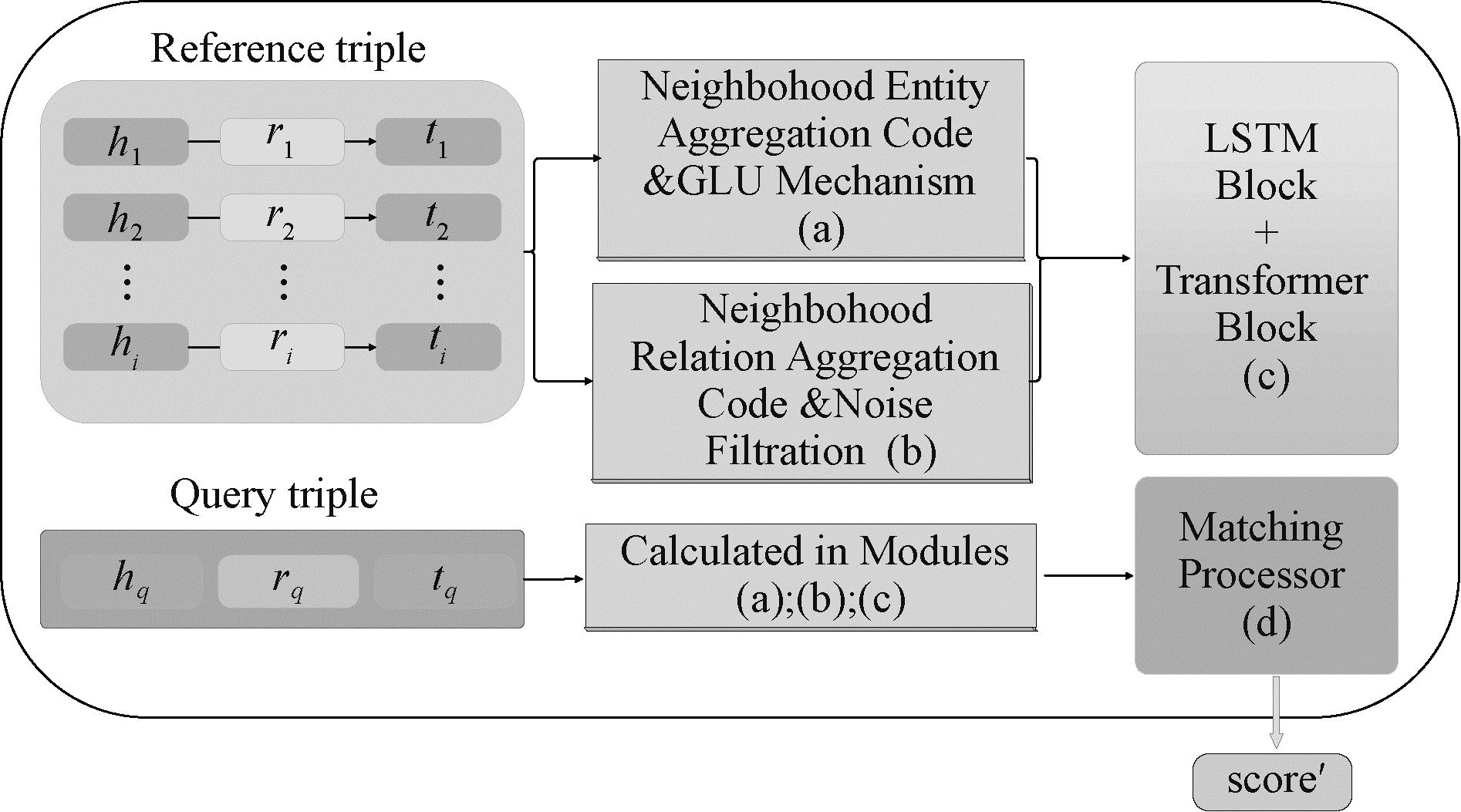

本文提出的FRLC模型是通过利用背景知识图谱以及知识图谱结构信息来训练学习,并实现小样本关系的尾实体预测。FRLC的整体框架如图2所示,其中包括:基于门控机制的高阶邻域实体编码器,使实体自适应地聚合邻域信息;关系表示编码器,利用参考集实体对的邻居关系信息,达到降低关系对于实体嵌入依赖性的目的,提高模型泛化性;Transformer 学习器,将LSTM单元与Transformer模块结合,进一步学习任务关系表示;匹配处理计算,利用Transformer 学习器输出的关系语义嵌入,并计算与查询关系的相似性,预测新的三元组。

图2 FRLC模型的整体框架

Figure 2 Overview of the FRLC framework

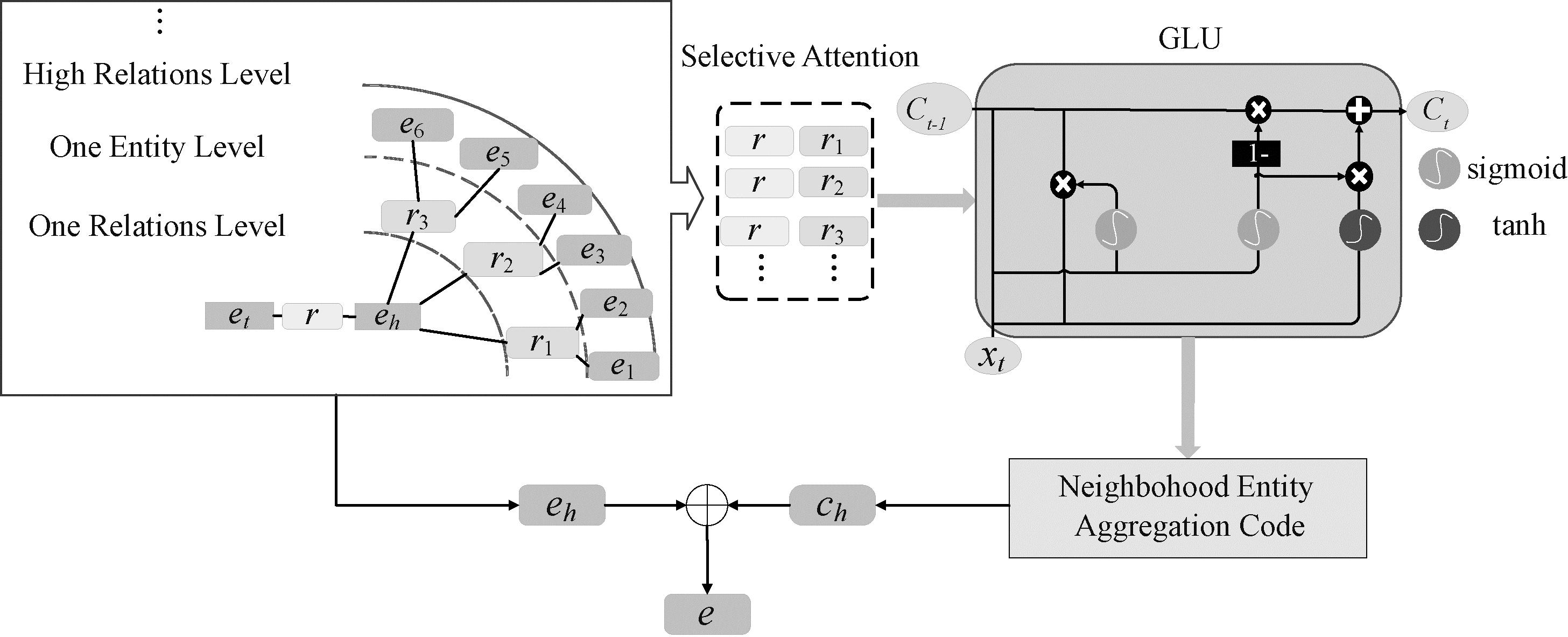

2.2 基于门控机制的高阶邻域实体编码器

在知识图谱中,实体的异构邻居对实体的表示有不同的影响,根据任务关系r自适应聚合邻域信息能够提高中心实体的表达质量。但这种方法没有将高阶邻域的实体信息聚合到中心实体,并且忽略了有用邻居和无用邻居对中心实体的编码影响。基于此,本文设计了一个基于门控机制的高阶邻域实体编码器,拓展了FAAN[14]模型的“自适应邻域编码器”,在一阶邻域的基础上拓展到高阶邻域,并且加入了门控机制。在提高实体的表达性的同时减少噪声邻居对中心实体编码更新的影响。基于门控机制的高阶邻域实体编码器的主要结构如图3所示。

图3 基于门控机制的高阶邻域实体编码器

Figure 3 High order neighborhood entity encoder based on gating mechanism

给定任务三元组(h,r,t),假设实体h为目标实体,通过高阶邻域实体编码器更新它的编码。定义实体h的高阶邻域为![]() 其中

其中![]() ′表示背景知识图;

′表示背景知识图;![]() 和

和![]() 表示实体h的第i个高阶邻居关系以及对应的尾实体。为了量化实体h的特征,首先使用度量函数φo(·)计算参考关系r与实体h的相邻高阶关系

表示实体h的第i个高阶邻居关系以及对应的尾实体。为了量化实体h的特征,首先使用度量函数φo(·)计算参考关系r与实体h的相邻高阶关系![]() 的相似性:

的相似性:

(1)

式中:r为任务关系r的初始特征;![]() 为高阶相邻关系

为高阶相邻关系![]() 的预训练嵌入;W和b分别为权重和偏置参数;φo(·)为双线性点积函数。

的预训练嵌入;W和b分别为权重和偏置参数;φo(·)为双线性点积函数。

根据高阶邻域编码的相似性得分φo(·),得到较高分数的实体![]() 赋予较大注意力得分。为了进一步提高实体h的表达质量,降低噪声邻居的影响,为更重要的邻居分配更高的权重。在计算邻居权重的过程引入“门控机制”自适应计算权重αi:

赋予较大注意力得分。为了进一步提高实体h的表达质量,降低噪声邻居的影响,为更重要的邻居分配更高的权重。在计算邻居权重的过程引入“门控机制”自适应计算权重αi:

(2)

(3)

式中:门控机制函数G(·)通过计算中心实体和邻居实体的内积;n为中心实体ho与邻居实体![]() 最大相邻阶;o代表第o阶。G(·)将ho和

最大相邻阶;o代表第o阶。G(·)将ho和![]() 作为输入,输出表示邻域与中心实体相关性的度量值,softmax(·)将输入转换为邻居的概率分布。

作为输入,输出表示邻域与中心实体相关性的度量值,softmax(·)将输入转换为邻居的概率分布。

为了更好地捕捉特定任务关系,引入了一个可学习的任务关系R,用于更新任务关系![]() :

:

(4)

式中:![]() 为更新后的任务关系。由此,可以获得中心实体h的邻域编码ch:

为更新后的任务关系。由此,可以获得中心实体h的邻域编码ch:

(5)

式中:GLU(·)为门控线性单元激活函数。最后,利用邻域编码器的输出和中心实体的初始特征自适应更新实体表示:

e=σ(w1·ch+w2·eh)。

(6)

式中:σ(·)为sigmoid激活函数;h为中心实体的初始化特征;w1、w2为可学习参数;e为中心实体h更新后的实体嵌入。此实体更新步骤应用于参考集和查询集的所有实体。本文提出的高阶邻域实体编码器考虑了高阶邻域实体的邻居所蕴含的信息,并引入门控机制,针对特定任务关系的噪声邻居进行过滤。本方法将高阶邻域的范围设置为3,因为过低的范围将丢失大量的隐藏信息,但过高的范围将降低模型的性能。

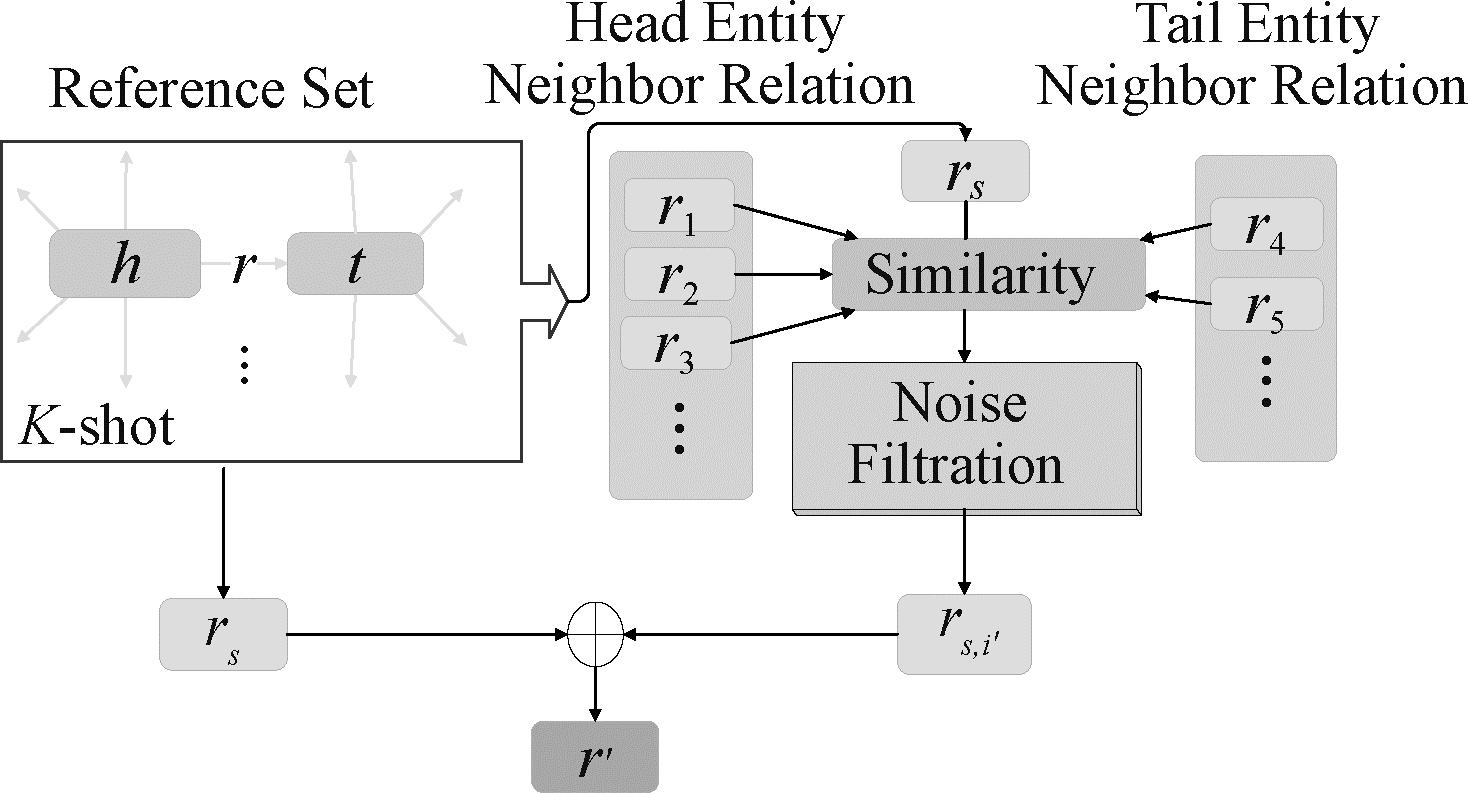

2.3 关系表示编码器

通过上述步骤,对参考集和查询集的实体进行了编码,以获得它们的表示h和t。将参考集的原型关系rs用hs和ts相连接起来的方式表达:

rs≈hs+ts。

(7)

然而,大部分的FKGC方法都只是简单地将实体对的平均嵌入作为关系的表示,并未充分利用参考集中的实体对之间的相关性。使用参考集中实体对的邻居关系能够丰富当前关系的语义表达,降低关系对于实体嵌入的依赖性,提高泛化性。关系表示编码器的主要结构如图4所示。

图4 关系表示编码器

Figure 4 Relationship representation encoder

首先,为了表示参考集中第i个实体对(hi,ei)的头实体hi和尾实体ei的邻居关系,将参考集实体对邻居关系定义为![]()

![]() }。将邻居关系集合中的关系r表示为

}。将邻居关系集合中的关系r表示为

Ers,i={Er|r∈Sr}。

(8)

式中:Ers,i为集合![]() 中第i个邻居关系rs的表示。在丰富当前关系的语义表达的同时,降低噪声的影响。使用特征向量的点积相似度计算Ers,i与参考集原型关系rs的相似性:

中第i个邻居关系rs的表示。在丰富当前关系的语义表达的同时,降低噪声的影响。使用特征向量的点积相似度计算Ers,i与参考集原型关系rs的相似性:

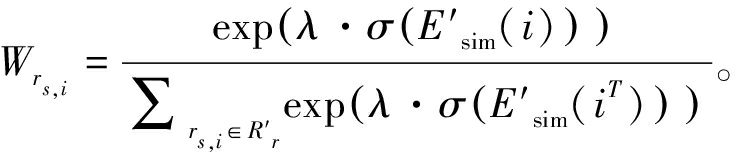

(9)

式中:Esim(i)表示第i个邻居关系rs的相似性分数,本文只保留相似分数最高的T个邻居关系。为此,使用噪声过滤的方式,过滤掉相似分数较低的,方法为

(10)

式中:函数Top(·)返回的是Esim(i)中相似性得分最高的T个(本文T设置为3)邻居关系;![]() 表示噪声过滤后的邻居关系。接下来,根据噪声过滤后的邻居关系

表示噪声过滤后的邻居关系。接下来,根据噪声过滤后的邻居关系![]() 进行编码:

进行编码:

(11)

(12)

式中:![]() 为融合了参考集实体对中噪声最小的邻居关系的表示;Wrs,i为编码过程中的权重;

为融合了参考集实体对中噪声最小的邻居关系的表示;Wrs,i为编码过程中的权重;![]() 为参考集实体对中每个邻居关系的表示;λ为一个学习参数;σ(·)为激活函数。最后,将参考集的原型关系rs和

为参考集实体对中每个邻居关系的表示;λ为一个学习参数;σ(·)为激活函数。最后,将参考集的原型关系rs和![]() 融合:

融合:

(13)

式中:σ(·)为激活函数;w1、w2均为可学习的参数。

2.4 Transformer学习器

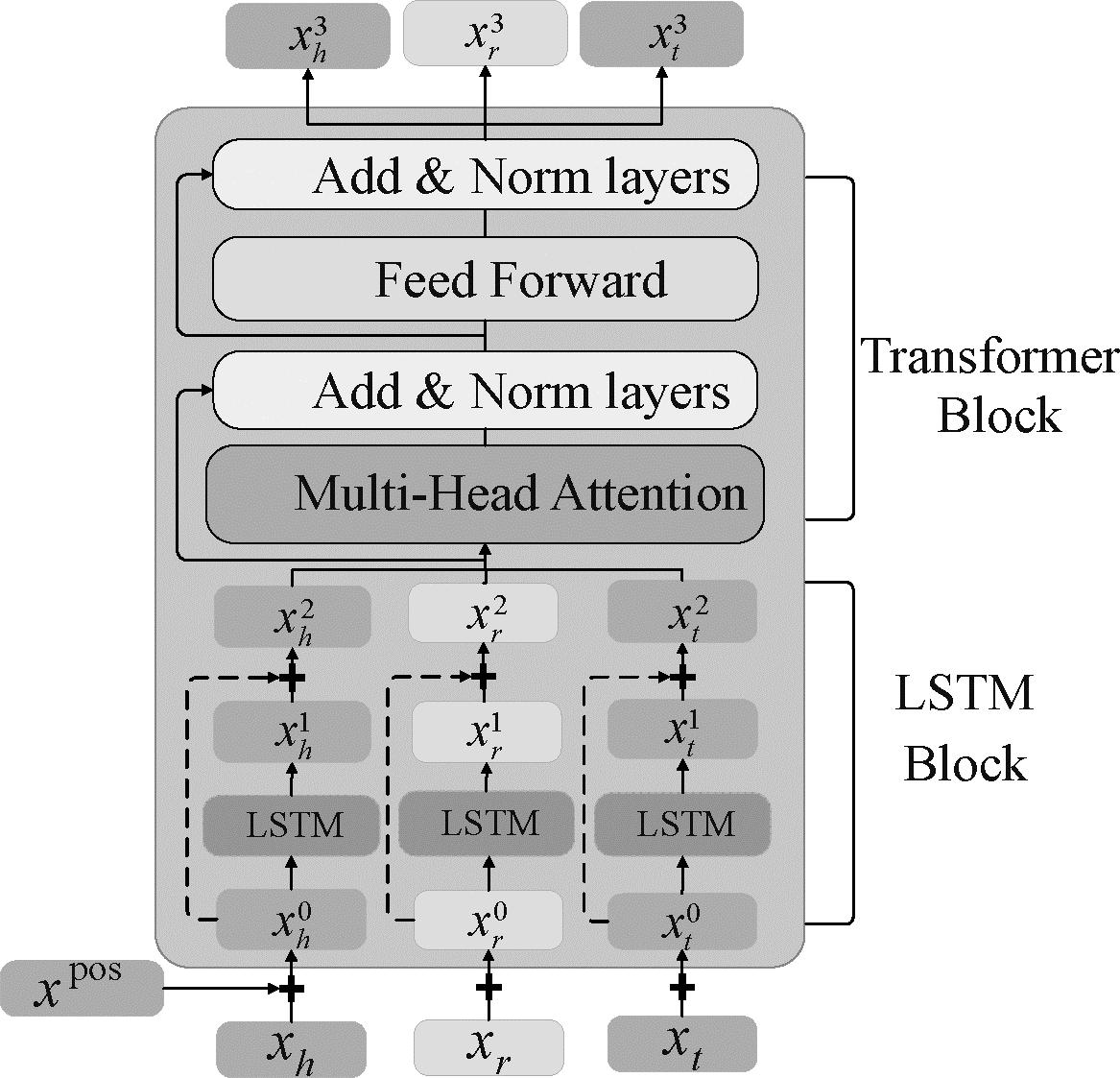

在FKGC任务中,核心目标是最后输出的关系表示r包含尽可能多的语义信息,从而提高小样本参考集中不同实体对的细粒度语义。本文使用具有强大学习能力的Transformer模型[17]作为学习器继续来学习三元组的关系表示。为了获得更准确的关系表示,FRLC模型将高阶邻域实体编码器产生的实体嵌入和关系表示编码器生成的任务关系嵌入作为Transformer学习器的输入。这样的设计有助于进一步优化关系表示。受到R-TLM[18]和FRLN[19]的启发,本文采用了简化后的R-TLM模块来进行学习器的优化,如图5所示。

图5 Transformer学习器

Figure 5 Transformer learning framework

首先,将任务关系r和对应的实体对(h,t)表示为一个序列X={x1,x2,x3},其中x1和x3分别表示头实体和尾实体,x2表示任务关系。定义Transformer的输入为![]() 对于序列X中的元素xi表示如下:

对于序列X中的元素xi表示如下:

(14)

式中:![]() 为元素的嵌入;

为元素的嵌入;![]() 为位置嵌入。实体嵌入

为位置嵌入。实体嵌入![]() 和

和![]() 是高阶邻域实体编码器更新后的实体表示,关系嵌入

是高阶邻域实体编码器更新后的实体表示,关系嵌入![]() 来自关系表示编码器。将

来自关系表示编码器。将![]() 输入到LSTM模块中,得到隐藏状态

输入到LSTM模块中,得到隐藏状态![]() 作为输出。接下来,将

作为输出。接下来,将![]() 和

和![]() 进行残差连接,作为Transformer模块的输入,进而生成学习器的输出

进行残差连接,作为Transformer模块的输入,进而生成学习器的输出![]() 具体计算步骤如下:

具体计算步骤如下:

(15)

(16)

(17)

将学习器的输出![]() 作为任务三元组(h,r,t)的最终关系表示z(h,r,t)。至此,对于每一个小样本关系r和它的任务三元组都有对应的最终关系表示。

作为任务三元组(h,r,t)的最终关系表示z(h,r,t)。至此,对于每一个小样本关系r和它的任务三元组都有对应的最终关系表示。

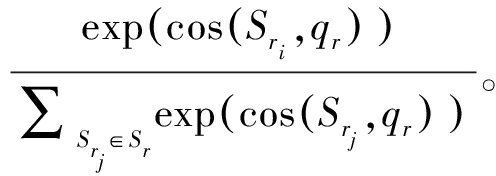

2.5 匹配处理计算

经过Transformer学习器的再学习,参考集和查询集中的每个实体都得到了对应的关系表示。FRLC使用基于度量的方法计算查询三元组与参考集的语义相似性,并将相似性分数最高的三元组作为模型预测结果。然而,在匹配计算过程中,每个参考集都蕴含着不同的信息,针对不同的查询三元组应当动态学习参考关系r的表示。FRLC为每个查询实体对生成一个动态的查询关系表示rm:

(18)

λi=softmax(cos(Sri,qr))=

(19)

式中:λi为各个参考集关系表示的softmax(·)注意力权重;Sri为参考集的第i个实体对经过Transformer学习器得到的关系表示;qr为查询实体对经过Transformer学习器得到的关系表示;cos(·)为余弦相似度;j为参考集的大小。接下来,计算动态的rm和qr的语义相似性分数:

score(rm,qr)=rm·qr。

(20)

当score(·)的值增加时,表示查询实体对(h,t)在参考关系r下与小样本参考集之间的语义相似性更高,增加了查询三元组成立的可能性;反之,score(·)值较小时,语义相似性减弱,可能性降低。然而,在应用平移模型(如TransE[8])时,还要充分考虑平移性对于h+r≈t的期望值的影响。根据式![]() 为查询实体对(hq,tq)经过Transformer学习器后的输出序列,定义平移得分s为

为查询实体对(hq,tq)经过Transformer学习器后的输出序列,定义平移得分s为

(21)

式中:z的L2范数表示为![]() 表示

表示![]() 与

与![]() 之间的距离。因此,s越小表示查询三元组成立的可能性就越大。综合考虑score(·)和s(·)的值可以得到待查询实体对(hq,tq)的最终匹配得分score′(·):

之间的距离。因此,s越小表示查询三元组成立的可能性就越大。综合考虑score(·)和s(·)的值可以得到待查询实体对(hq,tq)的最终匹配得分score′(·):

score′(hq,tq)=score(rm,qr)-δs(hq,tq)。

(22)

式中:δ为调整因子。对所有的待查三元组进行计算,得出最终的匹配得分score′(·)并进行排序。

2.6 模型训练

本文遵循其他FKGC的模型训练设置[12]。给定一个任务关系r∈![]() train和它的相关三元组,在三元组集合中随机抽取K个三元组构建参考集Sr={(hi,ti)|(hi,r,ti)∈

train和它的相关三元组,在三元组集合中随机抽取K个三元组构建参考集Sr={(hi,ti)|(hi,r,ti)∈![]() }i,并从剩余的三元组中随机抽取B(batch size)个三元组作为正查询集Qr={(hq,tq)|(hq,r,tq)∈

}i,并从剩余的三元组中随机抽取B(batch size)个三元组作为正查询集Qr={(hq,tq)|(hq,r,tq)∈![]() }。因为知识图谱本身不存在负三元组,所以通过替换查询集Qr中的三元组尾实体构建对应的负查询集

}。因为知识图谱本身不存在负三元组,所以通过替换查询集Qr中的三元组尾实体构建对应的负查询集![]() 本文采用合页损失函数(hinge loss)进行训练:

本文采用合页损失函数(hinge loss)进行训练:

![]()

![]() score′(hq,tq)]+。

score′(hq,tq)]+。

(23)

式中:[·]+=max(0,x)为标准合页损失函数;γ为margin超参数,用来分隔正查询三元组和负查询三元组。最后,本文采用基于批量抽样的元训练策略[13],在最小化损失函数![]() 的同时,进行模型参数集的优化。为了避免过拟合,还对模型参数集进行了L2正则化。在优化过程中,采用了Adam[20]优化器进行模型的参数优化。该模型伪代码如算法1所示。

的同时,进行模型参数集的优化。为了避免过拟合,还对模型参数集进行了L2正则化。在优化过程中,采用了Adam[20]优化器进行模型的参数优化。该模型伪代码如算法1所示。

算法1 FRLC的训练过程。

输入:训练任务集Tmeta-training,TransE知识图谱嵌入向量,矩阵模型初始化参数θ,参考样本大小K;

输出:保存模型的优化参数Wc,λc,θ。

①For epoch in 1 to M do

② 对Tmeta-training中的任务进行打乱

③ For Tr in Tmeta-training do

④ 抽取K个G中关系r的实体对构建小样本参考集Sr

⑤ For k in K do

⑥ 增强头实体和尾实体的嵌入向量表示,并更新小样本关系的表示

⑦ End For

⑧ 通过Transformer学习器处理三元组

⑨ Qr=Sample(r,G)-Sr∥构建正三元组查询集

⑩![]() 污染正三元组的尾实体获得负三元组

污染正三元组的尾实体获得负三元组

计算Qr与

计算Qr与![]() 中每个实体对与Sr的匹配得分

中每个实体对与Sr的匹配得分

计算损失函数

计算损失函数![]()

使用Adam优化器更新参数集

使用Adam优化器更新参数集

End For

End For

End For

End For

3 实验

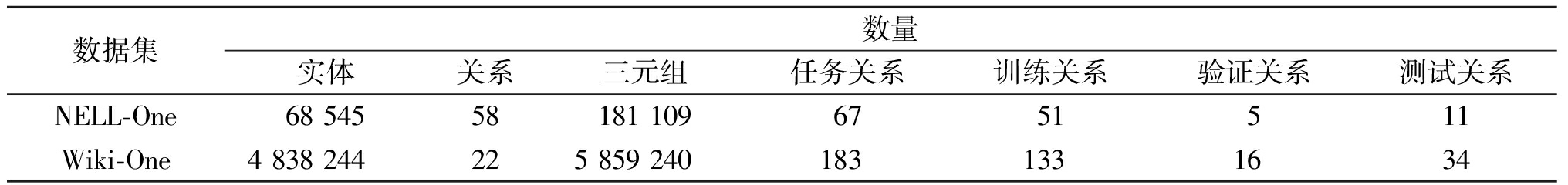

本文在实验中使用NELL-One和Wiki-One这2个数据集进行链接预测实验,并与多个基准模型进行比较,最后基于实验结果评估FRLC模型的性能。

3.1 数据集与评价指标

本文使用的2个基准数据集NELL-One和Wiki-One都是小样本知识图谱补全任务的常用数据集。在这2个数据集中,将关联三元组的数量限定在50到500之间的关系定义为小样本关系(任务关系![]() task),而与这些三元组相关的其他关系则构成了背景知识图

task),而与这些三元组相关的其他关系则构成了背景知识图![]() ′。按照FKGC任务的设定,根据比例分别将NELL-One和Wiki-One中的任务关系进行划分,划分比例为51/5/11和133/16/34,分别对应训练关系/验证关系/测试关系(

′。按照FKGC任务的设定,根据比例分别将NELL-One和Wiki-One中的任务关系进行划分,划分比例为51/5/11和133/16/34,分别对应训练关系/验证关系/测试关系(![]() train/

train/![]() validation/

validation/![]() test)。数据集的详细统计如表1所示。

test)。数据集的详细统计如表1所示。

表1 数据集的统计信息

Table 1 Statistics of dataset

数据集数量实体关系三元组任务关系训练关系验证关系测试关系NELL-One68 54558181 1096751511Wiki-One4 838 244225 859 2401831331634

3.2 基准模型与参数设置

为了评估FRLC模型的有效性,本文选用传统知识图谱嵌入模型和FKGC模型这两类基准模型进行比较。选取传统知识图谱嵌入方法TransE[8],DISTMULT[9],ComplEx[10],SimplE[21]和RotatE[22]5个模型作为对照模型。对比的FKGC模型主要包括GMatching[12],FSRL[13],FAAN[14],MetaR[15]和GANA[16]。其中,GMatching模型采用GMatching(MaxP)作为对比。它提出了一个邻居编码器和匹配处理器,并通过最大池化(max pooling)的方式完成小样本推理任务。MetaR模型分为MetaR(Pre-train)和MetaR(In-train)这2种情况,其中MetaR(Pre-train)是只使用背景知识图谱进行实体嵌入训练,而MetaR(In-train)将背景知识图谱和原始训练集中的三元组进行抽样,并添加到模型训练过程当中。在对比实验中,传统知识图谱嵌入模型和小样本知识图谱补全模型按照各方法的最优参数设置,分别进行5次5-shot知识图谱补全实验,将5次实验结果取均值作为最终结果。

FRLC模型使用PyTorch框架实现,并在单张NVIDIA GeForce RTX 4090 GPU上进行实验。在预训练嵌入模型的选择上采用TransE模型,并针对NELL-One和Wiki-One数据集进行了训练。具体的参数设置如下:实体和关系嵌入的维度d分别为100和50;批处理大小batchsize为128;初始学习率lr分别为5×10-5和6×10-5;最大邻居数量M固定为150;γ超参数设置为5;使用Adam作为优化器。在训练过程的前104步,模型逐渐增加学习率,之后线性下降。每104训练步进行一次模型验证,最大训练步数设置为3×105。在模型验证过程中,取MRR最高的模型参数作为FRLC的最优训练结果。

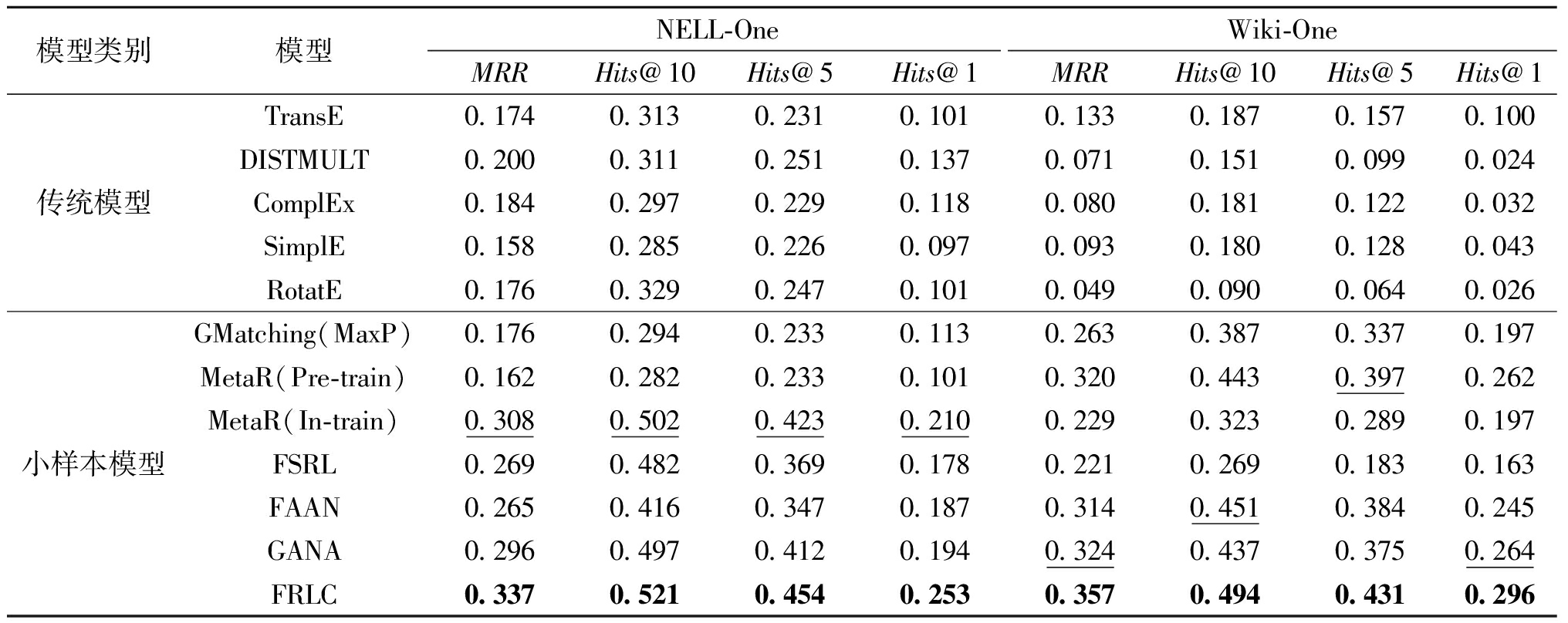

3.3 性能比较

所有模型在NELL-One和Wiki-One数据集上的5-shot链接预测结果如表2所示。从表2中可以看出,与传统的知识图谱嵌入方法相比,FRLC在2个数据集上均取得了较好的成绩。实验结果表明,FRLC能够有效地预测小样本关系中的缺失实体。在2个数据集上,FRLC模型在4个评价指标上均优于基准模型中的最佳结果。相比于NELL-One数据集上最佳表现的MetaR (In-train)模型,FRLC模型分别将MRR、Hits@10、Hits@5和Hits@1指标提高了2.9百分点、1.9百分点、3.1百分点和4.3百分点。在Wiki-One数据集上,相较于其他次优模型,性能分别提高了3.3百分点、4.3百分点、3.4百分点和3.2百分点。值得注意的是MetaR仅有Pre-train或In-train中的一种设置在单个数据集上表现良好。这表明本文提出的FRLC模型对于不同的数据集有一定的泛化性,可以利用知识图谱中实体的上下文语义和结构信息提高小样本知识图谱补全的性能。

表2 模型在NELL-One和Wiki-One上的5-shot链接预测结果

Table 2 5-shot link prediction results on NELL-One and Wiki-One

模型类别模型NELL-OneWiki-OneMRRHits@10Hits@5Hits@1MRRHits@10Hits@5Hits@1传统模型TransE0.1740.3130.2310.1010.1330.1870.1570.100DISTMULT0.2000.3110.2510.1370.0710.1510.0990.024ComplEx0.1840.2970.2290.1180.0800.1810.1220.032SimplE0.1580.2850.2260.0970.0930.1800.1280.043RotatE0.1760.3290.2470.1010.0490.0900.0640.026小样本模型GMatching(MaxP)0.1760.2940.2330.1130.2630.3870.3370.197MetaR(Pre-train)0.1620.2820.2330.1010.3200.4430.3970.262MetaR(In-train)0.3080.5020.4230.2100.2290.3230.2890.197FSRL0.2690.4820.3690.1780.2210.2690.1830.163FAAN0.2650.4160.3470.1870.3140.4510.3840.245GANA0.2960.4970.4120.1940.3240.4370.3750.264FRLC0.3370.5210.4540.2530.3570.4940.4310.296

注:加粗数字为最优结果,划线数字为次优结果,下同。

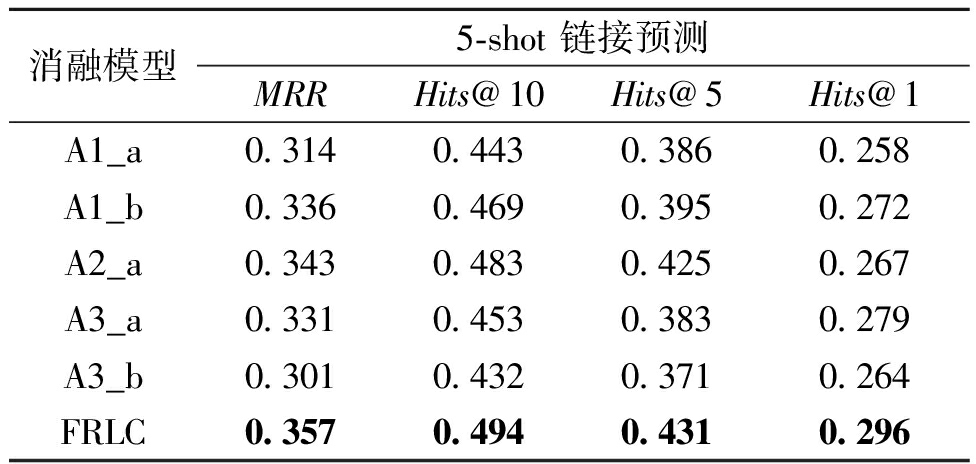

3.4 消融实验

FRLC模型的框架主要由3个关键部分组成:基于门控机制的高阶邻域实体编码器、关系表示编码器和Transformer学习器。为了体现每个部分对FRLC的整体效果影响,本文在Wiki-One数据集上进行5-shot链接预测消融实验。表3给出了模型在移除其中一个部分后的对比实验结果。为了研究高阶邻域实体编码器中门控机制的有效性,首先,在A1_a中仅对一阶邻域实体进行编码输出;而在A1_b中移除了门控机制,并使用邻域实体嵌入的均值代替了ch;其次,为了探究关系表示编码器的有效性,在A2_a中简单地将参考集实体对的平均嵌入作为关系的表示;最后,针对Transformer学习器的有效性,在A3_a中移除了LSTM模块,而在A3_b中则取消了Transformer模块的使用。

表3 FRLC在Wiki-One数据集上的5-shot

链接预测消融实验

Table 3 Ablation study of FRLC with 5-shot settings on Wiki-One

消融模型5-shot 链接预测MRRHits@10Hits@5Hits@1A1_a0.3140.4430.3860.258A1_b0.3360.4690.3950.272A2_a0.3430.4830.4250.267A3_a0.3310.4530.3830.279A3_b0.3010.4320.3710.264FRLC0.3570.4940.4310.296

由表3可以看出,完整的FRLC模型在推理效果上均优于其各个变体。这说明基于门控机制的高阶邻域实体编码器可以有效利用中心实体的邻域信息,并通过门控机制过滤掉噪声邻居的影响,提高了中心实体的语义表达;通过引入参考集中实体对的邻居关系表示,FRLC可以提高关系嵌入的质量,有助于提高关系预测准确度,并降低对关系对实体的依赖性,提高模型的泛化能力;结合LSTM网络和Transformer模块的组合结构在Transformer学习器中表现出优势,相较于各自独立使用时的效果,LSTM网络提升了细粒度的上下文语义表达,再和Transformer模块结合使用可以进一步提高链接预测的准确性。

3.5 参考集大小影响分析

为了体现参考集中实例数量(few-shot size)对模型性能的影响,本文在Wiki-One数据集上进行了对比实验,如图6所示。由图6可知,随着参考集实例数量K的增加,FRLC在MRR和Hits@1上的数值逐步上升,所有模型的预测精度总体在提高,但在提高一定程度后趋于平缓又下降。这表明在预测新三元组时,参考集的大小是影响链接预测准确性的一个关键因素。

图6 在Wiki-One上参考集尺寸对各模型性能影响

Figure 6 The impact of reference set size on the performance of various models on Wiki-One

在以MRR为评价指标的实验中,FRLC在参考集实例数量K为6时预测精度达到最高,其他部分模型也出现了类似的情况。在以Hits@1为评价指标的实验中,FRLC在参考集实例数量K从1到6的条件下都优于其他模型。这验证了FRLC模型在小样本条件下的效果。随着参考集数量的增加,查询三元组能够查询更多的参考信息,链接预测准确度得以提升。但当参考集数量过多后,出现了预测精度处于平缓甚至下降的现象。这表明当有更多的参考信息时,模型在学习关系表示的过程中学习了更多的无用信息,引入了不必要的噪声从而导致预测精度下降;其次,三元组的实体有了更多的解释和意义,在进行关系学习的过程中复杂程度显著提升,这也造成了预测精度的降低。

4 结论

本文针对小样本知识图谱补全任务提出了基于关系学习的小样本知识图谱补全模型FRLC。聚合高阶领域实体信息过程中引入门控机制,过滤邻域实体的噪声并进行聚合,提高实体编码质量;在学习关系表示过程中,FRLC对参考集中实体对邻居关系所蕴含的信息进行学习,这提高了关系嵌入质量并降低对实体的依赖,提升模型泛化性;最后,在Transformer学习器中加入LSTM网络,进一步提高小样本关系的质量。实验结果表明,FRLC在链接预测精度上优于基线FKGC模型。但知识图谱是动态变化的,模型的链接预测精度是否能够得到保障,这是一个具有挑战的问题。在未来的工作中,将通过引入外部知识的手段增强实体和关系的表示,例如使用关系和实体的文本描述来提高知识图谱的表征能力。

[1] CHEN X J, JIA S B, XIANG Y. A review: knowledge reasoning over knowledge graph[J]. Expert Systems with Applications, 2020, 141: 112948.

[2] BOLLACKER K, EVANS C, PARITOSH P, et al. Freebase: a collaboratively created graph database for structuring human knowledge[C]∥Proceedings of the 2008 ACM SIGMOD International Conference on Management of Data. New York: ACM, 2008: 1247-1250.

[3] SUCHANEK F M, KASNECI G, WEIKUM G. YAGO: a core of semantic knowledge[C]∥Proceedings of the 16th International Conference on World Wide Web. New York: ACM, 2007: 697-706.

[4] BERANT J, CHOU A, FROSTIG R, et al. Semantic parsing on freebase from question-answer pairs[C]∥2013 Conference on Empirical Methods in Natural Language Processing. Stroudsburg: ACL, 2013: 1533-1544.

[5] 左敏, 徐泽龙, 张青川, 等. 基于双维度中文语义分析的食品领域知识库问答[J]. 郑州大学学报(工学版), 2020, 41(3): 8-13.

ZUO M, XU Z L, ZHANG Q C, et al. A question answering model of food domain knowledge bases with two-dimension Chinese semantic analysis[J]. Journal of Zhengzhou University (Engineering Science), 2020, 41(3): 8-13.

[6] ZHANG F Z, YUAN N J, LIAN D F, et al. Collaborative knowledge base embedding for recommender systems[C]∥Proceedings of the 22nd ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. New York: ACM, 2016: 353-362.

[7] CHAMI I, WOLF A, JUAN D C, et al. Low-dimensional hyperbolic knowledge graph embeddings[C]∥Proceedings of the 58th Annual Meeting of the Association for Computational Linguistics. Stroudsburg: ACL, 2020: 6901-6914.

[8] BORDES A, USUNIER N, GARCIA-DUR N A, et al. Translating embeddings for modeling multi-relational data[C]∥Proceedings of the 26th International Conference on Neural Information Processing Systems. New York: ACM, 2013: 2787-2795.

N A, et al. Translating embeddings for modeling multi-relational data[C]∥Proceedings of the 26th International Conference on Neural Information Processing Systems. New York: ACM, 2013: 2787-2795.

[9] YANG B S, YIH W T, HE X D, et al. Embedding entities and relations for learning and inference in knowledge bases[EB/OL]. (2015-08-29)[2023-07-08]. https:∥arxiv.org/abs/1412.6575.

[10] TROUILLON T, WELBL J, RIEDEL S, et al. Complex embeddings for simple link prediction[C]∥Proceedings of the 33rd International Conference on International Conference on Machine Learning. New York: ACM, 2016: 2071-2080.

[11] ![]() P, CUCURULL G, CASANOVA A, et al. Graph attention networks[EB/OL]. (2018-02-04)[2023-07-08]. https:∥arxiv.org/abs/1710.10903.

P, CUCURULL G, CASANOVA A, et al. Graph attention networks[EB/OL]. (2018-02-04)[2023-07-08]. https:∥arxiv.org/abs/1710.10903.

[12] XIONG W H, YU M, CHANG S Y, et al. One-shot relational learning for knowledge graphs[EB/OL]. (2018-08-27)[2023-07-08]. https:∥arxiv.org/abs/1808.09040.

[13] ZHANG C X, YAO H X, HUANG C, et al. Few-shot knowledge graph completion[EB/OL]. (2019-11-26)[2023-07-08]. https:∥arxiv.org/abs/1911.11298.

[14] SHENG J W, GUO S, CHEN Z Y, et al. Adaptive attentional network for few-shot knowledge graph completion[C]∥Proceedings of the 2020 Conference on Empirical Methods in Natural Language Processing. Stroudsburg: ACL, 2020: 1681-1691.

[15] CHEN M Y, ZHANG W, ZHANG W, et al. Meta relational learning for few-shot link prediction in knowledge graphs[C]∥Proceedings of the 2019 Conference on Empirical Methods in Natural Language Processing and the 9th International Joint Conference on Natural Language Processing. Stroudsburg: ACL, 2019: 4217-4226.

[16] NIU G L, LI Y, TANG C G, et al. Relational learning with gated and attentive neighbor aggregator for few-shot knowledge graph completion[C]∥Proceedings of the 44th International ACM SIGIR Conference on Research and Development in Information Retrieval. New York: ACM, 2021: 213-222.

[17] VASWANI A, SHAZEER N, PARMAR N, et al. Attention is all you need[C]∥Proceedings of the 31st International Conference on Neural Information Processing Systems. New York: ACM, 2017: 6000-6010.

[18] SUN G, ZHANG C, WOODLAND P C. Transformer language models with LSTM-based cross-utterance information representation[C]∥2021 IEEE International Conference on Acoustics, Speech and Signal Processing. Piscataway: IEEE, 2021: 7363-7367.

[19] 冉丈杰, 孙林夫, 邹益胜, 等. 基于关系学习网络的小样本知识图谱补全模型[J].计算机工程, 2023, 49(9):52-59.

RAN Z J, SUN L F, ZOU Y S, et al. Few-shot knowledge graph completion model based on relation learning network[J]. Computer Engineering, 2023, 49(9):52-59.

[20] KINGMA D P, BA J. Adam: a method for stochastic optimization[EB/OL]. (2017-01-30)[2023-07-08]. https:∥arxiv.org/abs/1412.6980.

[21] KAZEMI S M, POOLE D. SimplE embedding for link prediction in knowledge graphs[EB/OL]. (2018-10-26)[2023-07-08]. https:∥arxiv.org/abs/1802.04868.

[22] SUN Z Q, DENG Z H, NIE J Y, et al. RotatE: knowledge graph embedding by relational rotation in complex space[EB/OL]. (2019-02-26)[2023-07-08]. https:∥arxiv.org/abs/1902.10197.