“深时数字地球”国际大科学计划[1]是由中国科学家发起和主导的国际科学合作计划。该计划以大数据为驱动,建立一个链接地学信息的研究平台,旨在实现地球科学领域重大科学问题的突破。目前,全国地质资料馆已经存储了海量非结构化的地质报告[2],如何高效挖掘其中地质信息是一个重要的研究课题[3]。

地质命名实体识别任务的目标是从给定的地质文本中识别出与地质相关的实体,并将它们归类到预定义的类别[4]。近年来,随着深度学习的发展,预训练模型的研究取得了巨大成功,其中BERT(bidirectional encoder representations from transformers)模型[5]就是代表之一,在多种自然语言处理任务上均取得了SOTA(state of the art)的效果。因此,在地质命名实体识别任务上,基于BERT模型的深度学习方法是目前的主流方法。尽管这些研究方法已经在地质命名实体识别任务上取得了不错的效果,但是仍然面临两大挑战。首先,这些方法采用的中文BERT模型在MLM(masked language model)任务中使用了字级别的掩码方法,无法捕捉词级别的语义信息。其次,有研究表明神经网络中的Dropout机制会导致训练和推理阶段之间存在不一致性,即训练过程中使用的由Dropout随机采样的子模型与推理过程中使用的完整模型不一致[6]。

针对上述问题,本文提出了一种基于MacBERT(masked language model as correction BERT)[7]和R-Drop(regularized dropout)[8]的地质命名实体识别模型MBCR(MacBERT-BiGRU-CRF-R-Drop)。首先,通过MacBERT在地质文本上学习具有丰富字词特征的向量表示;其次,利用BiGRU(bidirectional gated recurrent unit)提取向量表示的上文语义信息,并运用CRF(conditional random field)输出全局最优标签序列;最后,在训练过程中引入R-Drop,降低由Dropout导致的训练和推理阶段之间的不一致性,从而提升模型的泛化能力。

本文的主要创新工作如下:①在地质命名实体识别任务中,首次引入MacBERT预训练模型,可以充分利用字词信息;②为地质命名实体识别研究引入R-Drop正则化,缓解由Dropout造成的训练与推理阶段之间的不一致问题;③在NERdata和Boson数据集上系统对比了包含MBCR在内的多种不同的命名实体识别模型。

1 相关工作

现有的命名实体识别方法可以分为三类:基于规则的方法、基于统计机器学习的方法和基于深度学习的方法[9]。其中,基于规则的方法需要领域专家对整个文本进行分析来构建规则模板,耗时耗力且难以泛化到其他领域[10]。基于统计机器学习的方法应用相对广泛,如HMM(hidden Markov model)模型[11]、ME(maximum entropy)模型[12]和CRF模型[13]等,但上述方法需要进行复杂的特征工程,对特征选取的质量要求较高。相比于基于统计机器学习的方法,基于深度学习的方法可以自动从文本中提取高阶特征,进一步提高命名实体识别的准确率。在地质领域,目前主要采用的是基于深度学习的方法。张雪英等[14]提出了一种基于深度信念网络的地质命名实体识别模型,并且构建了地质实体信息的标注规范和语料库;Qiu等[15]针对传统的命名实体识别方法对特征工程依赖严重的问题,提出了一种融入注意力机制的BiLSTM-CRF地质命名实体识别方法。

近年来,随着深度学习的蓬勃发展,预训练模型的研究取得了重大进展,其中Devlin等[5]提出的BERT模型就是代表工作之一。相较于传统的Word2Vec模型[16],BERT能有效处理一词多义的情况,并已被广泛应用于自然语言处理的各种任务。Huang等[17]提出了一种结合BERT、BiLSTM(bidirectional long short-term memory)和CRF的地质新闻命名实体识别方法,该方法能够从地质新闻数据集中准确地识别出实体的边界和类别;王权于等[18]提出了一种岩土工程命名实体识别模型BERT-BiGRU-CRF,并且构建了小规模岩土工程命名实体语料库;Yu等[19]设计了一种基于BERT和CRF的矿物命名实体识别模型,该模型能够有效地提取出矿物实体信息;Liu等[20]针对现有的地质命名实体识别方法需要大量标注语料进行训练的问题,提出了一种基于GeoBERT的地质命名实体识别模型。

综上所述,在地质命名实体识别领域中,已经有不少研究方法被提出并取得了一定的成果。然而,这些方法都是基于字级别特征表示的方法,未能充分利用词信息,因此难以全面捕捉地质实体的语义信息。此外,基于深度学习的方法所采用的Dropout技术会导致训练和推理阶段之间存在不一致性。

2 基于MBCR模型的地质命名实体识别

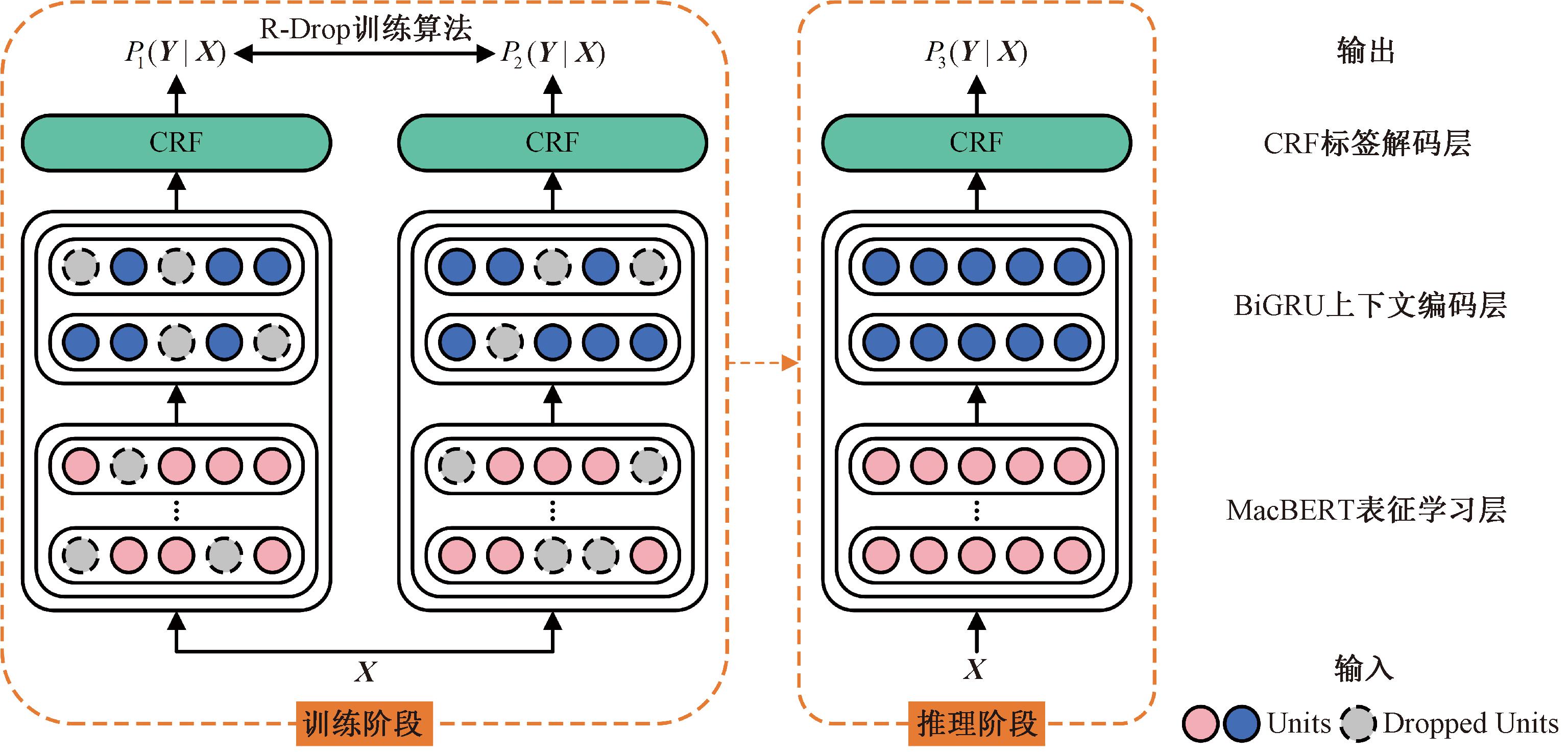

本文提出的地质命名实体识别模型MBCR包含4个部分:MacBERT表征学习层、BiGRU上下文编码层、CRF标签解码层和R-Drop训练算法,其整体结构如图1所示。该模型首先通过MacBERT表征学习层在地质文本上学习具有字词语义信息的特征向量;其次,使用BiGRU上下文编码层对特征向量进行上下文编码;最后,利用CRF标签解码层获取概率最大的标签序列。在训练过程中,对每个样本数据采用R-Drop训练算法来实现由Dropout随机采样的两个子模型间的输出分布趋同,从而减少训练和推理阶段之间的不一致性。

图1 MBCR模型结构

Figure 1 MBCR model structure

2.1 MacBERT表征学习层

地质文本中存在大量的多义词,在不同语境中同一个词具有不同的含义。例如,“水平”可以解释为同水平面平行,也可以解释为在某一专业方面所达到的高度;“品位”可以解释为矿石中有用成分的含量,也可以解释为官阶或品质。BERT模型能够处理一词多义的情况,但却无法捕捉词级别的语义信息。因此,本文引入MacBERT作为模型的表征学习层,学习地质文本特征表示。相比于BERT,MacBERT在MLM任务中采用了相似词掩码策略。例如:原始文本为“退变为纤闪石,粒度与辉石相近”,BERT掩码策略为“退[MASK]为纤闪石,粒度与辉石相[MASK] ”,MacBERT掩码策略为“退化为纤闪石,粒度与辉石相似”。该策略减小了预训练和微调任务之间的差距,增强了捕获词级别语义信息的能力。

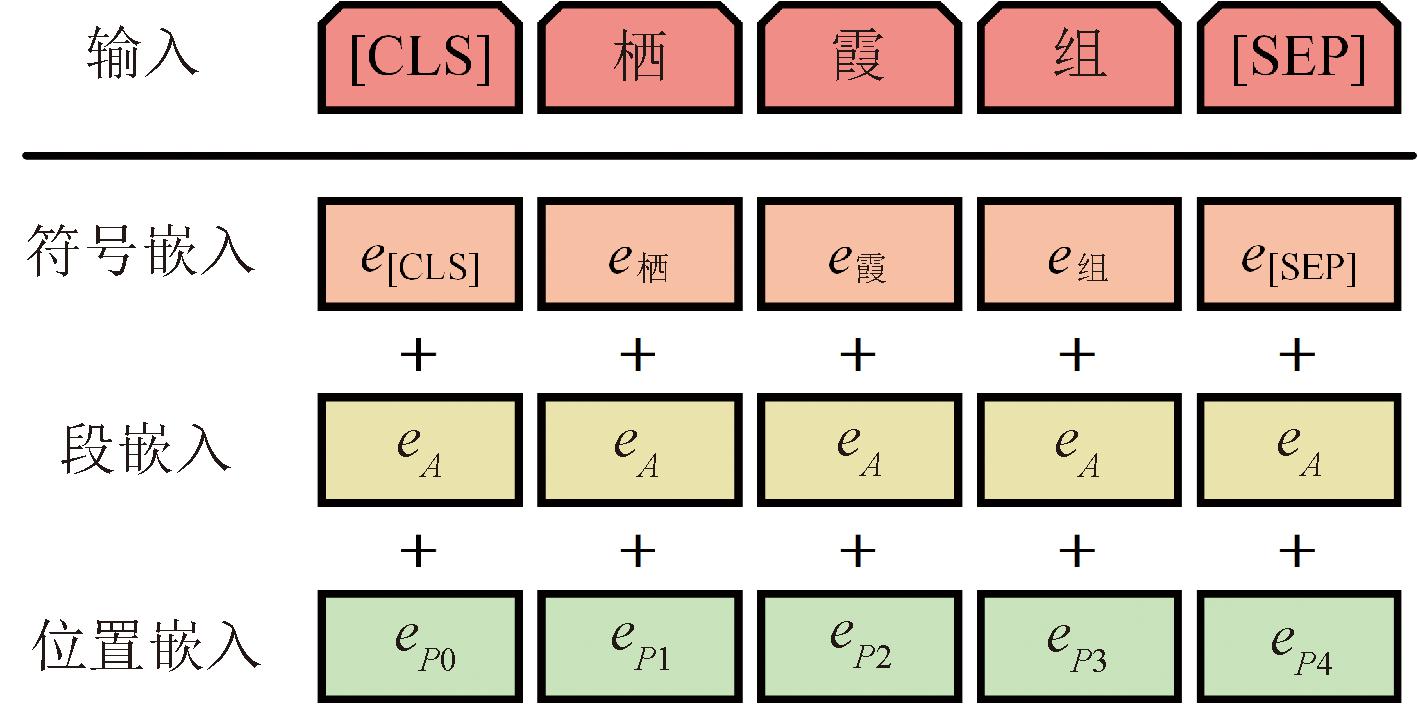

模型初始输入为地质文本序列X={x1,x2,…,xk},其中xj为序列X的第j个字符。序列X对应的MacBERT输入表示E={e1,e2,…,ek}由3个嵌入特征相加而成,如图2所示。其中,3个嵌入特征分别为符号嵌入、段嵌入、位置嵌入,符号[CLS]标识序列的开始,符号[SEP]标识序列的结束。向量E经过多个双向Transformer编码器获得特征向量A={a1,a2,…,ak}。

图2 MacBERT输入表示

Figure 2 MacBERT input representation

2.2 BiGRU上下文编码层

地质命名实体识别是一种序列标注任务,通过分析上下文中的语义信息,可以更准确地识别地质实体。前向GRU无法获取目标字的下文信息,例如,针对岩石实体“黑云石英片岩”,目标字为“片”,前向GRU只能获取“片”的前一个字“英”的特征,无法获取后一个字“岩”的特征,因此,采用BiGRU作为模型的上下文编码层。将MacBERT层输出的向量输入到BiGRU层中,用来提取上下文信息。BiGRU由前向GRU和后向GRU构成。相比于LSTM,GRU只包含重置门和更新门,结构更精简,在小样本地质数据集上的泛化效果更好。GRU计算公式[21]为

rt=σ(Wraat+Wrhht-1+br);

(1)

zt=σ(Wzaat+Wzhht-1+bz);

(2)

(3)

(4)

式中:at表示t时刻的输入;rt和zt分别表示t时刻重置门和更新门的输出;![]() 和ht分别表示t时刻的候选隐藏状态和隐藏状态;W和b分别表示权重矩阵和偏置向量;σ表示Sigmoid函数;⊙表示Hadamard乘积。

和ht分别表示t时刻的候选隐藏状态和隐藏状态;W和b分别表示权重矩阵和偏置向量;σ表示Sigmoid函数;⊙表示Hadamard乘积。

2.3 CRF标签解码层

BiGRU层能编码上下文语义信息,但忽略了地质实体标签间的依赖关系。因此,在模型的顶部使用CRF层,学习地质实体相邻标签间的约束关系,保证预测标签序列的合理性。

对于地质文本序列X={x1,x2,…,xk},其标签序列Y={y1,y2,…,yk}的得分为

(5)

式中:Tyj,yj+1表示由标签yj转移到标签yj+1的概率;Oj,yj表示第j个字符预测为标签yj的分数。

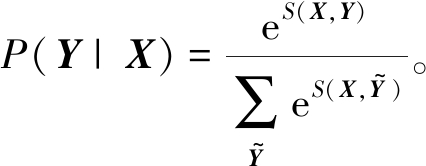

通过Softmax函数对标签序列得分S(X,Y)进行归一化,得到标签序列Y的概率分布为

(6)

式中:![]() 表示所有可能的标签序列。

表示所有可能的标签序列。

最后,通过Viterbi算法[22]获得概率最大的标签序列:

Y*=argmax P(Y|X)。

(7)

在模型训练过程中,CRF损失为

LCRF=-log P(Y|X)。

(8)

2.4 R-Drop训练算法

考虑到训练阶段使用的由Dropout生成的子模型与推理阶段使用的完整模型之间存在不一致性,本文引入R-Drop训练算法。该算法通过最小化双向KL散度来正则化子模型间的输出分布,从而缓解了训练和推理阶段之间的不一致问题。

将地质文本序列X分别输入到由Dropout采样的2个子模型中,获得其标签序列Y的2个概率分布P1(Y|X)和P2(Y|X),其双向KL散度损失为

(DKL(P2(Y|X)‖P1(Y|X)))。

(9)

因此,模型整体的损失为

(10)

式中:α为LKL的权重系数。

算法1 R-Drop训练算法。

输入:训练数据集![]()

输出:模型参数θ。

① 初始化模型参数θ;

② 随机抽样数据对(Xi,Yi)~D;

③ 将数据Xi重复输入模型两次,获得输出分布P1(Yi|Xi)和P2(Yi|Xi);

④ 使用式(8)计算得到CRF损失![]() 和

和![]()

⑤ 使用式(9)计算得到双向KL散度损失LKL;

⑥ 通过最小化式(10)中的损失L来更新模型参数θ;

⑦ 重复②~⑥,直到模型收敛。

3 实验

3.1 数据集

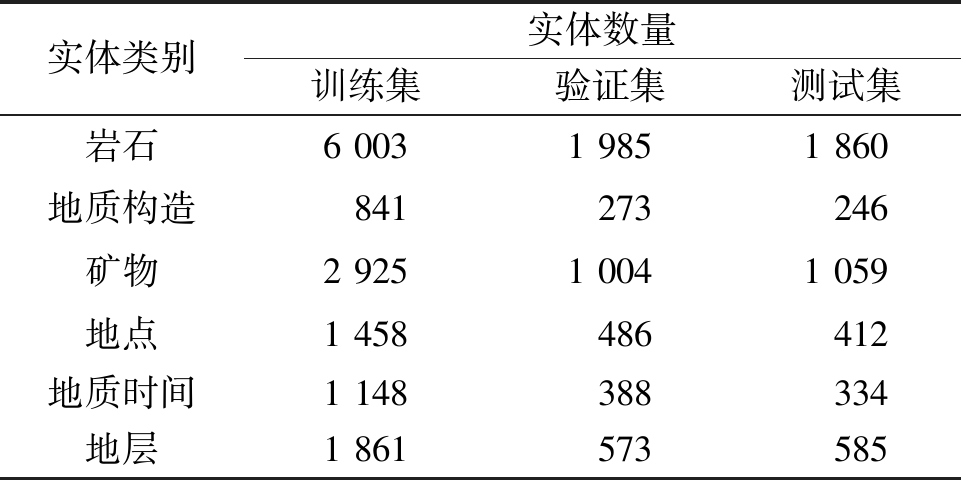

为了验证模型的有效性和泛化能力,本文在地质领域命名实体识别数据集NERdata[2]和通用领域命名实体识别数据集Boson上进行了实验。

NERdata是由马凯等[2]基于4份区域地质调查报告构建的数据集,包含6类实体:岩石(Rock)、地质构造(Geological structure)、矿物(Mineral)、地点(Location)、地质时间(Geological time)、地层(Stratum)。

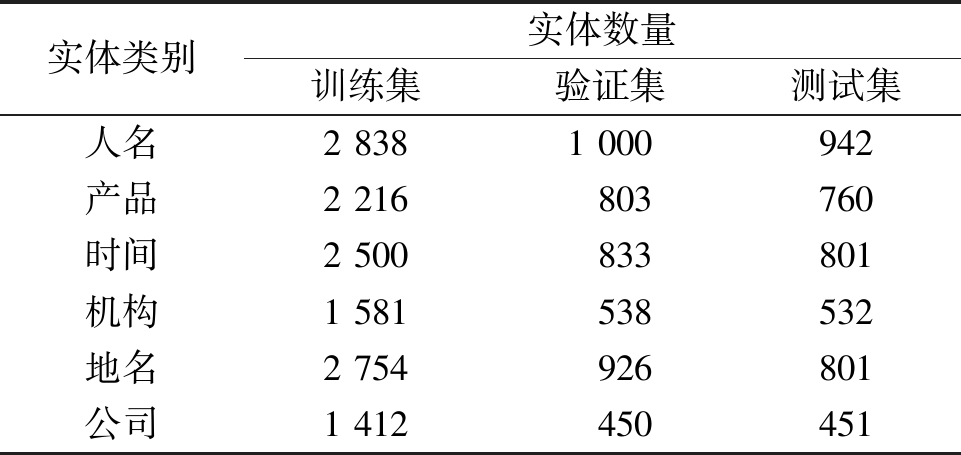

Boson是由Boson中文语义开放平台发布的数据集,包含6类实体:人名(Person)、产品(Product)、时间(Time)、机构(Organization)、地名(Location)、公司(Company)。

将NERdata和Boson数据集中的文本以句号进行切分,分别得到了10 796和9 875条语句。按照6∶2∶2的比例将各个数据集划分为训练集、验证集、测试集。NERdata数据集实体统计如表1所示,Boson数据集实体统计如表2所示。

表1 NERdata数据集实体统计

Table 1 Entity statistics of NERdata dataset

实体类别实体数量训练集验证集测试集岩石6 0031 9851 860地质构造841273246矿物2 9251 0041 059地点1 458486412地质时间1 148388334地层1 861573585

表2 Boson数据集实体统计

Table 2 Entity statistics of Boson dataset

实体类别实体数量训练集验证集测试集人名2 8381 000942产品2 216803760时间2 500833801机构1 581538532地名2 754926801公司1 412450451

实验采用命名实体识别任务中常用的BIO标注规范,如表3所示。

表3 BIO标注示例

Table 3 BIO annotation examples

文本序列标注结果具复理石韵律特征具/O复/B-Mineral理/I-Mineral石/I-Mineral韵/O律/O特/O征/O碎屑岩,碳酸盐岩碎/B-Rock屑/I-Rock岩/I-Rock,/O碳/B-Rock酸/I-Rock盐/I-Rock岩/I-Rock

3.2 评价指标

实验采用精确率P、召回率R和F1值作为模型性能的评价指标,具体计算公式为

(11)

(12)

(13)

式中:TP表示真正例的数量;FP表示假正例的数量;FN表示假负例的数量。当且仅当实体的边界和类型都被正确识别,才认为该实体被正确识别。

3.3 实验环境及设置

本文采用Python 3.8.0和PyTorch 1.12.0作为实验环境,使用Chinese-MacBERT-base版本的MacBERT,其包含12个双向Transformer编码器。模型的超参数:MacBERT隐藏层维度为768;BiGRU隐藏层维度为256;学习率为10-5;Batch size为32;Dropout丢弃神经元的比例Dp为30%。

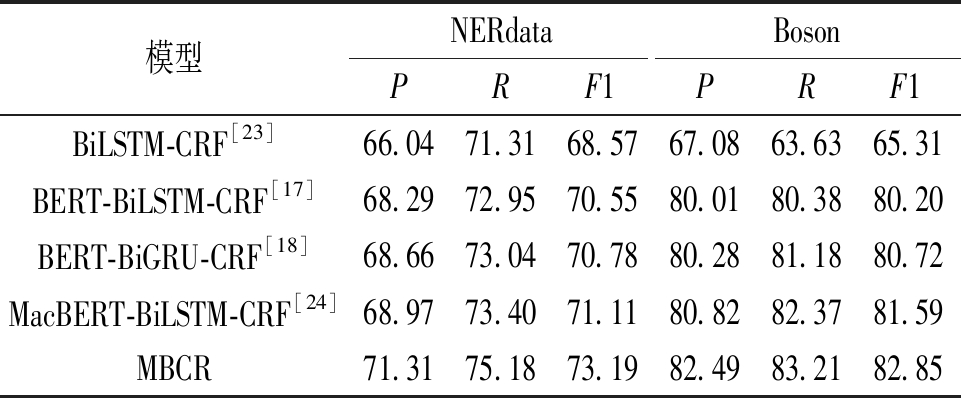

3.4 不同模型性能对比

为了验证MBCR模型的有效性,本文在NERdata和Boson数据集上系统对比了BiLSTM-CRF[23]、BERT-BiLSTM-CRF[17]、BERT-BiGRU-CRF[18]、MacBERT-BiLSTM-CRF[24]和MBCR这5种不同的命名实体识别模型。不同模型在NERdata和 Boson数据集上的对比结果如表4所示。

表4 不同模型性能对比

Table 4 Performance comparison of different models %

模型NERdataBosonPRF1PRF1BiLSTM-CRF[23]66.0471.3168.5767.0863.6365.31BERT-BiLSTM-CRF[17]68.2972.9570.5580.0180.3880.20BERT-BiGRU-CRF[18]68.6673.0470.7880.2881.1880.72MacBERT-BiLSTM-CRF[24]68.9773.4071.1180.8282.3781.59MBCR71.3175.1873.1982.4983.2182.85

实验结果表明,MBCR模型性能优于其他对比模型。MBCR在NERdata数据集上的精确率、召回率和F1值分别为71.31%、75.18%和73.19%,在Boson数据集上的精确率、召回率和F1值分别为82.49%、83.21%和82.85%。虽然BERT、MacBERT预训练模型参数量大,导致模型整体复杂度高,但由于其可以生成考虑语境的嵌入向量,因此能够显著提高模型的表现。相比于BERT,MacBERT减少了预训练和微调任务之间的差距,增强了捕获词级别语义信息的能力,从而使模型能够更准确地识别出实体的类型和边界。由于BiGRU的结构更精简,参数更少,因此在小样本数据集上的泛化效果更好。R-Drop仅增加了双向KL散度损失,没有进行结构修改。与MacBERT-BiLSTM-CRF相比,MBCR在NERdata和Boson数据集上的F1值分别提升了2.08百分点和1.26百分点,具有显著的优势。

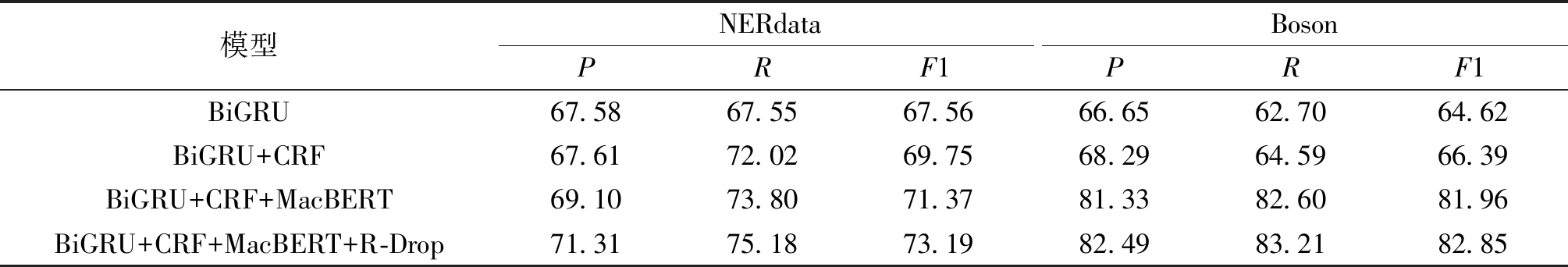

3.5 消融实验

在BiGRU的基础上进行实验,验证了MBCR中各个组成部分对模型性能的影响,在NERdata和Boson数据集上的消融实验结果如表5所示。引入CRF来获取标签间的依赖关系,有助于提升模型性能。采用MacBERT可以生成高质量动态嵌入向量,从而使模型能够有效识别出实体信息。加入R-Drop后,模型的精确率、召回率和F1值均有明显提升,验证了R-Drop的有效性。

表5 消融实验结果

Table 5 Ablation experiment results %

模型NERdataBosonPRF1PRF1BiGRU67.5867.5567.5666.6562.7064.62BiGRU+CRF67.6172.0269.7568.2964.5966.39BiGRU+CRF+MacBERT69.1073.8071.3781.3382.6081.96BiGRU+CRF+MacBERT+R-Drop71.3175.1873.1982.4983.2182.85

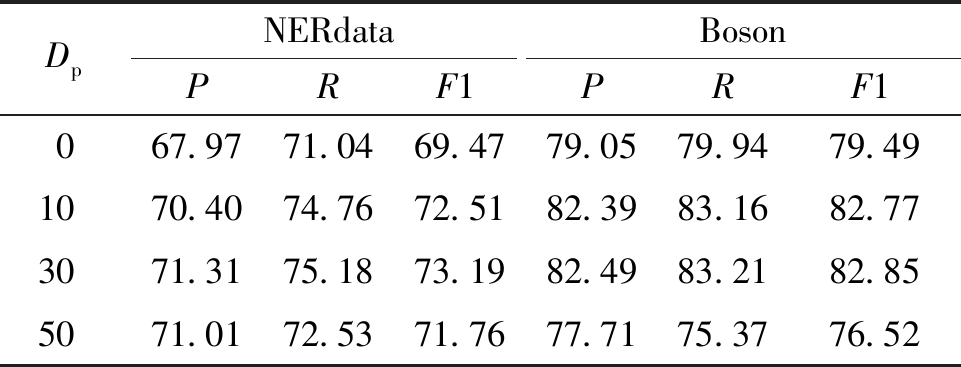

3.6 Dropout的影响

实验探索了Dropout对MBCR模型性能的影响,在NERdata和Boson数据集上的实验结果如表6所示。Dropout在训练过程中随机丢弃一定比例的神经元来执行隐式集成,有助于提升MBCR的泛化能力。但是,MBCR的F1值不会随着Dropout丢弃神经元的比例Dp的增加而完全提高。当Dp为50%时,MBCR在NERdata和Boson数据集上的F1值均低于Dp为30%时的F1值。

表6 Dropout对模型性能的影响

Table 6 Effect of Dropout on model performance %

DpNERdataBosonPRF1PRF1067.9771.0469.4779.0579.9479.491070.4074.7672.5182.3983.1682.773071.3175.1873.1982.4983.2182.855071.0172.5371.7677.7175.3776.52

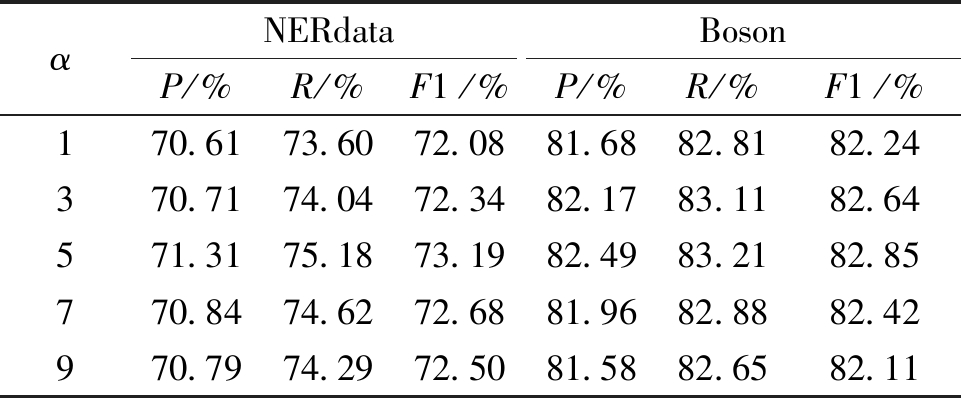

3.7 α的影响

本节实验探索了R-Drop的权重α对MBCR模型性能的影响,在NERdata和Boson数据集上的实验结果如表7所示。α太小会导致模型过于复杂,容易发生过拟合。相反,α太大会使得模型过于简单,存在欠拟合的风险。当α为5时,MBCR在NERdata和Boson数据集上的性能最出色。

表7 α对模型性能的影响

Table 7 Effect of α on model performance

αNERdataBosonP/%R/%F1/%P/%R/%F1/%170.6173.6072.0881.6882.8182.24370.7174.0472.3482.1783.1182.64571.3175.1873.1982.4983.2182.85770.8474.6272.6881.9682.8882.42970.7974.2972.5081.5882.6582.11

4 结论

针对地质命名实体识别问题,本文提出了一种基于MacBERT和R-Drop的地质命名实体识别模型MBCR。在NERdata数据集和Boson数据集上的实验结果表明,MBCR模型性能明显优于其他模型。

由于目前公开的带标注的地质命名实体识别数据集规模较小,并且存在标注不统一和实体位置偏差的问题,这导致了所有实验模型的评价指标整体偏低。因此,未来的研究工作将围绕两个方面开展:一方面,优化模型结构,进一步提升模型的泛化能力;另一方面,完善地质命名实体识别语料库,规范地质实体标注。

[1] WANG C S, HAZEN R M, CHENG Q M, et al. The deep-time digital earth program: data-driven discovery in geosciences[J]. National Science Review, 2021, 8(9): nwab027.

[2] 马凯, 田苗, 谭永健, 等. 基于四份区域地质调查报告构建的命名实体识别试验数据集研发[J]. 全球变化数据学报(中英文), 2022, 6(1): 78-84, 237-243.

MA K, TIAN M, TAN Y J, et al. Development of a named entity recognition dataset based on four regional geological survey reports[J]. Journal of Global Change Data &Discovery, 2022, 6(1): 78-84, 237-243.

[3] QIU Q J, XIE Z, WU L, et al. Automatic spatiotemporal and semantic information extraction from unstructured geoscience reports using text mining techniques[J]. Earth Science Informatics, 2020, 13(4): 1393-1410.

[4] 储德平, 万波, 李红, 等. 基于ELMO-CNN-BiLSTM-CRF模型的地质实体识别[J]. 地球科学, 2021, 46(8): 3039-3048.

CHU D P, WAN B, LI H, et al. Geological entity recognition based on ELMO-CNN-BiLSTM-CRF model[J]. Earth Science, 2021, 46(8): 3039-3048.

[5] DEVLIN J, CHANG M W, LEE K, et al. Bert: pre-training of deep bidirectional transformers for language understanding[EB/OL]. (2018-10-11)[2023-03-15]. https:∥arxiv.org/abs/1810.04805.

[6] ZOLNA K, ARPIT D, SUHUBDY D, et al. Fraternal dropout[EB/OL]. (2017-10-31)[2023-03-15]. https:∥arxiv.org/abs/1711.00066.

[7] CUI Y M, CHE W X, LIU T, et al. Pre-training with whole word masking for Chinese BERT[J]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2021, 29: 3504-3514.

[8] LIANG X B, WU L J, LI J T, et al. R-drop: regularized dropout for neural networks[J/OL]. (2021-10-29)[2023-03-15]. https:∥arxiv.org/abs/2106.14448.

[9] LIU P, GUO Y M, WANG F L, et al. Chinese named entity recognition: the state of the art[J]. Neurocomputing, 2022, 473: 37-53.

[10] LI J, SUN A X, HAN J L, et al. A survey on deep learning for named entity recognition[J]. IEEE Transactions on Knowledge and Data Engineering, 2022, 34(1): 50-70.

[11] ZHANG J, SHEN D, ZHOU G D, et al. Enhancing HMM-based biomedical named entity recognition by studying special phenomena[J]. Journal of Biomedical Informatics, 2004, 37(6): 411-422.

[12] SAHA S K, SARKAR S, MITRA P. Feature selection techniques for maximum entropy based biomedical named entity recognition[J]. Journal of Biomedical Informatics, 2009, 42(5): 905-911.

[13] SUN C J, GUAN Y, WANG X L, et al. Rich features based conditional random fields for biological named entities recognition[J]. Computers in Biology and Medicine, 2007, 37(9): 1327-1333.

[14] 张雪英, 叶鹏, 王曙, 等. 基于深度信念网络的地质实体识别方法[J]. 岩石学报, 2018, 34(2): 343-351.

ZHANG X Y, YE P, WANG S, et al. Geological entity recognition method based on deep belief networks[J]. Acta Petrologica Sinica, 2018, 34(2): 343-351.

[15] QIU Q J, XIE Z, WU L, et al. BiLSTM-CRF for geological named entity recognition from the geoscience literature[J]. Earth Science Informatics, 2019, 12(4): 565-579.

[16] MIKOLOV T, SUTSKEVER I, CHEN K, et al. Distributed representations of words and phrases and their compositionality[C]∥Proceedings of the 26th International Conference on Neural Information Processing Systems: Volume 2. New York: ACM, 2013: 3111-3119.

[17] HUANG C, WANG Y Z, YU Y Q, et al. Chinese named entity recognition of geological news based on BERT model[J]. Applied Sciences, 2022, 12(15): 7708.

[18] 王权于, 李振华, 涂志鹏, 等. 基于BERT-BiGRU-CRF模型的岩土工程实体识别[J]. 地球科学, 2023, 48(8): 3137-3150.

WANG Q Y, LI Z H, TU Z P, et al. Geotechnical named entity recognition based on BERT-BiGRU-CRF model[J]. Earth Science, 2023, 48(8): 3137-3150.

[19] YU Y Q, WANG Y Z, MU J Q, et al. Chinese mineral named entity recognition based on BERT model[J]. Expert Systems with Applications, 2022, 206: 117727.

[20] LIU H, QIU Q J, WU L, et al. Few-shot learning for name entity recognition in geological text based on GeoBERT[J]. Earth Science Informatics, 2022, 15(2): 979-991.

[21] CHO K, VAN M B, GULCEHRE C, et al. Learning phrase representations using RNN encoder-decoder for st-atistical machine translation[EB/OL]. (2014-06-03)[2023-03-15]. https:∥arxiv.org/abs/1406.1078.

[22] STRUBELL E, VERGA P, BELANGER D, et al. Fast and accurate entity recognition with iterated dilated convolutions[EB/OL]. (2017-02-07)[2023-03-15]. https:∥arxiv.org/abs/1702.02098.

[23] HUANG Z H, XU W, YU K. Bidirectional LSTM-CRF models for sequence tagging[EB/OL]. (2015-08-09)[2023-03-15]. https:∥arxiv.org/abs/1508.01991.

[24] CUI Z J, YUAN Z M, WU Y F, et al. Intelligent recommendation for departments based on medical knowledge graph[J]. IEEE Access, 2023, 11: 25372-25385.