随着大数据、人工智能等技术的蓬勃发展,自动驾驶已在全球掀起浪潮[1]。目标检测在自动驾驶感知系统中发挥着重要作用。

基于深度学习的目标检测算法通过卷积神经网络自动学习目标的高级语义特征,具备优异的检测性能。目前主流的深度学习目标检测算法分为单阶段以及两阶段,其中两阶段目标检测算法代表有R-cnn[2]、Fast R-cnn[3]。此类算法首先从图像中提取出感兴趣的候选区域,固定大小后送入CNN中进行特征提取,最后进行目标分类与回归。但是由于该类算法时间成本高,不能做到实时检测。2015年,Redmon等[4]提出了YOLOv1网络,将目标检测算法引入到单阶段的研究中,此算法将输入分割成一个S×S的网格,让每一个网格单元回归边界框的位置以及目标中心落入该单元的置信度得分。YOLOv1展示了单阶段目标检测算法的潜力,自此单阶段目标检测算法的研究迎来新的篇章。

本文以单阶段目标检测算法YOLOv5s[5]为基础网络,提出了改进YOLOv5s算法,主要贡献有以下两方面:①针对复杂的交通背景带来的干扰,提出基于多头注意力残差模块(multi-head self-attention residuals module,MHSARM);②针对传统卷积层的空间感知能力较弱,导致模型特征提取能力不足的问题,采用 CoordConv[6]来取代YOLOv5s中特征融合层中的传统卷积层。

1 相关工作

在交通目标检测领域,袁志宏等[7]在YOLOv3中引入SPP结构,进一步提升了检测精度,但是此算法通过牺牲图片分辨率来换取检测速度的提升,此方式容易丢失细节特征信息,在复杂的交通场景并没有起到较好的效果。刘丽伟等[8]在YOLOv4残差模块中嵌入轻量级SimAM注意力模块,提升网络对重要特征的提取能力,改善了小目标检测精度不足的问题,但对于特征信息较弱的交通目标存在大量漏检的现象。院老虎等[9]通过在YOLOv5s中加CBAM注意力机制,提升网络对遮挡目标与小目标的检测性能。Cai等[10]使用可变形卷积代替CSPDaeknet中最后一层,通过自适应动态调整卷积核大小,捕捉更加丰富的局部特征信息,提升了网络对小目标的检测性能。Shi等[11]在原有检测头的基础上增加额外的检测头,并将注意机制与检测器头部融合,进一步提高目标的检测精度。Gao等[12]在YOLOv5特征提取区域加入接收场,更好地关注小目标物体,且引入了空间通道注意力机制,减少背景信息干扰,增强网络关注能力。

上述算法虽然能实现交通目标检测,但是对于复杂交通场景下的检测仍然存在以下挑战。①背景多样性。对比其他应用场景,交通场景富含丰富的信息,如天气、光照、背景等,交通目标容易受到各个复杂场景的干扰,导致特征信息衰减。②局部遮挡现象普遍发生。在交通目标密集的交通场景,由于目标之间相互遮挡会使目标特征信息丢失,从而导致被遮挡目标存在重检、漏检现象。

2 改进YOLOv5s

2.1 YOLOv5s网络架构

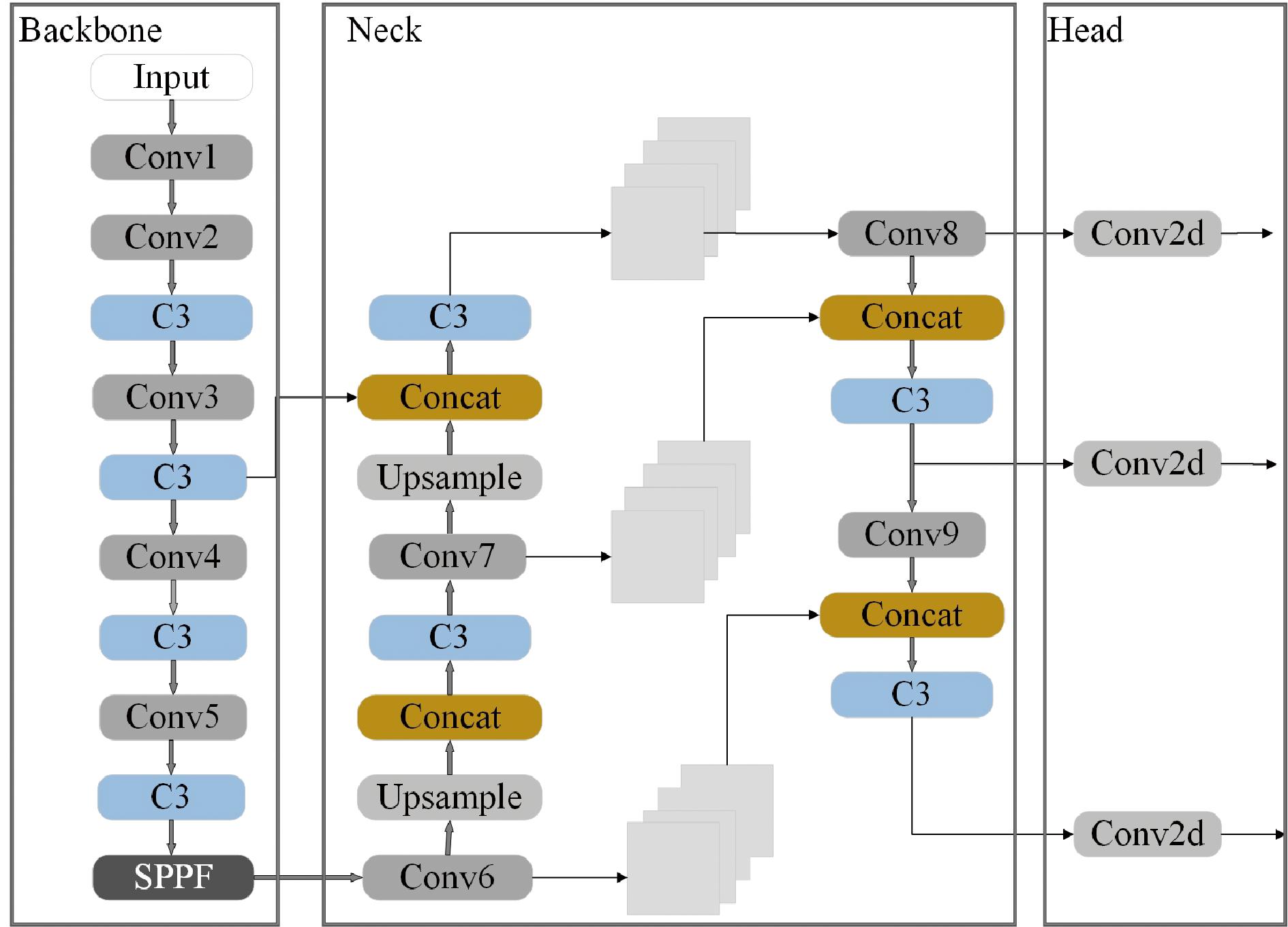

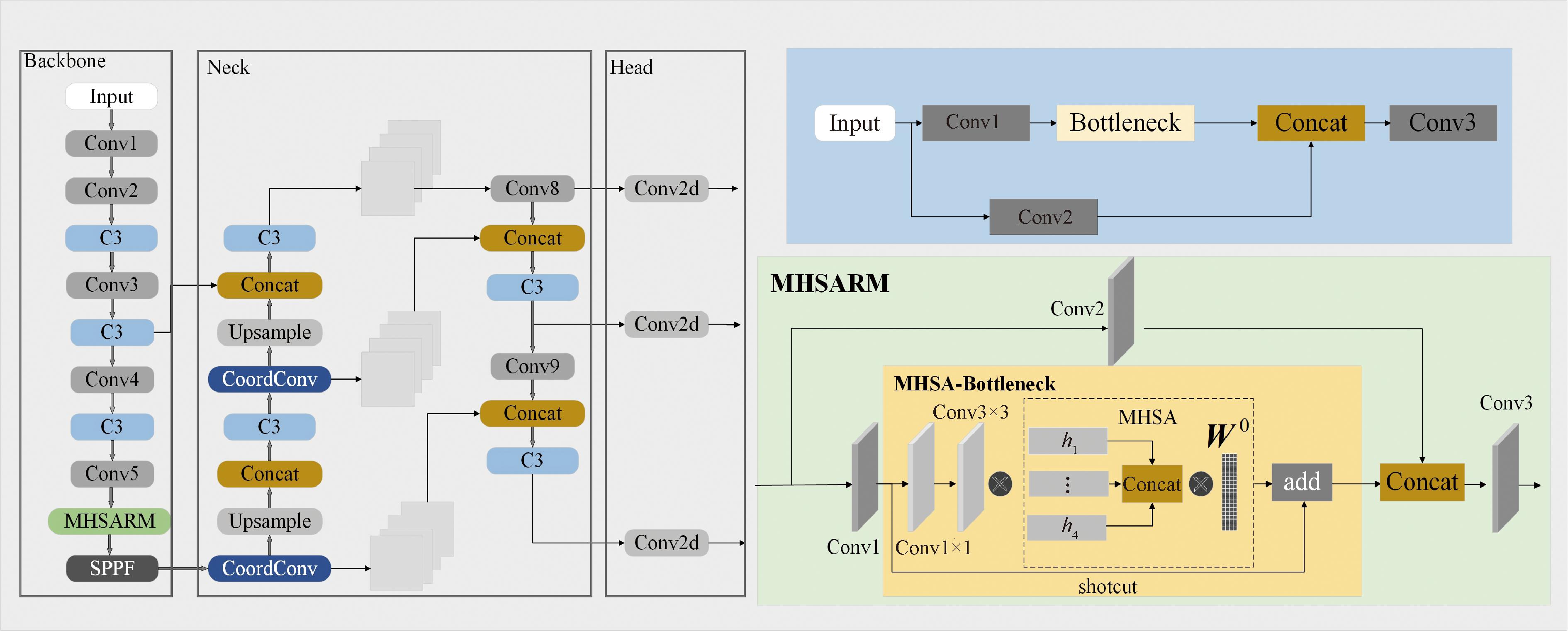

YOLOv5s[5]网络为全卷积网络,整体架构如图1所示,其网络架构由Backbone、Neck和Head三个部分组成。Backbone主要用于特征提取,通过自上而下的路径获取多尺度的特征;Neck结构是一个特征金字塔(FPN),其目的是把浅层的图像特征与深层的语义特征融合,以获取更加完整的特征;Head层为Detect模块,由卷积层构成,对应三个特征检测层。

图1 YOLOv5s网络架构

Figure 1 YOLOv5s network architecture

YOLOv5通过调整深度depth和宽度width两个参数,可分为五个版本,分别为YOLOv5n、YOLOv5s、YOLOv5m、YOLOv5l、YOLOv5x。为了平衡精度和速度,本实验采用轻量级版本YOLOv5s作为基础模型。

2.2 多头自注意力机制(MHSA)

Self-attention[13]更多地关注输入的关键信息,注重特征内部相关性,减少对外部信息的依赖。首先,通过输入向量X乘以对应的权重矩阵获取Q、K、V;其次,通过Q跟K相乘计算自注意力分数;再次,通过注意力分数除以根号下向量K的维度调整自注意力分数幅值,并使用softmax函数对注意力得分进行操作得到权重系数,确保分数都为正数且分数之和为1;最后,根据权重系数对V值进行加权求和,得到最终的输出,如式(1)[13]所示。

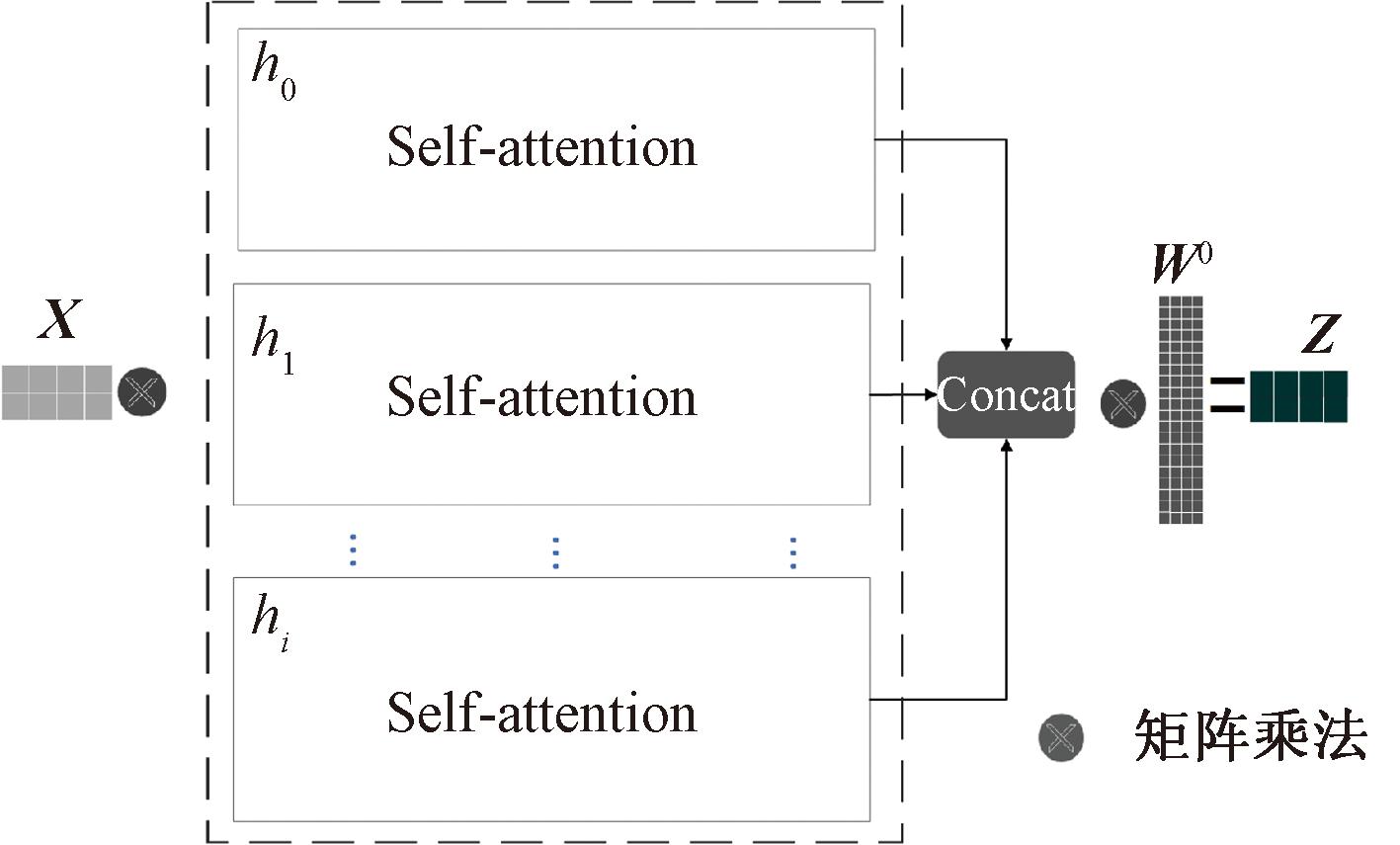

对比Self-attention,MHSA[14]使模型拥有多个表示子空间,进一步丰富了信息的特征表达,其网络结构如图2所示。MHSA使用多组不同注意力权重W对Q、K、V进行线性变换,随后将多组变换结果并行进行自注意机制计算,最后对产生的多组结果进行拼接,并通过线性变化得到最终输出结果,如式(2)、(3)[14]所示:

(1)

图2 MHSA结构图

Figure 2 MHSA structure diagram

(2)

MultiHead(Q,K,V)=Concat(h1,h2,…,hi)。

(3)

2.3 CoordConv

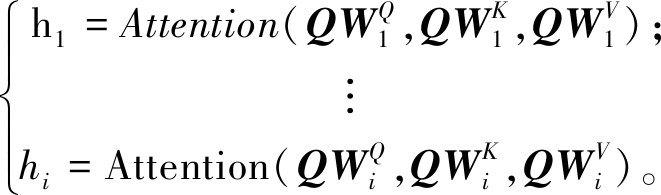

CoordConv继承传统卷积优异特性,能有效解决传统卷积获取空间信息能力差的问题,其结构如图3所示。

图3 CoordConv结构图

Figure 3 CoordConv structure diagram

与传统卷积相比,CoordConv在输入的Feature Map中增加2个通道,分别代表X坐标、Y坐标,两者的加入使卷积具备了空间信息感知能力,增强交通目标在网络中的信息表达。

2.4 MHSA-Bottleneck方法

Bottleneck[5]是一种精简的网络结构。首先,Bottleneck利用1×1的卷积降低特征通道;其次,通过3×3的卷积将通道数加倍;最后,采用残差结构将输入输出相加。该模块通过先降维再升维的方式,不仅减小模型参数量,降低模型的推理时间,还使卷积核能更好地理解特征信息,有利于提取到更多的细节特征。MHSA通过相关像素之间的相似函数动态计算注意力权重,以适应关注不同的区域,并捕捉到更多的特征。

如图4金色区域所示,MHSA-Bottleneck的原理是在Bottleneck中3×3卷积后接入MHSA,考虑实时性跟检测精度之间的平衡,本次研究采用的是4头MHSA,其优势体现在以下三点:①保证模型不会增加过多的参数量导致实时性受到影响;②不会因为自注意力机制层数的加深反而导致特征学习能力的下降;③将Bottleneck优异的特征学习能力与MHSA优秀的抗干扰能力结合,在复杂的交通场景具备更好的检测性能。

图4 改进YOLOv5s整体架构

Figure 4 The overall architecture of improved YOLOv5s

2.5 MHSARM方法

C3[5]模块是YOLOv5s主干网络和特征融合网络重要组成部分,其综合了深度可分离卷积和空洞卷积的优势。C3由3个卷积层和Bottlenenck模块组成,结构如图4浅蓝色区域所示,其中Conv1步幅为2,其目的是增加网络的感受野,使网络能更好地保留全局信息。Conv2、Conv3步幅为1,其目的为保留特征图的空间分辨率,从而更好地保留目标的局部特征信息。但C3模块因缺乏对目标的关注能力,导致在复杂场景中的检测性能不足,存在检测精度低、漏检、错检现象。

MHSARM结构如图4浅绿色区域所示,该模块原理为C3中的Bottleneck模块用MHSA-Bottlentck替换,既继承了MHSA-Bottleneck 的优势,又结合了C3优异的不同尺度特征提取能力,使其具备优异的特征提取能力的同时,也可根据特征相关性,为特征分配权重系数。在自动驾驶目标检测领域,MHSARM将更多的注意力集中于交通目标,以此达到弱化背景干扰、强化目标特征信息的目的。经过实验证明,MHSARM面对复杂的各类场景(强光、背光、密集遮挡),能有效提升检测性能。

2.6 整体架构

改进YOLOv5s整体架构如图4所示,改进的内容主要包含MHSARM替换C3模块和CoordConv。在YOLOv5s特征提取区域,SPPF结构是特征提取区域的最后一个模块,作用是将任意大小的特征图转换成固定大小的特征向量,其包含图像的强语义信息,降低复杂背景对SPPF结构带来的干扰,能有效提升算法的检测效率,因此使用MHSARM代替基础算法中获取SPPF的C3模块。

特征金字塔实现了浅层网络的图像特征和深层网络的语义特征融合。但针对空间特征信息,传统卷积学习难度大,并且在经过一系列的卷积、池化操作后,空间信息进一步丢失,因此本文使用CoordConv来代替基础网络特征融合区域中的Conv6、Conv7卷积层,从而弥补基础网络的空间信息提取能力不足,提升网络检测性能。

3 仿真实验与结果分析

3.1 数据集介绍

实验采用由德国卡尔斯鲁厄理工学院和丰田美国技术研究院联合创办的自动驾驶数据集(Kitti)。Kitti数据集包含真实图像数据共7 481张图片,分为8个类别,考虑到自动驾驶场景中的情况,将8个类别改为3个类别:汽车、货车、箱式汽车合并为汽车;坐着的人和行人合并为人;骑车的人单独做一个类别,删除电车及其他2个类别。

3.2 实验平台

本次实验采用的实验平台的配置分别为操作系统Windows10、显卡RTX 3090、CUDA11.6、深度学习框架Pytorch1.12。

3.3 评价指标

本次实验采用mAP、FPS来衡量该网络的检测性能和速度。mAP为所有类别的平均精度值,其值为以召回率(Recall)为横坐标和精确率(Precision)为纵坐标得出的P-R曲线的面积。精确率又叫查准率,表示在所有被预测为正的样本中实际为正的样本的概率;召回率也叫查全率,表示在实际为正的样本中被预测为正样本的概率。Precison与Recall的计算公式[15]分别为

(4)

(5)

式中:TP表示正样本分类为正样本数量;FP表示负样本分类为正样本数量;FN表示正样本分类为负样本数量。

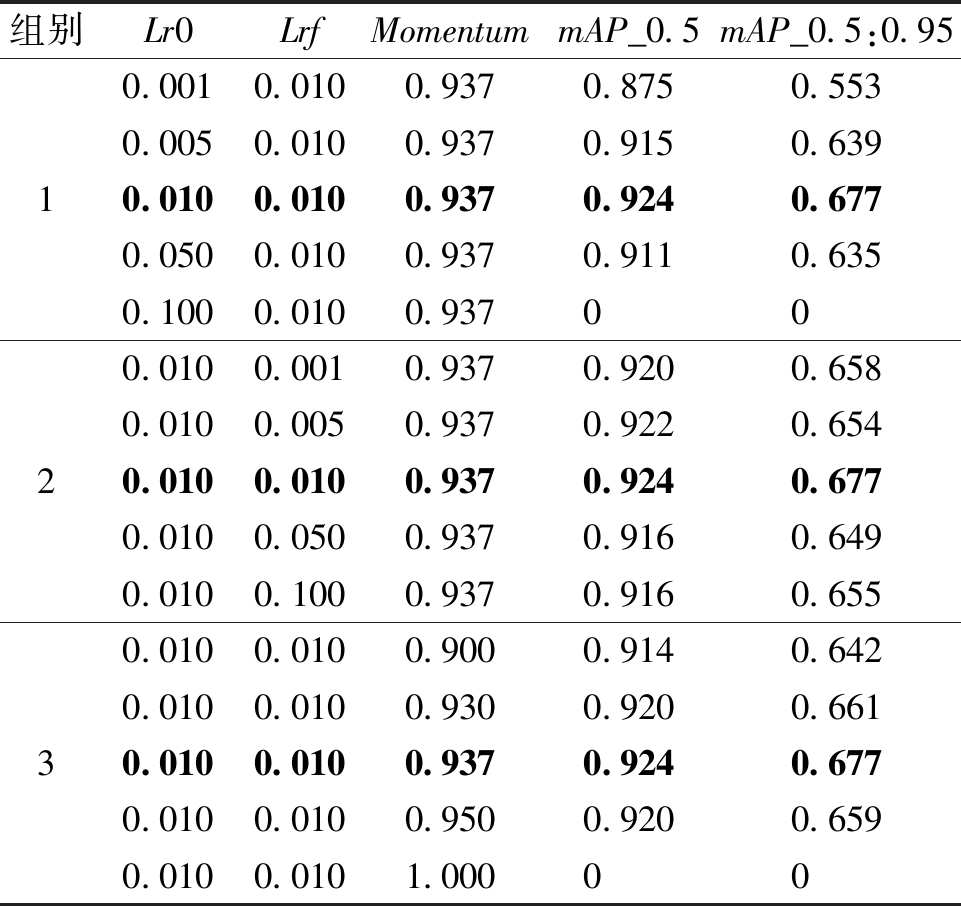

3.4 训练参数对比实验

超参数在控制模型结构、功能、效率方面发挥着至关重要的作用,本文以YOLOv5s为基础算法,采用控制变量法分析学习率(Lr0)、余弦退火参数(Lrf)、学习率动量(Momentum)的取值对模型性能的影响,如表1所示。表1中加粗数值为YOLOv5s默认值,也是本文所用参数值及最优值。学习率(Lr0)是优化算法中的关键参数,该参数确定每次迭代中的步长,Lr0太小,会导致下降速度慢,需要长时间才能找到最优解;反之,虽然收敛的速度加快,但是模型会忽略损失的最小值,导致损失来回震荡无法收敛甚至直接造成梯度爆炸。表1中,第1组实验为Lr0对于模型检测性能的影响实验,本文以0.01为基础数值,分别朝着更大及更小的取值方向进行4次实验,结果表明,Lr0=0.01时的模型取得最优的检测性能。Lrf是一种优化参数,其主要思想是使用余弦函数动态调整学习率。Lrf可以将学习率从初始值逐步降低到最小值,从而提升模型的训练稳定性和泛化能力。表1中第2组实验以0.01为基础值,双向调整Lrf值的变化以分析Lrf对模型检测性能的影响。如表1所示,Lrf=0.01时模型具备最优异的检测性能。Momentum用于解决损失函数在训练过程中出现局部最小值而没有达到全局最优的问题,其原理是由动量和梯度共同决定损失函数的运动方向,减少损失震荡现象,更快找到全局最优解。第3组实验结果表明,Momentum=0.937时模型取得最佳的检测性能。

表1 训练参数对比实验

Table 1 Experiment with comparison of training parameters

组别Lr0LrfMomentummAP_0.5mAP_0.5:0.951230.0010.0100.9370.8750.5530.0050.0100.9370.9150.6390.0100.0100.9370.9240.6770.0500.0100.9370.9110.6350.1000.0100.937000.0100.0010.9370.9200.6580.0100.0050.9370.9220.6540.0100.0100.9370.9240.6770.0100.0500.9370.9160.6490.0100.1000.9370.9160.6550.0100.0100.9000.9140.6420.0100.0100.9300.9200.6610.0100.0100.9370.9240.6770.0100.0100.9500.9200.6590.0100.0101.00000

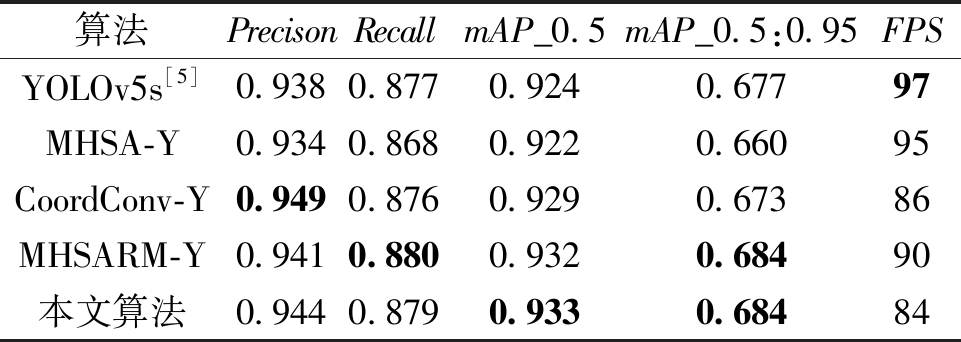

3.5 消融实验结果与分析

采用控制变量法对Kitti实验数据进行消融实验,目的是分析不同模块对改进YOLOv5s算法性能的影响,结果如表2所示。其中CoordConv-Y 、MHSARM-Y分别对应两种改进措施,mAP_0.5是IOU阈值为0.5的所有类别的平均精度值,mAP_0.5∶0.95是不同IOU阈值(从0.5到0.95)的mAP平均值。由表2可知,两种改进措施都提升了网络的检测性能。CoordConv-Y与基础算法相比,Precison提高了1.1百分点,Recall下降了0.1百分点。两者数据变化说明具备空间感知能力CoordConv能大幅度提升网络的检测精确度,但是针对漏检、错检问题,效果并不明显。MHSARM-Y与基础算法相比,Precison提高了0.3百分点,Recall上升0.2百分点,mAP_0.5提高了0.8百分点,该数据表明,MHSARM-Y具备更强的检测性能。

表2 消融实验数据对比

Table 2 Comparison of ablation experimental data

算法PrecisonRecallmAP_0.5mAP_0.5:0.95FPSYOLOv5s[5]0.9380.8770.9240.67797MHSA-Y0.9340.8680.9220.66095CoordConv-Y0.9490.8760.9290.67386MHSARM-Y0.9410.8800.9320.68490本文算法0.9440.8790.9330.68484

为对比MHSARM模块与MHSA模块之间的性能差异,采用控制变量对MHSA-Y、MHSARM-Y两种模型的结果进行数据分析,其中MHSA-Y是将C3模块替换成MHSA。由表2可知,与MHSA-Y相比,MHSARM-Y的Precison提高了0.7百分点,Recall提高了1.2百分点,mAP_0.5提高了1.0百分点。该数据表明,MHSA特征学习能力有限,其与Bottlentck组合而成的MHSARM,具备更强的检测性能。

由表2可知,改进YOLOv5s在检测性能方面的数据都优于原基础算法,整体检测精度上升明显,mAP_0.5提高了0.9百分点,Precison提高了0.6百分点,Recall提高了0.2百分点,mAP_0.5:0.95提高了0.7百分点。整体数据表明,YOLOv5s虽在Kitti数据集上取得了较好的效果,但是在复杂交通场景下的检测精度有限,漏检、错检等问题依然存在,改进YOLOv5s算法可以有效改善网络在各种复杂场景中的特征提取能力,使算法在自动驾驶交通目标检测领域的检测性能得到进一步提升。最后,比较FPS可以看出,就本次研究的平台环境而言,本文中各个改进点对实时性能造成的影响并不明显,仍可以达到自动驾驶实时性的要求。

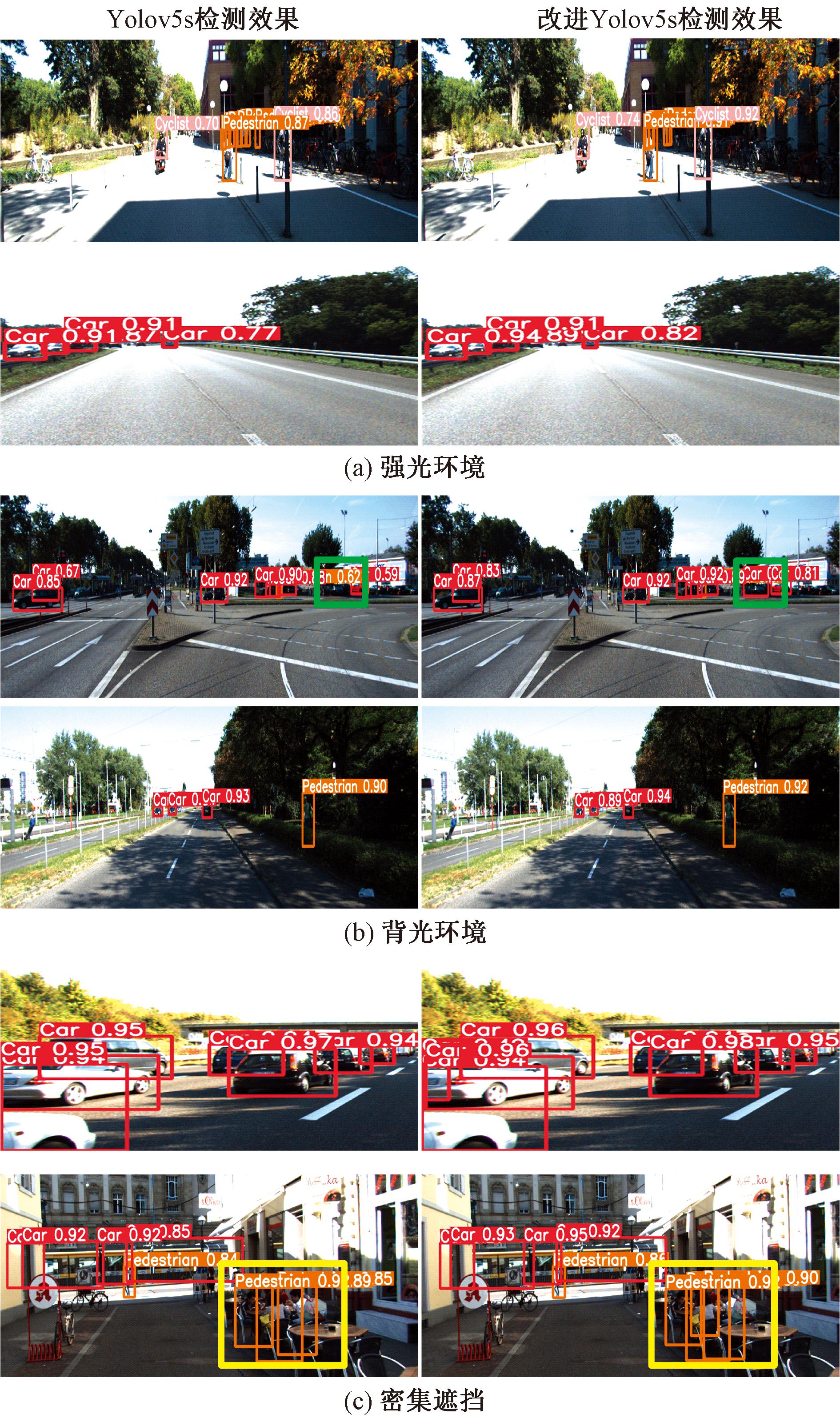

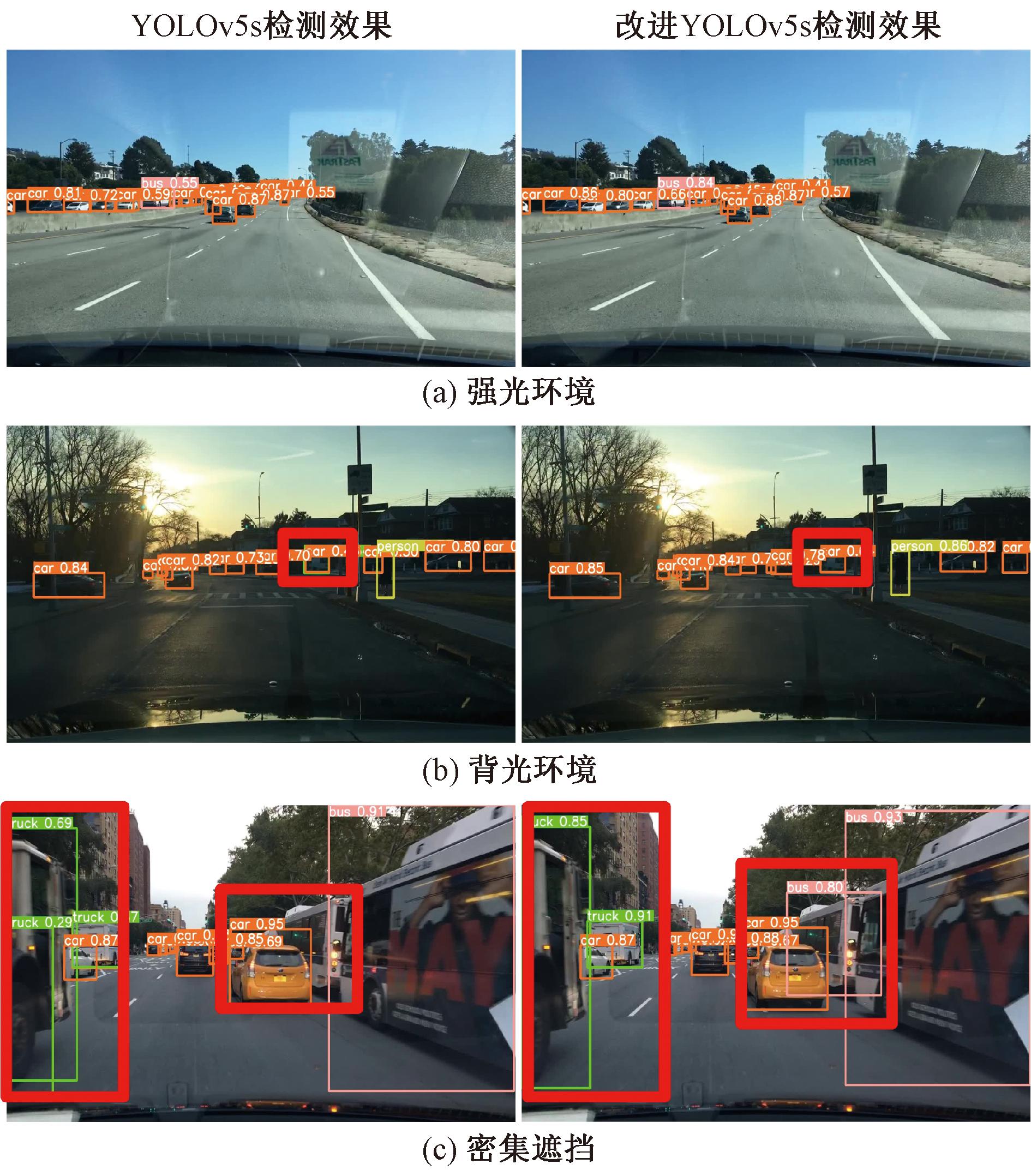

3.6 Kitti数据集检测效果分析

选取复杂背景典型样本(强光、背光、密集遮挡)的检测效果分析改进YOLOv5s对交通目标的检测能力,如图5所示。

图5 实际检测效果对比

Figure 5 Comparison of actual detection results

改进YOLOv5s的各种复杂场景下的目标框拥有更高的置信度。由图5(a)可以看出,在强光环境中,受强光照射的物体会导致物体色淡化、特征信息减弱,改进YOLOv5s网络改善了特征减弱的目标的检测性能。由图5(b)可以看出,在背光场景中,待检目标呈现黑色灰暗的状态,能见度、清晰度大幅降低,导致模型特征学习难度大,存在漏检现象(绿色方框区域),改进YOLOv5s通过强化对目标的关注度及学习目标空间维度特征的方式,提升网络对该类目标的特征提取能力,改善漏检的问题。由图5(c)可以看出,在交通场景中,交通目标密集拥堵现象造成待检目标仅保留局部特征,使得网络提取到的特征不全、不准,导致漏检问题(黄色区域所示),改进YOLOv5s通过MHSARM模块增强模型对关键点的特征提取能力,改善了漏检现象。

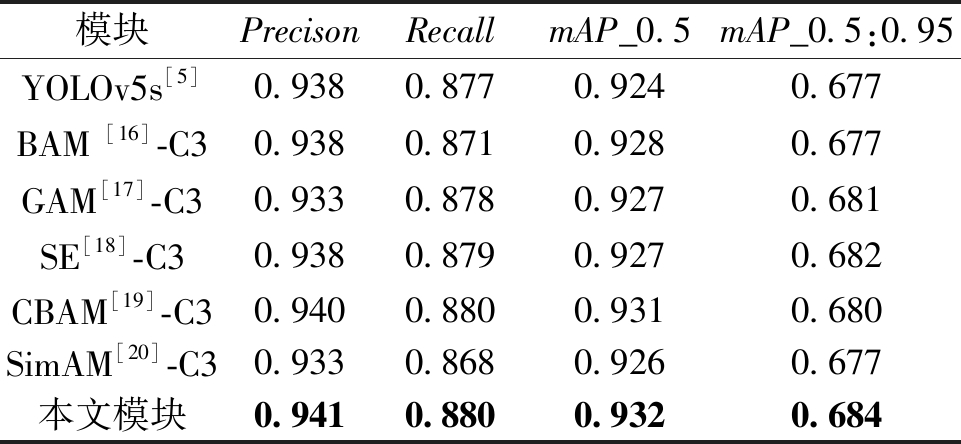

3.7 不同注意力机制改进模型对比

为了验证MHSARM的优势,分别采用多种表现优异的注意力机制对YOLOv5s中C3结构进行改进,改进方式与MHSARM一致,得到改进的模块BAM-C3、GAM-C3等,如表3所示。由表3可知,对比其他注意力残差结构,MHSARM的Precison、Recall、mAP_0.5、mAP_0.5:0.95均为最大值,表明由C3模块跟多头自注意力机制(MHSA)组合的MHSRAM在目标检测自动驾驶场景中有着更好的适用性,对交通目标的特征学习能力更强。此外,该实验数据再一次证明,对比其他表现优异的注意力机制,MHSA在应对复杂背景带来的干扰时抗性更强。

表3 不同注意力机制改进模型对比

Table 3 Different attention mechanisms comparison of improved models

模块PrecisonRecallmAP_0.5mAP_0.5:0.95YOLOv5s[5]0.9380.8770.9240.677BAM [16]-C30.9380.8710.9280.677GAM[17]-C30.9330.8780.9270.681SE[18]-C30.9380.8790.9270.682CBAM[19]-C30.9400.8800.9310.680SimAM[20]-C30.9330.8680.9260.677本文模块0.9410.8800.9320.684

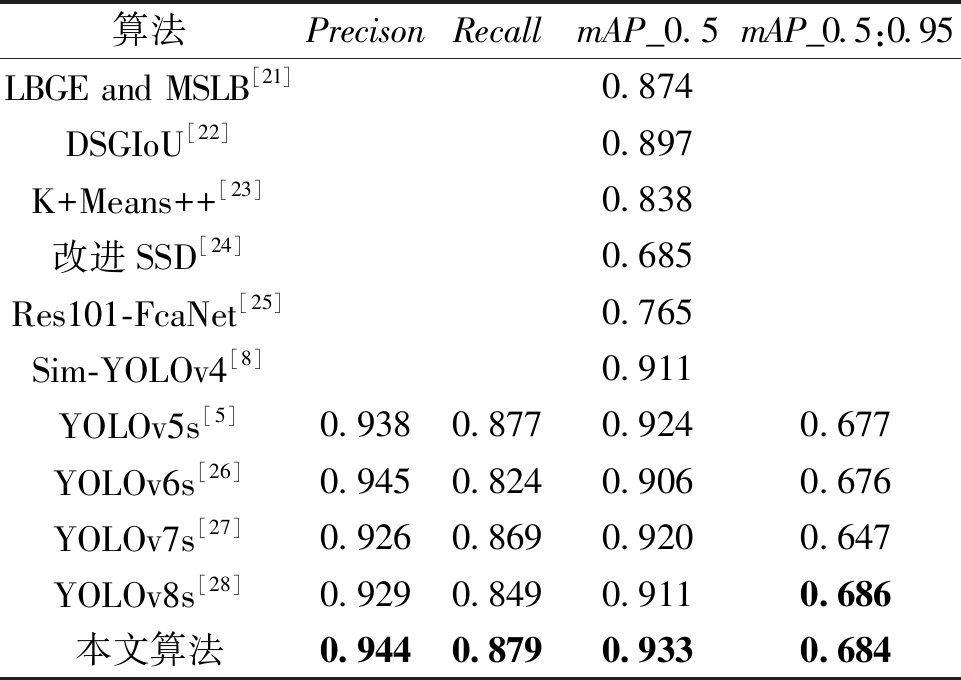

3.8 模型对比

为了进一步验证改进YOLOv5s的创新性及优势,本文从两个角度进行对比实验:①与主流的目标检测算法(YOLO系列)对比;②与在Kitti 数据集上最新的(2022年至2023年)研究成果对比。如表4所示,对比当前先进的目标检测网络,改进YOLOv5s算法的Precison、Recall、mAP_0.5均取得最好的效果,在自动驾驶交通目标检测任务中具备最优异的性能。

表4 模型性能比较

Table 4 Model performance comparison

算法PrecisonRecallmAP_0.5mAP_0.5:0.95LBGE and MSLB[21]0.874DSGIoU[22]0.897K+Means++[23]0.838改进SSD[24]0.685Res101-FcaNet[25]0.765Sim-YOLOv4[8]0.911YOLOv5s[5]0.9380.8770.9240.677YOLOv6s[26]0.9450.8240.9060.676YOLOv7s[27]0.9260.8690.9200.647YOLOv8s[28]0.9290.8490.9110.686本文算法0.9440.8790.9330.684

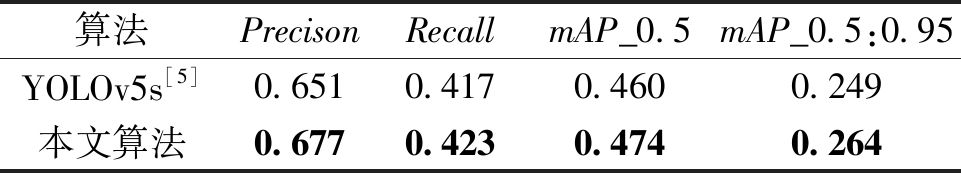

3.9 模型泛化能力验证

为进一步验证模型能力,排除数据集偏差的影响,在开源自动驾驶数据集BDD100K中分别对YOLOv5s和改进YOLOv5s进行测试和训练。BDD100K是迄今为止规模最大、内容最具多样性的开源数据集,总共包含105张图像数据,本次实验采用的是BDD100K轻量级数据集,共包含10 000张图像数据,包含10个类别,为了排除误差,删除样本数极少的类别,最终保留6个类别。与Kitti数据集相比,该数据集数据类型更多,采集环境丰富,背景干扰强度也更大。

表5为两种模型在数据集的性能比较, 从表5中可以看出,改进YOLOv5s对比原基础模型,各个参数数值均取得提升,其中Precison提高了1.6%,Recall提高了0.6%,mAP_0.5提高了1.4%,mAP_0.5:0.95提高了1.5%。

表5 两种网络模型性能比较

Table 5 Performance comparison of the two network models

算法PrecisonRecallmAP_0.5mAP_0.5:0.95YOLOv5s[5]0.6510.4170.4600.249本文算法0.6770.4230.4740.264

3.10 BDD100K检测效果分析

图6为YOLOv5s和改进YOLOv5s在BDD100K数据集上各类场景的检测效果对比。由图6可知,在各类环境中,改进YOLOv5s的目标框拥有更高的置信度。如图6中红色边框所示,YOLOv5s对特征信息不明显以及局部丢失的交通目标存在错检、漏检、重检等现象。改进YOLOv5s弱化了背景干扰,在关注目标信息的同时,通过学习空间信息特征优化检测性能,缓解了上述现象。改进YOLOv5s除了在Kitti数据集有着较好的检测效果,在类别更多、场景更复杂的数据集中同样拥有更好的检测效果。

图6 在BDD100K数据集上的实际检测效果对比

Figure 6 Comparison of actual detection results on BDD100K dataset

4 结论

本文提出改进YOLOv5s复杂道路交通目标检测算法。在特征提取区域,引入基于多头自注意力机制残差模块(MHSARM),在含有强语义信息的深层特征层采用分配权重的方式,强化目标信息,抑制背景干扰。经实验证明,MHSARM应对复杂的交通场景的特征提取能力明显超越原C3模块。特征融合方面,使用CoordConv代替传统卷积,使网络具备感知空间位置信息的能力,实现更丰富的特征融合。经实验证明,在自动驾驶领域,具备空间感知能力的检测网络能更精准地检测出目标。

改进YOLOv5s网络虽然在强光、背光、密集遮挡等场景下取得良好的效果,但是面对更复杂的背景,如下雨天、大雾天气、下雪天的检测性能依然有限。同时,据检测效果分析,改进YOLOv5s面对跨度大的目标时,存在严重的重检现象,面对局部特征丢失的小目标存在较严重漏检现象。下一步工作主要解决三个问题:对跨度大的目标重检率较高的问题;局部特征的小目标漏检问题;面对更复杂的场景检测能力有限的问题。

[1] 崔家悦. 浅谈自动驾驶的研究现状和发展[J]. 科技资讯, 2021, 19(13): 83-85.

CUI J Y. Research status and development of automatic driving[J]. Science &Technology Information, 2021, 19(13): 83-85.

[2] GIRSHICK R, DONAHUE J, DARRELL T, et al. Region-based convolutional networks for accurate object detection and segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2016, 38(1): 142-158.

[3] CHEN Y H, LI W, SAKARIDIS C, et al. Domain adaptive faster R-CNN for object detection in the wild[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2018: 3339-3348.

[4] REDMON J, DIVVALA S, GIRSHICK R, et al. You only look once: unified, real-time object detection[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway: IEEE, 2016: 779-788.

[5] ULTRALYTICS. Yolov5[EB/OL].[2023-08-11].https:∥github.com/ultralytics/yolov5.

[6] LIU R, LEHMAN J, MOLINO P, et al. An intriguing failing of convolutional neural networks and the CoordConv solution[C]∥Proceedings of the 32nd International Conference on Neural Information Processing Systems. New York: ACM, 2018: 9628-9639.

[7] 袁志宏, 孙强, 李国祥, 等. 基于Yolov3的自动驾驶目标检测[J]. 重庆理工大学学报(自然科学), 2020, 34(9): 56-61.

YUAN Z H, SUN Q, LI G X, et al. Automatic driving target detection based on Yolov3[J]. Journal of Chongqing University of Technology (Natural Science), 2020, 34(9): 56-61.

[8] 刘丽伟, 侯德彪, 侯阿临, 等. 基于SimAM-YOLOv4的自动驾驶目标检测算法[J]. 长春工业大学学报, 2022, 43(3): 244-250.

LIU L W, HOU D B, HOU A L, et al. Automatic driving target detection algorithm based on SimAM-YOLOv4[J]. Journal of Changchun University of Technology, 2022, 43(3): 244-250.

[9] 院老虎, 常玉坤, 刘家夫. 基于改进YOLOv5s的雾天场景车辆检测方法[J]. 郑州大学学报(工学版), 2023, 44(3): 35-41.

YUAN L H, CHANG Y K, LIU J F. Vehicle detection method based on improved YOLOv5s in foggy scene[J]. Journal of Zhengzhou University (Engineering Science), 2023, 44(3): 35-41.

[10] CAI Y F, LUAN T Y, GAO H B, et al. YOLOv4-5D: an effective and efficient object detector for autonomous driving[J]. IEEE Transactions on Instrumentation and Measurement, 2021, 70: 4503613.

[11] SHI T, DING Y, ZHU W X. YOLOv5s_2E: improved YOLOv5s for aerial small target detection[J]. IEEE Access, 2023, 11: 80479-80490.

[12] GAO T Y, WUSHOUER M, TUERHONG G. DMS-YOLOv5: a decoupled multi-scale YOLOv5 method for small object detection[J]. Applied Sciences, 2023, 13(10): 6124.

[13] VASWANI A, SHAZEER N, PARMAR N, et al. Attention is all you need[C]∥Proceedings of the 31st International Conference on Neural Information Processing Systems. New York: ACM, 2017: 6000-6010.

[14] WU C H, WU F Z, GE S Y, et al. Neural news recommendation with multi-head self-attention[C]∥Proceedings of the 2019 Conference on Empirical Methods in Natural Language Processing and the 9th International Joint Conference on Natural Language Processing (EMNLP-IJCNLP). Stroudsburg: Association for Computational Linguistics, 2019: 6389-6394.

[15] ZHANG Y F, REN W Q, ZHANG Z, et al. Focal and efficient IOU loss for accurate bounding box regression[J]. Neurocomputing, 2022, 506: 146-157.

[16] PARK J, WOO S, LEE J Y, et al. BAM: bottleneck attention module[EB/OL]. (2018-07-17)[2023-08-11]. http:∥arxiv.org/abs/1807.06514.

[17] LIU Y C, SHAO Z R, HOFFMANN N. Global attention mechanism: retain information to enhance channel-spatial interactions[EB/OL].(2021-10-10)[2023-08-11]. http:∥arxiv.org/abs/2112.05561.

[18] HU J, SHEN L, ALBANIE S, et al. Squeeze-and-excitation networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020, 42(8): 2011-2023.

[19] WOO S, PARK J, LEE J Y, et al. CBAM: convolutional block attention module[C]∥European Conference on Computer Vision. Cham: Springer, 2018: 3-19.

[20] YANG L X, ZHANG R Y, LI L D, et al. Simam: a simple, parameter-free attention module for convolutional neural networks[C]∥Proceedings of the 38th International Conference on Machine Learning. United States: International Conference on Machine Learning,2021: 11863-11874.

[21] SU T, SHI Y, XIE C J, et al. A hybrid loss balancing algorithm based on gradient equilibrium and sample loss for understanding of road scenes at basic-level[J]. Pattern Analysis and Applications, 2022, 25(4): 1041-1053.

[22] 马素刚, 李宁博, 侯志强, 等. 基于DSGIoU损失与双分支坐标注意力的目标检测算法[J/OL].北京航空航天大学学报, 2023: 1-14.https:∥bhxb.buaa.edu.cn/bhzk/cn/article/doi/10.13700/j.bh.1001-5965.2023.0192.

MA S G, LI N B, HOU Z Q, et al. Object detection algorithm based on DSGIoU loss and dual branch coordinate attention[J/OL]. Journal of Beijing University of Aeronautics and Astronautics, 2023: 1-14.https:∥bhxb.buaa.edu.cn/bhzk/cn/article/doi/10.13700/j.bh.1001-5965.2023.0192.

[23] 丁剑洁, 安雯. 基于改进锚点框与Transformer架构的目标检测算法[J]. 现代电子技术, 2023, 46(15): 37-42.

DING J J, AN W. Object detection algorithm based on improved anchor box and transformer architecture[J]. Modern Electronics Technique, 2023, 46(15): 37-42.

[24] 李娟娟, 侯志强, 白玉, 等. 基于空洞卷积和特征融合的单阶段目标检测算法[J]. 空军工程大学学报(自然科学版), 2022, 23(1): 97-103.

LI J J, HOU Z Q, BAI Y, et al. Single-stage object detection algorithm based on dilated convolution and feature fusion[J]. Journal of Air Force Engineering University (Natural Science Edition), 2022, 23(1): 97-103.

[25] 侯志强, 郭浩, 马素刚, 等. 基于双分支特征融合的无锚框目标检测算法[J]. 电子与信息学报, 2022, 44(6): 2175-2183.

HOU Z Q, GUO H, MA S G, et al. Anchor-free object detection algorithm based on double branch feature fusion[J]. Journal of Electronics &Information Technology, 2022, 44(6): 2175-2183.

[26] LI C Y, LI L L, JIANG H L, et al. YOLOv6: a single-stage object detection framework for industrial applications[EB/OL]. (2022-09-07)[2023-08-11]. http:∥arxiv.org/abs/2209.02976.

[27] WANG C Y, BOCHKOVSKIY A, LIAO H Y M. YOLOv7: trainable bag-of-freebies sets new state-of-the-art for real-time object detectors[C]∥2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway: IEEE, 2023: 7464-7475.

[28] ULTRALYTICS.YOLOv8[EB/OL].(2023-01-01)[2023-08-11]. https:∥github.com/ultralytics/ultralytics.