图像超分辨率重建(super-resolution, SR)是一项重要的底层计算机视觉任务,旨在将低分辨率(low-resolution, LR)图像转换为高分辨率(high-resolution, HR)图像,这一技术在图像识别、遥感探测和视频监控等领域中具有重要应用价值。传统的SR方法通过填补图像放大后像素空缺的位置来提高图像的分辨率,往往忽略了图像的详细纹理信息。因此,需要更加高效的方法来解决这个问题。

近年来,基于深度学习的SR方法重建出图像的纹理细节更加丰富[1]。2015年,Dong等[2]提出了首个基于CNN的超分辨率重建网络SRCNN (super-resolution convolutional neural network),大大提高了图像重建质量。Dong等[3]对SRCNN进行改进,提出了FSRCNN (fast super-resolution convolutional neural network),FSRCNN是第1个使用反卷积层从LR特征图中重建HR图像的SR方法,但是网络仍然过于简单,重建出的纹理细节不够丰富。Kim等[4]提出了VDSR(very deep convolutional networks),其网络架构为20层的残差网络,但VDSR将图像插值放大后进行训练,增加了网络训练难度。Lim等[5]提出了EDSR (enhanced deep residual network for single image super-resolution),该方法移除批处理归一化层以降低内存占用,加深网络结构来提取更加丰富的特征。Lai等[6]提出了LapSRN (deep laplacian pyramid networks for fast and accurate super-resolution),该网络利用金字塔结构逐级生成高分辨率图像。为了进一步提升SR的性能,Kim等[7]提出了DRCN (deeply-recursive convolutional network),使用相同的模块来递归地学习高级特征,但是递归学习也会导致梯度消失和梯度爆炸。Tai等[8]提出了DRRN (deep recursive residual network),网络使用残差块作为递归模块的一部分,并结合局部残差和全局残差来提高网络的特征利用能力。Zhang等[9]提出了RCAN(residual channel attention network),在残差块中引入注意力机制,提高网络对低频、高频特征的判别能力。Ahn等[10]提出了CARN (cascading residual network),采用全局和局部级联结构提取中间特征,但网络将提取到的中间特征集中到1×1卷积中,阻碍了信息的传递。

一些方法不断加深网络,在一定程度上提升了图像的重建效果,但仍然存在特征利用率低导致重建图像信息模糊的问题。与以往方法不同的是,本文充分考虑了图像特征提取以及融合对网络性能的影响,提出了一种基于双特征提取和注意力机制的图像超分辨率重建方法。特别地,本文提出了局部空间注意力模块(local spatial attention block, LSAB),并将其与Hu等[11]提出的通道注意力模块 (channel attention block, CAB)相结合,增强网络在通道维度和空间维度上的细节信息感知能力,使网络获取更加有效的轮廓、纹理信息。此外,本文构建空洞金字塔模块(atrous pyramid block, APB)以提高网络的多尺度特征提取能力。

为了有效提取融合高频特征和多尺度特征,本文设计了双分支网络。第1个分支通过注意力机制使网络提取到更加精细的高频特征,第2个分支使用空洞金字塔模块扩大网络感受野,提取多尺度特征,最后将提取到的特征进行上采样并进一步融合。考虑到注意力机制可以有效改善网络性能,提出了LSAB,提高网络对高频特征的定位能力。将LSAB与CAB相结合构建残差融合注意力模块(residual fusion attention block, RFAB),使网络在通道维度和空间维度上更加关注高频特征。本文提出的APB模块各分支由扩张率不同的空洞卷积构成,扩大了网络感受野,使得网络以多尺度提取特征。

1 本文方法

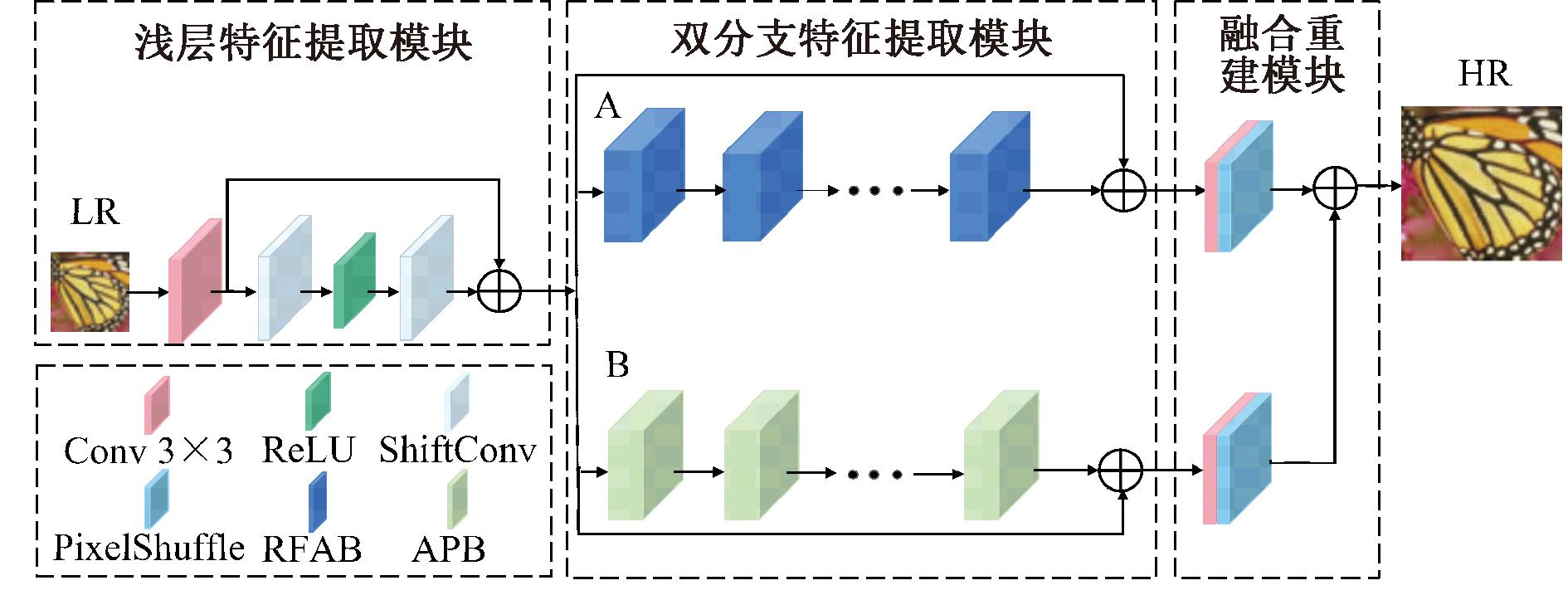

为了提高图像的重建质量,本文提出了一种基于双特征提取和注意力机制的图像超分辨率重建方法。整体网络结构如图1所示,主要由3个模块组成:浅层特征提取模块、双分支特征提取模块、融合重建模块。

图1 整体网络结构图

Figure 1 Structure of the overall network

首先,低分辨率图像ILR由3×3卷积进行浅层特征提取,为了对提取到的特征进一步细化,将低频信息进一步过滤,提取到的特征将由Wu等[12]提出的移位卷积进一步处理。该过程如式(1)所示:

(1)

式中:f0(·)表示3×3卷积特征提取函数;fshift(·) 表示移位卷积函数;δ(·)表示ReLU激活函数;ILR和H1分别表示该模块的输入和输出。

细化后的浅层特征H1将进入双分支特征提取模块,双分支网络由A、B这2个分支组成。H1将同时进入2个分支,其中A分支由若干个残差融合注意力模块和一个长短跳跃连接组成,B分支由若干个级联的空洞金字塔模块和一个长短跳跃连接构成。该过程如式(2)所示:

(2)

式中:fA(·)和fB(·)分别表示A、B这2个分支的深层特征提取函数。

其次,提取到的深层特征H2和H3分别进入图像重建模块。

最后,将重建后的两组特征进行融合生成最后的高分辨率图像ISR。该过程如式(3)所示:

ISR=fup(H2)+fup(H3)。

(3)

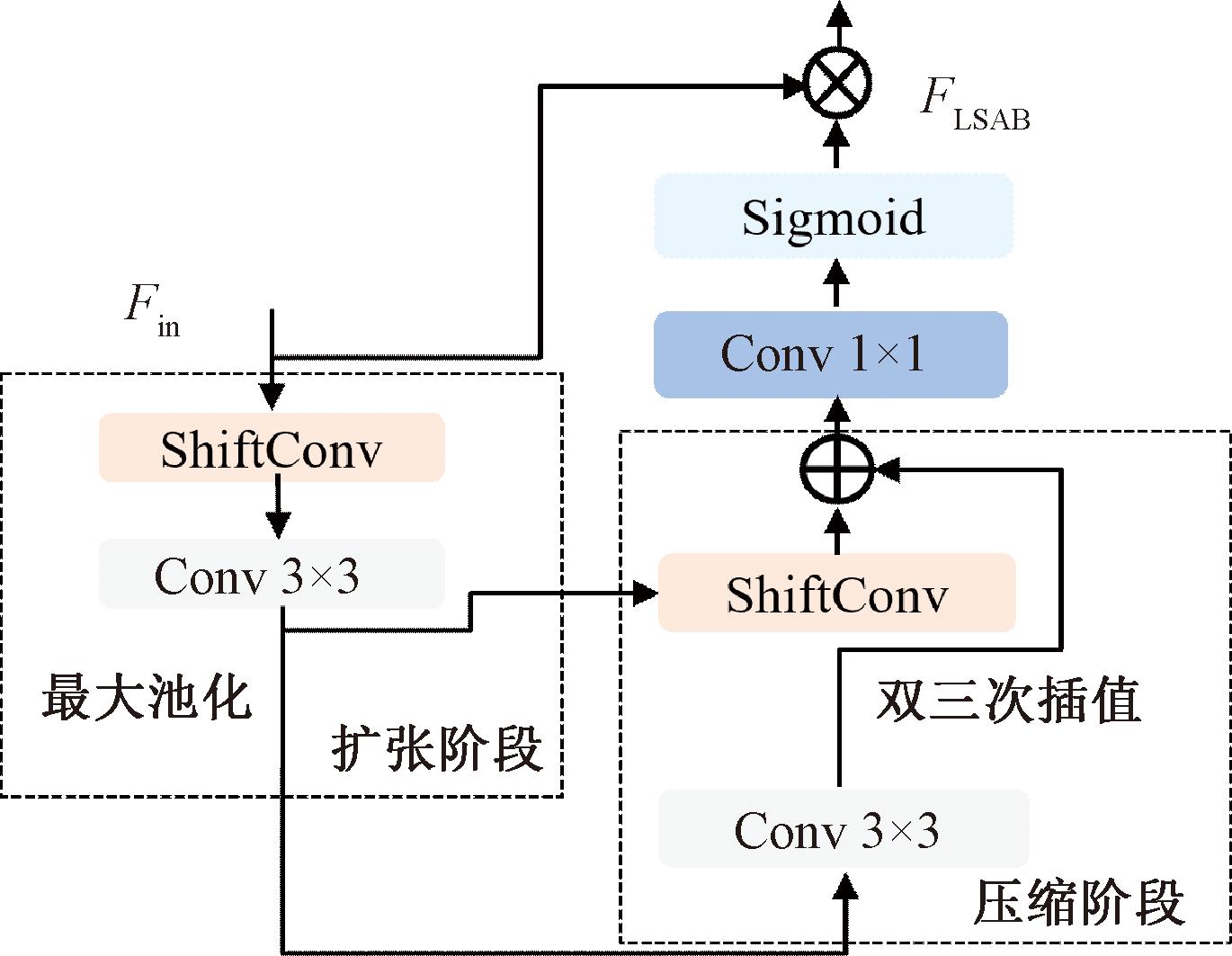

1.1 局部空间注意力模块(LSAB)

虽然CAB可以有效改善网络性能,但是只能捕捉图像不同通道之间的特征相关性。本文提出了LSAB,对输入的每个特征赋予不同的权重,使网络更加关注空间特征信息,保证空间信息完整性的同时提高网络对高频特征的定位能力。该模块共分为压缩和扩张2个阶段,其详细结构如图2所示。

图2 局部空间注意力模块

Figure 2 Local spatial attention block

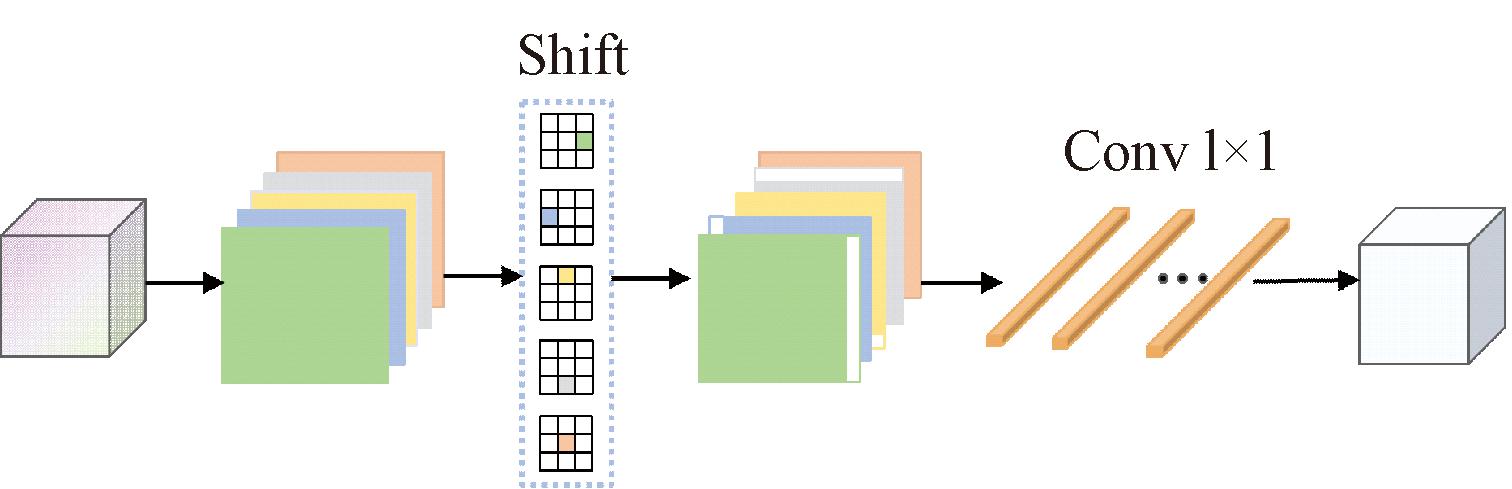

压缩阶段:输入的特征图首先通过移位卷积进行处理,移位卷积由一组移位操作和一个1×1卷积构成,在不引入额外参数的情况下,通过移位操作扩大感受野,并且由1×1卷积整合信息,其详细结构如图3所示。

图3 移位卷积结构图

Figure 3 Structure of shift-convolution

其次,使用3×3卷积进一步提取特征,通过最大池化进行下采样,使特征图内的高频区域更加突出。该过程如式(4)所示:

Fseq=f↓(f3×3(fshift(Fin)))。

(4)

式中:Fin和Fseq分别为压缩阶段的输入和输出;fshift(·) 和f3×3(·)分别表示移位卷积和3×3卷积的特征提取函数;f↓(·)表示最大池化下采样。

扩张阶段:通过3×3卷积、双三次插值上采样和移位卷积对特征进一步处理,与压缩阶段相呼应。为了充分利用已提取到的特征,避免下采样特征丢失,将压缩阶段下采样之前提取的特征输入到扩张阶段的移位卷积层,并与上采样得到的特征图逐像素相加,然后经过一个1×1卷积调整通道得到该模块的输出,该过程如式(5)所示:

(5)

式中:Fout和Fext分别为压缩阶段3×3卷积和扩张阶段的输出;f↑(·)表示双三次插值上采样;f1×1(·)和f3×3(·)分别表示1×1和3×3卷积函数;fshift(·)表示移位卷积函数。

最后,通过Sigmoid函数得到局部空间注意力权重,对输入的特征图进行调整,该过程如式(6)所示:

FLSAB=Fin·δ(Fext)。

(6)

式中:δ(·)表示激活函数;Fin和FLSAB分别表示LSAB的输入和输出。

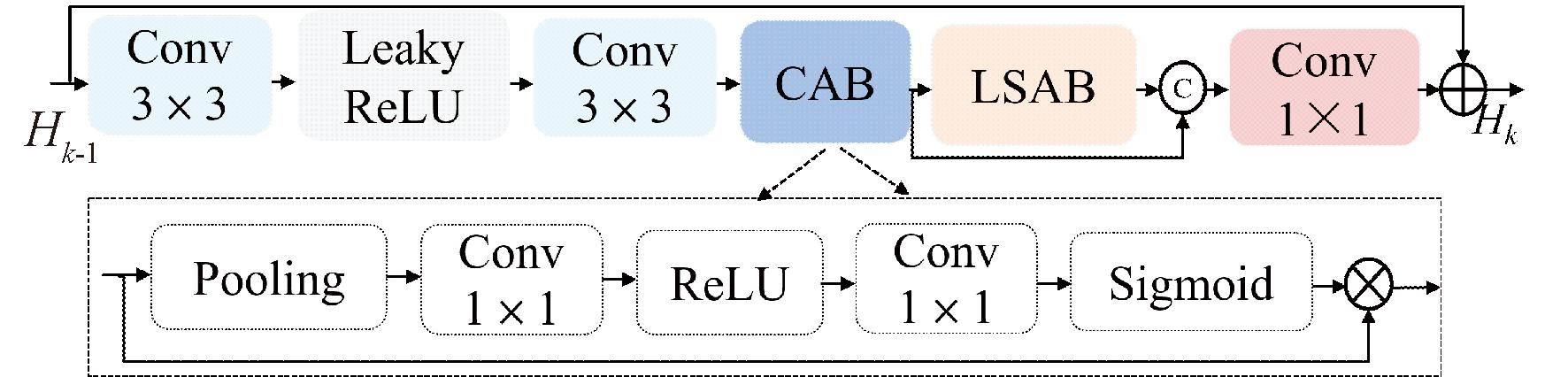

1.2 残差融合注意力模块(RFAB)

大多数图像超分辨率重建方法在特征提取时忽略了通道维度和空间维度上特征分布的差异性,导致网络无法充分提取图像的高频特征。针对该问题,本文将CAB与LSAB相结合,构建RFAB模块进行深层特征提取。通过CAB使网络根据通道信息量的多少选择特征,且LSAB能够提高网络对高频特征的定位能力,从而使网络选取更加精细的高频特征。其详细结构如图4所示。

图4 残差融合注意力模块

Figure 4 Residual fusion attention block

第k个RFAB的输出结果可以表示为

Hk=Fk(Hk-1)。

(7)

式中:Hk-1和Hk分别表示第k个RFAB的输入和输出;Fk(·)表示第k个RFAB函数,具体操作如下。

首先,Hk-1经过2个3×3卷积层、1个Leaky ReLU激活层得到H′k-1,该过程如式(8)所示:

H′k-1=f3×3(δ(f3×3(Hk-1)))。

(8)

式中:f3×3(·)代表3×3卷积层函数;δ(·)为Leaky ReLU激活函数。

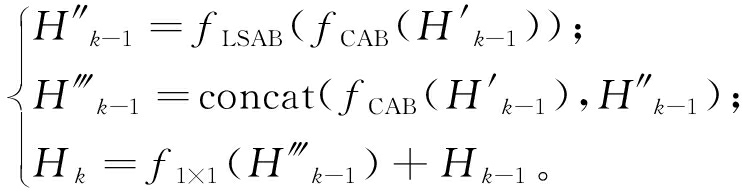

其次,H′k-1通过CAB提取到特征,使网络判别出不同通道特征的重要程度,忽略不相关的信息。提取到的特征之后进入LSAB得到H″k-1,使网络更加准确地定位到高频特征所在的空间位置。

最后,将LSAB与CAB提取到的特征进行拼接,使用1×1卷积调整通道,得到输出Hk,该过程如式(9)所示:

(9)

式中:f1×1(·)表示1×1卷积函数;fCAB(·)和fLSAB(·)分别代表CAB和LSAB所用的功能函数。

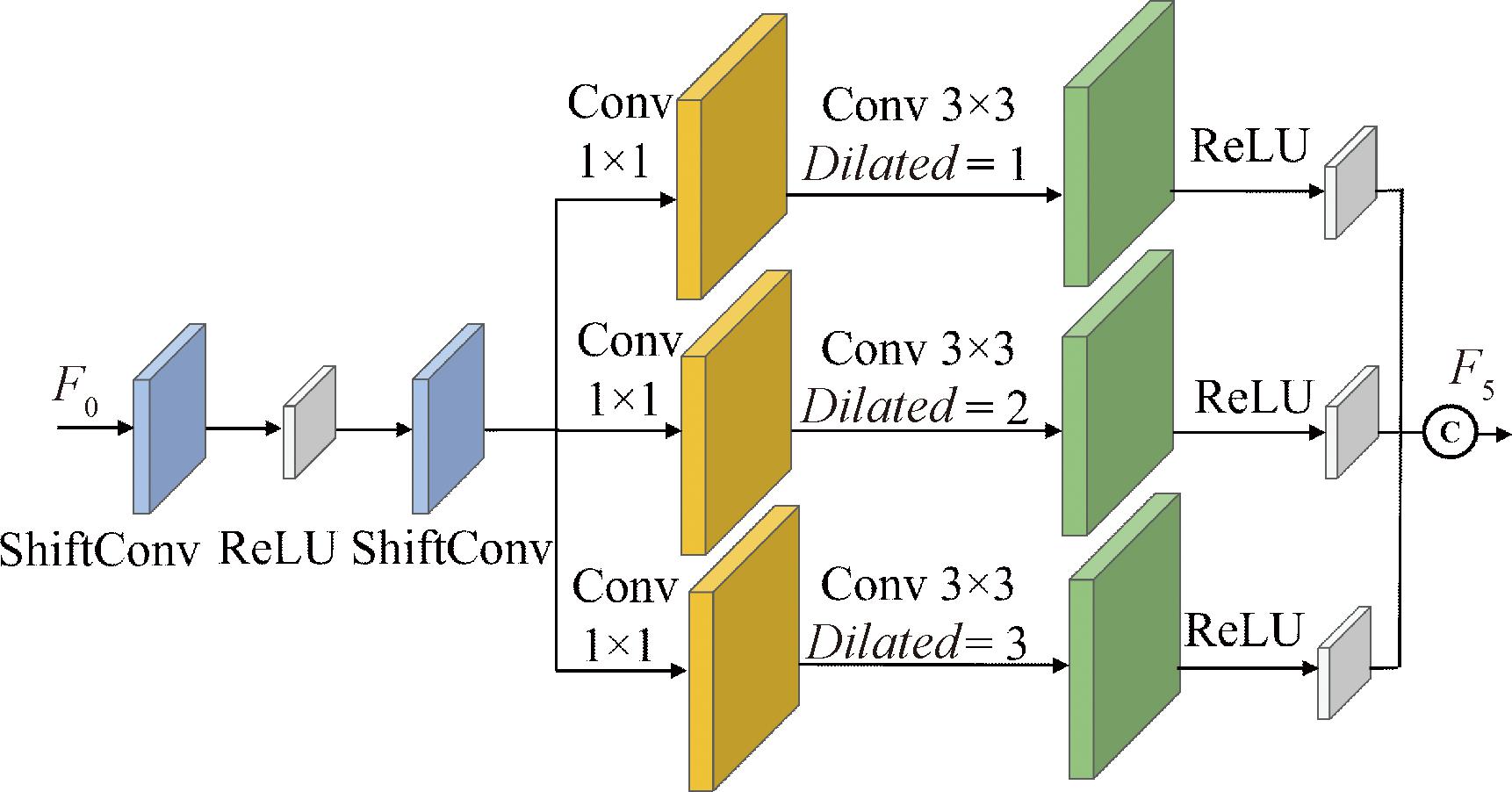

1.3 空洞金字塔模块(APB)

为了扩大网络感受野,使网络多尺度提取图像特征,本文设计了APB,详细结构如图5所示。该模块由不同类型的卷积构成,共分为3个分支。首先通过2个移位卷积和1个ReLU激活函数,使网络获得更大的感受野;其次采用并行的方式使用扩张率为1,2,3的3×3卷积多尺度提取特征;最后将每个分支提取到的特征进行拼接。为了减少参数量并且保证重建质量,本文在每个分支开端增加了1×1卷积进行降维。

图5 空洞金字塔模块

Figure 5 Atrous pyramid block

该过程如式(10)所示:

(10)

式中:fshift(·)表示移位卷积函数;![]() 表示扩张率为i的空洞卷积函数;f1×1(·)表示1×1卷积函数;δ(·)表示ReLU激活函数。

表示扩张率为i的空洞卷积函数;f1×1(·)表示1×1卷积函数;δ(·)表示ReLU激活函数。

1.4 损失函数

本文实验采用L1[13]损失函数,给定N对训练样本,通过模型训练来研究其端到端的映射关系,不断优化调整降低损失函数。损失函数定义为

(11)

式中:N表示样本对的数量;IHR和ISR分别表示原始HR图像和生成的SR图像。

2 实验与结果分析

2.1 数据集

本文实验使用DIV2K数据集作为训练数据集。在图像处理过程中,对图像进行旋转、翻转并裁剪成64×64大小的图像块,以便模型的训练和优化。为了验证该模型性能,采用Set5、Set14、BSD100、Urban100[14]4个基准数据集作为测试数据集。这些数据集被广泛应用于图像超分辨率重建领域,能够有效评估模型的重建效果。为了证明本文方法的有效性,采用峰值信噪比 (PSNR)和结构相似度 (SSIM)对实验结果进行客观评价[15]。

2.2 实验环境

本文方法实验平台的CPU为Intel(R) Xeon(R) Platinum 8255C,GPU为RTX 3080,Cuda11.1。模型的训练环境为Python3.7,编程框架为Pytorch1.8.1。采用Adam优化器训练网络以及优化参数,β1=0.9,β2=0.999,设定batchsize为8,初始学习率为0.000 1,每个尺度因子的epoch均为500,每训练250个回合,学习率下降50%。

2.3 消融实验

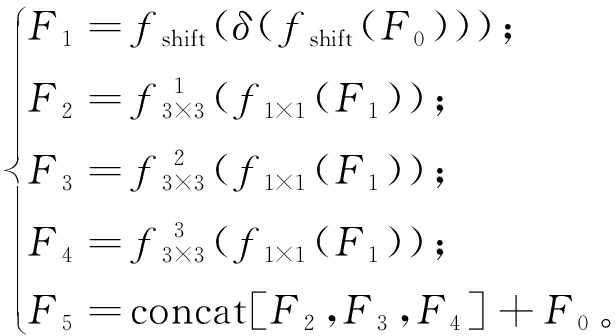

2.3.1 LSAB对图像重建质量的影响

CAB只能在通道维度上根据通道所包含的信息量多少进行选择,无法准确定位图像的高频特征,本文设计了LSAB解决此问题。为了研究LSAB对图像重建的影响,去除RFAB中的LSAB进行对比。在Set5数据集上的重建结果如表1所示,与原始网络模型相比,去除LSAB的网络后,PSNR和SSIM分别下降了0.18 dB和0.003 3,验证了LSAB对高频特征提取有一定的作用。

表1 LSAB和APB对图像重建质量的影响

Table 1 The effects of LSAB and APB on image reconstruction quality

LSABAPBPSNR/dB SSIM无有32.070.893 5有无31.030.876 6有有32.250.896 8

2.3.2 APB对图像重建质量的影响

此外,为了研究APB对图像重建质量的影响,将该模块从网络中去除,如表1所示,去除APB后PSNR和SSIM都有所下降,说明APB使网络提取到的特征更加全面,从而可以提高网络重建性能。

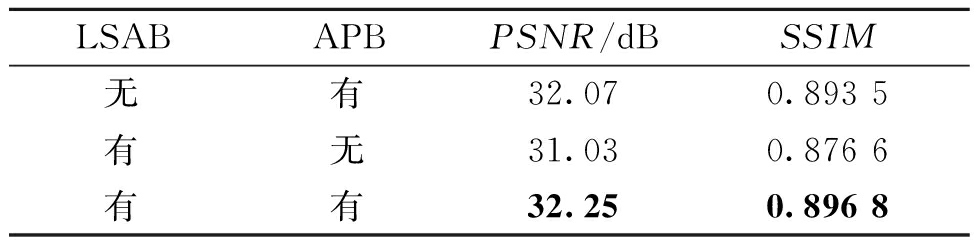

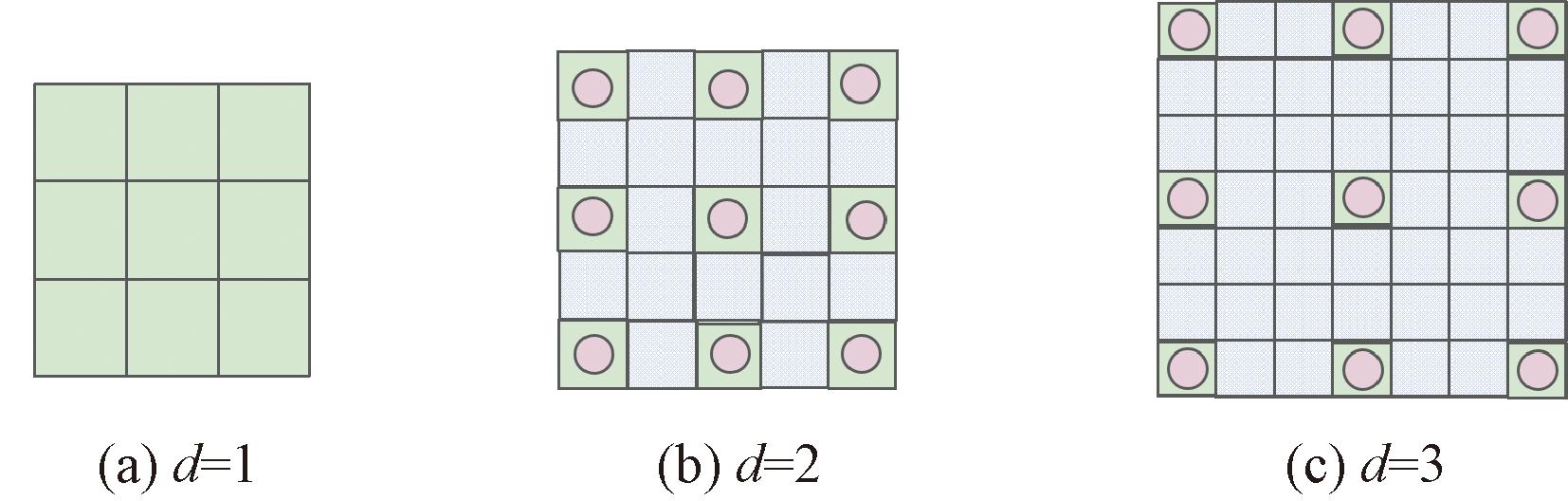

2.3.3 空洞卷积对图像重建质量的影响

本文提出APB的目的是扩大网络感受野以提取图像的多尺度信息,APB由扩张率d为1,2,3的3×3卷积构成。图6为空洞卷积的原理图,通过填充0扩张标准卷积核,来获得不同大小的感受野[16]。

图6 空洞卷积原理图

Figure 6 Schematic diagram of dilated convolution

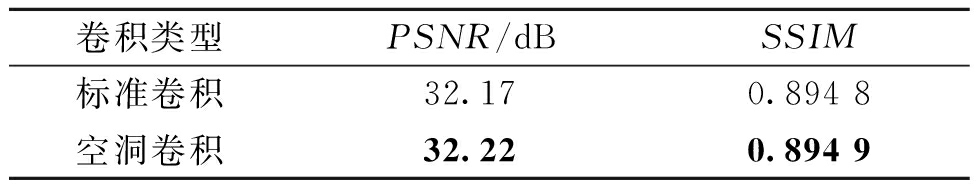

为了进一步验证空洞卷积对图像重建的有效性,本文将空洞卷积构成的金字塔结构与标准卷积构成的金字塔结构进行超分辨率重建对比,在Set5数据集上的对比结果如表2所示。由表2可以看出,APB中使用空洞卷积相比于使用标准卷积,PSNR和SSIM分别提高了0.05 dB和0.000 1,验证了空洞卷积的有效性。

表2 空洞卷积对图像重建质量的影响

Table 2 The effects of dilated convolution on image reconstruction quality

卷积类型PSNR/dBSSIM标准卷积32.170.894 8空洞卷积32.220.894 9

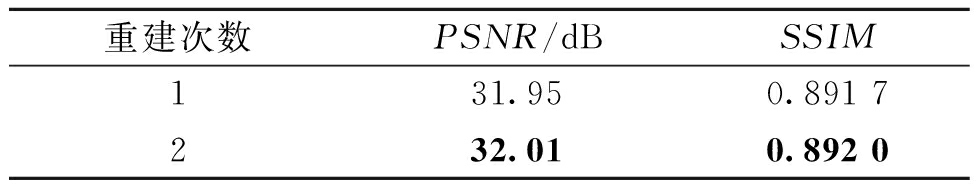

2.3.4 图像重建模块对图像重建质量的影响

本文对2个分支网络所提取到的特征分别使用亚像素卷积进行重建,为了验证其有效性,本文设置了消融实验,将A、B这2个分支融合后进行一次重建,在Set5数据集上的重建结果如表3所示。由表3可知,重建2次得到的PSNR和SSIM分别提高了0.06 dB和0.000 3。说明对2个分支的特征分别上采样进行重建有利于提高重建效果。

表3 不同重建次数对图像重建质量的影响

Table 3 The effects of different reconstruction times on image reconstruction quality

重建次数PSNR/dB SSIM131.950.891 7232.010.892 0

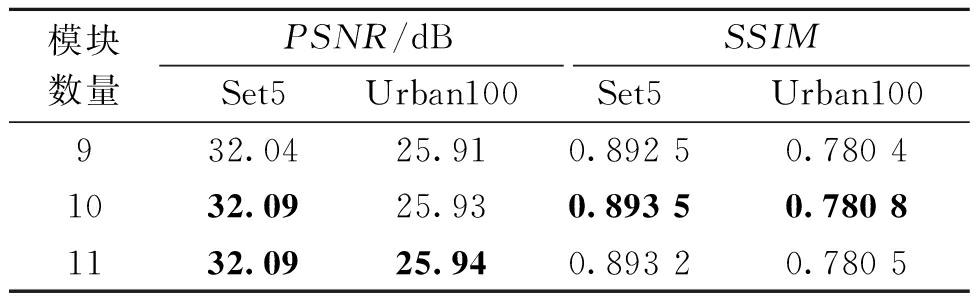

2.3.5 网络深度对图像重建质量的影响

本文提出的网络模型包含A和B分支,每个分支分别由10个RFAB和10个APB构成。为了验证采用不同数目的RFAB和APB对于图像重建质量的影响,本次实验在2个测试数据集上设置了3组实验(模块数量分别为9,10,11)进行4倍的图像超分辨率实验,如表4所示。由表4可知,随着网络深度的增加,PSNR和SSIM都有提高的趋势。当2个模块数量均为10时,模型的性能达到最优;当2个模块数量均为9时,模型的性能指标明显降低;当2个模块数量均为11时,模型的性能指标没有明显升高,甚至降低。考虑到计算成本,本文深层特征提取采用10个RFAB和10个APB模块。

表4 网络深度对图像重建质量的影响

Table 4 The effects of depths of network on image reconstruction quality

模块数量PSNR/dB SSIMSet5Urban100Set5Urban100932.0425.910.892 50.780 41032.0925.930.893 50.780 81132.0925.940.893 20.780 5

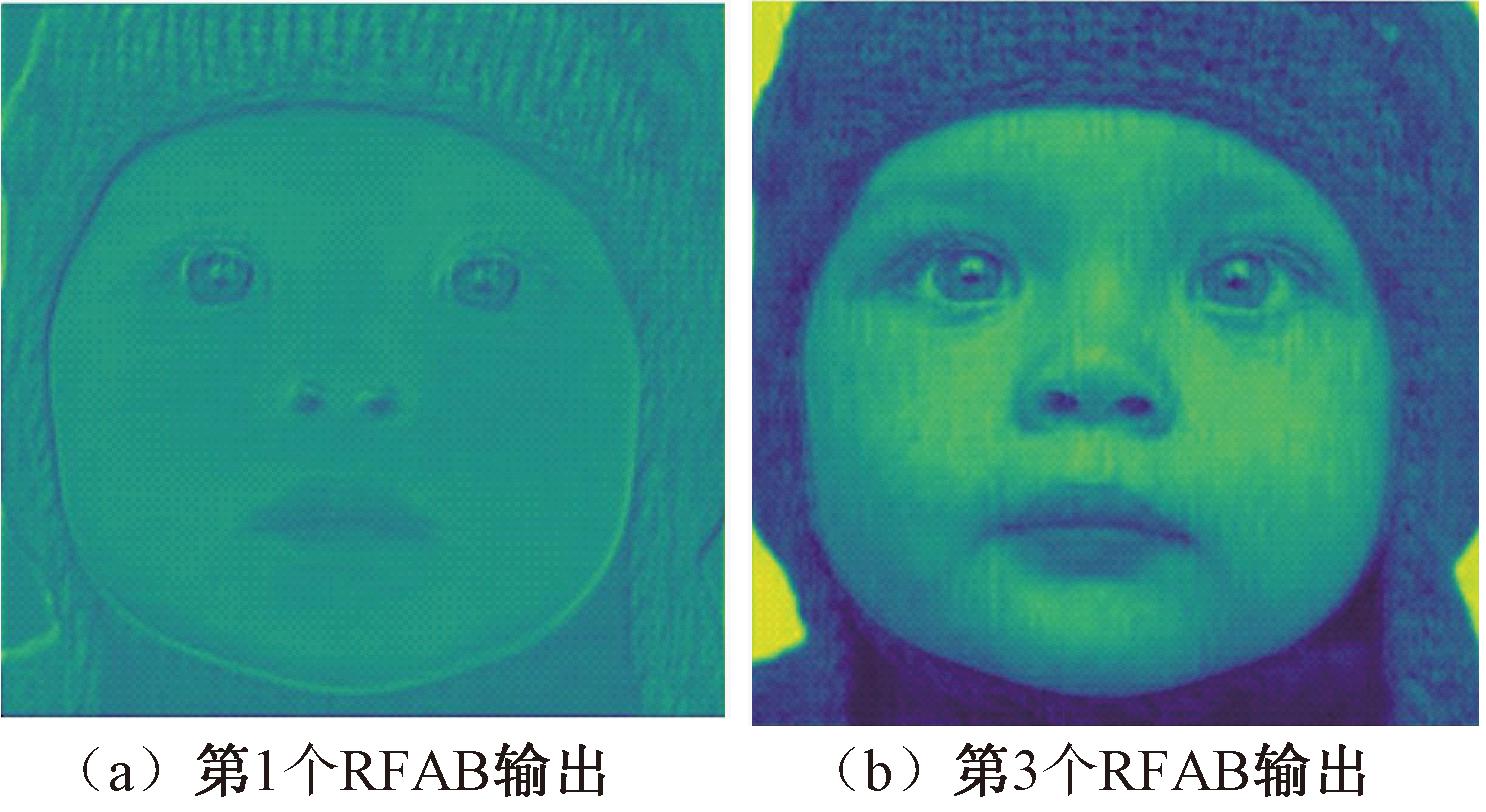

为了进一步验证A分支中RFAB数量对重建质量的影响,本文将单独使用A分支网络进行重建。如图7所示,可以看出第3个RFAB后输出的特征图包含更多的高频特征,婴儿脸部的纹理细节更加明显,因此适当加深网络结构深度,有助于提高图像重建效果。

图7 输出特征图对比

Figure 7 Comparison of output feature maps

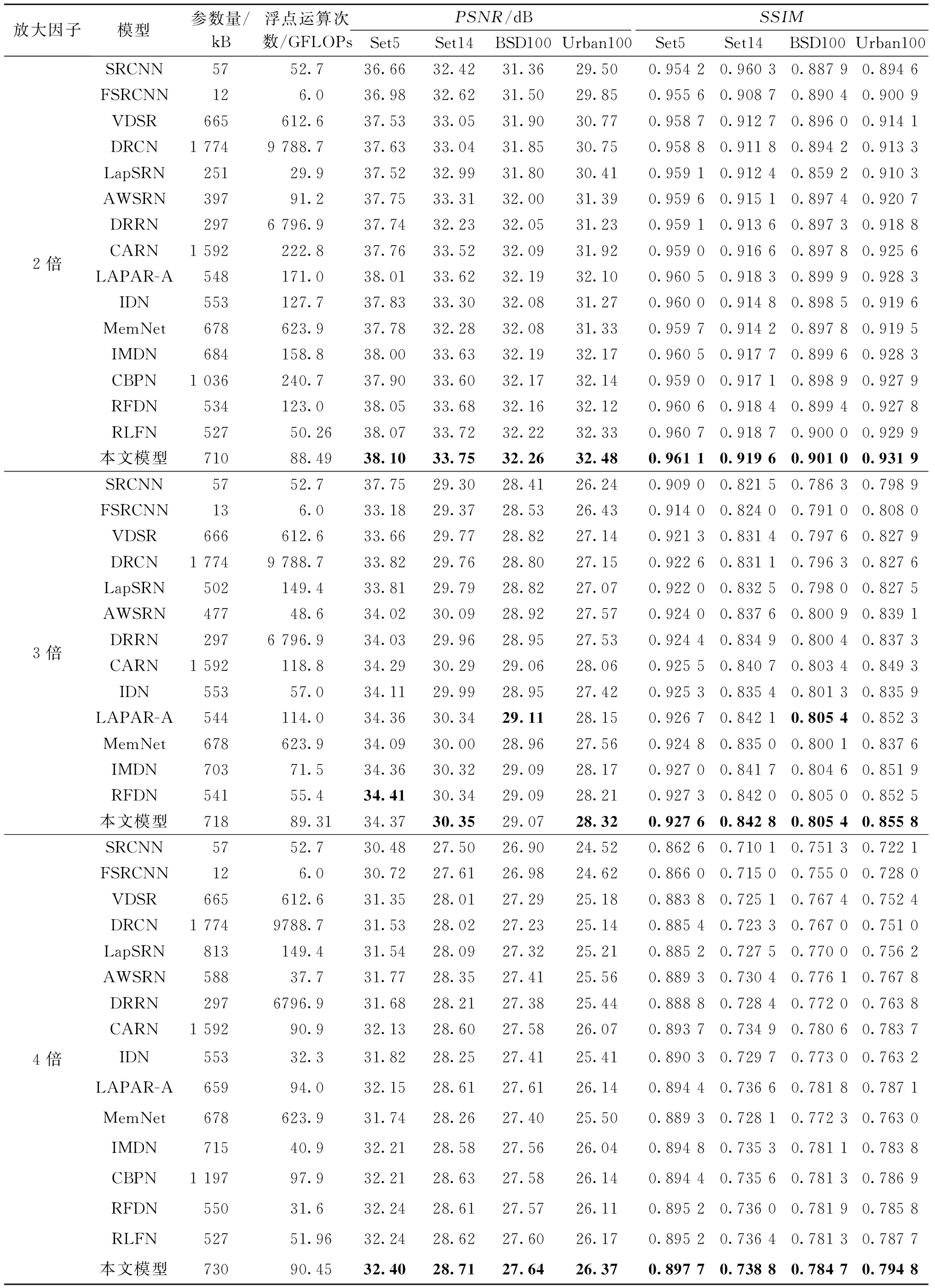

2.4 客观评价

为了验证本文方法的有效性,将本文方法与SRCNN[2]、FSRCNN[3]、VDSR[4]、LapSRN[6]、DRCN[7]、DRRN[8]、CARN[10]、LAPAR-A[17]、MemNet[18]、AWSRN[19]、IDN[20]、IMDN[21]、CBPN[22]、RFDN[23]、RLFN[24]15种方法进行比较,在Set5、Set14、BSD100、Urban100上分别进行放大因子为2倍、3倍、4倍超分辨率重建对比,如表5所示。

表5 不同SR算法在测试数据集上的指标值对比

Table 5 Comparison of index values of different SR algorithms on test datasets

放大因子模型参数量/kB浮点运算次数/GFLOPsPSNR/dBSSIMSet5Set14BSD100Urban100Set5Set14BSD100Urban1002倍3倍4倍SRCNN5752.736.6632.4231.3629.500.954 20.960 30.887 90.894 6FSRCNN126.036.9832.6231.5029.850.955 60.908 70.890 40.900 9VDSR665612.637.5333.0531.9030.770.958 70.912 70.896 00.914 1DRCN1 7749 788.737.6333.0431.8530.750.958 80.911 80.894 20.913 3LapSRN25129.937.5232.9931.8030.410.959 10.912 40.859 20.910 3AWSRN39791.237.7533.3132.0031.390.959 60.915 10.897 40.920 7DRRN2976 796.937.7432.2332.0531.230.959 10.913 60.897 30.918 8CARN1 592222.837.7633.5232.0931.920.959 00.916 60.897 80.925 6LAPAR-A548171.038.0133.6232.1932.100.960 50.918 30.899 90.928 3IDN553127.737.8333.3032.0831.270.960 00.914 80.898 50.919 6MemNet678623.937.7832.2832.0831.330.959 70.914 20.897 80.919 5IMDN684158.838.0033.6332.1932.170.960 50.917 70.899 60.928 3CBPN1 036240.737.9033.6032.1732.140.959 00.917 10.898 90.927 9RFDN534123.038.0533.6832.1632.120.960 60.918 40.899 40.927 8RLFN52750.2638.0733.7232.2232.330.960 70.918 70.900 00.929 9本文模型71088.4938.1033.7532.2632.480.961 10.919 60.901 00.931 9SRCNN5752.737.7529.3028.4126.240.909 00.821 50.786 30.798 9FSRCNN136.033.1829.3728.5326.430.914 00.824 00.791 00.808 0VDSR666612.633.6629.7728.8227.140.921 30.831 40.797 60.827 9DRCN1 7749 788.733.8229.7628.8027.150.922 60.831 10.796 30.827 6LapSRN502149.433.8129.7928.8227.070.922 00.832 50.798 00.827 5AWSRN47748.634.0230.0928.9227.570.924 00.837 60.800 90.839 1DRRN2976 796.934.0329.9628.9527.530.924 40.834 90.800 40.837 3CARN1 592118.834.2930.2929.0628.060.925 50.840 70.803 40.849 3IDN55357.034.1129.9928.9527.420.925 30.835 40.801 30.835 9LAPAR-A544114.034.3630.3429.1128.150.926 70.842 10.805 40.852 3MemNet678623.934.0930.0028.9627.560.924 80.835 00.800 10.837 6IMDN70371.534.3630.3229.0928.170.927 00.841 70.804 60.851 9RFDN54155.434.4130.3429.0928.210.927 30.842 00.805 00.852 5本文模型71889.3134.3730.3529.0728.320.927 60.842 80.805 40.855 8SRCNN5752.730.4827.5026.9024.520.862 60.710 10.751 30.722 1FSRCNN126.030.7227.6126.9824.620.866 00.715 00.755 00.728 0VDSR665612.631.3528.0127.2925.180.883 80.725 10.767 40.752 4DRCN1 7749788.731.5328.0227.2325.140.885 40.723 30.767 00.751 0LapSRN813149.431.5428.0927.3225.210.885 20.727 50.770 00.756 2AWSRN58837.731.7728.3527.4125.560.889 30.730 40.776 10.767 8DRRN2976796.931.6828.2127.3825.440.888 80.728 40.772 00.763 8CARN1 59290.932.1328.6027.5826.070.893 70.734 90.780 60.783 7IDN55332.331.8228.2527.4125.410.890 30.729 70.773 00.763 2LAPAR-A65994.032.1528.6127.6126.140.894 40.736 60.781 80.787 1MemNet678623.931.7428.2627.4025.500.889 30.728 10.772 30.763 0IMDN71540.932.2128.5827.5626.040.894 80.735 30.781 10.783 8CBPN1 19797.932.2128.6327.5826.140.894 40.735 60.781 30.786 9RFDN55031.632.2428.6127.5726.110.895 20.736 00.781 90.785 8RLFN52751.9632.2428.6227.6026.170.895 20.736 40.781 30.787 7本文模型73090.4532.4028.7127.6426.370.897 70.738 80.784 70.794 8

相比于其他主流方法,本文提出的方法在4个公开测试数据集上的PSNR和SSIM都取得了最优或次优值。具体来说,对于测试数据集Set5、Set14、BSD100、Urban100,当放大倍数为2时,本文方法的PSNR比RLFN算法的次优值分别提升了0.03,0.03,0.04,0.15 dB;当放大倍数为3时,本文方法在测试数据集Set14和Urban100上的PSNR相比于RFDN方法的次优PSNR分别提高了0.01,0.11 dB;当放大倍数为4时,本文方法在4个数据集上的PSNR比RLFN方法和CBPN方法的次优值分别提升了0.16,0.08,0.03,0.20 dB。此外,当放大倍数为2,3,4时,本文方法在4个测试数据集上均取得了最优的SSIM,说明双分支网络充分考虑图像的多尺度特征以及高频特征,更有利于挖掘图像的内部信息。本文方法性能提升主要得益于APB结构、LSAB结构以及RFAB结构。APB能够充分提取图像不同尺度的特征,使网络获取图像丰富的特征信息;LSAB能够更加准确地定位到高频特征信息;RFAB分别在通道和空间维度上提高网络的高频特征选择能力,引导网络聚焦可靠信息;且本文采用的双分支网络能够有效融合多尺度特征和高频特征,提高网络的特征利用率,这些因素都是本文方法性能显著提高的原因。

同时,本文与其他方法进行了模型参数量和计算量的对比。从表5可以看出,本文方法的性能和参数量之间具有很好的平衡。相比于DRCN和CARN,本文方法在提升PSNR和SSIM的同时,参数量约为其他方法的一半。对比RFDN、RLFN、IMDN,虽然本文方法的参数量有所增加,但是本文方法的PSNR和SSIM显著提升,这表明本文方法能够在较小参数量的情况下使网络获得更好的性能。

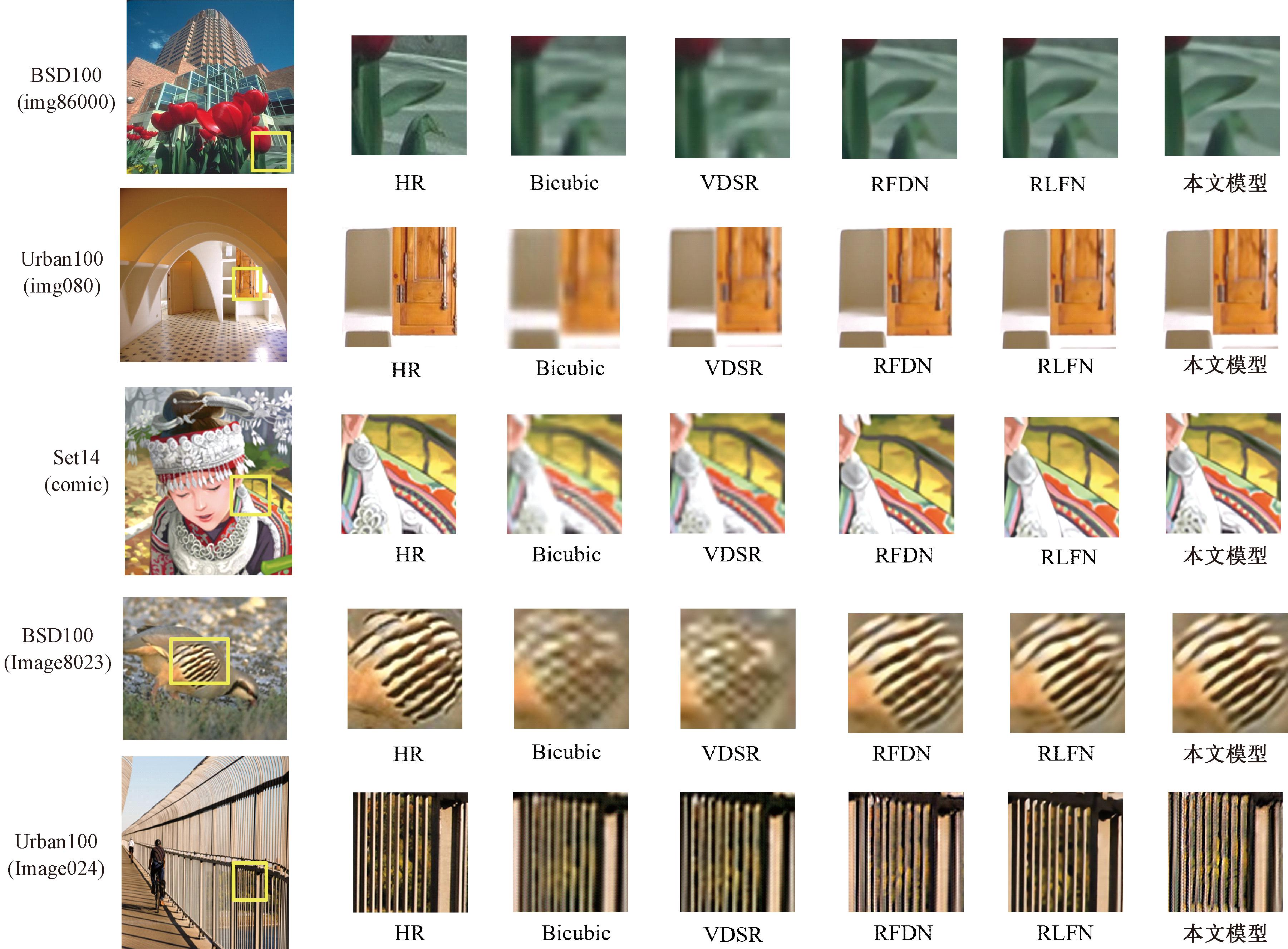

2.5 实验结果分析

为了进一步展示不同超分辨率方法的重建效果,图8展示了在不同测试数据集上的重建效果。从图8可以看出,Bicubic重建后的图像整体虚化,轮廓最为模糊。对于BSD100中的img86000图像,其他方法中放大后的叶片有轻微的模糊感,背景轮廓虚化,而本文方法重建后的图像叶片更加清晰;本文方法重建的Urban100中的img080图像结构更加规则,与HR图像更接近;Set14中的comic图像,人物的服装细节较多,RFDN和RLFN重建图像放大后的边缘轮廓不清晰并且细节缺失,本文模型重建图像放大后有较为清晰的纹理细节,给人的视觉效果要比其他模型更好。相比于一些主流方法,本文方法不仅取得了较高的PSNR和SSIM,而且重建图像的结构和边缘更加清晰,整体效果明显提升。

图8 放大4倍时各网络视觉效果对比

Figure 8 Visual effect comparison by different networks with 4 times of scale factor

然而,对于一些纹理比较密集且不规则的图像,本文的重建效果没有显著提高。BSD100数据集的Image8023中包含较多不规则的黑色纹理图案,本文重建图像中出现黑色边缘纹理缺失、轮廓模糊的现象;Urban100数据集的Image024含有较多建筑物的规则结构,本文重建的图像中存在扭曲、失真且细节不完整的情况。本文方法在重建过程中主要关注图像的高频特征和多尺度特征,并未考虑图像局部与非局部信息之间的交互性,重建出图像的轮廓虽然更加清晰,但是图像一些局部的复杂纹理区域重建效果并不显著。如何进一步提高密集且不规则的形状和结构的重建效果,仍是本文进一步研究和解决的问题。

3 结论

本文提出了一种基于双特征提取和注意力机制的图像超分辨率重建方法。使用双分支网络有效传递信息,将提取的高频特征和多尺度特征重建后进一步融合,提高图像的重建质量。通过构建残差融合注意力模块,将局部空间注意力和通道注意力相结合,增强了网络在空间维度和通道维度上对高频特征的提取能力,使网络更准确地判别和定位高频特征;使用不同类型的卷积构建空洞金字塔模块,扩大了网络感受野,提升网络多尺度特征的提取能力。本文训练数据集使用DIV2K数据集,PSNR、SSIM作为评价指标,实验结果表明,本文方法重建出的图像有较好的纹理细节,PSNR和SSIM都有所提升,证明了本文研究方法的有效性。但是该模型计算量略大,后续工作将在确保算法重建精度的前提下,进一步降低参数量并减小网络结构。

[1] 成科扬, 荣兰, 蒋森林, 等. 基于深度学习的遥感图像超分辨率重建方法综述[J]. 郑州大学学报(工学版), 2022, 43(5): 8-16.CHENG K Y, RONG L, JIANG S L, et al. Overview of methods for remote sensing image super-resolution reconstruction based on deep learning[J]. Journal of Zhengzhou University (Engineering Science), 2022, 43(5): 8-16.

[2] DONG C, LOY C C, HE K M, et al. Learning a deep convolutional network for image super-resolution[C]∥European Conference on Computer Vision. Cham: Springer, 2014: 184-199.

[3] DONG C, LOY C C, TANG X O. Accelerating the super-resolution convolutional neural network[C]∥European Conference on Computer Vision. Cham: Springer, 2016: 391-407.

[4] KIM J, LEE J K, LEE K M. Accurate image super-resolution using very deep convolutional networks[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway:IEEE, 2016: 1646-1654.

[5] LIM B, SON S, KIM H, et al. Enhanced deep residual networks for single image super-resolution[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition Workshops (CVPRW). Piscataway:IEEE, 2017: 1132-1140.

[6] LAI W S, HUANG J B, AHUJA N, et al. Deep Laplacian pyramid networks for fast and accurate super-resolution[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway:IEEE, 2017: 5835-5843.

[7] KIM J, LEE J K, LEE K M. Deeply-recursive convolutional network for image super-resolution[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway: IEEE, 2016: 1637-1645.

[8] TAI Y, YANG J, LIU X M. Image super-resolution via deep recursive residual network[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway:IEEE, 2017: 2790-2798.

[9] ZHANG Y L, LI K P, LI K, et al. Image super-resolution using very deep residual channel attention networks[C]∥European Conference on Computer Vision. Cham: Springer, 2018: 294-310.

[10] AHN N, KANG B, SOHN K A. Fast, accurate, and lightweight super-resolution with cascading residual network[C]∥Computer Vision—ECCV 2018: 15th European Conference. New York:ACM, 2018: 256-272.

[11] HU J, SHEN L, SUN G. Squeeze-and-excitation networks[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2018: 7132-7141.

[12] WU B C, WAN A, YUE X Y, et al. Shift: a zero FLOP, zero parameter alternative to spatial convolutions[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2018: 9127-9135.

[13] TONG T, LI G, LIU X J, et al. Image super-resolution using dense skip connections[C]∥2017 IEEE International Conference on Computer Vision (ICCV). Piscataway:IEEE, 2017: 4809-4817.

[14] YUAN Y, LIU S Y, ZHANG J W, et al. Unsupervised image super-resolution using cycle-in-cycle generative adversarial networks[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops (CVPRW). Piscataway:IEEE, 2018: 814-822.

[15] WANG Z, BOVIK A C, SHEIKH H R, et al. Image quality assessment: from error visibility to structural similarity[J]. IEEE Transactions on Image Processing: A Publication of the IEEE Signal Processing Society, 2004, 13(4): 600-612.

[16] YU F, KOLTUN V. Multi-scale context aggregation by dilated convolutions[EB/OL]. (2015-11-23)[2023-06-14]. https:∥arxiv.org/abs/1511.07122.

[17] LI W B, ZHOU K, QI L, et al. LAPAR: linearly-assembled pixel-adaptive regression network for single image super-resolution and beyond[EB/OL]. (2021-05-21)[2023-06-14]. https:∥arxiv.org/abs/2105.10422.

[18] TAI Y, YANG J, LIU X M, et al. MemNet: a persistent memory network for image restoration[C]∥2017 IEEE International Conference on Computer Vision (ICCV). Piscataway:IEEE, 2017: 4549-4557.

[19] WANG C F, LI Z, SHI J. Lightweight image super-resolution with adaptive weighted learning network[EB/OL]. (2019-04-04)[2023-06-14]. https:∥arxiv.org/abs/1904.02358.

[20] HUI Z, WANG X M, GAO X B. Fast and accurate single image super-resolution via information distillation network[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway:IEEE, 2018: 723-731.

[21] HUI Z, GAO X B, YANG Y C, et al. Lightweight image super-resolution with information multi-distillation network[C]∥Proceedings of the 27th ACM International Conference on Multimedia. New York: ACM, 2019: 2024-2032.

[22] ZHU F Y, ZHAO Q J. Efficient single image super-resolution via hybrid residual feature learning with compact back-projection network[C]∥2019 IEEE/CVF International Conference on Computer Vision Workshop (ICCVW). Piscataway:IEEE, 2019: 2453-2460.

[23] LIU J, TANG J, WU G S. Residual feature distillation network for lightweight image super-resolution[C]∥European Conference on Computer Vision. Cham: Springer, 2020: 41-55.

[24] KONG F Y, LI M X, LIU S W, et al. Residual local feature network for efficient super-resolution[C]∥2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops (CVPRW). Piscataway:IEEE, 2022: 765-775.