在数据驱动的科学研究中,科学数据作为重要的证据性材料,其基础作用日益凸显。开放共享环境下,科学数据集主要存储于各大数据仓储、数据集共享平台和政府开放数据网站中[1]。在开放科学运动驱动下,传统的关键词匹配方法已无法满足科研人员快速、准确获得相关数据集的需求[2]。语义匹配任务可以简单地描述为确定句子对是否语义等价,广泛应用于信息检索、机器翻译、问答、推荐系统等领域,能够帮助用户快速捕捉所需信息[3]。语义匹配技术的发展与自然语言处理(natural language processing, NLP)的发展一脉相承,自Transformer框架提出后,预训练模型开始迅速发展[4]。采用预训练模型对下游任务进行微调是目前语义匹配的主流方法之一。

科学数据集的语义信息主要由其元数据进行表达,如标题、关键词和描述等。因此,从任务类型角度,科学数据集元数据语义匹配任务属于一类经典的NLP匹配任务,但是,相比于传统的文本匹配,科学数据集具有其独特的任务特点,主要问题包括:①现有的预训练模型在对文本进行表示时主要基于词级别,对科学数据集句子级匹配模型鲜有研究;②中英文混合文本中具有高度重叠但语义不相似的文本较多。

针对以上问题,本文提出了一个面向中文科学数据集的句子级语义匹配模型 (chinese scientific dataset sentence-level match,CSDSM)模型。首先,使用CSL (chinese scientific literature dataset)[5]数据集对SimCSE[6]和CoSENT (cosine sentence)进行训练,生成CoSENT预训练模型。基于CoSENT模型,引入多头自注意力机制[4]进行特征提取,通过余弦相似度与KNN分类结果加权求和得到最终输出。其次,使用网络采集技术收集了国家地球系统科学数据中心的标题信息,通过多人标注和投票机制,构建了一个超过20 000条数据的中文科学数据集。在公共数据集和自建数据集上的实验结果表明,在语义匹配任务中CSDSM模型比现有模型性能更好。

1 相关工作

1.1 传统语义匹配技术

计算语义相似度是语义匹配模型中的一项关键任务。早期方法是从文本对象中提取关键词,构建向量空间模型,然后通过余弦相似度等方法计算相似性。传统基于词的特征关键词匹配模型无法解决语义问题[7]。随着深度学习的发展,通过构建大型语料库的方式,为挖掘上下文语境信息提供了材料和方法支持。从最早的深度神经网络(DNN)使用前馈神经网络映射文本序列,再到卷积神经网络(CNN)在固定大小的滑动窗口中共享参数[8],为了进一步获取文本序列的长期依赖性,出现了循环神经网络(RNN)。

早期工作受到孪生网络架构的启发,分配各自的神经网络将2个输入序列编码为高级表示。如Huang等[9]使用DNN将查询和标题表示为低维语义向量。Shen等[10]通过使用CNN从文本中提取局部上下文文本表示。Mohan等[11]利用RNN及其变体来捕获上下文依赖。这些传统神经网络在面对新的数据时,其泛化能力有限。这意味着它们可能会在未知数据上表现不佳,需要重新训练或进行调整以适应新的数据分布。近来,学者们大量的研究工作表明,在大型语料库上预训练模型可以学习通用语言表示,这有利于NLP的下游任务,并且可以避免从头开始训练新模型[12]。

1.2 基于预训练模型的语义匹配技术

由于注释成本昂贵,为NLP任务构建大规模标签数据集是一个巨大的挑战,而大规模无标签语料库相对容易构建。利用这些语料库,模型可以从中学习良好的表示,将这些表示应用于其他任务。早期方法是将单词表示为密集向量进行单词嵌入。Word2vec[13]是典型代表,它通过预训练单词嵌入用于不同的NLP任务。由于多数NLP任务超出了单词级别,因此出现了句子等更高级别的预训练神经编码器[14]。预训练模型在学习通用语言表示方面具有强大能力,如BERT、GPT、XLNet、T5等[15]。

以BERT为代表的预训练语言模型广泛应用于语义匹配任务中。这些模型先在大型语料库上进行预训练,然后对特定的任务进行微调。Choudhary等[16]通过BERT获取丰富的语义信息。Esteva等[17]通过BERT模型创建大量的元组(引文、标题和段落)用于训练匹配模块。虽然BERT等通用预训练模型已广泛应用于各个领域,但面对科学数据集领域时,通用预训练模型缺乏对特定科学领域的深入学习,无法充分利用该领域的专业知识,尤其是在需要深入理解领域特定概念和关系的科学任务中,这限制了模型的使用范围。

1.3 科学数据领域的预训练模型

随着预训练模型的发展,已出现一些针对科学领域的预训练语言模型。其中,SciBERT[18]是一种专门为科学领域设计的模型。SciBERT在大量科学文献数据上进行预训练,相较于通用的BERT模型,SciBERT在预训练过程中采用了一些特殊的处理方式。首先,它使用了与BERT相同的基础架构——Transformer编码器。其次,SciBERT使用了领域特定的词汇表,以便覆盖科学领域的术语和专有名词。除此之外,还有一些其他领域的模型,如BioBERT、ClinicalBERT、BEHRT以及MT-BERT等[19],它们在不同的科学领域中具有特定的应用。

以上模型均采用基于BERT结构的方法,主要应用于英文科学数据集任务,对中文数据的适应性较差。此外,由于原始BERT模型主要关注词级上下文的表示,对句子级语义理解的能力有限,可能导致部分信息的丢失。同时,针对科学数据集的匹配任务,实现句子级别的交互较为困难。因此,针对中文科学数据集的句子级语义匹配问题,本文使用CSL数据集对SimCSE和CoSENT进行训练生成预训练模型;在预训练模型的基础上,利用KNN算法以及多头自注意力机制训练获得了CSDSM模型。

2 CSDSM模型

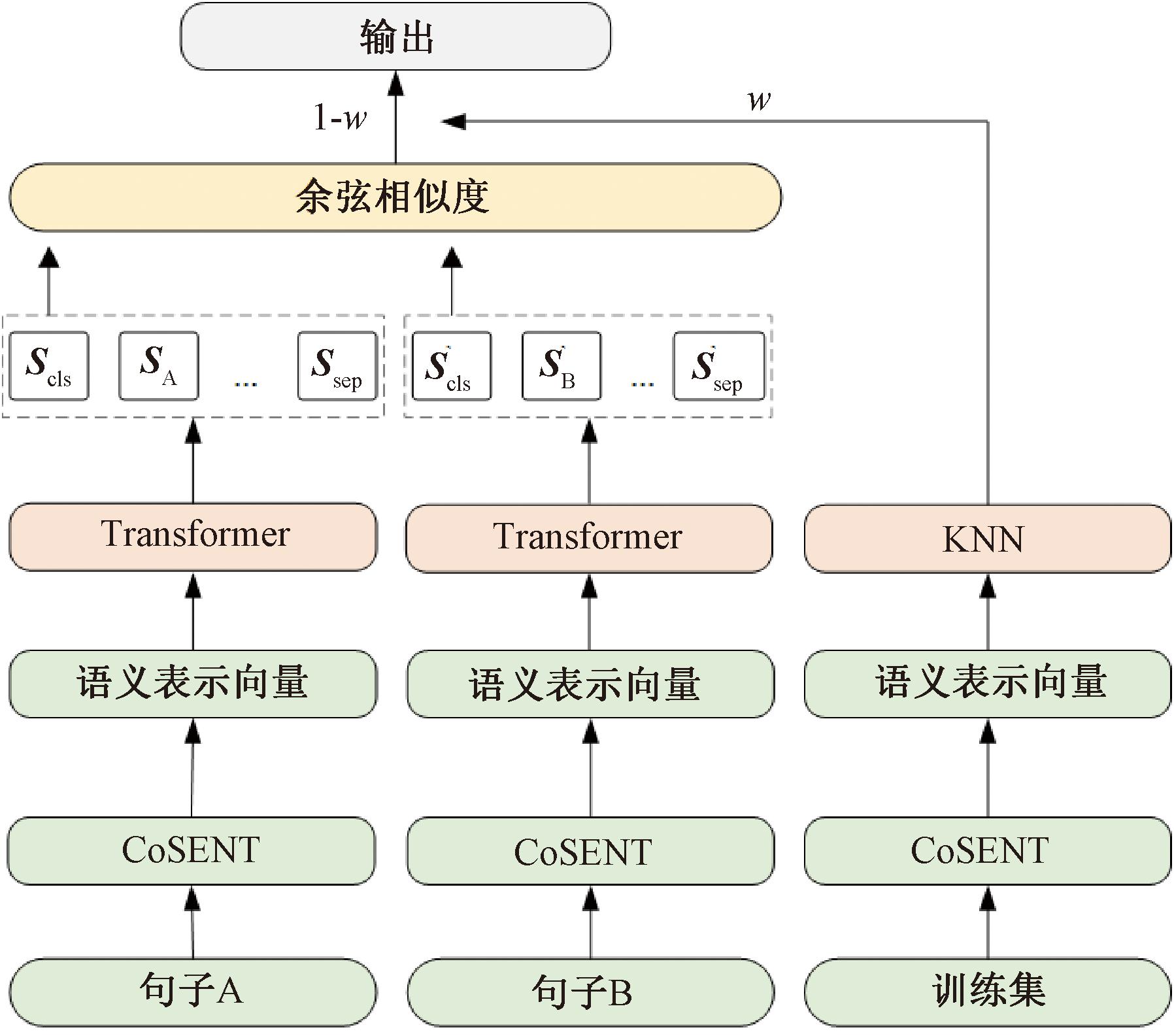

本文CSDSM模型的具体结构如图1所示。

图1 CSDSM模型

Figure 1 CSDSM model

模型采用Sentence-BERT模型[20]作为基础方法,预训练CoSENT模型嵌入科学数据集句子对,获得句子A和句子B的向量,分别为![]() 和

和![]() 其中

其中![]() 和

和![]() 分别表示第m个和第n个句子;送入多头自注意力机制模块,提取句子的CLS token向量,CLS token通常用于表示整个输入序列的句子级别的语义信息,最后使用余弦相似度和KNN分类结果加权求和得到最终输出。

分别表示第m个和第n个句子;送入多头自注意力机制模块,提取句子的CLS token向量,CLS token通常用于表示整个输入序列的句子级别的语义信息,最后使用余弦相似度和KNN分类结果加权求和得到最终输出。

2.1 CoSENT函数

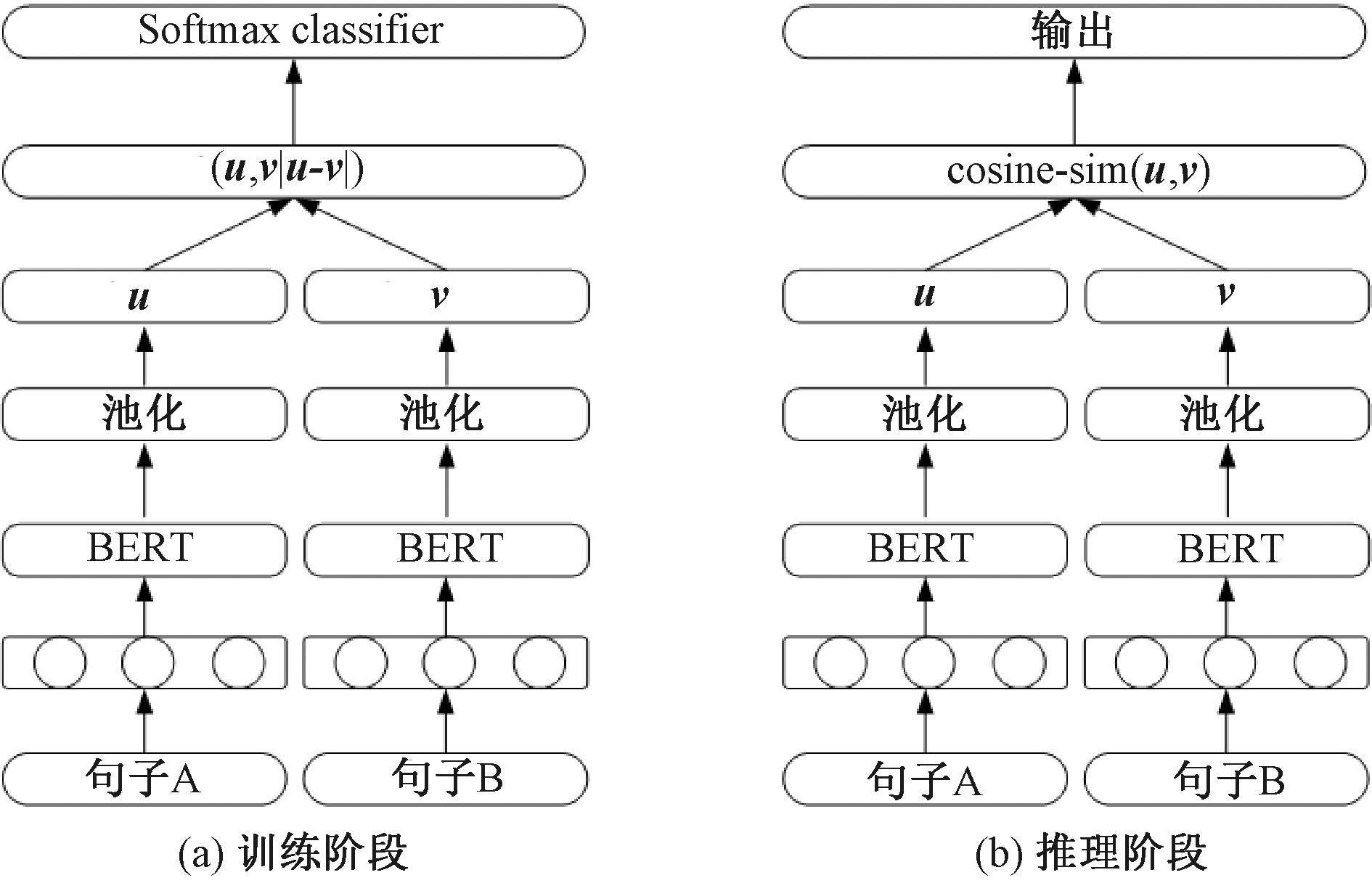

Sentence-BERT模型如图2所示,将2个文本向量表示进行拼接,并乘上一个可训练的权重和偏置,用于优化分类任务,具体公式为

Ssent=ReLU(aout·[u:v]+bout)。

(1)

图2 Sentence-BERT模型

Figure 2 Sentence-BERT model

式中:u、v分别表示2个句子的BERT嵌入;[u:v]表示2个向量拼接;aout和bout分别为模型可训练的权重向量和偏置向量;ReLU表示激活函数,当输入小于0时,ReLU函数的输出为0,这意味着一些神经元的激活值会被抑制为0。这种稀疏性有助于减少特征空间的维度,提取更加重要和有区别性的特征,并降低模型的复杂度,其表达式为ReLU(x)=max(0,x),其中x表示输入。

然而,模型的预测阶段使用余弦相似度进行预测,导致模型的训练阶段和预测阶段不一致。此外,对于标注样本,损失函数的目标对于正样本尽可能大,对于负样本则尽可能小,导致模型失去泛化能力或难以优化,模型的损失函数为

t·(1-cos(u,v))+(1-t)·

(1+cos(u,v)), t∈{0,1}。

(2)

式中:t=1表示相似,t=0表示不相似。

为解决上述问题,本文将损失函数改为CoSENT损失函数:

(3)

式中:Ωpos为正样本对集合;Ωneg为负样本对集合;ui和uj均为正样本对的句向量;uk和ul均为负样本对的句向量;λ表示缩放因子,为了避免某些特征对模型的影响过大,通过缩放因子将其缩放到相似的范围,本文λ取值为20,该值参考CoSENT源码及其实验。

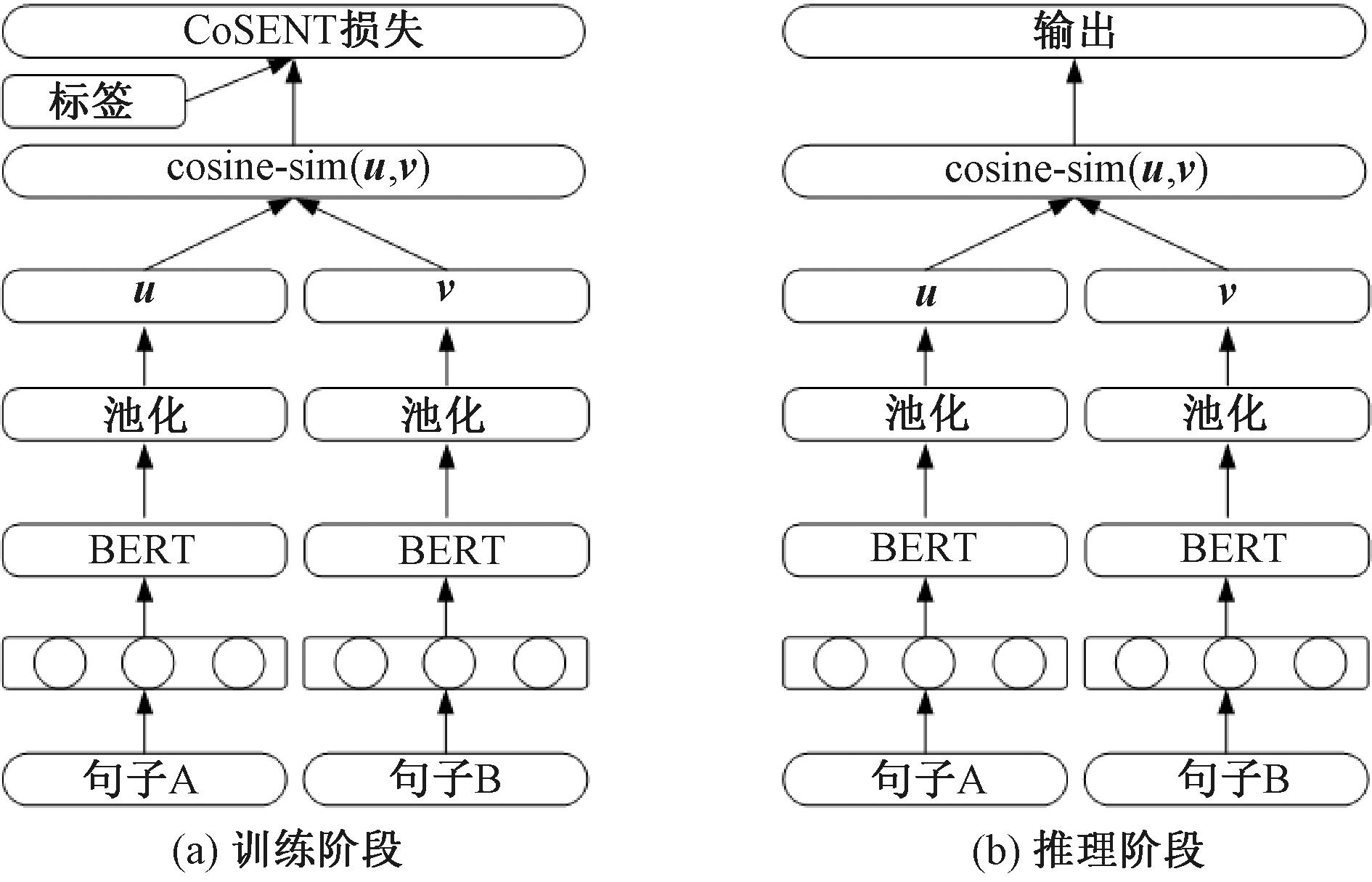

GoSENT函数是一种有监督损失函数,它直接优化余弦相似度和标签的差异,而不是使用传统的交叉熵或均方误差等损失函数,如图3所示。CoSENT损失函数考虑了所有正样本对和负样本对的余弦值的差异,并确保正样本对的相似度大于负样本对的相似度。以使模型的训练阶段和推理阶段的任务保持一致,提高模型语义匹配的能力,具体公式为

cos(ui,uj)>cos(uk,ul)。

(4)

图3 CoSENT模型

Figure 3 CoSENT model

式中:cos(·)表示相似度。

2.2 SimCSE对比学习框架

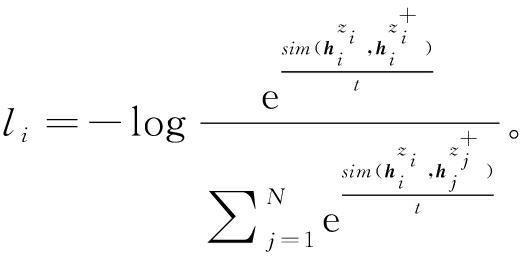

对比学习在自监督学习中被广泛应用,它能够利用未标记的数据集来增强潜在的语义表示,通过学习样本之间的相似性来增强语义表示,具体公式为

(5)

式中:xi和![]() 为2个语义相关的句子向量。

为2个语义相关的句子向量。

具体来说,首先将样本通过一个编码器映射到潜在的语义空间中,然后通过度量样本之间的距离来衡量它们在语义空间中的相似度。在对比学习中,通过拉近正样本的距离并拉远负样本的距离来增强语义表示的区分度。

在传统的Transformer中,全连接层放置了dropout掩码(默认概率值Pd为0.1),把它表示为![]() 其中dropout代表以一定概率Pd失活部分神经元,z代表随机dropout掩码。在无监督SimCSE方法中,将相同的输入送入编码器2次,可以得到2个具有不同dropout掩码的嵌入,由此得到无监督SimCSE的训练目标,如式(6)所示。通过预训练模型编码,将句子的余弦相似度作为相似性得分,根据式(6),通过对数函数的运算,使得正样本对的相似性得分尽可能大,负样本对的相似性得分尽可能小。在训练中,通过最小化损失函数值,模型学习到更好的句子表示,使得相似的句子在嵌入空间中更加接近,而不相似的句子则更加远离,从而达到无监督对比学习的目标。

其中dropout代表以一定概率Pd失活部分神经元,z代表随机dropout掩码。在无监督SimCSE方法中,将相同的输入送入编码器2次,可以得到2个具有不同dropout掩码的嵌入,由此得到无监督SimCSE的训练目标,如式(6)所示。通过预训练模型编码,将句子的余弦相似度作为相似性得分,根据式(6),通过对数函数的运算,使得正样本对的相似性得分尽可能大,负样本对的相似性得分尽可能小。在训练中,通过最小化损失函数值,模型学习到更好的句子表示,使得相似的句子在嵌入空间中更加接近,而不相似的句子则更加远离,从而达到无监督对比学习的目标。

(6)

式中:t为温度系数控制softmax分布的一个超参数;sim(·)代表相似度;N代表batch size的大小;![]() 代表

代表![]() 在dropout后的样本;li代表对比损失函数的第i个样本的损失值。

在dropout后的样本;li代表对比损失函数的第i个样本的损失值。

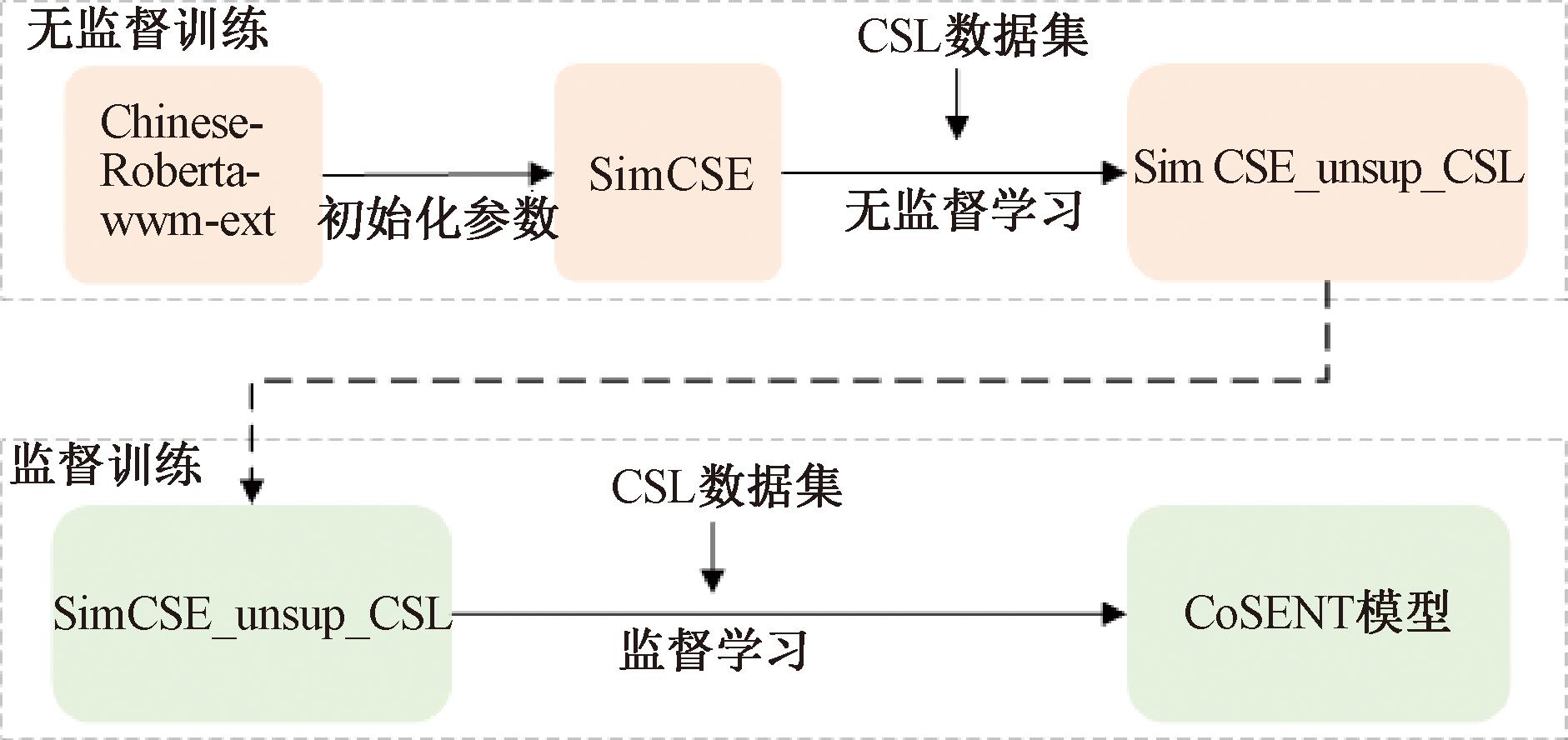

为了在科学数据集领域应用性能更好,本文使用CSL科学数据集来训练SimCSE和CoSENT模型。首先,采用预训练模型Chinese-Roberta-wwm-ext对SimCSE进行了无监督训练,以增强领域知识;其次,将训练好的SimCSE无监督模型输入到CoSENT中进行有监督训练,以进一步优化模型性能;最后,得到针对科学数据集领域的CoSENT模型,如图4所示。

图4 CoSENT模型训练过程

Figure 4 CoSENT model training process

2.3 多头自注意力机制

本文使用Transformer中的多头自注意力机制对输入的句子对进行建模。这种机制可以在一个句子中捕捉到不同词语之间的关联,并且能够在多个句子之间进行信息交互。通过多头自注意力机制,能够有效地捕捉到句子之间的语义关系,从而提高模型的准确度和表现力。具体地,对上述2个句子向量SA∈Rd和SB∈Rd进行拼接得到 x=[SA:SB]∈R2d,通过多头自注意力机制计算向量中每个词和其他词之间的相似度得分,得到一个向量s∈Rd,其中向量si表示向量x中第i个词和其他词之间的相似度得分,具体公式如下:

(7)

headi=s(xW1,xW2,xW3);

(8)

O=concat(head1,head2,…,headh)Wo。

(9)

式中:W1∈Rd×h、W2∈Rd×h和W3∈Rd×h为线性变换矩阵;h表示每个头部的向量维度,通过softmax函数将结果映射到[0,1]的概率分布空间中;xW1和xW2分别为输入向量x经过线性变换得到的矩阵;![]() 为标量;xW3表示对得到的相似度得分加权并进行线性变换得到最终的向量;headi代表第i个自注意力层;Wo为输出矩阵,用于将多个注意力头输出映射到向量空间中;concat(·)表示将多个注意力头的输出结果按维度拼接;O表示多头自注意力的输出结果。

为标量;xW3表示对得到的相似度得分加权并进行线性变换得到最终的向量;headi代表第i个自注意力层;Wo为输出矩阵,用于将多个注意力头输出映射到向量空间中;concat(·)表示将多个注意力头的输出结果按维度拼接;O表示多头自注意力的输出结果。

2.4 KNN算法

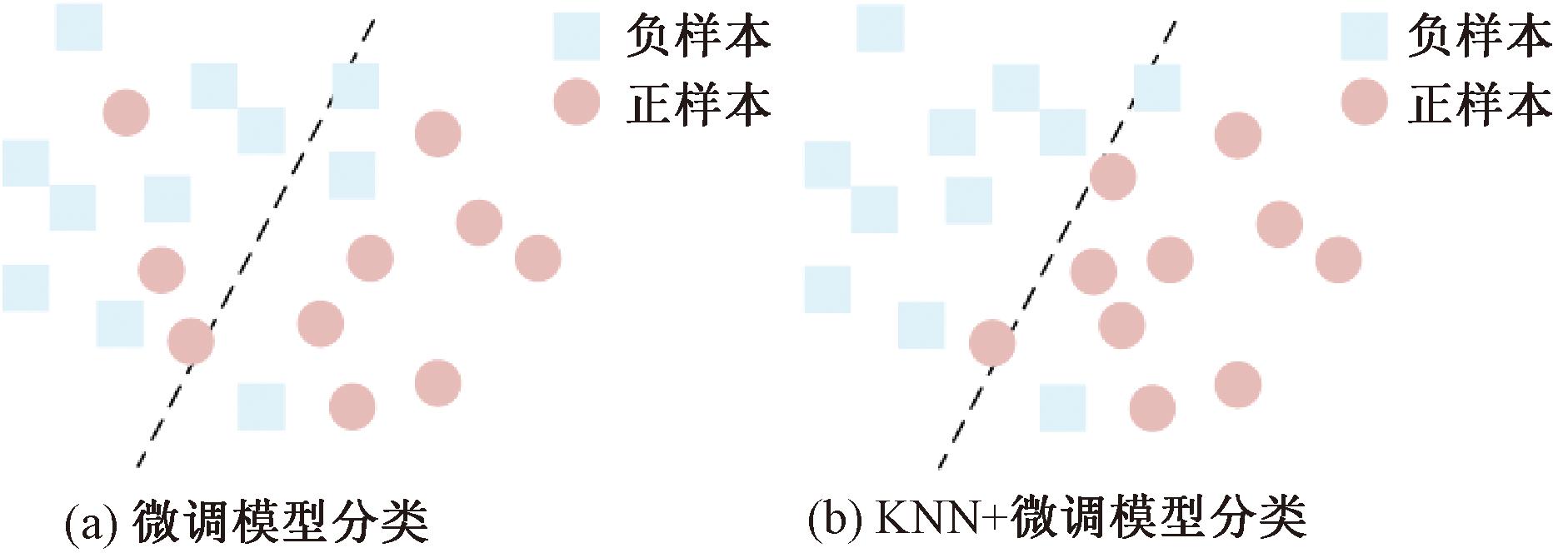

为进一步提高语义匹配准确性,本文在模型中引入了KNN方法。该方法将有监督的科学数据集输入到KNN算法中,使用余弦相似度来度量最近邻数量K,通过将KNN分类结果与模型预测的余弦相似度结果相结合来提高语义匹配的准确性,如图5所示,具体公式如下:

(10)

P=(1-w)cos(SA,SB)+wKNN(x)。

(11)

图5 KNN算法辅助模型分类结果

Figure 5 Classification results of the model aided by KNN algorithm

式中:P为概率;w为权重;SA和SB为输入句子的向量表示;KNN(x)为待分类句子x利用KNN算法输出分类概率值。

2.5 余弦相似度

多头自注意力机制输出CLS token向量空间来表示句子的语义信息。该向量空间模型将句子映射到一个多维向量空间中,并通过余弦相似度来计算2个句子之间的相似度。

具体地,本文使用预训练的语言模型来计算每个句子的嵌入向量并通过多头自注意力机制模块输出CLS token向量。向量表示句子在向量空间中的位置,其在空间中的距离可以用来表示它们之间的相似度。模型通过余弦相似度输出结果。余弦相似度是一种用于比较2个向量之间的相似度的度量方法,其取值在-1到1之间。2个向量越相似,其余弦相似度越接近1,反之亦然。

3 实验

3.1 实验环境及参数

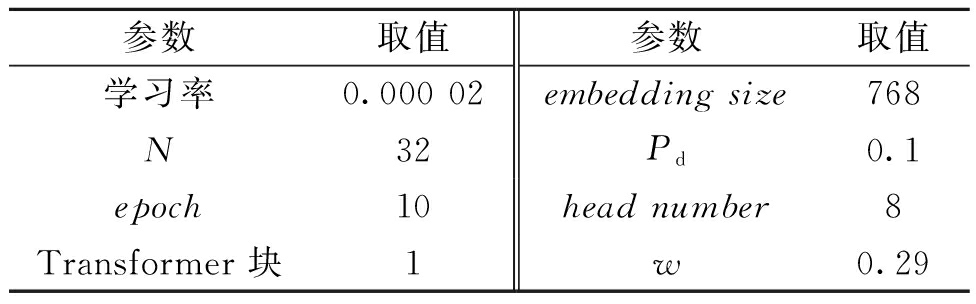

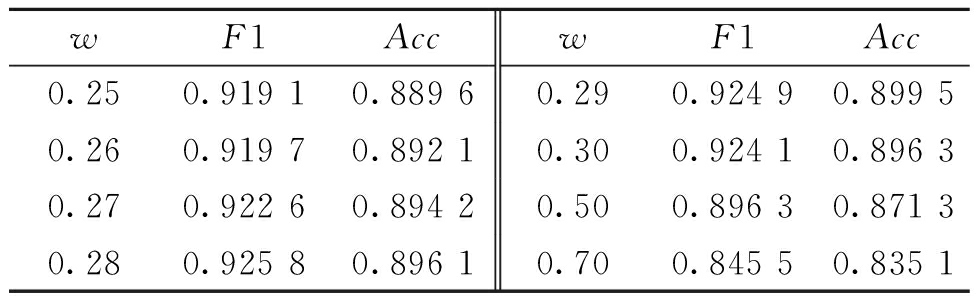

实验中使用操作系统为Linux,GPU为NVIDIA Tesla V100,CUDA为10.1。深度学习框架为Pytorch1.7.1,Adam optimizer优化网络。在模型的初始训练中进行数据集长度×0.05个步长的warm-up训练,文本向量输出CLS。本文进行了大量实验,研究了K值(例如3,5,7等)以及相似度阈值(从0.6至0.8)。通过平衡模型性能和时间消耗,实验将K设置为3,预测相似度的阈值设定为0.79。模型的主要超参数如表1所示。其中参数w的值参考文献[21],初始值设定为0.5,详细实验结果如表2所示。实验结果表明,将权重值设为0.29可以在此实验中达到最佳的效果。为了确保实验结果的一致性,后续实验中权重值不变。

表1 超参数设置

Table 1 Hyperparameter of CSDSM

参数取值参数取值学习率0.000 02embedding size768N32Pd0.1epoch10head number8Transformer 块1w0.29

表2 不同权重在科学数据集上的实验结果比较

Table 2 Comparison of experimental results on scientific datasets with different weights

wF1AccwF1Acc0.250.919 10.889 60.290.924 90.899 50.260.919 70.892 10.300.924 10.896 30.270.922 60.894 20.500.896 30.871 30.280.925 80.896 10.700.845 50.835 1

3.2 数据集

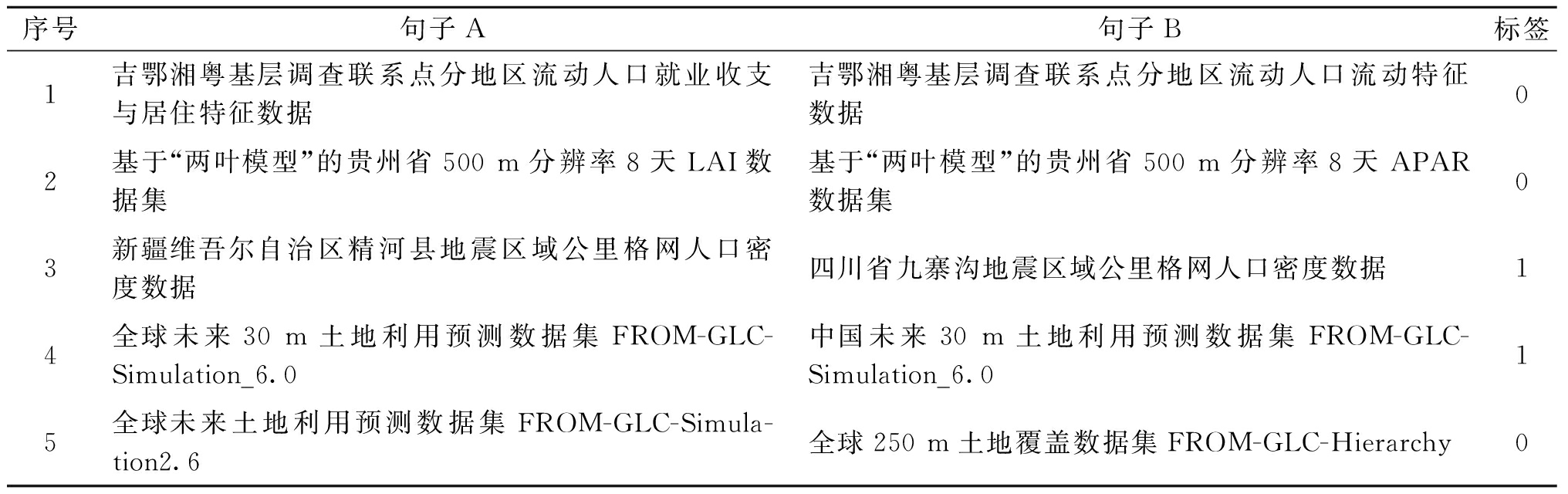

目前公开的科学领域的数据集相对有限,为了丰富科学数据集,本文采用Python中的Requests库和Scrapy框架从国家地球系统科学数据中心采集数据集的标题等元数据超过30 000条。使用数据清洗、去重等手段对数据进行预处理。人工标注构建相似语义句子对并收集术语添加到模型词表中。相似度标签通过多人标注,利用投票机制取平均结果。标签分为2个等级:相似为1,不相似为0,并按照8∶2的比例构建训练集和测试集(简称科学数据集)。其中训练集8 607对,测试集2 353对,样例见表3。

表3 部分科学数据集样例

Table 3 Some examples of scientific datasets

序号句子A句子B标签1吉鄂湘粤基层调查联系点分地区流动人口就业收支与居住特征数据吉鄂湘粤基层调查联系点分地区流动人口流动特征数据02基于“两叶模型”的贵州省500 m分辨率8天LAI数据集基于“两叶模型”的贵州省500 m分辨率8天APAR数据集03新疆维吾尔自治区精河县地震区域公里格网人口密度数据四川省九寨沟地震区域公里格网人口密度数据14全球未来30 m土地利用预测数据集FROM-GLC-Simulation_6.0中国未来30 m土地利用预测数据集FROM-GLC-Simulation_6.015全球未来土地利用预测数据集FROM-GLC-Simula-tion2.6全球250 m土地覆盖数据集FROM-GLC-Hierarchy0

中文科学文献数据集(CSL)包含396 209篇中文核心期刊论文的元数据(标题、摘要、关键词、学科、门类)。数据源自国家科技资源共享服务工程技术研究中心。

扩展实验中使用公开的中文语义匹配数据集,包括AFQMC(蚂蚁金融语义相似度数据集)、LCQMC(哈尔滨工业大学语义匹配数据集)、Chinese-STS-B(人工翻译修正的中文STS-B语义匹配数据集)以及PAWS-X(谷歌同义句识别数据集)。

3.3 评价指标

语义匹配任务的评价指标是判断输入句子对的语义是否等价。本文采用该领域常用的3个评价指标:F1、Acc和Spearman相关系数来评价模型性能。评价指标数值越大,模型性能越好。

精确率Pre[22]:

(12)

式中:TP代表样本为真预测为真的数量;FN代表样本为真预测为假的数量;FP代表为样本为假预测为真的数量;TN代表样本为假预测为假的数量。

召回率Rec[22]:

(13)

F1为综合考虑精确率和召回率的指标[22]:

(14)

准确率Acc[22]:

(15)

Spearman相关系数ρ[23]:

(16)

式中:di表示第i个数据对的等级差;n为总的观测样本数。

3.4 基准模型

目前,预训练-微调方法已成为语义匹配领域的主流方法之一。为了验证本文所提出的方法在科学数据集语义匹配中的有效性,本文选择了一些代表性的预训练模型进行微调,并比较它们的性能表现。

BERT[24]:中文BERT-base-Chinese预训练模型。

RoBERTa[25]: 基于全词掩码的Chinese-Roberta-wwm-ext预训练模型。PERT[26]: 一种基于乱序语言模型的预训练模型。

LERT[27]:融合了多种语言学知识的语言学信息增强的预训练模型。

4 结果分析

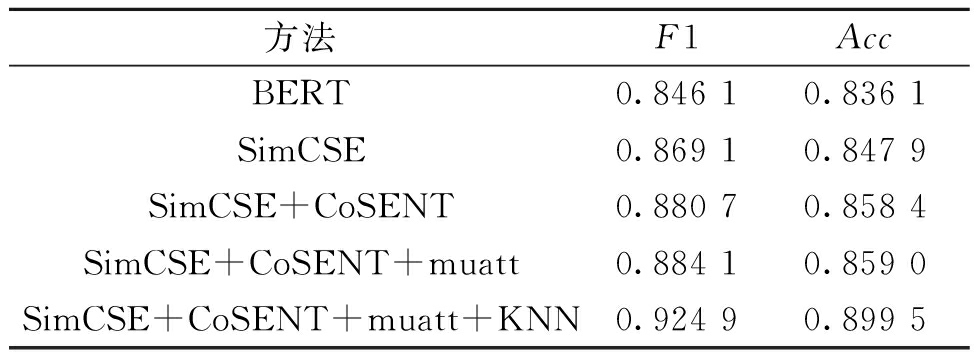

为了验证不同模块在科学数据集语义匹配的作用,在科学数据集上进行了消融实验,结果如表4所示。

表4 科学数据集上的消融实验结果比较

Table 4 Comparison of ablation experimental results on scientific datasets

方法F1AccBERT0.846 10.836 1SimCSE0.869 10.847 9SimCSE+CoSENT0.880 70.858 4SimCSE+CoSENT+muatt0.884 10.859 0SimCSE+CoSENT+muatt+KNN0.924 90.899 5

注:SimCSE表示预训练模型为SimCSE_unsup_CSL模型;muatt代表多头自注意力机制。

由表4可知,在模型中使用SimCSE后F1提升了0.021 8,说明具有领域知识的预训练模型能够理解科学数据语义;使用CoSENT函数后F1提升了0.034 6,训练和预测阶段任务一致使得模型性能进一步提升;加入多头自注意力机制,模型F1提升了0.003 8,将所有方法加入后,F1提升了0.078 8,此时F1达到了0.924 9。具有科学领域知识的预训练模型能够更准确地理解和捕捉科学领域的特定语义,从而更好地完成科学数据集上的语义匹配任务。

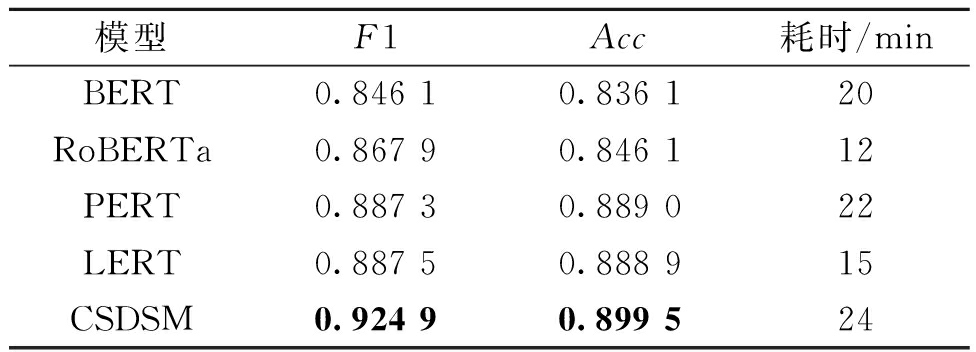

为了体现公平性,本文在科学数据集上微调了基线模型,对比实验结果如表5所示。

表5 不同模型在科学数据集上语义匹配结果比较

Table 5 Comparison of semantic matching results of different models on scientific datasets

模型F1Acc耗时/minBERT0.846 10.836 120RoBERTa0.867 90.846 112PERT0.887 30.889 022LERT0.887 50.888 915CSDSM0.924 90.899 524

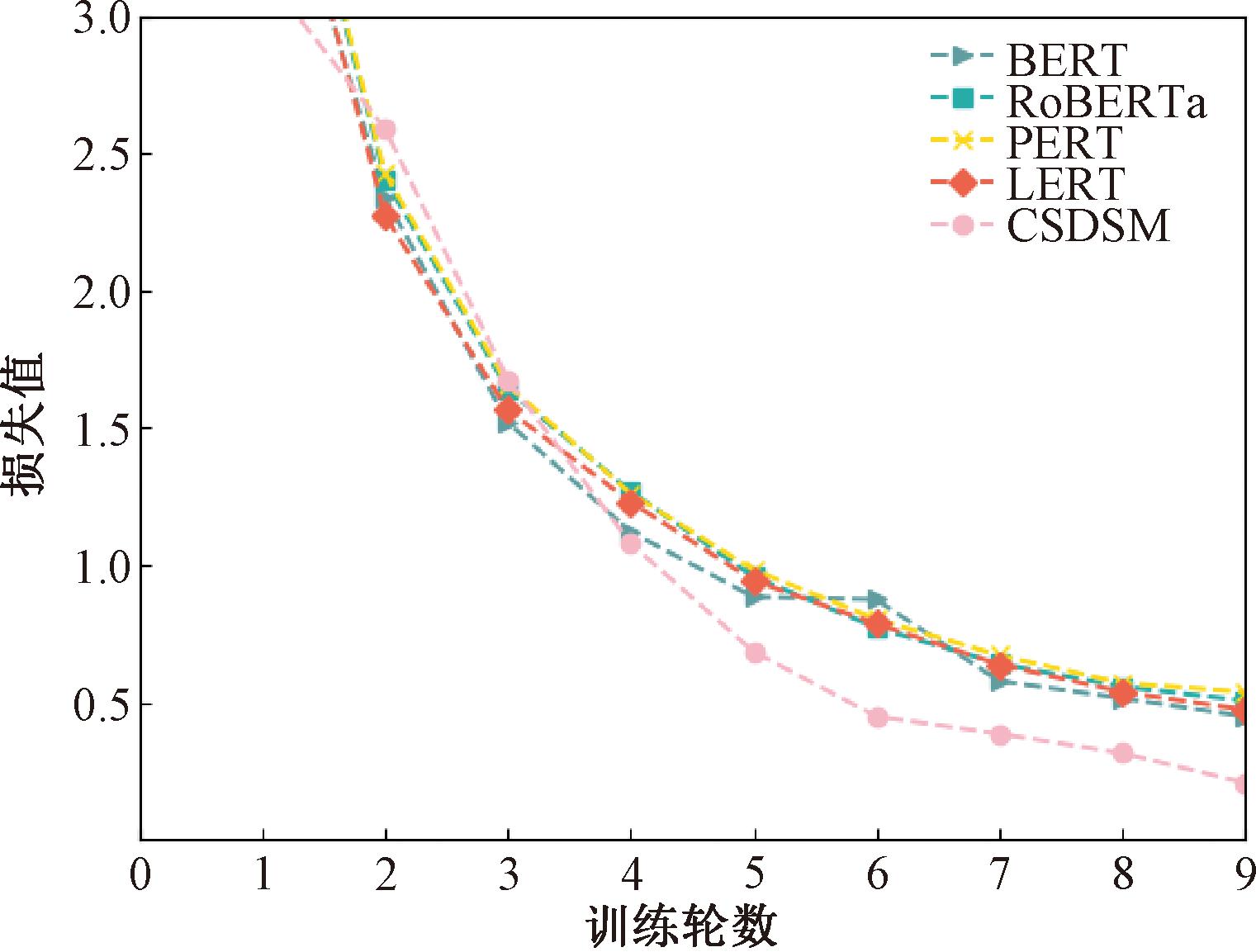

由表5可知,在科学数据集上,相比于原始预训练微调的方法,本文模型CSDSM的Acc和F1都有一定提升。由于在模型中增加了多头自注意力机制,并且首次训练需要将科学数据集嵌入到KNN算法中,导致了模型的训练时间增加。从测试结果看,相较于中文BERT模型,CSDSM模型在科学数据集上F1值和Acc分别提高了0.078 8和0.063 4。图6显示了不同模型在10轮训练中损失值的大小。可以看出,CSDSM模型使用CoSENT损失函数,在训练过程中损失值收敛速度更快。

图6 科学数据集上训练的损失值变化图

Figure 6 Loss curve of training on the scientific dataset

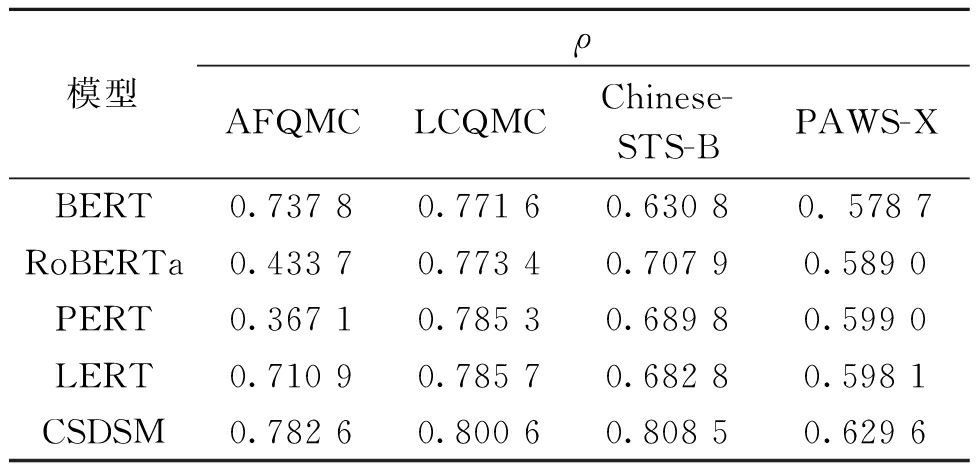

为了验证提出模型的可扩展性,本文在各个中文语义匹配数据集上进行了对比实验。由于中文语义匹配数据上多数作者使用Spearman相关性系数,所以本文使用此评价指标,实验结果如表6所示。

表6 不同模型在中文语义匹配数据上的Spearman相关性系数

Table 6 Spearman correlation coefficients of different models on Chinese semantic matching data

模型ρAFQMCLCQMCChinese-STS-BPAWS-XBERT0.737 80.771 60.630 80. 578 7RoBERTa0.433 70.773 40.707 90.589 0PERT0.367 10.785 30.689 80.599 0LERT0.710 90.785 70.682 80.598 1CSDSM0.782 60.800 60.808 50.629 6

由表6可知,CSDSM模型使用CoSENT函数优化模型的效果要好于预训练微调的结果,利用多头自注意力机制和KNN算法提升模型性能。实验结果表明,与中文BERT模型相比,所提模型在公共数据集AFQMC、LCQMC、Chinese-STS-B和PAWS-X上,Spearman指标ρ分别提升了0.044 8,0.029 0,0.177 7和0.050 9,证明了本文方法的可扩展性。

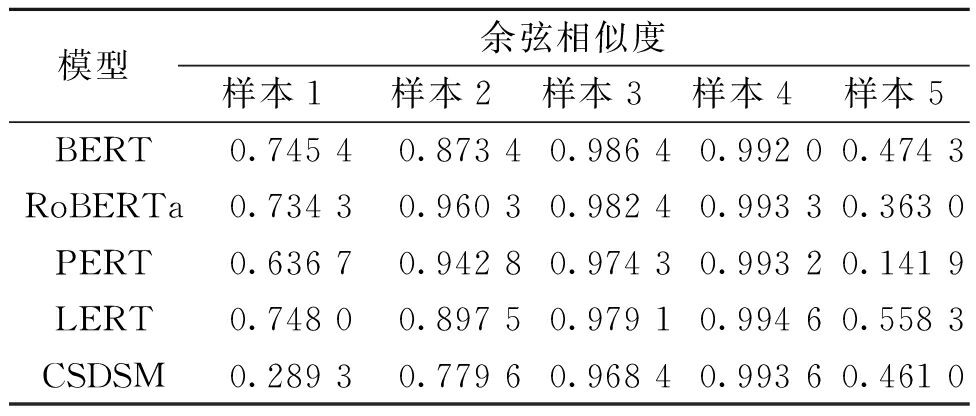

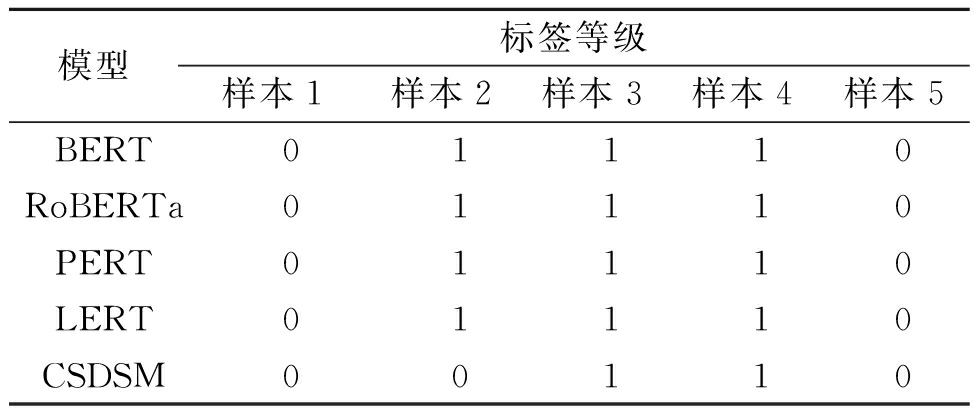

为了进一步说明CSDSM模型在科学数据集语义匹配上的有效性,本文使用基线模型在科学数据集上进行微调,并对表3中的句子进行实例分析,其中样本序号分别对应表3中样本,具体结果如表7和表8所示。

表7 不同模型在科学数据集上的实例分析

Table 7 Different models′ instance analysis on scientific datasets

模型余弦相似度样本1样本2样本3样本4样本5BERT0.745 40.873 40.986 40.992 00.474 3RoBERTa0.734 30.960 30.982 40.993 30.363 0PERT0.636 70.942 80.974 30.993 20.141 9LERT0.748 00.897 50.979 10.994 60.558 3CSDSM0.289 30.779 60.968 40.993 60.461 0

表8 不同模型在科学数据集上的实例预测结果

Table 8 Prediction results of different models on instances in the scientific datasets

模型标签等级样本1样本2样本3样本4样本5BERT01110RoBERTa01110PERT01110LERT01110CSDSM00110

从表7和表8中可以看出,基线模型在大部分样本中分类正确,而样本2“基于‘两叶模型’的贵州省500 m分辨率8天LAI数据集”和“基于‘两叶模型’的贵州省500 m分辨率8天APAR数据集”,具有中英文混合、文本重叠但语义不相似的样本,基线模型对于该样本都没有正确分类。CSDSM模型对所有实例中的样本都做出了正确的判断,这说明本文提出的改进策略在科学数据集语义匹配上的效果更好。

5 结论

本文提出了一个面向中文科学数据集的句子级语义匹配模型CSDSM。采用爬虫技术对科学数据集进行了收集和标注。通过CSL数据集对SimCSE和CoSENT模型进行预训练以学习领域知识;加入多头自注意力机制模块捕获语义信息;使用KNN算法来增强语义判断的能力。模型在自建数据集和公共数据集上均取得了最优的结果。

下一步,基于本研究将开展以下工作:①模型的持续优化,进一步探索利用模型压缩技术,以提升模型的线上部署能力;②提升模型的泛化能力,面向不同领域的国家科技资源共享服务平台,收集和组织更为丰富的科学数据语义元数据集开展实验。

[1] 罗鹏程, 王继民, 王世奇, 等. 基于深度学习的科学数据集检索方法研究[J]. 情报理论与实践, 2022, 45(7): 49-56.LUO P C, WANG J M, WANG S Q, et al. Research on deep learning based scientific dataset retrieval method[J]. Information Studies: Theory &Application, 2022, 45(7): 49-56.

[2] CHEN S H, XU T J. Long text QA matching model based on BiGRU-DAttention-DSSM[J]. Mathematics, 2021, 9(10): 1129.

[3] 冯皓楠, 何智勇, 马良荔. 基于图文注意力融合的主题标签推荐[J]. 郑州大学学报(工学版), 2022, 43(6): 30-35.FENG H N, HE Z Y, MA L L. Multimodal hashtag recommendation based on image and text attention fusion[J]. Journal of Zhengzhou University (Engineering Science), 2022, 43(6): 30-35.

[4] VASWANI A, SHAZEER N, PARMAR N, et al. Attention is all you need[C]∥Proceedings of the 31st International Conference on Neural Information Processing Systems. New York: ACM, 2017: 6000-6010.

[5] LI Y D, ZHANG Y Q, ZHAO Z, et al. CSL: a large-scale Chinese scientific literature dataset[EB/OL].(2022-09-12)[2023-06-11]. https:∥arxiv.org/abs/2209.05034.

[6] GAO T Y, YAO X C, CHEN D Q. SimCSE: simple contrastive learning of sentence embeddings[C]∥Proceedings of the 2021 Conference on Empirical Methods in Natural Language Processing. Stroudsburg: Association for Computational Linguistics, 2021: 6894-6910.

[7] LI S H, GONG B. Word embedding and text classification based on deep learning methods[J]. MATEC Web of Conferences, 2021, 336: 06022.

[8] LIU J P, CHU X T, WANG Y F, et al. Deep text retrieval models based on DNN, CNN, RNN and Transformer: a review[C]∥2022 IEEE 8th International Conference on Cloud Computing and Intelligent Systems (CCIS). Piscataway: IEEE, 2022: 391-400.

[9] HUANG P S, HE X D, GAO J F, et al. Learning deep structured semantic models for web search using clickthrough data[C]∥Proceedings of the 22nd ACM international conference on Information &Knowledge Management. New York: ACM, 2013: 2333-2338.

[10] SHEN Y L, HE X D, GAO J F, et al. A latent semantic model with convolutional-pooling structure for information retrieval[C]∥Proceedings of the 23rd ACM International Conference on Conference on Information and Knowledge Management. New York: ACM, 2014: 101-110.

[11] MOHAN S, FIORINI N, KIM S, et al. A fast deep learning model for textual relevance in biomedical information retrieval[C]∥Proceedings of the 2018 World Wide Web Conference. New York: ACM, 2018: 77-86.

[12] KHURANA D, KOLI A, KHATTER K, et al. Natural language processing: state of the art, current trends and challenges[J]. Multimedia tools and applications, 2023, 82(3): 3713-3744.

[13] MIKOLOV T, SUTSKEVER I, CHEN K, et al. Distributed representations of words and phrases and their compositionality[C]∥Proceedings of the 26th International Conference on Neural Information Processing Systems:Volume 2. New York: ACM, 2013: 3111-3119.

[14] 汪烨, 周思源, 翁知远, 等. 一种面向用户反馈的智能分析与服务设计方法[J]. 郑州大学学报(工学版), 2023, 44(3): 56-61.WANG Y, ZHOU S Y, WENG Z Y, et al. An intelligent analysis and service design method for user feedback[J]. Journal of Zhengzhou University (Engineering Science), 2023, 44(3): 56-61.

[15] LIU P F, YUAN W Z, FU J L, et al. Pre-train, prompt, and predict: a systematic survey of prompting methods in natural language processing[J]. ACM Computing Surveys, 2021,55(9): 195.

[16] CHOUDHARY S, GUTTIKONDA H, CHOWDHURY D R, et al. Document retrieval using deep learning[C]∥2020 Systems and Information Engineering Design Symposium (SIEDS). Piscataway: IEEE, 2020: 1-6.

[17] ESTEVA A, KALE A, PAULUS R, et al. COVID-19 information retrieval with deep-learning based semantic search, question answering, and abstractive summarization[J]. NPJ Digital Medicine, 2021, 4: 68.

[18] BELTAGY I, LO K, COHAN A. SciBERT: a pretrained language model for scientific text[C]∥Proceedings of the 2019 Conference on Empirical Methods in Natural Language Processing and the 9th International Joint Conference on Natural Language Processing (EMNLP-IJCNLP). Stroudsburg: Association for Computational Linguistics, 2019: 3615-3620.

[19] CHOWDHURY A, ROSENTHAL J, WARING J, et al. Applying self-supervised learning to medicine: review of the state of the art and medical implementations[J]. Informatics, 2021, 8(3): 59.

[20] REIMERS N, GUREVYCH I. Sentence-BERT: sentence embeddings using siamese BERT-networks[C]∥Proceedings of the 2019 Conference on Empirical Methods in Natural Language Processing and the 9th International Joint Conference on Natural Language Processing (EMNLP-IJCNLP). Stroudsburg: Association for Computational Linguistics, 2019: 3982-3992.

[21] LI L Y, SONG D M, MA R T, et al. KNN-BERT: fine-tuning pre-trained models with KNN classifier[EB/OL].(2021-10-06)[2023-06-11]. https:∥arxiv.org/abs/2110.02523.

[22] PALANIVINAYAGAM A, EL-BAYEH C Z, DAMA EVI

EVI IUS R. Twenty years of machine-learning-based text classification: a systematic review[J]. Algorithms, 2023, 16(5): 236.

IUS R. Twenty years of machine-learning-based text classification: a systematic review[J]. Algorithms, 2023, 16(5): 236.

[23] CHICCO D. Siamese neural networks: an overview[J]. Methods in Molecular Biology, 2021, 2190: 73-94.

[24] DEVLIN J, CHANG M W, LEE K, et al. BERT: pre-training of deep bidirectional transformers for language understanding[EB/OL].(2019-05-24)[2023-06-11]. https:∥arxiv.org/abs/1810.04805.

[25] CUI Y M, CHE W X, LIU T, et al. Pre-training with whole word masking for Chinese BERT[J]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2021, 29: 3504-3514.

[26] CUI Y M, YANG Z Q, LIU T. PERT: pre-training BERT with permuted language model[EB/OL].(2022-03-14)[2023-06-11]. https:∥arxiv.org/abs/2203.06906.

[27] CUI Y M, CHE W X, WANG S J, et al. LERT: a linguistically-motivated pre-trained language model[EB/OL]. (2022-11-10)[2023-06-11].https:∥arxiv.org/abs/2211.05344.