宽带信号检测与识别在电磁战争、反恐安防等领域都有着广泛的应用。信号检测作为获取敌方信息的首要环节,在战场通信侦察对抗场景中发挥至关重要的作用[1]。研究在较宽的频带上进行精准定位和跟踪信号并实施“瞄准式”的干扰,已成为智能化通信对抗体系的一个发展方向。

随着宽带通信信号频段范围的增大,电磁环境越来越复杂,传统的信号检测方法如匹配滤波法[2]、循环平稳法[3]、特征值检测法[4]和能量检测法[5],已无法满足现代无线通信信号智能检测与识别的需求。近几年发展起来的深度学习技术为复杂环境下的通信信号检测与识别提供了全新的解决思路。Huang等[6]设计了一维全卷积网络(fully convolutional networks,FCN)对宽带功率谱进行检测,将宽带上的载波信号检测问题转化为一维图像上的语义分割问题。Prasad等[7]采用并缩小了现有的快速区域卷积神经网络(faster region convolutional neural networks,Faster-RCNN)框架,从宽带信号时频图上检测和定位信号,缩小后的Faster-RCNN模型达到0.8的平均检测精度(mAP)。Zha等[8]提出了一种用于多信号检测和调制识别的深度学习框架,使用SSD网络实现多信号检测。Li等[9]提出了基于YOLOv3目标检测网络的宽带检测方法,引入了CIOU代价函数和DIOU-NMS推理算法来实现信号检测。然而,大部分研究主要集中在对原始宽带数据进行信号存在性的二元判决,对信号参数估计的研究较少[10]。少数学者虽然尝试利用宽带时频图检测获取信号参数,但存在识别精度不高、定位不准、泛化能力差等问题[11]。此外,在大带宽场景采样所得的信号中,通信信号主要呈现为细小的线段状。将时频图的尺寸压缩后直接送入网络进行训练,图上的“细线形”信号区域会变得更加细长、窄小,难以实现精准的目标检测[12];如果采用原图进行训练,则会消耗过多的计算资源,导致训练时间过长、推理速度慢等问题。

针对大带宽范围内的无线通信信号检测与识别问题,本文提出了一种基于时频图切割的宽带信号智能检测与识别方法。该方法通过时频图切割对数据进行增强,采用Mobilenet网络代替YOLOv4当中的CSPdarknet53网络进行特征提取,构建了一种轻量化的YOLOv4模型;同时,引入Focal-EIOU代价函数和一种改进的加权盒融合算法(WBF)来实现高精度的信号检测与识别。实验结果表明,本文提出的方法具有更高的检测精度,其性能优于传统的能量检测方法;与同类方法相比,该模型在提升识别精度的同时降低了时间成本,兼顾了检测精度与实时性要求。

1 信号模型

宽带接收机的接收频段为[fL,fR],起止时刻为[tL,tR],在其带宽范围内存在N个窄带信号,第i个窄带信号占用的频段范围为![]() 起止时刻为

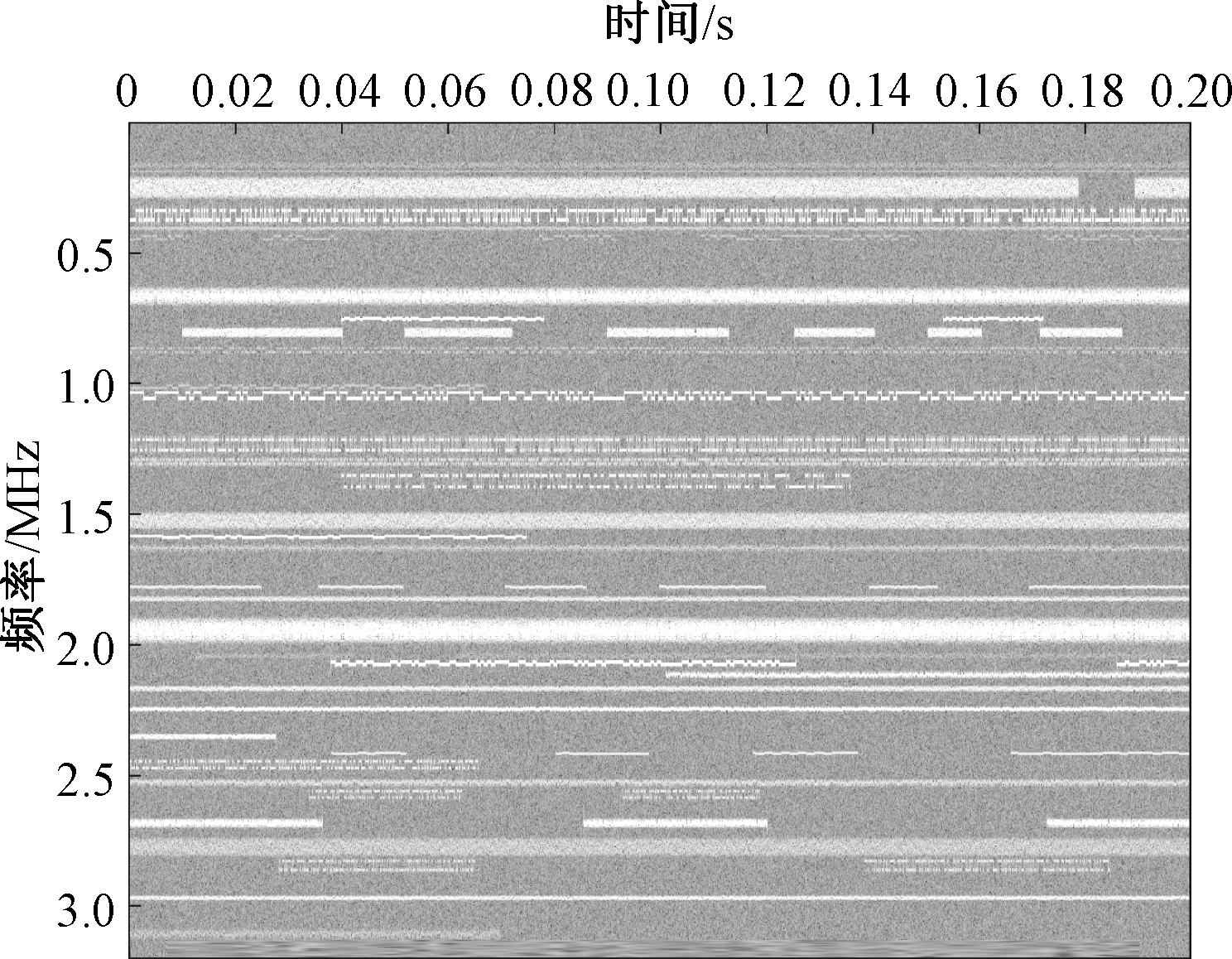

起止时刻为![]() 如图1所示的宽带多信号时频图,描述了信号在不同时间和频率的能量密度,由信号的短时傅里叶变换得到。信号s(t)的短时傅里叶变换定义为

如图1所示的宽带多信号时频图,描述了信号在不同时间和频率的能量密度,由信号的短时傅里叶变换得到。信号s(t)的短时傅里叶变换定义为

STFT(t,f)=![]() [s(τ)γ(τ-t)]e-j2πfτdτ。

[s(τ)γ(τ-t)]e-j2πfτdτ。

(1)

式中:t和f分别为时间和频率变量;γ(·)为分析窗口函数,它控制傅里叶变换所涉及的数据长度和窗口类型。

图1的纵轴频率为0~3.2 MHz,对应像素点数为1 249;横轴时间为0~0.20 s,对应像素点数为1 025,信噪比为0~30 dB随机分布。其中包含3个窄带信号,分别为PSK、FSK、GMSK,以定频和突发的形式随机生成。

图1 宽带多信号时频图

Figure 1 Broadband multi-signal time-frequency diagram

假设目标检测模型在时频图中预测到信号的归一化坐标为![]() 通过坐标值、采样率Fs和时间尺度Ts可估计频率和带宽等参数。参数估计公式:中心频率

通过坐标值、采样率Fs和时间尺度Ts可估计频率和带宽等参数。参数估计公式:中心频率![]() 带宽

带宽![]() 起止时刻

起止时刻![]()

2 系统架构

本文方法主要分为样本预处理和网络模型2部分,其总体框架如图2所示。其中,样本预处理包括短时傅里叶变换、灰度变换、样本生成和时频切割4个步骤;网络模型包括二维时频图集合的标签转换、深度神经网络训练、信号检测3个部分。

图2 信号检测与识别处理流程

Figure 2 Signal detection and recognition

processing flow chat

2.1 样本预处理

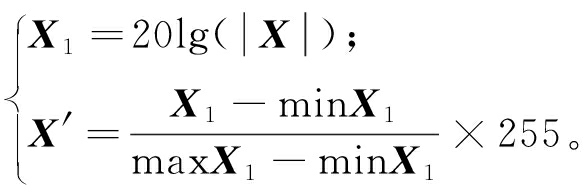

本文所使用的宽带数据通过2台软件无线电模拟收发产生,设置采样率6.4 MHz,采样时间0.2 s,共采集数据500个,并通过特定程序获得每个数据对应的标签文件,标签内容包括信号个数、信号调制方式、信号的频率范围和时间范围。采用短时傅里叶变换对宽带数据进行运算,窗的类型采用汉明窗,窗的长度为2 048,重叠比例为1/2。X表示输入信号,X′为变换后的灰度矩阵,采用的灰度变换公式如下:

(2)

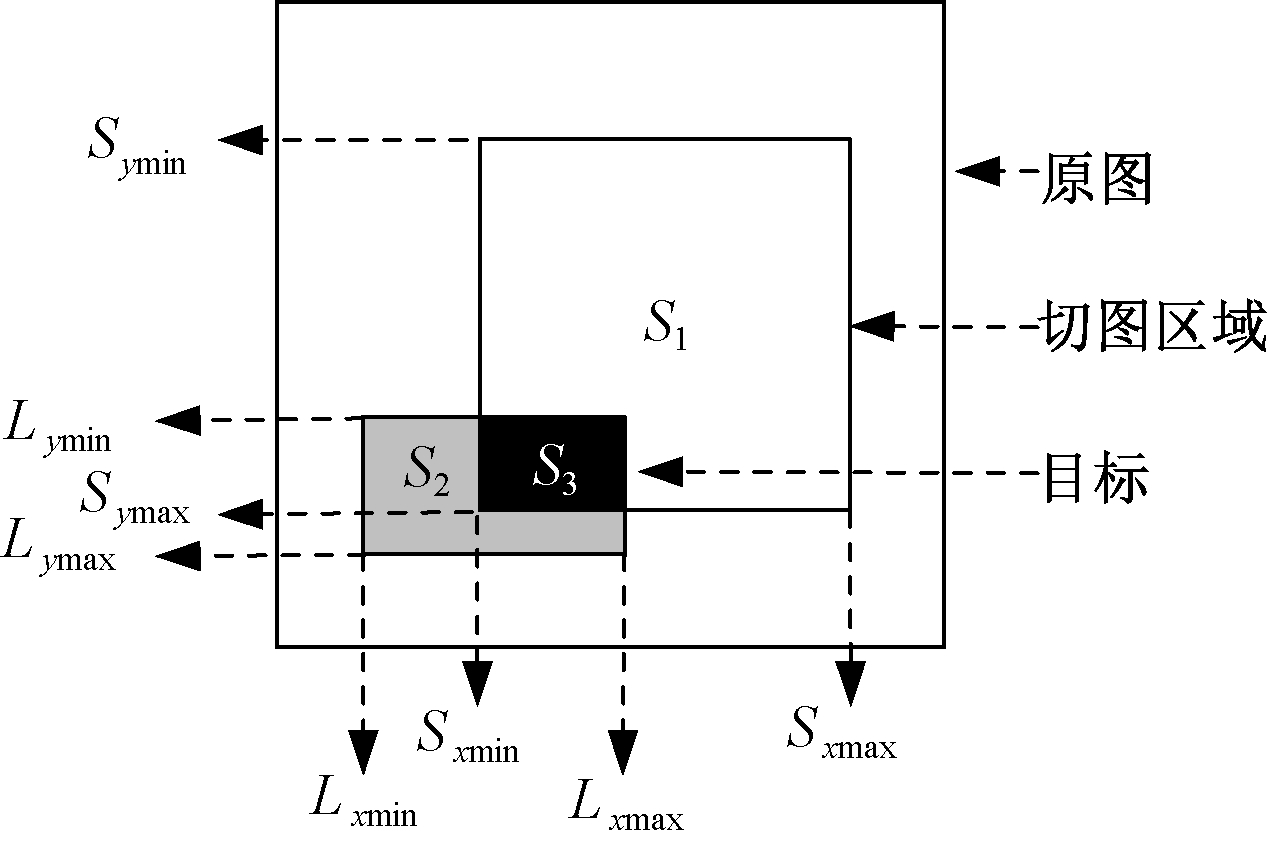

本文采用一种时频切割的数据增强方法,将时频图按一定的宽高比例切成若干小图进行训练。实现原理如图3所示,为了保留信号的完整性,定义一个切片占比S_IOU,通过设置S_IOU的大小判断信号是否保留:

图3 时频切割原理示意图

Figure 3 Schematic diagram of time-frequency

cutting principle

(3)

式中:S1为切图区域面积;S2为目标信号区域面积;S3为两区域的交集面积。

假设宽带时频图中第i个窄带信号框坐标为![]() 第j个切图坐标

第j个切图坐标![]() 返回的坐标为(Rxmin,Rymin,Rxmax,Rymax),将原图上的坐标映射到切图上,详细流程如下:

返回的坐标为(Rxmin,Rymin,Rxmax,Rymax),将原图上的坐标映射到切图上,详细流程如下:

步骤1 从左到右,从上到下,依次滑动切割。本文设定切片大小为512像素×512像素,切片重叠比例为0.2,步长为1。当滑动切片的长度大于原图的边界值时,切图的起始位置等于原图大小减去切片大小。

步骤2 依次遍历每张切图中的信号,根据S_IOU的大小判断信号是否保留。本文将S_IOU设定为0.2。

步骤3 在水平方向上将![]() 升序排列,组成一个新的列表Xlist;在垂直方向上将

升序排列,组成一个新的列表Xlist;在垂直方向上将![]() 升序排列,组成一个新的列表Ylist。

升序排列,组成一个新的列表Ylist。

步骤4 映射到切图中的坐标,![]()

2.2 网络模型

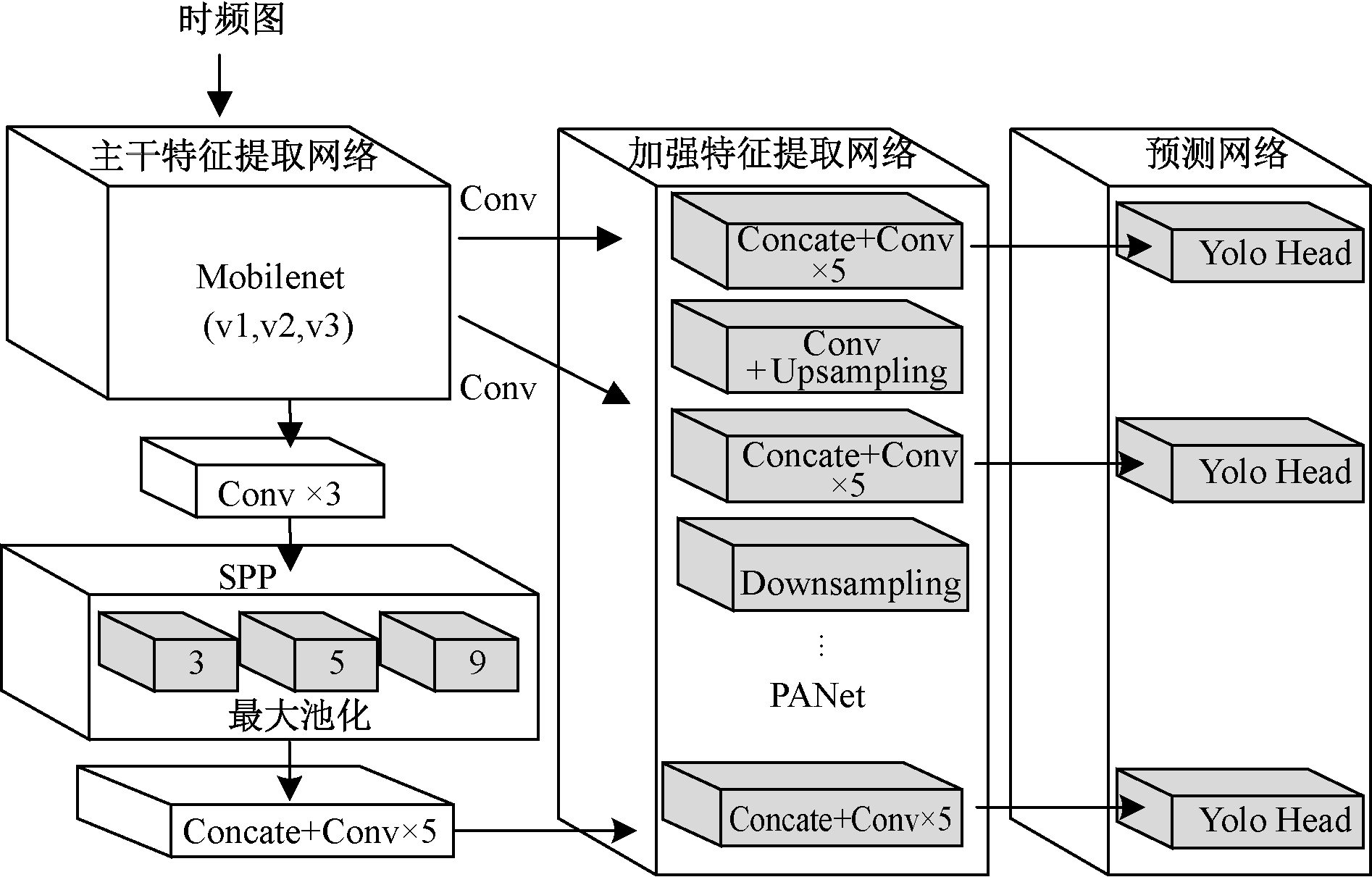

Mobilenet[13]是Google针对手机等嵌入式设备提出的一种轻量级深层神经网络,其核心思想是使用深度可分离卷积减少模型参数。本文采用Mobilenet作为主干特征提取网络来获得3个有效特征层;采用YOLOv4作为预测网络,对获得的特征进行预测。整体的网络结构主要包括主干特征提取网络、加强特征提取网络、预测网络,如图4所示。

图4 YOLOv4-Mobilenet网络结构图

Figure 4 Structure of YOLOv4-Mobilenet network

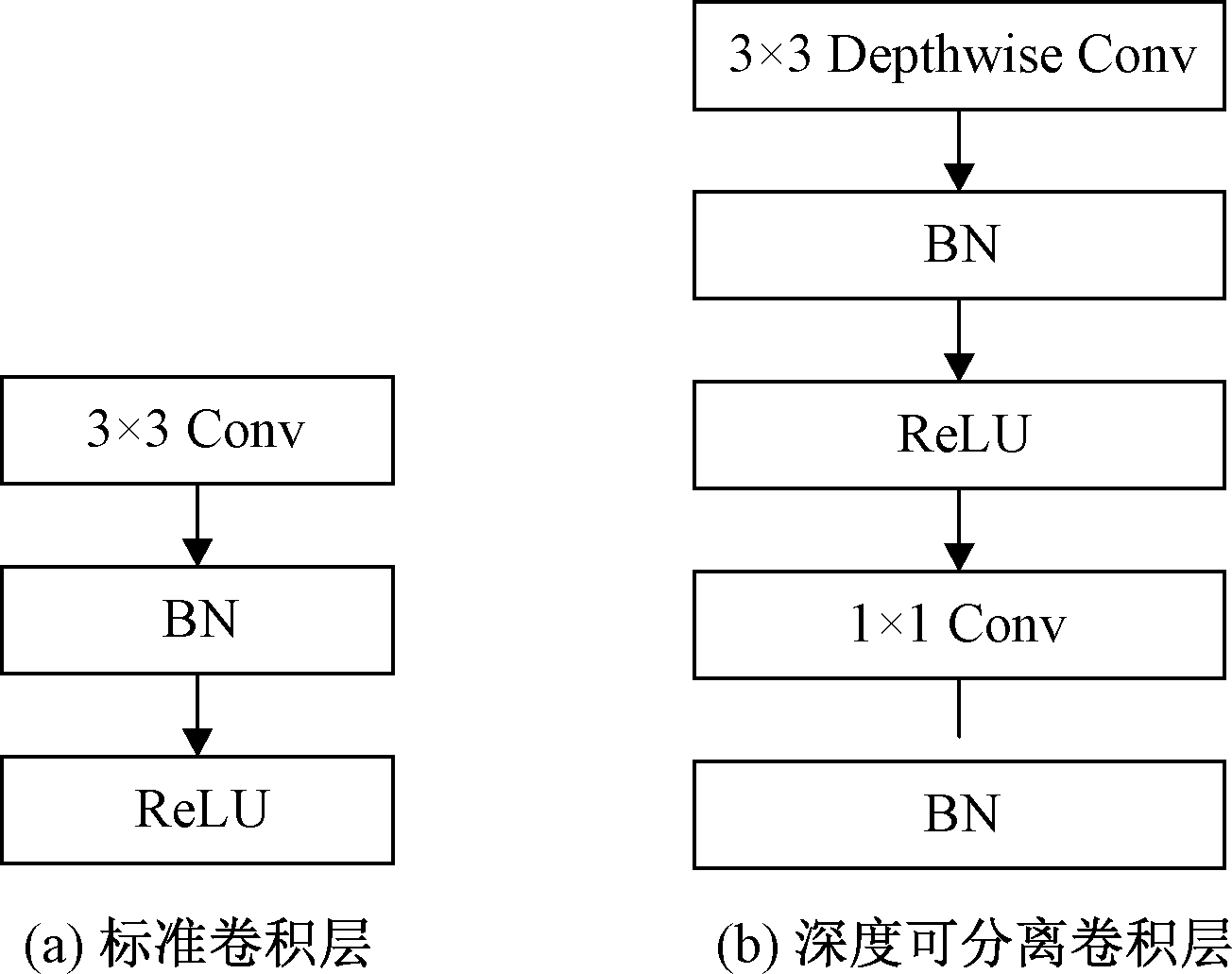

(1)主干特征提取网络。将Mobilenet作为主干特征提取网络获取3个基本特征进行加强特征金字塔的构建。为进一步减少参数量,使用深度可分离卷积代替YOLOv4中的标准卷积,如图5所示。图5(a)为标准卷积层,图5(b)为深度可分离卷积层。

图5 2种卷积对比

Figure 5 Comparison of the two convolutions

(2)加强特征提取网络。在特征金字塔部分,YOLOv4使用了SPP结构和PANet结构。SPP结构用于Mobilenet的最后1个卷积层,利用4个不同尺寸(1×1、5×5、9×9、13×13)的最大池化层进行处理,极大增加感受视野,分离出显著的上下文特征。PANet结构对特征进行反复提取,加强特征提取网络对3个基本特征层的特征融合,最后获得3个有效的特征层。

(3)预测网络。Yolo Head对3个有效特征层分别进行处理,进行一次3×3卷积和一次1×1卷积,N张图片经过多层的运算后,会输出3个形状分别为(N,13,13,255)、(N,26,26,255)、(N,52,52,255)的结果。预测网络对预测框进行解码后,进行得分排序与非极大抑制筛选(NMS),最后得到每一个类别的预测类型、置信度以及坐标位置。

2.3 训练和推理方面的改进

YOLOv4网络采用CIOU (Complete-IOU)作为回归优化损失函数,CIOU将目标与先验框之间的距离、重叠率、尺度和惩罚项考虑在内,使得目标回归框更加稳定[14]。CIOU计算公式为

(4)

式中:b、bgt分别表示预测框、真实框的中心点;ρ(·)表示2个中心点间的欧式距离;c表示能同时包含预测框和真实框的最小闭合区域的对角线距离;α表示权重函数;v表示用于衡量长宽比的相似性。α和v的表达式为

(5)

(6)

YOLOv4网络的损失函数主要由坐标回归损失(LOSSCIOU),置信度损失(LOSSCONF)以及分类损失(LOSSCLS)3部分组成:

LOSS=LOSSCIOU+LOSSCONF+LOSSCLS=LOSSCIOU+

(7)

式中:s为特征图大小;B为预测框数目;![]() 表示特征图中第i个单元的第j个预测边框是否包含真实目标,若包含则为1,否则为

表示特征图中第i个单元的第j个预测边框是否包含真实目标,若包含则为1,否则为![]() 定义相反;Ci为预测边框置信度;

定义相反;Ci为预测边框置信度;![]() 为Ci对应的真实边框置信度;ρi(c)为预测边框的类别概率;

为Ci对应的真实边框置信度;ρi(c)为预测边框的类别概率;![]() 为ρi(c)对应的真实边框类别概率。

为ρi(c)对应的真实边框类别概率。

CIOU虽然考虑了边界框回归的重叠面积、中心点距离、纵横比,但其公式中的v反映的是纵横比的差异,而不是宽高分别与其置信度的真实差异,所以训练过程中会阻碍模型的优化相似性。针对这一问题,采用LOSSFocal-EIOU[15]作为坐标回归损失,惩罚项公式如下:

LOSSEIOU=LOSSIOU+LOSSDIS+LOSSASP=

(8)

式中:cw和ch分别为覆盖2个盒子的最小封闭盒子的宽度和高度。

考虑到回归过程中训练样本不平衡的问题,即在1张图像中回归误差小的高质量锚框的数量远少于误差大的低质量样本,质量较差的样本会产生过大的梯度影响训练过程,在EIOU的基础上结合Focal-Loss损失函数提出LOSSFocal-EIOU,从梯度的角度出发,把高质量的锚框和低质量的锚框分开,惩罚项公式如下:

LOSSFocal-EIOU=IOUλ·LOSSEIOU。

(9)

式中:λ为控制异常值抑制程度的参数。根据上述公式,IOU越高损失越大,相当于加权作用,越好的回归目标反馈一个越大的损失,有利于提高回归精度。

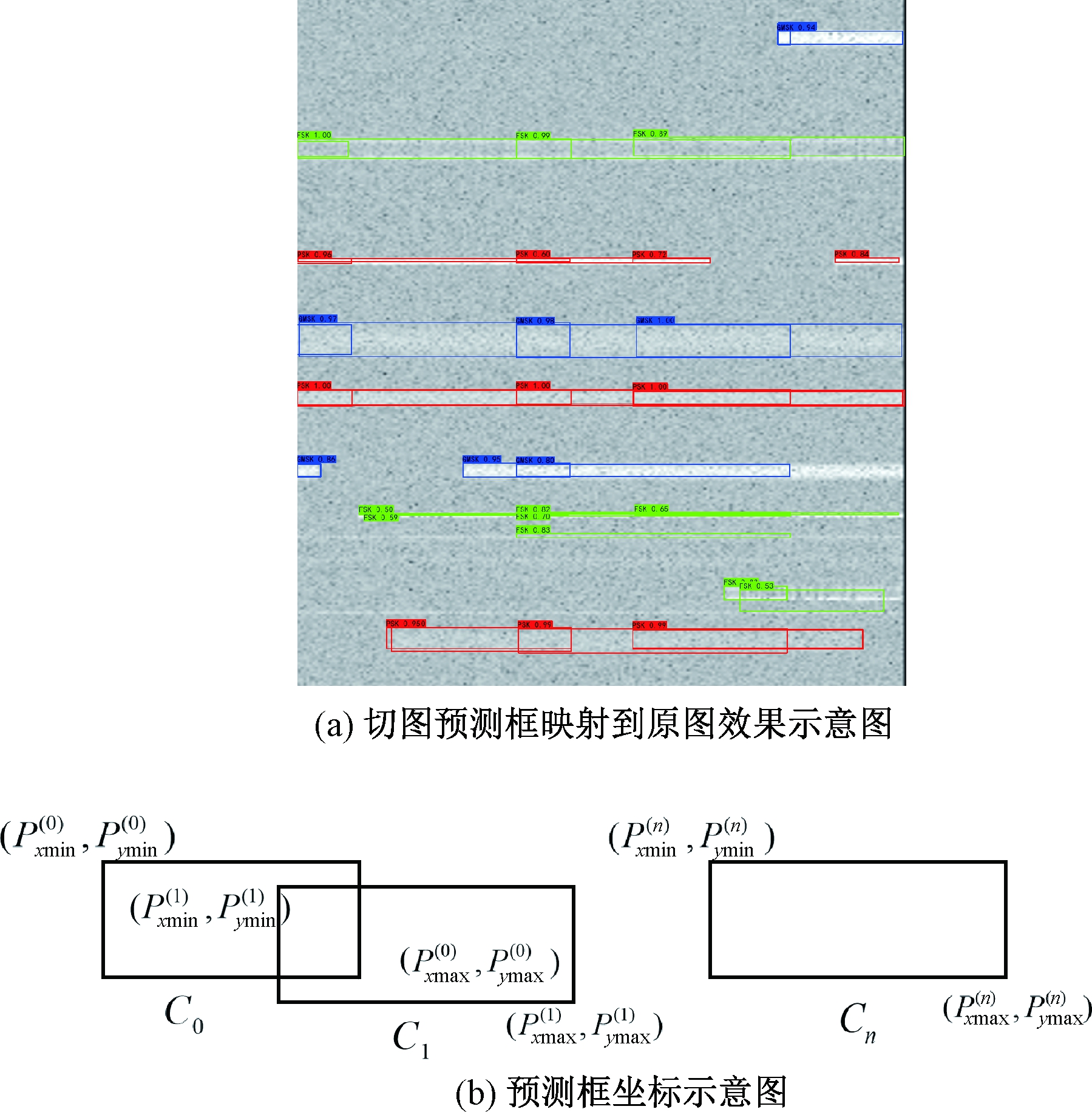

薛均晓等[16]对YOLOv4模型的改进中,引入DIOU-NMS用于缓解目标存在遮拦而被错误抑制的现象。本文YOLOv4模型同样采用DIOU-NMS非极值抑制方法。其次,本文模型在对原图切割后的图片进行预测后,将每一张切图上得到的信号预测框坐标映射到原图上时,每一类信号上会得到多个大小不同和位置不同的预测框,如图6(a)所示。针对此问题,提出一种基于加权框融合WBF[17]的解决方法,处理流程如下。

步骤1 将模型对每一张切图的检测结果(包括类别、置信度、坐标)都添加到列表PreDates中,并将此列表按照切图顺序、类别以及置信度大小降序排列。其中,![]() 为所有预测框总数。

为所有预测框总数。

步骤2 建立Clusters容器和Fusions容器。Clusters容器用来存放原图上同一位置、同一类信号的预测结果;Fusions容器用来存放Clusters容器融合后的结果。

步骤3 通过2个预测框的水平中心差(HCD)进行聚类,![]() 循环遍历PreDates,得到N个聚类,对应N个Clusters容器,再将每一个Clusters容器中的结果按照框的垂直中心大小(VC)进行升序排列,

循环遍历PreDates,得到N个聚类,对应N个Clusters容器,再将每一个Clusters容器中的结果按照框的垂直中心大小(VC)进行升序排列,![]() 如图6(b)所示。

如图6(b)所示。

图6 改进的加权框融合原理示意图

Figure 6 Schematic diagram of the improved weighted

frame fusion principle

步骤4 对每一个容器Clusters中的类别、置信度和坐标进行加权融合,并将融合后的结果放入容器Fusions。一个Clusters容器中至少存在一种信号类别,假设第j(j∈[0,N-1])个Clusters容器中存在2种类别S1和S2,每一种类别的个数分别为K1和K2,每一种类别的预测置信度为C。融合方法如下。

类别:若![]() 则判为S1;若

则判为S1;若![]() 则判为S2。

则判为S2。

置信度:若判为S1,则![]()

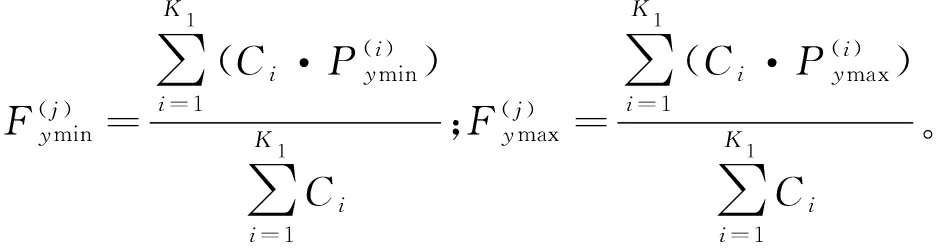

坐标:若判为S1,则

依次遍历Clusters容器中的![]() 若

若![]() 则

则![]() 说明该信号是连续信号;若出现

说明该信号是连续信号;若出现![]() 则该容器中将产生多个融合坐标,第1个坐标

则该容器中将产生多个融合坐标,第1个坐标![]() 第2个坐标的起始值

第2个坐标的起始值![]() 依次类推,说明该信号为突发信号。

依次类推,说明该信号为突发信号。

3 实验与结果分析

3.1 实验设置

根据上文数据预处理方法,对500个数据切割后得到的6 000张时频图的集合按照8∶1∶1的比例划分为训练集、验证集、测试集。测试集采用2种数据对模型进行测试,分别为100个采样率6.4 MHz、采样时间0.2 s的宽带数据和100个采样率6.4 MHz、采样时间2 s的宽带数据。

本文数据预处理过程都在MATLAB R2020b上完成,利用Python语言在平台TensorFlow 2.2.0上实现网络的训练,所有程序的GPU环境为GeForce RTX 2080Ti。训练过程分为冻结阶段和解冻阶段。在冻结阶段,模型的主干被冻结,特征提取网络不会发生改变。设置冻结阶段的迭代次数epoch为50,batchsize为16;解冻阶段的epoch为100,batchsize为8。使用SGD优化算法进行模型参数更新,初始学习率设置为0.001,优化器内部参数momentum设置为0.9,权重衰减量为0.000 05。

3.2 实验结果

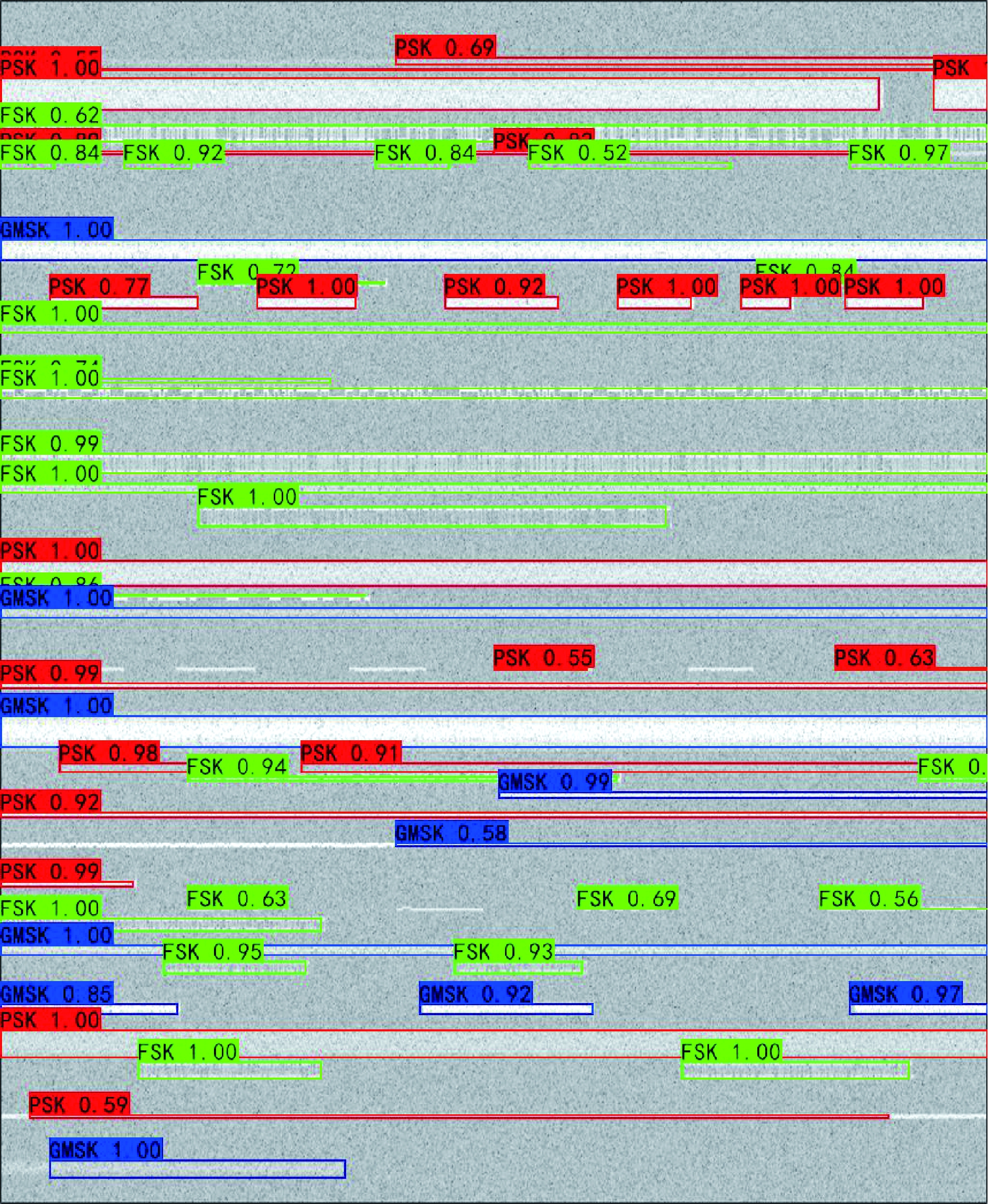

本文模型检测结果如图7所示。不同的信号分别用不同颜色的预测框包围,并在左上角注明信号的调制类型和置信度。从检测结果来看,该模型可以有效的检测出宽带数据中信号区域,同时可以准确区分连续信号和突发信号,对于PSK和GMSK这2种人眼无法轻易识别的信号,该算法模型也能准确识别,不足之处在于可能存在部分突发信号漏检或信号起止时刻估计不准确的情况。

图7 本文模型检测结果

Figure 7 Test results of this model

3.3 算法性能评估

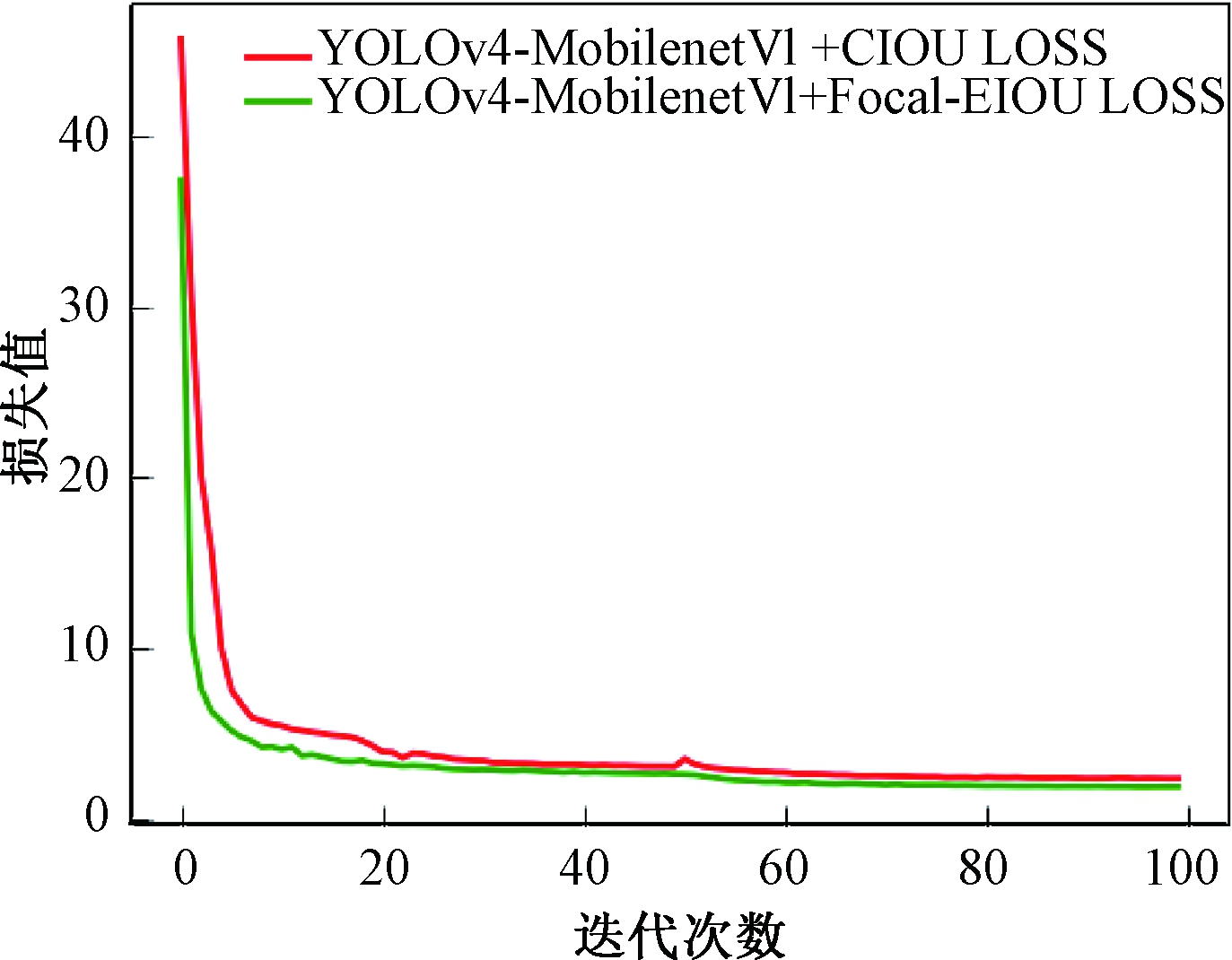

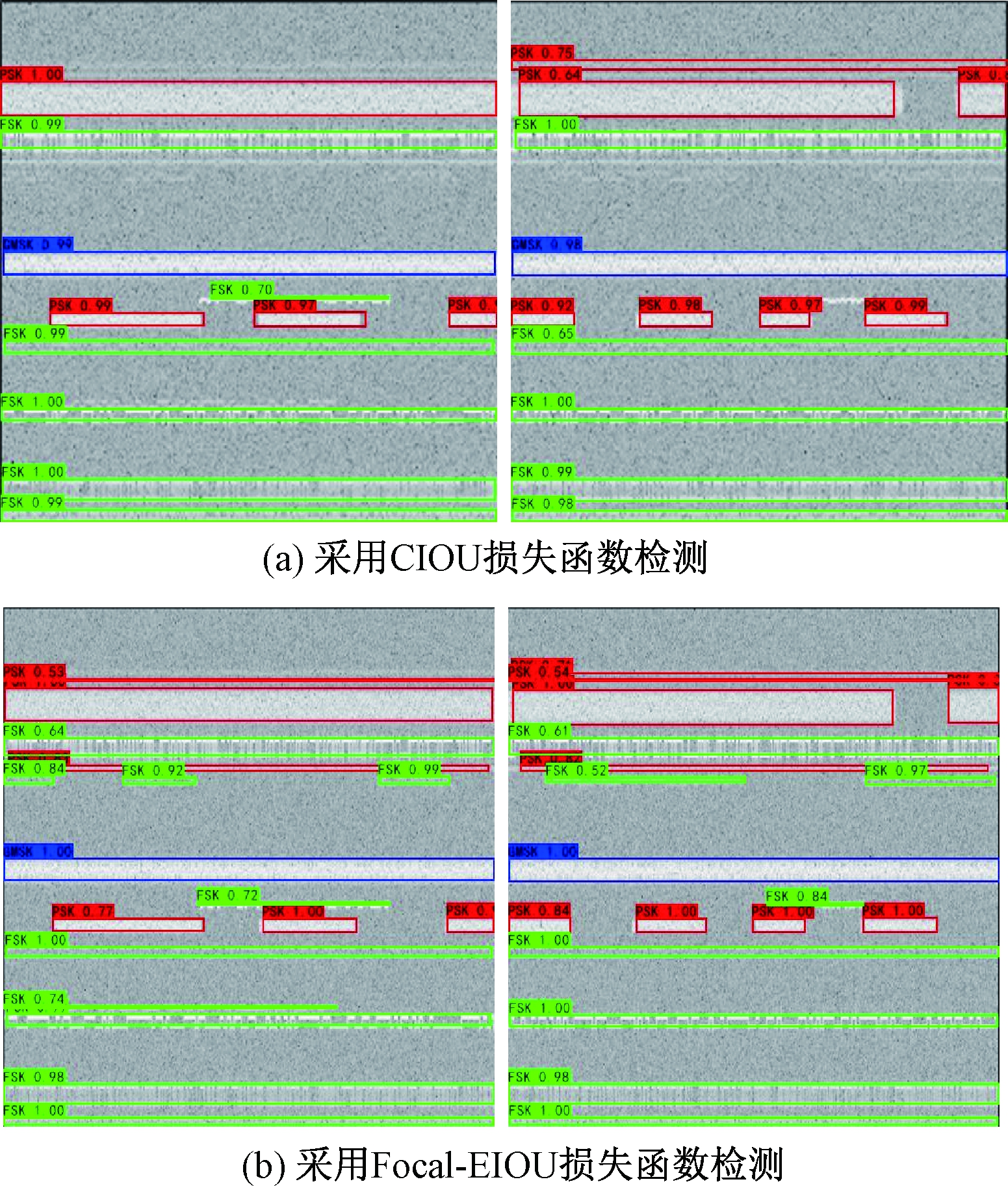

为了验证算法改进方案的有效性,设计了2组消融实验。LOSSFocal-EIOU将纵横比的损失项拆分成预测的宽、高与最小外接框宽高的差值,既加速了收敛又提高了回归精度。图8为YOLOv4-MobilenetV1训练损失曲线对比示意图,可见采用LOSSFocal-EIOU损失函数具有更快的收敛速度。图9为YOLOv4-MobilenetV1网络改进前后检测效果图。由图9可知,LOSSFocal-EIOU损失函数优化了边界框回归任务中的样本不平衡问题,特别是对低信噪比信号具有良好的检测效果。

图8 YOLOv4-MobilenetV1训练损失曲线对比示意图

Figure 8 The comparison diagram of

YOLOv4-MobilenetV1 training loss curve

图9 YOLOv4-MobilenetV1网络改进前后检测效果

Figure 9 Detection effect of YOLOv4-MobilenetV1

network before and after improvement

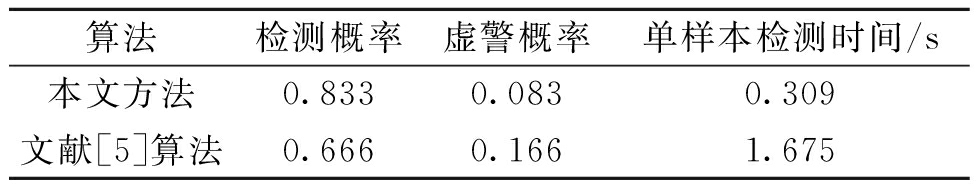

为了验证本文算法的检测性能,采用相同的测试数据对文献[5]中的能量检测方法进行测试,本文方法与文献[5]检测性能对比结果如表1所示。由表1可以看出,本文算法在检测概率以及检测速度方面均更优。

表1 本文方法与其他算法性能比较

Table 1 Performance comparison between the method

in this paper and other algorithms

算法检测概率虚警概率单样本检测时间/s本文方法0.8330.0830.309文献[5]算法0.6660.1661.675

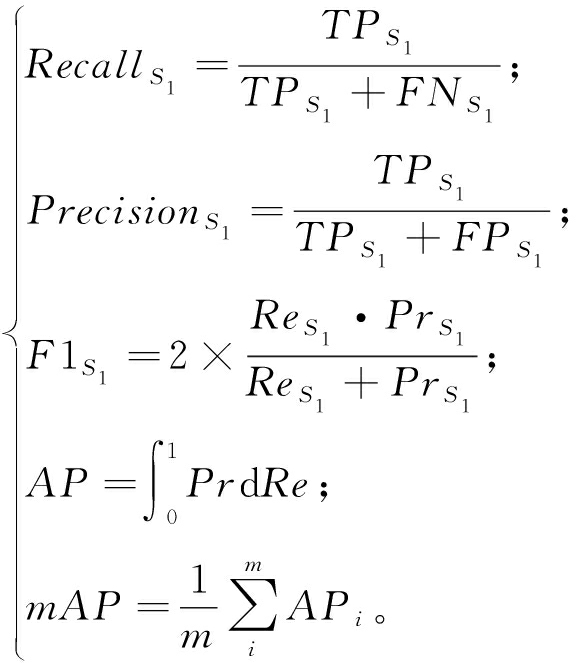

为了更好地评价算法的识别性能,采用的评价指标为召回率(Recall)、精确率(Precision)、F1值、平均精度(mAP)、帧率(FPS)。为了计算这5个指标值,首先定义以下4个标准。对于信号类别S1,有①真阳性(TPS1):类别为S1的信号被预测为S1类;②假阳性(FPS1):类别不属于S1的信号被预测为S1类;③假阴性(FNS1):类别为S1的信号被预测为Si(∀i≠1)类;④真阴性(TNS1):类别不属于S1信号被预测为Si(∀i≠1)类。

(10)

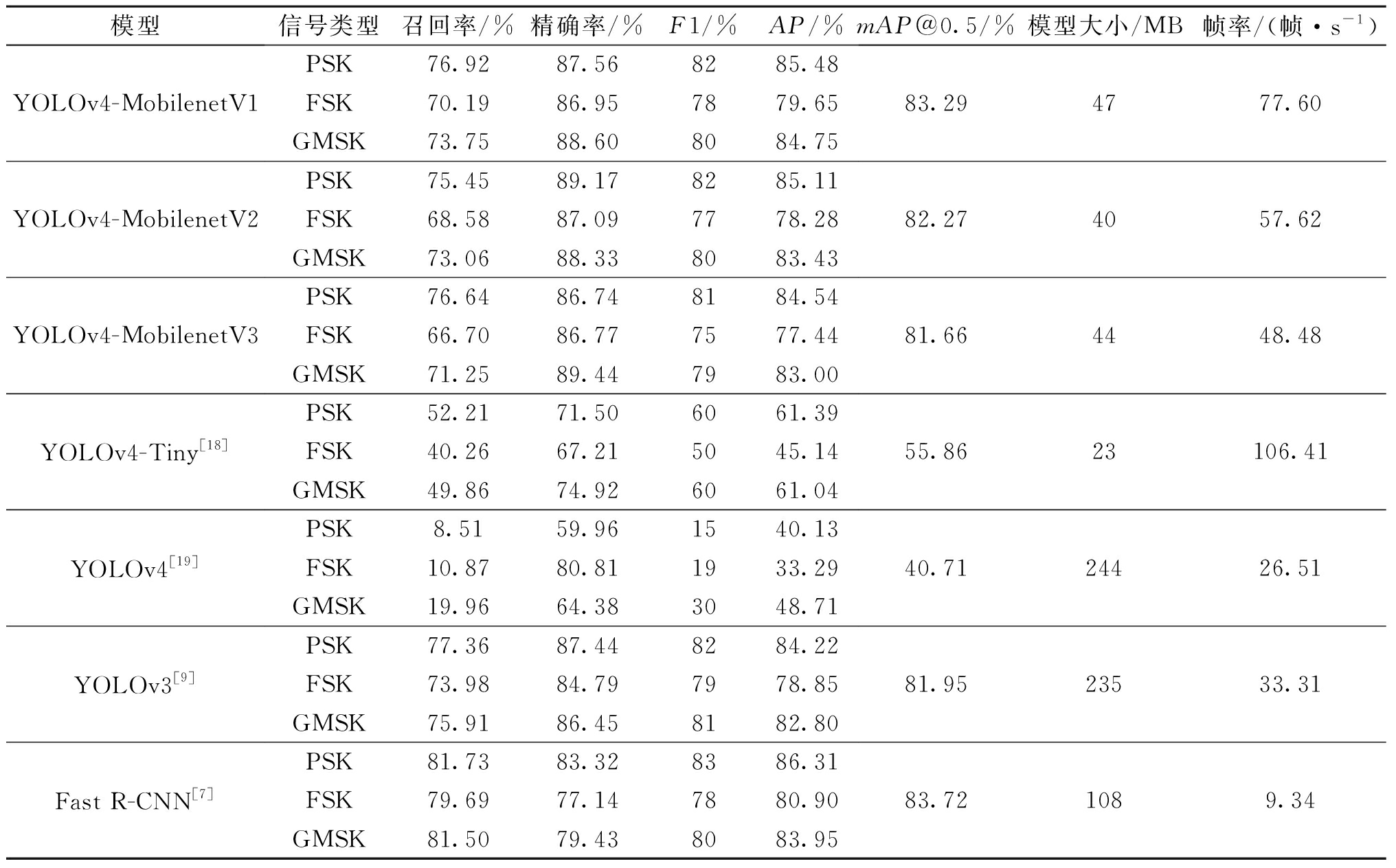

阈值为0.5时,YOLOv4-Mobilenet模型与其他网络模型性能对比结果如表2所示。在模型的准确度方面,相较于传统的YOLOv4模型,本文YOLOv4-Mobilenet模型的mAP都在81%以上,有效提升了识别精度,且YOLOv4-MobilenetV1的mAP高达83.29%。通常来讲,MobilenetV3性能最好,但是实验结果显示MobilenetV1的mAP比MobilenetV2高1.02百分点,比MobilenetV3高1.63百分点。YOLOv3和Fast R-CNN的准确率同样达到了最优,说明同种类的目标检测算法在准确度方面都能达到预期的效果。Fast R-CNN模型在整个模型对比中,模型的准确度最高,但检测速度最慢,无法达到实时检测的效果。

表2 YOLOv4-Mobilenet模型与其他网络模型性能对比

Table 2 Performance comparison of YOLOv4-Mobilenet model with other network models

模型信号类型召回率/%精确率/%F1/%AP/%mAP@0.5/%模型大小/MB帧率/(帧·s-1)YOLOv4-MobilenetV1YOLOv4-MobilenetV2YOLOv4-MobilenetV3YOLOv4-Tiny[18]YOLOv4[19]YOLOv3[9]Fast R-CNN[7]PSK76.9287.568285.48FSK70.1986.957879.65GMSK73.7588.608084.75PSK75.4589.178285.11FSK68.5887.097778.28GMSK73.0688.338083.43PSK76.6486.748184.54FSK66.7086.777577.44GMSK71.2589.447983.00PSK52.2171.506061.39FSK40.2667.215045.14GMSK49.8674.926061.04PSK8.5159.961540.13FSK10.8780.811933.29GMSK19.9664.383048.71PSK77.3687.448284.22FSK73.9884.797978.85GMSK75.9186.458182.80PSK81.7383.328386.31FSK79.6977.147880.90GMSK81.5079.438083.9583.294777.6082.274057.6281.664448.4855.8623106.4140.7124426.5181.9523533.3183.721089.34

模型的复杂度最直观的评价标准即模型大小以及检测时间。从表2中可以看出,传统的YOLOv3、YOLOv4模型大小都在200 MB以上,而YOLOv4-Mobilenet模型大小在43 MB左右,处于一个比较低的水平。本文采用对1张图片预测100次的方法来获得FPS,FPS值越大,说明模型的运算速度越快。本文提出的YOLOv4-Mobilenet模型因为继承了Mobilenet的优点,在运算速度方面也得到了大幅度的提升。YOLOv4-Tiny虽然大大减少了参数量,刷新率最高,但准确度下降过于明显。综合考虑,本文提出的YOLOv4-Mobilenet模型同时兼顾了准确度和复杂度,在网络模型部署方面更具优势,在3个YOLOv4-Mobilenet模型中,YOLOv4-MobilenetV1模型的准确度和刷新率最高,该模型的综合表现最优。

4 结论

本文提出了一种基于时频图切割的宽带信号智能检测与识别方法,实现对宽带信号的检测和参数估计。实验结果表明,该方法能够有效的检测出大带宽下的连续信号以及突发信号,同时可以准确地获得信号的调制方式、信号带宽等参数。除此之外,本文方法的平均精度(mAP)均大于81%,其中采用YOLOv4-MobilenetV1模型的检测速度达到77.60帧/s,较好地兼顾了检测精度与实时性要求,更利于工程部署。

[1] 潘宝凤. 通信侦察系统总体设计技术[J]. 电讯技术, 2011, 51(6): 1-5.

PAN B F. Overall design of communication reconnaissance system[J]. Telecommunication Engineering, 2011, 51(6): 1-5.

[2] DIAMANT R. Closed form analysis of the normalized matched filter with a test case for detection of underwater acoustic signals[J]. IEEE Access, 2016, 4: 8225-8235.

[3] GARDNER W A. Exploitation of spectral redundancy in cyclostationary signals[J]. IEEE Signal Processing Magazine, 1991, 8(2): 14-36.

[4] ZENG Y H, LIANG Y C. Spectrum-sensing algorithms for cognitive radio based on statistical covariances[J]. IEEE Transactions on Vehicular Technology, 2009, 58(4): 1804-1815.

[5] NIKONOWICZ J, JESSA M. A novel method of blind signal detection using the distribution of the bin values of the power spectrum density and the moving average[J]. Digital Signal Processing, 2017, 66: 18-28.

[6] HUANG H, LI J Q, WANG J, et al. FCN-based carrier signal detection in broadband power spectrum[J]. IEEE Access, 2020, 8: 113042-113051.

[7] PRASAD K N R S V, DSOUZA K B, BHARGAVA V K, et al. A deep learning framework for blind time-frequency localization in wideband systems[C]∥2020 IEEE 91st Vehicular Technology Conference (VTC2020-Spring). Piscataway: IEEE, 2020: 1-6.

[8] ZHA X, PENG H, QIN X, et al. A deep learning framework for signal detection and modulation classification[J]. Sensors (Basel, Switzerland), 2019, 19(18): 4042.

[9] LI R D, HU J H, LI S Q, et al. Blind detection of communication signals based on improved YOLO3[C]∥6th International Conference on Intelligent Computing and Signal Processing (ICSP). Piscataway: IEEE, 2021: 424-429.

[10] 李润东. 基于深度学习的通信信号智能盲检测与识别技术研究[D]. 成都: 电子科技大学, 2021.

LI R D. Research on intelligent blind detection and recognition of communication signals based on deep learning[D]. Chengdu: University of Electronic Science and Technology of China, 2021.

[11] 单倩文, 郑新波, 何小海, 等. 基于改进多尺度特征图的目标快速检测与识别算法[J]. 激光与光电子学进展, 2019, 56(2): 021002.

SHAN Q W, ZHENG X B, HE X H, et al. Fast object detection and recognition algorithm based on improved multi-scale feature maps[J]. Laser &Optoelectronics Progress, 2019, 56(2): 021002.

[12] 幸晨杰. 基于深度神经网络的宽带信号频谱检测方法及其后处理流程设计[J]. 电子质量, 2021(7): 126-131.

XING C J. A wideband signal spectrum detection method based on deep neural network and its post-processing workflow[J]. Electronics Quality, 2021(7): 126-131.

[13] HOWARD A G, ZHU M, CHEN B, et al. MobileNets: efficient convolutional neural networks for mobile vision applications[EB/OL].(2017-04-17)[2022-10-01].https:∥arxiv.org/pdf/1704.04861.pdf.

[14] ZHENG Z, WANG P, REN D, et al. Enhancing geometric factors in model learning and inference for object detection and instance segmentation[J]. IEEE Transactions on Cybernetics, 2022, 52(8): 8574-8586.

[15] ZHANG Y F, REN W Q, ZHANG Z, et al. Focal and efficient IOU loss for accurate bounding box regression[J]. Neurocomputing, 2022, 506: 146-157.

[16] 薛均晓, 武雪程, 王世豪, 等. 基于改进YOLOv4的自然人群口罩佩戴检测方法[J]. 郑州大学学报(工学版), 2022, 43(4): 16-22.

XUE J X, WU X C, WANG S H, et al. A method on mask wearing detection of natural population based on improved YOLOv4[J]. Journal of Zhengzhou University (Engineering Science), 2022, 43(4): 16-22.

[17] SOLOVYEV R, WANG W M, GABRUSEVA T. Weighted boxes fusion: ensembling boxes from different object detection models[J]. Image and Vision Computing, 2021, 107: 104117.

[18] WANG C Y, BOCHKOVSKIY A, LIAO H Y M. Scaled-YOLOv4: scaling cross stage partial network[C]∥2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway:IEEE, 2021: 13024-13033.

[19] BOCHKOVSKIY A, WANG C Y, LIAO H Y M. YOLOv4: optimal speed and accuracy of object detection[EB/OL].(2020-10-11)[2022-10-01]. https:∥arxiv.org/abs/2004.10934.