0 引言

随着智能科学技术与社会的共同发展,人工智能技术在安防监控中的应用场景越来越多。2021年全世界有上百家安防设备厂商,然而绝大部分的设备是以可见光成像为主[1],在夜间和恶劣天气下的成像效果差。红外成像技术[2]应用于特定场景诸如夜间及恶劣气候等也能获得较好的图像质量,能突出展现红外人、车等敏感目标[3]。然而当前国内外对于红外目标检测的研究较少,大部分以传统的方法为主,在检测效果和速度上不能满足实际应用需求。

针对红外目标检测,传统的研究算法大都是基于对比度的方法[4]。基于对比度的算法是根据红外图像中目标与背景之间的对比度差异而设计出的算法。Kim等[5]提出了一种基于对比机制的算法。Shao等[6]利用文献[5]的方法来增加图像的对比度,然后用形态学滤波进一步消除了残留噪声。Chen等[7]提出了两阶段的局部对比度测量算法(LCM)来测量目标位置与其领域之间的差异,并通过自适应阈值对目标进行分割。这些基于对比度的检测算法受限于人工设计的参数[8],适用于特定场景,无法满足场景多样化需求。

由于深度学习的快速发展,出现了很多基于深度学习的目标检测算法[9]。Du等[10]使用卷积神经网络对红外图像特征进行提取,然后使用支持向量机(SVM)[11]完成目标的分类以实现红外目标检测。汪慎文等[12]提出了两阶段搜索的多模态多目标差分进化算法。深度学习的方法弥补了传统红外目标检测中人工设计复杂、特征提取不足和场景迁移能力差的缺陷[13],更具有自适应性和准确性。

为了实现目标检测网络模型在硬件平台上的准确性与实时性,本文以YOLOv5为网络框架,提出了一种基于特征蒸馏的改进Ghost-YOLOv5红外目标检测算法。该方法包含以下几个创新点:①针对YOLOv5模型参数量大的问题,提出了利用GhostNet的模型剪枝方法;②为了提高模型准确率,在红外数据集中使用Mosaic数据增强和Copy-paste数据增强方法,在模型中使用特征蒸馏的方法;③本文创建了一个红外目标检测数据集。

1 Ghost-YOLOv5检测网络结构

在本节中,主要介绍Ghost-YOLOv5基本网络模型结构,并分析其中各个模块的作用。

1.1 Ghost-YOLOv5模型框架简介

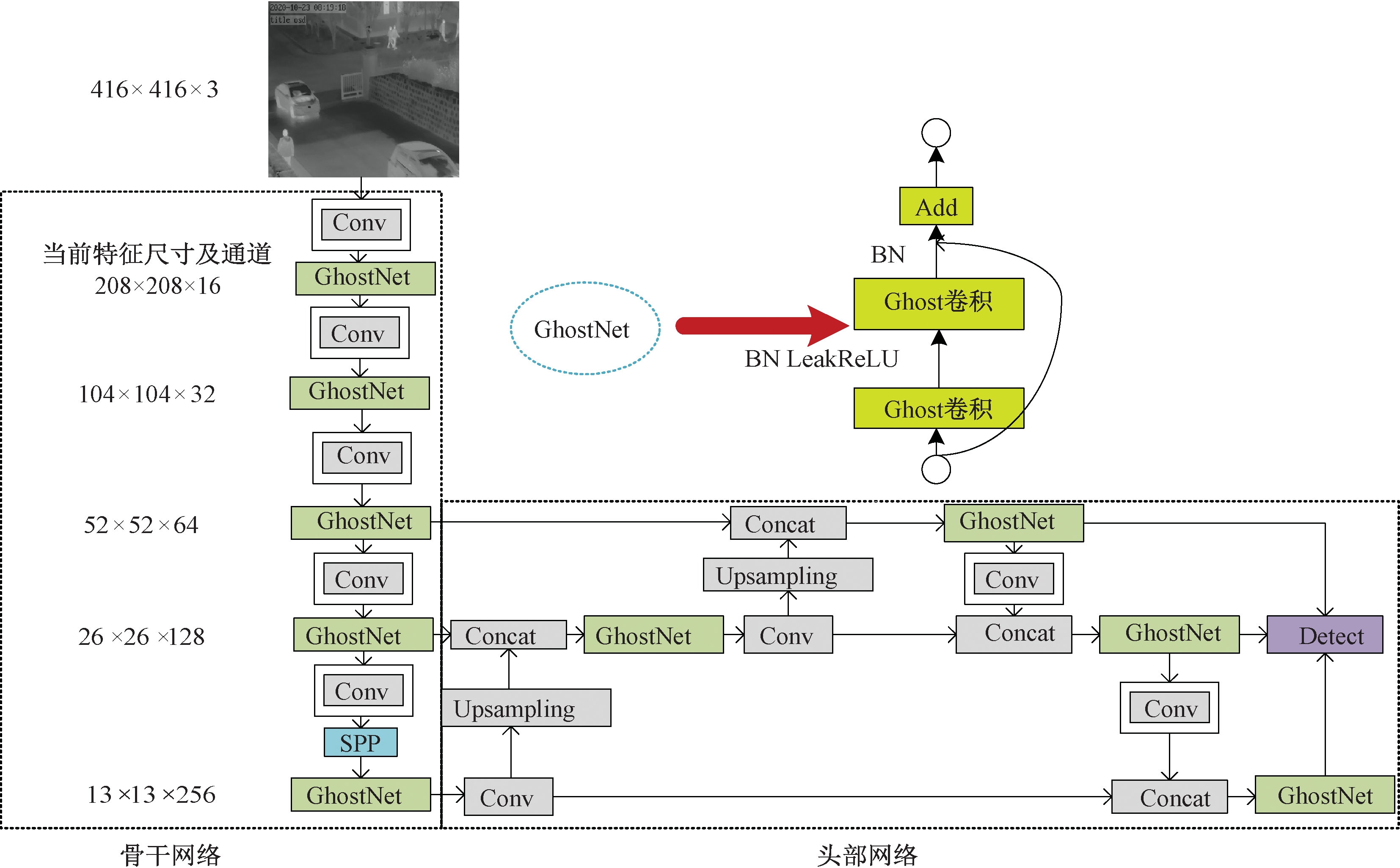

Ghost-YOLOv5的整个网络分为骨干(Backbone)和头部(Head)两个部分,如图1所示。模型的骨干网络为GhostNet结构、Conv卷积结构和SPP[14]结构的组合;头部网络是由FPN[15]结构和PAN[16]结构所组成。

图1 Ghost-YOLOv5网络结构

Figure 1 Architecture diagram of Ghost-YOLOv5

1.2 GhostNet模块

在红外目标的检测任务中,产生的特征图中都是灰度信息,不像可见光检测那样有着明显的色域区分度[17],这就造成了大量重复的特征图的产生。这些冗余的特征图对于红外检测效果提升程度有限,而且增大了模型的参数量。

这些冗余特征图大多是由常规卷积所产生,针对红外图像独有的特性,本文中采用了GhostNet模块去减少模型的参数和计算量。

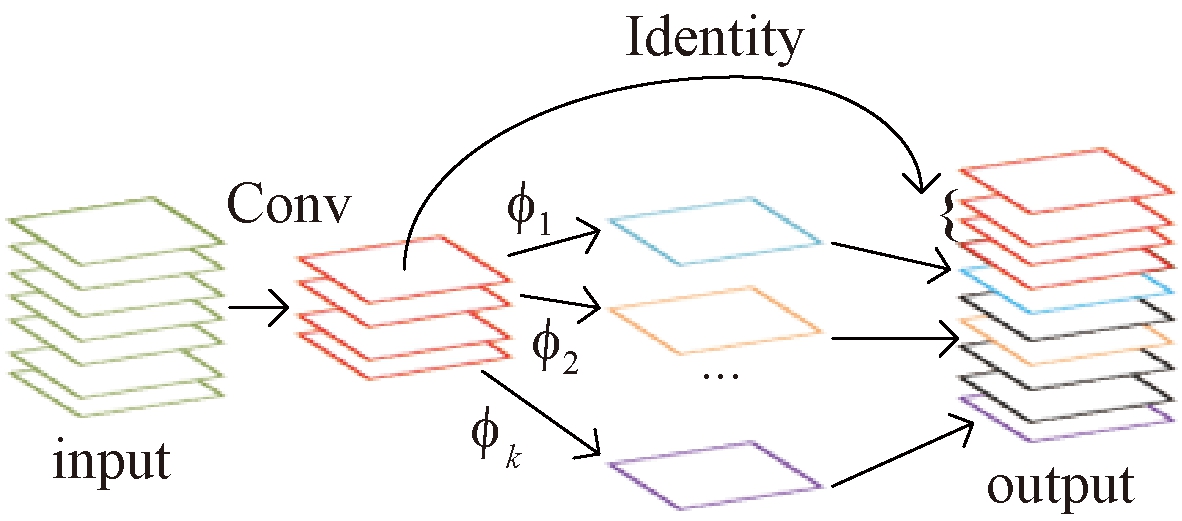

GhostNet模块的组成部分是Ghost卷积[18],首先利用较少的计算量通过常规卷积生成数量较少的特征图,然后通过线性操作再进一步利用较少的特征图,生成新的相似特征图,最后将两组特征图中的信息进行组合,作为全部特征信息,如图2所示。Ghost卷积分为常规卷积、Ghost生成和特征图拼接共3步。

图2 Ghost卷积过程示意图

Figure 2 Ghost reeling process diagram

(1)首先,假设输入特征图的尺寸是H×W×c,输出特征图的尺寸是H′×W′×n,卷积核大小为k×k。用常规卷积得到本征特征图YH′×W′×m,这部分的计算量约等于H×W×c×m×W′×H′(忽略偏置项)。

(2)然后,将本征特征图YH′×W′×m中每一个通道的特征图用φi操作来产生Ghost特征图。在线性变换(φi)中,假设特征图的通道数为m,变换的数量为s,最终得到的新的特征图的数量为n,那么可以得到等式:

n=m·s。

(1)

由于Ghost模块的变换过程中最后存在一个恒等变换(Identity),所以实际有效的变换数量是(s-1),根据式(1)可以得到:

(2)

(3)最后,将第1步得到的本征特征图和第2步得到的Ghost 特征图拼接(Identity 连接)得到最终结果。

综合上述考虑,当输出特征图的通道数量远大于本征特征图的通道数时(即n≫m),可以计算得到普通卷积模块与Ghost模块的计算量比值为

rs≈s。

(3)

相比于直接用常规卷积,Ghost卷积的计算量大幅度降低,仅用简单线性变换就能产生大部分的特征信息。利用Ghost卷积这些特征,本文设计了GhostNet模块作为骨干网络中的卷积层,使整体网络结构在保持适度深度的同时具备多尺度检测的能力,让模型更适合红外图像的目标检测。

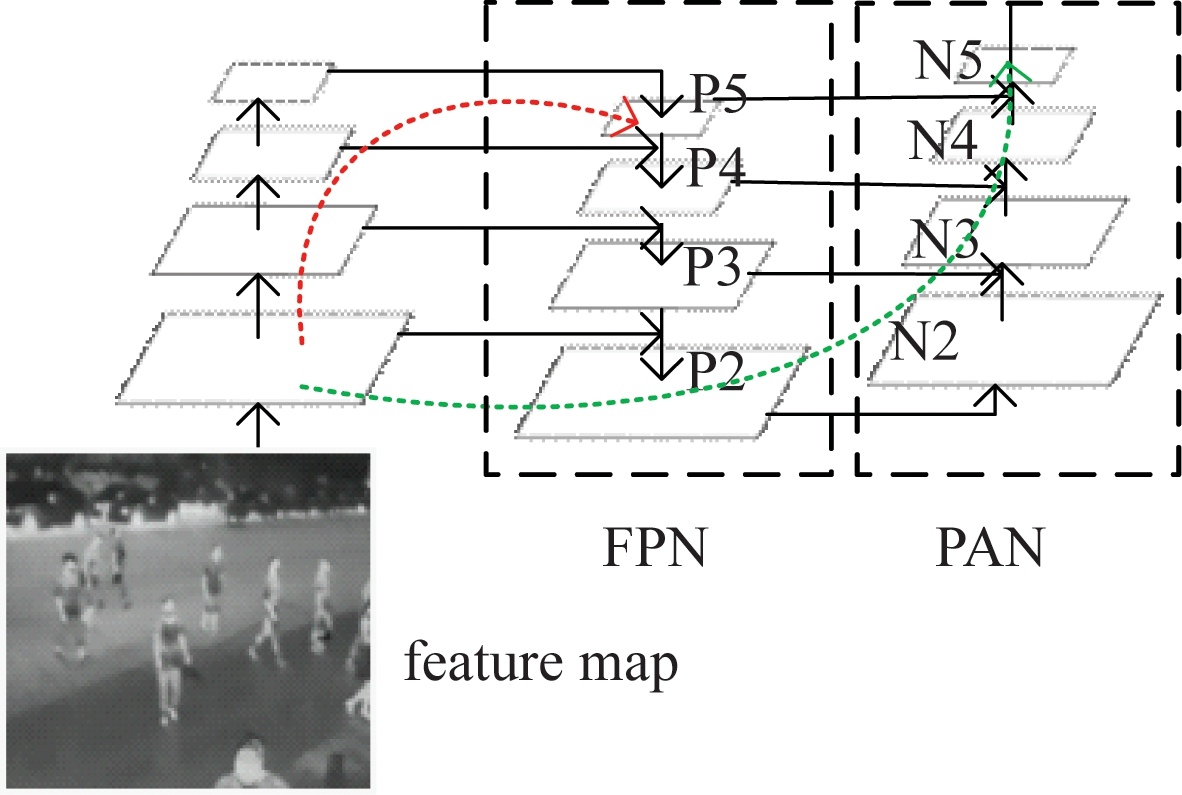

Backbone中的SPP结构在不同尺度上将特征图划分成不同的空间区域,然后在每个区域上计算特征向量,最后将计算得到的所有特征组合起来。SPP结构的优点在于增大特征提取的感受野,获取最重要的上下文特征,并且不会导致操作速度减小。Ghost-YOLOv5模型的头部网络由FPN结构和PAN结构组成,如图3所示。

图3 FPN与PAN结构

Figure 3 Architecture diagram of FPN and PAN

FPN结构自顶向下传达强语义特征,而PAN结构则自底向上传达强定位特征,极大地丰富了特征的表征内容,提升了检测的性能。

2 模型精度提升策略

使用GhostNet模块降低了模型的参数和计算量,为了提升Ghost-YOLOv5模型的检测精度,本文使用了特征蒸馏和数据增强的方法。

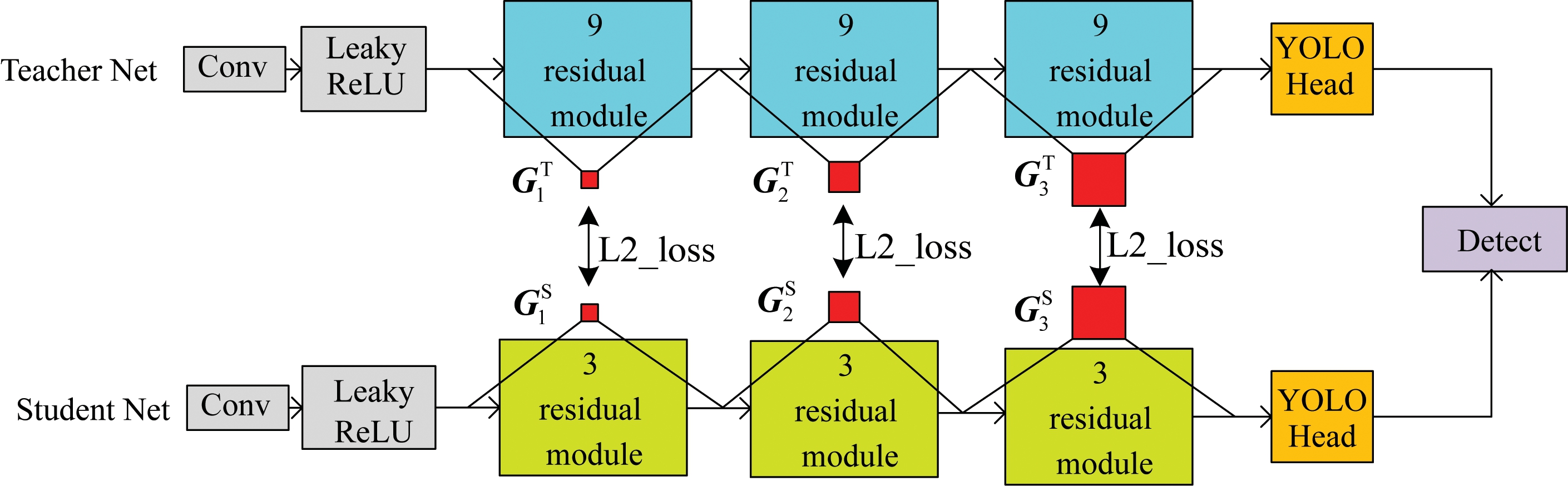

2.1 特征蒸馏

在本文中,使用了基于FSP矩阵[19]的特征蒸馏方法,该方法利用FSP矩阵去表征小模型和大模型不同层间的数据关联,然后使用L2_loss拟合小模型对应层的FSP矩阵和大模型对应层的FSP矩阵,如图4所示。本文中将Scaled-YOLOv4[20]这个大模型作为教师模型(Teacher Net),将Ghost-YOLOv5模型作为学生模型(Student Net),然后构建大小模型中对应层的FSP矩阵(GT/GS)。此方法的优势在于让小模型学习解决问题的中间过程和方法,从而让其学到更多的知识。经过特征蒸馏之后Ghost-YOLOv5模型的准确率相较于蒸馏之前提升了超过3百分点,为了进一步增加模型的精度,本文使用了Mosaic和Copy-paste数据增强方法去增强红外数据集。

图4 基于FSP蒸馏方法示意图

Figure 4 Schematic diagram of FSP-based distillation method

2.2 数据增强

数据增强有两方面好处:一方面可以提高模型的泛化能力;另一方面不改变模型结构。本文使用了Mosaic和Copy-paste的数据增强方式用于红外目标检测数据集。

2.2.1 Mosaic数据增强

Mosaic数据增强的思想是使用4张图片经过随机裁剪、随机拼接组合在一起,如图5所示。Mosaic的好处有以下两点:一是利用随机裁剪丰富了数据集中目标局部特征,便于模型学习;二是利用随机拼接保留了图像所有目标特征,没有将裁剪完的特征丢弃,使用拼接方式充分地利用图像的所有特征。

图5 Mosaic数据增强示意图

Figure 5 Mosaic data enhancement schematic

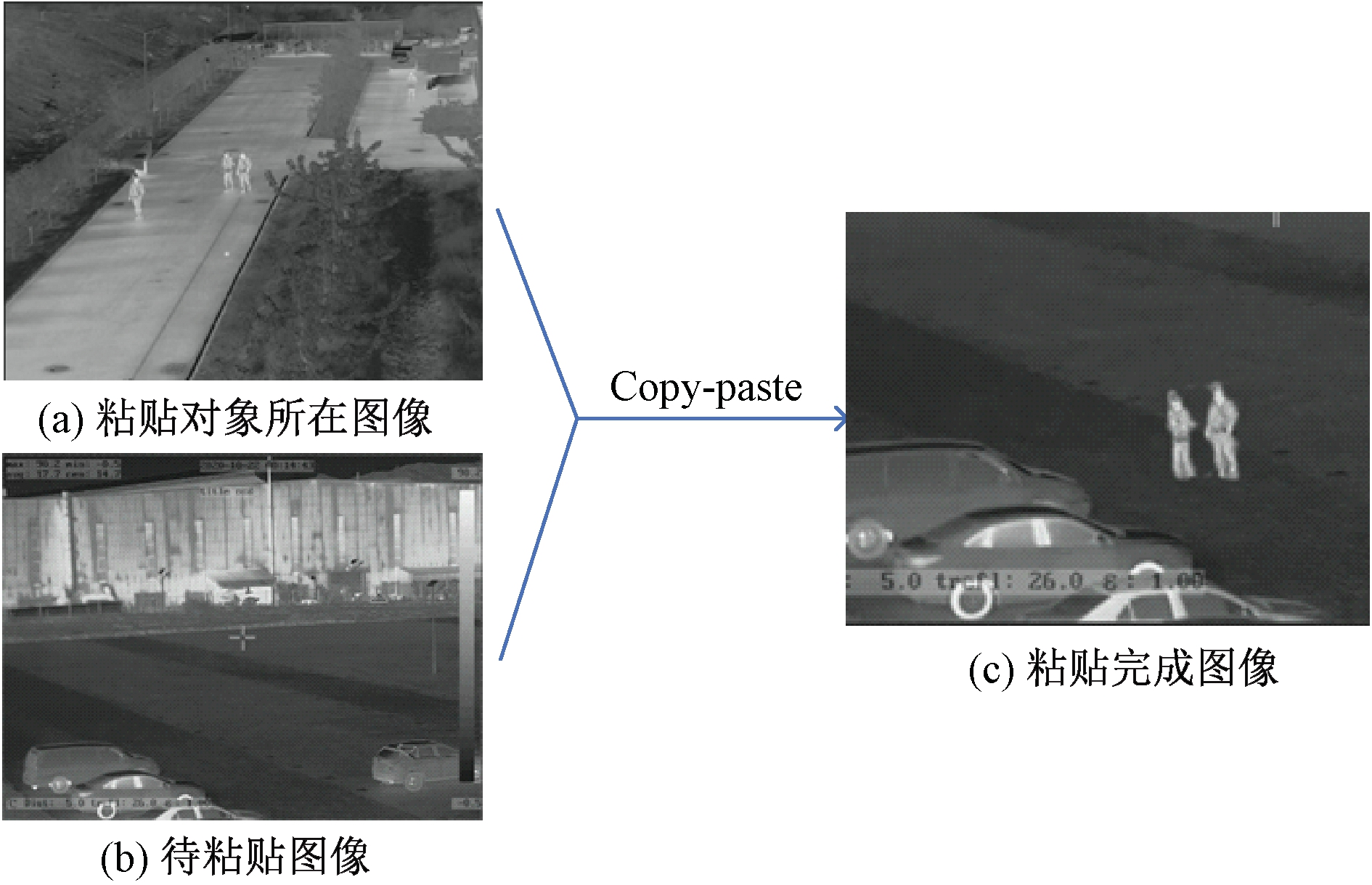

2.2.2 Copy-paste数据增强

Copy-paste 数据增强的核心是混合粘贴与目标大尺度缩放,这种数据增强方法的流程如图6所示。混合粘贴是指利用公式I1α+I2(1-α)将两幅图像的内容混合在一起。其中,I1为粘贴对象所在的图像,I2为主图像,α为掩膜,即目标所在位置的像素。整个过程是将I1中目标部分的像素抠出来,然后粘贴到I2中,这个过程有以下几种随机性:①选择用于粘贴的源图和目标图的随机性;②选择粘贴源图中目标对象的随机性;③选择粘贴到目标图像位置的随机性。目标大尺度缩放是在提取目标掩膜的基础上对整个目标进行大尺度的缩放,本文中使用的尺度变化为0.1~2.0[21]。Copy-paste这种数据增强方法也有着以下两点好处:一是使数据分布更加随机化,便于模型学习所有数据的一般性特征,提高模型的泛化能力;二是通过大尺度缩放的方法突出了红外目标的特征,提高模型对小目标的检测能力。

图6 Copy-paste数据增强示意图

Figure 6 Copy-paste data enhancement schematic

3 红外安防数据集介绍

在安防领域中,通过红外镜头对周边环境进行监测,是实现24 h全面监控的重要手段。然而现有的安防数据库大都是可见光数据库,难以满足夜间和恶劣天气下安防需求。针对这一问题,本文创建了一个新的红外安防人车目标识别数据库,该数据库通过在不同时间段内采用红外成像摄像头对着路口进行拍摄,获得了大量监控俯视角度的真实安防场景下的红外图像数据,其中摄像头的布置高度均高于地面5 m,与真实的安防场景中的仪器布设角度基本一致。在不同的视角高度本文使用了不同的设备采集了3种不同分辨率(384×288、640×512、704×576)红外图像,然后标注了图像中出现的人、机动车及非机动车3类目标。该数据库将其主要用于真实世界红外安防领域的目标检测识别技术研究,使得红外目标识别技术能够进一步发展,从而推动红外技术在各行业领域的应用与发展。

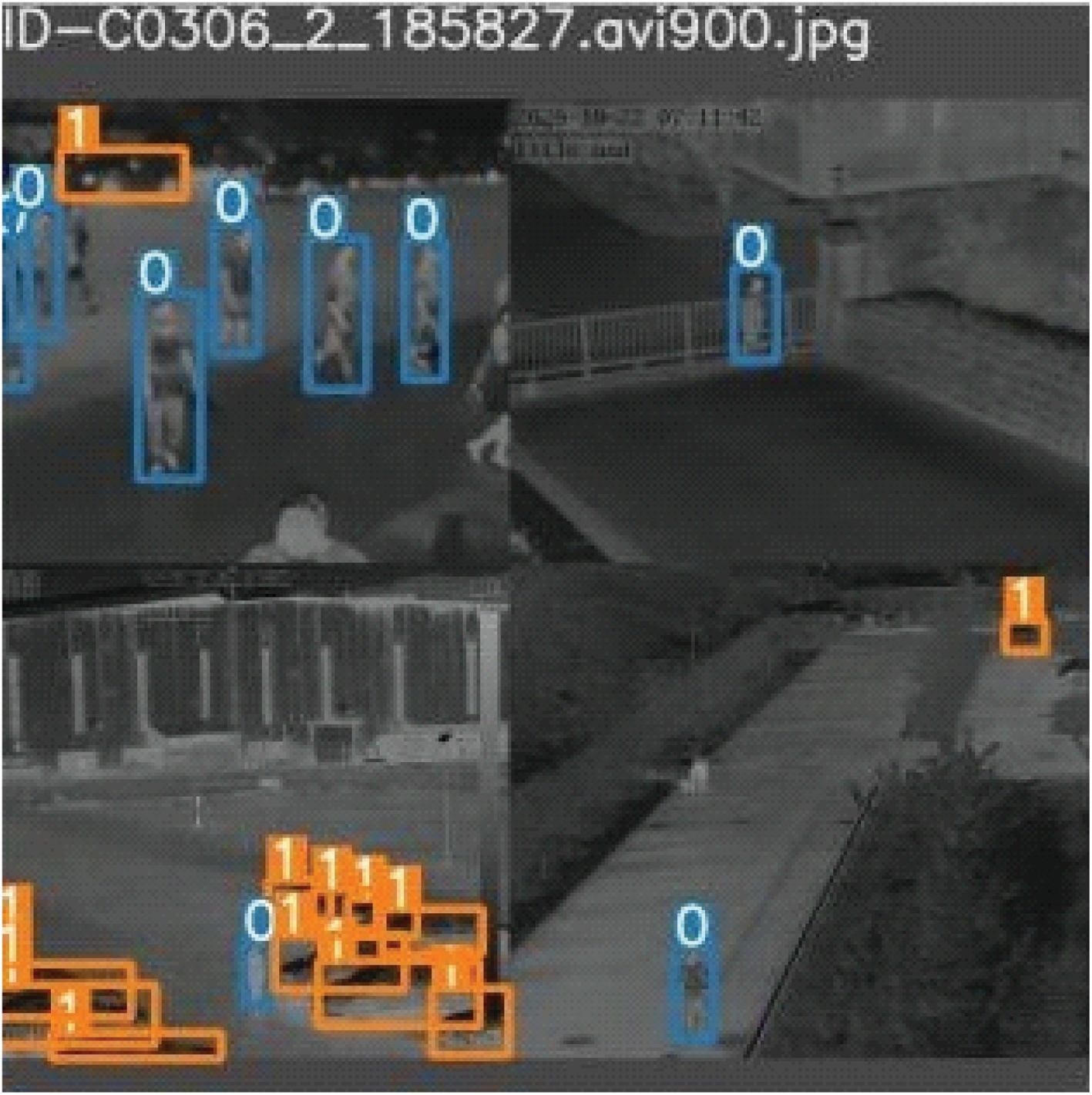

数据库使用person、vehicle、NonMotorVehicle分别作为人、机动车和非机动车的标签,使用矩形框对其中的目标进行标注,以图片的左上角为坐标原点(0,0),使用x1,y1,x2,y2的形式记录矩形框的位置,x1表示矩形框的左上角横坐标,y1表示矩形框的左上角纵坐标,x2表示矩形框的右下角横坐标,y2表示矩形框的右下角纵坐标。所有标签信息以xml文件的形式进行保存,标注样例如图7所示。

图7 红外安防数据集标注样例

Figure 7 Annotation examples of infrared security data set

4 实验与结果

在本节中,设计了一系列实验以评估本文提出的基于特征蒸馏的改进Ghost-YOLOv5红外目标检测算法的检测性能。

4.1 数据集准备与实验平台介绍

本实验中使用的数据集是艾睿光电科技有限公司提供的室外场景红外目标数据集。该数据集总共包含8 999张图像,10多种不同的场景和5万多个目标,可用于人、机动车、非机动车识别。

4.2 实验设置

所有的红外数据集按照场景同分布原则将80%的数据集划分为训练集,将10%的数据集作为验证集,剩下的10%作为测试集。

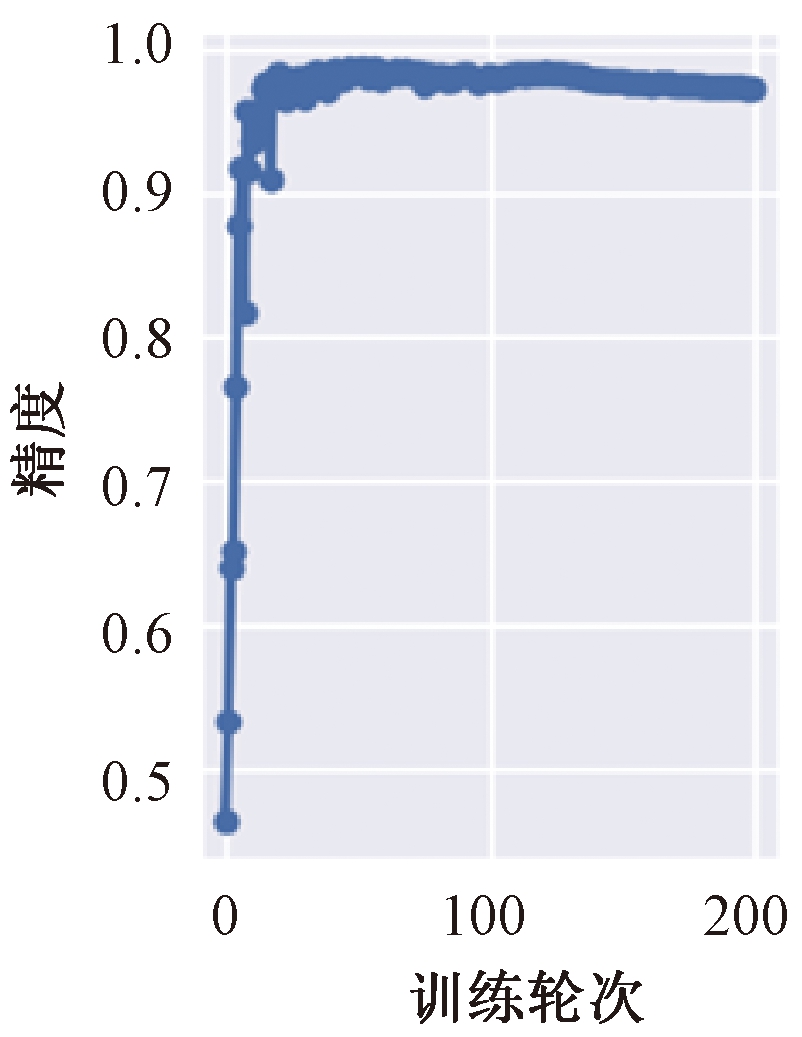

设置的超参数如下:总训练轮次为200轮,采用随机梯度下降[15]策略,初始学习率设置为0.01,动量和权重衰减分别设置为0.937和0.000 5。使用批量大小为32的单GPU执行多尺度训练。模型训练指标变化曲线如图8所示。

图8 模型训练指标变化曲线

Figure 8 Model training indicator change curve

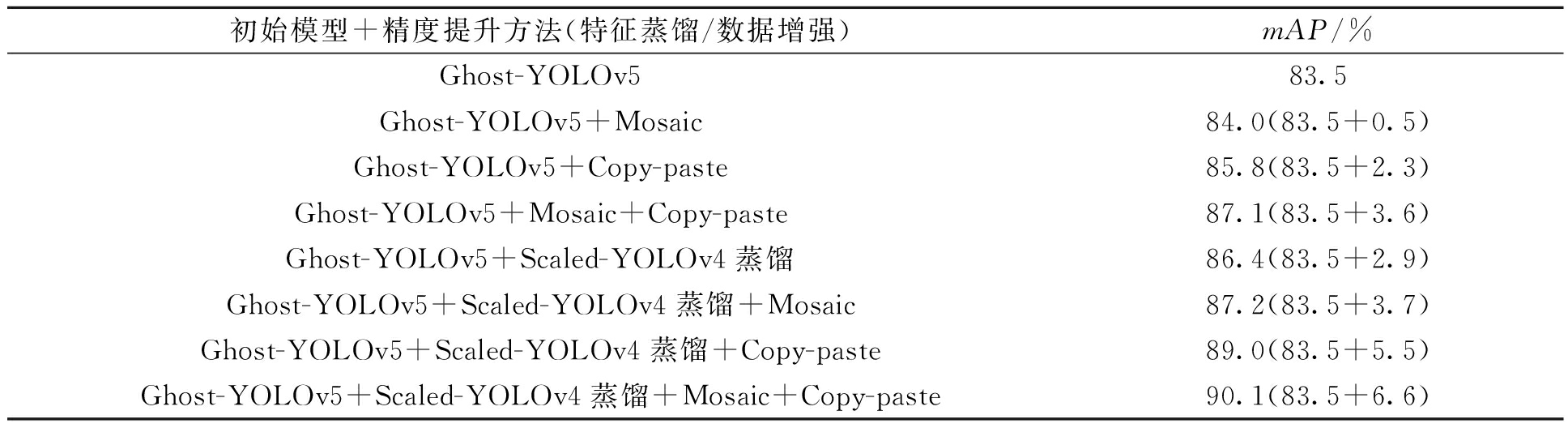

本文测试了特征蒸馏和两种数据增强方式的检测精度,得到的实验结果如表1所示。通过表1可以得出Mosaic和Copy-paste数据增强方法对训练数据调整的方式能够提高模型的检测精度,而特征蒸馏的方法能够通过让小模型学习大模型检测结果的方式来提升模型的精度。

表1 不同模型精度提升方法对比

Table 1 Comparison of different model accuracy improvement methods

初始模型+精度提升方法(特征蒸馏/数据增强)mAP/%Ghost-YOLOv583.5Ghost-YOLOv5+Mosaic84.0(83.5+0.5)Ghost-YOLOv5+Copy-paste85.8(83.5+2.3)Ghost-YOLOv5+Mosaic+Copy-paste87.1(83.5+3.6)Ghost-YOLOv5+Scaled-YOLOv4蒸馏86.4(83.5+2.9)Ghost-YOLOv5+Scaled-YOLOv4蒸馏+Mosaic87.2(83.5+3.7)Ghost-YOLOv5+Scaled-YOLOv4蒸馏+Copy-paste89.0(83.5+5.5)Ghost-YOLOv5+Scaled-YOLOv4蒸馏+Mosaic+Copy-paste90.1(83.5+6.6)

4.3 嵌入式平台实验

本文使用Hi3519AV100芯片中的SVP(smart vision platform)海思媒体处理芯片智能视觉异构加速平台完成模型推理过程。该平台包含了CPU、DSP、NNIE(neural network inference engine)等多个硬件处理单元和运行在这些硬件上的SDK开发环境,以及配套的工具链开发环境。

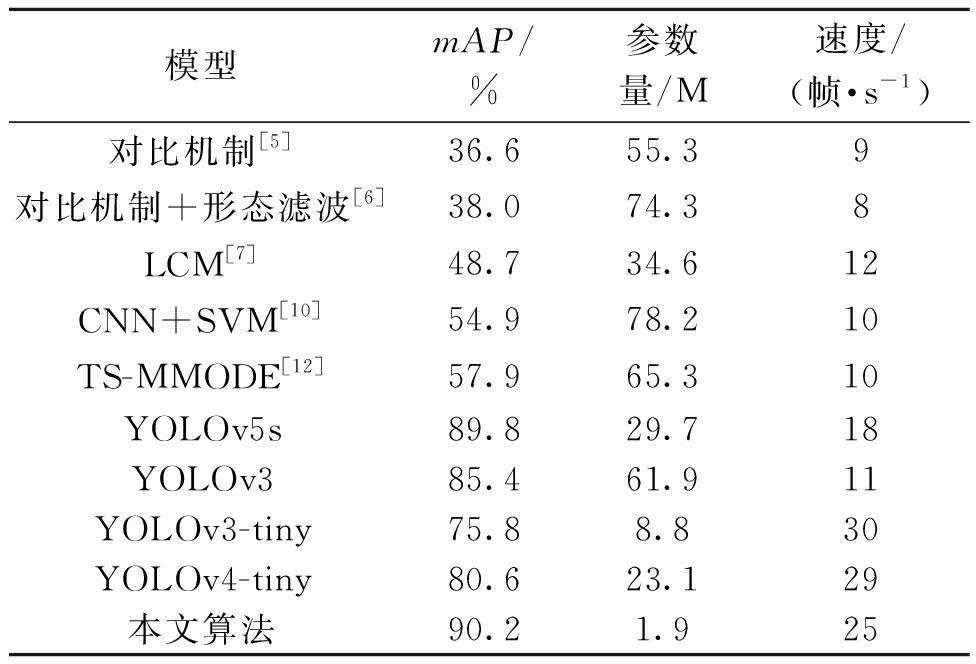

为了验证本文中所设计的模型在该平台中的有效性,选取了多种可移植进该平台的常用模型作为对比。实验使用4.1节中的数据集,并采用相同的分布方式,得到的模型性能指标如表2所示。

表2 海思平台中模型性能指标

Table 2 Model performance metrics in Hisi platform

模型mAP/%参数量/M速度/(帧·s-1)对比机制[5]36.655.39对比机制+形态滤波[6]38.074.38LCM[7]48.734.612CNN+SVM[10]54.978.210TS-MMODE[12]57.965.310YOLOv5s89.829.718YOLOv385.461.911YOLOv3-tiny75.88.830YOLOv4-tiny80.623.129本文算法90.21.925

实验说明本文模型的检测精度在嵌入式平台中要高于传统算法及YOLOv5s、YOLOv3、YOLOv3-tiny、YOLOv4-tiny这些深度学习算法,而且本文模型的推理速度在这些常用模型中也处于较快水平。

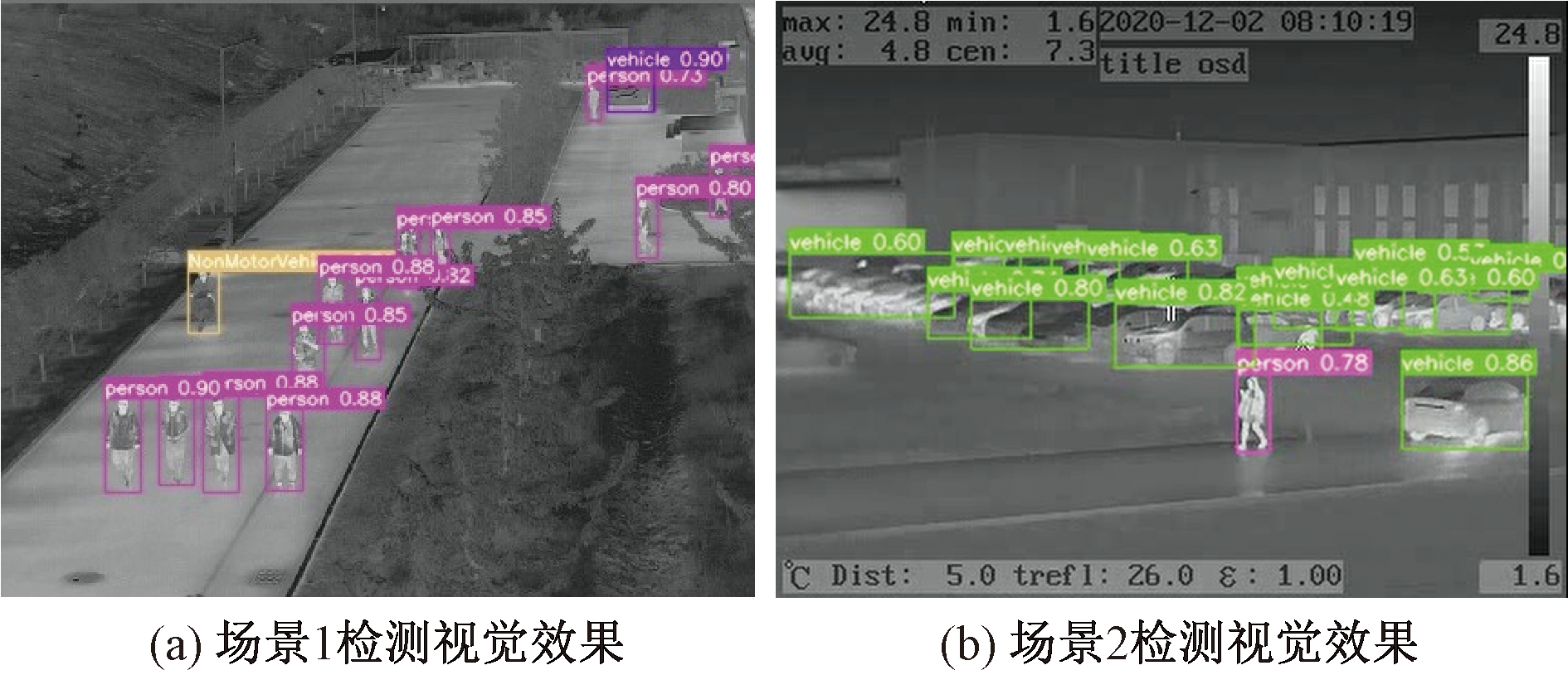

对于工程应用来说,目标检测模型的泛化性能也非常重要,本文另外选取了数据集中不同红外场景中的图像进行了检测,检测的视觉效果如图9所示。

图9 模型检测视觉效果

Figure 9 Model detects visual effects

5 结论

本文提出了基于特征蒸馏的改进Ghost-YOLOv5红外目标检测算法。该算法首先利用GhostNet模块做模型剪枝,降低了模型计算量和参数量;其次使用特征蒸馏方法以及Mosaic和Copy-paste两种数据增强方法提高压缩后模型的检测精度。本文还构建了一个包含多种真实场景下人、机动车和非机动车目标的数据集。在上述数据集上测试实验结果表明:本文提出的算法利用Ghost模块得到的模型参数量仅1.9 M,并通过特征蒸馏和数据增强的方法,使得小模型在红外数据集上的精度提升了6.6%,总体mAP达到了90.1%。在海思平台上实测,模型的检测速度能达到25帧,平均检测精度能达到90.2%,与多种可移植于该平台的常用模型相比,均取得了更高的检测精度。本算法是基于海思硬件平台的模型算法设计,如何根据硬件资源去修改模型这点还有所不足,在未来的研究工作中,需要充分利用海思平台的硬件资源去完善本文算法。

[1] 张敏, 韩芳, 康键,等.红外热成像技术在民用领域的应用[J].红外, 2019, 40(6):37-45.

[2] 陈华,周晓巍.红外热成像技术在通信电源电路板故障检测中的应用[J].通信电源技术,2021,38(1):114-116.

[3] 王洪琳,郑睿.激光雷达在轨道列车自动驾驶系统中的应用研究[J].江苏科技信息,2021,38(31):42-44,55.

[4] 蔡军,黄袁园,李鹏泽,等.基于视觉对比度机制的红外弱小目标检测算法[J].系统工程与电子技术,2019,41(11):2416-2423.

[5] KIM S,YANG Y,LEE J,et al.Small target detection utilizing robust methods of the human visual system for IRST[J].Journal of infrared, millimeter and terahertz waves,2009,30(9):994-1011.

[6] SHAO X P,FAN H,LU G X,et al.An improved infrared dim and small target detection algorithm based on the contrast mechanism of human visual system[J].Infrared physics & technology,2012,55(5):403-408.

[7] CHEN C L P,LI H,WEI Y T,et al.A local contrast method for small infrared target detection[J].IEEE transactions on geoscience and remote sensing,2014,52(1):574-581.

[8] 张震,李浩方,李孟洲,等.改进YOLOv3算法与人体信息数据融合的视频监控检测方法[J].郑州大学学报(工学版),2021,42(1):28-34.

[9] 崔娟.红外偏振成像技术在船舶目标探测中的应用[J].舰船科学技术,2020,42(18):82-84.

[10] DU L,GAO C Q,FENG Q,et al.Small UAV detection in videos from a single moving camera[C]//Communications in Computer and Information Science. Cham:Springer, 2017:187-197.

[11] CHEN P H,LIN C J,SCHÖLKOPF B.A tutorial on ν-support vector machines[J].Applied stochastic models in business and industry,2005,21(2):111-136.

[12] 汪慎文,张佳星,褚晓凯,等.两阶段搜索的多模态多目标差分进化算法[J].郑州大学学报(工学版),2021,42(1):9-14,110.

[13] 周贵华,许丽娟,周伟昌.基于深度学习的红外序列图像小目标检测方法研究[J].激光杂志,2020,41(12):61-64.

[14] HE K,ZHANG X,REN S,et al.Spatial pyramid pooling in deep convolutional networks for visual recognition[J].IEEE transactions on pattern analysis and machine intelligence,2015,37(9):1904-1916.

[15] LIN T Y,DOLLAR P,GIRSHICK R,et al.Feature py-ramid networks for object detection[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Piscataway:IEEE,2017:2117-2125.

[16] LIU S,QI L,QIN H F,et al.Path aggregation network for instance segmentation[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE,2018:8759-8768.

[17] 陈寂驰,魏国华,郭聪隆,等.一种基于红外图像序列的深度学习三维重建仿真方法初探[J].空天防御,2020,3(4):21-29.

[18] HAN K,WANG Y H,TIAN Q,et al.GhostNet:more features from cheap operations[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway:IEEE,2020:1580-1589.

[19] YIM J,JOO D,BAE J,et al.A gift from knowledge distillation:fast optimization,network minimization and transfer learning[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Pisca-taway:IEEE,2017:4133-4141.

[20] WANG C Y,BOCHKOVSKIY A,LIAO H Y M.Scaled-YOLOv4:scaling cross stage partial network[EB/OL]. (2020-11-16)[2021-05-06]. https://arxiv.org/abs/2011.08036.

[21] RUDER S.An overview of gradient descent optimization algorithms[EB/OL]. (2016-09-15)[2021-05-06]. https://arxiv.org/abs/1609.04747.