0 引言

塑料制品为人类的生活提供便利的同时也带来了环境污染的问题。塑料垃圾在物理和化学的作用下降解为微小的塑料,直径小于5 mm的塑料颗粒和纤维被称为微塑料[1]。微塑料在水体中具有尺寸小、比面积大和疏水性强等特点,更容易成为疏水性有机污染物和重金属的载体[2]。在水体环境中,微塑料可以持续成百上千年[3],其表面附着了许多细小微生物,微生物以塑料表面的疏水性物质为食,以微塑料为载体在生态系统中迁移,甚至会进入到食物链被人误食[4]。微塑料污染问题已经成为全球重大环境问题之一,引起了各国政府、学者和公众的关注[5]。

微塑料根据形态特征可以分为5种类型:碎片、薄膜、纤维、泡沫塑料和微珠[6]。微纤维是微塑料的主要类型且在水体环境中长久存在、降解率低,因此,越来越多的学者加大了对微纤维识别的研究。目前,大多数学者使用光学显微镜和电子扫描显微镜识别微纤维。普通光学显微镜很难分析鉴定粒径小于100 μm的微纤维[7];电子扫描显微镜要求样品必须是固体,且无毒、无放射性、无污染、无磁、无水分、成分稳定、大小适中[8],且仪器价格昂贵,耗时耗力,限制了一定时间内可处理的样本数量[9]。

随着人工智能的发展,图像识别技术也被广泛应用。 Yurtsever等[10]使用GoogLeNet模型对废水中形态为微珠的微塑料进行识别,识别准确率达到89%;Pazdernik等[11]采用深度卷积神经网络对LiAlO2颗粒进行分割识别,实验表明,U-Net对空隙的分割识别精度最高,SegNet对晶粒边界和杂质的分割识别精度最高。微纤维识别算法通常需要部署在嵌入式或移动设备中,上述算法的识别模型偏大,部署困难,限制了其实用价值。针对微纤维识别难度大的问题,本文构建了一种MobileNetV2网络的改进模型,通过重构微纤维深度卷积特征,重新分配通道特征的权值,并利用不同尺度的下采样器获取更多的微纤维特征进行融合,从而实现微纤维识别效果的提升。

1 微纤维图像识别模型

1.1 模型总体框架

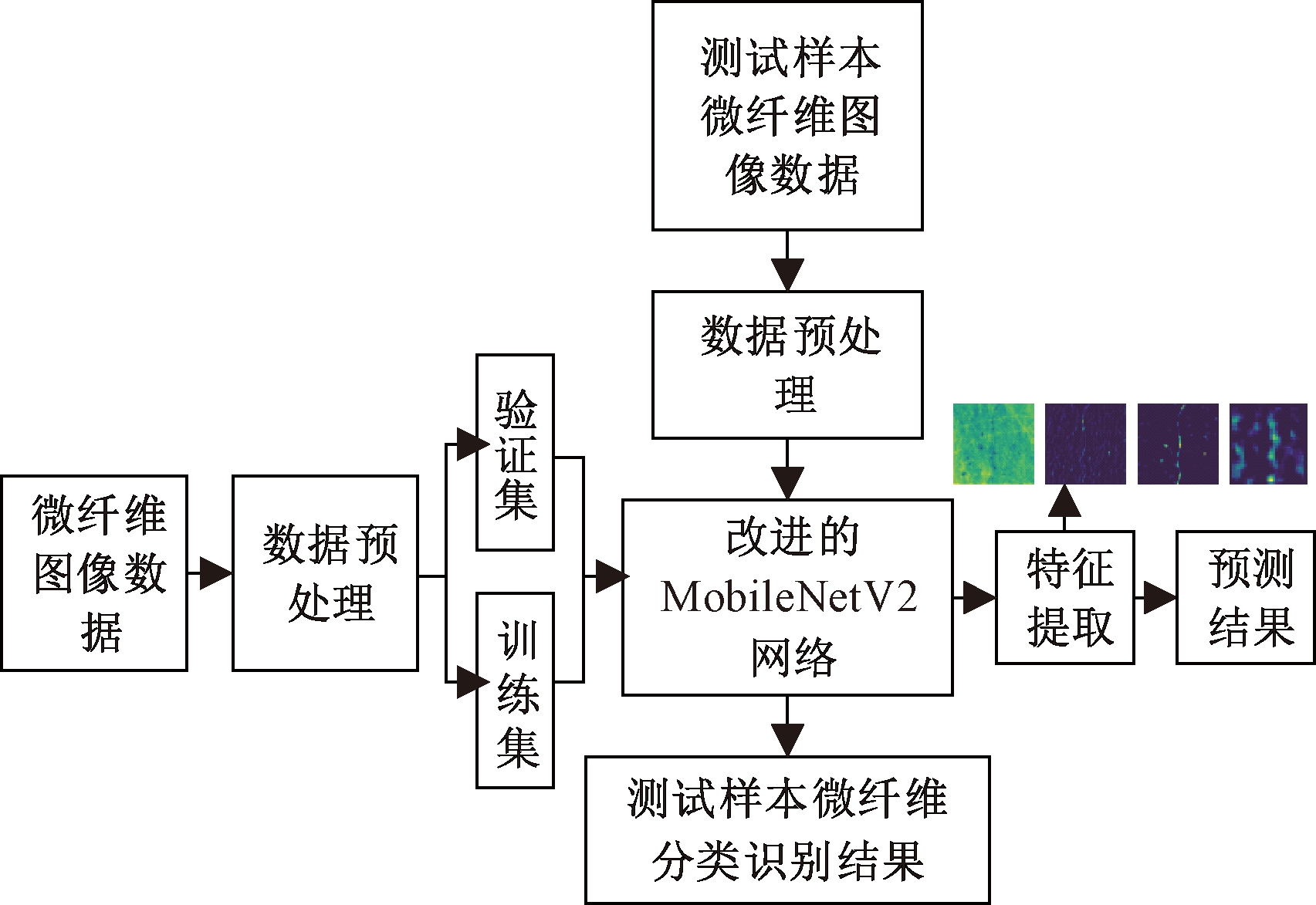

传统的卷积神经网络通过加深、加宽网络提取图像特征,但是越深、越宽的网络结构会使得算法模型较为庞大。为了便于微纤维识别的嵌入式系统的实现,在此采用深度可分离卷积网络以减少参数量和计算量。受微纤维尺寸、缠绕形状和显微图像获取环境等因素的影响,提取特征的过程中不能有效地学习到其关键特征信息。为解决此问题,在优化网络结构过程中,将着重于微纤维通道特征信息的提取,加强微纤维识别模型的泛化性。模型训练与测试的流程如图1所示。

图1 微纤维识别模型训练与测试流程

Figure 1 Microfiber recognition model training and

testing process

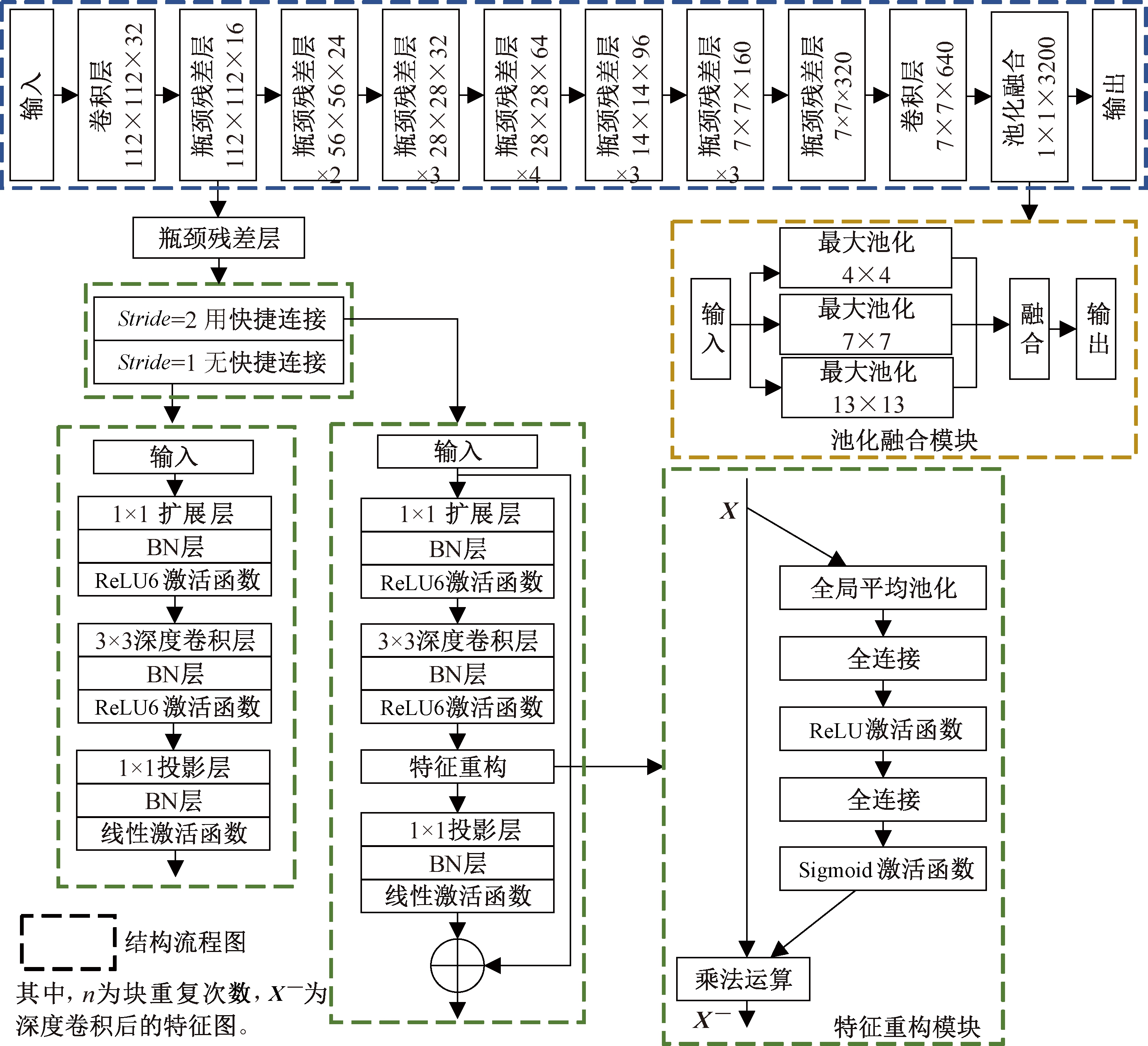

为解决正负样本平衡失调的问题,对原始网络的深度卷积特征通道进行重构,使网络在学习微纤维特征时,将注意力集中在关键的区域,并利用池化融合代替平均池化进行特征采样,捕获不同尺度的微纤维特征信息,有效提高微纤维识别率。改进后的MobileNetV2识别模型如图2所示。该模型主要是由卷积层、瓶颈残差层、特征重构模块和池化融合模块4个部分组成。卷积层利用尺寸为3×3的卷积核对输入的微纤维图像进行下采样操作,感知微纤维特征的位置、细节、语义信息。瓶颈残差层分为扩展层、深度卷积层和投影层3个部分:扩展层采用卷积核大小为1×1的卷积层对特征图进行升维操作,将低维空间映射到高维空间,提取更多特征图整体的信息;深度卷积层采用3×3大小卷积核提取微纤维的特征信息;投影层采用1×1大小卷积核的卷积层进行降维。在瓶颈残差层中,卷积操作后使用BN层控制梯度爆炸防止梯度消失。其次,扩展层和深度卷积层使用ReLU激活函数增加模型的非线性,提升模型的表达力。为防止非线性破坏太多信息,投影层采用线性激活函数捕获兴趣流形,保留更多有用的特征信息。针对深度模型中特征信息逐渐衰弱问题,瓶颈残差层引入残差结构增强特征提取的指向性。特征重构模块通过平均池化下采样器和2个全连接层重构微纤维特征,集中关键信息,将注意力聚集到微纤维的位置,从而提升模型学习微纤维特征的能力。池化融合模块采用3种不同池化核将特征细节信息融入上采样中,增强微纤维图像的特征信息,提取到更细致的特征图。

图2 微纤维识别模型

Figure 2 Microfiber recognition model

1.2 特征重构

瓶颈残差层采用深度可分离卷积提取微纤维特征,并没有考虑各通道的依赖关系。在原网络中融合通道注意力策略[12]的目的是让网络有选择性地加强大信息量特征,并对无用特征进行抑制。

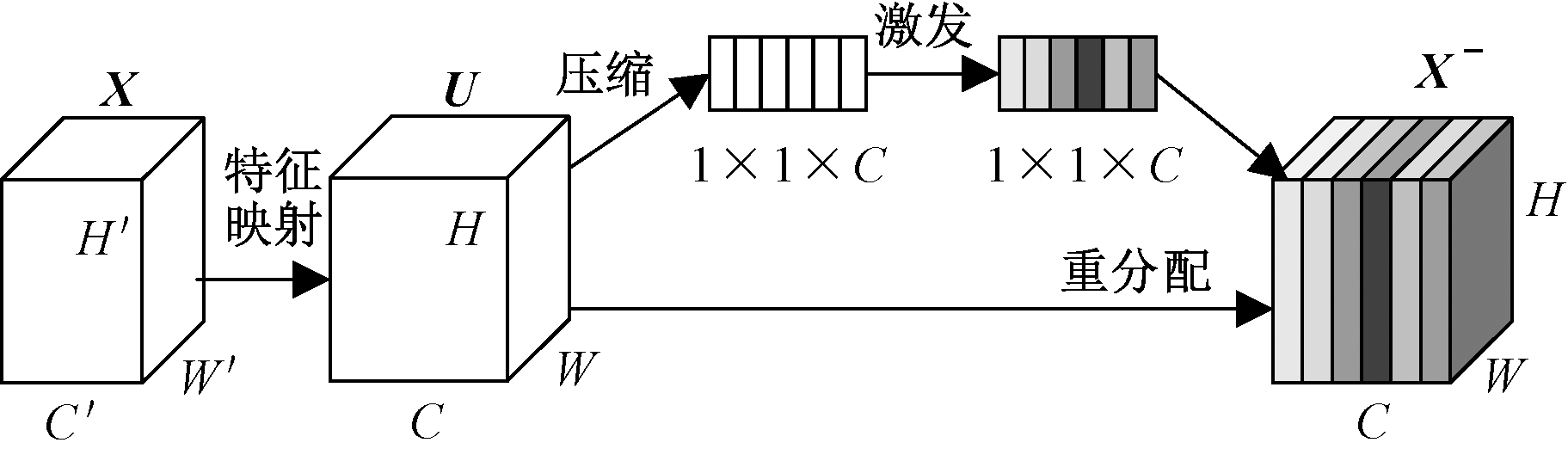

特征重构模块由3个部分组成:压缩、激发和重分配。将输入X映射到特征映射U,通过压缩操作在空间维度上聚合特征图来产生信道描述符。之后是激发操作,产生多通道调制权重。最后将权重加到特征图U上生成X—馈入网络的后续层,其尺寸没有发生改变,结构如图3所示。

图3 特征重构模块结构

Figure 3 Feature reconstruction module structure

压缩操作的目的是获取训练微纤维图像中上层网络特征的全局信息。低层网络的感受野较小,只能对局部的特征信息进行操作,无法学习到通道特征映射中上下文的信息。通过全局平均池化将U特征图W×H×C维特征压缩成1×1×C维特征,将空间上所有点的信息都平均成一个值,使得靠近输入的层也可以获得全局的感受野,如式(1)所示:

(1)

式中:W表示特征图U的水平方向像素数;H表示竖直方向像素数。

激发操作是通过权重矩阵组重新将微纤维特征构成特征间完整的映射,采用2个全连接进行:第1个全连接压缩通道来降低计算量,同时采用ReLU激活函数激活;第2个全连接再恢复到原来维度的通道,采用Sigmoid激活函数激活,获得0~1归一化的权重,进而更好地建立通道之间复杂的相关性,如式(2)所示:

Wc=σ(W2δ(W1V))。

(2)

式中:δ(·)为ReLU激活函数;σ为Sigmoid激活函数;W1、W2为全连接中的两个权重矩阵。

特征重分配是利用通道间的相关性屏蔽空间上的分布信息,通过乘法运算逐通道地加权到先前的特征上,从而完成在通道维度上对原始特征权重的重分配,并采用Sigmoid激活函数获得不同通道的特征权重,根据特征的重要程度自适应分配权重,获取表达能力更强的特征,提高网络对微纤维的识别,如式(3)所示:

X—=Wc f(i,j)。

(3)

其中,X—是式(1)和式(2)的结合。

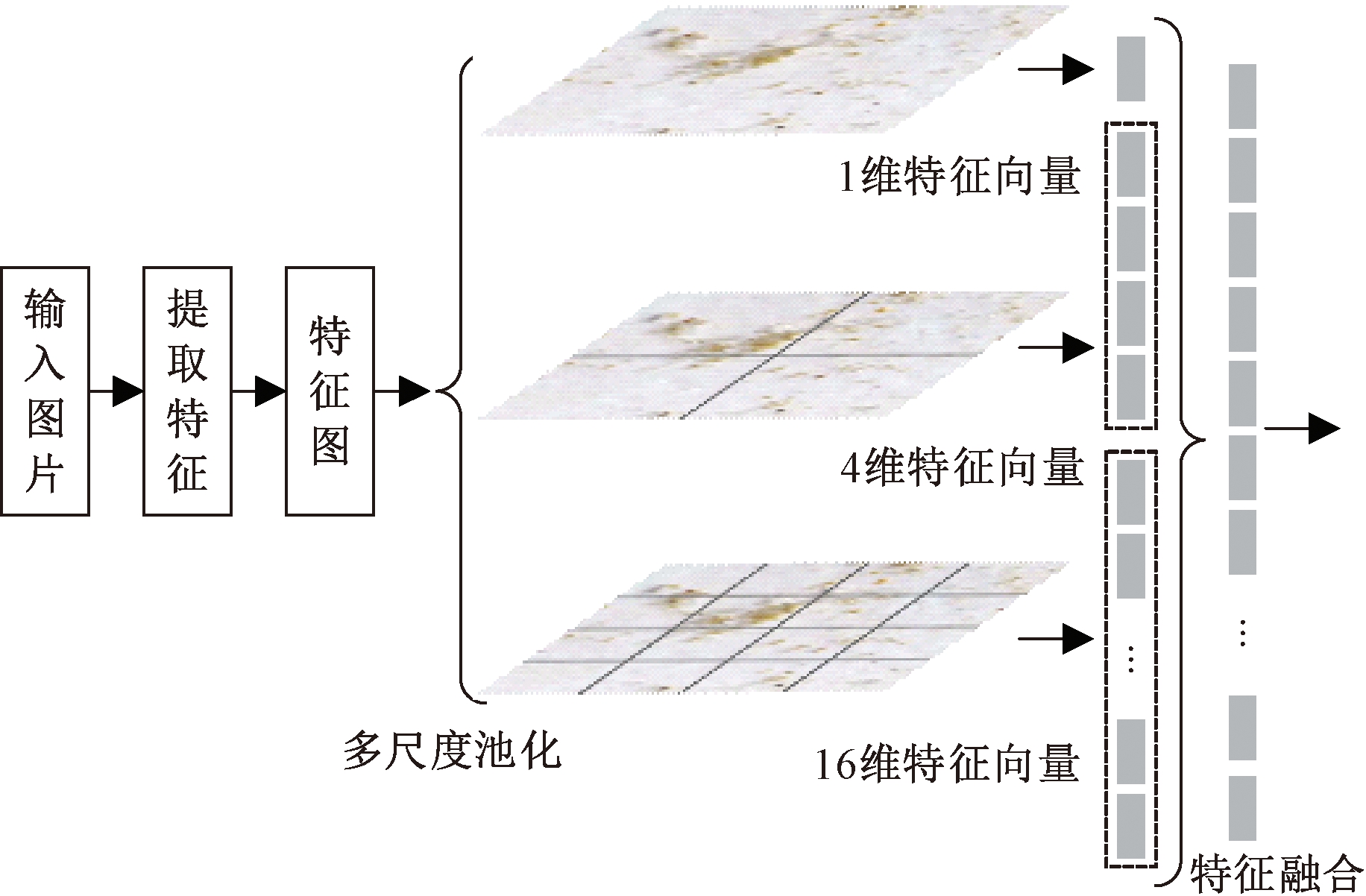

1.3 池化融合

MobileNetV2网络的全局平均池化下采样提取特征信息的能力有限,使得微纤维宽度信息不显著,注意力区域有偏差。采用池化融合策略通过不同大小池化核的下采样器,使网络获得不同的感受野,在不同尺度上捕捉信息,提高微纤维的识别精度,结构如图4所示。

图4 池化融合结构

Figure 4 Pooled fusion structure

池化融合模块采用多尺度的空间金字塔[13],以4×4、2×2和1×1大小的网格将输入的特征图分成16、4、1块,分别提取16维、4维、1维的特征向量,然后将提取到的特征融合为21维的特征向量。池化融合是在卷积层后对每1张图片都进行了多方面的特征提取,并将1个特征图从不同的角度进行特征提取,之后再进行融合操作,保留了在聚合时局部空间块的空间位置信息且获得更多的特征、场景语境信息与上下文间的联系,提高了微纤维的识别精度。

2 实验结果与分析

实验硬件环境:Inter@CORE i7 16 GB CPU,GeForce GTX 1070 GPU。实验在tensorflow以及keras框架下使用python3.7.0进行。

2.1 实验数据获取

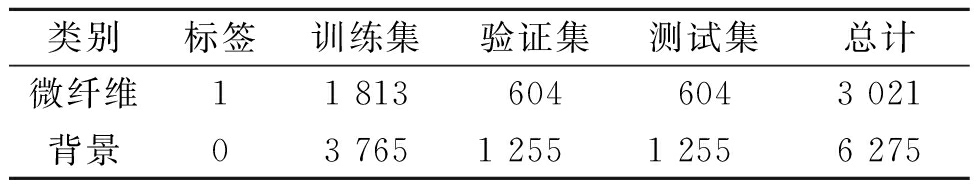

实验数据样本收集自不同时期的江苏省常州市滆湖。使用日本尼康SMZ18显微镜与电脑搭建硬件环境,随机采集不同微塑料纤维图像样本,其中, 3 021幅含有微纤维的图像组成微纤维数据集,6 275幅背景图像组成背景数据集。之后,对数据集的图像构建相应的类别标签,按照6∶2∶2的比例将数据集分为训练集、验证集和测试集,如表1所示。

表1 带标签数据集

Table 1 Labeled data set

类别标签训练集验证集测试集总计微纤维11 8136046043 021背景03 7651 2551 2556 275

2.2 评价指标

对于微纤维识别结果的评判,本文采用识别率(RR)、误识率(FRR)、漏识率(MRR)和准确率(AR)作为识别微纤维的评价指标,计算式如下:

(4)

(5)

(6)

(7)

式中:TP表示微纤维被正确识别的样本数目;FP表示非微纤维被错误识别的样本数目;FN表示微纤维被错误识别的样本数目;TN表示非微纤维被正确识别的样本数目。

2.3 实验设置

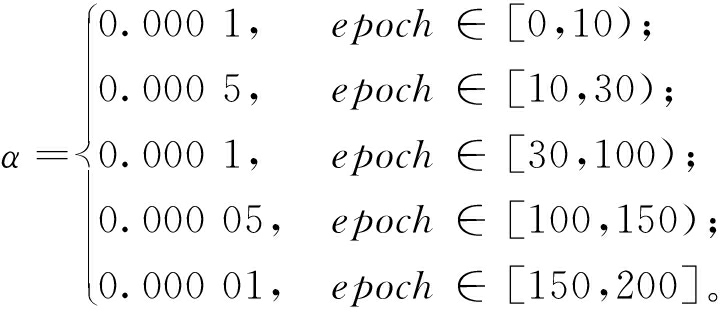

网络训练时参数更新策略采用适应性矩估计算法,一阶矩估计的指数衰减率设置为0.9,二阶矩估计的指数衰减率设置为0.999,交叉熵作为损失函数,批量大小设置为32,遍历1次训练集作为1个周期(epoch),迭代200个周期,学习率α采用的是分段常数衰减策略,如式(8)所示:

(8)

2.4 实验结果分析

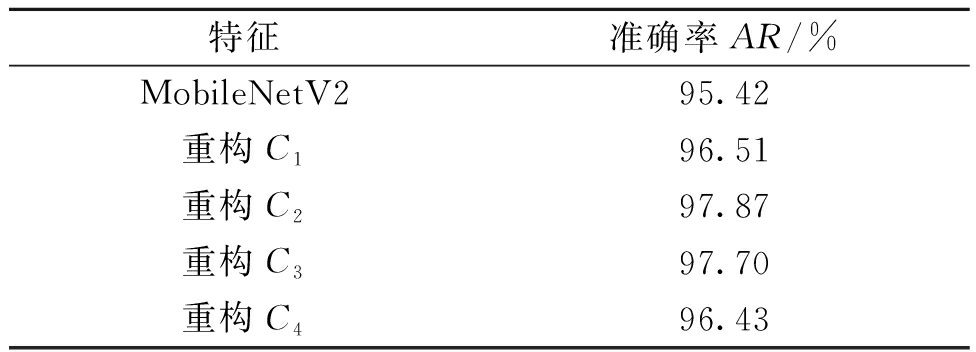

为了研究需要的重构特征位置,分别对瓶颈残差层中不同卷积特征进行重构,并比较特征重构后的微纤维识别效果。以第一个瓶颈残差层为例,特征C1、C2、C3、C4分别表示扩展层、深度卷积层、投影层和残差连接的特征。表2给出第一个瓶颈残差层不同位置特征重构的微纤维识别结果。

表2 不同位置特征重构的微纤维识别结果

Table 2 Recognition results of microfibers reconstructed

from different location features

特征准确率AR/%MobileNetV295.42重构C196.51重构C297.87重构C397.70重构C496.43

从表2可以看出,重构深度卷积特征后,微纤维识别的准确率最高达到97.87%,比没有经过特征重构的MobileNetV2特征准确率高2.45%。其次,其他位置的卷积特征经过重构后,微纤维识别的准确率也有所提高,分别高1.09%、2.28%、1.01%,体现了特征重构能使MobileNetV2特征有更好的表达效果。扩展层(C1)、投影层(C3)和残差连接(C4)后进行特征重构会丢失一些重要的特征信息,深度卷积(C2)后的特征重构将通道特征权重与特征图融合,学习到较完整的通道特征,保留更多微纤维特征的重要信息,因此,重构C2的效果更佳。

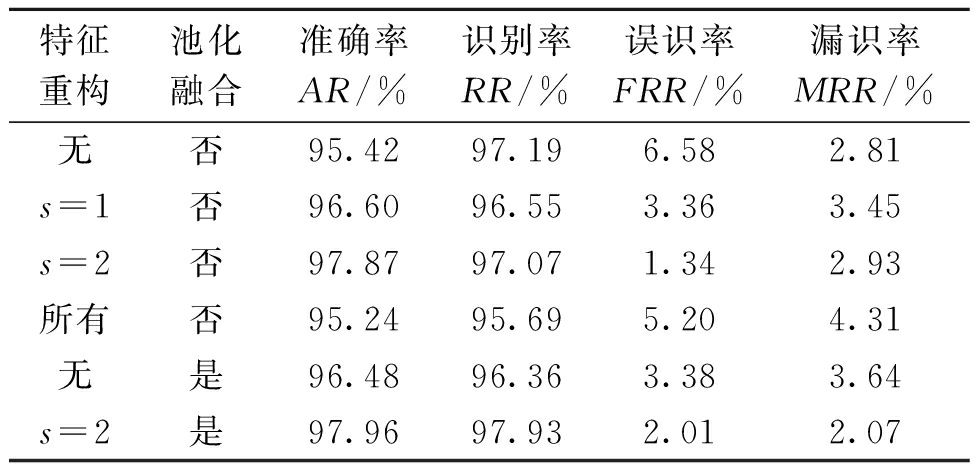

为体现本文算法识别微纤维的优势,在微纤维数据集上做了详细的实验,分析每个模块的性能,如表3所示。表中,“s=1”代表步长为1所在的瓶颈残差层,“s=2”代表步长为2所在的瓶颈残差层,“所有”即所有瓶颈残差层。从表3中可看出,在所有瓶颈残差层中添加特征重构模块,微纤维识别的准确率反而下降,识别率下降且漏识率升高。与没有添加特征重构模块和没有采用池化融合的结果相比,只对s=1或s=2的瓶颈残差层采用特征重构,准确率分别高1.18%、2.45%,且误识率有明显的下降;仅采用池化融合,准确率高1.06%,误识率低3.20%;对步长为2的瓶颈残差层添加特征重构并采用池化融合,准确率高2.54%,识别率高0.74%,误识率低4.57%,漏识率低0.74%。这体现了采用特征重构与池化融合增强了特征选择的判别性,提升了微纤维识别效果。

表3 不同模块的实验结果

Table 3 Experimental results of different modules

特征重构池化融合准确率AR/%识别率RR/%误识率FRR/%漏识率MRR/%无否95.4297.196.582.81s=1否96.6096.553.363.45s=2否97.8797.071.342.93所有否95.2495.695.204.31无是96.4896.363.383.64s=2是97.9697.932.012.07

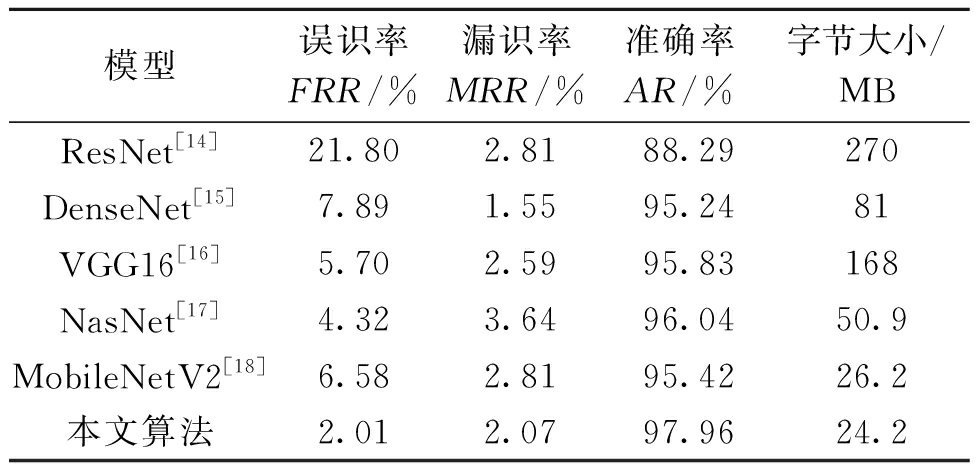

2.5 对比实验结果分析

为验证本文算法对识别微纤维的有效性,表4给出了将本文数据集用于ResNet、DenseNet、VGG16、NasNet和MobileNetV2进行识别微纤维效果的对比。

表4 不同网络微纤维识别结果

Table 4 Different network microfiber recognition results

模型误识率FRR/%漏识率MRR/%准确率AR/%字节大小/MBResNet[14]21.802.8188.29270DenseNet[15]7.891.5595.2481VGG16[16]5.702.5995.83168NasNet[17]4.323.6496.0450.9MobileNetV2[18]6.582.8195.4226.2本文算法2.012.0797.9624.2

由表4的对比可见,改进模型字节大小为24.2 MB,比原MobileNetV2网络模型小了2 MB,且比其他网络模型压缩了若干倍。改进后的MobileNetV2模型识别微纤维的准确率最高达到97.96%,相较于ResNet、DenseNet、VGG16、NasNet和MobileNetV2分别高9.67%、2.72%、2.13%、1.92%和2.54%,充分体现出改进后网络识别微纤维的优势。尽管改进后网络识别微纤维的漏识率比DenseNet网络高0.52%,但误识率与漏识率与其他网络相比有大幅度的降低。总体来说,改进MobileNetV2在模型大小和识别微纤维效果上有明显的提升,且提升效果较为稳定。

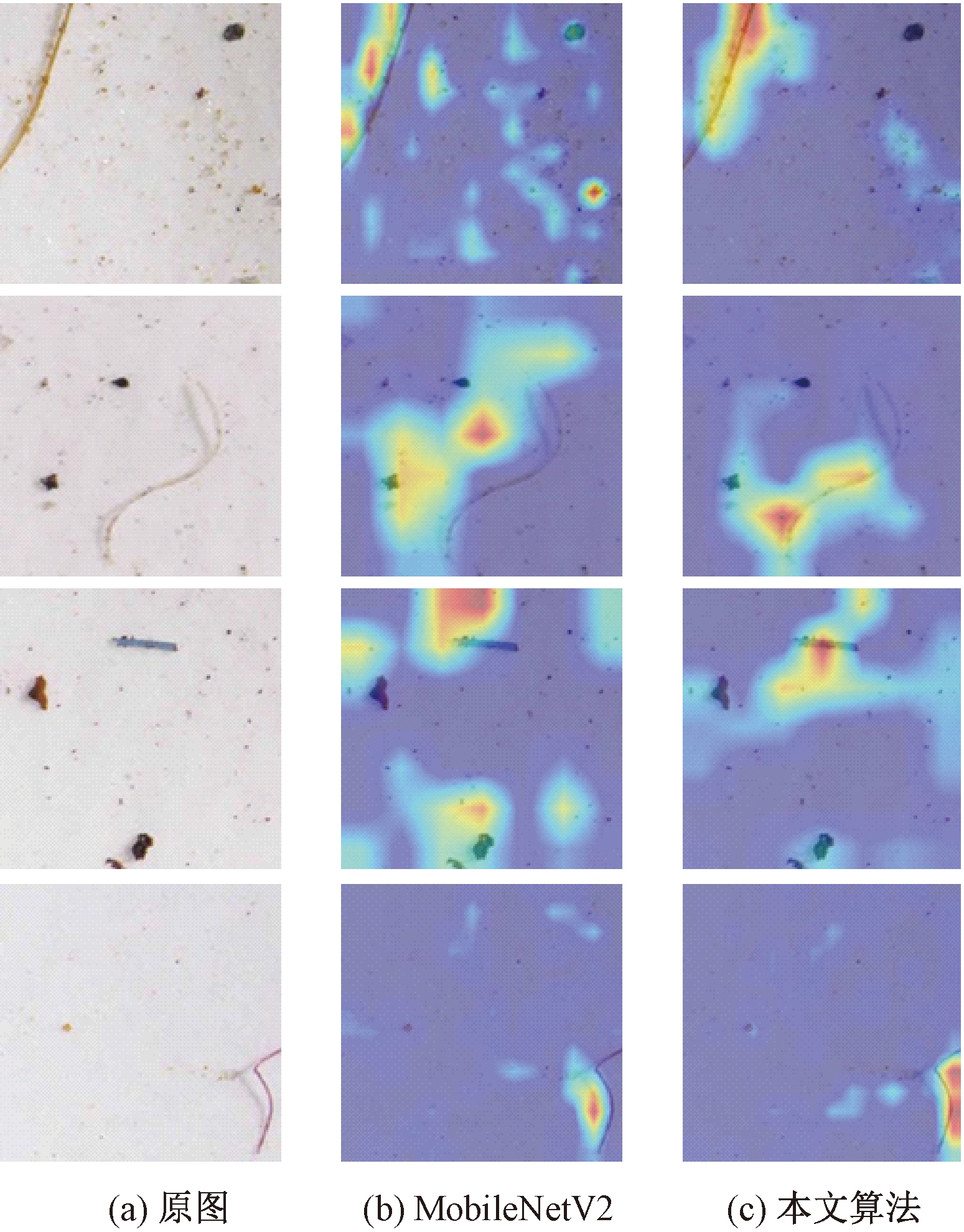

2.6 可视化结果分析

为进一步验证改进后网络识别微纤维的有效性,使用类激活映射将输入的微纤维图像进行可视化,如图5所示。图5(a)为微纤维的原始图像,图5(b)为MobileNetV2网络可视化图,图5(c)为改进后的网络可视化特征图。通过图5(b)、5(c)的对比,可以清楚地看到,经过特征重构与池化融合的MobileNetV2网络将注意力更加集中在微纤维特征所在区域而忽略其他无关的特征区域,增强了微纤维的关键特征信息,加强了特征判别的指向性,提升了网络学习微纤维特征的表达性能,从而改善了微纤维识别效果。

图5 类激活可视化

Figure 5 Grad-CAM visualization

3 结论

构建了一种改进的MobileNetV2的微纤维识别算法,在MobileNetV2网络特征提取的部分采用特征重构的算法,分配权重将深度卷积后的特征进行重构,捕捉微纤维特征之间的空间相关性,从中获取微纤维特征的有用关键信息,提升模型的学习能力与特征的表达能力。此外,采用池化融合算法进行下采样,利用不同池化核的采样器获取不同尺度的微纤维特征信息并将其进行融合,获得更多有关微纤维特征的信息,提取出更加细致的微纤维特征。通过与其他卷积神经网络实验的对比,验证了本文算法能有效提高识别率和准确率,降低误识率和漏识率。在今后的工作中,将针对已经识别出的微纤维进行更细致的分类,并且收集其他形态的水体微塑料样本,并扩大水域收集范围进行识别。

[1] THOMPSON R C,OLSEN Y,MITCHELL R P,et al.Lost at sea:where is all the plastic?[J].Science,2004,304(5672):838.

[2] HODSON M E,DUFFUS-HODSON C A,CLARK A,et al.Plastic bag derived-microplastics as a vector for metal exposure in terrestrial invertebrates[J].Environmental science & technology,2017,51(8):4714-4721.

[3] ANDRADY A L.Microplastics in the marine environment[J].Marine pollution bulletin,2011,62(8):1596-1605.

[4] SMITH M,LOVE D C,ROCHMAN C M,et al.Microplastics in seafood and the implications for human health[J].Current environmental health reports,2018,5(3):375-386.

[5] 许霞,侯青桐,薛银刚,等.污水厂中微塑料的污染及迁移特征研究进展[J].中国环境科学,2018,38(11):4393-4400.

[6] MILLER R Z,WATTS A J R,WINSLOW B O,et al.Mountains to the sea:river study of plastic and non-plastic microfiber pollution in the northeast USA[J].Marine pollution bulletin,2017,124(1):245-251.

[7] 李珊,张岚,陈永艳,等.饮用水中微塑料检测技术研究进展[J].净水技术,2019,38(4):1-8.

[8] 李剑平.扫描电子显微镜对样品的要求及样品的制备[J].分析测试技术与仪器,2007,13(1):74-77.

[9] SILVA A B,BASTOS A S,JUSTINO C I L,et al.Microplastics in the environment:challenges in analytical chemistry-a review[J].Analytica chimica acta,2018,1017:1-19.

[10] YURTSEVER M,YURTSEVER U.Use of a convolutional neural network for the classification of microbeads in urban wastewater[J].Chemosphere,2019,216:271-280.

[11] PAZDERNIK K,LAHAYE N L,ARTMAN C M,et al.Microstructural classification of unirradiated LiAlO2 pellets by deep learning methods[J].Computational materials science,2020,181:109728.

[12] HU J,SHEN L,ALBANIE S,et al.Squeeze-and-excitation networks[J].IEEE transactions on pattern analysis and machine intelligence,2020,42(8):2011-2023.

[13] HE K M,ZHANG X Y,REN S Q,et al.Spatial pyramid pooling in deep convolutional networks for visual recognition[J].IEEE transactions on pattern analysis and machine intelligence,2015,37(9):1904-1916.

[14] HE K M,ZHANG X Y,REN S Q,et al.Deep residual learning for image recognition[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Piscataway:IEEE,2016:770-778.

[15] HUANG G,LIU Z,VAN DER MAATEN L,et al.Densely connected convolutional networks[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Piscataway:IEEE,2017:2261-2269.

[16] SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[EB/OL]. (2014-09-04)[2020-10-30].https://arxiv.org/abs/1409.1556.

[17] ZOPH B,VASUDEVAN V,SHLENS J,et al.Learning transferable architectures for scalable image recognition[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Piscataway:IEEE,2018:8697-8710.

[18] SANDLER M,HOWARD A,ZHU M L,et al.MobileNetV2:inverted residuals and linear bottlenecks[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Piscataway:IEEE,2018:4510-4520.