0 引言

3D电影利用人的双眼视差,显示因位置差异而略有不同的2个图像,给观影者以身临其境的感觉。其中,3D场景的产生一方面主要依靠颜色数据,另一方面主要依靠高分辨率(high resolution,HR)深度数据。HR深度数据与颜色数据相比更难获得,因此成为研究的重点。

当前可通过利用彩色图像引导和深度学习等方式获得HR深度图。其中,Ren等[1]将图像中的像素点进行分类并将HR深度图像完成联合双边滤波(pixel category and joint bilateral filtering,PCJBF),该算法实验输出的任意像素点的深度值存在较大偏差。Gu等[2]提出加权分析模型,利用动态调整增强深度不连续区域,但不能有效利用彩色图像的引导作用。Yang等[3]提出用于HR深度修正的自适应彩色图像引导的自回归模型(autogressive model,AR),其即时性较差,所需的存储空间也较大,不能有效避免产生梯度反转伪像[4]以及细节边缘不清晰的问题。Qiao等[5]提出基于像素点聚类的深度上采样算法,当像素点所处区域的特性不同时,无法获得较好的像素点聚类与区域分割的结果。Ferstl等[6]利用图像建模优化,并使用各向异性扩散张量完成深度修正,不能降低不同区域间像素的影响。Wen等[7]利用卷积网络级联的深度学习算法完成图像超分辨,但GAN网络训练的稳定性不足,其结果不能充分地说明与解释其有效性。

针对上述问题,本文提出了自适应参数与边缘点引导的深度图像超分辨率重建算法。首先完成对LR(low resolution)深度图像的深度修正,保证其深度数据的准确性与有效性,并对像素点进行聚类;然后提出在用于HR深度图像重建的AR模型中加入多个自适应参数,可有效防止由彩色图像与深度图像结构差异引起的实验输出结果出现伪像的情况发生,同时降低处于不同区域像素间的影响,获得更精确的深度数值。

1 相关AR模型

Yang等[3]提出HR彩色图像引导的自回归模型完成深度图像超分辨。其中,AR模型如下所示:

(1)

(2)

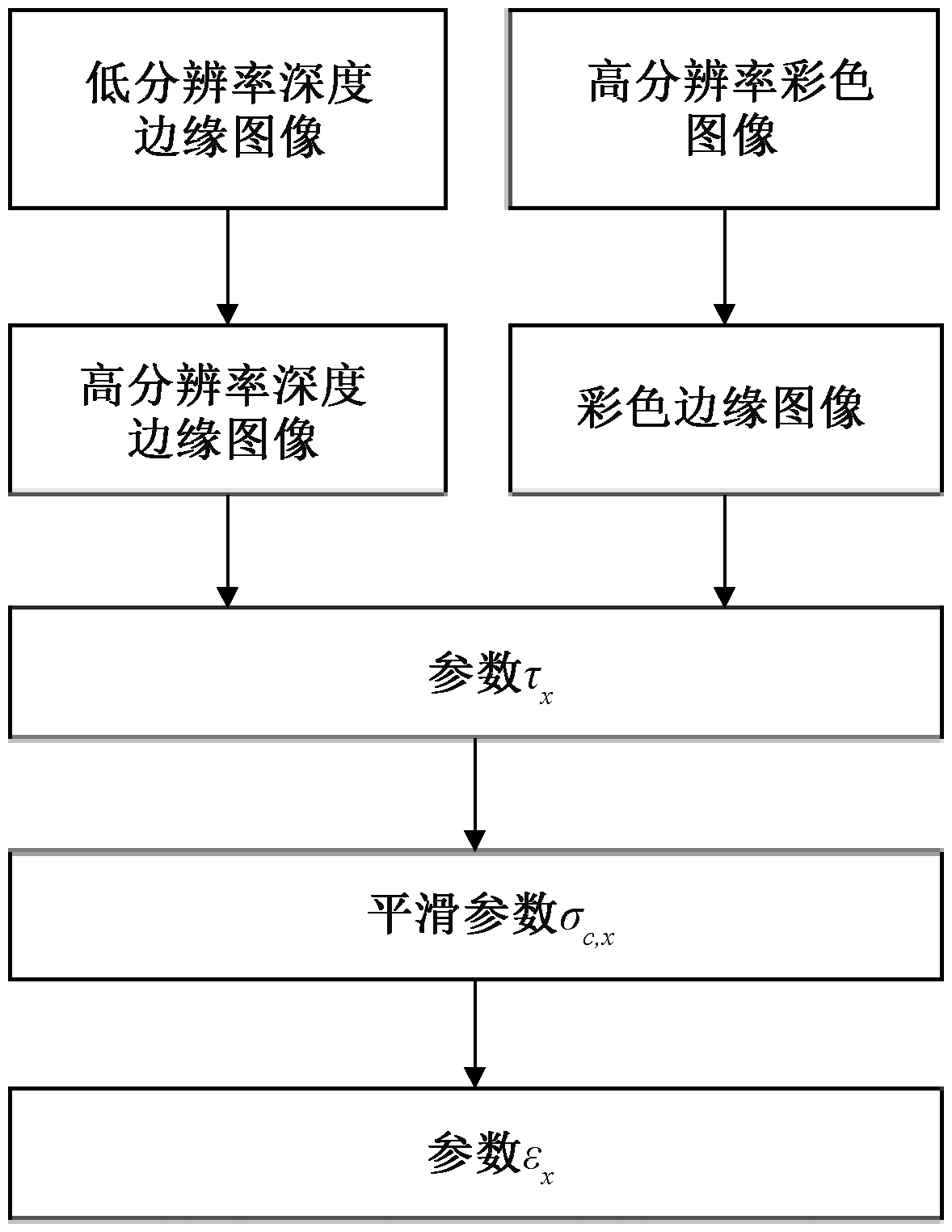

式中:ax,y为模型系数,x为中心点,y为x邻域的任意像素点;σd和σ3为自适应变化参数;![]() 用于彩色图像滤波;参数σ4和σ5均为常数;c为YUV颜色空间;I为高分辨率的彩色图像。

用于彩色图像滤波;参数σ4和σ5均为常数;c为YUV颜色空间;I为高分辨率的彩色图像。

Yang等[3]提出的AR模型在用于获得HR深度矩阵时,其获得的深度值不够准确,未考虑像素点处于不同区域的特性,忽略了像素点之间的强烈影响,不能合理有效利用HR彩色图,因此不能获得高质量的HR深度图像。

2 算法思路框架

2.1 LR深度图修正

由于LR深度图的深度可能会出现丢失、不准确等情况,本文提出的标记并修正不可靠像素点的算法,可以有效避免这种情况的发生,步骤如下所示。

对LR深度图使用Sobel算子获取边缘图SDL。对深度不可靠像素点进行标记:①深度值为0的点标记为不可靠像素点;②将图像分为3×3大小的不重叠的图像块,计算每个块内中心点与周围点像素值差值的绝对值,并记录绝对值大于3的个数, 如果个数大于t1,则将该区域的中心像素点标记为不可靠像素点,本文实验将t1设置为3;③如果图像块同时处于两个特性不同的区域,则利用SDL与边缘区域对比,同样对图像块中边缘处的像素点与区域临界处的像素点求其差值的绝对值,若绝对值大于3的个数超过t2,那么该像素点为不可靠像素点,t2在本文实验中设置为2。按照此种方法依次完成判断,标记出所有不可靠像素点。

当8个邻域像素点的区域特性不同时,则计算其周围可靠像素点深度的均值,对其进行填充,否则则利用边缘图的指导,利用8个像素点的插值获得像素深度,最后可获得深度完整且可靠的图像![]()

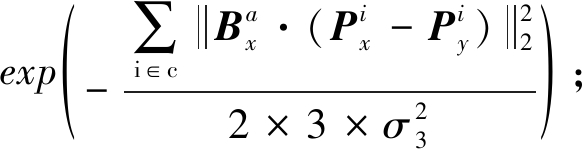

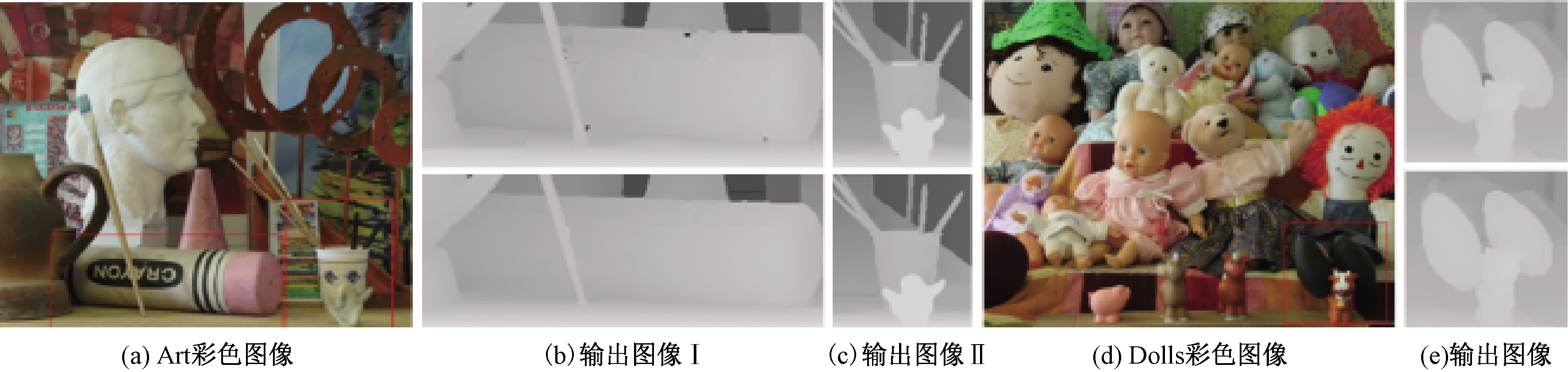

如图1所示,图1(a)和图1(c)表示未被预处理的LR深度图像,其中在边缘区域带有很多空洞,会对后期深度图像超分辨带来不利影响。图1(b)和图1(d)分别表示已完成LR深度修正的Books和Dolls图像,该图像深度信息完整,深度不连续区域得到增强,可有效完成后期深度图像的超分辨。

图1 LR深度修正图像

Figure 1 LR depth repair image

2.2 改进AR模型系数

HR深度图D1是对LR深度图双三次插值的结果,但其存在一些问题,例如图像边缘模糊以及部分深度值误差较大。本文算法对AR模型进行改进,根据像素点的区域特性,通过加入一系列自适应参数,以预防出现梯度反转伪像以及由深度图与其对应的彩色图结构不一致而产生伪像的情况。对初始化深度图的深度不连续像素点采用深度修正,其公式如下所示:

(3)

(4)

式中:Sx为归一化系数;wx,y为AR模型的加权系数;![]() 为深度项的约束因子;

为深度项的约束因子;![]() 为颜色项的约束因子。

为颜色项的约束因子。

2.2.1 深度项约束因子

在深度项中加入参数σd,x,其随像素点所处的3×3像素块变化,在同一个图像块设置相同的参数,可有利于均衡不同位置像素点的深度权值,使边界处像素点深度的差异度更平滑,促进两相邻像素间互相制约,确保深度的准确性。深度项约束因子的公式为

(5)

(6)

式中:![]() 表示在HR深度图像中,以x为中心点的第s个图像块的梯度值;Z根据实验设为9;像素点y是像素点x邻域N中任意像素点;a1、a2和a3的值根据经验设置。

表示在HR深度图像中,以x为中心点的第s个图像块的梯度值;Z根据实验设为9;像素点y是像素点x邻域N中任意像素点;a1、a2和a3的值根据经验设置。

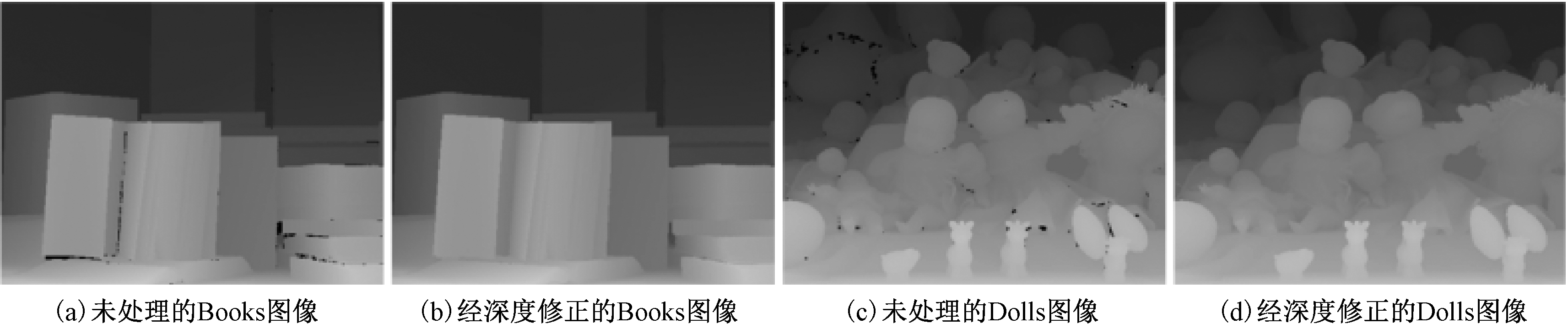

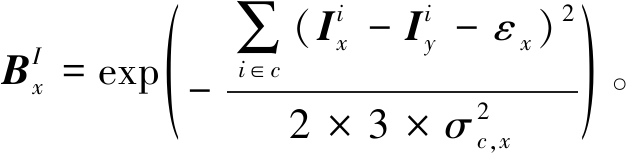

图2(a)和图2(d)分别表示Art、Laundry的彩色图像,图2(b)、2(c)和2(e)分别为图2(a)和2(d)的局部实验输出图像,其第1行与第2行分别表示参数σd,x随像素点自适应变化与随像素块自适应变化的局部实验输出图像。由图2可知,在图2(b)和图2(c)中,第1行图像的边缘区域出现部分缺失,第2行的图像边缘结构清晰且完整;在图2(e)中,第1行图像出现空洞是由于像素点所属区域特性的差异导致部分深度出现错误,因此参数σd,x随像素块自适应变化可确保深度不连续区域的完整性以及深度的有效性。

图2 实验结果图像对比

Figure 2 Image comparison of experimental results

2.2.2 颜色项约束因子

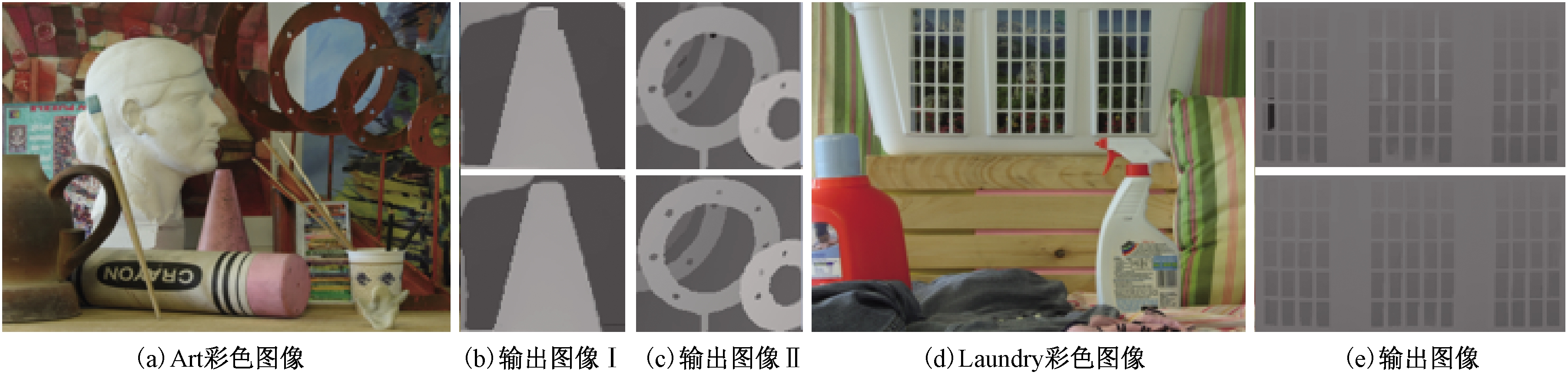

在颜色项约束因子中,加入用于判断深度图与彩色图结构是否一致的参数τx,平滑参数σc,x与其相关,可根据像素点的区域特性改变彩色图像产生的权重。同时,加入用于降低处于不同区域边缘对侧像素点影响的控制参数εx,防止因区域特性的差异而导致深度上产生较大的误差。图3为颜色项约束因子算法的整体框架,其表达式为

图3 颜色项约束实现框架

Figure 3 Implement framework for adaptive parameters of the color item

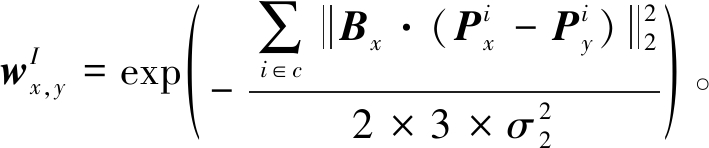

(7)

式中:σ2为常数,![]() 为以x为中心点的图像块;Bx用于对彩色图滤波,并且将控制参数σc,x和εx加入其中,σc,x与σd,x相同,均由区域内的图像块决定,εx的变化由像素点的区域特性决定。

为以x为中心点的图像块;Bx用于对彩色图滤波,并且将控制参数σc,x和εx加入其中,σc,x与σd,x相同,均由区域内的图像块决定,εx的变化由像素点的区域特性决定。

(8)

![]()

(9)

(10)

式中:![]() 用于衡量空间紧密度;σ1为常数;

用于衡量空间紧密度;σ1为常数;![]() 用于衡量强度相似度;参数σc,x的变化与参数τx密切相关,参数τx可表明深度图像与其所对应HR彩色图像的结构匹配程度,匹配程度越高,彩色图像的约束因子越高,否则会降低彩色图像的权重,从而避免出现边缘信息过于丰富的情况。其表达式如下所示:

用于衡量强度相似度;参数σc,x的变化与参数τx密切相关,参数τx可表明深度图像与其所对应HR彩色图像的结构匹配程度,匹配程度越高,彩色图像的约束因子越高,否则会降低彩色图像的权重,从而避免出现边缘信息过于丰富的情况。其表达式如下所示:

(11)

(12)

其中,由![]() 与D1之间的位置映射关系,产生边缘深度图像SD1。通过Sobel边缘检测算法得到边缘图SC。SAD是SD1和SC绝对差异值的和,τx是SD1和SC的平均绝对偏差,可有利于检测深度图与彩色图之间的结构匹配程度。

与D1之间的位置映射关系,产生边缘深度图像SD1。通过Sobel边缘检测算法得到边缘图SC。SAD是SD1和SC绝对差异值的和,τx是SD1和SC的平均绝对偏差,可有利于检测深度图与彩色图之间的结构匹配程度。

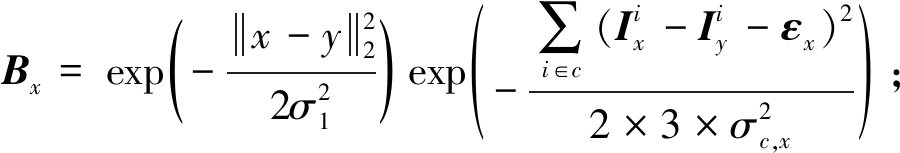

在图3中,用于调节彩色图像权重系数的常数σ5变为自适应变化的参数σc,x,这两种情况实验结果的比较如图4所示。其中,图4(b)、4(c)和4(e)的第1行为将σ5设为常数时图像局部区域的实验结果,第2行为参数σc,x随像素点自适应变化时的实验结果。第1行的图像存在部分锯齿以及模糊伪像的问题,第2行的图像更清晰,边缘细节丰富,可说明上述方法的有效性。

图4 算法输出图像

Figure 4 The output images of the algorithm

3 实验结果与分析

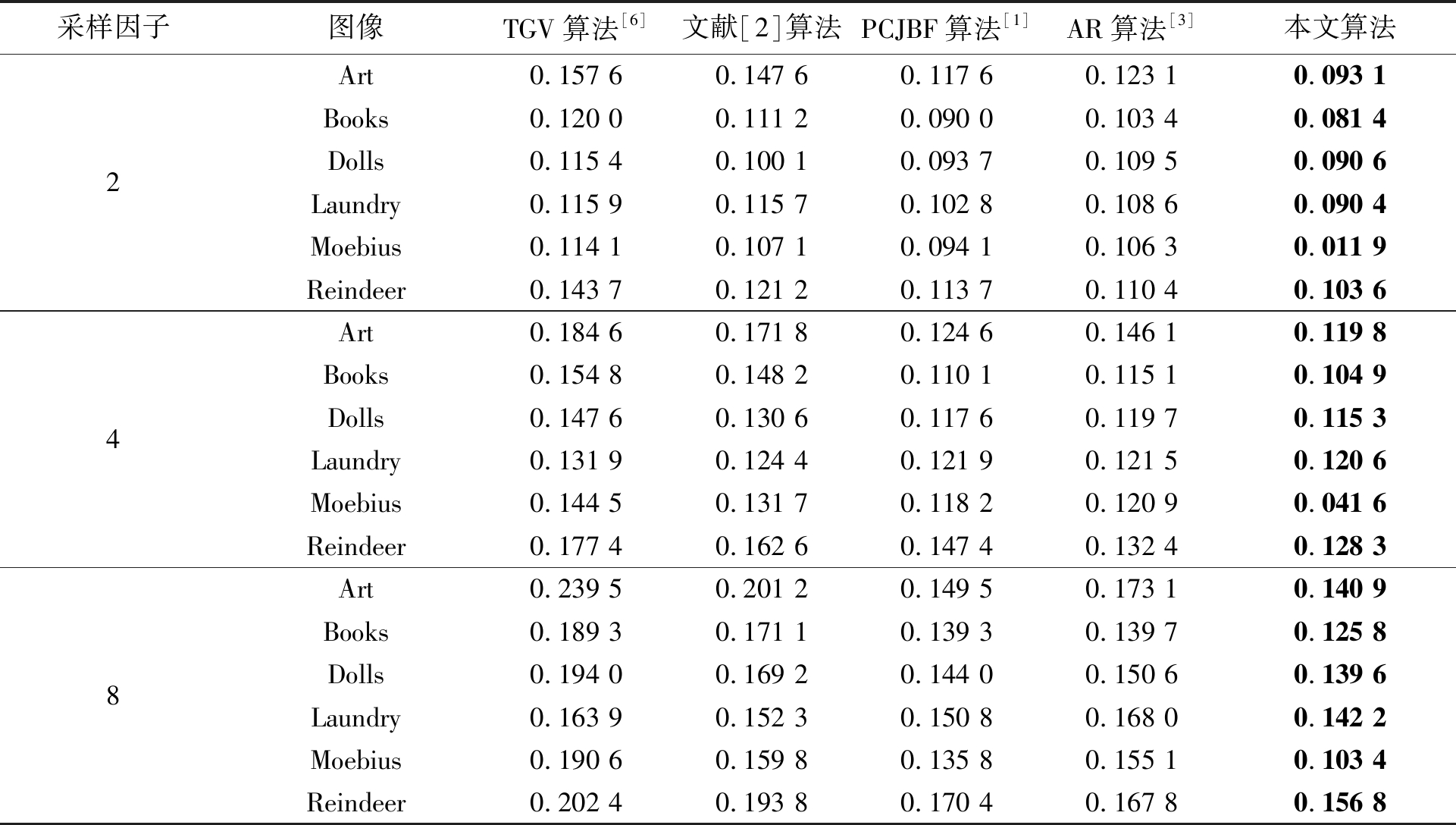

为体现本文所提出算法的优势,采用深度数据集[8]中的深度与彩色图像对进行实验,本文列出Art、Books、Laundry等6幅图像的部分实验数据如表1所示。

通过表1可以看出,本文算法的实验输出图像都具有最低的BPR(坏点率),说明本文算法的性能较好,在AR模型中加入一系列自适应参数,可有效避免梯度反转伪像的产生,减小不同区域间像素点的影响,有效调节彩色图像的权重。

表1 实验输出结果的BPR比较

Table 1 BPR comparison of experimental output results

采样因子图像TGV算法[6]文献[2]算法PCJBF算法[1]AR算法[3]本文算法248Art0.157 60.147 60.117 60.123 10.093 1Books0.120 00.111 20.090 00.103 40.081 4Dolls0.115 40.100 10.093 70.109 50.090 6Laundry0.115 90.115 70.102 80.108 60.090 4Moebius0.114 10.107 10.094 10.106 30.011 9Reindeer0.143 70.121 20.113 70.110 40.103 6Art0.184 60.171 80.124 60.146 10.119 8Books0.154 80.148 20.110 10.115 10.104 9Dolls0.147 60.130 60.117 60.119 70.115 3Laundry0.131 90.124 40.121 90.121 50.120 6Moebius0.144 50.131 70.118 20.120 90.041 6Reindeer0.177 40.162 60.147 40.132 40.128 3Art0.239 50.201 20.149 50.173 10.140 9Books0.189 30.171 10.139 30.139 70.125 8Dolls0.194 00.169 20.144 00.150 60.139 6Laundry0.163 90.152 30.150 80.168 00.142 2Moebius0.190 60.159 80.135 80.155 10.103 4Reindeer0.202 40.193 80.170 40.167 80.156 8

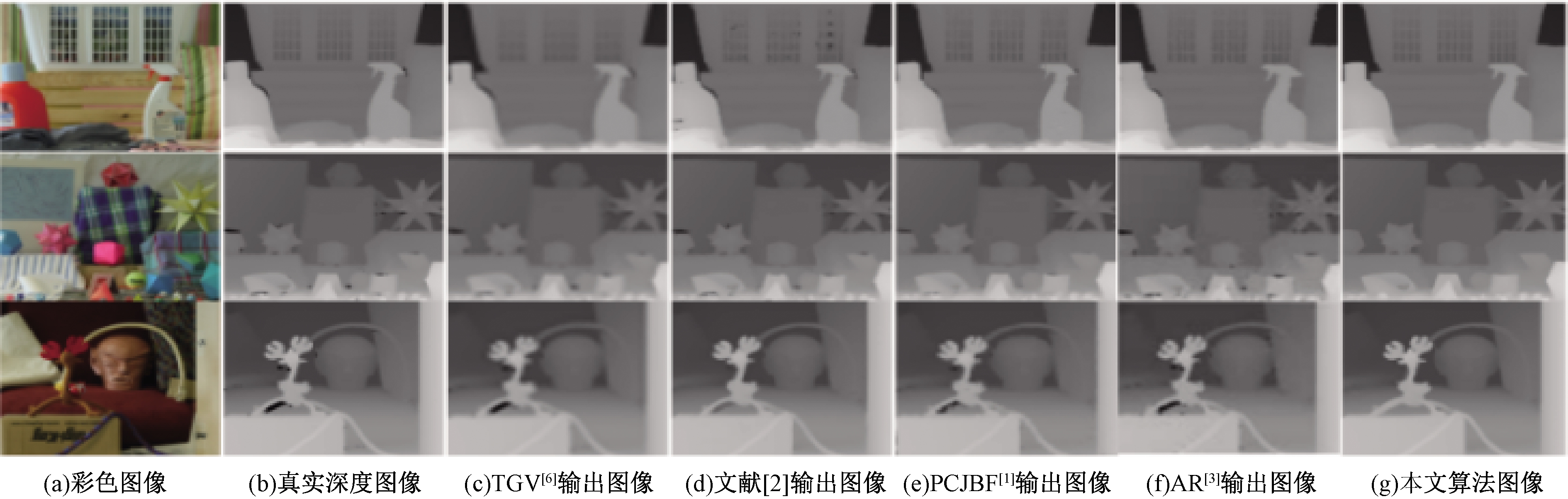

图5提供了测试图像为Laundry、Moebius以及Reindeer,上采样因子为8时的实验结果图,其中,图5(a)为HR彩色图像,图5(b)为真实深度图像,图5(c)~5(g)分别表示TGV[6]、文献[2]、PCJBF[1]、AR[3]以及本文算法实验输出的高分辨率深度图像。对上述算法的实验结果进行主观视觉上的比较,从图5(c)和图5(d)可以看出,图像中空洞和伪像区域扩大;从图5(e)可以看出,图像增加了部分空洞区域;从图5(f)可以看出,细节边缘结构模糊,部分区域细节过于丰富;通过图5(g)可以看出,图像细节边缘结构清晰,整体清晰度较高。

图5 算法实验输出图像

Figure 5 Algorithm experiment output image

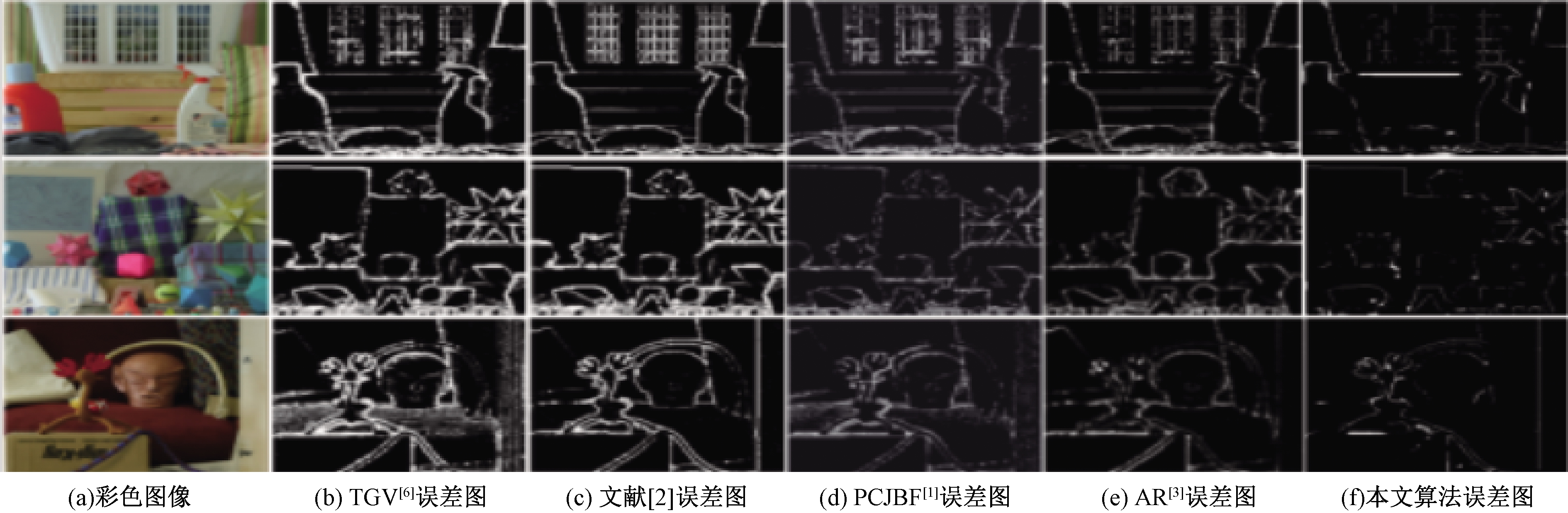

图6为上采样因子为8的误差主观比较图像。误差主观比较图为真实深度图与不同HR深度图的差,线条越粗或越多反映了其误差越大,反之则说明其误差越小。图6(a)~6(f)为HR彩色图像以及TGV[6]、文献[2]、PCJBF[1]、AR[3]和本文算法的输出结果分别与真实深度图像作差所得的结果。由图6可知,本文算法的误差线条相对于其他几种算法明显较少,可以证明本文算法对不连续的深度区域处理较好,能有效减小误差。

图6 算法实验误差图像

Figure 6 Algorithm experiment error image

4 结论

针对目前的算法存在输出实验结果中边缘区域不清晰、平滑区域出现伪像以及处于不同区域像素点之间的影响较大导致输出错误的深度值等问题,本文基于HR深度伪矩阵提出自适应参数与边缘点引导的深度值重建的算法。首先利用Sobel算子对LR深度图进行修正;其次利用加入一系列自适应参数的自适应自回归模型完成深度不连续区域的深度重建。由实验结果可知,本文算法与其他算法相比,在采样因子为2、4、8时,Art、Books、Dolls等6幅图像上均取得了最低的BPR值,并且在主观视觉上取得了较好的结果。下一步将结合图像分割[9]的方法针对深度不连续区域完成深度图像超分辨的相关工作。

[1] REN Y, LIU J, YUAN H, et al. Depth up-sampling via pixel-classifying and joint bilateral filtering[J]. KSII transactions on internet & information systems, 2018, 12(7):3217-3238.

[2] GU S, ZUO W, GUO S, et al. Learning dynamic guidance for depth image enhancement[C]// 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway:IEEE, 2017:712-721.

[3] YANG J Y, YE X C, LI K, et al. Color-guided depth recovery from RGB-D data using an adaptive autogressive model [J]. IEEE transactions on image processing, 2014, 23(8): 3443-3458.

[4] BAE S, PARIS S, DURAND F. Two-scale tone management for photographic look [J]. ACM transactions on graphics, 2006, 25(3): 637-645.

[5] QIAO Y G, JIAO L C, YANG S Y, et al. A novel segmentation based depth map up-sampling[J]. IEEE transactions on multimedia, 2019, 21(1): 1-14.

[6] FERSTL D, REINBACHER C, RANFTL R, et al. Image guided depth upsampling using anisotropic total generalized variation[C]//Proceedings of the 2013 IEEE International Conference on Computer Vision. New York:IEEE, 2013:993-1000.

[7] WEN Y, SHENG B, LI P, et al. Deep color guided coarse-to-fine convolutional network cascade for depth image super-resolution[J]. IEEE Transactions on Image Processing, 2019, 28(2): 994-1006.

[8] Middlebury datasets [EB/OL]. (2001-02-11)[2020-09-15].http://vision.middlebury.edu/stereo/data/.

[9] 胡春鹤,王依帆,朱书豪,等.基于鸽群优化算法的图像分割方法研究[J].郑州大学学报(工学版),2019,40(4):42-47.