0 引言

图像显著性检测旨在找出图像中最吸引人视觉注意的区域,因其反映了人视觉机制最本质的机理而成为各种计算机视觉任务中重要的预处理步骤,比如图像识别[1]、视觉跟踪[2-3]、对象检测[4]等。

近年来,解决显著性对象检测的方法已出现很多。早期的显著性对象模型多数是基于非深度学习的传统算法,显著映射的生成都基于浅层的、人工设置的先验特征,这导致算法的鲁棒性及泛化能力不强,并且人工提取特征也非常耗时。随着大数据时代的到来,越来越多的学者开始研究基于深度学习的显著性检测方法。当前,应用最广且最有效的方法是全卷积神经网络(fully con-volutional networks, FCNs)[5],它通过卷积-反卷积结构能够端到端地生成与输入大小相同的显著映射。然而,在全卷积神经网络中,大多是通过依次堆叠多个卷积层和池化层来逐步扩大感受野并提取高级语义特征,这会导致特征映射的分辨率不断减小,对于显著性对象检测这种像素级的任务是非常不友好的。此外,利用深层卷积提取的高级特征去预测显著映射,会由于缺乏浅层的空间细节信息,使得检测到的显著性对象的边缘十分模糊。

本文针对以上两大问题,提出了一种全新的显著性对象检测方法:基于注意力嵌入的金字塔特征以及渐进边缘优化的显著性对象检测模型。首先,受到DenseASPP[6]的启发,设计了一个由多个扩张卷积构成的注意力嵌入的密集空洞金字塔模块(attention embedded dense atrous pyramid module, AEDAPM),通过具有不同扩张率的扩张卷积处理,在不减小特征映射分辨率的前提下,获得具有不同感受野的多级多尺度上下文特征,同时嵌入注意力机制,对这些不同感受野下得到的特征产生不同程度的响应,以此来灵活检测图像中大小、形状不一的显著对象。其次,为了得到清晰的显著性对象的边缘,提出了一个渐进边缘优化模块(stepped edge optimization module, SEOM)。仅仅用高级语义特征去检测显著性对象,是无法得到清晰的边界轮廓的,由于浅层特征中保留了更多的空间细节,适合于定位边界,所以借助渐进边缘优化模块,向不同分辨率的显著特征中逐次补充浅层的外观特征,以此得到更加清晰的边缘轮廓。

1 相关工作

1.1 传统的显著性对象检测方法

显著性对象检测的研究已有深远的历史,早期的方法大多靠自底向上的计算模型以及人工设置的较为低级的特征去检测显著性对象,这些特征大多借助于经验,如对比度、中心先验等。这些方法中最经典的要数Itti等[7]提出的模型,其受灵长类动物视觉神经系统及其行为的启发,对多个特征通道和尺度进行分解,再通过滤波得到多个显著特征,最后将其融合得到最终的显著图。Hou等[8]认为图像的信息都包含在图像的幅度谱信息中,利用谱残差模型来检测显著性。后来,FT模型由Achanta等[9]提出,利用颜色以及亮度特征的中心周围算子来得到显著映射。Xie等[10]通过利用中低层次线索,在贝叶斯框架内提出了一种自下而上显著性的新模型。更多的总结可以参考Fan等[11]的研究。

1.2 基于深度学习的显著性对象检测方法

在最近几年中,深度学习已经在显著性对象检测领域被广泛应用。Wang等[12]通过训练2个深度神经网络,将超像素的局部估计和全局建议相结合检测显著性。受到全卷积神经网络(fully convolutional networks, FCNs)成功的启发[5],很多研究开始在全卷积神经网络的基础上展开。Zhang等[13]提出一种新颖的全卷积神经网络模型,在解码部分设计了混合上采样方法,在一定程度上解决了反卷积“棋盘效应”的问题。Li等[14]提出了基于FCN的多任务模型,通过显著性对象检测和图像分割这2个相关任务的协作学习,对有效信息进行编码。Hu等[15]将深度神经网络和水平集的方法巧妙结合,使显著性对象边界模糊的问题得到了改善。

然而本文认为,在自然图像中,对象的大小不同,形状万千,在这种情况下,多尺度特征的提取尤为重要,并且,在扩大感受野的同时,还要兼顾特征的分辨率以及空间细节特征的保留,如何得到丰富而不冗余的多尺度特征,并保留显著性对象的边缘轮廓特征,从而得到完整、边缘轮廓清晰的显著性对象,仍是一个值得继续研究的问题。因此,本文提出了基于金字塔特征与边缘优化的显著性对象检测模型,采用注意力嵌入的密集空洞金字塔模块(AEDAPM)并结合渐进边缘优化模块(SEOM),共同检测自然图像中的显著对象。

2 本文方法

2.1 网络架构

本文提出了一个基于注意力嵌入的金字塔特征以及渐进边缘优化的显著性对象检测网络(attention embedded pyramid feature and stepped edge optimized based salient object detection network, ASNet)模型。图1展示了它的总体架构。模型是以VGG-16为骨干特征提取器的全卷积神经网络结构。首先,将图像输入到VGG-16的前4个卷积块中,逐层提取图像特征。通常浅层卷积块会提取低级的空间结构特征,深层的卷积结构会提取高级语义特征。接着,将从VGG-16中提取到的特征输入到由扩张卷积构成的注意力嵌入的密集空洞金字塔模块(AEDAPM),该模块中,利用一系列带“孔”的卷积去处理特征映射,从而在不减小特征分辨率的前提下,得到丰富的多尺度特征。同时,该模块还嵌入了通道注意力机制,对不同通道的特征进行过滤,从而让多尺度特征更加合理有效。然后,从AEDAPM中得到的多尺度特征会传入解码模块中逐步恢复分辨率,在此过程中,网络模型会将从VGG-16中得到的空间结构特征相继传入本文设计的渐进边缘优化模块(SEOM),逐步清晰显示对象的边缘轮廓。

图1 ASNet总体架构

Figure 1 ASNet overall architecture

2.2 注意力嵌入的密集空洞金字塔模块

在自然图像中,往往包括多个大小不同、形状多变的对象,这就要求深度神经网络可以捕获丰富的多尺度上下文特征。然而,大多数已存在的方法通常直接使用堆叠的卷积层和池化层来解决这一问题,但这样做不仅会丢失空间细节信息,而且无法有效应对复杂多变的情况。对此,Yang等[6]提出了用一系列扩张卷积构成DenseASPP模块去提取多尺度上下文特征。受此启发,本文设计了一个有注意力嵌入的密集空洞金字塔模块(AEDAPM),在不改变特征分辨率的前提下,多样化扩大感受野,同时嵌入注意力机制,对这些不同感受野下得到的特征产生不同程度的响应,而不是简单地将其均等对待。

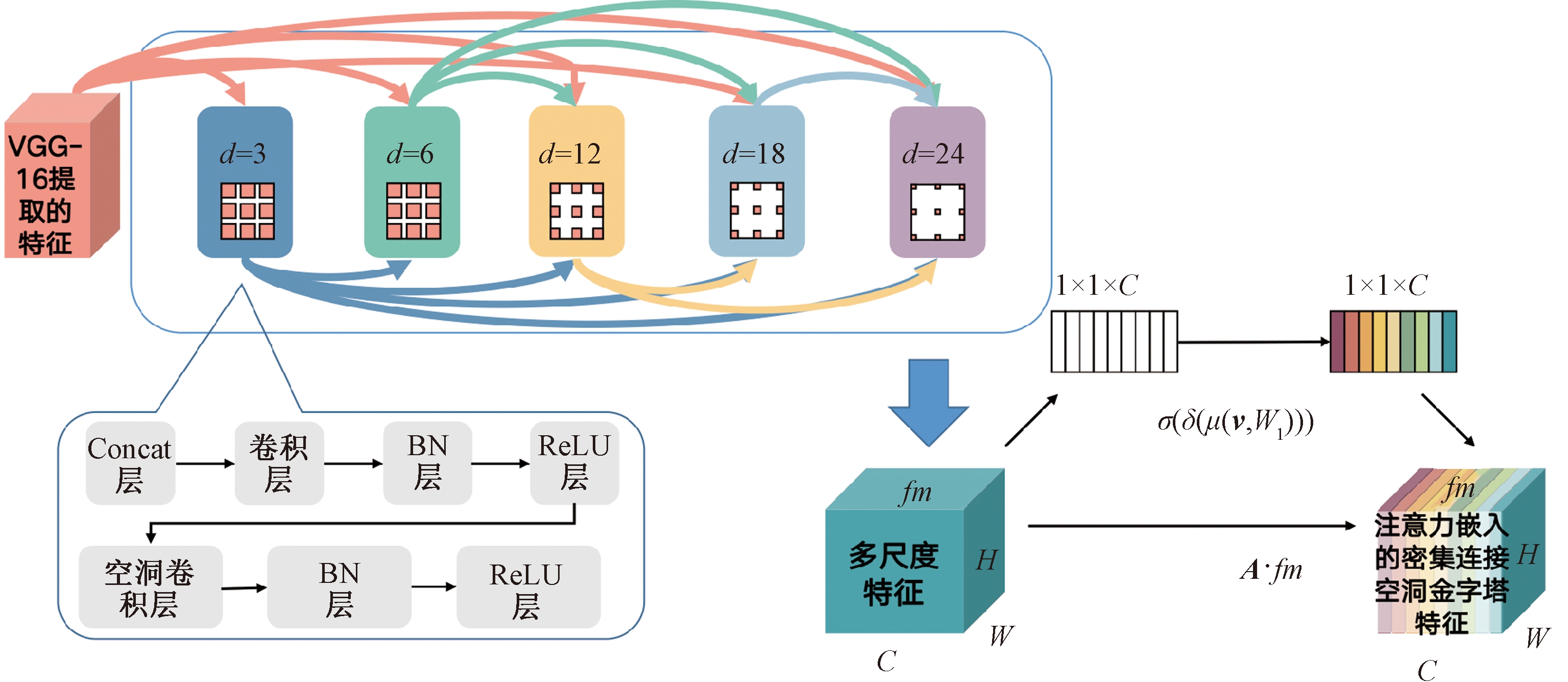

具体来说,AEDAPM的网络结构如图2所示。首先,将来自于骨干特征提取网络的各个卷积块中池化层输出的特征定义为{E1,E2,E3,E4},将E4作为该模块的输入,为了使最终提取的高级特征能够适应对象大小、形状的多变性,应用了多个具有不同扩张率(r=3,6,12,18,24)的空洞卷积块来处理输入的特征,每个卷积块都包含一个输出通道为64、扩张率为r且卷积核大小为3×3的空洞卷积层,用于防止过拟合的BN层以及为了提高模型的表达能力的ReLU激活层。空洞卷积是指在一般的卷积核中加入不同大小的“孔”,从而让该卷积的感受野增大,并且不会减小特征的分辨率。然而,空洞卷积也存在天然的缺陷,即“棋盘效应”,对此,通过密集连接的方式将较浅的扩张卷积层的输出与其输入相连接,并继续输送到更深的扩张卷积层中,如式(1)所示:

图2 注意力嵌入的密集空洞金字塔模块

Figure 2 Attention embedded dense atrous pyramid module

yl=Conv1([yl-1,yl-2,…,y0])。

(1)

式中:yl为扩张率为l的空洞卷积块的输入;Conv1代表包含输出通道为256且卷积核大小为1×1的卷积层、BN层、以及ReLU激活层的卷积块;[yl-1,yl-2,…,y0]表示将之前各层的输出串联起来形成特征,其目的是为了让不同感受野下得到的特征更好地融合,进而输入到下一个空洞卷积块中。

密集的结构让不同扩张率的扩张卷积之间可以相互依赖,构成密集特征金字塔,缓解“棋盘效应”,同时也可以获得更大的感受野。如式(2)所示,注意力嵌入的密集空洞金字塔模块最大的感受野为128。

Rmax=R3,3+R3,6+R3,12+R3,18+R3,24=128。

(2)

式中:RK,d表示卷积核大小为K,扩张率为d的扩张卷积的感受野。

在原始的DenseASPP中,当特征通过最后一个空洞卷积块后,会将每一个空洞卷积块以及该模块所输入的初始特征相串联,作为DenseASPP模块最终输出的多尺度的上下文特征。然而,由于不同通道的特征映射了不同的语义,如果将它们不加以区别地集成为多尺度特征,会导致信息冗余。所以本文与DenseASPP有所区别的是嵌入了通道注意力机制,对不同通道的特征进行过滤,向对显著对象有较高响应的通道分配较高的权值,同时向表示非显著区域特征的通道分配较低的权值,削弱非显著的背景信息,产生更加合理的多尺度特征。

将原始DenseASPP的输出f∈RW×H×C展开为f=[f1,f2,…,fC],其中fi∈RW×H是f的第i个切片,C是f的总通道数。首先,对每个fi进行平均池化从而获得通道级特征向量v∈RC,之后,利用全连接层去捕获通道间的相关性,接着,通过sigmoid激活函数将特征映射到[0,1],从而获得每个通道的注意力权值A。具体过程为

(3)

式中:A为每个通道的注意力权值;v表示通道级特征向量;W为该通道注意力机制中的参数;σ为sigmoid激活函数;δ为ReLU激活函数;μ为全连接层;W1为全连接层中的参数。

最后,使用注意力权值A对原始多尺度特征fm进行加权,从而获得注意力嵌入的密集连接空洞金字塔特征![]() :

:

(4)

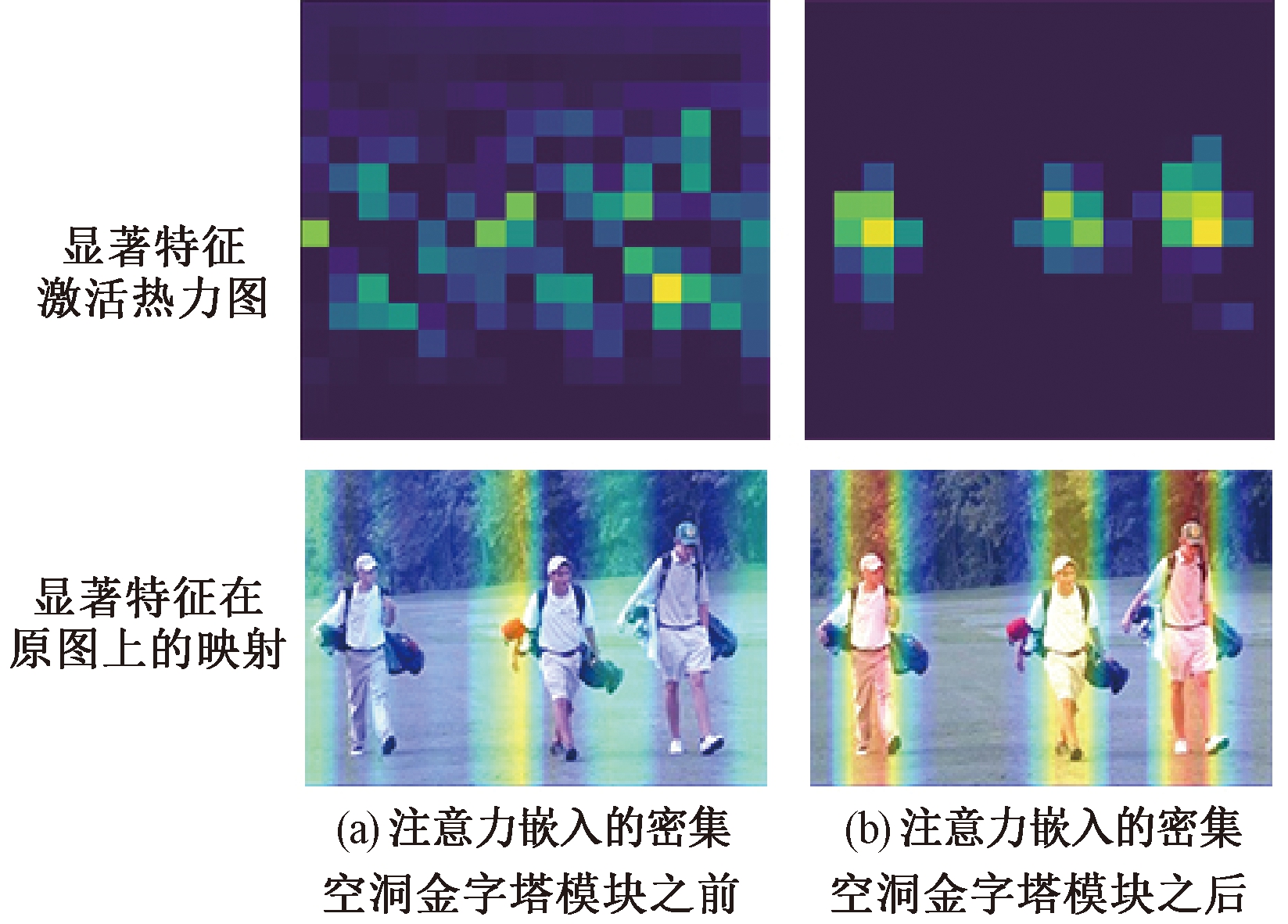

图3展示了该模块前后的特征可视化结果。在该模块之前,网络提取到的特征比较杂乱,不能区分明显的显著对象,在该模块之后,由于密集空洞卷积对感受野的多样化扩大,以及注意力机制对特征的有效选择,使网络提取的特征对显著区域具有了高响应性,从而准确地获得了多个大小不同、位置不一的显著性对象。

图3 注意力嵌入的密集空洞金字塔模块前后的特征可视化

Figure 3 Visualization of feature maps around attention embedded dense atrous pyramid module

2.3 渐进边缘优化模块

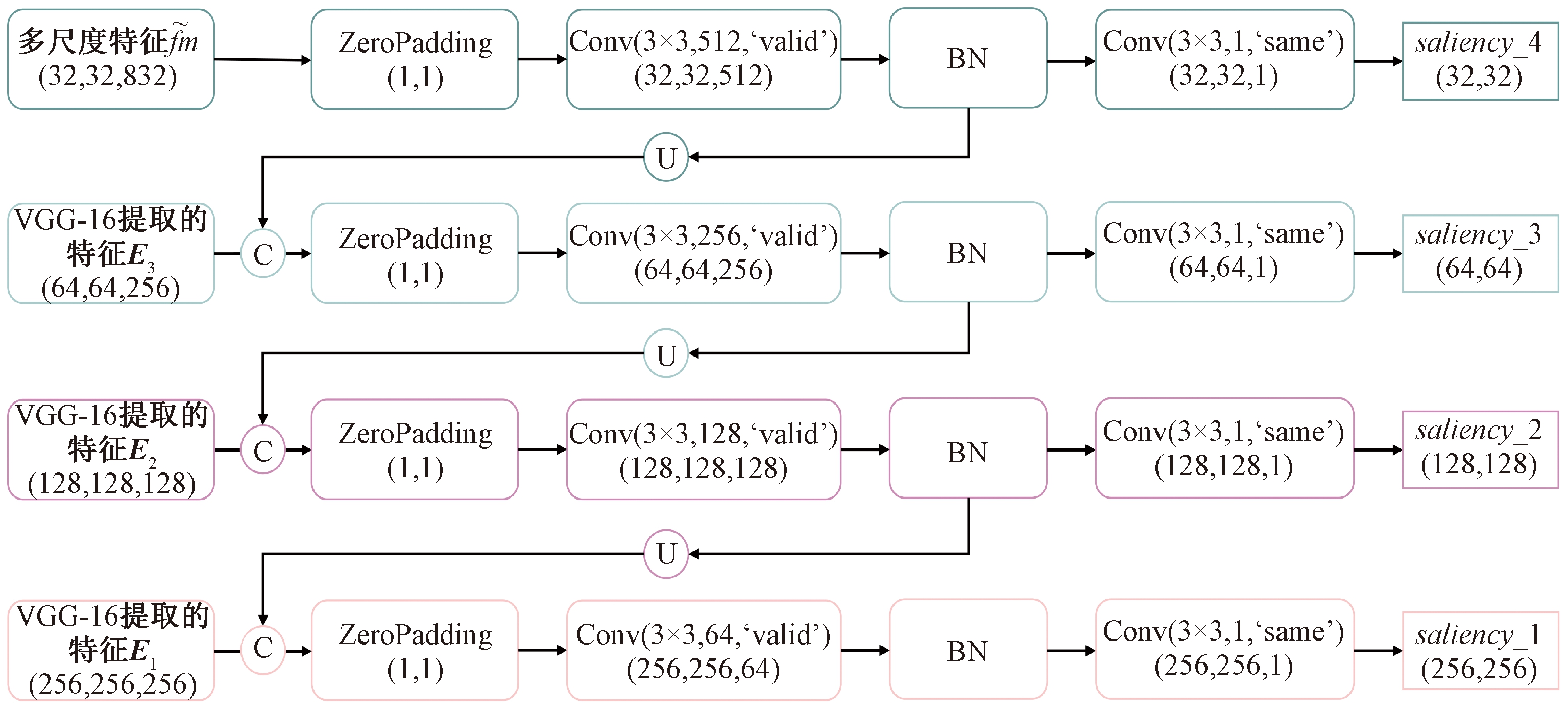

显著性对象的边缘模糊一直是该领域的热点问题。本文认为,深层特征中往往包含更多的语义特征,而浅层特征中包含更多的空间结构特征,仅仅用高级语义特征去检测显著性对象无法得到清晰的边界轮廓。由于浅层的特征中保留了更多的空间细节,适合于定位边界,所以借助渐进边缘优化模块,向最终进行显著性检测的特征中依次补充从骨干特征提取网络中提取的各级浅层特征,以此来得到更加清晰的边缘轮廓。

渐进边缘优化模块的结构如图4所示。将来自于注意力嵌入的密集连接空洞金字塔模块特征![]() 作为该模块的输入,并定义该模块中的卷积块Hi为ZeroPadding(1,1)→Conv(3×3,Ni,‘valid’)→BN,Ni为与当前特征分辨率相同的底层特征Ci的通道数。首先,将

作为该模块的输入,并定义该模块中的卷积块Hi为ZeroPadding(1,1)→Conv(3×3,Ni,‘valid’)→BN,Ni为与当前特征分辨率相同的底层特征Ci的通道数。首先,将![]() 通过卷积块得到显著特征S4;然后,通过式(5)依次得到显著特征{S3,S2,S1}。

通过卷积块得到显著特征S4;然后,通过式(5)依次得到显著特征{S3,S2,S1}。

图4 渐进边缘优化模块

Figure 4 Stepped edge optimization module

A=F(v,W)=σ(δ(μ(v,W1)))。

Si-1=Hi-1(Concat(UpSampling(Si,Ci))。

(5)

式中:Hi-1为第(i-1)个卷积块;Concat为连接层;UpSampling为上采样层;Si为第i个显著特征;Ci为第i个来自于骨干特征提取网络的特征。即每一次将特征上采样后,都将其与来自底层网络的相同分辨率的特征相串联,以补充相应的空间信息,并经过卷积层进行充分融合。

为了使每一次边缘优化都能够从底层网络中获取对显著性检测有用的特征,而不是引入噪声,因此在每一个Si之后,都设置了一个输出通道为1、卷积核大小为3×3的卷积层,并将得到的显著映射{saliency_4,saliency_3,saliency_2,saliency_1}作为输出,将原始的标注结果分别调整到与各个显著映射大小相同的分辨率(256×256、128×128、64×64、32×32),并计算其损失,监督每一个边缘优化块从底层网络中提取出有效的空间细节信息,从而使得显著映射中显著性对象的边缘逐步清晰。

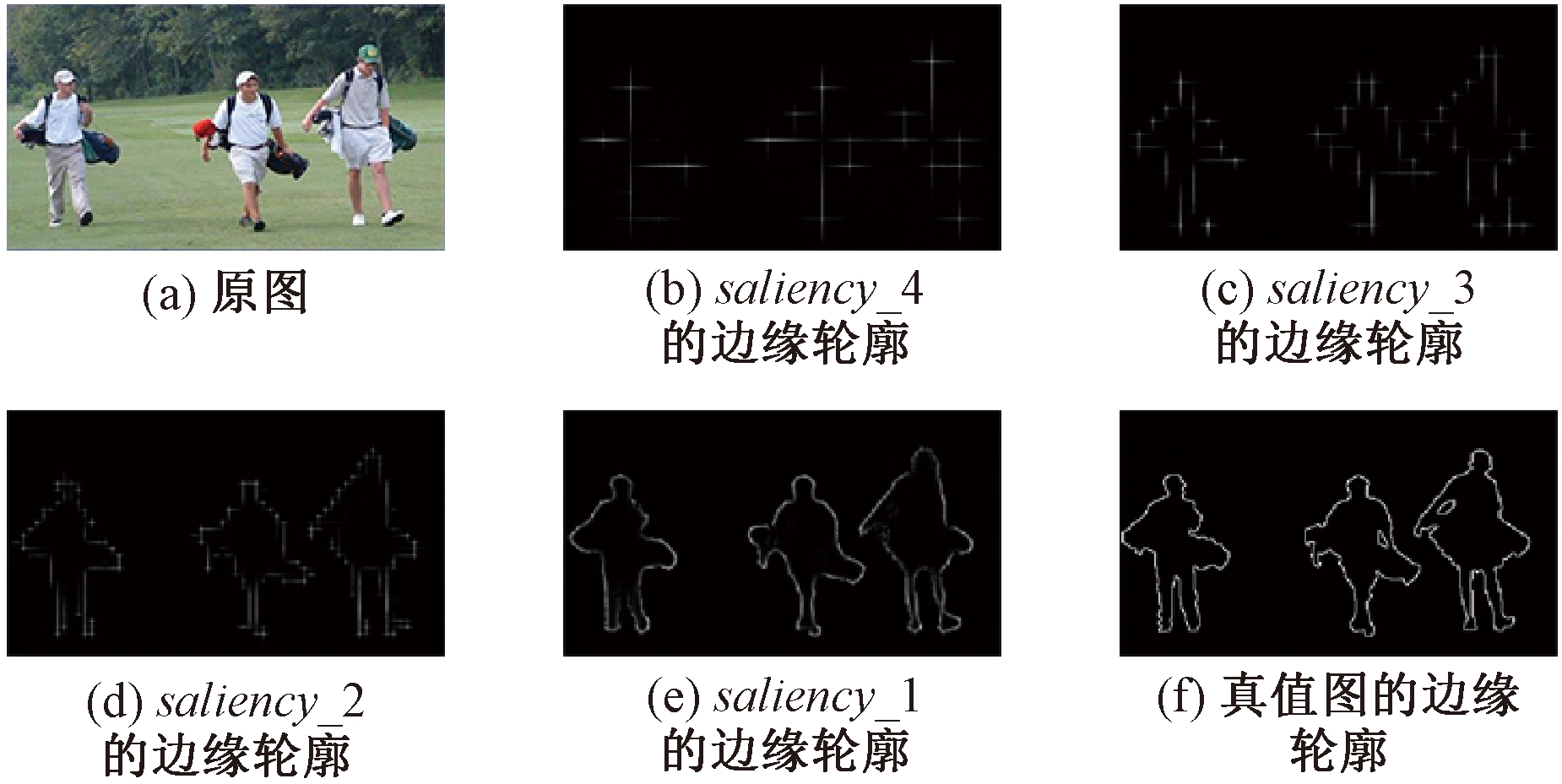

图5展示了渐进边缘优化模块中每一次优化后所得的显著映射的边缘轮廓,可以看出,得益于各级底层网络特征的补充,显著性对象的边缘轮廓也逐渐清晰,一步步接近真值图的边缘轮廓。该模块对网络性能指标的提升将在3.3节中详细介绍。

图5 渐进边缘优化模块中每一次优化所得到的边缘轮廓可视化

Figure 5 Visualization of edges obtained with every optimization in stepped edge optimization module

2.4 实现细节

2.4.1 损失函数

受Wang等[16]的启发,考虑多种评价指标,利用融合的损失函数进行显著性预测,如式(6)所示:

Loss=LC+LM。

(6)

式中:LC表示交叉熵损失函数;LM表示平均绝对误差损失函数。

LC的定义如下:

(7)

LM的定义如下:

(8)

式中:lx,y∈{0,1}表示像素(x,y)的标签;Px,y表示像素(x,y)的预测值。

2.4.2 训练数据集

使用DUTS-train数据集[17]来训练网络,它包含10 553张图像。

为了使模型拥有足够强的泛化能力,在训练时使用了数据增强技术。具体来说,使用了随机角度变换、水平或垂直方向上平移、随机错切变换角度、图像水平翻转,从而使图像增强至65 k。

2.4.3 其他细节

本文模型使用Keras框架来实现。主干特征提取网络的参数由在ImageNet上预训练的VGG-16进行初始化,对于其他卷积层,采用截断法初始化它们的参数。训练时,所有的图像和真值图的分辨率都被调整为256×256。模型的初始学习率被设置为10-4,使用Adam算法在NVIDIA GTX 1 080 Ti GPU显卡上进行训练,直至模型参数收敛。

3 实验部分

3.1 数据集和评价指标

在显著性领域中常用的5个公开数据集上对本文的网络模型进行性能评价,5个数据集为DUTS-TE[17]、HKU-IS[18]、DUT-OMRON[19]、PASCAL-S[20]和ECSSD[21]。

与其他最新的显著性对象检测方法相同,本文选用了3种流行的的评价指标对性能进行评估:精确率-召回率曲线、F值以及平均绝对误差MAE。

3.2 性能比较

将本文的方法与其他12种经典、主流的显著性对象检测方法在5个公开数据集上进行了比较,对象检测方法分别是:AMU[22]、DCL[23]、DLS[15]、DS[14]、ELD[24]、KSR[25]、LEGS[12]、MCDL[26]、MDF[18]、UCF[13]、CapSal[27]、CAN[28]。

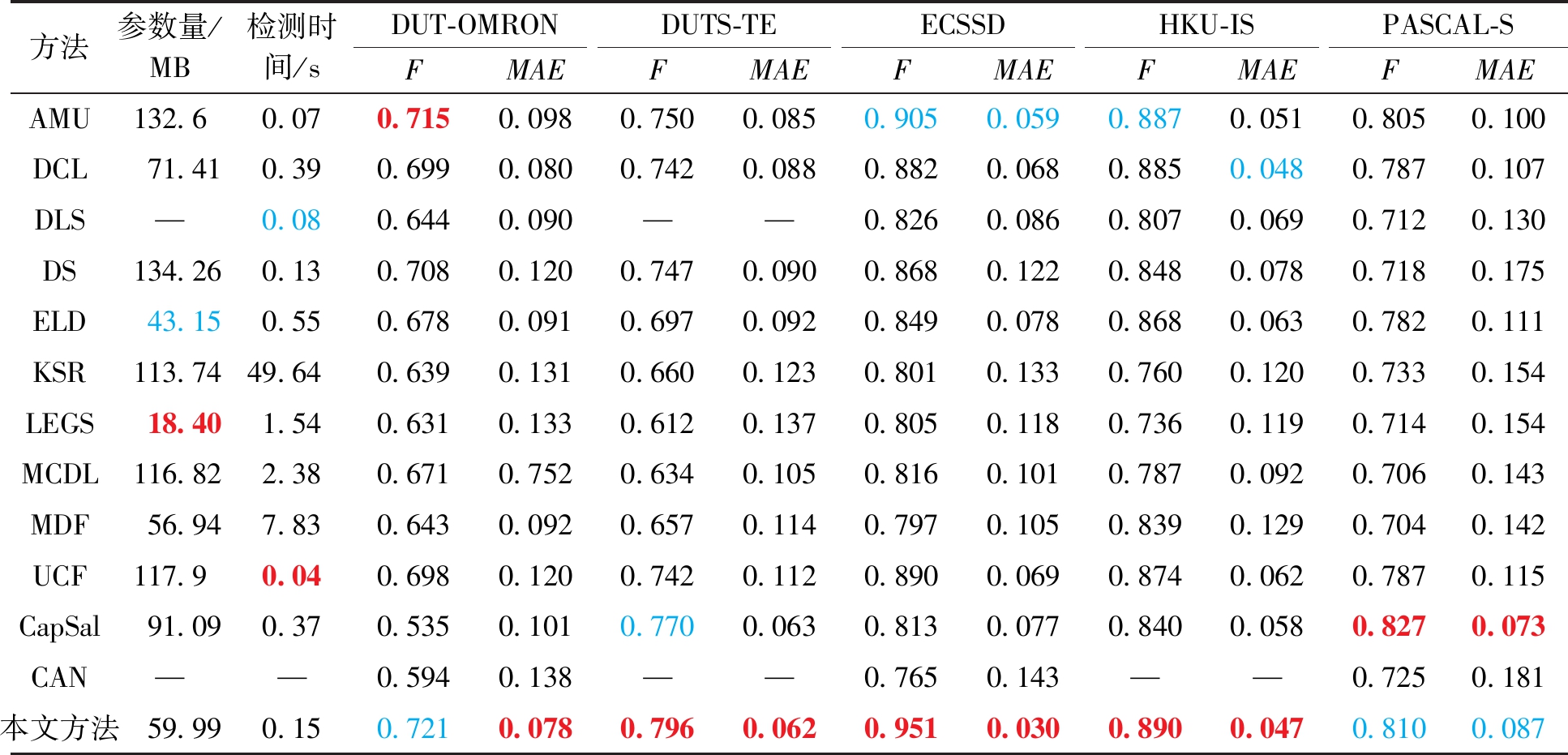

3.2.1 定量评价

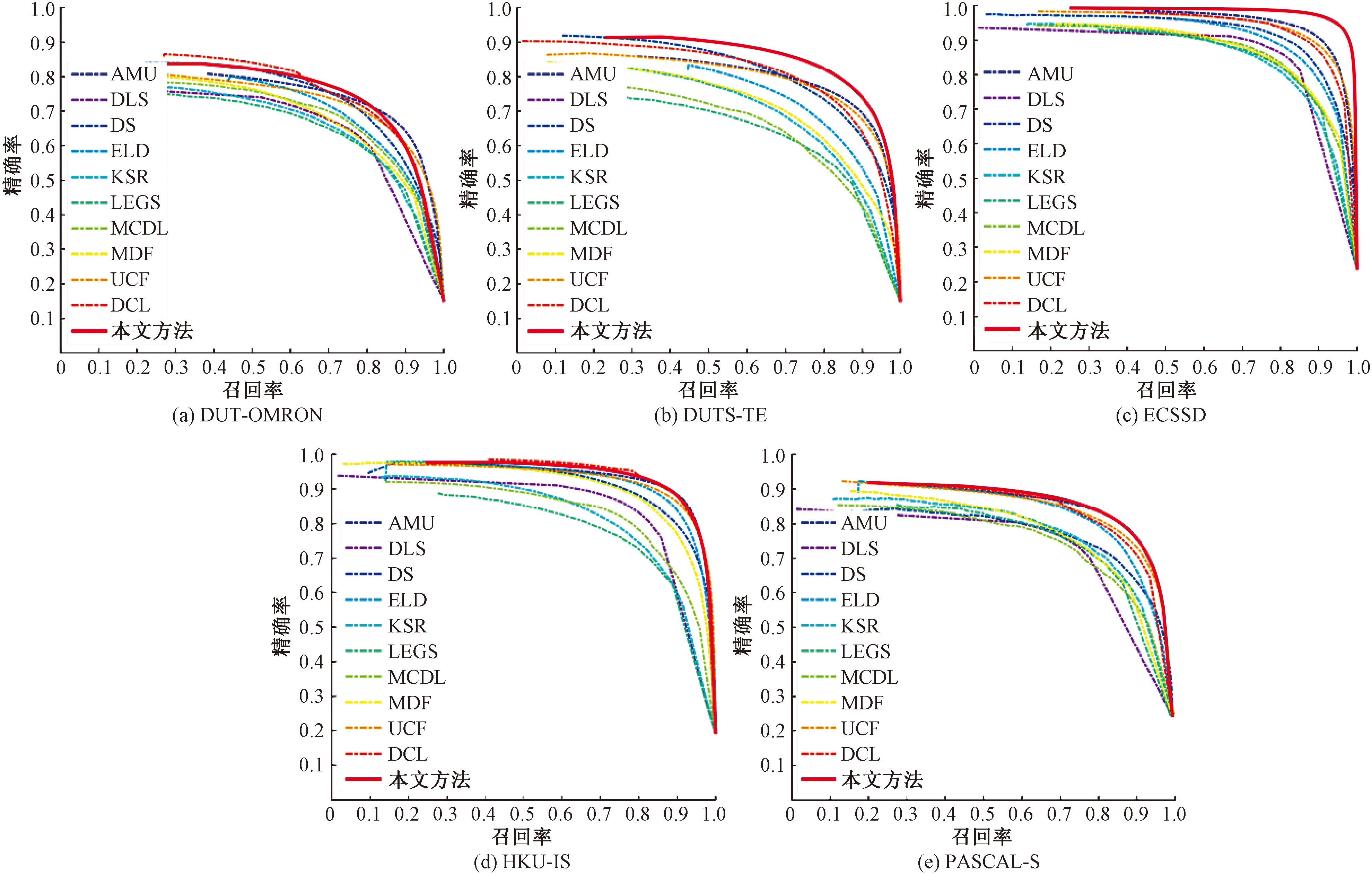

表1和图6展示了本文方法与其他方法在5个数据集上定量比较的结果。表1显示了不同方法在不同数据集上所测得的F值、平均绝对误差MAE、模型参数量和检测时间,图6则展示了对应的精确率-召回率曲线。总体而言,本文方法使用所有的评价指标在5个数据集中都取得了很好的结果。

图6 5个数据集上的精确率-召回率曲线

Figure 6 Precision-recall curves on five datasets

表1 不同显著性检测方法在5个公开数据集上的F值和MAE、参数量以及检测时间的对比结果

Table 1 The maximum F, MAE, parameter quantity and detection speed of different saliency detection methods on five released saliency detection datasets

方法参数量/MB检测时间/sDUT-OMRONDUTS-TEECSSDHKU-ISPASCAL-SFMAEFMAEFMAEFMAEFMAEAMU132.60.070.7150.0980.7500.0850.9050.0590.8870.0510.8050.100DCL71.410.390.6990.0800.7420.0880.8820.0680.8850.0480.7870.107DLS—0.080.6440.090——0.8260.0860.8070.0690.7120.130DS134.260.130.7080.1200.7470.0900.8680.1220.8480.0780.7180.175ELD43.150.550.6780.0910.6970.0920.8490.0780.8680.0630.7820.111KSR113.7449.640.6390.1310.6600.1230.8010.1330.7600.1200.7330.154LEGS18.401.540.6310.1330.6120.1370.8050.1180.7360.1190.7140.154MCDL116.822.380.6710.7520.6340.1050.8160.1010.7870.0920.7060.143MDF56.947.830.6430.0920.6570.1140.7970.1050.8390.1290.7040.142UCF117.90.040.6980.1200.7420.1120.8900.0690.8740.0620.7870.115CapSal91.090.370.5350.1010.7700.0630.8130.0770.8400.0580.8270.073CAN——0.5940.138——0.7650.143——0.7250.181本文方法59.990.150.7210.0780.7960.0620.9510.0300.8900.0470.8100.087

注:红色(加粗)字体表示最优结果,蓝色(浅色)字体表示次优结果。

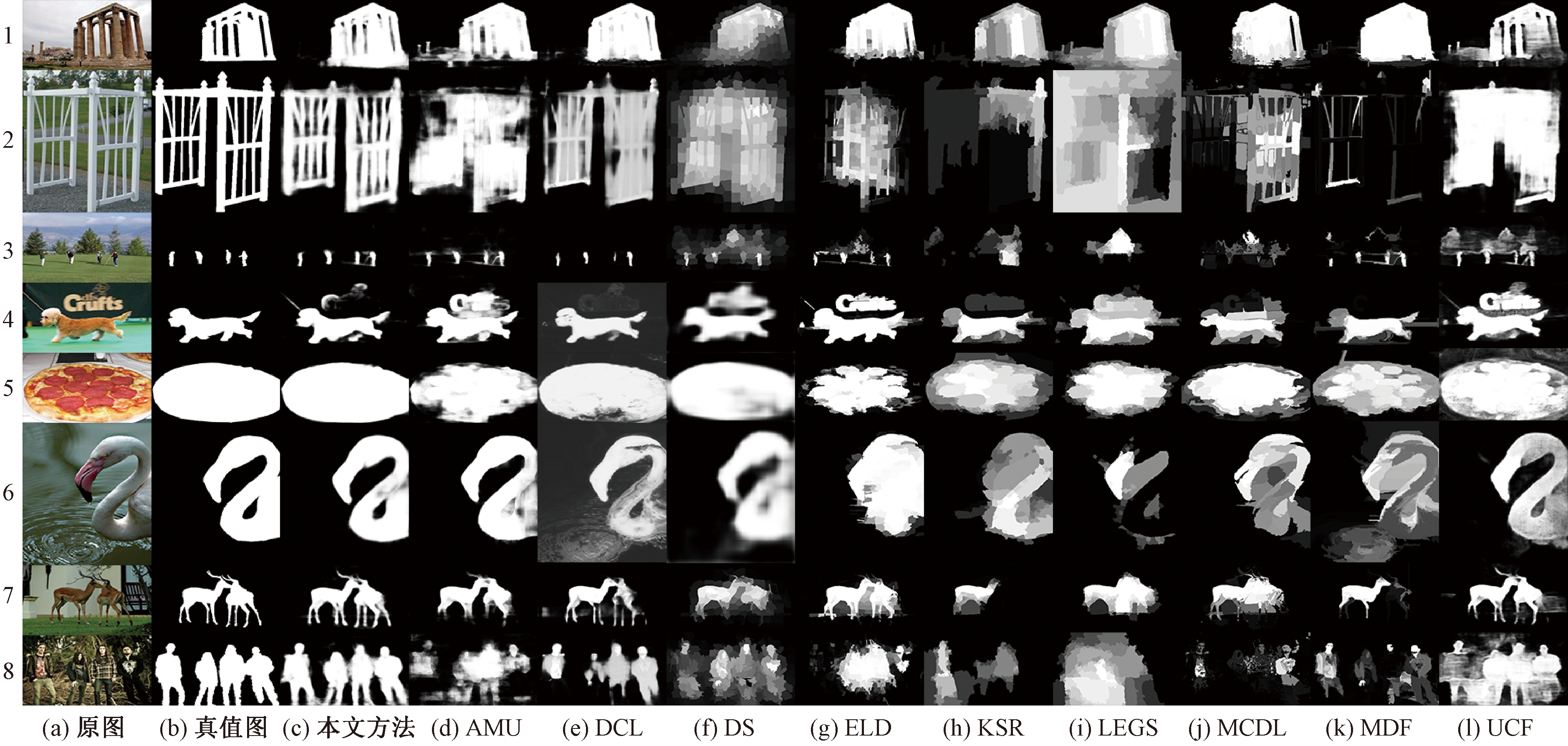

3.2.2 定性评价

图7显示了本文模型与其他显著性对象检测模型所生成的显著映射的对比结果。可以看出,本文方法相比于其他方法来说,无论是单一物体的简单场景(图7第4、5行)、存在多个大小不同的对象的场景(图7第3、7行)、存在多个断开连接的物体的情况(图7第1、2、6行)、对象与背景的色彩对比度差异较低的情况(图7第8行),不仅可以准确地检测出其中所有的显著对象,并且可以获得更加清晰的边缘轮廓。这得益于本文提出的AEDAPM和SEOM网络结构,使网络具有更好的特征提取能力和边缘检测能力,从而让显著映射具有更完整的显著区域和更清晰的边缘轮廓。

图7 不同方法的实验结果对比

Figure 7 Qualitative comparisons of different SOD methods

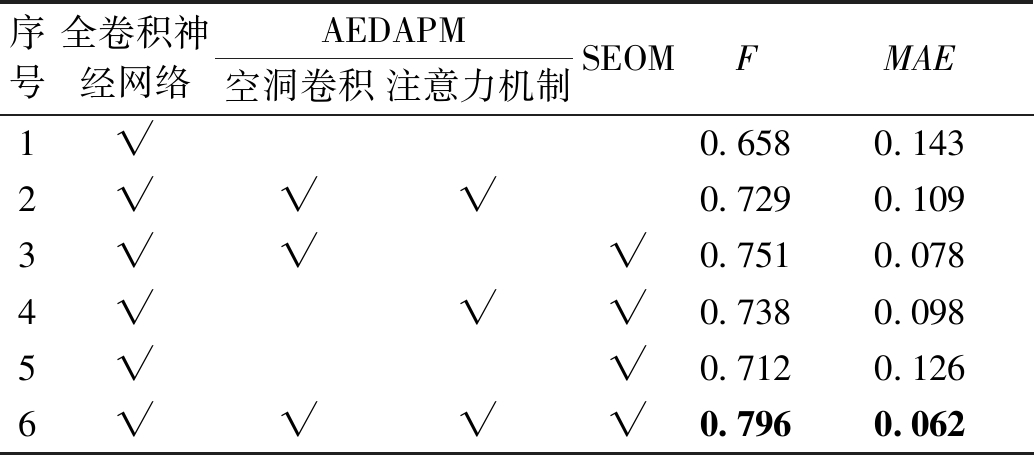

3.3 消融实验

本文提出的网络模型主要由2个模块组成:注意力嵌入的密集空洞金字塔模块(AEDAPM)和渐进边缘优化模块(SEOM)。为了检测2个模块的有效性,进行了以下的消融实验。如表2所示,当模型包含所有模块时,能够取得最好的性能表现,当分别去掉了AEDAPM和SEOM时,精度都会有一定程度的下降,这说明所有组件对于该方法获得最佳的结果而言都是必要的。

表2 AEDAPM和SEOM的消融实验

Table 2 Ablation study for AEDAPM and SEOM

序号全卷积神经网络AEDAPM空洞卷积注意力机制SEOMFMAE1√0.6580.1432√√√0.7290.1093√√√0.7510.0784√√√0.7380.0985√√0.7120.1266√√√√0.7960.062

注:√表示该实验的网络包含这一模块,加粗字体为最优值。

首先使用基本的全卷积网络作为基本模型。其次,将AEDAPM单独添加到网络中(对比第1行和第2行),F值以及MAE分别优化了10.79%和23.78%,这说明了本文提出的AEDAPM能够获得更加丰富的多尺度特征,从而提高模型的表征能力。此外,将SEOM单独添加到基本的全卷积网络中(对比第1行和第5行),F值以及MAE分别优化了8.2%和11.89%,这表明SEOM能够让网络补充浅层的空间细节信息,同时避免冗杂背景信息的干扰。

此外,对AEDAPM中空洞卷积和注意力机制的影响作出了进一步的对比和分析。由表2的第3、4行所示,空洞卷积比注意力机制对网络的影响更大,这说明空洞卷积对于网络感受野的丰富要比注意力机制对特征产生不同程度的响应更加重要。

4 结论

本文提出了一个新颖的基于金字塔特征与边缘优化的显著性对象检测模型,采用由扩张卷积构成的注意力嵌入的密集空洞金字塔模块(AEDAPM)获取不同感受野下不同尺度的上下文信息,以此检测不同大小、形状的显著性对象,同时设计了渐进边缘优化模块(SEOM),用于补充更加丰富而不冗余的空间细节特征,使显著性对象的边缘轮廓更加清晰。本文提出的方法在多个公开的显著性对象检测数据集上与其他主流方法相比,都能得到更加准确、对象边缘更加清晰的结果。

[1] 杨文柱,刘晴,王思乐,等.基于深度卷积神经网络的羽绒图像识别[J].郑州大学学报(工学版),2018,39(2):11-17.

[2] 张震,李浩方,李孟洲,等.改进YOLOv3算法与人体信息数据融合的视频监控检测方法[J].郑州大学学报(工学版),2021,42(1):28-34.

[3] BORJI A,FRINTROP S,SIHITE D N,et al.Adaptive object tracking by learning background context[C]//2012 IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops.Piscataway: IEEE,2012:23-30.

[4] 魏宏彬,张端金,杜广明,等.基于改进型YOLO v3的蔬菜识别算法[J].郑州大学学报(工学版),2020,41(2):7-12,31.

[5] LONG J,SHELHAMER E,DARRELL T.Fully convolutional networks for semantic segmentation[C]//2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Piscataway:IEEE,2015:3431-3440.

[6] YANG M K,YU K,ZHANG C,et al.DenseASPP for semantic segmentation in street scenes[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Piscataway:IEEE,2018:3684-3692.

[7] ITTI L,KOCH C,NIEBUR E.A model of saliency-based visual attention for rapid scene analysis[J].IEEE transactions on pattern analysis and machine intelligence,1998,20(11):1254-1259.

[8] HOU X D,ZHANG L Q.Saliency detection:a spectral residual approach[C]//2007 IEEE Conference on Computer Vision and Pattern Recognition.Piscataway:IEEE,2007:1-8.

[9] ACHANTA R,HEMAMI S,ESTRADA F,et al.Frequency-tuned salient region detection[C]//2009 IEEE Conference on Computer Vision and Pattern Recognition.Piscataway:IEEE,2009:1597-1604.

[10] XIE Y,LU H,YANG M H.Bayesian saliency via low and mid level cues[J].IEEE transactions on image processing,2013,22(5):1689-1698.

[11] FAN D P, CHENG M M, LIU J J, et al. Salient objects in clutter: bringing salient object detection to the foreground[C]// European Conference on Computer Vision. Springer: Cham, 2018:438-445.

[12] WANG L J,LU H C,RUAN X,et al.Deep networks for saliency detection via local estimation and global search[C]//2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Piscataway:IEEE,2015:3183-3192.

[13] ZHANG P P,WANG D,LU H C,et al.Learning uncertain convolutional features for accurate saliency detection[C]//2017 IEEE International Conference on Computer Vision (ICCV).Piscataway:IEEE,2017:212-221.

[14] LI X,ZHAO L M,WEI L N,et al.DeepSaliency:multi-task deep neural network model for salient object detection[J].IEEE transactions on image processing,2016,25(8):3919-3930.

[15] HU P,SHUAI B,LIU J,et al.Deep level sets for salient object detection[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Pisca-taway:IEEE,2017:540-549.

[16] WANG W G,SHEN J B,DONG X P,et al.Salient object detection driven by fixation prediction[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Piscataway:2018:1711-1720.

[17] WANG L J,LU H C,WANG Y F,et al.Learning to detect salient objects with image-level supervision[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Piscataway:IEEE,2017:3796-3805.

[18] LI G B,YU Y Z.Visual saliency based on multiscale deep features[C]//2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Piscataway:IEEE,2015:5455-5463.

[19] YANG C,ZHANG L H,LU H C,et al.Saliency detection via graph-based manifold ranking[C]//2013 IEEE Conference on Computer Vision and Pattern Recognition.Piscataway:IEEE,2013:3166-3173.

[20] LI Y,HOU X D,KOCH C,et al.The secrets of salient object segmentation[C]//2014 IEEE Conference on Computer Vision and Pattern Recognition.Piscataway:IEEE,2014:280-287.

[21] YAN Q,XU L,SHI J P,et al.Hierarchical saliency detection[C]//2013 IEEE Conference on Computer Vision and Pattern Recognition.Piscataway:IEEE,2013:1155-1162.

[22] ZHANG P P,WANG D,LU H C,et al.Amulet:aggregating multi-level convolutional features for salient object detection[C]//2017 IEEE International Conference on Computer Vision (ICCV).Piscataway:IEEE,2017:202-211.

[23] LI G B,YU Y Z.Deep contrast learning for salient object detection[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Pisca-taway:IEEE,2016:478-487.

[24] LEE G,TAI Y W,KIM J.Deep saliency with encoded low level distance map and high level features[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Piscataway:IEEE,2016:660-668.

[25] WANG T T,ZHANG L H,LU H C,et al.Kernelized subspace ranking for saliency detection[M].Computer Vision-ECCV 2016.Cham:Springer International Publishing,2016:450-466.

[26] ZHAO R,OUYANG W L,LI H S,et al.Saliency detection by multi-context deep learning[C]//2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Piscataway:IEEE,2015:1265-1274.

[27] ZHANG L,ZHANG J M,LIN Z,et al.CapSal:leveraging captioning to boost semantics for salient object detection[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).Piscataway:IEEE,2019:6017-6026.

[28] 刘尚旺,赵欣莹,杨磊.基于全局和局部信息融合的显著性检测[J]. 河南师范大学学报(自然科学版), 2020, 48(3): 26-33.