0 引言

目标跟踪是计算机视觉领域的重要研究内容,也是计算机视觉领域的难点之一,除了光照变化、障碍物遮挡等环境影响,目标本身的旋转、尺度变化及出视野情况都对进行准确的目标跟踪造成挑战[1]。根据观测模型的不同,可将视觉目标跟踪方法分为生成式方法和判别式方法。比较著名的生成式方法有Meanshift算法[2-3]、粒子滤波算法[4]。生成式方法重点关注对目标本身的刻画,不考虑背景的影响,在目标形变剧烈或遮挡严重时容易产生目标漂移;判别式方法同时考虑了目标和背景信息,在现有跟踪方法中具有明显的优势,其中比较经典且性能突出的判别类方法有FCT算法(fast compressive tracking)[5]和相关滤波算法(correlation filter-based tracking,CFTs)。

相关滤波算法是由Bolme最早引入的,该算法通过相关滤波器(minimum output sum of squared error, MOSSE)[6]来构造一种自适应的训练策略。由于该算法在实时目标跟踪上的优秀表现,此后基于该算法框架的改进算法被相继提出[7-10],其中最有影响力的为Henriques等[7]提出的核相关滤波算法(kernelized correlation filters,KCF)。KCF不仅能以每秒数百帧的速度运行,且实现简单,在VOT(visual object tracking)竞赛测评中展现出明显的高效性和鲁棒性。

传统的相关滤波跟踪算法均是针对短时视频的跟踪研究,而在实际应用中往往需要长时间对目标进行准确跟踪。在进行长时目标跟踪过程中,由于目标的外观变化、周围环境造成的目标遮挡以及光照变化等,传统滤波跟踪算法很容易发生模板漂移现象。

为解决上述问题,提出了一种基于改进核相关滤波的长时目标跟踪算法LKCF(long-term kernelized correlation filter)。该算法以KCF算法为基本跟踪框架,为避免模板漂移,采用了一个高置信度的模版更新机制。另外,通过构造目标重检机制来解决由于遮挡造成的目标丢失问题,以便实现鲁棒的目标跟踪。

1 LKCF算法

1.1 相关滤波原理

设f表示输入图像;h表示相关滤波器;g表示响应输出,则

g=h⊗f,

(1)

式中:g由高斯函数产生;h为滤波器,在跟踪时,将下一帧的搜索窗口与滤波器进行相关计算,目标的新位置根据响应最大值所对应的位置确定。通过快速傅里叶变换,在频率域计算相关性可加快运算速度。另外,由卷积定理可知:

F{g}=(F*(h))⊙F(f),

(2)

式中:F表示傅里叶变换;⊙表示点乘;*表示复数共轭,则有

(3)

1.2 滤波器训练

LKCF采用了KCF的训练机制。在KCF中,对相关滤波器的求解实质是一个岭回归问题,即

(4)

式中:λ为正则化参数,用来控制训练的过拟合;w为权重参数矩阵,用以描述样本x和评分f(x)之间的关系。每一个样本xi对应一个标记yi∈[0,1]。通过各种垂直、水平的循环移位来构建训练样本矩阵X,并采用核函数K将目标x的低维特征空间映射到高维空间。滤波器w的求解空间则被转化到对偶空间α中,核化的岭回归表示为[11]:

α=(K+λI)-1y,

(5)

式中:I为单位矩阵;K是核矩阵,也是一个循环矩阵,由循环矩阵的性质可以继续化解为:

(6)

式中:![]() 为K的第一行元素组成的向量;所求的

为K的第一行元素组成的向量;所求的![]() 即为用于跟踪图像位置的相关滤波器系数。选用高斯函数作为核函数,对于核函数有k(x,x′)=g(xT,x′),则

即为用于跟踪图像位置的相关滤波器系数。选用高斯函数作为核函数,对于核函数有k(x,x′)=g(xT,x′),则

(7)

由高斯核函数的性质可以得到:

(8)

1.3 模板更新机制

传统的相关滤波算法采用的是线性插值方法,该方法能够将最新的特征信息添加到训练模型中,从而简单有效地进行在线跟踪。但是对于实际应用中的复杂环境,相关滤波类算法仍存在着很大挑战,如长时跟踪产生的错误累积问题、目标遮挡时的模板漂移问题等。

针对以上问题,通过分析模板更新时对跟踪阶段的影响,提出了对长时目标跟踪的基本解决方案:①设计了最大响应值和响应模式的稳定度两个指标来反映跟踪器的跟踪置信度,以此避免目标在遇到遮挡和严重形变时的跟踪失败;②运用TLD算法[12]思想将跟踪任务分解为跟踪、学习和检测三部分,以减轻在线模版更新时的错误累积。检测器负责在检测到跟踪失败时重新初始化跟踪器,把跟丢的目标找回并将产生的误差清零,而跟踪器的结果则提供训练数据来更新检测器。

当新一帧进来时,s为上一帧目标位置,当前目标位置为y=φ(s;w)。其中,w的求解转化到对偶空间α中,通过式(6)来计算。通过循环采样获得的整个响应图按下式计算[13]:

(9)

式中:![]() 为岭回归所产生的封闭解的核矩阵;

为岭回归所产生的封闭解的核矩阵;![]() 为回归函数的向量。

为回归函数的向量。

为判断跟踪目标位置的精确度,设定了两个基准。第一个基准是响应图F(s,y;w)中最大响应分数Fmax,定义为:

Fmax=max F(s,y;w),

(10)

如果当前帧的Fmax小于第一个阈值Ta(外观阈值),则调用重检测机制,得到新的响应图F′和相应的![]() 这时如果

这时如果![]() 则固定目标位置框,提取出历史模版的信息。在接下来的视频流中增加搜索窗口的范围,逐帧查找目标位置,直到历史信息的目标框与当前帧的搜索框之间的目标响应大于Ta为止。

则固定目标位置框,提取出历史模版的信息。在接下来的视频流中增加搜索窗口的范围,逐帧查找目标位置,直到历史信息的目标框与当前帧的搜索框之间的目标响应大于Ta为止。

高置信度更新机制的第二个判断基准为平均峰值相关能量(average peak-to correlation energy)[13],即APCE为

(11)

式中:Fmax、Fmin以及Fi,j分别为F(s,y;w)的最大值,最小值和指定的第i行第j列的元素。如果当前帧中的APCE大于算法设定的第二个阈值Tt(运动阈值),则认为当前帧中的跟踪结果是高置信度的。此时,相关滤波模版将会在固定的学习率参数μ下进行在线更新,更新方式如下:

(12)

(13)

式中:t为当前帧的索引。

1.4 LKCF算法流程

步骤1 在首帧中标出欲跟踪目标的位置与尺寸,利用式(6)训练核相关滤波器中的参数;

步骤2 提取下一帧的图像特征ft,并用式(9)计算响应图F(s,y;w);

步骤3 通过式(10)和(11)计算两个判断基准Fmax和APCE;

步骤4 如果Fmax小于第一个阈值Ta则调用检测器Dtf实现重检测机制,得到新的响应图F′和相应的![]() 这时如果

这时如果![]() 则固定目标位置框,调用历史更新中最近的模版信息

则固定目标位置框,调用历史更新中最近的模版信息![]() 加大目标搜索框的padding并重复步骤2、3,计算得

加大目标搜索框的padding并重复步骤2、3,计算得![]() 和相应的

和相应的![]() 直到

直到![]() 时,判断为找回跟踪目标

时,判断为找回跟踪目标![]() 其中

其中![]()

步骤5 保存目标位置信息s=ft;

步骤6 采用APCE基准判断跟踪的置信度,若APCE≥Tt,则用式(12)和(13)来更新滤波模版Ht,否则转到步骤2;

步骤7 更新检测器Dtf,转到步骤2直到视频结束。

2 实验与分析

实验采用13个目标跟踪基准数据库OTB50和OTB100中的具有挑战性的视频序列对提出的算法进行评测,序列涉及了运动模糊(MB)、快速运动(FM)、遮挡(OCC)、背景杂乱(BC)和光照变化(IV)等多种因素。实验结果采用两种度量评估标准:

(1)成功重叠率(OS),即预测边框与实际边框重叠超过阈值的帧占比,可利用有效帧的重叠率均值来计算;

(2)距离精度(DP),即跟踪到的位置与目标实际位置的距离小于指定阈值的帧占比。

2.1 实验配置

实验用电脑的配置:CPU为Intel Core i7,内存4 GB,选择Windows 10操作系统,使用MATLAB 7.0来实现和验证算法。正样本空间α的窗口大小设置为目标大小的1.8倍,搜索窗口的大小设置为目标框空间α的1.5倍。训练过程中的正则化参数λ=10-4。高斯核的![]() 其中n和m是指在特征单元中测量目标的宽度和高度。式(12)和(13)中学习率μ=0.01。检测阶段中的阈值Ta=0.25,Tt=0.5。

其中n和m是指在特征单元中测量目标的宽度和高度。式(12)和(13)中学习率μ=0.01。检测阶段中的阈值Ta=0.25,Tt=0.5。

2.2 实验比较

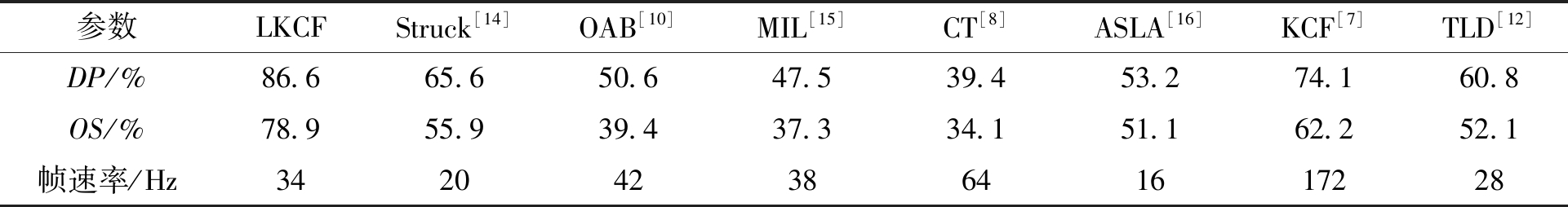

在公共基准数据集OTB100上将LKCF与7种典型的跟踪算法进行了对比实验。7个对比算法包括Struck(structured output tracking with kernels)[14]、TLD(tracking-learn-detection)[12]、在线AdaBoost方法(OAB)[10]、KCF [7]以及依据在线分类器分类的跟踪算法MIL (multiple instance learing)[15]、CT(compressive tracking)[8]和ASLA(adaptive structural local sparse appearance model)[16]。采用距离精度和重叠成功率评估标准[17],以0.5为重叠阈值的重叠率、20个像素内的精度分数以及平均帧速来定量比较,如表1所示。结果显示,LKCF算法的成功重叠率(OS)为78.9%、距离精度(DP)为86.6%,优于其他7个对比算法。虽然KCF的平均OS为62.2%,DP为74.1%,但是KCF的帧速率172 Hz明显比LKCF的34 Hz快。这是由于LKCF算法的重新检测机制增长了检测时间,但在实际应用中仍可满足工程的实时要求。

表1 与其他算法的跟踪结果对比

Table 1 Comparison with other algorithms

参数LKCFStruck[14]OAB[10]MIL[15]CT[8]ASLA[16]KCF[7]TLD[12]DP/%86.665.650.647.539.453.274.160.8OS/%78.955.939.437.334.151.162.252.1帧速率/Hz34204238641617228

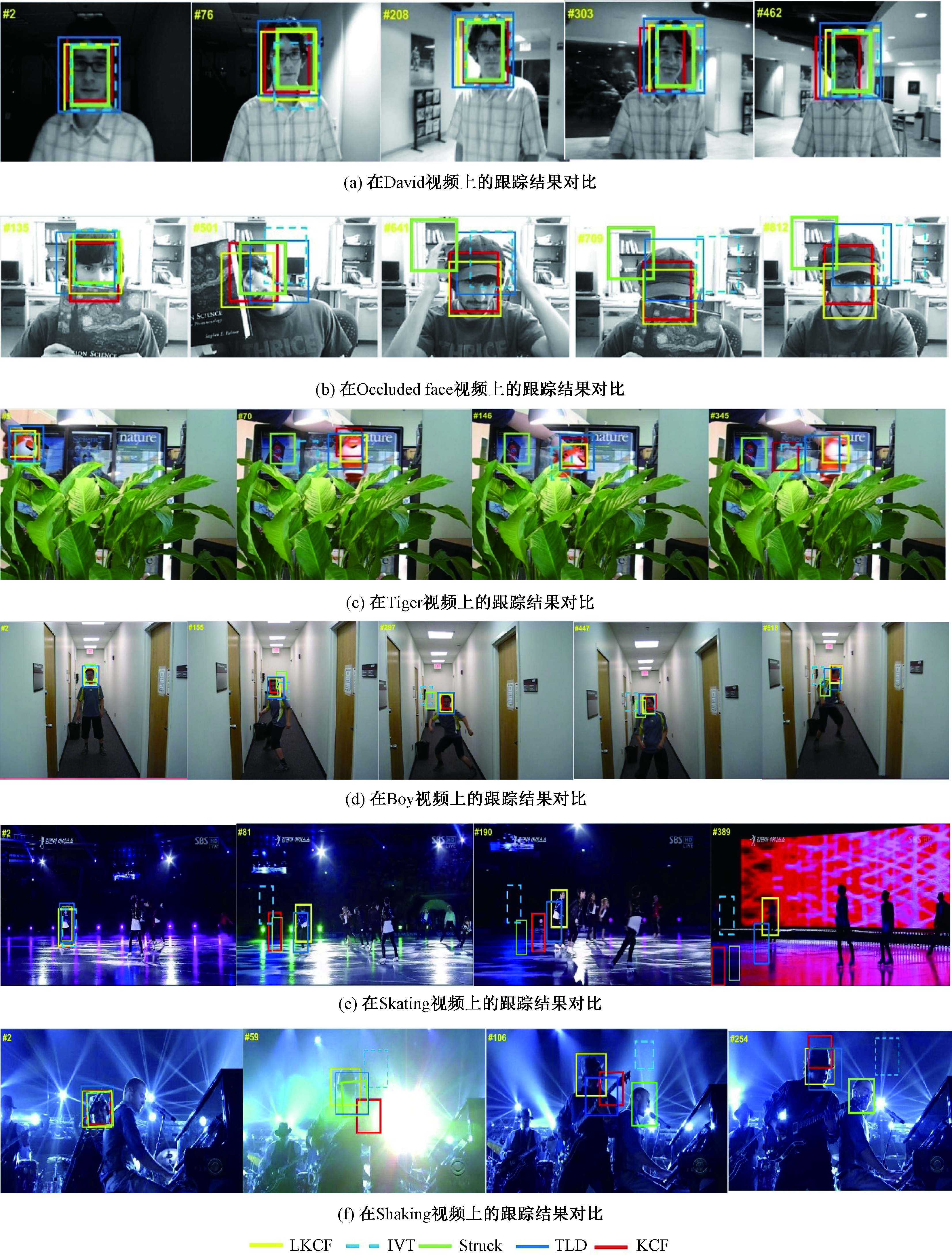

不同环境下目标跟踪效果的分析。将LKCF与其他4个目前最好的追踪器KCF、TLD、IVT(incremental visual tracking)和Struck在公共数据集OTB50上进行了对比,实验效果如图1所示。

图1 不同场景下的跟踪结果对比

Figure 1 Tracking results in different video scenes

在图1(a)中,目标David经历光照变化,所有被测试的算法都可以稳定地跟踪目标,原因在于上述算法均使用了基于PCA的外观模型,可适应目标的外观变化。在图1(b)和图1(c)中,目标对象遭受了重度遮挡,此时只有TLD和LKCF方法可以完成跟踪,因为它们使用了重新检测机制。在图1(d)的快速运动场景下,KCF、TLD和LKCF方法表现良好,而Struck和IVT算法无法在帧#297之后跟踪目标。在图1(e)中,目标的运动方向和背景环境发生了很大变化,大多数算法均丢失了目标,只有LKCF算法能正确跟踪。在图1(f)的杂波背景下,KCF跟踪器由于仅使用了HOG特征,使跟踪目标产生了漂移。相比之下,LKCF和TLD跟踪器由于采用了重新检测机制使得跟踪效果更好。

总之,由于采用了重新检测机制和有条件的模板更新机制,笔者提出的LKCF算法有效避免了检测中的误差累积和模板漂移问题,完整地完成了跟踪任务。

3 结论

通过改进核相关滤波跟踪算法,实现了一种长时核相关滤波目标跟踪算法。①构建了高置信度模版更新机制,使长时目标跟踪中的模板漂移问题得到较好解决;②构造了目标重检机制,以此解决由于遮挡造成的目标丢失问题。实验结果表明,所提算法在处理长时目标跟踪时,相较于传统算法在效率、准确性和鲁棒性方面表现更好。下一步工作将探索更富表现力的特征来描述目标对象,并扩展尺度变换模块来完善目标跟踪器。

[1] 毛晓波,周晓东,刘艳红.基于FAST特征点改进的TLD目标跟踪算法[J].郑州大学学报(工学版),2018,39(2):1-5.

[2] 毛晓波,郝向东,梁静. 基于ELM与Mean Shift的抗遮挡目标跟踪算法[J].郑州大学学报(工学版),2016,37(1):1-5.

[3] HOU Z Q, LIU X, YU W S, et al. Mean-shift tracking algorithm with improved background-weighted histogram[C]//International Conference on Intelligent Systems Design & Engineering Applications.Zhangjiajie,China:IEEE, 2014:597-602.

[4] 宋策. 基于粒子滤波的目标跟踪技术研究[D].长春:中国科学院大学,2014.

[5] ZHANG K H, ZHANG L, YANG M H. Fast compressive tracking[J]. IEEE transactions on pattern analysis & machine intelligence, 2014, 36(10):2002-2015.

[6] 张微,康宝生.相关滤波目标跟踪进展综述[J].中国图象图形学报, 2017,22(8):1017-1033.

[7] HENRIQUES J F, CASEIRO R, MARTINS P, et al. High-speed tracking with kernelized correlation filters[J]. IEEE transactions on pattern analysis & machine intelligence, 2014, 37(3):583-596.

[8] ZHANG K H, ZHANG L, YANG M H. Real-time compressive tracking[C]//European Conference on Computer Vision. Florence,Italy: Springer, 2012:864-877.

[9] DANELLJAN M, HAGER G, KHAN F S, et al. Discriminative scale space tracking[J]. IEEE transactions on pattern analysis & machine intelligence, 2017, 39(8):1561-1575.

[10] GRABNER H, GRABNER M, BISCHOF H. Real-time tracking via on-line boosting[C]//British Machine Vision Conference 2006. Edinburgh,England: British Machine Vision Association, 2006:47-56.

[11] 任维雅,李国辉. 面向监督学习的稀疏平滑岭回归方法[J]. 国防科技大学学报, 2015,37(6):121-128.

[12] KALAL Z, MIKOLAJCZYK K, MATAS J. Tracking-learning-detection[J]. IEEE transactions on pattern analysis & machine intelligence, 2012, 34(7):1409-1422.

[13] WANG M M, LIU Y, HUANG Z. Large margin object tracking with circulant feature maps[C]//IEEE Conference on Computer Vision. Honolulu, Hawaii,USA: IEEE,2017:4800-4808.

[14] HARE S, SAFFARI A, TORR P H S. Struck: Structured output tracking with kernels[C]//IEEE International Conference on Computer Vision. Barcelona,Spain: IEEE, 2011:263-270.

[15] BABENKO B, YANG M H, BELONGIE S. Visual tracking with online multiple instance Learning[C]//2009 IEEE Conference on Computer Vision and Pattern Recognition. Miami, Florida,USA:IEEE, 2009:983-990.

[16] JIA X,LU H C,YANG M H. Visual tracking via adaptive structural local sparse appearance model[C]//IEEE Conference on Computer Vision and Pattern Recognition. Providence,USA:IEEE, 2012:1822-1829.

[17] VOJIR T, NOSKOVA J, MATAS J. Robust scale-adaptive mean-shift for tracking[J]. Pattern recognition letters, 2014, 49:250-258.